说到AI,我们第一个想到的可能是ChatGPT、Transformer这些大名鼎鼎的技术。但你有没有想过,其实我们“遗忘”的RNN(递归神经网络)可能才是真正的宝藏?最近有一篇论文提到一个耐人寻味的问题:“RNN真的是我们唯一需要的技术吗?” 这个问题不仅让我陷入深思,也引发了对RNN新潜力的探讨。今天,我们就来聊聊这个被“冷落”的老朋友,看看它是否真的值得重新重视。

论文地址:

https://arxiv.org/pdf/2410.01201

RNN并没有过时,它只是被低估了

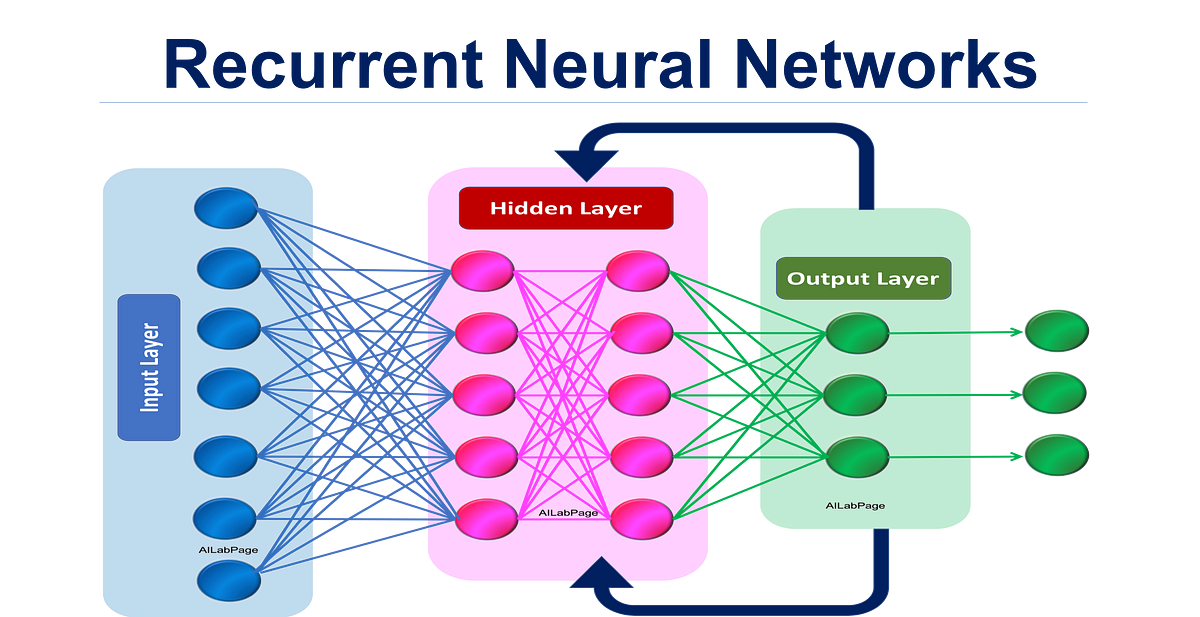

RNN曾经在自然语言处理、语音识别等领域大放异彩。它有一个很大的特点,就是能够处理序列数据,也就是说,它能记住前面发生过的事情并将其应用于后续步骤。这对于处理时间序列信息至关重要。但随着Transformer的出现,RNN被迅速边缘化。我们不妨思考一下:它真的不行了吗?

其实,RNN并不是技术上落后,而是被“替代性”掩盖了光芒。Transformer的强大在于它的并行处理能力,它能同时处理大量数据,效率惊人。相较之下,RNN更像是个一步一步“慢慢来”的选手,这让它在计算效率上稍显逊色。但我们不能因此忽视它在处理时序问题时的天然优势。如果我们能重新发掘并优化RNN的结构,或许它还能带给我们意想不到的惊喜。