Transformer变异衍生出来了两个超强悍的预训练模型

一、Transformer模型

Transformer是近年来深度学习领域中备受瞩目的模型之一,其核心思想是通过自注意力机制和位置编码来捕捉输入序列中的长距离依赖关系。

自注意力机制让模型在处理每个输入元素时能够关注到所有其他元素,从而学习到输入序列中的全局依赖关系。位置编码则用于解决传统RNN等模型在处理序列数据时对位置信息的忽略问题。

Transformer模型主要由两部分组成:编码器和解码器。编码器由多个相同的层堆叠而成,每个层包含一个自注意力子层和一个简单的全连接层。解码器同样由多个相同的层组成,但在每个解码层中还包含一个跨注意力子层,用于捕捉编码器的输出。

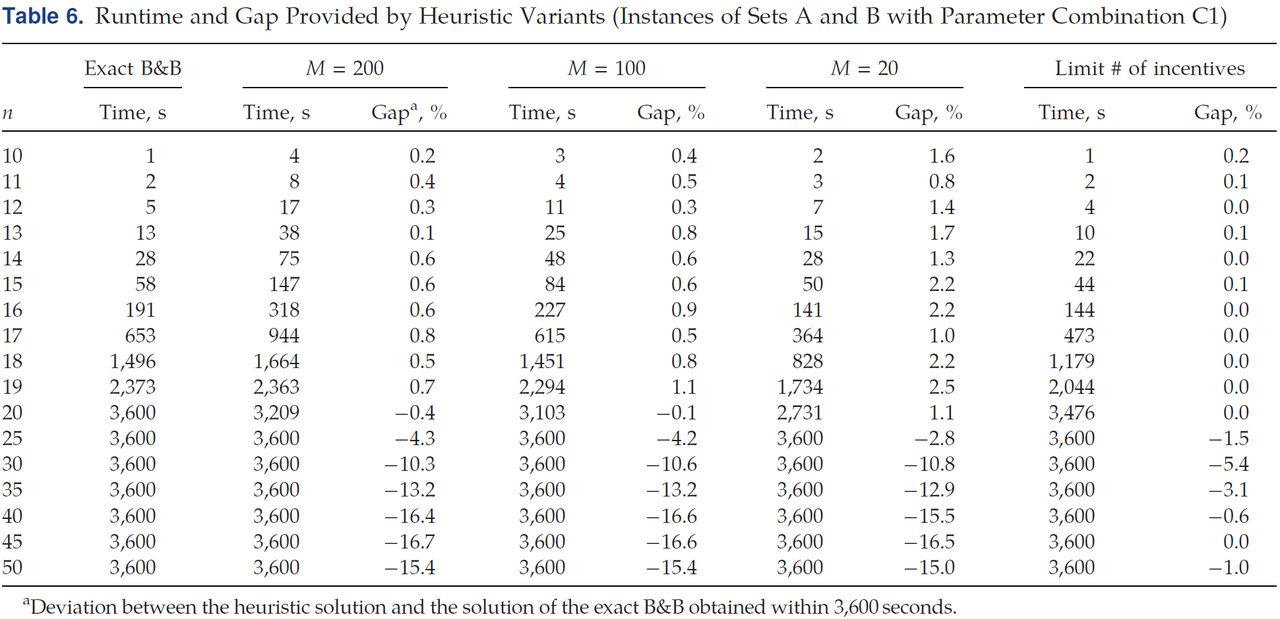

一张Transformer看烂了的图(还得多看几遍)

追加一张中文的图

二、BERT模型

BERT(Bidirectional Encoder Representations from Transformers)是一种基于Transformer的预训练语言模型,旨在通过双向训练来捕捉文本中的上下文信息。

BERT 代表双向编码器表示来自Transformer(BERT),用于高效地将高度非结构化的文本数据表示为向量。BERT是一个经过训练的 Transformer 编码器堆栈。

与GPT等模型不同,BERT在训练时同时考虑了文本的左信息和右信息,从而能够更好地理解上下文含义。这一特点使得BERT在许多NLP任务中取得了显著的性能提升。

BERT的基本结构与Transformer类似,由多个相同的编码器层堆叠而成。每个编码器层都包含一个双向的自注意力子层和一个前馈神经网络子层。

BERT的训练过程涉及两个阶段:预训练和微调。在预训练阶段,BERT使用大规模无标注文本数据来学习词向量表示;在微调阶段,BERT针对特定任务进行训练,以适应下游任务的需求。

三、GPT模型

GPT(Generative Pre-Trained Transformer)是一种基于互联网的、可用数据来训练的、文本生成的深度学习模型。GPT强调文本生成能力,并采用了一种名为“自回归语言模型”的技术来实现。

在自回归语言模型中,模型逐个生成文本中的每个单词,并使用生成的单词来预测下一个单词。这种生成方式允许GPT在处理文本生成任务时表现出色,如文本摘要、对话系统和机器翻译等。

GPT的结构与BERT类似,主要由一系列相同的编码器层组成。

每个编码器层包含一个自注意力子层和一个前馈神经网络子层。GPT的训练过程也分为预训练和微调两个阶段。在预训练阶段,GPT使用大量文本数据来学习词向量表示;在微调阶段,GPT针对特定任务进行训练,以适应下游任务的需求。

四、BERT与GPT的区别

BERT和GPT虽然都是基于Transformer的预训练语言模型,但在应用场景和生成方式上存在一些差异。BERT更适用于理解型任务,如情感分析、问答和语义匹配等,而GPT更适用于生成型任务,如机器翻译、文本摘要和对话系统等。

此外,BERT采用双向训练方式,能够更好地理解上下文含义;

而GPT采用自回归生成方式,能够更好地生成连贯的文本内容。在实际应用中,根据任务需求选择合适的模型至关重要。

总之,Transformer、BERT和GPT这三种模型各具特色,为解决不同领域的NLP问题提供了强有力的工具。

深入了解它们的原理和特点有助于更好地应用这些工具来提高我们的工作效率和有针对性的使用。