文章目录

- 一、Service详解

- 1、Service介绍

- 1.1 userspace模式

- 1.2 iptables 模式

- 1.3 ipvs模式

- 2、Service类型

- 3、Service使用

- 3.1 实现环境准备

- 3.2 Cluster类型的Service

- 3.2.1 cluster类型的生成ip

- 3.2.2 cluster类型不生成ip

- 3.3 NodePort类型的service

- 3.4 LoadBalancer类型的Service

- 3.5 ExternelName类型的Service

- 4、Ingress详解

- 4.1 Ingress介绍

- 4.2 Ingress使用

- 4.2.1 环境准备,搭建ingress环境

- 4.2.2 准备service和pod

- 4.2.3 配置 http代理

- 4.2.4 配置https代理

- 4.3 ingress总结

一、Service详解

1、Service介绍

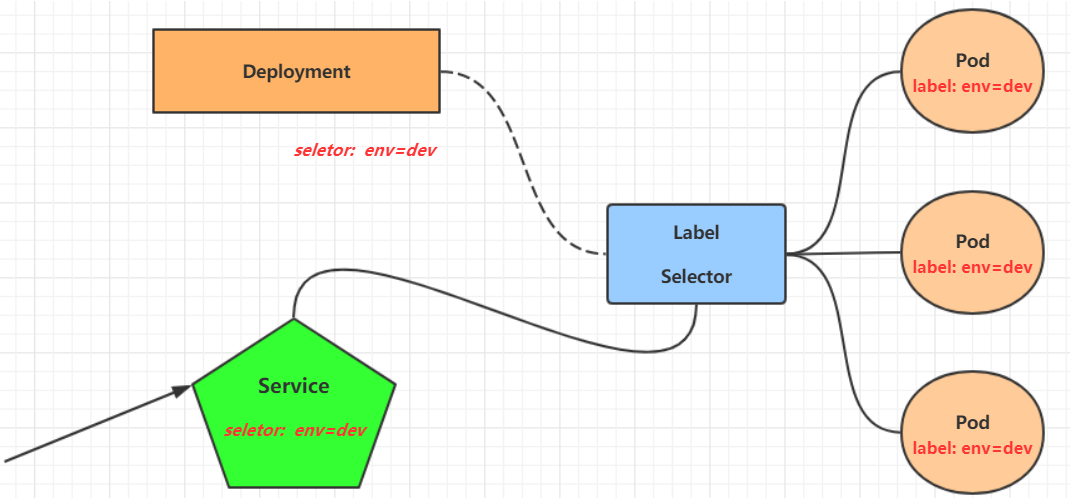

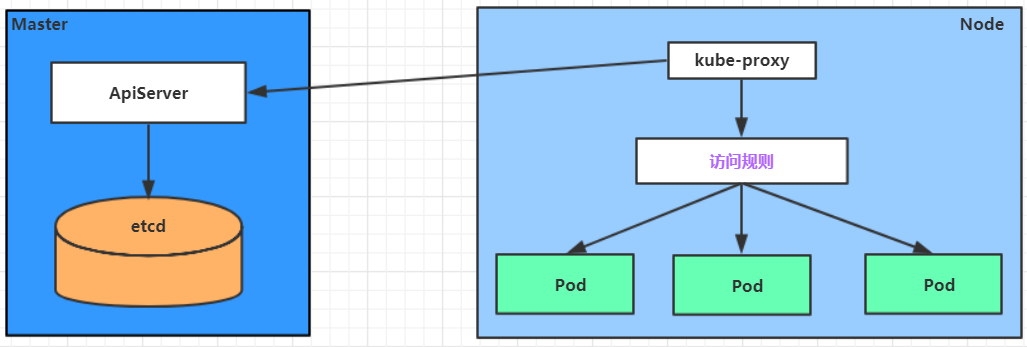

在k8s中,pod是应用程序的载体,我们可以通过Pod的ip来访问应用程序,但是Pod的ip地址不是固定的,这也就意味着不方便直接采用pod的ip对服务进行访问。

为解决这个问题,k8s提供了service资源,service会对提供同一个服务的多个pod进行聚合,并且提供一个统一的入口地址,通过访问service的入口地址就能访问到后面的pod服务。

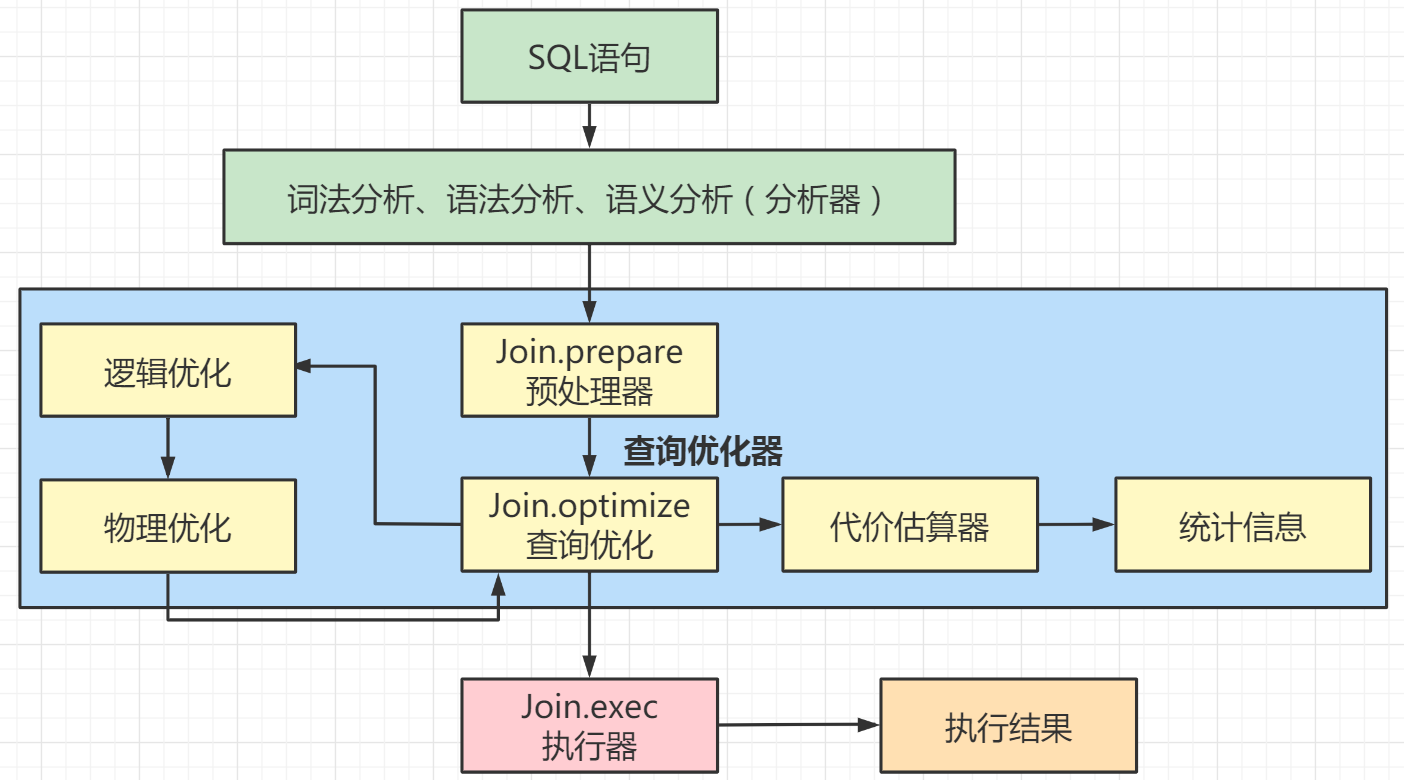

service在很多情况下只是一个概念,真正起作用的是kube-proxy服务进程,每个Node节点上都运行着一个kube-proxy服务进程, 当创建Service的时候会通过api-server向etcd写入创建的service的信息,而kube-proxy会基于监听的机制发现这种service的变动,然后它会将最新的service信息转换成对应的访问规则。

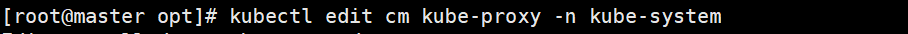

安装service的ipvs内核模块后,需要开启ipvs

kubectl edit cm kube-proxy -n kube-system

#在线编辑,开启ipvs(cm为配置资源的configmaps的缩写)

kubectl delete pod -l k8s-app-kube-proxy -n kube-system

#删除以前的pod,因为它是控制器创建的坡度,它会根据yum文件重建

ipvsadm -Ln

#查看各项规则

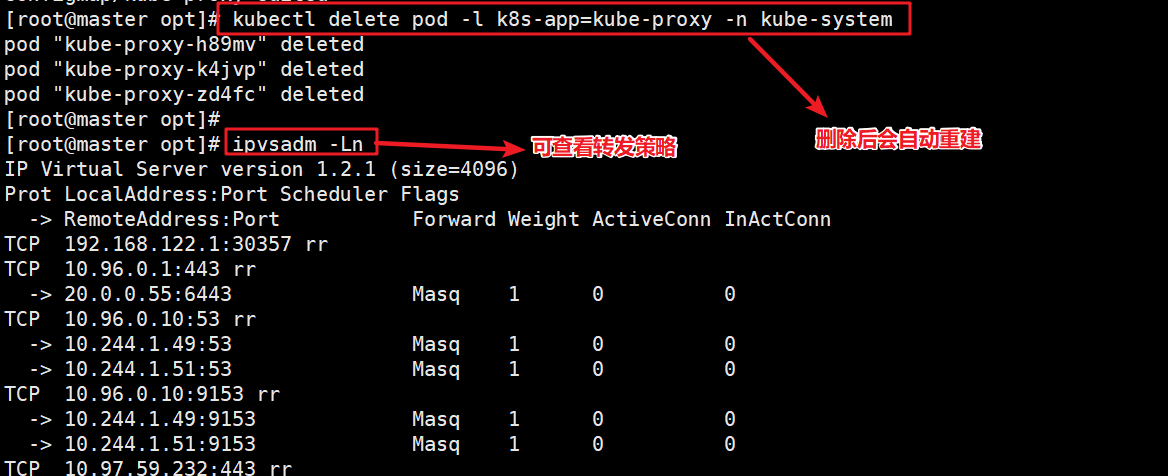

1.1 userspace模式

userspace 模式下,kube-proxy会为每一个Service创建一个监听端口,发向Cluster IP 的请求被iptables 规则重定向kube-proxy 监听的端口上,kube-proxy 根据LB 算法选择一个提供服务的Pod并和其建立连接,以将请求转发到Pod上。

该模式下,kube-proxy充当了一个四层负载均衡器的角色,由于kube-proxy 运行在userspace 中,在进行转发处理时会增加内核和用户空间之间的数据拷贝。虽然比较稳定,但是效率比较低。

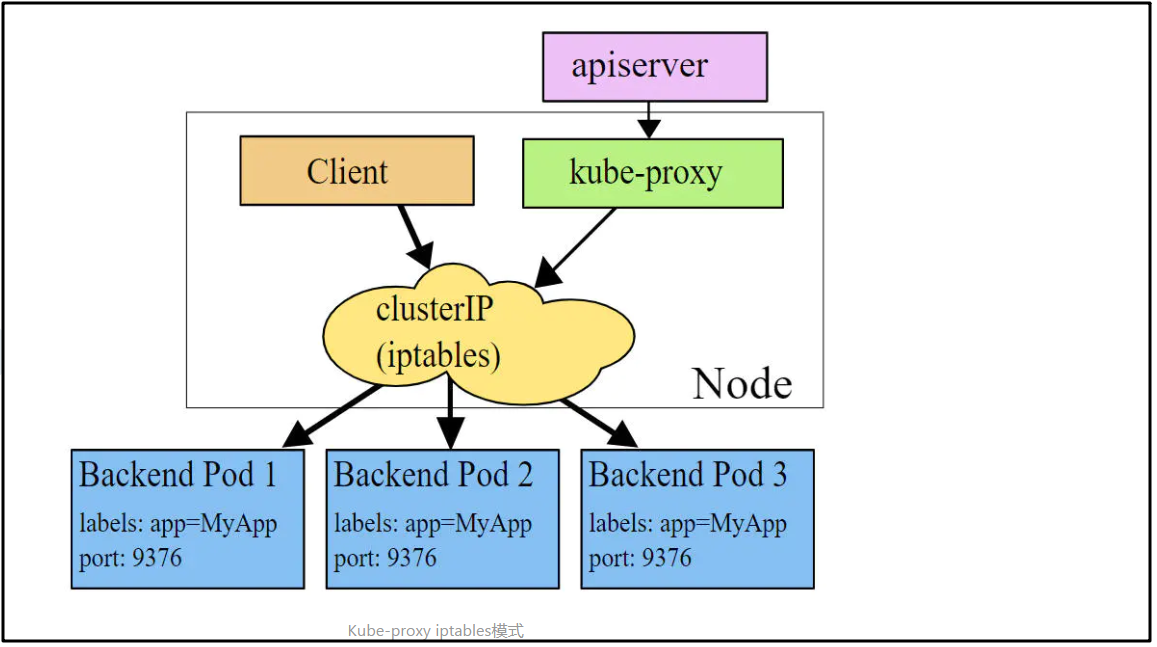

1.2 iptables 模式

iptables模式下,kube-proxy 为service 后端的每个pod 创建对应的iptables规则,直接将发向 Cluster IP 的请求重定向到一个Pod IP,该模式下 kube-proxy 不承担四层负载均衡器的角色,只负责创建iptables 规则。

该模式的优点是比userspace模式效率更高,但不能提供灵活的LB策略,当后端Pod不可用时也无法进行重试。

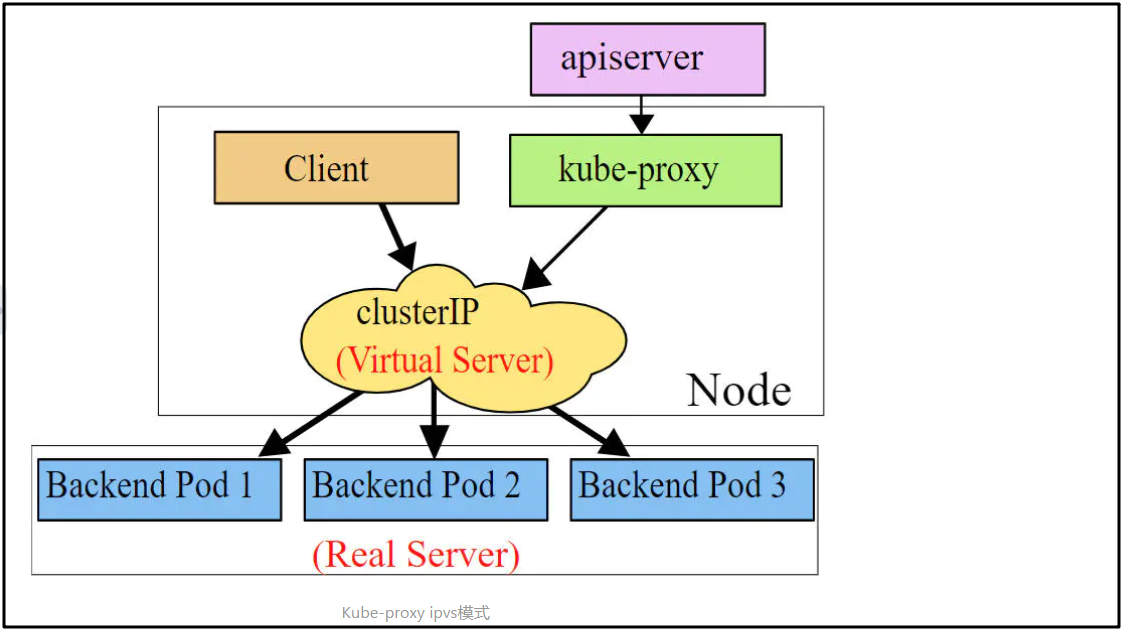

1.3 ipvs模式

ipvs模式和iptables类似,kube-proxy监控Pod的变化并创建相应的ipvs规则,ipvs相对iptables转发效率更高,除此以外,ipvs支持更多的LB算法。

2、Service类型

service的资源清单文件:

apiVersion: v1 #资源版本

kind: Service #资源类型

metadata: #元数据

name: service #资源名称

namespace: dev #命名空间

spec: #描述

selector: #标签选择器,用于确定当前service代理哪些Pod

app: nginx

type: #service类型,指定service的访问方式

clusterIP: #虚拟服务的ip地址

sessionAffinity: #session亲和性,支持clientIP、None两个选项

ports: #端口信息

- protocol: TCP

port: 3017 #service端口

targetPort: 5003 #pod端口

nodePort: 31122 #主机端口

service的四种类型

- ClusterIP : 默认值,同时kubernetes系统自动分配的虚拟IP,只能在集群内部访问

- NodePort: 将Service通过指定的Node上的端口暴露给外部,通过此方法,就可以在集群外部访问服务

- LoadBalancer: 使用外界负载均衡器完成到服务的负载分发,注意此模式需要外部云环境支持。

- EXternalName: 把集群外部的服务映入集群内部,直接使用

3、Service使用

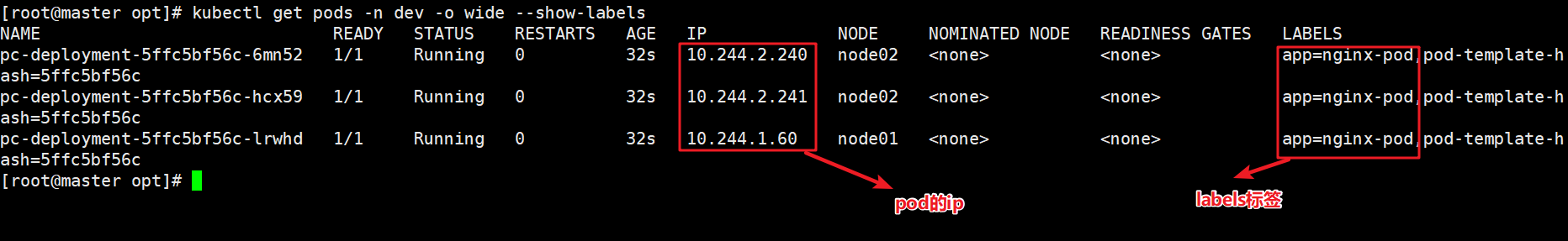

3.1 实现环境准备

在使用service之前,首先要利用Deployment创建出3个Pod,注意要为Pod设置app=nginx-pod的标签

创建deployment.yaml文件

apiVersion: apps/v1

kind: Deployment

metadata:

name: pc-deployment

namespace: dev

spec:

replicas: 3

selector:

matchLabels:

app: nginx-pod

template:

metadata:

labels:

app: nginx-pod

spec:

containers:

- name: nginx

image: nginx:1.17.1

ports:

- containerPort: 80

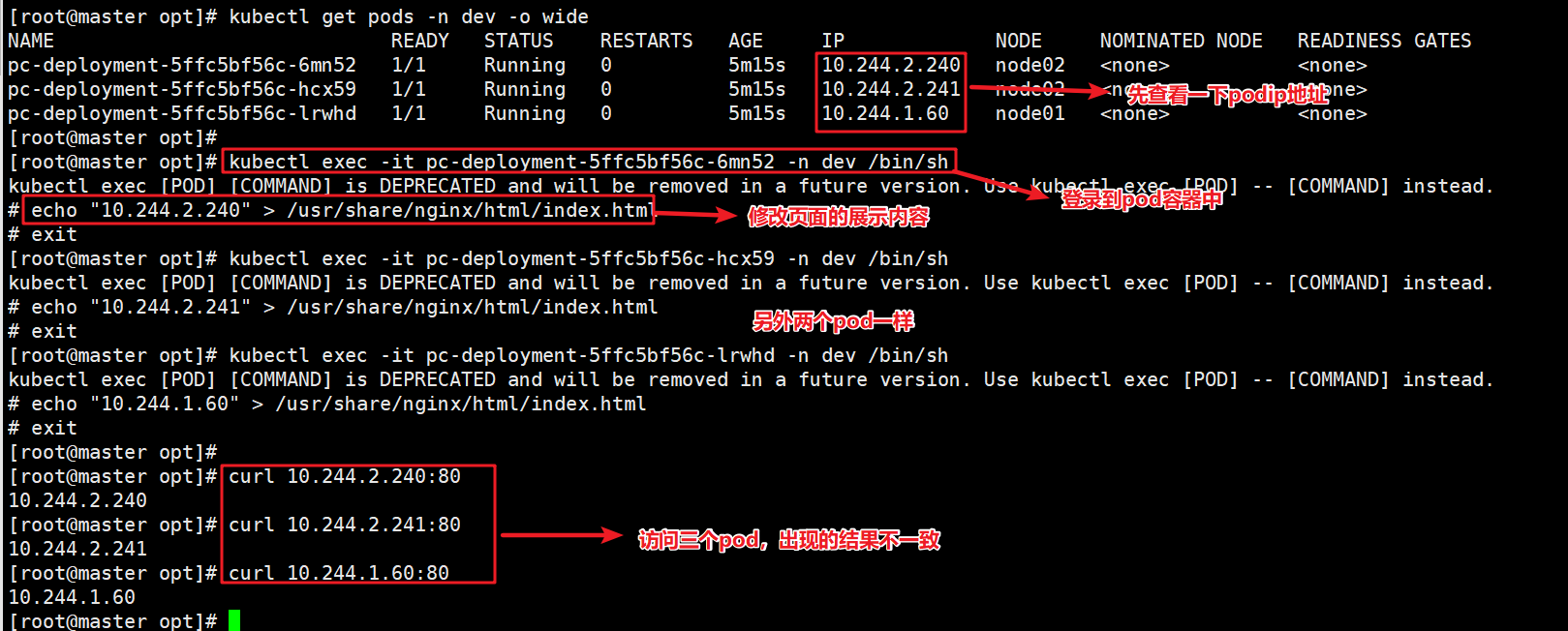

下面开始创建pod

kubectl create -f deployment.yaml

#创建pod

kubectl get pods -n dev -o wide --show-labels

#查看pod详情

###为了方便后面测试,修改三台nginx的index.html的页面

kubectl exec -it 【pod名称】 -n dev /bin/sh

#进入pod中更多容器

echo "10.244.2.240" >> /usr/share/nginx/html/index.html

#修改页面标签

curl 10.244.2.240

3.2 Cluster类型的Service

3.2.1 cluster类型的生成ip

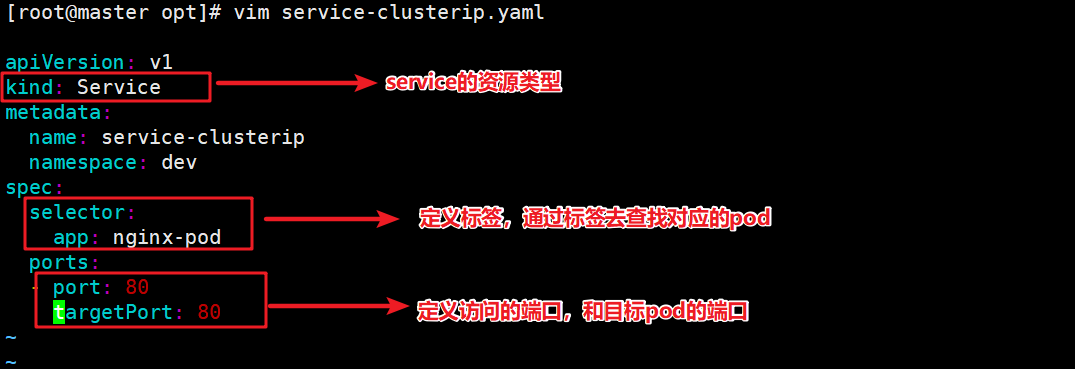

创建service-clusterip.yaml

apiVersion: v1

kind: Service

metadata:

name: service-clusterip

namespace: dev

spec:

selector:

app: nginx-pod

# clusterIP: 10.97.97.97 # service的ip地址,如果不写,默认会生成一个

# type: ClusterIP #service类型,不写,默认clusterIP

ports:

- port: 80 # Service端口

targetPort: 80 # pod端口

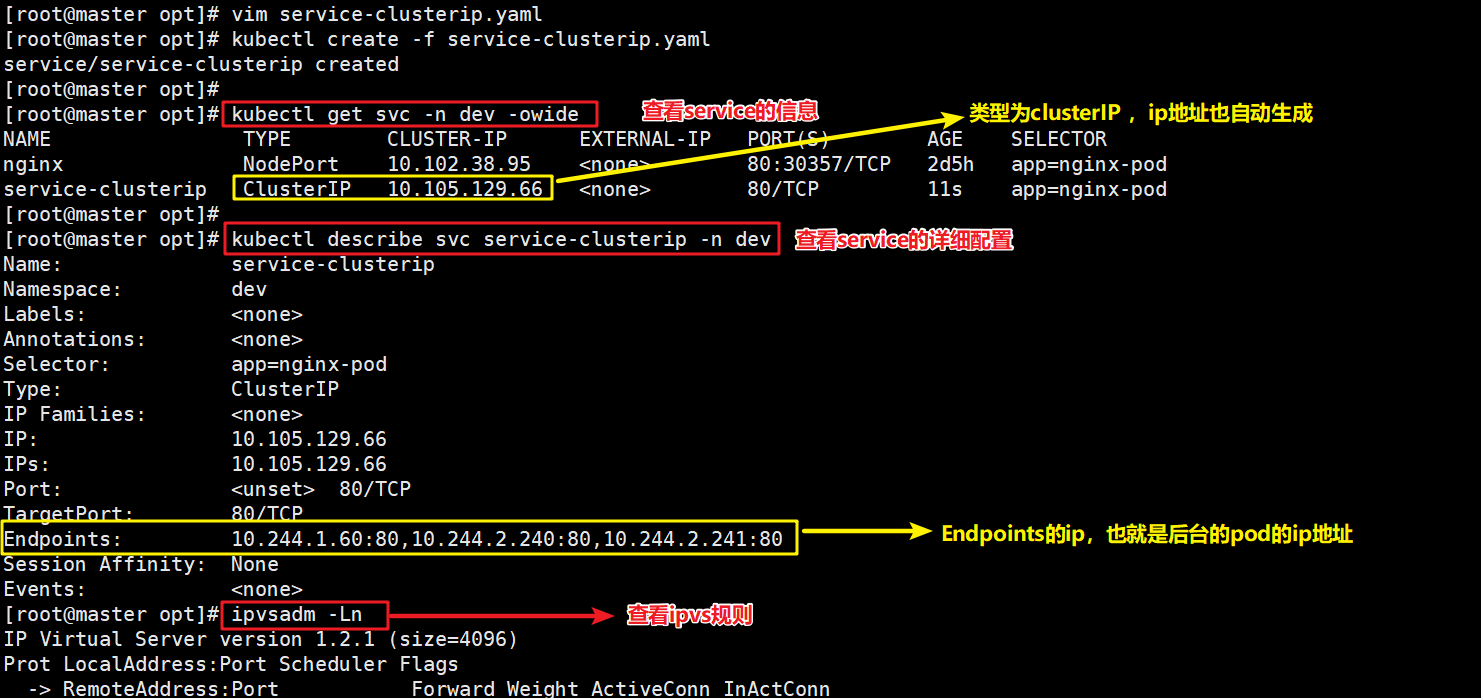

下面开始创建service

kubectl create -f service-clusterip.yaml

#创建service

kubectl get svc -n dev -o wide

#查看service

kubectl describe svc service-clusterip -n dev

#查看service的详细信息

//这里面有一个Endpoints列表,里面就是当前service可以负载到的服务入口

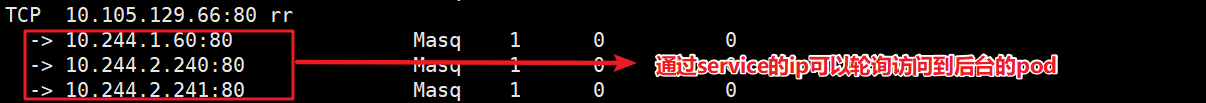

ipvsadm -Ln

#查看ipvs的映射

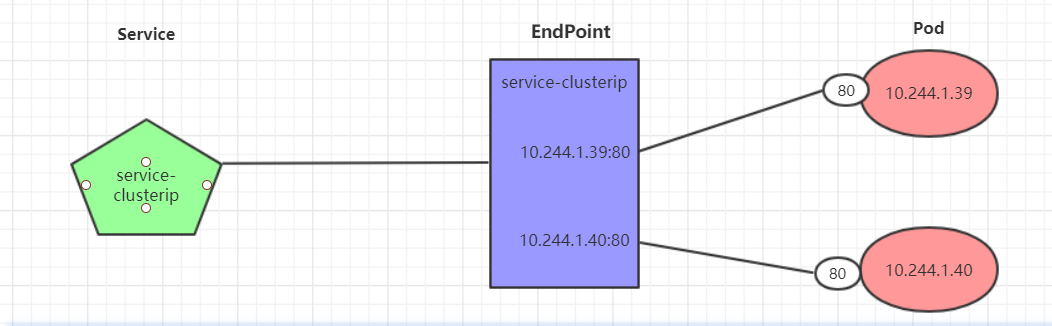

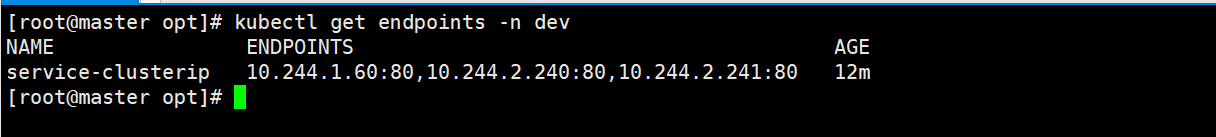

Endpoints讲解

- Endpoint是kubernetes中的一个资源对象,存储在etcd中,用来记录一个service对应的所有的pod的访问记录,它是根据service配置文件中的selector描述产生的。

- 一个service由一组Pod组成,这些Pod通过Endpoints暴露出来, Endpoints 是实现实际服务的端口集合。简单来说,service和pod自检的联系是通过Endpoints实现的。

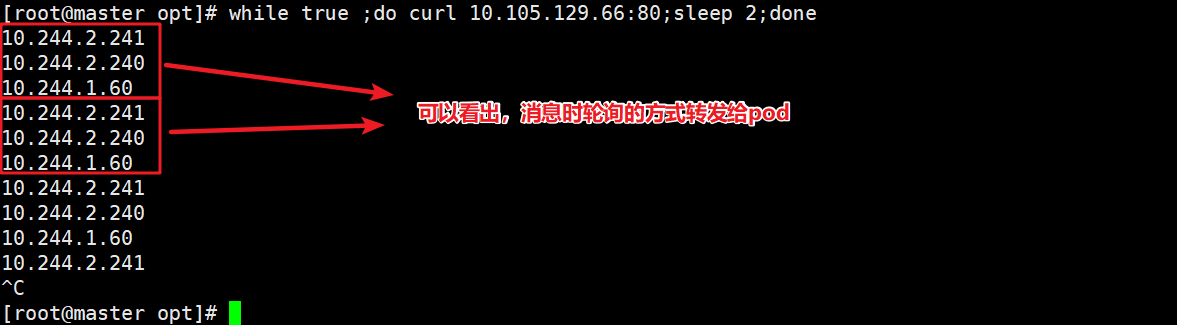

负载分发策略讲解

对service的访问被分发到了后端的Pod上去,目前kubernetes提供了两种负载分发策略

- 如果不定义,默认使用lube-proxy的策略,比如随机、轮询

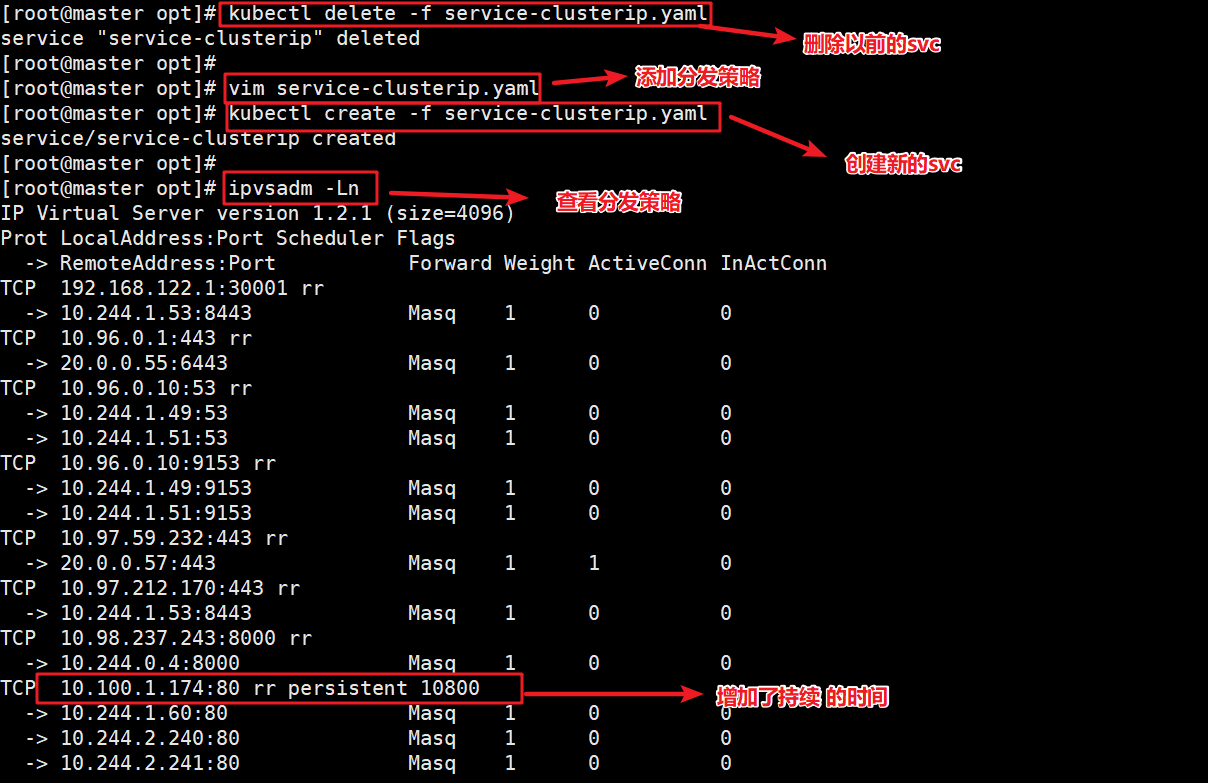

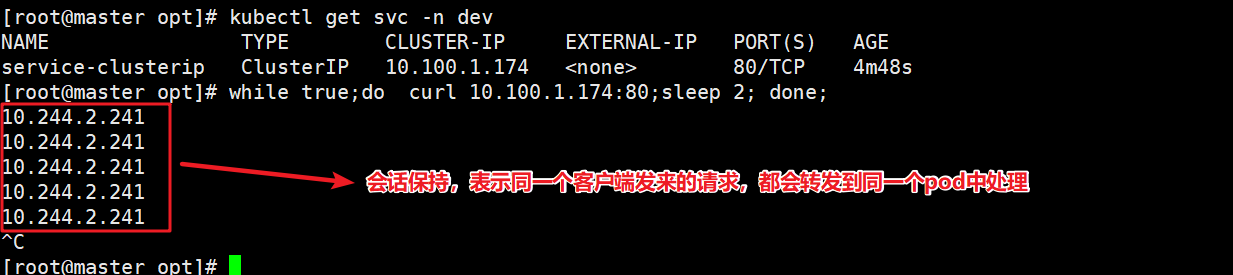

- 基于了护短地址的会话保持模式,即来自同一个客户端发起的所有请求都会被转发到固定的一个pod上。 这个需要在spec属性中设置sessionAffinity:ClientIP 选项,添加亲和性

while true ;do curl 10.105.129.66:80;sleep 2;done

#循环访问service查看页面返回的效果

此时,修改spec的分发策略

kubectl delete -f service-clisterip.yaml

#删除svc

vim service-clusterip.yaml

#在spec下面添加 sessionAffinity: ClientIP(表示会话保持模式)

ipvsadm -Ln

#查看转发策略

while true; curl 10.100.1.174:80;sleep 2; done;

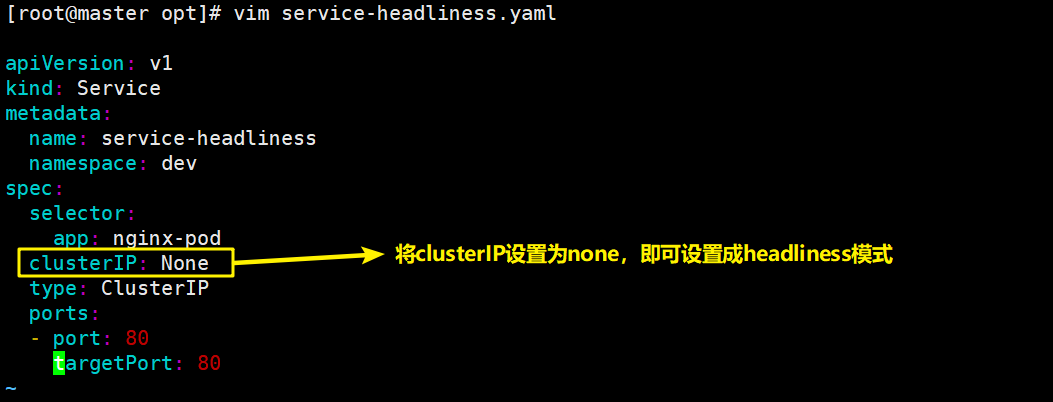

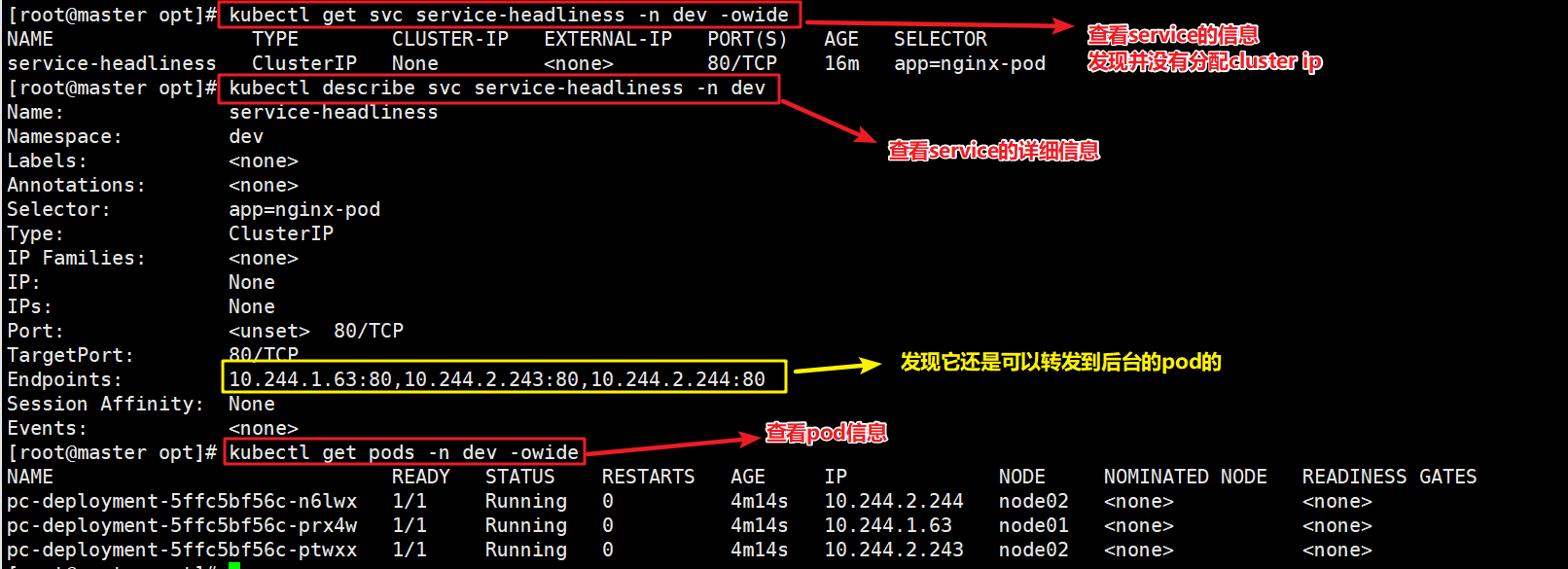

3.2.2 cluster类型不生成ip

在某些场景中,开发人员可能不想使用Serbice提供的负载均衡功能,而希望自己来控制负载均衡策略。

针对这种情况,kubernetes 提供了 HeadLiness Service , 这类Service 不会分配 Cluster IP,如果想要访问service,只能通过service的域名进行查询。

创建service-headliness.yaml

apiVersion: v1

kind: Service

metadata:

name: service-headliness

namespace: dev

spec:

selector:

app: nginx-pod

clusterIP: None # 将clusterIP设置为None,即可创建headliness Service

type: ClusterIP

ports:

- port: 80

targetPort: 80

下面创建service,进行验证

kubectl create -f service-headliness.yaml

#创建service

kubectl get svc service-headliness -n dev -o wide

#获取service,发现Cluster-ip 未分配

kubectl describe svc service-headliness -n dev

#查看service详情

kubectl exec -it 【pod名称】 -n dev /bin/sh

#进入pod中的容器

cat /etc/resolv.conf

#查看域名解析

dig @10.96.0.10 service-headliness.dev.svc.cluster.local

#使用dig访问一下域名服务

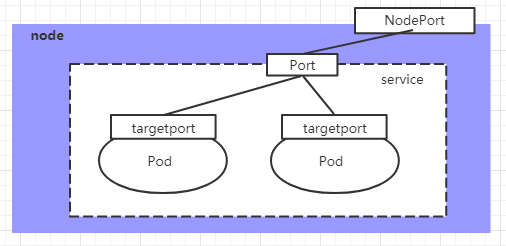

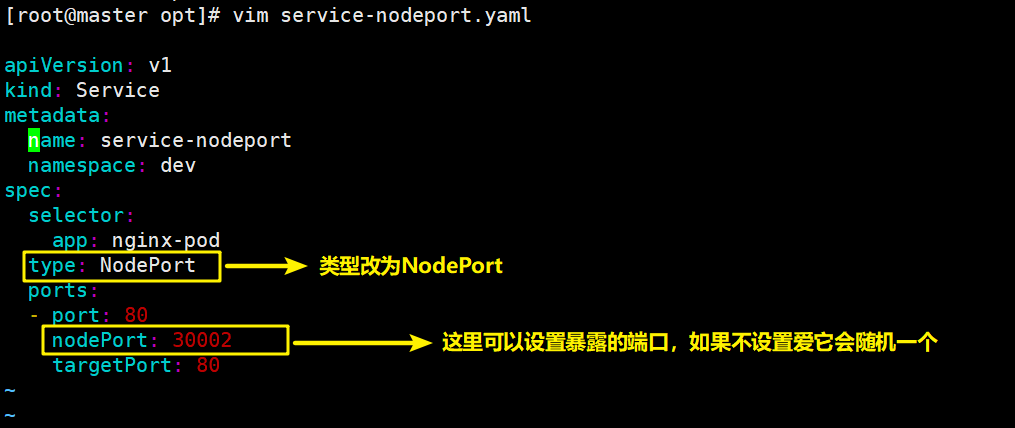

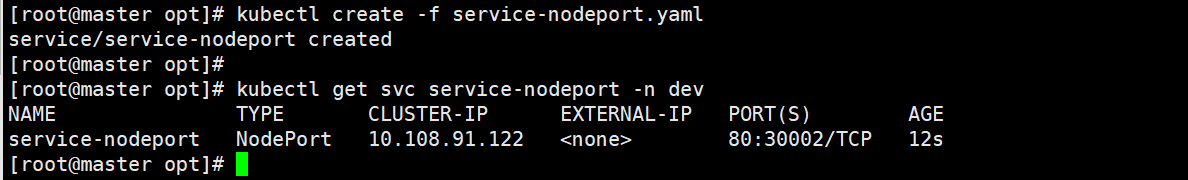

3.3 NodePort类型的service

在之前的样例中,创建的Service的匹配地址只有集群内部才可以访问,如果希望将Service暴露给集群外部使用,那么就要使用到另一种类型的Service,称为NodePort类型。

NodePort的工作原理其实就是将Service的断就映射到Node的一个端口上,然后就可以通过NodeIP:NodePort 来访问service了。

创建service-nodeport.yaml

apiVersion: v1

kind: Service

metadata:

name: service-nodeport

namespace: dev

spec:

selector:

app: nginx-pod

type: NodePort # service类型

ports:

- port: 80

nodePort: 30002 # 指定绑定的node的端口(默认的取值范围是:30000-32767), 如果不指定,会默认分配

targetPort: 80

下面创建service,然后进行访问

kubectl get svc service-nodeport -n dev

#查看service的信息

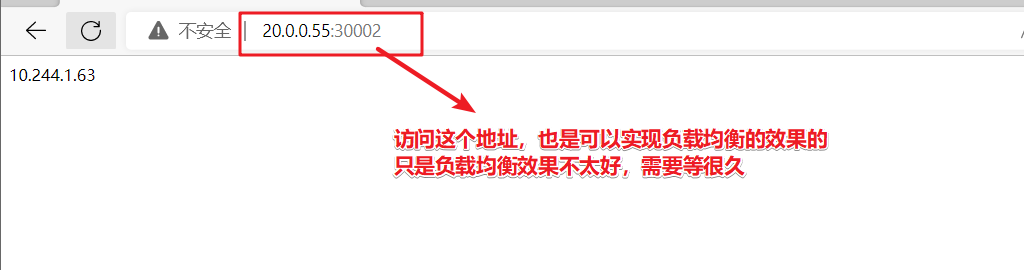

3.4 LoadBalancer类型的Service

LoadBalancer和NodePort很相似,目的都是向外暴露一个端口,区别在于LoadBalancer会在集群外部再来做个负载均衡设备。

而这个设备需要外部环境支持的,外部服务发送到这个设备上的请求,会被设备负载之后转发到集群中。

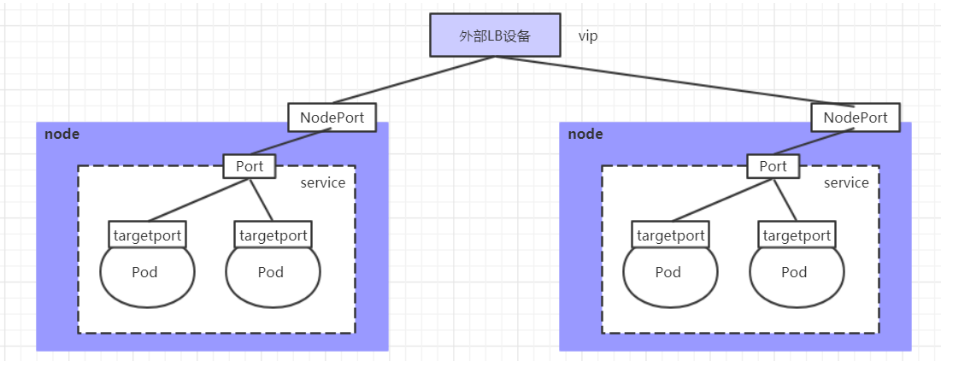

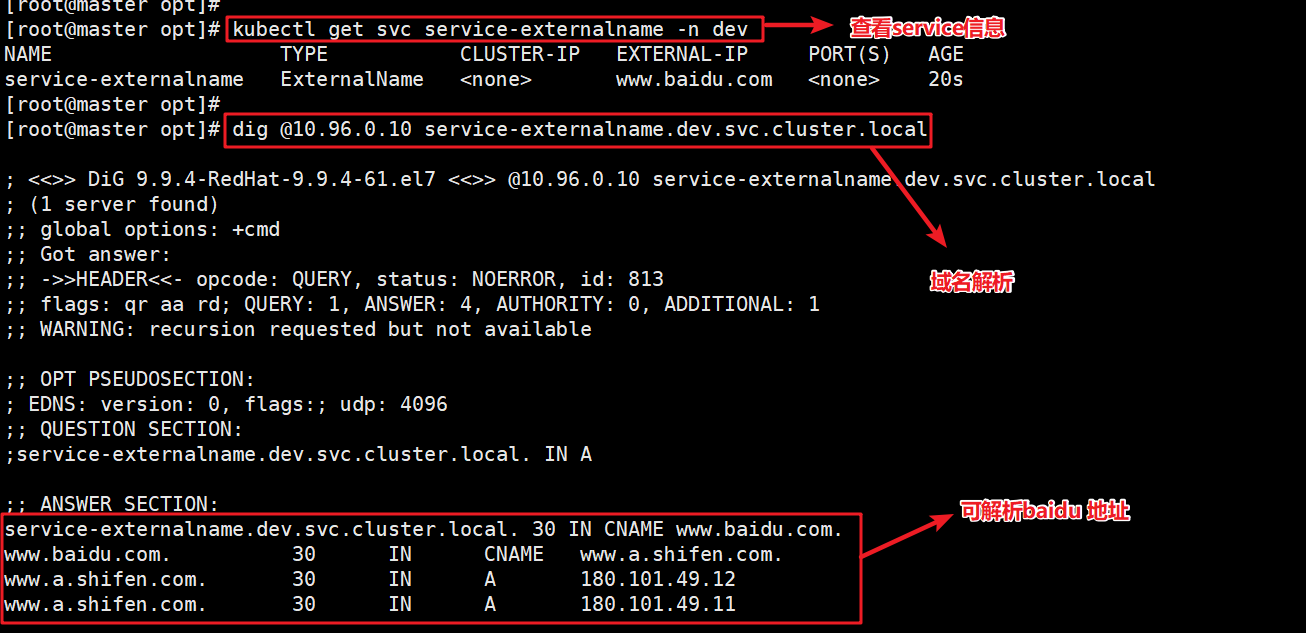

3.5 ExternelName类型的Service

ExternelName类型的Service用于引入集群外部的服务,它通过externelname属性指定外部一个服务的地址,然后在集群内部访问此service就可以访问到外部服务了。

创建 service-externalname.yaml

apiVersion: v1

kind: Service

metadata:

name: service-externalname

namespace: dev

spec:

type: ExternalName # service类型

externalName: www.baidu.com #改成ip地址也可以

下面创建service进行访问一下

dig @10.96.0.10 service-externalname.dev.svc.cluster.local

#域名解析

4、Ingress详解

4.1 Ingress介绍

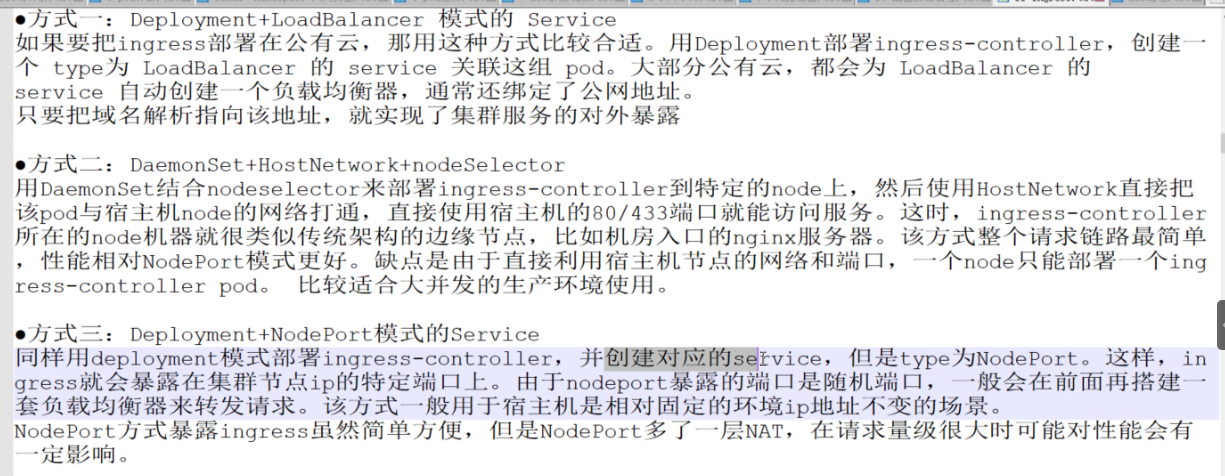

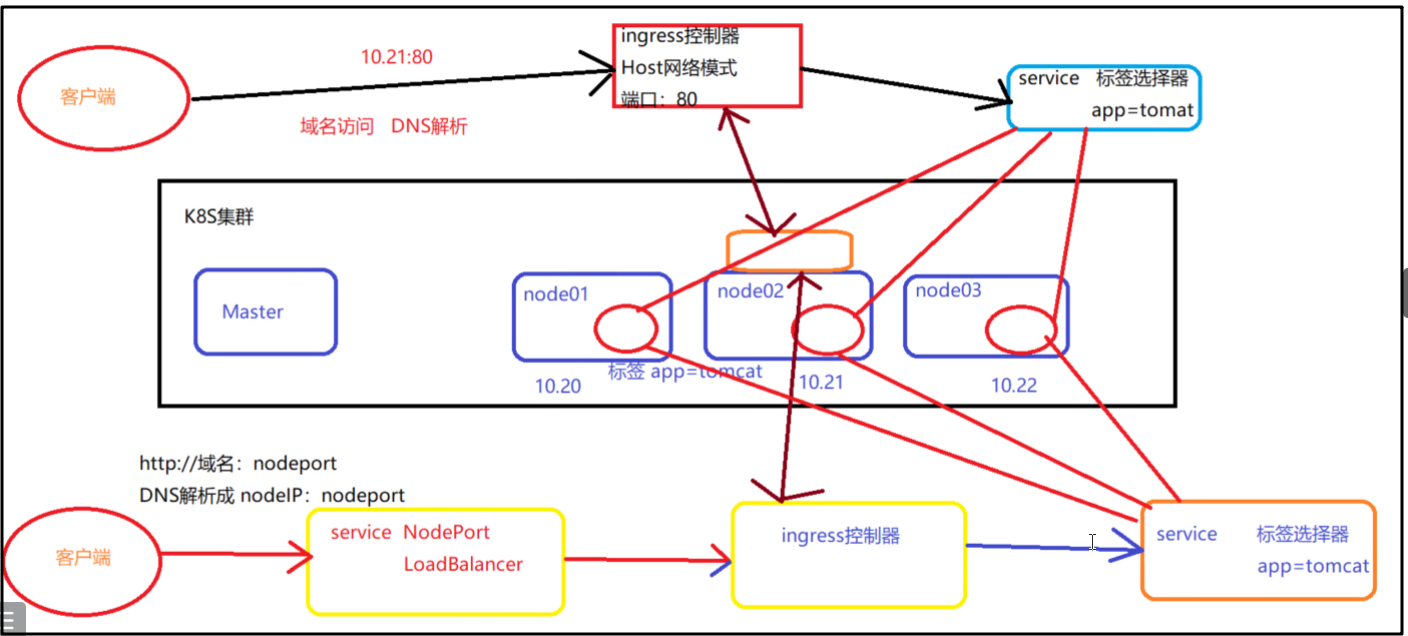

早前面介绍到。service对集群之外暴露服务的主要方式有两种:NotPort 和LoadBalancer,但是这两种方式都有一定的缺点。

- NodePort: 会占用很多集群机器的端口,那么当集群服务变多的时候,这个缺点就会越发明显。

- LoadBalancer: 每个serice需要一个LB设备。浪费、麻烦、并且需要k8s之外的设备支持。

基于这种现状,kubernetes 提供了Ingress资源对象。Ingress只需要一个NodePort 或者一个LB就可满足暴露多个service的需求。

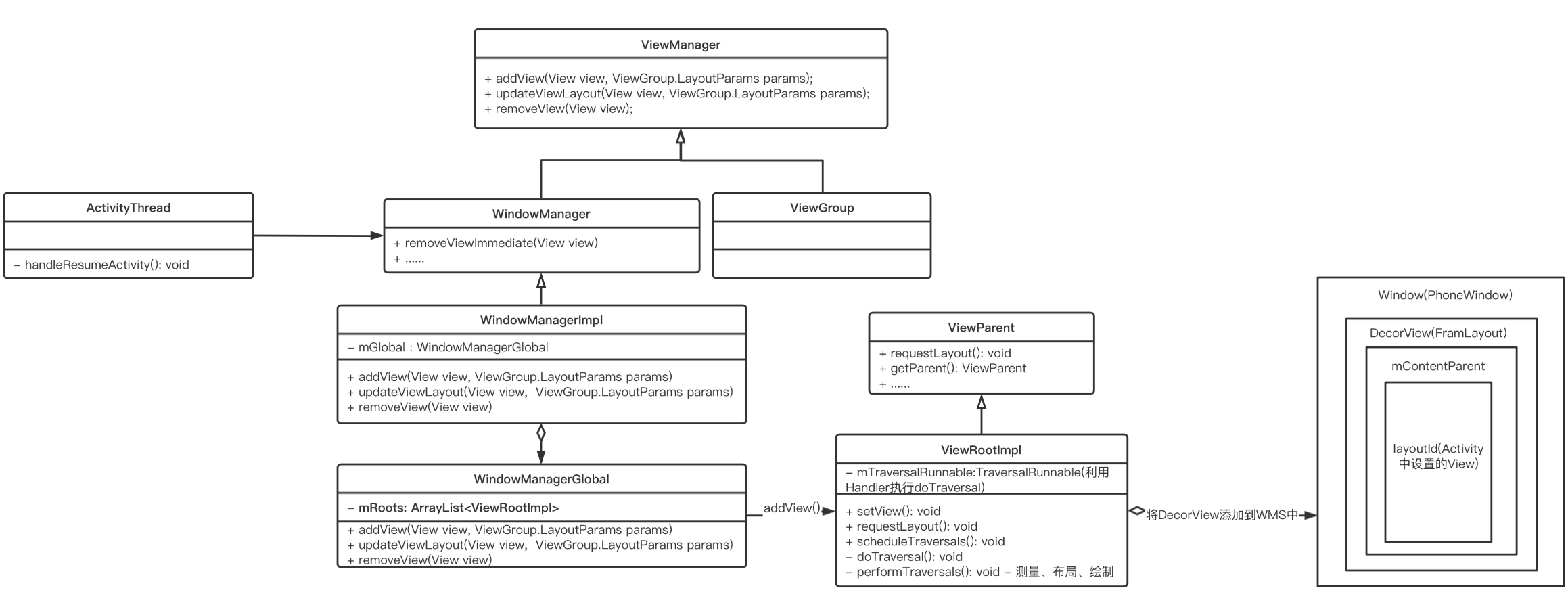

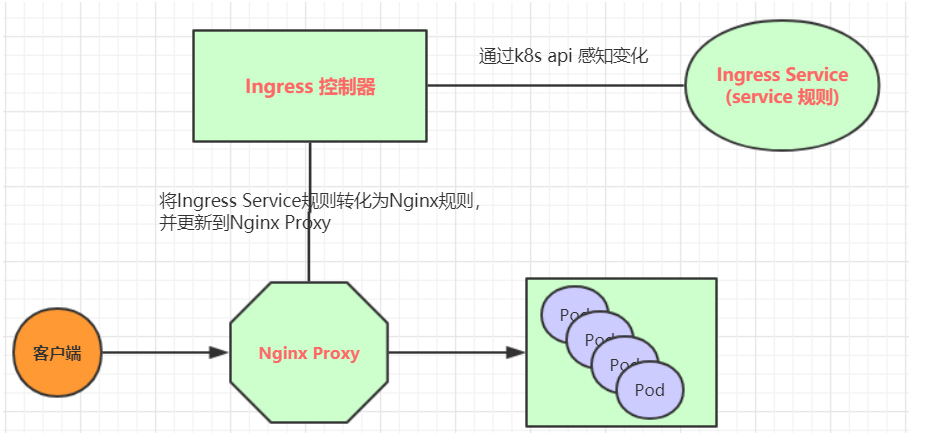

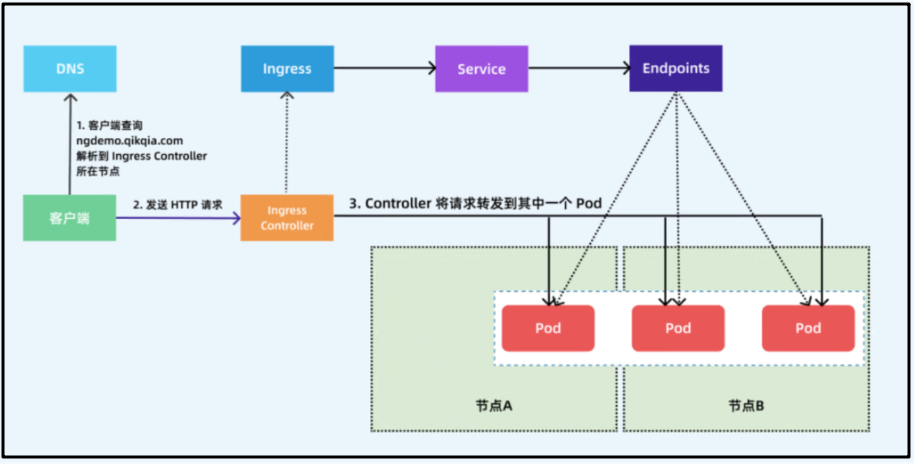

实际上,Ingress相当于一个7层的负载均衡器,是kubernetes对反向代理的一个抽象,它的工作原理类似于nginx, 可以理解成在Ingress里建立诸多映射规则,Ingress Controller 通过监听这些配置规则并转化成Nginx的反向代理配置,然后对外部提供服务。

- Ingress: kubernetes中的一个对象,作用是定义请求如何转发到service的规则

- Ingress controller : 具体实现反向代理及负载均衡的程序,对ingress定义的规则进行解析,根据配置的规则来实现请求转发,实现方式有多种,比如nginx、contour、haproxy等。

Ingress(以nginx为例)的工作原理如下:

- 用户编写Ingress规则,说明哪个域名对应k8s集群中的哪个service

- Ingress控制器动态感知Ingress服务规则的变化,然后生成一段对应的nginx反向代理配置。

- Ingress控制器会将生成的nginx配置写入到一个运行着的nginx服务中,并动态更新。

- 到此为止,其实真正工作的就是一个nginx了,内部配置了用户定义的请求转发规则。

4.2 Ingress使用

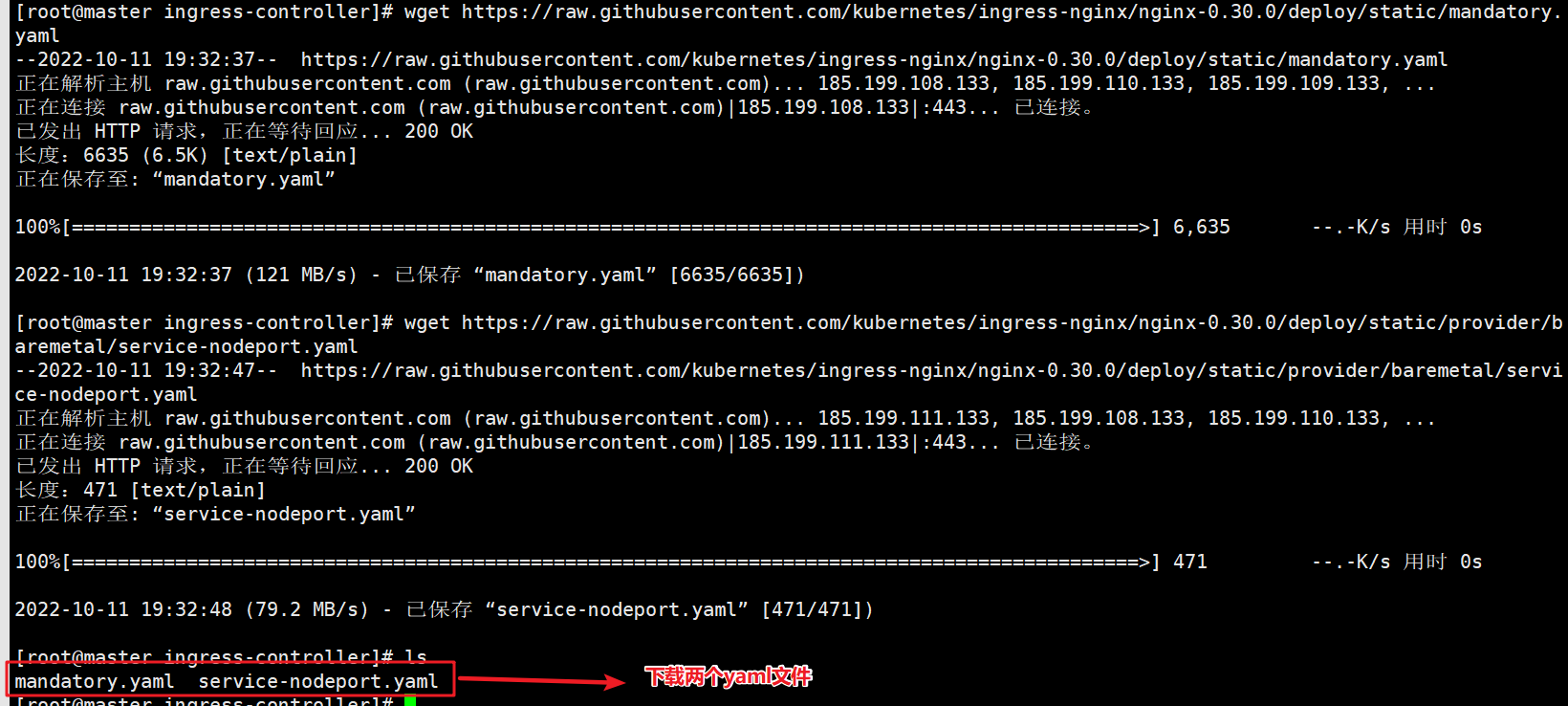

4.2.1 环境准备,搭建ingress环境

# 创建文件夹

mkdir ingress-controller

cd ingress-controller/

# 获取ingress-nginx,本次案例使用的是0.30版本

wget https://raw.githubusercontent.com/kubernetes/ingress-nginx/nginx-0.30.0/deploy/static/mandatory.yaml

wget https://raw.githubusercontent.com/kubernetes/ingress-nginx/nginx-0.30.0/deploy/static/provider/baremetal/service-nodeport.yaml

kubectl apply -f ./

#执行所有yaml文件

# 查看ingress-nginx

kubectl get pod -n ingress-nginx

# 查看service

kubectl get svc -n ingress-nginx

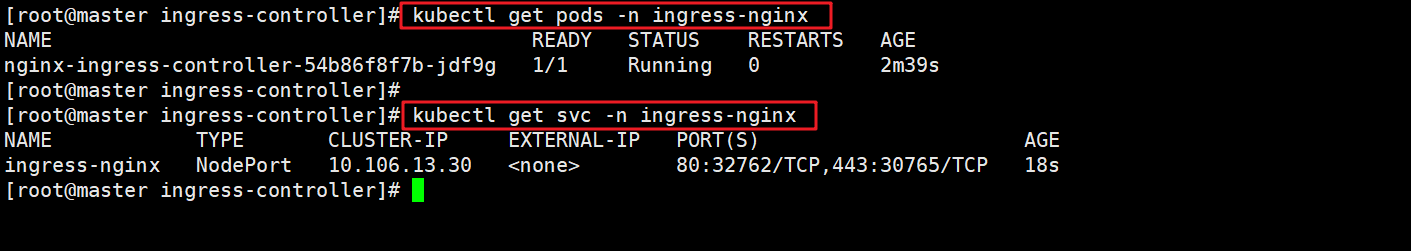

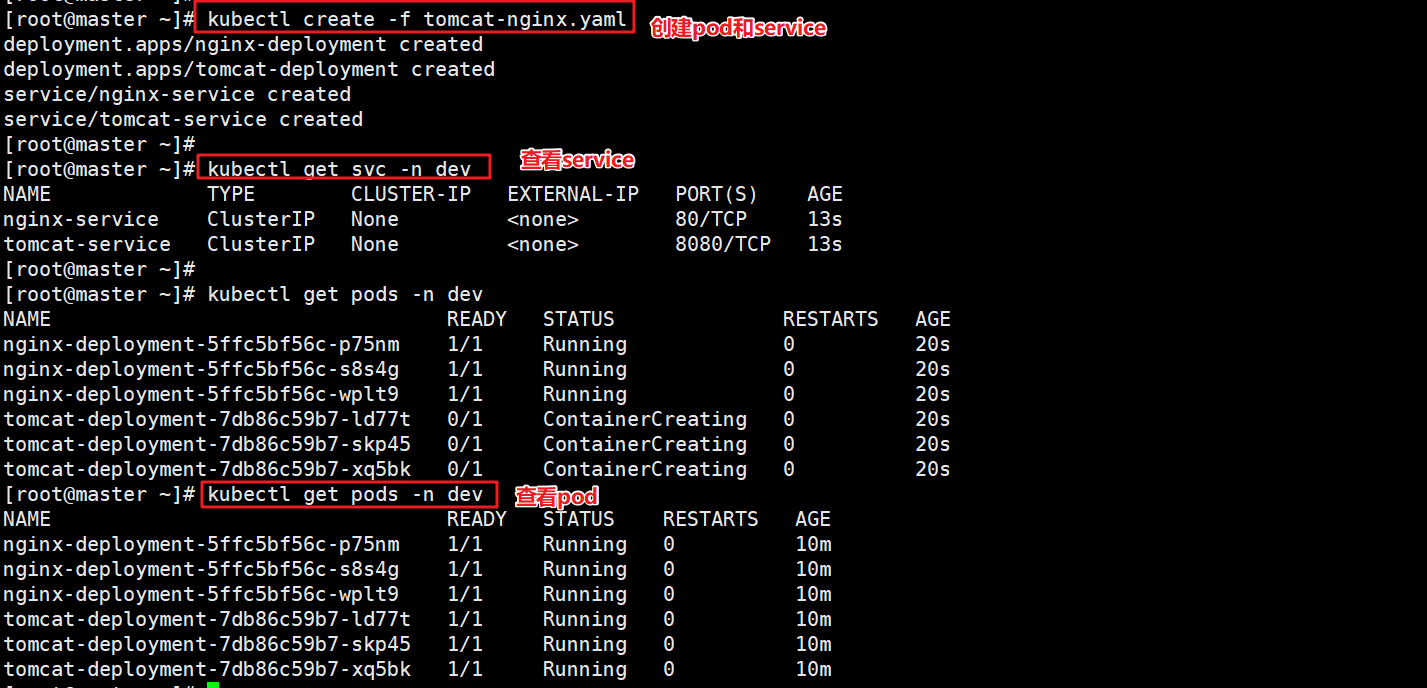

4.2.2 准备service和pod

为了后续实现,创建两组service,一组nginx的pod,一组tomcat的pod,分别通过两个service出来

创建tomcat-nginx.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

namespace: dev

spec:

replicas: 3

selector:

matchLabels:

app: nginx-pod

template:

metadata:

labels:

app: nginx-pod

spec:

containers:

- name: nginx

image: nginx:1.17.1

ports:

- containerPort: 80

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: tomcat-deployment

namespace: dev

spec:

replicas: 3

selector:

matchLabels:

app: tomcat-pod

template:

metadata:

labels:

app: tomcat-pod

spec:

containers:

- name: tomcat

image: tomcat:8.5-jre10-slim

ports:

- containerPort: 8080

---

apiVersion: v1

kind: Service

metadata:

name: nginx-service

namespace: dev

spec:

selector:

app: nginx-pod

clusterIP: None

type: ClusterIP

ports:

- port: 80

targetPort: 80

---

apiVersion: v1

kind: Service

metadata:

name: tomcat-service

namespace: dev

spec:

selector:

app: tomcat-pod

clusterIP: None

type: ClusterIP

ports:

- port: 8080

targetPort: 8080

kubectl create -f tomcat-nginx.yaml

kubectl get svc -n dev

kubectl get pods -n dev

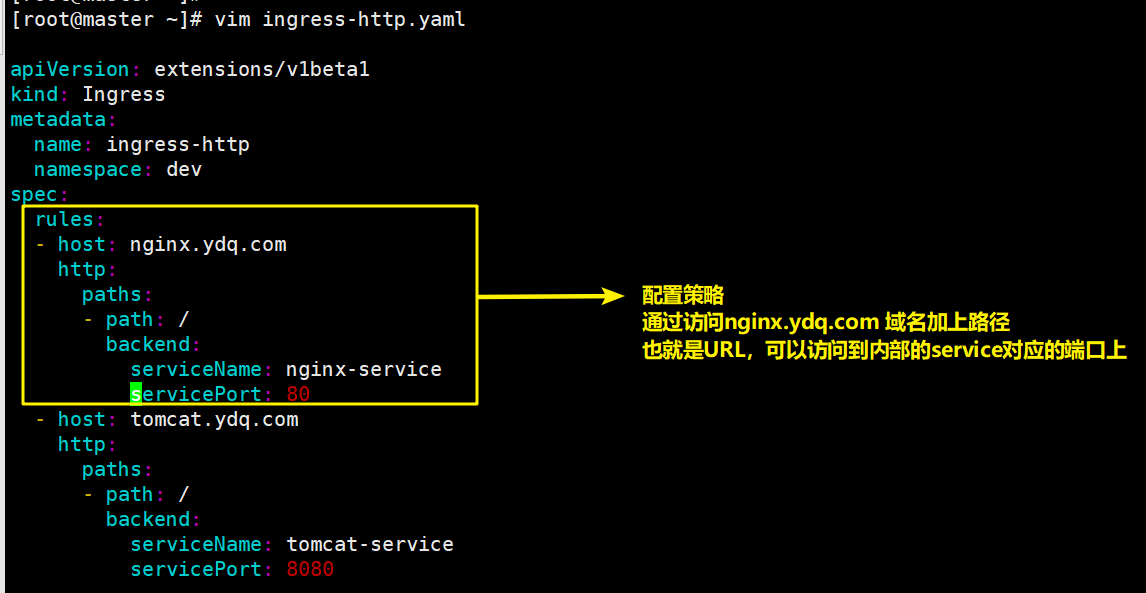

4.2.3 配置 http代理

配置好ingress资源后,这些信息会被apiserver存储到etcd中。ingress-controller会一直监听etcd中的ingress的变化,感知变化后,它知道当有请求访问时,它就知道往哪个service中转发了。

创建ingress-http.yaml

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: ingress-http

namespace: dev

spec:

rules: #配置ingress规则

- host: nginx.ydq.com #访问的域名

http: #设置连接协议

paths: #设置路径和访问的service

- path: / #设置路径

backend: #设置后端的service

serviceName: nginx-service #设置要访问的service名称

servicePort: 80 #设置访问的service端口

- host: tomcat.ydq.com

http:

paths:

- path: /

backend:

serviceName: tomcat-service

servicePort: 8080

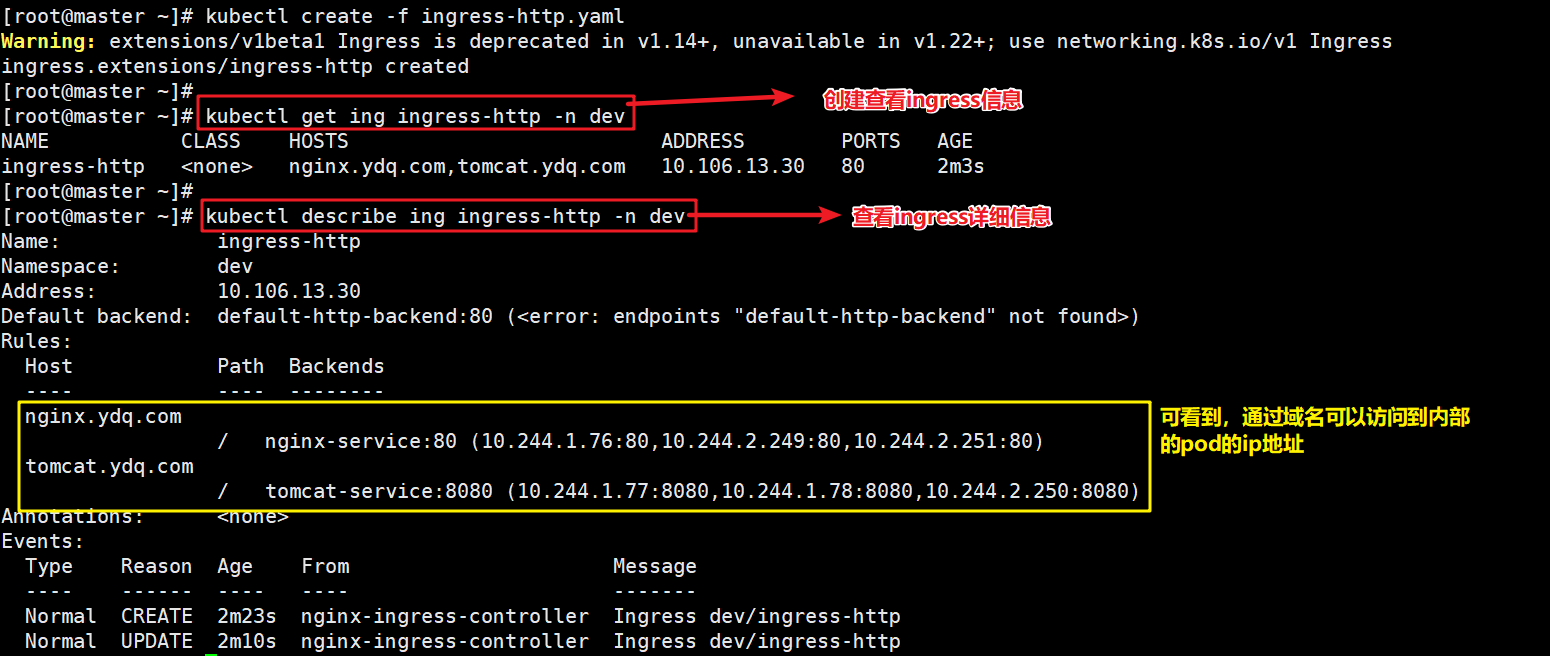

kubectl get create -f ingress-http.yaml

#创建ingress

kubectl get ing ingress-http -n dev

#查看ingerss信息

kubectl describe ing ingress-http -n dev

#查看详细信息

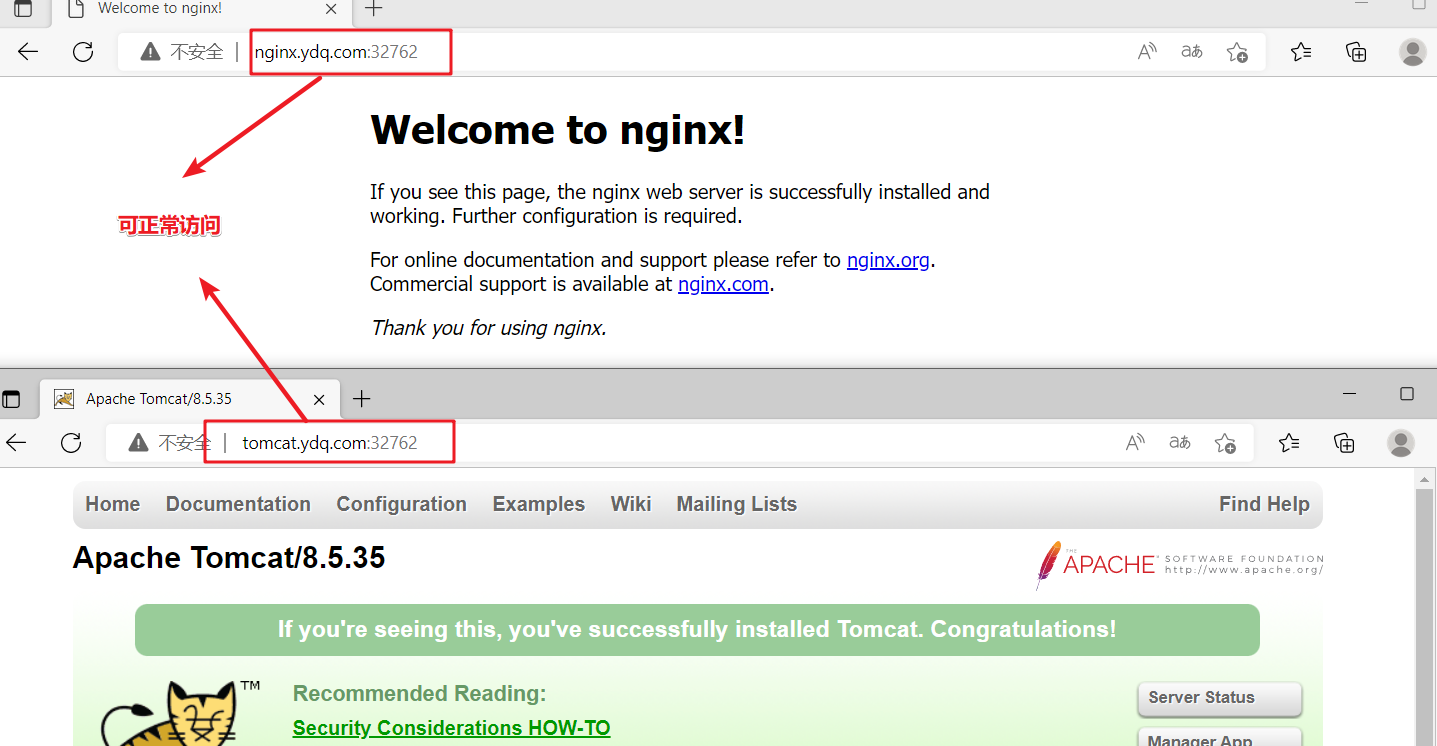

#### 接下来,在本地电脑上配置host文件,解析上面的两个域名到20.0.0.55(master)上

配置好host解析文件,就能进行访问了。通过域名加ingress暴露在外面的端口即可完成访问。

kubectl get svc -n ingress-ngin

#可查看到ingress的保留端口

http://nginx.ydq.com:32762

http://tomcat.ydq.com:32762

#宿主机访问

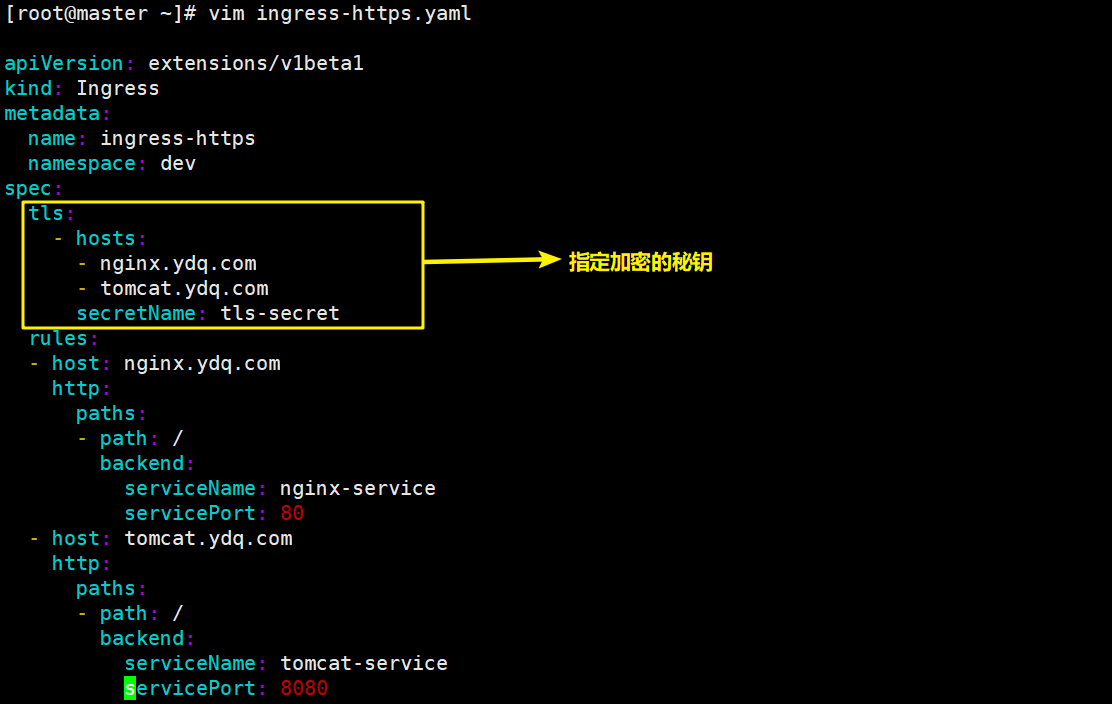

4.2.4 配置https代理

创建证书

# 生成证书

openssl req -x509 -sha256 -nodes -days 365 -newkey rsa:2048 -keyout tls.key -out tls.crt -subj "/C=CN/ST=BJ/L=BJ/O=nginx/CN=itheima.com"

# 创建密钥

kubectl create secret tls tls-secret --key tls.key --cert tls.crt

创建ingress-https.yaml

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: ingress-https

namespace: dev

spec:

tls:

- hosts:

- nginx.ydq.com

- tomcat.ydq.com

secretName: tls-secret # 指定秘钥

rules:

- host: nginx.itheima.com

http:

paths:

- path: /

backend:

serviceName: nginx-service

servicePort: 80

- host: tomcat.itheima.com

http:

paths:

- path: /

backend:

serviceName: tomcat-service

servicePort: 8080

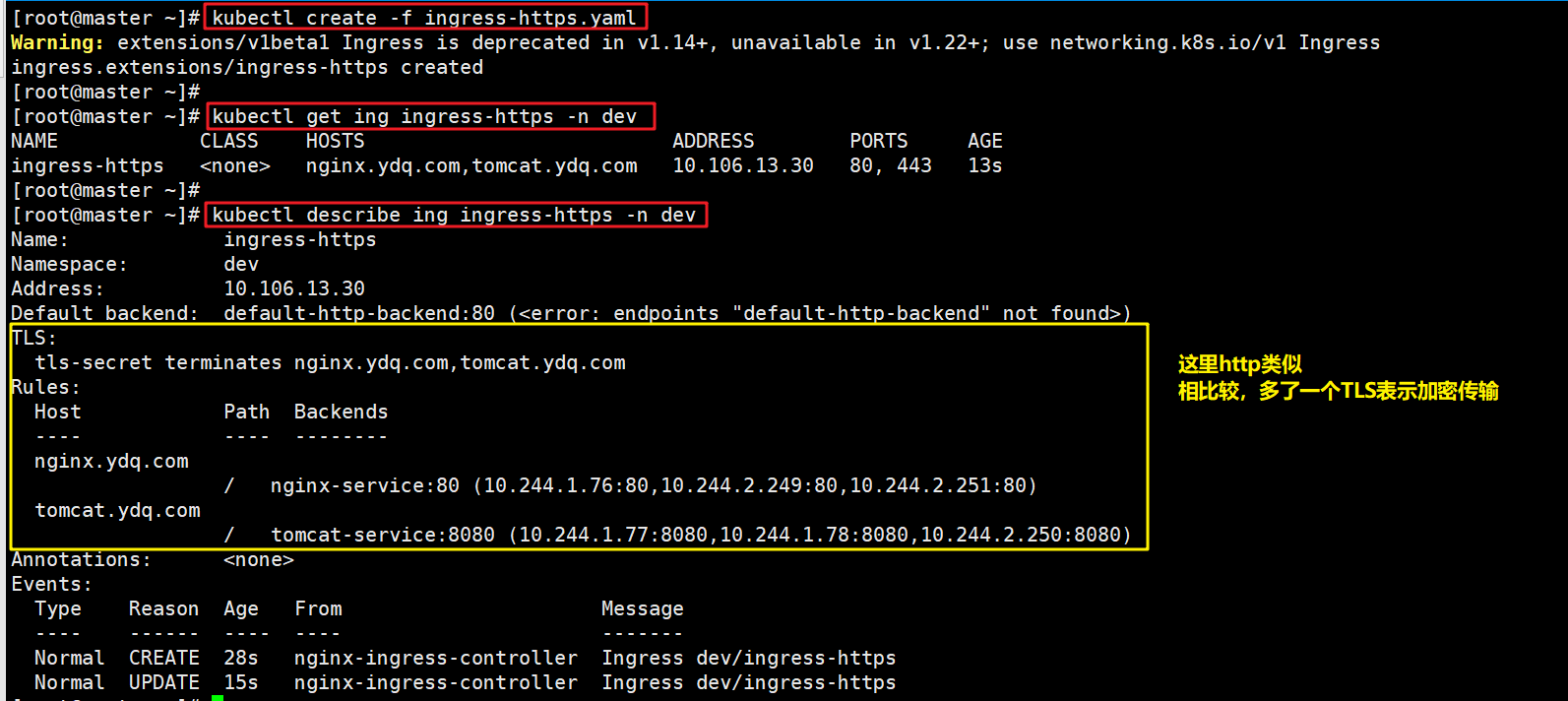

kubectl create -f ingress-https.yaml

#创建https的ingress

kubectl get ing ingress-https -n dev

#查看ingress的信息

kubectl describe ing ingress-https -n dev

#查看详细信息

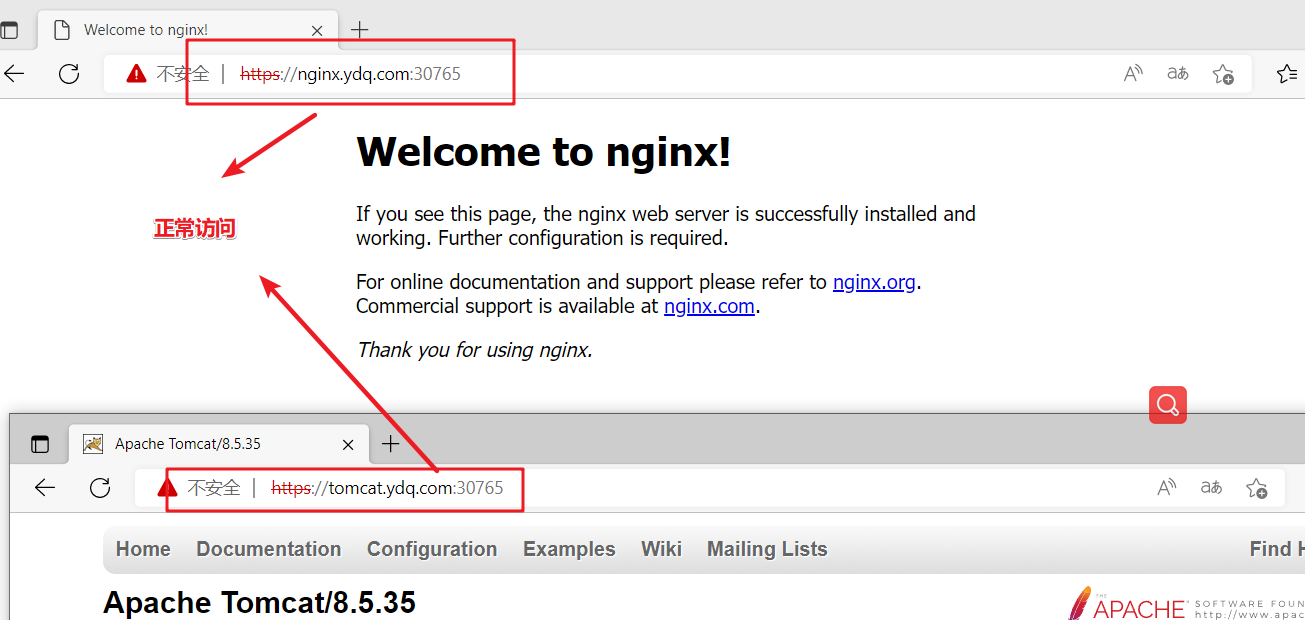

最后,也是通过宿主机访问域名,然后再访问ingress暴露的https的端口,进行查看

kubectl get svc -n ingress-nginx

#查看ingress暴露的端口

https://nginx.ydq.com:30765

https://tomcat.ydq.com:30765

#宿主机访问

4.3 ingress总结

ingress主要就是先创建ingress环境,ingress环境就是需要生成含有ingress的pod,以及ingress暴露的端口。最后通过配置ingress类型的service中配置一些ingress的转发规则,将请求转发到指定的service上面,然后用户通过访问ingress的上面定义的域名以及ingress上面暴露的端口进行访问指定service,可以配置http或https进行相应的访问。

![Azure 深入浅出[2] --- App Service的部署并查看应用Log](https://img-blog.csdnimg.cn/c2a598512ccb433ab9fc29df4ab357df.png)

![[附源码]java毕业设计停车场管理系统](https://img-blog.csdnimg.cn/c5ecaba2e7bf4f54b1387e40e3bd7790.png)