RAG(Retrieval-Augmented Generation)是一种结合了信息检索(Retrieval)和生成模型(Generation)的技术,旨在提高生成模型的性能和准确性。RAG 技术通过在生成过程中引入外部知识库,使得生成模型能够更好地理解和利用外部信息,从而生成更准确、更丰富的内容。具体来说,当模型需要生成文本或者回答问题时,它会先从一个庞大的文档集合中检索出相关的信息,然后利用这些检索到的信息来指导文本的生成,从而提高预测的质量和准确性。

Facebook AI Research(FAIR)团队2020年发表名为《Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks》首次提出了RAG概念。RAG即Retrieval-Augmented Generation,是一种结合检索和生成技术的模型。它通过引用外部知识库的信息来生成答案或内容,具有较强的可解释性和定制能力,适用于问答系统、文档生成、智能助手等多个自然语言处理任务中。RAG模型的优势在于通用性强、可实现即时的知识更新,以及通过端到端评估方法提供更高效和精准的信息服务。

1. RAG 的基本概念

RAG 的核心思想是将生成模型与信息检索系统结合起来,使得生成模型在生成文本时能够动态地检索和利用外部知识库中的信息。具体来说,RAG 模型包括以下几个关键组件:

-

生成模型:通常是一个预训练的语言模型(如GPT、BERT等),负责生成文本。

-

检索系统:负责从外部知识库中检索相关信息,通常使用向量搜索或关键词匹配等技术。

-

知识库:存储大量结构化或非结构化数据,如文本、文档、数据库等。

2. RAG 的工作流程

RAG 的工作流程可以分为以下几个步骤:

2.1 输入处理

首先,将用户的输入(如问题、指令等)传递给生成模型,生成模型会对输入进行初步处理和理解。

2.2 信息检索

生成模型在生成文本的过程中,会根据当前的上下文和生成的内容,动态地调用检索系统,从知识库中检索相关信息。检索系统通常会返回与当前上下文最相关的文档片段或信息片段。

2.3 信息融合

检索到的信息会被融合到生成模型的上下文中,生成模型会结合检索到的信息和当前的上下文,继续生成文本。这一过程可以多次迭代,直到生成完整的文本。

2.4 文本生成

最终,生成模型会根据融合后的上下文,生成最终的输出文本。由于引入了外部知识库的信息,生成的文本通常会更加准确和丰富。

3. RAG 的优势

RAG 技术具有以下几个显著的优势:

3.1 提高生成质量

通过引入外部知识库,RAG 模型能够生成更准确、更丰富的内容。生成模型在生成过程中可以动态地检索和利用外部信息,避免了生成模型在缺乏足够上下文时可能产生的错误或不准确的内容。

3.2 增强可解释性

RAG 模型在生成过程中引入了外部知识库的信息,使得生成过程更加透明和可解释。用户可以清楚地看到生成模型在生成过程中使用了哪些外部信息,从而更容易理解和信任生成的内容。

3.3 灵活性和可扩展性

RAG 模型可以根据需要灵活地引入不同的知识库,从而适应不同的应用场景。知识库可以包含各种类型的信息,如文本、文档、数据库等,使得 RAG 模型具有很强的可扩展性。

3.4 减少幻觉问题

生成模型在缺乏足够上下文时,可能会产生“幻觉”(即生成与事实不符的内容)。RAG 模型通过引入外部知识库,能够减少幻觉问题的发生,生成更符合事实的内容。

4. RAG 的应用场景

RAG 技术在许多领域都有广泛的应用,包括:

4.1 问答系统

在问答系统中,RAG 模型可以根据用户的问题,动态地检索相关信息,并生成准确的答案。由于引入了外部知识库,RAG 模型能够回答更复杂、更专业的问题。

4.2 对话系统

在对话系统中,RAG 模型可以根据对话上下文,动态地检索相关信息,并生成更自然、更丰富的回复。RAG 模型能够更好地理解用户的意图,并提供更有针对性的回复。

4.3 文本生成

在文本生成任务中,RAG 模型可以根据输入的上下文,动态地检索相关信息,并生成更准确、更丰富的文本。例如,在新闻生成、故事生成等任务中,RAG 模型能够生成更符合事实和逻辑的内容。

4.4 知识问答

在知识问答任务中,RAG 模型可以根据用户的问题,动态地检索相关知识,并生成准确的答案。RAG 模型能够处理更复杂、更专业的知识问答任务。

5. RAG 的挑战

尽管 RAG 技术具有许多优势,但在实际应用中仍然面临一些挑战:

5.1 检索效率

检索系统的效率直接影响 RAG 模型的性能。高效的检索系统能够快速地从知识库中检索相关信息,从而提高生成模型的响应速度。

5.2 信息融合

如何有效地将检索到的信息融合到生成模型的上下文中,是一个重要的挑战。信息融合不当可能会导致生成内容的不准确或不连贯。

5.3 知识库的质量

知识库的质量直接影响 RAG 模型的性能。高质量的知识库能够提供准确、丰富的信息,从而提高生成模型的性能。

5.4 模型的复杂性

RAG 模型结合了生成模型和检索系统,模型的复杂性较高。如何有效地训练和部署 RAG 模型,是一个重要的挑战。

6. RAG 应用实践

RAG 技术通过结合信息检索和生成模型,能够显著提高生成模型的性能和准确性。RAG 模型在生成过程中动态地检索和利用外部知识库的信息,生成更准确、更丰富的内容。RAG 技术在问答系统、对话系统、文本生成等领域具有广泛的应用前景,但也面临检索效率、信息融合、知识库质量等挑战。随着技术的不断发展,RAG 技术有望在更多领域发挥重要作用。构建一个基于开源大模型的RAG(Retrieval-Augmented Generation)系统涉及多个步骤,包括数据检索、模型选择、模型微调、以及系统集成。

首先,你需要选择一个适合的开源大模型。常见的开源大模型包括:

-

GPT-2/GPT-3 (OpenAI): 虽然GPT-3不是开源的,但GPT-2是开源的,并且有一些社区改进版本。

-

BERT (Google): 一个强大的预训练模型,适用于文本分类、问答等任务。

-

T5 (Google): 一个多任务模型,可以用于文本生成、翻译、问答等。

-

GPT-Neo/GPT-J (EleutherAI): 社区开发的GPT-3替代品,性能接近GPT-3。

-

LLaMA (Meta): 一个较新的开源大模型,性能优异。

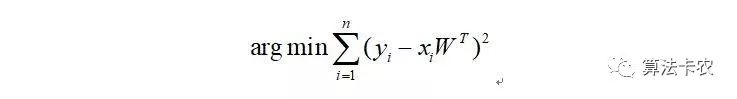

RAG的核心是检索增强生成,因此你需要一个高效的数据检索系统。常见的检索方法包括:

-

TF-IDF: 适用于简单的文本检索。

-

BM25: 改进的TF-IDF,适用于更复杂的检索任务。

-

Dense Retrieval (如DPR): 使用预训练的嵌入模型(如BERT)进行检索。

这里我们可以使用开源的检索库,如:

-

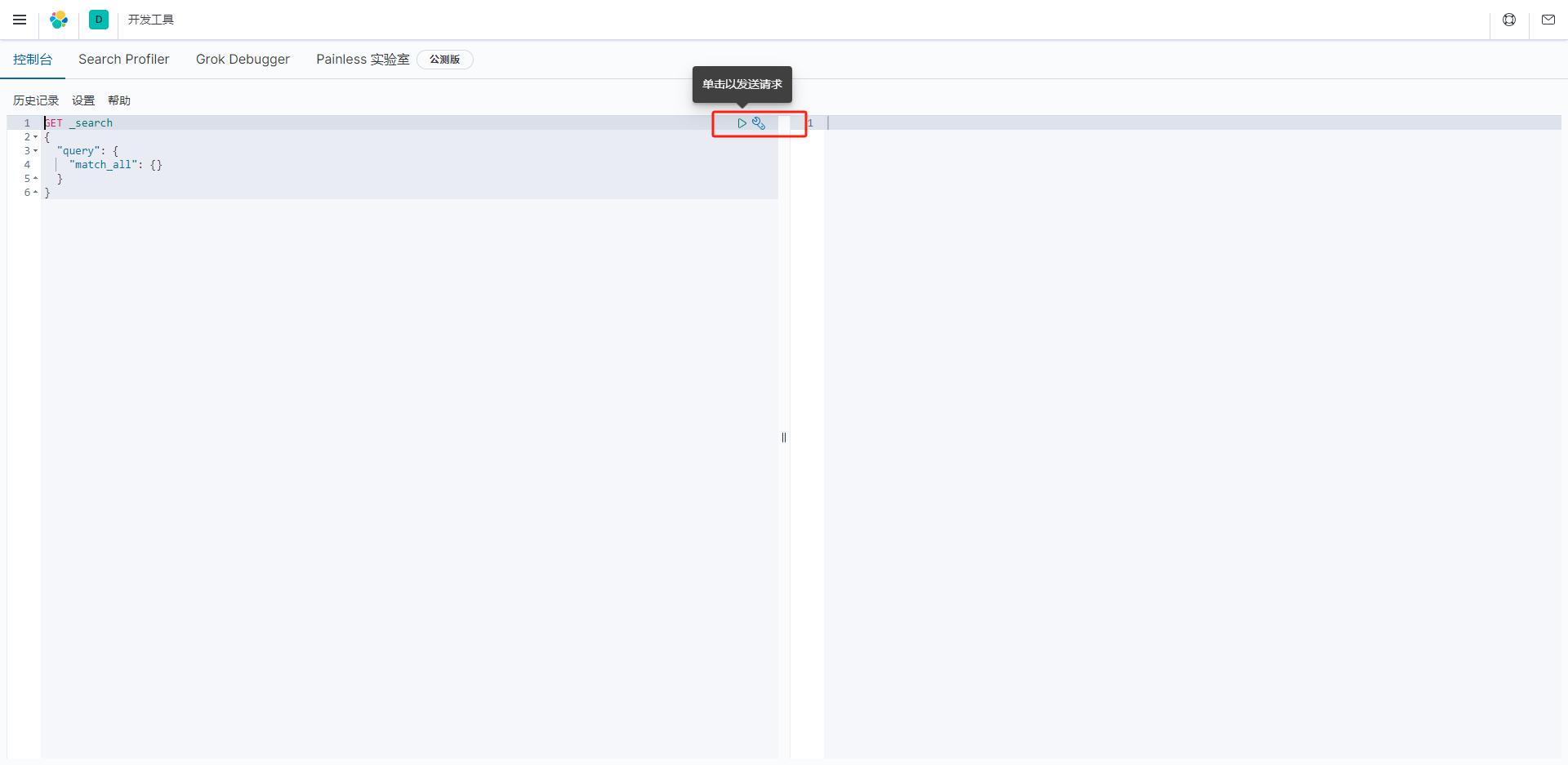

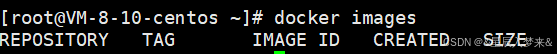

Elasticsearch: 一个强大的全文搜索引擎。

-

FAISS (Facebook AI Similarity Search): 一个高效的向量检索库。

-

Pyserini: 一个基于Lucene的Python接口,支持BM25和Dense Retrieval。

选择好想要使用的模型权重和检索技术之后就可以尝试构建自己的RAG了,但是如果自己的应用场景比较垂直化,这里可以考虑基于自己场景下构建数据集来对开源大模型的效果进行微调,这里就不再展开去说了。一个Demo实例如下:

from transformers import AutoModelForSeq2SeqLM, AutoTokenizer, Trainer, TrainingArguments

# 加载预训练模型和分词器

model_name = "t5-small"

model = AutoModelForSeq2SeqLM.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name)

# 准备训练数据

train_dataset = ... # 你的训练数据

# 定义训练参数

training_args = TrainingArguments(

output_dir="./results",

evaluation_strategy="epoch",

learning_rate=2e-5,

per_device_train_batch_size=8,

per_device_eval_batch_size=8,

num_train_epochs=3,

weight_decay=0.01,

)

# 定义Trainer

trainer = Trainer(

model=model,

args=training_args,

train_dataset=train_dataset,

eval_dataset=eval_dataset,

)

# 开始训练

trainer.train()最后实现需要将检索系统和生成模型集成在一起,整体计算流程如下:

-

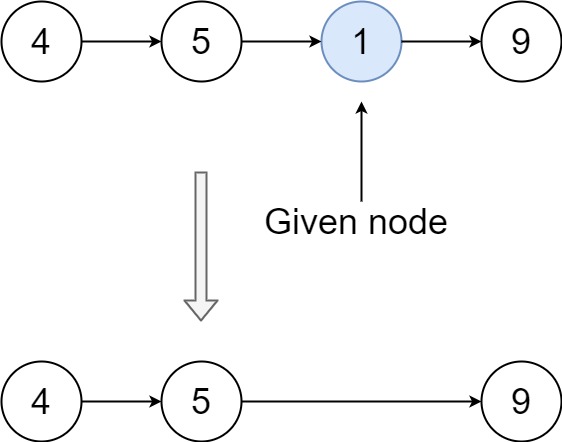

用户输入问题。

-

检索系统根据问题从知识库中检索相关文档。

-

生成模型根据检索到的文档生成答案。

简单的实现如下:

from flask import Flask, request, jsonify

from transformers import pipeline

app = Flask(__name__)

# 加载微调后的模型

generator = pipeline("text2text-generation", model="./results")

# 检索函数

def retrieve_documents(query):

# 这里实现你的检索逻辑

return ["相关文档1", "相关文档2"]

@app.route("/generate", methods=["POST"])

def generate():

data = request.json

query = data["query"]

# 检索相关文档

documents = retrieve_documents(query)

# 生成答案

input_text = f"{query} [SEP] {' '.join(documents)}"

answer = generator(input_text, max_length=100)

return jsonify({"answer": answer[0]["generated_text"]})

if __name__ == "__main__":

app.run(debug=True)当然了我们大可以直接使用开源的模型权重,亦或是直接调用各大厂商提供的API接口来构建实践我的应用程序,如果自己可以使用OpenAI的功能的话,构建RAG会更加简单。

from llama_index.llms.openai import *

from llama_index.embeddings.openai import *

from llama_index.core import *

# 参数配置

Settings.llm = llm

Settings.embed_model = embed_model

# 模型初始化

llm = OpenAI(model="gpt-4o")

# 嵌入初始化

embed_model = OpenAIEmbedding(model="text-embedding-3-small")

# 加载外部数据

data = SimpleDirectoryReader(input_dir="data/",required_exts=[".docx"]).load_data()

# 向量化索引存储

index = VectorStoreIndex.from_documents(data)

# 查询引擎

query_engine = index.as_query_engine(similarity_top_k=3)

# 生成

response = query_engine.query("碳硅化合物分子结构是什么?")

print(response)借助于预先提供的外部专业领域的数据内容,可以帮助模型生成这个垂直细分领域下更加精细细腻的内容,而无需完全基于这个专业领域去开发训练新的模型权重。这里还可以设定内存缓存记录,让模型对历史的对话或者是内容具备记忆功能:

memory = ChatMemoryBuffer.from_defaults(token_limit=4500)

chat_engine = CondensePlusContextChatEngine.from_defaults(

index.as_retriever(),

memory=memory,

llm=llm

)

response = chat_engine.chat(

"超导材料一般具备什么样的共性?"

)

print(str(response))这里我们从初步学习了解的角度出发,整体学习了解了RAG技术的相关概念、背景、内容,最后基于开源框架实践了简单的应用程序,感兴趣的话也都可以选择自己喜欢的大模型和对应的检索框架来构建自己的RAG应用程序。