文章目录

- 0、IA-3基本原理

- 1、IA-3微调实战

- 1.1、导包

- 1.2、加载数据集

- 1.3、数据预处理

- 1.4、创建模型

- 1.5、LORA微调

- 1.5.1、配置文件

- 1.5.2、创建模型

- 1.6、配置训练参数

- 1.7、创建训练器

- 1.8、模型训练

- 1.9、模型推理

0、IA-3基本原理

IA3的基本思想就是抑制和放大内部激活,通过可学习的向量对激活值进行抑制或放大。具体来说,会对K、VFFN三部分的值进行调整,训练过程中同样冻结原始模型的权重,只更新可学习的部分向量部分。训练完成后,与Lora类似,也可以将学习部分的参数与原始权重合并,没有额外推理开销。

1、IA-3微调实战

1.1、导包

from datasets import Dataset

from transformers import AutoTokenizer, AutoModelForCausalLM, DataCollatorForSeq2Seq, TrainingArguments, Trainer

1.2、加载数据集

ds = Dataset.load_from_disk("../Data/alpaca_data_zh/")

ds

1.3、数据预处理

tokenizer = AutoTokenizer.from_pretrained("../Model/bloom-389m-zh")

tokenizer

def process_func(example):

MAX_LENGTH = 256

input_ids, attention_mask, labels = [], [], []

instruction = tokenizer("\n".join(["Human: " + example["instruction"], example["input"]]).strip() + "\n\nAssistant: ")

response = tokenizer(example["output"] + tokenizer.eos_token)

input_ids = instruction["input_ids"] + response["input_ids"]

attention_mask = instruction["attention_mask"] + response["attention_mask"]

labels = [-100] * len(instruction["input_ids"]) + response["input_ids"]

if len(input_ids) > MAX_LENGTH:

input_ids = input_ids[:MAX_LENGTH]

attention_mask = attention_mask[:MAX_LENGTH]

labels = labels[:MAX_LENGTH]

return {

"input_ids": input_ids,

"attention_mask": attention_mask,

"labels": labels

}

tokenized_ds = ds.map(process_func, remove_columns=ds.column_names)

tokenized_ds

1.4、创建模型

model = AutoModelForCausalLM.from_pretrained("../Model/bloom-389m-zh", low_cpu_mem_usage=True)

1.5、LORA微调

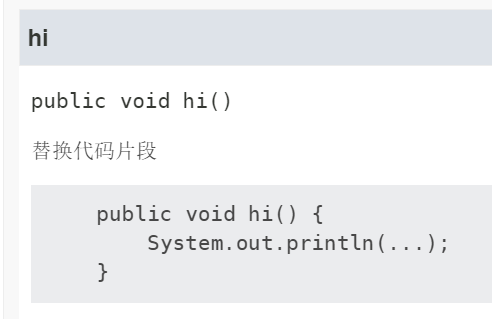

1.5.1、配置文件

from peft import IA3Config, TaskType, get_peft_model

config = IA3Config(task_type=TaskType.CAUSAL_LM)

config

1.5.2、创建模型

model = get_peft_model(model, config)

model.print_trainable_parameters()

1.6、配置训练参数

args = TrainingArguments(

output_dir="./chatbot",

per_device_train_batch_size=1,

gradient_accumulation_steps=8,

logging_steps=10,

num_train_epochs=1,

learning_rate=3e-3

)

1.7、创建训练器

trainer = Trainer(

model=model,

args=args,

train_dataset=tokenized_ds,

data_collator=DataCollatorForSeq2Seq(tokenizer=tokenizer, padding=True),

)

1.8、模型训练

trainer.train()

1.9、模型推理

model = model.cuda()

ipt = tokenizer("Human: {}\n{}".format("考试有哪些技巧?", "").strip() + "\n\nAssistant: ", return_tensors="pt").to(model.device)

tokenizer.decode(model.generate(**ipt, max_length=128, do_sample=True)[0], skip_special_tokens=True)