【深度学习】【TensorRT】【C++】模型转化、环境搭建以及模型部署的详细教程

提示:博主取舍了很多大佬的博文并亲测有效,分享笔记邀大家共同学习讨论

文章目录

- 【深度学习】【TensorRT】【C++】模型转化、环境搭建以及模型部署的详细教程

- 前言

- 模型转换--pytorch转engine

- Windows平台搭建依赖环境

- 安装TensorRT

- 安装OpenCV

- 简化部署

- TensorRT调用onnx模型

- TensorRT推理核心流程

- ONNXRuntime推理代码

- 总结

前言

NVIDIA TensorRT 是一款由英伟达推出的高性能深度学习推理优化库,专门针对NVIDIA的GPU硬件进行优化。它能够将深度学习模型转换为优化的推理引擎,从而在保持精度的同时提高推理速度和效率。TensorRT 专注于优化和加速机器学习模型的推理阶段,特别是对于大规模部署和实时应用场合。TensorRT 的设计目的是为了提供一个高度优化的执行环境,利用 NVIDIA GPU 的硬件特性来实现极致的性能优化。

TensorRT是对NVIDIA GPU最原生的支持。

模型转换–pytorch转engine

Pytorch模型转ENGINE并推理的步骤如下:

- 将PyTorch预训练模型文件( .pth 或 .pt 格式)转换成ONNX格式的文件(.onnx格式),这一转换过程在PyTorch环境中进行。

- 将转换得到的 .onnx 文件再次转换成ENGINE格式的文件(.engine格式),这一转换过程在安装的TensorRT版本的bin目录下通过trtexec.exe转化而成。

- 将转换得到的 .engine文件随后作为输入,调用TensorRT的C++ API来执行模型的推理。

博主使用AlexNet图像分类(五种花分类)进行演示,需要安装pytorch环境,对于该算法的基础知识,可以参考博主【AlexNet模型算法Pytorch版本详解】博文

conda create --name AlexNet python==3.10

conda activate AlexNet

# 根据自己主机配置环境

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

# 假设模型转化出错则降级为指定1.16.1版本

pip install onnx==1.16.1

然后把训练模型好的AlexNet.pth模型转成AlexNet.onnx模型,pyorch2onnx.py转换代码如下:

import torch

from model import AlexNet

model = AlexNet(num_classes=5)

weights_path = "./AlexNet.pth"

# 加载模型权重

model.load_state_dict(torch.load(weights_path))

# 模型推理模式

model.eval()

model.cpu()

# 虚拟输入数据

dummy_input1 = torch.randn(1, 3, 224, 224)

# 模型转化函数

torch.onnx.export(model, (dummy_input1), "AlexNet.onnx", verbose=True, opset_version=11)

cmd进入安装好的tensorrt中的bin路径下,将AlexNet.onnx拷贝至此,执行以下命令转成AlexNet.engine模型。安装tensorrt在下一小节中具体讲述。

trtexec.exe --onnx=AlexNet.onnx --saveEngine=AlexNet.engine

【AlexNet.pth百度云链接,提取码:ktq5 】直接下载使用即可。

Windows平台搭建依赖环境

安装TensorRT

官网下载安装文件地址,根据自己的情况选择合适的版本【官方说明】。

推荐优先选择的8.6版本

博主的cuda版本是11.8,cudnn版本是8.9.7,因此选择TensorRT v8.6版本。

cmd命令框下输入nvcc -V 查询cuda版本;

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\vxx.x\include\cudnn_version.h 查看cuda版本.

在TensorRT 10.4 GA下选择TensorRT-8.6.1.6.Windows10.x86_64.cuda-11.8.zip下载

双击运行解压后即可:

打开VS 2019:新建新项目---->空项目---->配置项目---->项目路径以及勾选“将解决方案和项目放在同一目录中---->点击创建。

在解决方案–>源文件–>右键添加新建项。这里暂时可以默认空着不做处理。

配置tensorrt:项目---->属性。假设没有新建cpp文件,空项目的属性页就不会存在C/C++这一项目。

添加附加包含目录:Release | x64---->C/C+±—>常规---->附加包含目录。

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8\include

D:\C++_demo_tensort\TensorRT-8.6.1.6\include

链接器:Release | x64---->链接器---->常规---->附加库目录。

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8\lib\x64

D:\C++_demo_tensort\TensorRT-8.6.1.6\lib

链接器:Release | x64---->链接器---->输入---->附加依赖项。

在C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8\lib\x64和D:\C++_demo_tensort\TensorRT-10.4.0.26\lib下找到附加依赖项的文件(.lib文件)。

nvinfer_dispatch.lib

nvinfer_lean.lib

nvinfer_plugin.lib

nvinfer_vc_plugin.lib

nvonnxparser.lib

nvparsers.lib

nvinfer.lib

cublas.lib

cublasLt.lib

cuda.lib

cudadevrt.lib

cudart.lib

cudart_static.lib

cudnn.lib

cudnn64_8.lib

cudnn_adv_infer.lib

cudnn_adv_infer64_8.lib

cudnn_adv_train.lib

cudnn_adv_train64_8.lib

cudnn_cnn_infer.lib

cudnn_cnn_infer64_8.lib

cudnn_cnn_train.lib

cudnn_cnn_train64_8.lib

cudnn_ops_infer.lib

cudnn_ops_infer64_8.lib

cudnn_ops_train.lib

cudnn_ops_train64_8.lib

cufft.lib

cufftw.lib

cufilt.lib

curand.lib

cusolver.lib

cusolverMg.lib

cusparse.lib

nppc.lib

nppial.lib

nppicc.lib

nppidei.lib

nppif.lib

nppig.lib

nppim.lib

nppist.lib

nppisu.lib

nppitc.lib

npps.lib

nvblas.lib

nvinfer.lib

nvinfer_dispatch.lib

nvinfer_lean.lib

nvinfer_plugin.lib

nvinfer_vc_plugin.lib

nvjpeg.lib

nvml.lib

nvonnxparser.lib

nvparsers.lib

nvptxcompiler_static.lib

nvrtc-builtins_static.lib

nvrtc.lib

nvrtc_static.lib

OpenCL.lib

安装OpenCV

官网下载安装文件地址,博主使用opencv-4.8.0-windows.exe版本

双击运行解压后即可,博主重命名为opencv4.8.0:

直接下载的opencv-4.8.0-windows.exe部分功能不完整,如读取视频这类功能,假如需要完整的功能则需要自己编译,参考windows10下opencv4.8.0-cpu C++版本源码编译教程,这里博主也提供了编译好的opencv4.8.0-cpu.rar【百度网盘,提取码:22r3】。目录格式仿造着opencv-4.8.0-windows.exe的目录格式。

添加附加包含目录:Release | x64---->C/C++—>常规---->附加包含目录。

D:\C++_demo_tensort\opencv4.8.0\build\include

链接器:Release | x64---->链接器---->常规---->附加库目录。

D:\C++_demo_tensort\opencv4.8.0\build\x64\vc16\lib

链接器:Release | x64---->链接器---->输入---->附加依赖项。

opencv_world480.lib

简化部署

在Release x64模式下测试时,需要将TensorRT所需的.dll文件,以及OpenCV的.dll文件复制到自己项目的Release下。

D:\C++_demo_tensort\TensorRT-8.6.1.6\lib

D:\C++_demo_tensort\opencv4.8.0\build\x64\vc16\bin

===>

D:\C++_demo_tensort\tensorrt\x64\Release

没有Release目录时,需要在Release | x64模式下运行一遍代码,代码部分在下面提供,读者可以先行新建文件复制代码。

将所有的.dll文件和.exe文件放在同一个目录下可以简化应用程序的部署过程。用户无需手动配置环境变量或安装额外的组件即可运行程序。

为什么CUDA的.dll文件不需要复制,是因为在环境变量Path中设置了CUDA的全局访问。操作系统在加载 .dll 文件时会先检查当前目录(即.exe文件所在的目录),然后检查Path环境变量中列出的所有目录。

TensorRT调用onnx模型

TensorRT推理核心流程

初始化推理运行时对象

返回一个指向IInferRuntime接口的指针,它包含了日志记录器设置。

nvinfer1::IRuntime* runtime = nvinfer1::createInferRuntime(gLogger);

| nvinfer1::createInferRuntime参数 | 日志记录器 (ILogger) |

|---|---|

| 作用 | 用于记录 TensorRT 在执行过程中产生的日志信息,包括错误、警告和调试信息。通过这个参数,用户可以控制日志输出的行为,比如日志等级和输出目的地。 |

| 内容 | kINTERNAL_ERROR:内部错误,表示遇到了不应该发生的问题;kERROR:错误,表示应用程序出现了严重的问题,可能导致无法继续执行;kWARNING:警告,表示可能存在潜在问题,但程序可以继续运行;kINFO:信息,用于提供普通的信息性消息;kVERBOSE:详细信息,用于提供详细的调试信息。 |

加载预先构建好的引擎

从包含 TensorRT 引擎数据的序列化的字节流中反序列化恢复出一个可以用于执行推理的 CUDA 引擎对象。

nvinfer1::ICudaEngine* engine = runtime->deserializeCudaEngine(trtModelStream, size);

| deserializeCudaEngine参数 | const void memory* | size_t length |

|---|---|---|

| 内容 | 指向包含序列化引擎数据的内存区域的字节数组指针 | 序列化引擎数据的实际长度 |

创建执行上下文

创建一个包含了所有必要的信息的执行上下文。

nvinfer1::IExecutionContext* context = engine->createExecutionContext();

| createExecutionContext参数 | — |

|---|---|

| 作用 | 用于在实际执行推理时绑定输入和输出缓冲区,并设置其他执行参数,负责管理执行时的内存分配和释放,以及执行引擎的初始化和清理工作。 |

获取模型输入输出信息

从nvinfer1::ICudaEngine对象中获取模型输入和输出的详细信息,包括数量、名称和形状。

int num_bindings = engine->getNbBindings();

const char* binding_name = engine->getBindingName(i);

int input_index = engine->getBindingIndex(input_names[0]);

int input_h = engine->getBindingDimensions(input_index).d[2];

getBindingIndex的名字可以直接通过【ONNX模型在线查看工具】直接查询输入输出的名字,而不需要再通过getBindingName去查询判断对应的输入输出名称。

预处理输入数据

对输入数据进行颜色空间转换,尺寸缩放、标准化以及形状维度扩展操作。

cv::cvtColor(image, rgb, cv::COLOR_BGR2RGB);

cv::resize(rgb, blob, cv::Size(input_w, input_h));

blob.convertTo(blob, CV_32F);

blob = blob / 255.0;

cv::subtract(blob, cv::Scalar(0.485, 0.456, 0.406), blob);

cv::divide(blob, cv::Scalar(0.229, 0.224, 0.225), blob);

cv::Mat tensor = cv::dnn::blobFromImage(blob);

这部分不是TensorRT核心部分,根据任务需求不同,代码略微不同。

推理准备

在设备内存(GPU)中分配输入输出缓冲区(一段连续的内存空间)。

cudaMalloc(&buffers[input_index], input_h*input_w*3*sizeof(float));

cudaMalloc(&buffers[output_index], output_h*output_w*sizeof(float));

| cudaMalloc参数 | ptr | size |

|---|---|---|

| 内容 | 一个指向 void** 的指针 | 分配以字节为单位的内存大小 |

执行推理

将主机内存(CPU)中的数据复制到设备内存(GPU)中,执行推理操作,然后再将结果从设备内存复制回主机内存。

cudaMemcpyAsync(buffers[0], tensor.ptr<float>(), input_h * input_w * 3 * sizeof(float), cudaMemcpyHostToDevice, stream);

context->enqueueV2(buffers, stream, nullptr);

cudaMemcpyAsync(prob.data(), buffers[1], output_h * output_w * sizeof(float), cudaMemcpyDeviceToHost, stream);

| 函数 | cudaMemcpyAsync | enqueueV2 |

|---|---|---|

| 作用 | 在不同内存区域之间异步复制数据。 | 在给定的执行上下文中执行一次推理操作。 |

| 参数一 | dst:目标地址,数据将被复制到这里。 | bindings:指向 void* 数组的指针,包含了所有输入和输出缓冲区的指针,每个元素对应一个输入或输出绑定,顺序与模型中绑定的顺序一致。 |

| 参数二 | src:源地址,数据将从这里被复制。 | stream:CUDA 流对象,用于调度异步操作。 |

| 参数三 | count:要复制的字节数。 | sharedMem:一个指向共享内存的指针,通常传递 nullptr,用于高级用法,如使用专用的共享内存。 |

| 参数四 | kind:复制类型,指示复制的方向。cudaMemcpyHostToDevice:从主机内存复制到设备内存;cudaMemcpyDeviceToHost:从设备内存复制到主机内存;cudaMemcpyDeviceToDevice:在设备内存内部复制;cudaMemcpyHostToHost:在主机内存内部复制;cudaMemcpyDefault:由 CUDA 自动选择复制方向。 | – |

| 参数五 | stream:CUDA 流对象,用于调度异步操作。 | – |

后处理推理结果

推理完成后,从输出张量中获取结果数据,根据需要对结果进行后处理,以获得最终的预测结果。

cv::Mat probmat(output_h, output_w, CV_32F, (float*)prob.data());

cv::minMaxLoc(probmat, &minv, &maxv, &minL, &maxL);

这部分不是TensorRT核心部分,根据任务需求不同,代码基本不同。

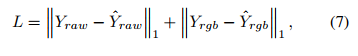

ONNXRuntime推理代码

需要配置flower_classes.txt文件存储五种花的分类标签,并将其放置到工程目录下(推荐)。

daisy

dandelion

roses

sunflowers

tulips

这里需要将AlexNet.engine放置到工程目录下(推荐),并且将以下推理代码拷贝到新建的cpp文件中,并执行查看结果。

#include <fstream>

#include <iostream>

#include <sstream>

#include <opencv2/opencv.hpp>

#include "NvInfer.h"

// 记录 TensorRT 运行时的日志信息

class Logger : public nvinfer1::ILogger

{

void log(Severity severity, const char* msg) noexcept

{

// suppress info-level messages

if (severity != Severity::kINFO)

std::cout << msg << std::endl;

}

} gLogger;

// 加载标签文件获得分类标签

std::string labels_txt_file = "D:/C++_demo_tensort/tensorrt/flower_classes.txt";

std::vector<std::string> readClassNames();

std::vector<std::string> readClassNames()

{

std::vector<std::string> classNames;

std::ifstream fp(labels_txt_file);

if (!fp.is_open())

{

printf("could not open file...\n");

exit(-1);

}

std::string name;

while (!fp.eof())

{

std::getline(fp, name);

if (name.length())

classNames.push_back(name);

}

fp.close();

return classNames;

}

int main(int argc, char** argv) {

// 预测的目标标签数

std::vector<std::string> labels = readClassNames();

// engine训练模型文件

std::string enginepath = "D:/C++_demo_tensort/tensorrt/AlexNet.engine";

// 从文件中读取一个序列化的 TensorRT 模型

std::ifstream file(enginepath, std::ios::binary);

char* trtModelStream = NULL;

int size = 0;

if (file.good()) {

// 将读指针移动到文件末尾

file.seekg(0, file.end);

// 获取文件大小

size = file.tellg();

// 将读指针移动到文件开始

file.seekg(0, file.beg);

trtModelStream = new char[size];

assert(trtModelStream);

// 从关联的输入流中读取了指定数量的字符

file.read(trtModelStream, size);

file.close();

}

// 初始化推理运行时对象

nvinfer1::IRuntime* runtime = nvinfer1::createInferRuntime(gLogger);

assert(runtime != nullptr);

// 加载预先构建好的引擎

nvinfer1::ICudaEngine* engine = runtime->deserializeCudaEngine(trtModelStream, size);

assert(this->engine != nullptr);

// 创建执行上下文

nvinfer1::IExecutionContext* context = engine->createExecutionContext();

assert(this->context != nullptr);

// 释放数组类型的内存

delete[] trtModelStream;

// 管理异步操作的流对象

cudaStream_t stream;

// 对象的绑定数量(即输入和输出的总数)

int num_bindings = engine->getNbBindings();

std::cout << " input/outpu : " << num_bindings << std::endl;

// 输入和输出名称

std::vector<const char*> input_names;

std::vector<const char*> output_names;

// 遍历所有绑定

for (int i = 0; i < num_bindings; ++i) {

// 获取绑定名称

const char* binding_name = engine->getBindingName(i);

// 判断当前绑定是输入还是输出,并保存到相应的向量中

if (engine->bindingIsInput(i)) {

input_names.push_back(binding_name);

}

else {

output_names.push_back(binding_name);

}

}

// 用于获取模型输入或输出张量的索引

int input_index = engine->getBindingIndex(input_names[0]);

int output_index = engine->getBindingIndex(output_names[0]);

// 获取输入维度信息 NCHW

int input_h = engine->getBindingDimensions(input_index).d[2];

int input_w = engine->getBindingDimensions(input_index).d[3];

printf("inputH : %d, inputW: %d \n", input_h, input_w);

// 获取输出维度信息

int output_h = engine->getBindingDimensions(output_index).d[0];

int output_w = engine->getBindingDimensions(output_index).d[1];

printf("outputH : %d, outputW: %d \n", output_h, output_w);

// 推理准备

// 包含所有输入和输出缓冲区的指针,每个元素对应一个输入或输出绑定,顺序与模型中绑定的顺序一致

void* buffers[2] = { NULL, NULL };

// 创建GPU显存输入/输出缓冲区(有几个就初始化几个)

cudaMalloc(&buffers[input_index], input_h*input_w*3*sizeof(float));

cudaMalloc(&buffers[output_index], output_h*output_w*sizeof(float));

// 输出结果

std::vector<float> prob;

// 创建临时缓存输出

prob.resize(output_h*output_w);

// 创建cuda流

cudaStreamCreate(&stream);

// 测试图片

cv::Mat image = cv::imread("D:/C++_demo_tensort/tensorrt/sunflowers.jpg");

// 预处理输入数据

cv::Mat rgb, blob;

// 默认是BGR需要转化成RGB

cv::cvtColor(image, rgb, cv::COLOR_BGR2RGB);

// 对图像尺寸进行缩放

cv::resize(rgb, blob, cv::Size(input_w, input_h));

blob.convertTo(blob, CV_32F);

// 对图像进行标准化处理

blob = blob / 255.0;

cv::subtract(blob, cv::Scalar(0.485, 0.456, 0.406), blob);

cv::divide(blob, cv::Scalar(0.229, 0.224, 0.225), blob);

// CHW-->NCHW 维度扩展

cv::Mat tensor = cv::dnn::blobFromImage(blob);

// 内存到GPU显存

cudaMemcpyAsync(buffers[0], tensor.ptr<float>(), input_h*input_w*3*sizeof(float), cudaMemcpyHostToDevice, stream);

// 模型推理

context->enqueueV2(buffers, stream, nullptr);

// GPU显存到内存

cudaMemcpyAsync(prob.data(), buffers[1], output_h*output_w*sizeof(float), cudaMemcpyDeviceToHost, stream);

// 后处理推理结果

cv::Mat probmat(output_h, output_w, CV_32F, (float*)prob.data());

cv::Point maxL, minL; // 用于存储图像分类中的得分最小值索引和最大值索引(坐标)

double maxv, minv; // 用于存储图像分类中的得分最小值和最大值

cv::minMaxLoc(probmat, &minv, &maxv, &minL, &maxL);

int max_index = maxL.x; // 获得最大值的索引,只有一行所以列坐标既为索引

std::cout << "label id: " << max_index << std::endl;

// 在测试图像上加上预测的分类标签

cv::putText(image, labels[max_index], cv::Point(50, 50), cv::FONT_HERSHEY_SIMPLEX, 1.0, cv::Scalar(0, 0, 255), 2, 8);

cv::imshow("输入图像", image);

cv::waitKey(0);

// 同步结束,释放资源

cudaStreamSynchronize(stream);

cudaStreamDestroy(stream);

if (!context) {

context->destroy();

}

if (!engine) {

engine->destroy();

}

if (!runtime) {

runtime->destroy();

}

if (!buffers[0]) {

delete[] buffers;

}

return 0;

}

图片正确预测为向日葵:

总结

尽可能简单、详细的介绍了pytorch模型到engnie模型的转化,C++下TensorRT环境的搭建以及engnie模型的TensorRT部署。

![[C#]winform 使用opencvsharp实现玉米粒计数](https://i-blog.csdnimg.cn/direct/8afef5f08c764fba967ee4595a67841c.jpeg)