OpenAI o1是通过强化学习去进行复杂推理,在它回答之前,他会经过复杂的内部思维链的思考。

经过强化训练的o1多强

1 表现

在美国数学奥林匹克预选赛中名列前500名的学生中,o1排89名

在物理、生物、化学问题的基准测试中超过人类博士水平

其实你都不需要细看每一个数据集是什么含义。

只需要相对对比就知道他有多强了

4o还是蛮厉害的吧

但是在o1 preview和o1面前简直就是一个傻子,很多准确率不是几个几个超越,而是几十几十的超越

降维打击

怪不得OpenAI都直接给他一个新的系列名称了~

2 实现方法

类似于人类在回答一个困难问题之前可能会思考很长时间,o1 在尝试解决问题时使用思维链。通过强化学习,o1 学习完善其思维链并优化所使用的策略。它学会识别和纠正自己的错误。它学会将棘手的步骤分解为更简单的步骤。当当前的方法不起作用时,它学会尝试不同的方法。这个过程显著提高了模型的推理能力。

这也可以解释为什么o1这么贵,因为很多时候,你问一个问题,他会将这个问题反复思考(思考的过程都会消耗tokens,不显示给用户罢了)

在技术报告这里其实OpenAI已经展示了怎么实现的

学习推理与 LLMs | OpenAI — Learning to Reason with LLMs | OpenAI

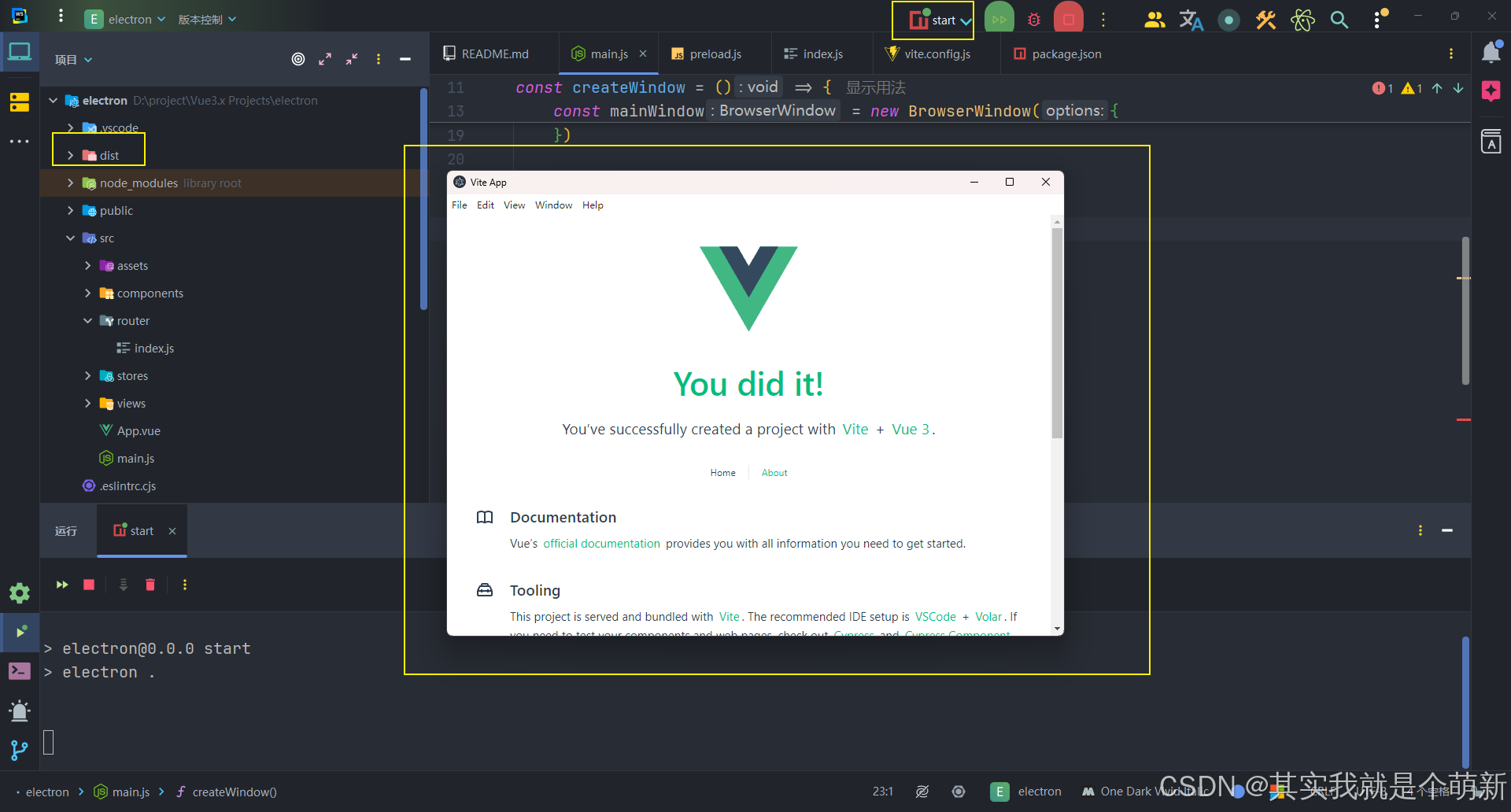

在第一个demo中,对比了4o和o1在解码的过程

可以点击右侧打开思维链条

你会发现非常有趣,就是o1好像在和自己聊天一样,他会不断的向自己提问,然后证明自己的问题是错误的或者是正确的,一步一步向后推进。

3 还没有达到上界?

现在最可怕的是,他其实还没有达到瓶颈期。

可以看报告中放出的这张图

可以看到随着训练时间或者测试时间的加长,准确率依然稳步上升。

有训练过模型的朋友可能知道,训练模型过程中,一般来说,最痛苦的就是准确率很快就达到瓶颈了(往往呈现先升后平),而像上图这样优美的上升曲线简直就是炼丹人的最爱。

那你可能会问,既然增加训练时间o1的性能还在上升,为什么OpenAI不继续增加训练时间看看他最终的效果?

当然,我不是内部人员我也不知道

但我大概可以猜测出,就是训练时间太长太长了。

如果你注意到横轴是log scale即对数尺度就知道了,他这个横轴时间是取了对数的,所以要想提高模型性能,你的训练时间就得指数增加,就已经不是普通人训练几小时甚至几天了,可能是按月或者年了。

这是个好消息也是个坏消息。

好消息是,模型训练依然没有到达瓶颈,OpenAI又一次证明了可能性,人们还是有机会训练出更加智慧更加聪明的AI

坏消息是,训练一次模型的成本指数增加,无论是时间成本还是显卡成本

4 思考

看完还是觉得很牛逼。

思维链还是没变,只不过原本是人类引导模型去一步一步思考,现在变成了通过强化学习让模型自己就可以一步一步反思思考。

AI技术发展我觉得不可避免

但说实话其实我真正担心的是

将这些技术用在国防,科学发现而产生的质的推进。

从而导致国与国的差异更加增大