人工智能咨询培训老师叶梓 转载标明出处

尽管图神经网络(GNNs)在处理图数据方面取得了显著成就,但它们在表达能力和捕获长距离依赖方面存在局限性。为了突破这些局限,研究者们开始探索将Transformer架构应用于图表示学习。在此基础上,瑞士苏黎世联邦理工学院的研究团队提出了一种创新的方法——Structure-Aware Transformer(SAT),旨在通过在自注意力机制中引入基于子图的表示,增强模型对图结构的感知能力,从而在计算注意力时能够显式地考虑节点间的图结构信息。

SAT

在传统的Transformer模型中,自注意力机制仅依赖于节点特征,忽略了节点在图中的结构位置和邻域信息。研究者提出的结构感知自注意力机制,通过引入子图表示来增强模型对图结构的感知能力。

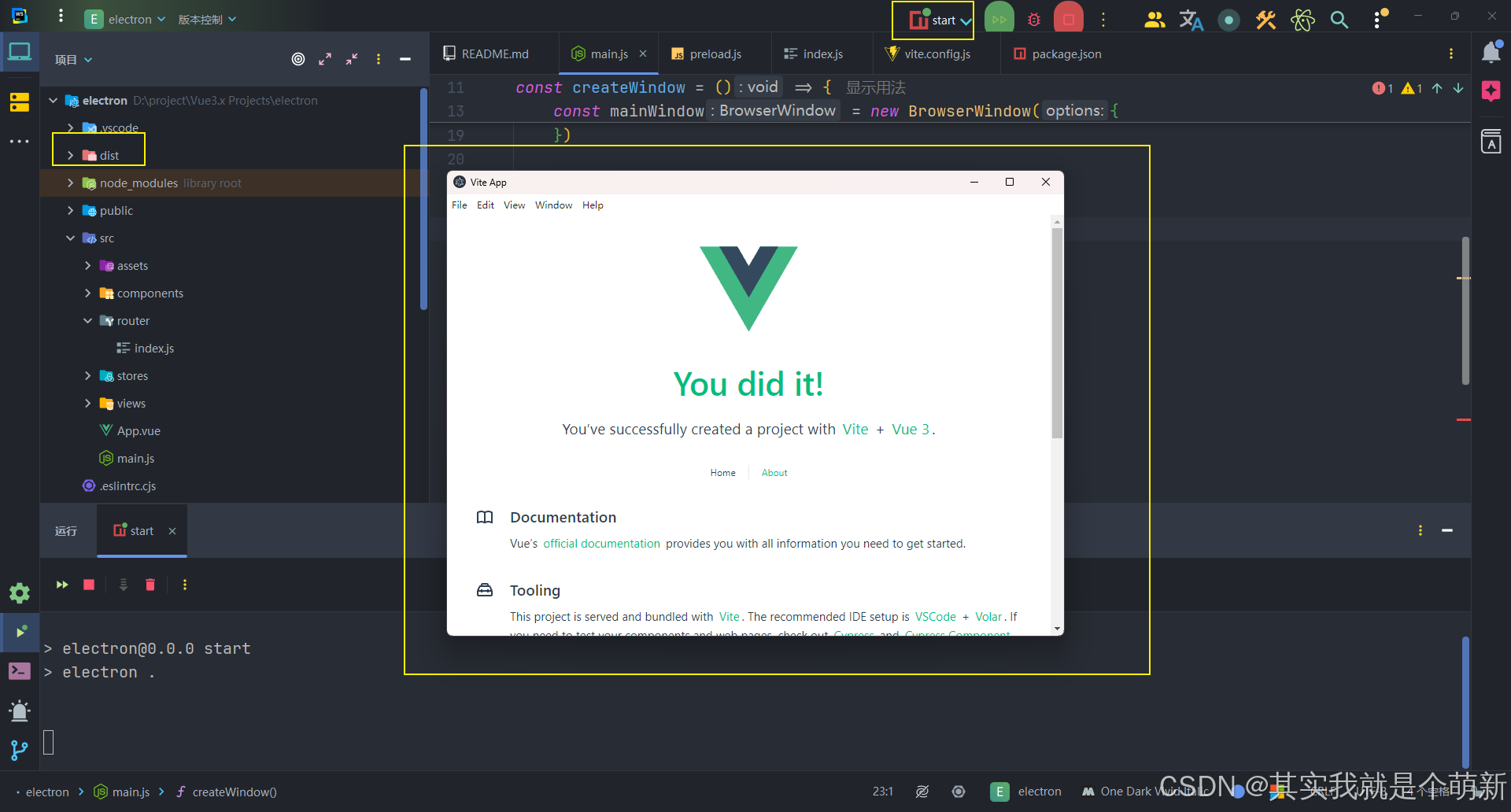

图 2 展示了一个使用k-subgraph GNN提取器作为其结构提取器的SAT层的概述。结构提取器生成结构感知的节点表示,这些表示被用来计算Transformer层中的查询(Q)和键(K)矩阵。具体为k-subgraph GNN提取器首先提取以每个节点为中心的k-hop子图(这里,k=1),然后使用GNN在每个子图上生成节点表示,利用完整的子图信息。

结构感知自注意力函数不仅考虑了节点特征的相似性,还考虑了子图之间的结构相似性。这使得它能够生成比原始自注意力更富有表达性的节点表示。

公式 (5) 定义了结构感知注意力函数 SA-attn(v),其中 SG(v) 表示以节点 v 为中心的子图,与节点特征 X 相关联,κgraph 是可以比较一对子图的核函数。这种自注意力不再是节点排列不变的,而仅在节点的特征和子图相同时才不变,这是理想的属性。

![]()

公式 (6) 提供了 κgraph 的一种形式,它包含了一大类富有表达性且计算上可行的模型。

在定义了结构感知自注意力函数之后,Structure-Aware Transformer的其他组件遵循Transformer架构。如图 2 所示,自注意力函数后面是一个跳跃连接(skip-connection)、一个前馈网络(FFN)以及FFN前后的两个归一化层。另外跳跃连接中还包括了度因子,这有助于减少高度连接的图组件的压倒性影响。

公式 (9) 展示了如何结合自注意力和节点的度来更新节点表示。

对于图属性预测,有多种方法可以将节点级表示聚合成图表示,例如通过取平均或求和。或者,可以使用虚拟 [CLS] 节点的嵌入,该节点附加到输入图上,与其他节点没有连接。

尽管结构感知自注意力已经能够感知结构信息,但大多数绝对编码技术仅是位置感知的,因此可以提供补充信息。实际上结合使用可以进一步提高性能。研究者选择使用随机游走位置编码(RWPE),尽管也可以使用其他任何绝对位置表示,包括可学习的表示。

定理 1 表明,如果两个节点的子图表示相似,那么它们在结构感知注意力之后的表示也会相似。这表明结构感知编码可以生成相似的节点级表示,即使在不同图中,只要它们具有相似的局部结构。

由于结构感知注意力的设计独特,依赖于子图结构提取器,因此可以研究输出表示的表达性。定理 2 表明,结构感知注意力层的节点表示至少与其子图表示一样具有表达性。

通过这些创新,Structure-Aware Transformer在图表示学习领域提供了一种新的视角,有望推动相关技术的发展。

想要掌握如何将大模型的力量发挥到极致吗?叶老师带您深入了解 Llama Factory —— 一款革命性的大模型微调工具。实战专家1小时讲解让您轻松上手,学习如何使用 Llama Factory 微调模型。

评论留言“参加”或扫描微信备注“参加”,即可参加线上直播分享,叶老师亲自指导,互动沟通,全面掌握Llama Factory。关注享粉丝福利,限时免费录播讲解。

LLaMA Factory 支持多种预训练模型和微调算法。它提供灵活的运算精度和优化算法选择,以及丰富的实验监控工具。开源特性和社区支持使其易于使用,适合各类用户快速提升模型性能。

实验

实验中,SAT模型与多种GNNs进行了比较,包括GCN、GraphSAGE、GAT、GIN、PNA、DeeperGCN和ExpC等。同时,也与最近提出的多种基于图的Transformer模型进行了比较,包括原始的Transformer与RWPE、Graph Transformer、SAN、Graphormer和GraphTrans等。

在表1和表2中,SAT模型与其他GNNs和Transformers的性能进行了比较。结果显示,SAT在所有数据集上一致地超越了现有的最先进方法,证明了其结合GNNs和Transformers优势的能力。特别是在CODE2数据集上,尽管参数数量相对较少且仅进行了最小的超参数调整,SAT模型仍然大幅度超越了其他SOTA方法。

在表1和表2中,SAT模型与其他GNNs和Transformers的性能进行了比较。结果显示,SAT在所有数据集上一致地超越了现有的最先进方法,证明了其结合GNNs和Transformers优势的能力。特别是在CODE2数据集上,尽管参数数量相对较少且仅进行了最小的超参数调整,SAT模型仍然大幅度超越了其他SOTA方法。

表3总结了SAT相对于其使用的稀疏GNN的性能,这些GNN用于提取子图表示。在不同的GNN选择中,两种变体的SAT(k-subtree和k-subgraph SAT)始终显著提高了基础GNN的性能,这表明结构感知方法的表达能力得到了显著提升。

超参数k的选择对SAT模型的性能有显著影响。图 3a 展示了在ZINC数据集上,使用PNA和不同k值的k-subtree和k-subgraph提取器时,测试MAE如何变化。结果表明,包含结构信息可以显著提高性能,k=3时性能最佳。与仅使用绝对位置编码的Transformer相比,结构感知注意力在性能上取得了显著提升,如图 3b所示。

除了性能提升外,SAT模型还提供了比仅具有绝对位置编码的经典Transformer更好的模型解释性。通过在Mutagenicity数据集上训练SAT模型和具有CLS读出的Transformer,并可视化[CLS]节点与其他节点之间的注意力分数,如图 4所示。SAT模型能够识别出更多与突变性相关的化学基团(例如NO2和NH2),并且注意力分数更稀疏、更具信息性。

这些实验结果不仅证明了SAT模型在图表示学习任务中的有效性,还展示了其在模型解释性方面的优势,为未来的研究和应用提供了有价值的参考。

https://arxiv.org/pdf/2202.03036v3

GitHub - BorgwardtLab/SAT: Official Pytorch code for Structure-Aware Transformer.

![[Excel VBA]如何使用VBA自动生成图表](https://i-blog.csdnimg.cn/direct/5381427ca0cd4a56be8c26b5c6db923a.png)