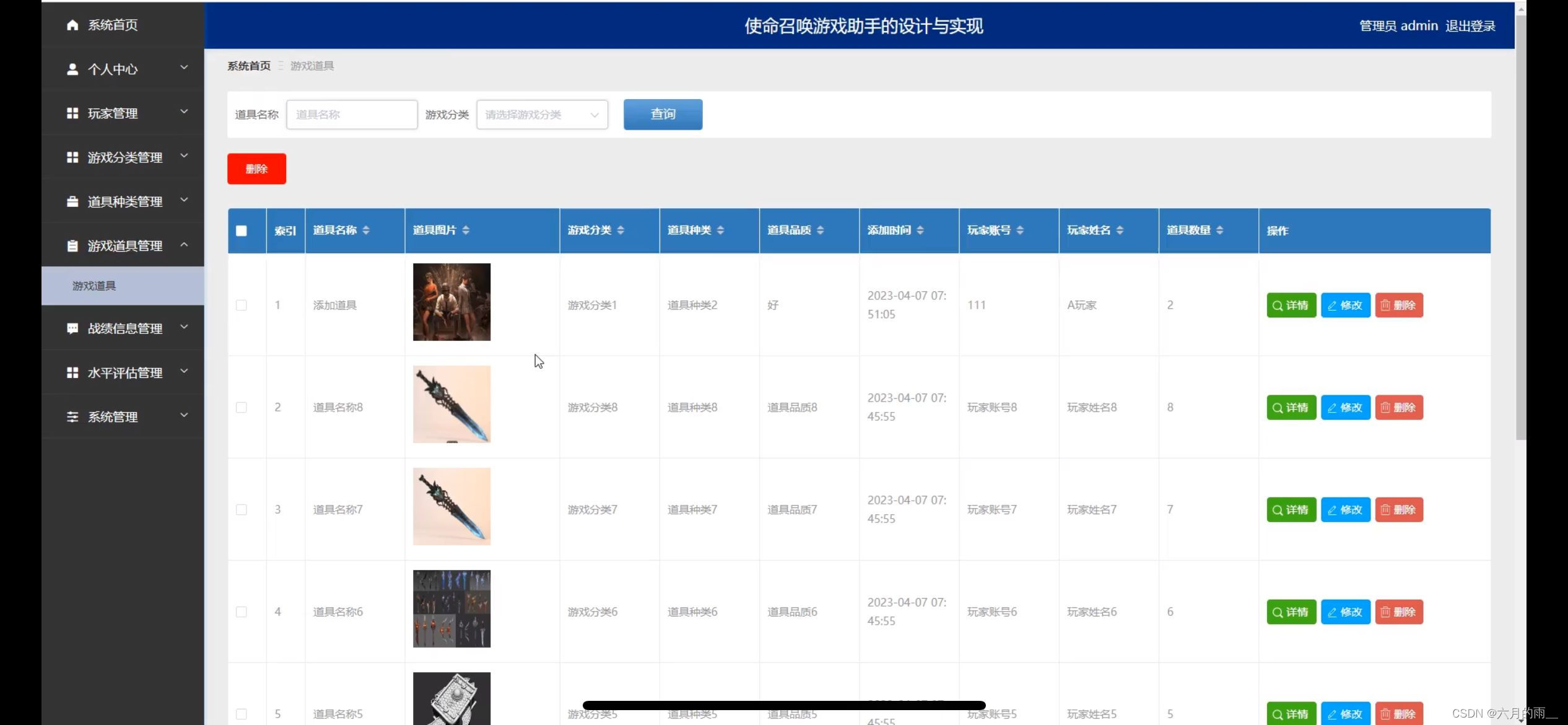

masked autoencoders (MAE)

论文地址:https://arxiv.org/abs/2111.06377

代码地址:https://github.com/facebookresearch/mae

模型结构图:

思想:自监督学习(Self-Supervised Learning),遮住大部分(75%)patches,还原这些patches。

- 包含编码器和解码器两部分,做分类任务等下游任务时,只使用encoder;

- encoder就是VIT;

- decoder计算损耗仅是encoder的10分之一左右;

其他:

给 Encoder 输入 mask tokens,效果是变差的;

VIT直接在ImageNet-1k训练是82.5%,VIT先在ImageNet-21k上通过MAE的方式预训练,再在ImageNet-1k上Fine-tuning是84,.9%;

除了Fine-tuning,还可以Linear Probing (只训练最后一层线性分类器的参数) 。