摘要

论文展示了标准Transformer模型,无需针对图数据的特定修改,就可以在图学习领域取得有希望的结果,无论是在理论还是实践上。作者提出,通过将图中的所有节点和边视为独立的token,并通过适当的token嵌入增强它们,然后将这些token输入到Transformer中,就可以有效地处理图数据。这种方法在大规模图数据集 PCQM4Mv2 上取得了显著优于图神经网络(GNN)基线的结果,并且与具有复杂图特定归纳偏置的Transformer变体相比具有竞争力。

概述

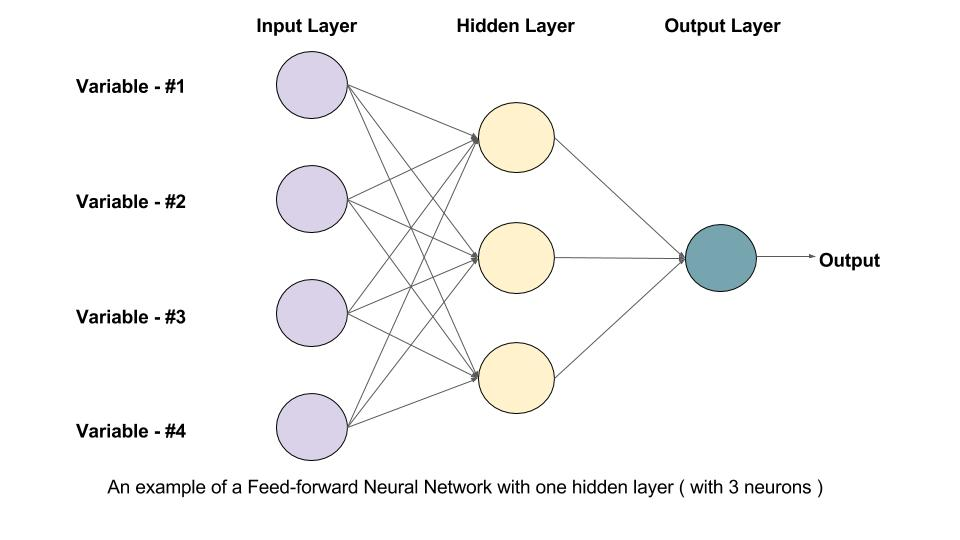

拟解决的问题: 在图学习领域,以往的研究主要集中在图神经网络(GNN)上,这些网络通常依赖于消息传递机制。然而,这些方法可能会受到过平滑(oversmoothing)等问题的影响,并且可能不适用于多任务和多模态的通用注意力架构。论文旨在探索将标准Transformer直接应用于图数据的可能性,并证明其有效性。

创新之处:

- 提出了一种新颖的方法,即Tokenized Graph Transformer(TokenGT),它直接将图的节点和边作为token输入到标准Transformer中,而不依赖于图特定的架构修改。

- 证明了这种方法在理论上至少与二阶不变图网络(2-IGN)一样表达能力强,这意味着它比所有消息传递的GNN都更具表达性。

- 在PCQM4Mv2数据集上的实验结果表明,TokenGT在没有复杂图特定归纳偏置的情况下,仍然能够取得与GNN基线相比更好的性能。

方法

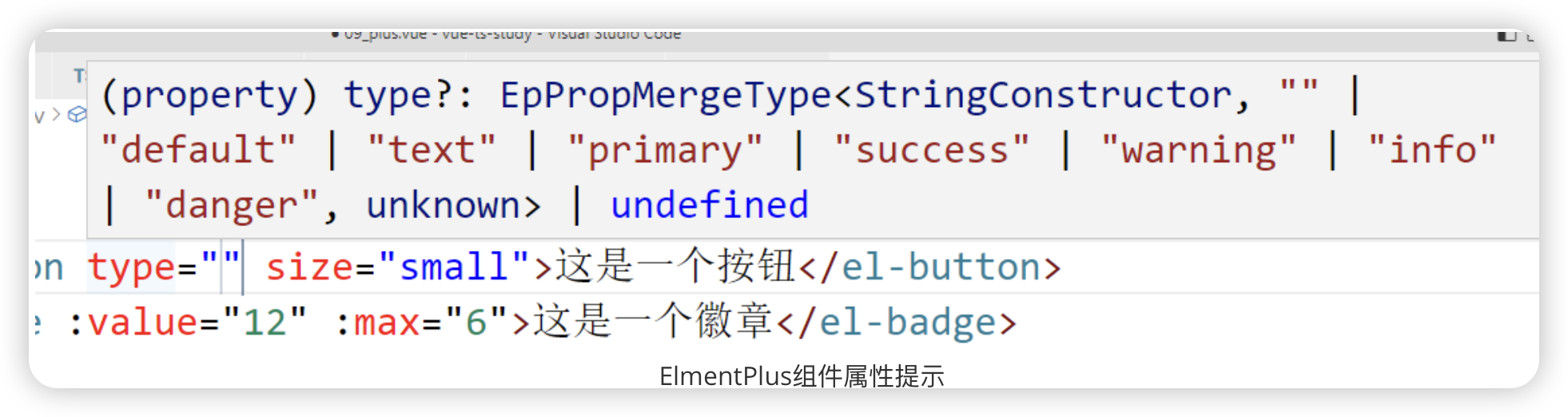

- 将图中的每个节点和边视为独立的token,并为它们分配token嵌入。

- 使用正交节点标识符和可训练的类型标识符来增强token,以保留图的结构信息。

- 将增强后的token输入到标准的Transformer模型中,进行图级别的预测。

处理图的最直接的方法是直接将令牌X作为Transformer的输入,但它是不合适的,因为图的连通性被丢弃。为了彻底表示图结构,我们使用令牌嵌入来增强令牌 X,更具体地说,用于表示令牌的连通性的正交节点标识符和编码令牌是否为节点或边的可训练类型标识符的连接。

定义图为n个节点,m条边。

3.1 Node Identifiers

Node Identifiers 的主要目的是在不直接修改 Transformer 架构的情况下,使模型能够识别和利用图中的节点连接性。这些标识符作为输入图的节点和边的额外信息,被用来增强每个节点和边的表示,从而让 Transformer 能够通过注意力机制识别节点间的连接关系。

3.2 Type Identifiers

Type Identifiers 的主要目的是在模型中明确区分不同类型的图元素,即节点和边。这对于模型正确理解和处理图结构至关重要,尤其是在执行注意力机制时,模型需要知道它正在处理的是节点信息还是边信息。

在 TokenGT 模型中,每个节点 v 的 token 被增强为:

![]()

对于每条边 (u,v),其 token 被增强为:

![]()

是节点标识符,

属于边标识符。

3.3 Main Transformer

Main Transformer 的目的是将增强后的图数据(节点和边作为独立的 tokens)进行有效的处理,以学习图的全局和局部特征。它通过标准的 Transformer 架构,利用自注意力机制(Self-Attention)来捕捉图中节点间的复杂关系。