文章目录

- 常见本地大模型个人知识库工具部署、微调及对比选型

-

- 知识库侧

-

- AnythingLLM

- MaxKB

- RAGFlow

- FastGPT

- Dify

- Open WebUI

- 小结

- 大模型侧

-

- Ollama

- LM Studio

- Xinference

- 小结

- 大模型侧工具安装部署实践

-

- Ollama部署

-

- Windows部署Ollama

- Linux部署Ollama

- Ollama使用技巧

-

- 模型更换存储路径

- 导出某个模型

- 导入某个模型

- 小结

- LM Studio部署

-

- Windows部署LM Studio

- Linux部署LM Studio

- LM Studio本地大模型下载设置

-

- 从魔塔社区下载

- 修改js文件中的默认下载路径

- 小结

- Xinference

-

- Windows 安装 Xinference

- Linux 安装 Xinference

- Xinference使用

-

- Xinference接口

- Xinference多模态模型

- XinferenceEmbedding 模型

- Xinference Rerank 模型

- Xinference 注意事项

- 小结

- 大模型侧工具安装部署总结

常见本地大模型个人知识库工具部署、微调及对比选型

这几年,各种新技术、新产品层出不穷,其中,**大模型(Large Language Models)**作为AI领域的颠覆性创新,凭借其在语言生成、理解及多任务适应上的卓越表现,迅速点燃了科技界的热情。从阿尔法狗的胜利到GPT系列的横空出世,大模型不仅展现了人工智能前所未有的创造力与洞察力,也预示着智能化转型的新纪元。然而,大模型的潜力要真正转化为生产力,实现从实验室到现实世界的平稳着陆,还需跨越理论到实践的鸿沟。

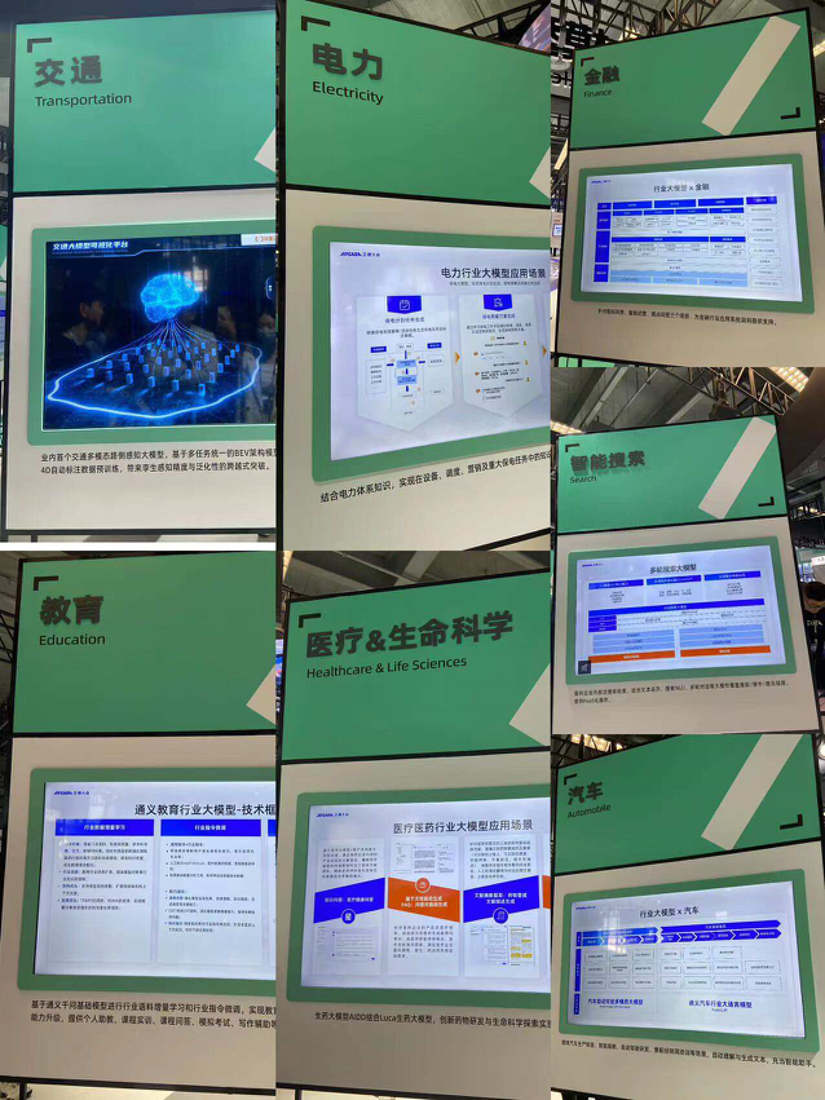

自去年云栖大会上,阿里云发布了一系列基于通义大模型的创新应用,标志着大模型技术开始迈向大规模商业化和产业化的关键一步。这一系列动作不仅展示了大模型在交通、电力、金融、政务、教育等多个行业的广泛应用前景,也揭示了一个重要趋势:大模型的落地应用需要与行业知识深度整合,形成具有领域特色的“行业大模型”。

而在这一过程中,一

![[Golang] Channel](https://img-blog.csdnimg.cn/img_convert/9a50f6e400871416a27c4c6b16d51301.png)