本文改编自实验室的最新综述论文《医疗领域的大型语言模型综述》,该论文发表于《智能系统学报》。《智能系统学报》是中国人工智能学会会刊、“中国人工智能学会推荐中文学术期刊”列表中的A类期刊。该论文合作单位包括上海理工大学、上海儿童医学中心、复旦大学附属妇产科医院以及上海市第一人民医院。

| 文献来源: 肖建力,许东舟,王浩,刘敏,周雷,朱林,顾松. 医疗领域的大型语言模型综述[J]. 智能系统学报,DOI:10.11992/tis.202405003. XIAO Jianli, XU Dongzhou, WANG Hao, LIU Min,ZHOU Lei,ZHU Lin,GU Song. A survey of large language models in healthcare [J]. CAAI transactions on intelligent systems,DOI:10.11992/tis.202405003. |

| 论文下载地址: 1. https://pan.baidu.com/s/1e8AxEevGOeqUfFQfgLdkHw?pwd=qb25 2. https://kns.cnki.net/kcms2/article/abstract?v=8oX70opUeL9T4_lYWZCh-fL74IhW9ur7YURtaHJI_rjezkx1Mr-sCNopwyU8d6pvRMRpEh5gAy5-iJWB1E8-mRHf48Q4_IuQslB9eo-0LG2fwrF9546ZsBuTuOcD4Om-BxDLHdQJWCJXkXK5xLEeGeWbYB8s6kgqfbqnB0RFkF92o3sH-DIPloswTDMNEgRj&uniplatform=NZKPT&language=CHS |

一、什么是医疗大模型?

自从2023年OpenAI推出的ChatGPT4在多个领域展现出了卓越表现以来,大型语言模型(Large Language Model,大模型)逐渐成为了人工智能领域的最大热点。大模型通过大量数据的预训练,具备了理解、分析并处理文本的能力,能够生成与人类语言相似的回答。现在,越来越多的研究机构和科技公司加大了对大模型研发的关注和投入,它已经在医疗领域中展现出了巨大的潜力和应用前景

医疗大模型则是在大模型的基础上,进行了针对医疗领域特定任务的训练和优化。通过使用大量的医学数据(如医学文献、电子健康记录、医学影像等)进行预训练和微调,这些模型被赋予了处理专业医疗工作的能力。医疗大模型能够理解复杂的医学概念和术语,不仅能帮助医务工作者减轻日常工作中的负担,还能进一步提升医疗服务的效率和质量。

二、医疗大模型为什么重要?

将大模型应用于医疗领域,不仅能在文本翻译、病历自动生成等任务中大幅减轻医疗工作者的负担,还能为临床实践提供参考,帮助医生做出更准确的诊断和决策。此外,医疗大模型在医学教育中的作用同样不可忽视,它为医学生和实习医生提供了通过问答形式轻松获取大量医学知识和临床案例的途径。

随着对医疗大模型研究的不断深入,这些技术将对传统医疗行业带来一场颠覆性的变革,不仅推动了人工智能技术的进步,更是对医疗服务质量和健康管理模式的全面升级。以下是医疗大模型几个主要的应用场景。

1)在线问诊

图1展示了使用ChatGPT4进行在线问诊的过程。通过分析患者描述的症状,模型能够提供初步的医疗建议和指导。不仅便于患者随时进行病情诊断,还有助于减轻医生的工作负担,提高诊断效率。

图 1 使用ChatGPT4进行在线问诊

2)提升公民健康素养

医疗大模型可以通过问答形式向公众提供医学知识,从而提升健康素养。它们在解答医学问题时,能将复杂的医学术语转化为通俗易懂的语言,帮助人们更好地理解健康信息和医疗建议。

3)提供临床决策支持

通过深入分析最新的医学研究,医疗大模型可以为医生提供最前沿的治疗方法和诊断建议,提高诊断的准确性和治疗的成功率。

4)药物研发

医疗大模型可以加速药物研发过程,通过分析药物与疾病之间的关系,探寻有前途的药物设计方向,并评估其有效性和安全性。此外,医疗大模型还有助于实现药物再利用研究,寻找已有药物的新应用。

5)医学教育

在医学教育领域,医疗大模型不仅能为获取医学知识产生便利,还能提供模拟与患者进行交互的机会,增强医学生或实习医生的实践能力。

三、医疗大模型有哪些?

本文中汇总了一些经过专门训练以适应医疗领域的大模型,如表1所示。这些模型针对不同医疗任务,采取了多样化的训练策略,因此有着各自的特点和优势。尽管GPT-4未经过医疗领域的专门训练,但由于其作为大模型中的标杆,并在多项医学任务中的出色表现,因此也将其包括在讨论范围之内。

3.1 GPT-4

GPT-4采用Transformer架构,并延续了前代模型的预训练和微调策略,凭借强大的语言处理能力,即使未经专门针对医疗问题的训练,也在多项医疗测试中展现出接近或超越专家的表现。例如,在美国医学执照考试中,其自我评估和样本考试准确率分别达到了86.65%和86.7%,超过了考试及格线[1]。在MedQA、PubMedQA等数据集上的表现也与人类专家相当。此外,在临床诊断和疾病分析中,GPT-4的准确率高达89%到98%[2];在分析癌症CT报告时,其提取病变参数和识别转移性疾病的准确率分别为98.6%和98.1%[3]。

3.2 BioBERT[4]

BioBERT基于BERT模型,利用PubMed医学文献进行预训练,从而增强了其对复杂医学文本的理解能力。该模型在命名实体识别、关系提取和医学问答等任务中表现出色。一项研究显示,通过在SQuAD和SQuAD 2.0数据集上的预训练及在BioASQ数据集上的微调,BioBERT显著提升了其医学问答的性能,并在第七届BioASQ挑战赛中获得了最佳表现。

3.3 Med-PaLM[5]

Med-PaLM是谷歌公司研发的一种医疗大语言模型,基于Flan-PaLM,通过指令提示进行优化。研究人员使用软提示作为跨医学数据集的统一引导,并添加了专门的任务指令、少样本示例和具体情境提示,为模型提供专业的思维框架,从而显著提升了模型对医疗需求的理解和处理能力。

谷歌研究团队还制定了一个名为MultiMedQA的多元化评估基准,包括七个数据集,用于全面评估模型的临床应用和医学问答能力。Flan-PaLM在多个基准上的表现优异,而Med-PaLM在各项评估标准上显著优于Flan-PaLM,其表现接近医学专家水平。

3.4 Med-PaLM 2[6]

为了缩小大语言模型与医学专家在问答准确率上的差距,谷歌研究团队基于PaLM 2模型,结合针对性微调和指令提示技术,推出了Med-PaLM 2。与早期版本相比,Med-PaLM 2在多个问答数据集上的表现显著提升,接近甚至超越了医学专家的水平。

评估研究表明,Med-PaLM 2在MedQA、PubMedQA和MedMCQA数据集上的准确率分别达到了86.5%、81.8%和72.3%。在MMLU临床主题的测试中,其成绩高达90%,展示出了强大的多项选择题和长篇医学问答处理能力,对临床决策支持和医疗咨询表现出极高的准确性。此外,研究还评估了Med-PaLM 2在处理有害或带偏见问题时的表现,结果显示其答案的潜在风险明显低于Med-PaLM,具备更高的安全性,从而更好地保障患者健康。

3.5 BioGPT[7]

BioGPT是一种基于Transformer架构的语言模型,通过大量生物医学文献的训练来有效生成和挖掘医学文本。研究中使用了多个数据集对BioGPT进行了综合评估,在端到端关系提取任务中,BioGPT在BC5CDR、KD-DTI和DDI数据集上的准确率分别为46.17%、38.42%和40.76%;在PubMedQA的医学问答和HoC的文本分类任务中,准确率分别达到78.2%和85.12%。此外,BioGPT在生物医学文本生成任务中也展现了优异的性能,体现了其在医学问答和文本分类等任务中的强大能力。

3.6 BiomedGPT[8]

BiomedGPT是一个基于BART的通用医疗模型,采用Transformer架构,通过多种类型的生物医学数据进行预训练,并在25个医学数据集上进行了微调。尽管BiomedGPT是一个轻量级的医疗大语言模型,但其性能依然与其他先进的医疗LLM具有较强的竞争力。其完全开源的特性进一步增强了用户的可用性,同时有助于模型的持续开发和改进。

3.7 LLaVA-Med[9]

LLaVA-Med是首个将多模态指令与生物医疗领域相结合的模型。LLaVA-Med的训练策略包括对齐图像-文本对与预训练医学概念、端到端指令调优、以及对下游数据集的微调,从而提升其在生物医学视觉任务中的理解和处理能力。在训练评估中,LLaVA-Med通过使用GPT-4生成的指令数据进行训练,在多模态任务上表现出色。在生物医学视觉问答任务中,LLaVA-Med在VQA-RAD、SLAKE和PathVQA数据集上的表现也优于原版LLaVA。

尽管LLaVA-Med的训练数据中没有包含中文,它仍能够正确理解中文问题,这可能归因于其从LLaMA训练中获得的多语言知识,实现了跨语言的零样本迁移能力。

3.8 MedAlpaca[10]

MedAlpaca是一款完全开源的医疗对话模型,能有效保护用户隐私并防止医学数据泄露。该模型基于LLaMA模型,有7B(70亿)和13B(130亿)两种参数规格。通过LoRA技术对模型的权重进行更新,使其适应特定任务。此外,模型在训练过程中还使用了8位矩阵乘法和8位优化器对前馈和注意力投影层进行优化,这种方法与LoRA结合使用时能进一步降低内存和计算需求。

研究团队使用了美国医学执照考试的三个步骤对MedAlpaca的性能进行评估。MedAlpaca 13B在考试第一、第二、第三步中分别取得了47.3%、47.7%、60.2%的准确率,明显高于参数量较少的MedAlpaca 7B模型,后者在评估中的准确率分别为29.7%、31.2%、39.8%。

3.9 ChatDoctor[11]

ChatDoctor是一款基于LLaMA的医疗模型,训练时使用了Alpaca的指令跟踪数据。该模型通过对十万个包含丰富医学专业知识的真实医患对话数据进行微调,从而能更精确地理解患者的需求,并提供更合理的诊断和情感建议。此外,ChatDoctor还增加了自主知识检索功能,可以实时查询维基百科或疾病数据库中的医疗信息,为患者提供更具有专业化的回答。

为了评估ChatDoctor的性能,研究中将其与ChatGPT进行了比较,并选取了来自名为iCliniq的在线医疗咨询平台上的问题,以真实医生的答案作为参考基准。实验结果表明,ChatDoctor无论是在准确率、召回率和F1分数上,均优于ChatGPT。

3.10 DoctorGPT[12]

DoctorGPT以Baichuan2为基础模型。在预训练阶段,使用维基医学数据获取了丰富的医学知识,然后使用了约两百万条指令数据进行监督式微调。这种训练方法使DoctorGPT能更好地适用于中文环境。

在训练过程中,DoctorGPT使用了LoRA技术,提高了训练效率并减少了存储空间需求,使其可以在32GB的GPU上完成预训练和微调。此外,采用INT8量化在进一步提升了模型推理速度的同时,还降低了部署成本,便于医疗机构进行部署使用。

为全面评估DoctorGPT的性能,研究团队将其与ChatGLM-6B、ChatGLM2-6B、Baichuan-7B和Baichuan2-7B等基线模型进行了比较,使用了BLEU、GLEU、ROUGE和Distinct等多种评估指标,并在Huatuo-26M和cMedQA2这两个中文医疗问答数据集上进行实验。结果表明,DoctorGPT在所有评估指标上均优于其他基线模型,显示出其在处理中文医学问答任务方面的显著优势,无论是在理解深度还是回答质量上。

3.11 DoctorGLM[13]

上海科技大学研究团队为了提升大模型在提供中文医疗建议时的准确性,创建了一个新的中文医疗对话数据集,并用于训练ChatGLM-6B模型基底。同时,团队还使用LoRA技术开发了易于部署的DoctorGLM,通过提示设计模块提取用户输入中的关键词,并根据疾病知识库生成简要的疾病说明,有效提高了对特定疾病的识别准确率。

DoctorGLM能够在单张A100 GPU上在13小时内完成对ChatGLM-6B的微调,并能在RTX 3090等消费级GPU上完成推理,显著降低了硬件需求,使得大多数医院或研究机构都能负担得起训练成本。研究将DoctorGLM与ChatGLM-6B和GPT-3.5-turbo在医学问答任务上进行了比较,结果显示,DoctorGLM提供的答案更具针对性。

3.12 BenTsao[14]

BenTsao (原名HuaTuo)是哈尔滨工业大学推出的一款开源的中文生物医疗领域LLM。该模型以LLaMA-7B为基础,整合了源自中文医学知识图谱中的8000条指令数据,通过中文医学指令进行微调,特别适用于处理与中文医学问答相关任务。

为全面评估模型在生成医学问答中的性能,研究团队提出了一种名为SUS的评估指标,其中包括安全性、可用性和流畅性。

在使用SUS指标进行的性能评估中,BenTsao与LLaMA、Alpaca和ChatGLM三款模型进行了对比。尽管BenTsao在安全性方面的得分略低于LLaMA,但在可用性和流畅性上均表现优异,分别获得了2.12和2.47的最高得分,显著超越了LLaMA的1.21和1.58,成为所有参与评估模型中表现最好的。

此外,BenTsao对训练资源的要求相对较低,预计使用单张3090或4090等消费级显卡即可满足其训练需求。这种较低的训练门槛有助于吸引更多研究人员参与到大模型的研究中,进一步推动其在医疗领域的发展与应用。

3.13 HuatuoGPT[15]

由香港中文大学研发的HuatuoGPT是一款专为中文医疗咨询设计的大模型。在监督微调阶段,该模型使用了来自ChatGPT的数据和医生的真实交互数据,通过人工智能反馈的训练方法,克服了ChatGPT在医疗咨询中的多种局限性,例如拒绝诊断和开药、难以进行医生式的交互诊断以及容易产生幻觉等问题。

研究团队基于cMedQA2、webMedQA和Huatuo-26M三个中文医学数据集,使用BLEU、ROUGE、GLEU等多种评估指标对比HuatuoGPT与GPT-3.5及经微调的T5模型。结果显示,HuatuoGPT在多项评估指标上均优于GPT-3.5-turbo,并在某些方面甚至超过了微调后的T5模型。

在单轮对话评估中,HuatuoGPT在所有类别上的表现明显优于BenTsao和DoctorGPT,并在某些方面超过了GPT-3.5-turbo,但整体性能仍不及GPT-4。在多轮对话评估中,HuatuoGPT以8.72比5.63和8.42比7.85的优势胜过DoctorGLM和GPT-3.5-turbo。人工评估结果也显示,HuatuoGPT的表现优于BenTsao、DoctorGPT和GPT-3.5-turbo,仅次于GPT-4。

四、医疗大模型如何构建?

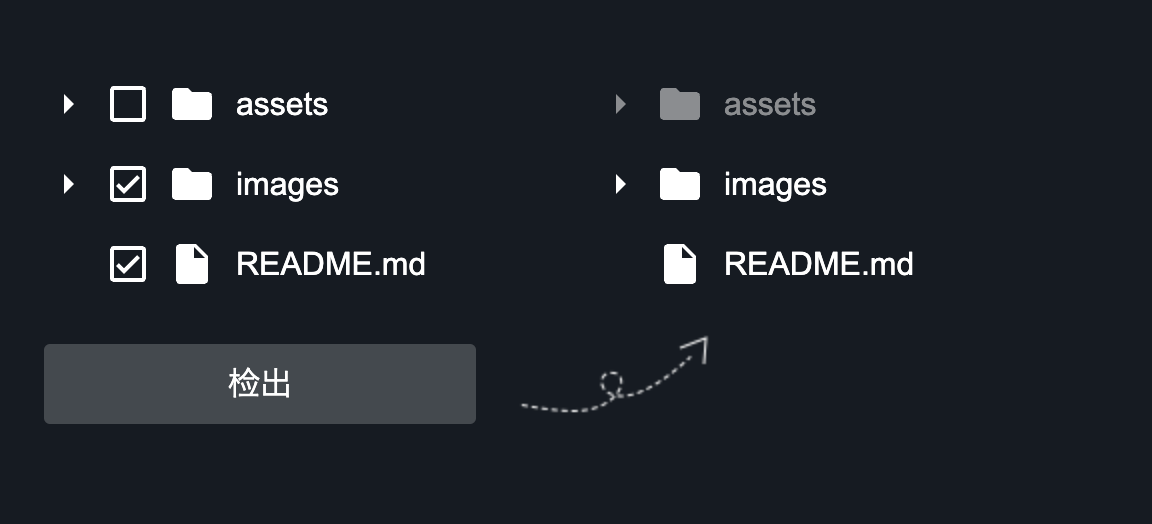

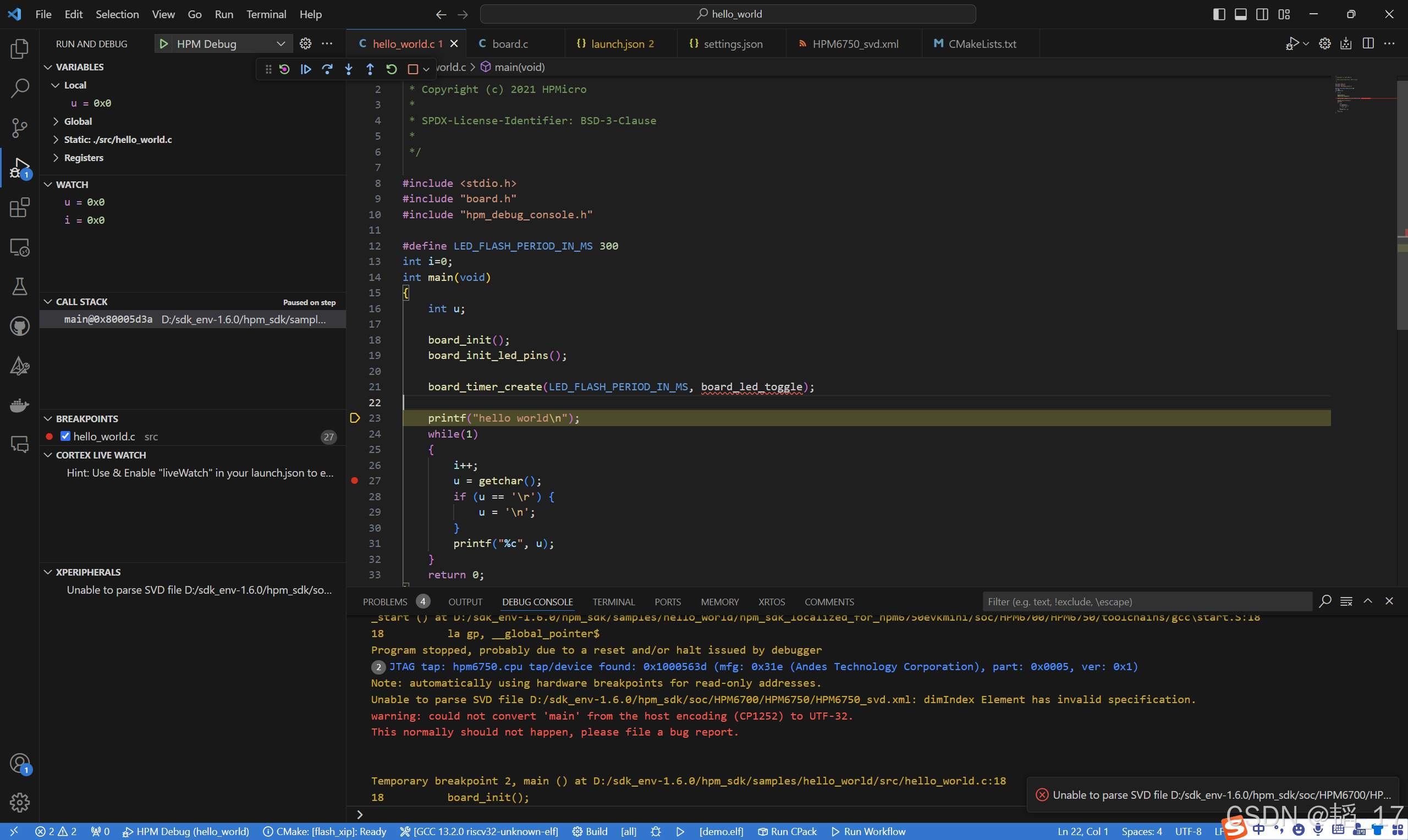

图 2展示了训练医疗大模型的基本步骤,这些步骤通常包括数据收集、数据预处理、预训练、微调、性能评估以及模型优化等。以下内容将对这些步骤做进一步介绍。

1)数据收集

为了确保大模型在处理复杂的医学专业知识方面能够发挥有效作用,充分保证数据在收集阶段的多样性与高质量至关重要。因此,需要准备多种类型的医学数据,例如医学文献、电子健康记录、医学影像和医学问答数据集等。

2)数据预处理

实施数据清洗能从语料库中过滤掉重复内容、非文本元素、含有噪声的文档以及低质量文本。随后,进行文本分割,将长句子或段落分割成单独的语元,并构建适用于医疗领域的词汇表,提高模型的分析效率。为确保患者隐私和权益得到保障,去标识化和匿名化等措施也至关重要。

3)预训练

通过使用大量医学数据,使大模型学习数据的结构和模式。预训练为模型提供了丰富的语言知识基础,增强了模型对语言上下文关系的理解,并赋予其跨领域的迁移能力,使大模型能以更低的成本和时间适用于不同但相关的特定任务。

4)微调

该过程在明确模型需要执行的具体任务后,使用特定的医学数据集进行专门化训练,增强模型对特定医疗任务的处理能力。微调不仅能提升模型的理解能力,还有助于降低过拟合风险。此外,微调在减少训练数据需求的同时,还能够加速模型训练过程,从而使模型更迅速地部署到下游任务。

5)性能评估

该过程不仅能反映模型的准确性,保证其可靠性,还能为后续模型的进一步优化提供有价值的反馈。同时根据具体的医疗应用场景,选取不同的评估指标,能够从多个维度深入分析模型的综合性能。

图 2 训练医疗大型语言模型的基本步骤

五、医疗大模型路在何方?

随着人工智能技术的不断突破,智慧医疗正在进入一个全新的纪元,医疗大模型成为了推动这一变革的重要力量。然而,大模型能否在医疗领域中广泛应用,还有一些亟待解决的挑战,尤其是在模型的可解释性、准确性、隐私保护和伦理问题等方面。

未来,医疗大模型将朝着多模态、智能体融合、跨平台协作等方向发展,为医疗行业带来更大的创新和变革。从更精确的临床决策支持到实时健康监测的智能设备集成,医疗大模型将会使医疗资源的分配更加合理、高效,并进一步提升医疗服务的质量和效率。以下内容对医疗大模型的未来发展趋势进行了分析:

1)多模态大型语言模型

多模态技术使大模型能够处理和理解多种数据类型,如图像、音频和视频等,并根据任务需求生成相应的数据格式,如图3所示。这不仅能为患者提供更精确的医疗服务,还极大地拓展了医疗大模型的应用范围。

图 3 多模态大型语言模型

2)模型参数压缩

随着大模型参数规模的不断扩大,对计算资源的需求也大幅增加,这使得模型的训练、部署的门槛昂贵。未来亟需通过知识蒸馏、权重共享和网络剪枝等技术对模型参数进行压缩,从而降低成本,提高运行效率和泛化能力。这将使得更多高校和研究机构能够负担得起医疗大模型的高额训练成本,进一步推动其在更广泛领域中的应用和发展。

3)基于大模型的智能体

开发基于大模型的智能体,在医疗环境中尤为关键,它们能够自主进行决策并采取行动,为特定医学任务提供创新解决方案,从而有效弥补大模型在推理和规划方面的局限性。通过结合外部数据和工具,智能体可以优化诊断流程、提高治疗方案的精准度,并为复杂医疗场景提供更具针对性的解决策略。

4)通用型医疗人工智能

通用型医疗AI可以根据用户的具体需求调整并执行多样化的任务,显著增强模型的应用灵活性,使其能广泛适用于医疗行业的多个方面。

5)与医疗设备集成

穿戴式医疗设备结合大模型强大的分析能力,能为患者的健康提供实时的监测和评估。这种方式极大地提高了医疗服务的效率和时效性。不仅能优化医疗资源的分配,还能为患者带来更便利的个性化医疗体验。

参考文献:

- Nori H, King N, McKinney S M, et al. Capabilities of GPT-4 on Medical Challenge Problems[J]. arXiv preprint arXiv:2303.13375, 2023.

- Ueda D, Walston S L, Matsumoto T, et al. Evaluating GPT-4-based ChatGPT's clinical potential on the NEJM quiz[J]. BMC Digital Health, 2024, 2(1): 4.

- Fink M A, Bischoff A, Fink C A, et al. Potential of ChatGPT and GPT-4 for Data Mining of Free-Text CT Reports on Lung Cancer[J]. Radiology, 2023, 308(3): e231362.

- Lee J, Yoon W, Kim S, et al. BioBERT: a pre-trained biomedical language representation model for biomedical text mining[J]. Bioinformatics, 2020, 36(4): 1234-1240.

- Singhal K, Azizi S, Tu T, et al. Large language models encode clinical knowledge[J]. Nature, 2023, 620: 172-180.

- Singhal K, Tu T, Gottweis J, et al. Towards Expert-Level Medical Question Answering with Large Language Models[J]. arXiv preprint arXiv:2305.09617, 2023.

- Luo R, Sun L, Xia Y, et al. BioGPT: generative pre-trained transformer for biomedical text generation and mining[J]. Briefings in Bioinformatics, 2022, 23(6): bbac409.

- Zhang K, Yu J, Yan Z, et al. BiomedGPT: A Generalist Vision-Language Foundation Model for Diverse Biomedical Tasks[J]. arXiv preprint arXiv:2305.17100, 2023.

- Li C, Wong C, Zhang S, et al. LLaVA-Med: Training a Large Language-and-Vision Assistant for Biomedicine in One Day[J]. Advances in Neural Information Processing Systems, 2024, 36.

- Han T, Adams L C, Papaioannou J M, et al. MedAlpaca -- An Open-Source Collection of Medical Conversational AI Models and Training Data[J]. arXiv preprint arXiv:2304.08247, 2023.

- Li Y, Li Z, Zhang K, et al. ChatDoctor: A Medical Chat Model Fine-Tuned on a Large Language Model Meta-AI (LLaMA) Using Medical Domain Knowledge[J]. Cureus, 2023, 15(6).

- Li W, Yu L, Wu M, et al. DoctorGPT: A Large Language Model with Chinese Medical Question-Answering Capabilities[C]// Proceedings of the 2023 International Conference on High Performance Big Data and Intelligent Systems. IEEE, 2023: 186-193.

- Xiong H, Wang S, Zhu Y, et al. DoctorGLM: Fine-tuning your Chinese Doctor is not a Herculean Task[J]. arXiv preprint arXiv:2304.01097, 2023.

- Wang H, Liu C, Xi N, et al. HuaTuo: Tuning LLaMA Model with Chinese Medical Knowledge[J]. arXiv preprint arXiv:2304.06975, 2023.

- Zhang H, Chen J, Jiang F, et al. HuatuoGPT, towards Taming Language Model to Be a Doctor [C]//Findings of the Association for Computational Linguistics: EMNLP 2023. Singapore: Association for Computational Linguistics, 2023: 10859-10885.