人工智能咨询培训老师叶梓 转载标明出处

这些模型的训练通常依赖于资源密集型的人工反馈,这不仅成本高昂,而且耗时。为了解决这一问题,一篇名为《FINE-TUNING LARGE LANGUAGE MODELS WITH MULTI-AGENT DEBATE SUPERVISION》的论文提出了一种创新的方法——DebateGPT。

DebateGPT是一个通过多智能体辩论(multi-agent debate)监督微调的大模型。基于GPT-3.5,通过一种新颖的方法——多智能体辩论,使用从Alpaca数据集中提取的有限指令进行微调,达到了与GPT-4相当的性能。这种方法不仅减少了对昂贵的人工反馈的依赖,而且避免了使用像GPT-4这样庞大且成本高昂的模型。

方法

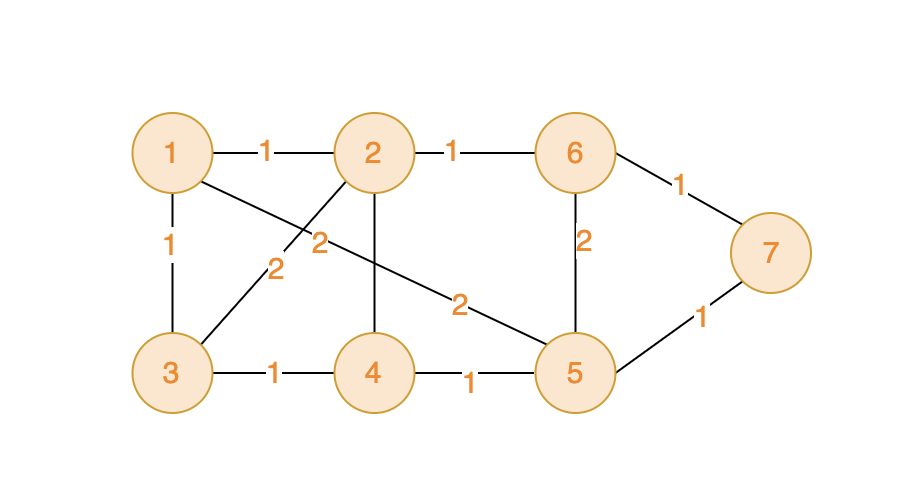

DebateGPT通过多智能体辩论收集的数据来微调语言模型。如图1所示:左侧部分展示了从Alpaca数据集中抽取5000条指令,并运用改进版的多代理辩论方法来提升生成回答的质量。这一过程包括要求代理给出置信度评分、总结其他代理的回答以及清理最终答案。右侧部分说明了如何收集这些问题和答案对,然后使用OpenAI的FineTuning API对GPT-3.5模型进行微调。

基于Transformer架构的大模型,特别是GPT系列,使用因果关系注意力机制,仅根据之前的token来预测下一个token。训练这些大模型的目标是最大化整个文本句子的概率![]() ,其中

,其中![]() 是在给定先前tokens的条件下token

是在给定先前tokens的条件下token ![]() 的条件概率,而T 是句子的token长度。训练期间的目标是最大化观测数据的似然度,可以通过以下损失函数实现:

的条件概率,而T 是句子的token长度。训练期间的目标是最大化观测数据的似然度,可以通过以下损失函数实现: ,其中 θ 是学习到的模型参数。在训练过程中,模型调整其参数(权重和偏差),以最大化训练数据上的这种似然度。这个目标确保了模型学会生成与训练数据中类似的序列。

,其中 θ 是学习到的模型参数。在训练过程中,模型调整其参数(权重和偏差),以最大化训练数据上的这种似然度。这个目标确保了模型学会生成与训练数据中类似的序列。

多个语言模型通过相互辩论可以增强需要推理和事实准确性的问答任务的性能。尽管现有的多智能体辩论已专门用于推理以增强问答能力,但它有超出此范围的潜力。多智能体辩论可以成为高质量数据的丰富来源,这些数据随后可以用来微调语言模型。通过利用较弱语言模型进行的辩论的结果,可以构建更强大的模型。这一策略提供了一条绕过人工注释需求的高质量训练数据的途径。

然而,直接应用现有的多智能体辩论方法进行微调遇到了几个挑战。首先,尽管增加代理和辩论轮次的数量可以提高准确性,但大模型在最大上下文窗口上的内在限制阻碍了在代理数量和辩论持续时间方面的扩展。其次,目前的多智能体辩论配置也可能得出错误的结论,主要是因为代理缺乏有效机制来适当评估和整合其他参与者的见解和观点。最后,产生的答案经常包含无关的辩论中心短语,如“在上一轮”或“其他代理”,这并不有助于模型的精细化。为了解决这些限制,作者们提出了三种特定的修改,以增强多智能体辩论范式的有效性。

总结:为了处理预训练语言模型中最大上下文窗口的限制,引入了一个总结模型,该模型在每轮辩论中总结来自其他大模型代理的响应。具体来说,在第r 轮辩论期间,首先收集上一轮所有其他代理的响应。对于代理 ![]() ,将收集的响应

,将收集的响应 ![]() =

=![]() 发送给总结模型,以整合这些响应并提供给定问题的简短而清晰的答案,其中 n 是代理的数量。在实验中使用另一个GPT-3.5作为总结者,并将其与辩论代理分开。由此能够使用更多的代理和辩论轮次,以获得更准确的数据,用于微调下游模型。

发送给总结模型,以整合这些响应并提供给定问题的简短而清晰的答案,其中 n 是代理的数量。在实验中使用另一个GPT-3.5作为总结者,并将其与辩论代理分开。由此能够使用更多的代理和辩论轮次,以获得更准确的数据,用于微调下游模型。

置信度评分:为了增强代理评估和整合自己响应以及来自其他代理的响应的能力,作者在多智能体辩论程序中集成了置信度评分机制。每个参与的代理被提示生成一个置信度评分,该评分在1到100的范围内。这个分数反映了代理对其自身响应的准确性和可靠性的确定程度。置信度较低的答案对最终答案的影响较小。这些置信度评分有助于在整合来自不同代理的见解时进行更统一的评估。

清洗:为了提高最终答案的一致性并删除通过多智能体辩论生成的无关文本,作者引入了一个清洗模型来清洗最后一轮辩论的响应。他们还在提示中为这个模型提供了四个GPT-4响应示例,以帮助它生成简洁且连贯的文本格式。他们使用一个单独的GPT-3.5作为清洗器,将其与辩论代理和总结模型分开。然后使用清洗后的数据进行下游模型的微调。

作者还介绍了一种新颖的微调大模型的方法,即利用多智能体辩论(multi-agent debate)生成的数据进行微调。作者从Alpaca数据集中随机抽取了5,000个问题,该数据集包含52,000个问答对。使用前文提到改进的多智能体辩论来回答这些问题。使用OpenAI FineTuning API对GPT-3.5进行微调,该API支持对GPT-3.5进行用户指定数量的时期的微调。使用以下数据格式:{"messages": ["role": "user", "content": "Question", "role": "assistant", "content":"Answer"]}。微调后的GPT-3.5,即DebateGPT3.5,尽管与GPT-4相比尺寸要小得多,并且仅使用了5,000个数据进行微调,但在多个数据集上实现了与GPT-4相当的性能。

想要掌握如何将大模型的力量发挥到极致吗?叶老师带您深入了解 Llama Factory —— 一款革命性的大模型微调工具。9月22日晚,实战专家1小时讲解让您轻松上手,学习如何使用 Llama Factory 微调模型。

加下方微信或评论留言,即可参加线上直播分享,叶老师亲自指导,互动沟通,全面掌握Llama Factory。关注享粉丝福利,限时免费CSDN听直播后的录播讲解。

LLaMA Factory 支持多种预训练模型和微调算法。它提供灵活的运算精度和优化算法选择,以及丰富的实验监控工具。开源特性和社区支持使其易于使用,适合各类用户快速提升模型性能。

实验及分析

用于评估的六个数据集,包括AlpacaEval、MMLU、算术、Winogrande和AI2 Reasoning Challenge (ARC)。这些数据集覆盖了从开放式问题到多项选择题,再到基于常识的推理和物理问题的广泛任务。

-

AlpacaEval 数据集包含805个示例,这些示例来自不同的数据集,包括Self-Instruct、OpenAssistant、ShareGPT、Koala测试集和HH-RLHF数据集。这个数据集的特点是问题开放,没有单一确定的答案,因此评估方法包括使用GPT-4对测试模型生成的回答和text-davinci-003生成的回答进行排名。

-

MMLU 数据集包含57个主题的多项选择题,测试模型在数学、编程、推理和事实性方面的能力。

-

算术 数据集包含1000个随机生成的算术问题,形式为a+b∗c+d−e∗f,用于测试模型解决数学问题的能力。

-

Winogrande 数据集包含1267个与常识推理相关的测试问题,任务是选择正确的选项来填补句子中的空白。

-

ARC 数据集包含小学数学问题和科学相关问题的多项选择题,用于评估模型在更复杂的推理任务上的表现。

作者将DebateGPT-3.5与GPT-3.5和GPT-4进行了比较。GPT-3.5是基于text-davinci-002的自回归语言模型,而GPT-4是OpenAI最新的大型语言模型,具有一万亿参数,是GPT-3的10倍。

图2 展示了GPT-3.5、DebateGPT-3.5和GPT-4的结果。比较了这三个模型在与指令遵循、数学、常识推理和多任务语言理解相关的5个基准测试上的表现。DebateGPT-3.5在多个任务上始终优于GPT-3.5,并且在几个任务上与GPT-4相当。

图3 和 图4 展示了不同方法的示例结果。在图3中,DebateGPT-3.5和GPT-4正确应用了二次公式解决了数学问题,而GPT-3.5则错误地尝试使用因式分解。在图4中,DebateGPT-3.5正确地解决了与光和波处理相关的物理问题,而GPT-3.5和GPT-4则未能正确回答。

假设改进的多智能体辩论可以生成更高质量的数据,这对模型微调非常有用。表1 显示了使用GPT-3.5、原始多智能体辩论、改进的多智能体辩论和GPT-4生成的数据的比较结果。结果表明,引入总结步骤、置信度评分和清洗步骤可以显著提高多智能体辩论的性能。

进一步假设数据量在影响微调结果中起着重要作用。图5(左)显示,即使只使用1K数据进行微调,DebateGPT-3.5在MMLU数据集上的性能也超过了GPT-3.5。这表明通过多智能体辩论生成的高质量数据对性能提升有显著影响。

理论上可以通过在Alpaca数据上使用GPT-4生成的回答进行微调来实现这些结果。然而,图6 显示,使用多智能体辩论生成数据比使用GPT-4更便宜。根据OpenAI的当前定价,使用DebateGPT-3.5生成文本的成本是使用GPT-4的一半。

实验分析结果表明,DebateGPT-3.5通过改进的多智能体辩论方法生成的高质量数据,以及精心设计的微调策略,能够在保持成本效益的同时,实现与GPT-4相当的性能。

论文链接:DebateGPT: Fine-tuning Large Language Models with Multi-agent Debate Supervision | OpenReview