文章目录

- 在线体验

- 快速开始

- 一、项目介绍篇

- 1.1 YOLO8

- 1.2 ultralytics

- 1.3 模块介绍

- 1.3.1 scan_task

- 1.3.2 scan_taskflow.py

- 1.3.3 segment_app.py

- 二、核心代码介绍篇

- 2.1 segment_app.py

- 2.2 scan_taskflow.py

- 三、结语

代码资源:计算机视觉领域YOLO8技术的图片实例分割实现

在线体验

- 基于YOLO8的图片实例分割系统

- 基于

opencv的摄像头实时图片实例分割

快速开始

- 创建

anaconda环境

conda create -n XXX python=3.10

- pytorch安装

# 查看cuda版本(示例为:11.8)

nvcc -V

# 安装对应版本的pytorch

# 官网:https://pytorch.org/

# pip安装

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

# conda安装,建议配置conda国内镜像源

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia

- 其他依赖包安装

pip install -r ./requirements-segment.txt

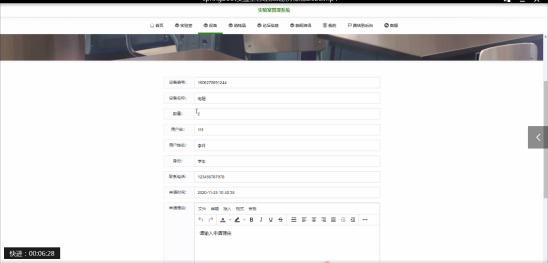

- 网页界面如下,可在示例图片中快速进行试验

python segment_app.py

一、项目介绍篇

在深度学习和计算机视觉的交汇点上,YOLO8以其创新的架构和优化的性能,成为了图像实例分割领域的佼佼者。本项目依托于YOLO8算法,开发了一个先进、用户友好的图像实例分割平台,致力于为客户提供一个高效且易于集成的解决方案。通过直观的操作界面和强大的功能集合,用户可以便捷地执行图像实例分割任务,无论是在云平台还是个人设备上。

1.1 YOLO8

- YOLO8是最新的图像实例分割算法,延续了YOLO(You Only Look Once)系列的创新精神。它不仅继承了YOLO系列算法的速度和效率,还通过一系列创新性的改进,使其能够处理更加复杂的实例分割任务。YOLO8通过引入先进的网络架构和训练技术,显著提升了分割的精确度和稳定性,特别是在处理小物体和重叠物体时表现出色。

- YOLO8算法的主要创新点包括:

- 先进的网络架构:YOLO8采用了更复杂的网络结构,通过增加网络深度和宽度,增强了对图像特征的捕捉能力,从而更准确地进行实例分割。

- 精细化的锚框系统:YOLO8对锚框机制进行了精细化调整,使其能够更灵活地适应各种尺寸和形状的物体,有效降低了分割错误。

- 创新的数据增强策略:通过采用一系列创新的数据增强技术,YOLO8提升了模型对多样化场景的适应性,增强了其在不同环境下的表现。

- 高效的训练流程:YOLO8引入了优化的损失函数和训练算法,不仅加快了训练过程,还确保了模型在实例分割任务上的高性能。

- YOLO8的这些创新使其在需要实时处理的领域,如医疗影像分析、工业自动化检测等,展现出巨大的应用潜力。尽管YOLO8的完整细节和性能数据还未完全公开,但其在图像实例分割领域的突破已经吸引了学术界和工业界的广泛关注。

1.2 ultralytics

- Ultralytics是一家专注于计算机视觉和人工智能技术的公司,以其开发的高性能目标检测模型YOLO(You Only Look Once)而闻名。YOLO模型以其快速和准确的目标检测能力在业界获得了广泛认可,特别是在需要实时处理的场合,如视频监控、自动驾驶和工业自动化等领域。

- Ultralytics的YOLO算法通过单次前向传播即可预测图像中的物体位置和类别,与传统的多步骤检测方法相比,大大提高了检测速度。随着YOLO算法的迭代发展,Ultralytics不断推出新版本,如YOLOv3、YOLOv4、YOLOv5等,每个版本都在准确性、速度和易用性方面进行了优化。

- 除了目标检测,Ultralytics还提供其他AI解决方案,包括图像分割、数据标注工具和模型部署服务。公司致力于推动AI技术的创新和应用,帮助企业实现智能化转型。Ultralytics的技术和产品因其高效性和可靠性,在全球范围内拥有众多用户和合作伙伴。

1.3 模块介绍

1.3.1 scan_task

- 构建了执行的任务,用于为

scan_taskflow提供可执行对象

1.3.2 scan_taskflow.py

- 基于open-cv2的本地界面系统

1.3.3 segment_app.py

- gradio页面代码

二、核心代码介绍篇

2.1 segment_app.py

import cv2

import gradio as gr

from scan_task import ScanSegment

scan_model = ScanSegment(version='YOLOv8n', use_gpu=False)

def segment_scan(frame, show_box, box_color, text_color, text_size=50, y_pos=0):

'''

show_box: 是否显示检测框

box_color: 检测框颜色 默认:(0, 255, 0)

text_color: 显示文字颜色 默认:(0, 0, 255)

text_size: 显示文字大小 默认:20

y_pos: y轴位置偏移量 默认:0

'''

# 将 16进制 颜色表示式转换为 RGB 格式

# 将 16进制 颜色表示式转换为 RGB 格式

box_color = tuple(int(box_color[i:i + 2], 16) for i in (1, 3, 5))

text_color = tuple(int(text_color[i:i + 2], 16) for i in (5, 3, 1))

frame, _ = scan_model.run(frame, show_box=show_box, box_color=box_color,

text_color=text_color, text_size=text_size, y_pos=y_pos)

return frame

def show_box_change(show_box):

if show_box:

return gr.update(visible=True)

else:

return gr.update(visible=False)

if __name__ == '__main__':

examples = [

[cv2.imread('./examples/image_detection.jpg')]]

with gr.Blocks() as demo:

with gr.Tabs():

# 图片分割

with gr.Tab(label='图片实例分割') as tab1:

gr.Markdown(value="# 图片实例分割")

with gr.Row(variant="panel"):

with gr.Column():

img_input1 = gr.Image(label="上传图片输入", mirror_webcam=False)

show_box = gr.Checkbox(label="显示检测框", value=False)

with gr.Row(visible=False, variant="panel") as box_config:

box_color = gr.ColorPicker(label="检测框颜色", value='#00FF00')

text_color = gr.ColorPicker(label="检测文字颜色", value='#FF0000')

text_size = gr.Slider(20, 50, value=20, step=1, label="检测框文字大小")

y_pos = gr.Slider(-50, 50, value=0, step=1, label="检测框文字偏移量")

with gr.Row(variant="panel"):

submit_bn1 = gr.Button(value='上传')

clear_bn1 = gr.ClearButton(value='清除')

img_out1 = gr.Image(label="图片实例分割输出", mirror_webcam=False)

# 添加演示用例

gr.Examples(label='上传示例图片', examples=examples, fn=segment_scan,

inputs=[img_input1, show_box, box_color, text_color, text_size, y_pos],

outputs=img_out1,

cache_examples=False)

# 检测框展示开关

show_box.change(fn=show_box_change, inputs=show_box, outputs=box_config)

# 上传图片分割

submit_bn1.click(fn=segment_scan, inputs=[img_input1, show_box, box_color, text_color, text_size, y_pos],

outputs=img_out1)

# 清除图片

clear_bn1.add([img_input1, img_out1])

# 摄像头实时目标检测

with gr.Tab(label='摄像头实时图片实例分割') as tab3:

gr.Markdown(value="# 摄像头实时图片实例分割")

with gr.Column(variant='panel') as demo_scan:

with gr.Row(variant="panel"):

img_input3 = gr.Image(label="实时输入", sources=["webcam"],

mirror_webcam=False, streaming=True)

img_out3 = gr.Image(label="图片实例分割输出", sources=["webcam"],

mirror_webcam=False, streaming=True)

img_input3.stream(fn=segment_scan, inputs=[img_input3, show_box, box_color, text_color, text_size, y_pos],

outputs=img_out3)

demo.launch()

- 此段代码主要是用于生成前端页面,以及配置按钮点击事件触发时的回调函数

- 可配置参数包括:

use_gpu、text_color、text_size、y_posuse_gpu: 是否使用gpubox_color:检测框颜色text_color:检测文字颜色 默认:(0, 0, 255)text_size:检测文字大小 默认:20y_pos:y轴位置偏移量 默认:0

2.2 scan_taskflow.py

class ScanTaskflow:

def __init__(self, task: str, video_index=0, win_name='Scan XXX', win_width=800, win_height=600, **kwargs):

..初始化摄像头扫描对象,设置窗口尺寸等属性..

def run(self, **kwargs):

..开启摄像头,进行检测任务..

if __name__ == '__main__':

# 启动默认的图像实例分割

scanTaskflow = ScanTaskflow(task='scan_segment',

version='YOLOv8n', use_gpu=True,

video_index=0, win_name='segment',

win_width=640, win_height=480)

scanTaskflow.run(text_color=(0, 255, 0), y_pos=0)

__init__用于预加载项目所需模型run是检测系统的核心方法,用于将视频的实时帧进行实例分割

三、结语

- 本项目提供了一个基于YOLO8算法的图片实例分割系统,它不仅易于部署和使用,而且具备高性能和高灵活性。我们相信,随着技术的不断进步和社区的积极参与,本项目将能够为更多用户提供价值,推动图片实例分割技术的发展。如果您在使用过程中遇到任何问题,欢迎在ModelScope创空间-基于YOLO8的图片实例分割系统上提出issue,我们会及时为您解答。

- 希望本项目能够成为您在图片实例分割领域的得力助手。如果您觉得本项目对您有帮助,请给项目点个star,并持续关注我的个人主页ModelBulider的个人主页

![[Linux]:环境变量与进程地址空间](https://img-blog.csdnimg.cn/img_convert/1a5c9abd46ac7af93e5dbe7e0180b970.jpeg)