说白了,关键点就三个:信源,压缩与信道

DMS就是无记忆的信源,该输出什么就输出什么。

马尔卡夫信源,准确来讲是m马尔卡夫,会受到前m个状态的影响。(妈的,马尔卡弗还在追我,diffusion那边也有马尔卡夫)

不常见的情况包含更多信息?深刻的见解。

是用公式量化一下刚才的结论,概率越低信息越多。这不就是熵嘛?均匀就是常见的情况(概率高,信息少),有序就是不常见的情况(概率低,信息多)。

一个符号能传递多少信息。比如说两个人用二进制数交流,那一个符号传递的信息就很少;用100进制数,那一个符号传递的信息就很多。这和上面的结论也一样,因为选择多了,出现某一种符号的概率就小了,情况不常见了,信息就多了。

举几个用刚才的公式计算的例子。

我们平时都是和二进制数打交道,只管二进制数就好:

有条件概率,当然也有条件信息,条件熵,毕竟它们是绑定在一起的嘛。

接下来的知识对于信息传输很有用

直观的看,这个I(X,Y)好像就是比较了X与Y之间的关联程度。假如X,Y毫无关联,那两个就是一样的,I就是0.要是X,Y完全一样,I就是等于H(X)了。因此I越大XY之间的联系越紧密,这个信道就越好。

信息率与信息传递效率:

一个是一个符号传递多少信息,一个是一段时间内传递多少信息。

接下来是重头戏:香农的信源加密理论:

香农终于还是登场了。这条理论是在无损加密的情况下生效的,也叫香农第一定律。

香农第一定律的核心内容

-

定义和前提:

- 适用于离散无记忆信源。

- 目标是找到一种编码方法,使得编码后的平均码长不超过信源熵。

-

编码方法:

- 采用变长编码,即根据信源符号出现的概率分配不同长度的码字。

- 高概率符号使用短码字,低概率符号使用长码字。

-

无损压缩:

- 保证解码后的信息能够完全恢复原始信息,无任何失真。

-

数学表达:

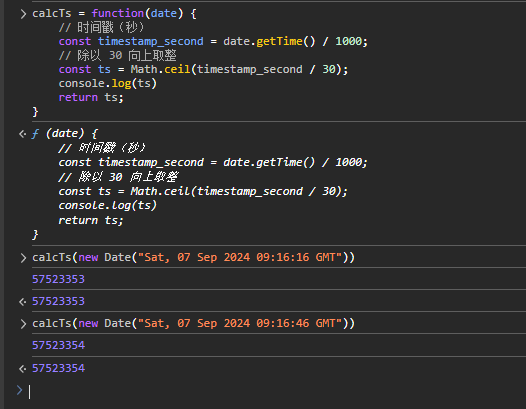

- 设离散无记忆信源X包含N个符号{x1, x2, ..., xi, ..., xN},信源发出K重符号序列,则此信源可发出N^k个不同的符号序列消息。每个符号序列消息的出现概率为PKj,其信源编码后所得的二进制代码组长度为Bj,代码组的平均长度为B。当K趋于无限大时,B与信息量H(X)之间的关系为B/k = H(X)(当K趋近无穷)。

接下来我们讲信道: