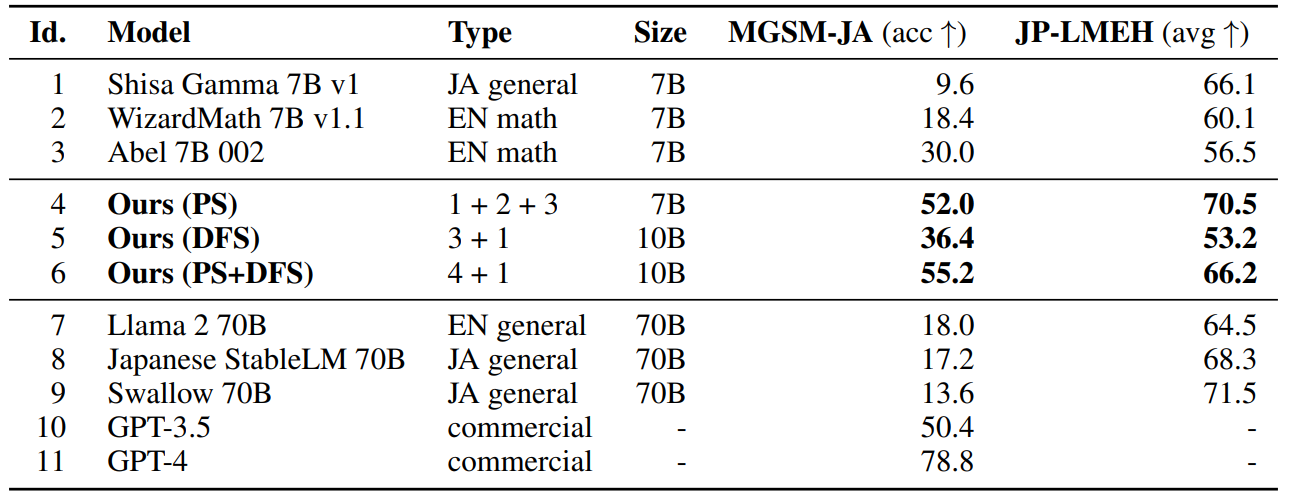

Transformer作者创业新成果火了!他们提出了一个70亿参数的日语数学大模型,直接打败700亿参数的Llama-2取得SOTA!更牛的是,得出这样的模型无需任何梯度训练,所需计算资源大大减少。

这种炸裂的成果得益于模型融合(Model Merging)技术,利用现有模型的参数、架构和特性,巧妙结合成一个新的、功能更强大的模型,这不仅减少了从头训练大型模型所需的计算资源和时间,还能帮我们在模型研究大爆发的情况下抓住机会,实现快速创新。

因此今年关于模型融合的研究也逐渐火热,出现了很多效果出众的成果,比如Zipit! 方法,性能最高提升了60%!为了给想发论文的同学节省时间,我从中挑选了11篇最新的模型融合论文给大家作参考,每一篇都值得学习,希望大家研读之后能有所收获。

论文原文+开源代码需要的同学看文末

Evolutionary Optimization of Model Merging Recipes

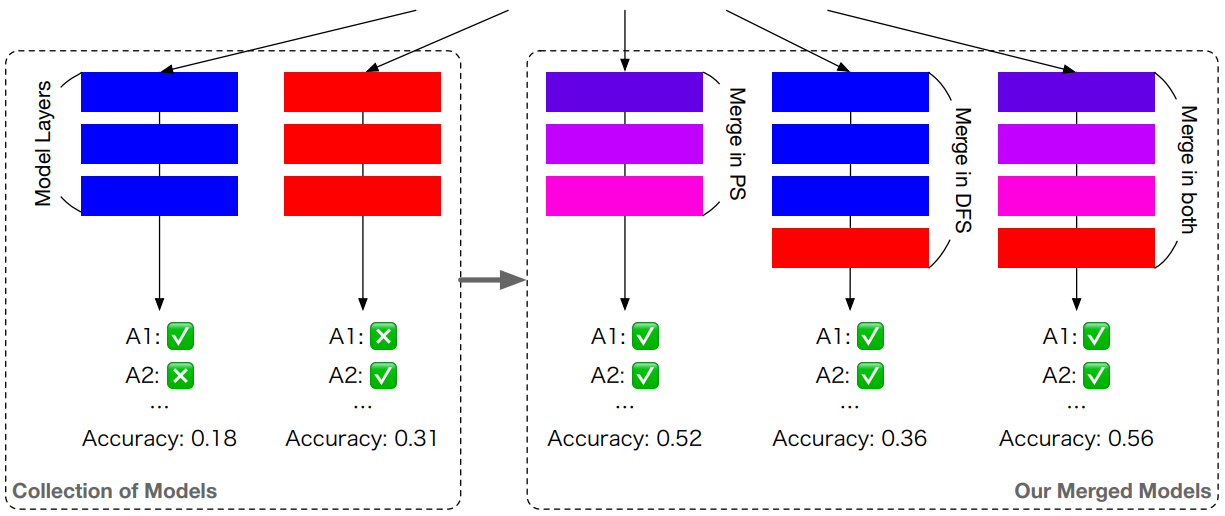

方法:论文提出了一种使用进化算法进行模型合并的方法,该方法在参数空间和数据流空间中操作,通过优化权重和推理路径,自动发现有效的模型组合,实现模型合并,生成具有新能力的模型,并在各种基准测试中取得了最先进的性能。

创新点:

-

通过进化算法自动发现多种开源模型的有效组合,而无需额外的训练数据或计算资源。

-

通过在参数空间和数据流空间中操作,实现了对个体模型权重以外的优化,实现了模型合并的优化。

-

创新地合并不同领域(如非英语语言和数学,或非英语语言和视觉)的模型,展示了合并模型在多个基准测试中取得的优秀性能。

-

提出了一种综合的框架,同时在参数空间和数据流空间中进行模型合并,进一步提升了合并模型的性能。

Zipit! merging models from different tasks without training

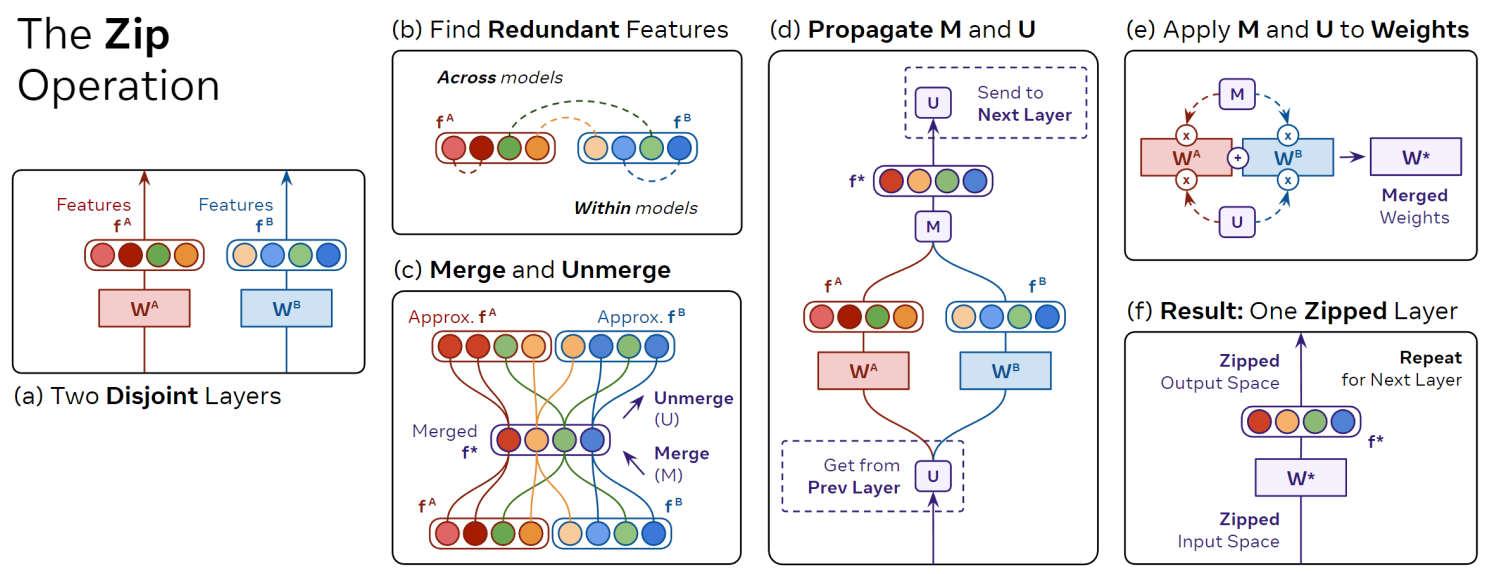

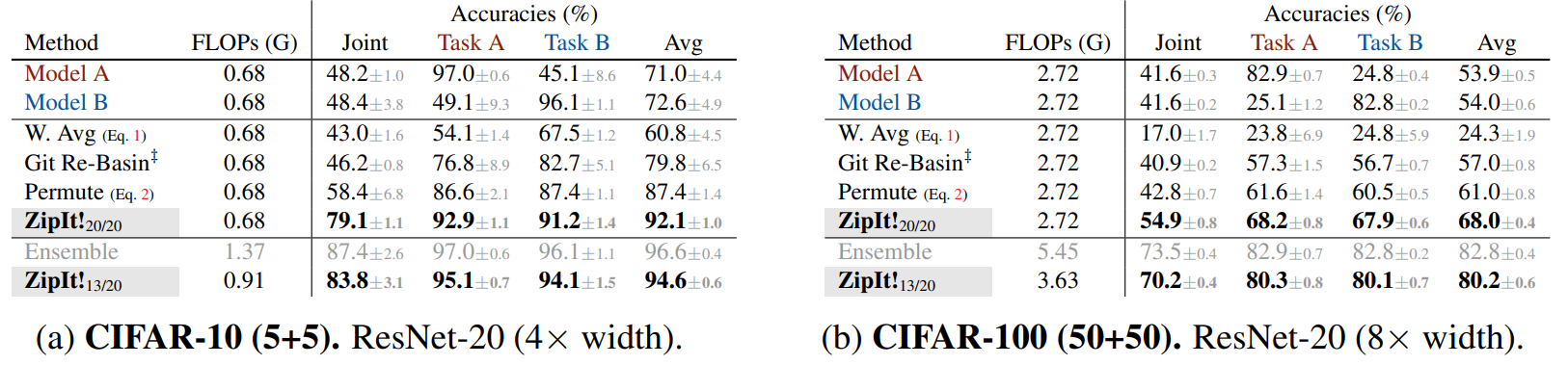

方法:本文提出了一种称为"ZipIt!"的模型融合方法,可以将训练在不同任务上的两个模型合并为一个多任务模型,无需额外训练。与之前的方法不同的是,ZipIt!支持在模型内部和跨模型之间合并特征,从而获得更好的性能。

创新点:

-

该方法引入了两种策略来解决模型融合的问题。首先,为了考虑到模型之间不共享的特征,它扩展了模型合并问题,允许在每个模型内部合并特征,通过定义一个通用的“zip”操作。其次,它支持部分合并模型,从而创建一个多头模型。

-

通过使用ZipIt!方法,作者发现在合并具有不同初始化的模型时,与之前的方法相比,可以获得20-60%的改进。

TIES-MERGING: Resolving Interference When Merging Models

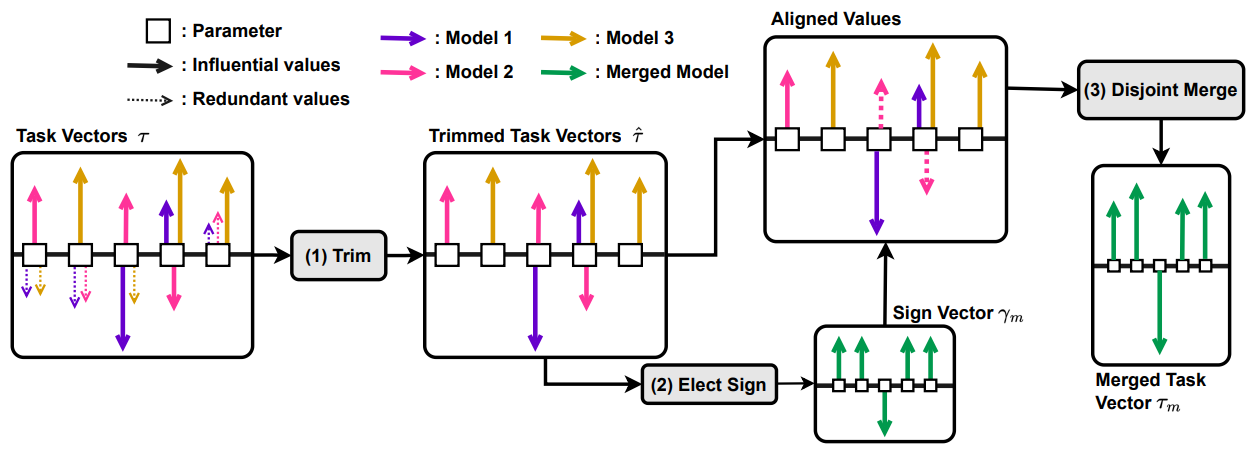

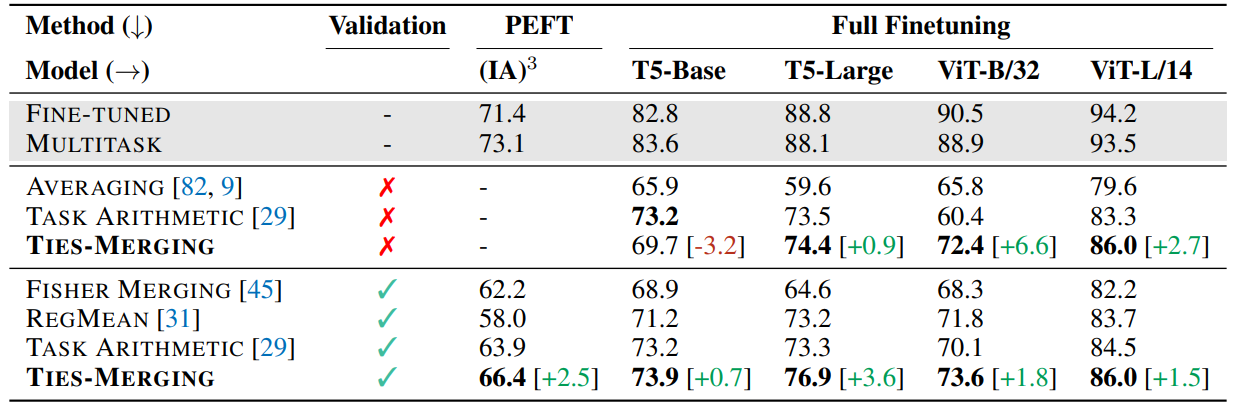

方法:论文介绍了一种解决模型融合中干扰问题的方法——TIES-MERGING。研究目标是将多个专门任务的模型融合为一个多任务模型,以在域内和域外的场景中都能表现良好。

创新点:

-

引入一种解决模型合并时干扰问题的方法TIES-MERGING(修剪、选择符号和合并)。

-

TIES-MERGING修剪了微调模型值中的小幅度变化,然后解决了合并模型间的符号不一致问题。

-

TIES-MERGING在多种设置中优于几种现有方法,包括不同的模态、模型大小、领域、任务数量、架构和微调设置。

SAM-CLIP: Merging Vision Foundation Models towards Semantic and Spatial Understanding

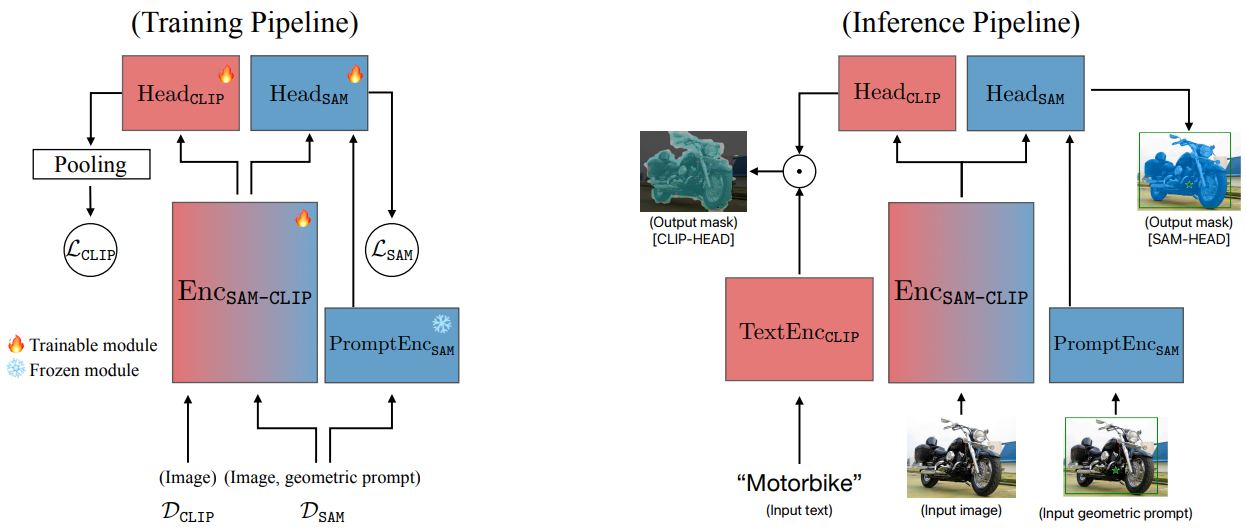

方法:本文介绍了一种有效地合并预训练视觉模型的方法。作者提出了一种多任务蒸馏和记忆重演的简单而高效的方法,将多个视觉模型合并成一个统一的架构。具体来说,作者将该方法应用于合并SAM和CLIP视觉模型,并介绍了合并后的SAM-CLIP模型。

创新点:

-

通过多任务蒸馏和记忆回放的方法,将公开可用的视觉基础模型合并成一个统一的架构。这种方法能够在最小程度上遗忘原始模型的零样本能力,适合在边缘设备上部署。

-

通过合并模型产生更丰富的表示,适用于更多不同的下游任务。与原始模型相比,在头部探测评估设置中,合并的模型能够产生更多样化的表示,具有更多的下游任务可利用性。

关注下方《学姐带你玩AI》🚀🚀🚀

回复“模型融合”获取全部论文+开源代码

码字不易,欢迎大家点赞评论收藏