今天学习了《 茴香豆:企业级知识库问答工具》这一课,对大模型的应用有了更深得认识。以下是记录本课实操过程及截图:

搭建茴香豆虚拟环境:

输入以下命令

``studio-conda -o internlm-base -t huixiangdou

成功安装虚拟环境截图

安装茴香豆

cd /root

克隆代码仓库

git clone https://github.com/internlm/huixiangdou && cd huixiangdou

git checkout 79fa810

上面是安装茴香豆的截图

安装茴香豆所需依赖:

conda activate huixiangdou

parsing word format requirements

apt update

apt install python-dev libxml2-dev libxslt1-dev antiword unrtf poppler-utils pstotext tesseract-ocr flac ffmpeg lame libmad0 libsox-fmt-mp3 sox libjpeg-dev swig libpulse-dev

python requirements

pip install BCEmbedding==0.1.5 cmake3.30.2 lit18.1.8 sentencepiece0.2.0 protobuf5.27.3 accelerate==0.33.0

pip install -r requirements.txt

在这里提醒一下:估计是老师太忙疏忽了,BCEmbedding应是0.1.5。花了多半天时间才弄明白。

python3.8 安装 faiss-gpu 而不是 faiss

上面是更改配置文件,让茴香豆使用本地模型的截图

创建 知识库:

conda activate huixiangdou

cd /root/huixiangdou && mkdir repodir

git clone https://github.com/internlm/huixiangdou --depth=1 repodir/huixiangdou

git clone https://github.com/open-mmlab/mmpose --depth=1 repodir/mmpose

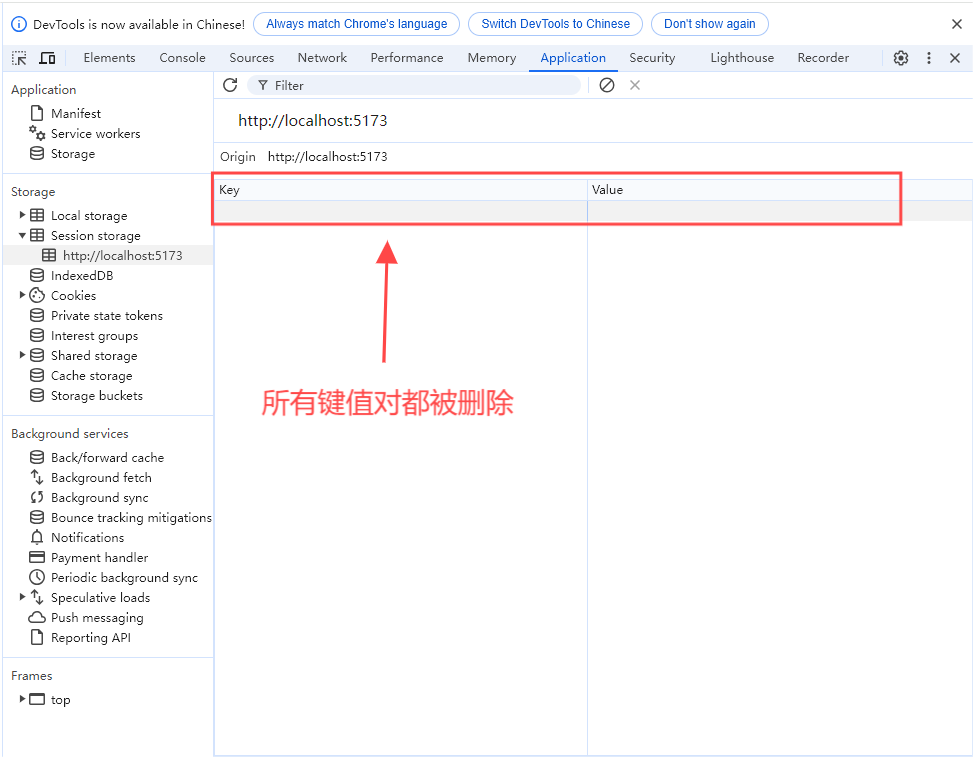

Save the features of repodir to workdir, and update the positive and negative example thresholds into config.ini

mkdir workdir

python3 -m huixiangdou.service.feature_store

上面是知识库的搭建的截图

上面是知识库的搭建的截图

知识库创建成功后会有一系列小测试,检验问题拒答和响应效果,如图所示,关于“mmpose 安装”的问题,测试结果可以很好的反馈相应答案和对应的参考文件,但关于“std::vector 使用”的问题,因为属于 C++ 范畴,不再在知识库范围内,测试结果显示拒答,说明我们的知识助手工作正常。

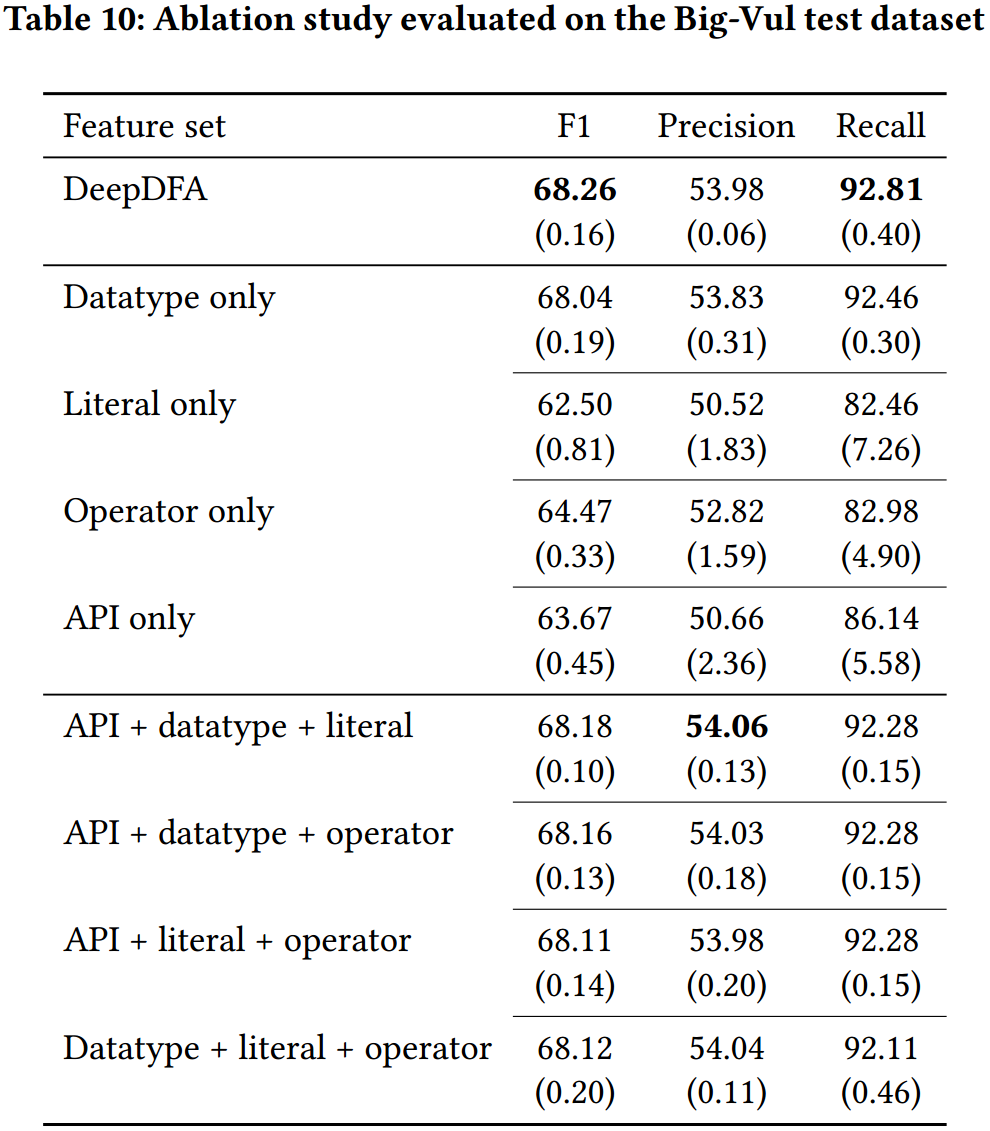

截图未运行前茴香豆的阈值 -1

截图未运行前茴香豆的阈值 -1

运行后茴香豆的阈值0.331506875892811,因此每次更新原始知识文档和正反例,都需要重新运行 命令进行向量知识库的重新创建和应答阈值的更新

python3 -m huixiangdou.service.feature_store

测试知识助手

运行下面的命令,可以用命令行对现有知识库问答助手进行测试:

conda activate huixiangdou

cd /root/huixiangdou

python3 -m huixiangdou.main --standalone

命令行方式启动的截图

Gradio UI 界面测试

在运行茴香豆助手的服务器端,输入下面的命令,启动茴香豆 Web UI:

conda activate huixiangdou

cd /root/huixiangdou

python3 -m huixiangdou.gradio

上面是 Gradio 服务启动成功的截图

对话截图

huixiangdou对话截图

huixiangdou对话截图

以上是这一课的主要过程及截图,请佬们指正。