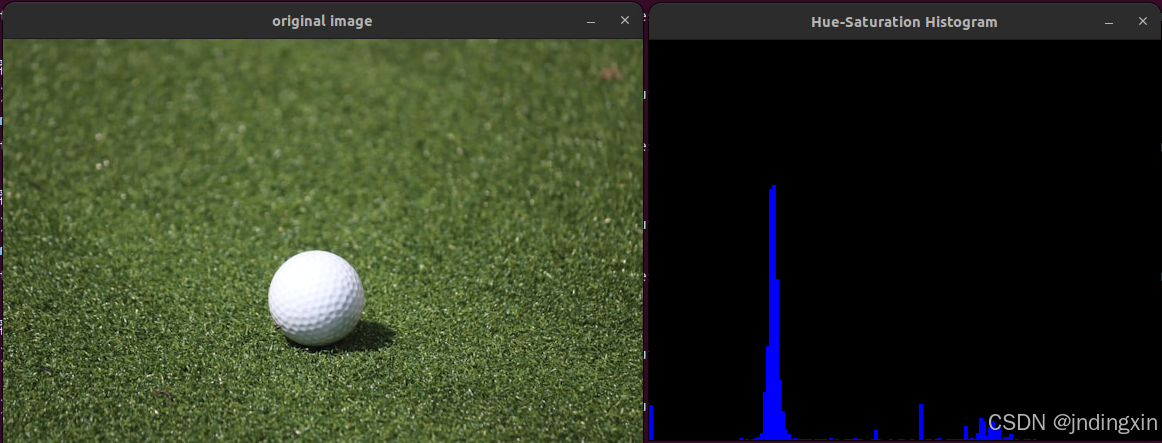

LSTM模型

如图,LSTM模型是rnn模型的改良版,通过ft来选择性的保留上一次得到的信息

ELMo模型(双向LSTM)

ELMo模型是对word2vec的改良,改良了word2vec的二义性

对比上下两图,可以发现,WE对预测词的上下文仅仅只是拼接,所以不能很好的解决二义性的问题,ELMO区分了上下文,可以通过上下文来判断预测词所代表的含义

T1是对这个词的预测,左边框传给T1上文信息,右边框传给T1下文信息,通过这样的方式改善了因为词的二义性造成的问题

训练好之后如何使用

如图所示,和WE训练完的Q矩阵一样,先得到独热向量,用ELMO得到的三层进行处理,最后进行剩余操作。注:LSTM层可以有多个,可以继续堆叠。

学习视频连接如下

该文章是学习b站up主水论文的程序员的笔记,链接如下可自行学习

https://www.bilibili.com/video/BV1mZ4y1q7J2/?spm_id_from=333.788&vd_source=2910693b31a0847b17a3d12d76d0e3f1