(注:本文为小报童精选文章。已订阅小报童或加入知识星球「玉树芝兰」用户请勿重复付费)

千万不要把 AI 生成的结果,直接端出去给你的导师,甚至是投稿到出版社。

需求

我最近在 B 站发布了一个视频,叫做《AI 文献综述效果对比:Dify 工作流 vs Perplexity》。如果你还没来得及看,这是链接。

简要地说,我对比了两种 AI 文献回顾的应用执行效果。第一种是 Perplexity (选择 Focus 信息范围为 Academic 学术来源)。第二种是 Dify 构造的 AI 工作流。对比的方式是提出同样的一个用户提问,然后观察文献回顾效果。

使用 Perplexity ,是因为我在 《文献综述 AI 应用对比 — Elicit, GPTs 与 Perplexity》里面给你对比了不同的 AI 文献回顾应用效果,结果是 Perplexity 最为卓越。

我们这次文献回顾的样例中,问题为:

ChatGPT 给科研工作带来的改变有哪些?

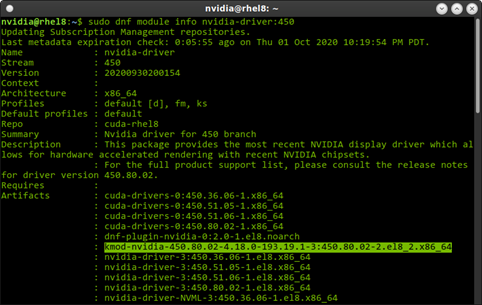

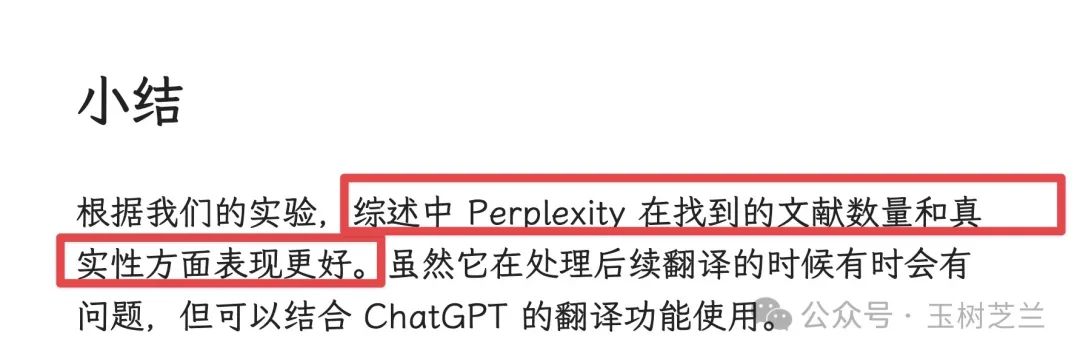

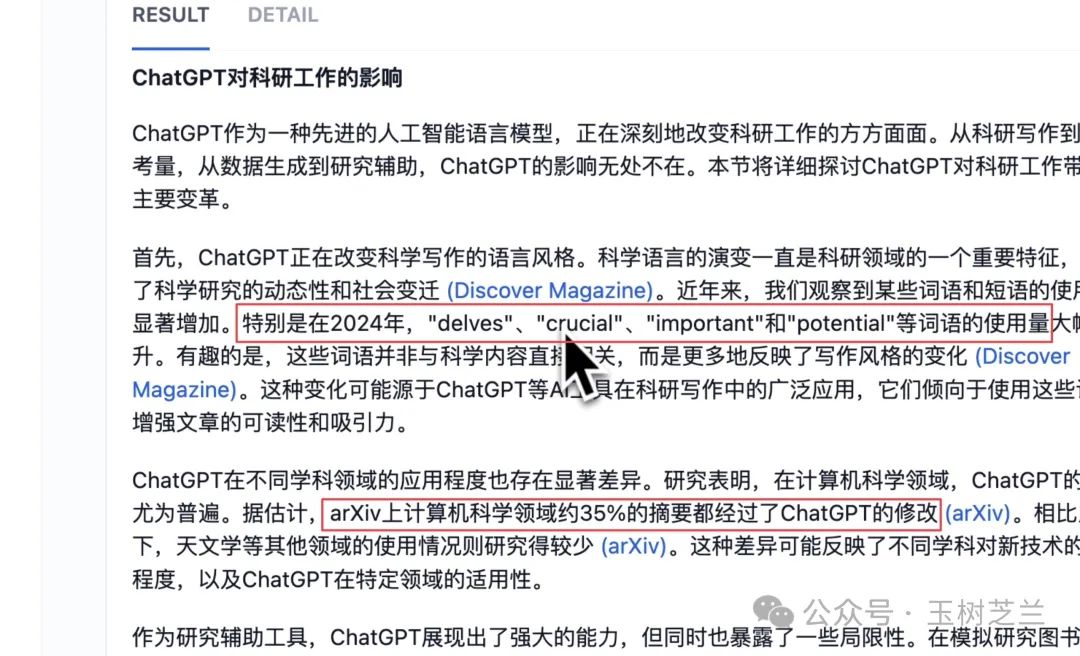

Perplexity 回顾的效果是这样的:

一屏肯定显示不开,后面还有。

Perplexity 会给到你具体的应用方向以及对应的检索来源。对于文献综述来说,这已经是一个非常好的起点。但是你会发现一个问题 ——Perplexity 给出的答案过于言简意赅,我们在这里看不到具体的数据。

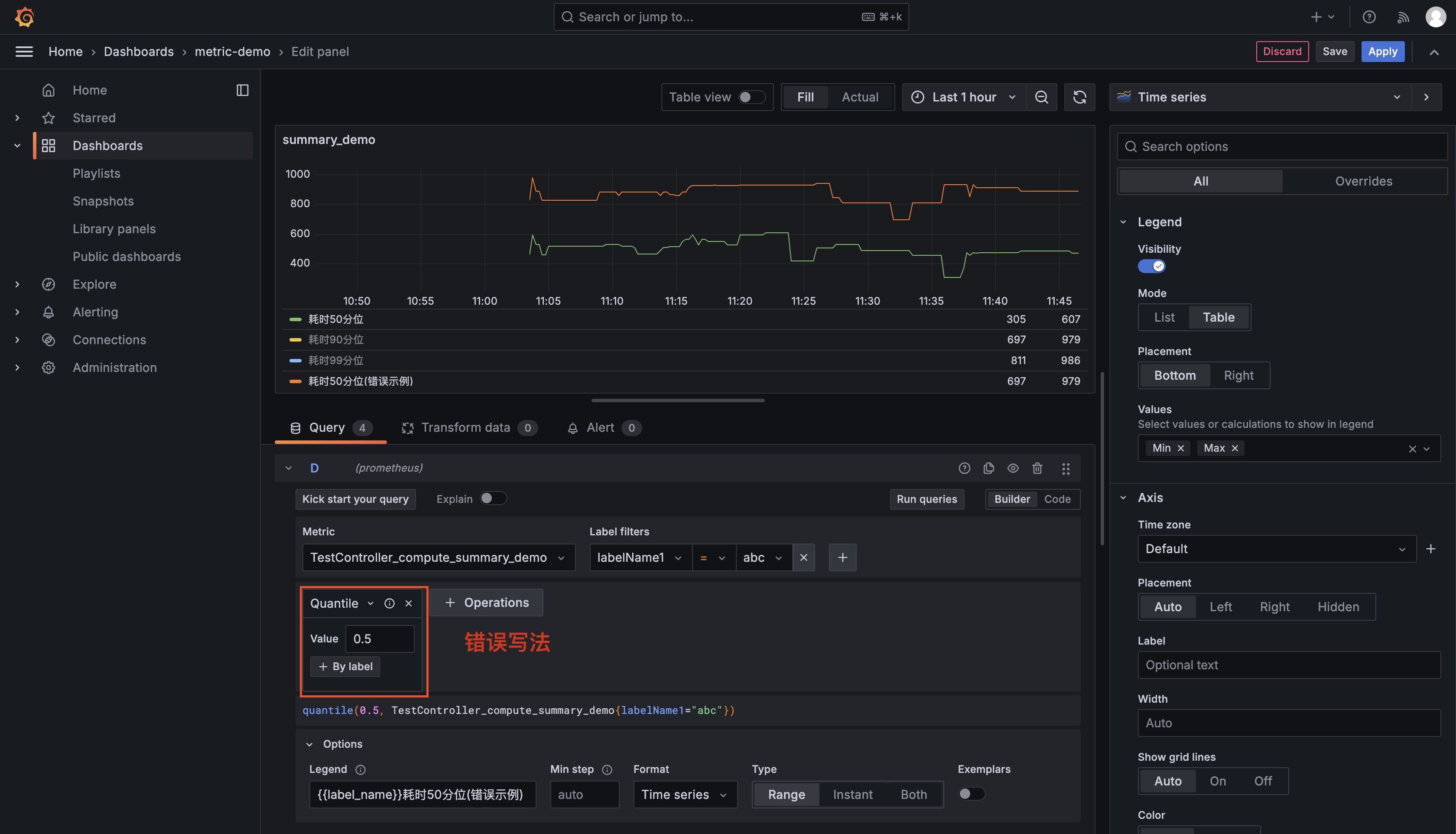

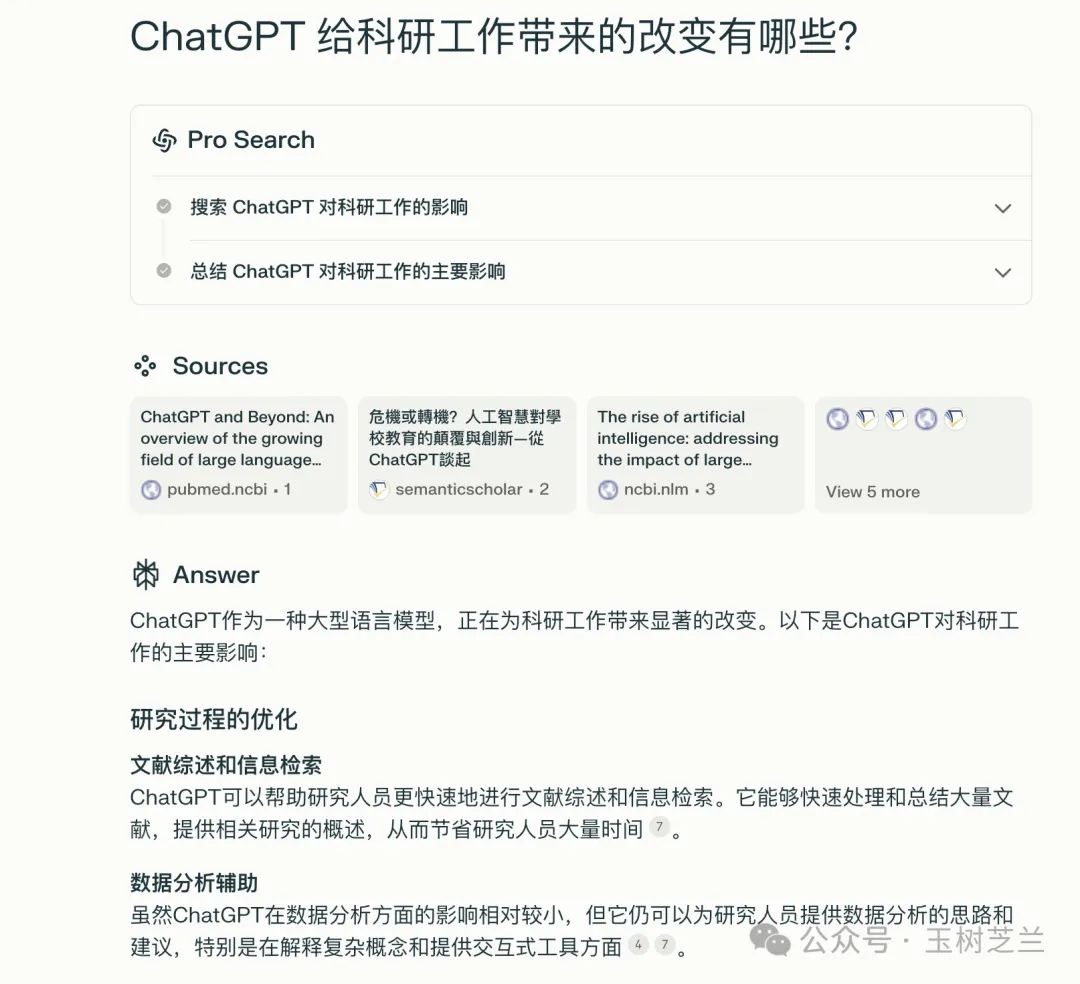

而同样的问题,在 Dify 实现的 AI 工作流中结果是这样的:

我截取了一张结果的图,并且把其中我觉得典型的部分用红色标了出来。

你不难看出区别。这样的总结,有例子,有数据,有文献支撑,更像是我们在一篇文献回顾中愿意看到的样子——它言之有物,不空洞。

文献的引用链接非常显眼,你也可以像在 Perplexity 中一样点击查看对应的内容,以便对相关的证据、数据等加以验证,避免由于大语言模型的幻觉导致最终产出文本可信度受影响。

今天这篇文章,咱们就来讲讲,如何在《如何轻松定制和调用你自己的 AI 工作流?》一文中提过的命令行 AI 工作流框架,实现这种文献回顾效果。