昇腾 Ascend 概念澄清 Host、Device、AI core、AI CPU、DVPP、AIPP、AscendCL、AscendC

flyfish

Ascend C开发算子,偏低。

AscendCL开发应用,偏高。

AI core、AI CPU、DVPP都属于计算资源。

Ascend C开发的算子运行在AI Core上。

AIPP用于在AI Core上完成图像预处理。

DVPP AIPP

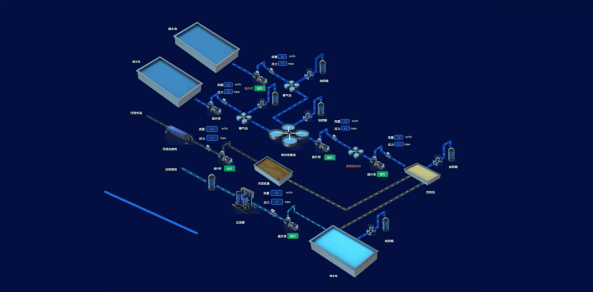

从下图找到AscendCL的位置

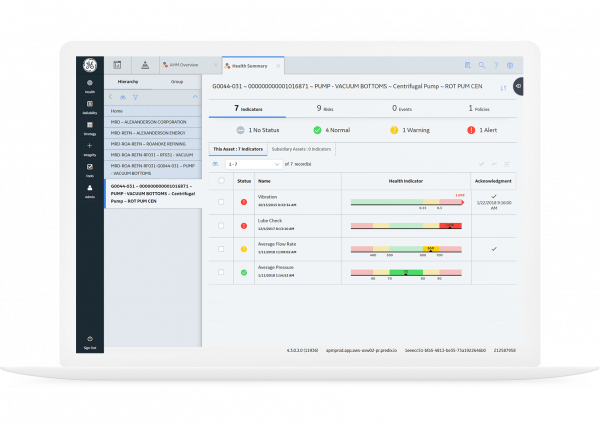

AscendCL(Ascend Computing Language)是一套用于在昇腾平台上开发深度神经网络应用的C语言API库。

图中媒体数据处理就是DVPP

AIcore、AI CPU、DVPP都属于计算资源

DVPP(Digital Vision Pre-Processing)DVPP是昇腾AI处理器内置的图像处理单元

AIPP(Artificial Intelligence Pre-Processing)人工智能预处理,在AI Core上完成数据预处理。

AI

AI

你问我AIPP算什么?我现在告诉你,你们DVPP不敢管的事,我们AIPP管。

先斩后奏,昇腾特许!这就是AIPP,够不够清楚。

AIPP、DVPP可以分开独立使用,也可以组合使用。

组合使用场景下,一般先使用DVPP对图片/视频进行解码、抠图、缩放等基本处理,

但由于DVPP硬件上的约束,DVPP处理后的图片格式、分辨率有可能不满足模型的要求,

因此还需要再经过AIPP进一步做色域转换、抠图、填充等处理。

AI Core

基于Ascend C开发的算子运行在AI Core上

AIPP(Artificial Intelligence Pre-Processing)用于在`AI Core`上完成图像预处理,

包括色域转换(转换图像格式)、

图像归一化(减均值/乘系数)、

抠图(指定抠图起始点,抠出神经网络需要大小的图片)等

AI Core架构本质上是为了适应某个特定领域中的常见应用和算法,通常称为“特定域架构”(Domain Specific Architecture,DSA)。

AI Core不同于传统的支持通用计算的CPU和GPU。

AI Core也不同于专用于某种特定算法的专用芯片ASIC(Application Specific Integrated Circuit)。

昇腾AI处理器的计算核心主要由AI Core构成,从控制上可以看成是一个相对简化的现代微处理器的基本架构。

AI CPU

AI CPU负责执行昇腾AI处理器的CPU类算子(包括控制算子、标量和向量等通用计算)

你问我AI CPU算什么?我现在告诉你,你们AI core不敢管的事,我们AI CPU管。

先斩后奏,昇腾特许!这就是AI CPU,够不够清楚。

Host指与Device相连接的X86服务器、ARM服务器,会利用Device提供的NN(Neural-Network )计算能力,完成业务。

Device指安装了昇腾AI处理器的硬件设备,利用PCIe接口与Host侧连接,为Host提供NN计算能力。