前言

随着人工智能技术的发展,大模型已成为智能系统进步的关键力量。

模型以其庞大的数据容量和深度学习能力,为处理复杂任务提供了前所未有的可能性。但在特定应用场景下仍面临挑战,尤其是在需要快速、准确响应的情境中。为了克服这些限制,构建一个基于大模型的本地知识库显得尤为重要。

01

关于本地知识库

本地知识库是一个存储特定领域知识的数据集,它可以是结构化的数据库、文档集合,或者其他形式的信息源。与通用知识库不同,本地知识库关注于特定的业务需求或领域,能够提供更为精确的信息和上下文。

本地知识库是存储在系统内部的、用于支持决策和问题解决的信息集合。它通常包含事实、规则、概念和过程等,这些信息被组织成易于访问和检索的形式。

本地知识库比作一个图书馆,里收藏了各种书籍和资料,我们可以根据需要查找和借阅。类似地,本地知识库存储了各种信息,人工智能系统可以根据需求检索和使用这些信息。

本地知识库的主要功提供信息支持。它允许系统快速访问和利用存储的知识,以执行任务、解决问题或生成响应。此外,知识库还支持学习过程,通过不断更新和扩展知识来提高系统的性能。

本地知识库对于提高系统的智能性和效率至关重要。没有知识库,系统可能无法有效地处理复杂问题或提供有用的信息。

02

搭建本地知识库

本地知识库问答应用需要对本地知识库智能搜索的能力,还需要具有语义理解和文字总结的能力。大模型正是这一场景的技术工具,将大模型语义理解和文字总结能力与本地知识库的内容相结合,可以构建出一个强大的问答系统。

- 数据采集层

负责从各类数据源抓取、整理、清洗和存储各种类型的知识内容。

- 知识处理层

利用LangChain接入LLM进行文本理解和生成,将原始数据转化为结构化或半结构化的知识实体和关系。

- 检索与推荐引擎

依托向量数据库构建检索链,实现基于语义理解的高精度知识检索与相关性推荐。

- Web展示层

借助Streamlit框架开发交互式Web应用,为用户提供简洁易用的查询界面与可视化结果展示。

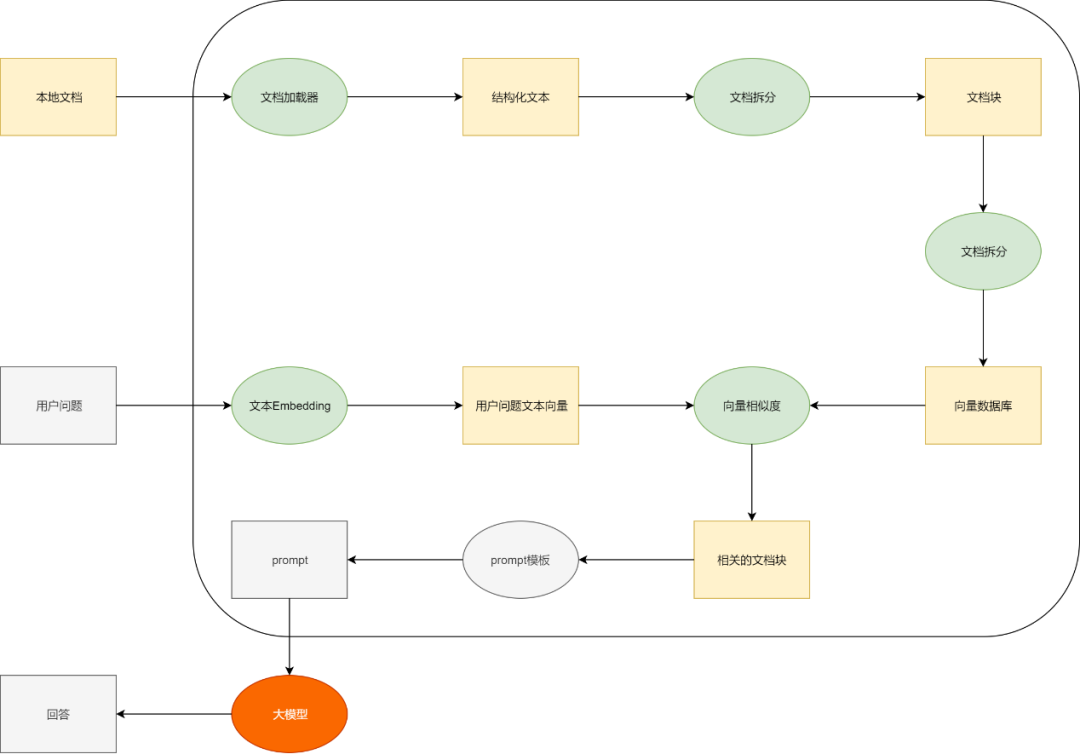

在进行模型问答时,使用信息检索构建知识库查询,将检索结果提供给大模型进行理解和生成。该方法使大模型作为用户和搜索系统中介,发挥其自然语言处理能力:对用户请求进行纠错、提取关键点等预处理实现“理解”;

对输出结果在保证正确性的基础上进行概括、分析、推理。这样无论是数据规模、查询效率、更新方式都可以满足常见知识库应用场景的需要。

检索增强生成相关技术栈较为成熟,降低了探索风险,主要涉及到对文档的加载、切分、向量化、相似度比对等,通过将挑选出的内容与问题,一起输入给大模型,再通过prompt模板进行问答效果优化。

03

搭建技术路线

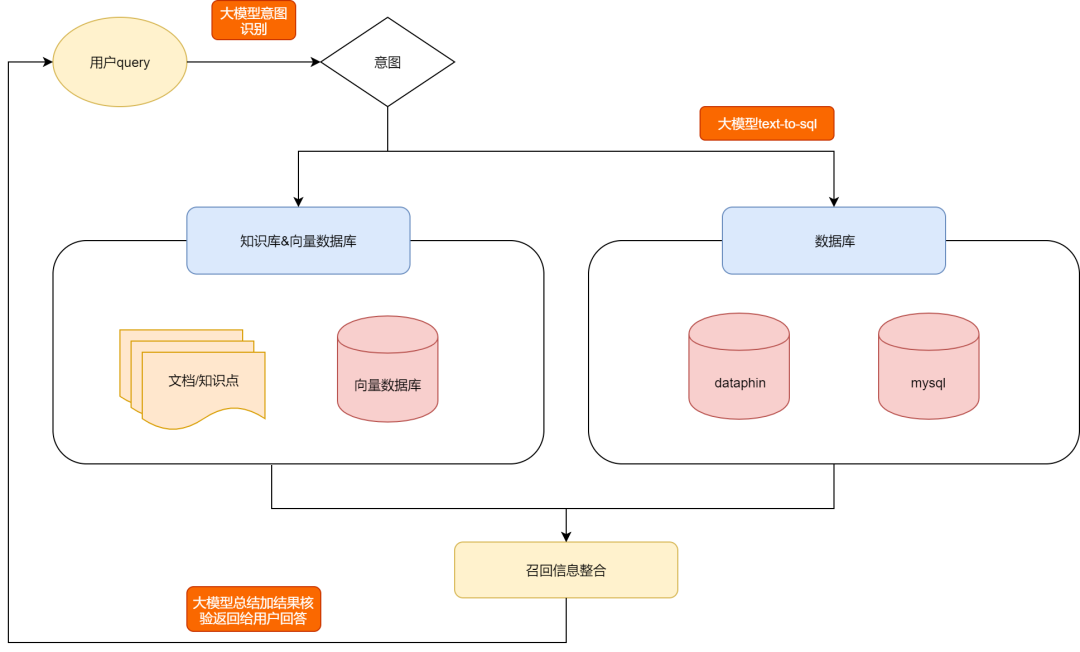

利用大语言模型构建本地知识库的应用场景,结合了自然语言处理技术和知识管理功能,能够帮助用户更有效地组织、搜索和利用本地的知识资源,其主要功能应用包括:

- 文本检索

可以通过关键词、短语或问题搜索知识库中的文本内容,支持全文搜索、模糊搜索和语义搜索,以便用户找到所需信息。

- 智能问答

通过自然语言问答形式,利用大语言模型理解用户提出的问题,帮助用户获取所需信息,提高问答效率。

- 知识管理

用户可以将自己的知识资源整理、存储和管理到知识库中,包括创建、编辑和删除文本、笔记或标签等。

- 智能推荐

基于用户的历史操作偏好和专业领域知识信息,应用可以提供个性化的内容推荐,帮助用户发现新的知识。

- 自然语言处理

通过自然语言处理,完成用户输入的语义理解,并基于知识库匹配相关的信息,形成自然语言解答。

- 文本写作

利用大模型知识库,根据用户的需求帮助用户快速生成高质量的专业领域文章。

当前,使用检索增强生成(RAG)已经成为业内公认的大模型最佳落地范式之一即大模型知识库的关键技术路线。这个范式简单来说就是大模型+知识库。是一种结合检索和生成模型的方法,旨在提高生成式模型的性能,尤其是在开放领域的问答任务中。RAG结合了检索模型和生成模型,利用检索模型从大型语料库中检索相关文本片段,然后将这些文本片段作为上下文输入到生成模型中,生成更加相关和准确的回答。

RAG为生成式大模型与外部信息交互提供了良好的解决方案,其主要作用类似搜索引擎,找到用户提问最相关的知识或者是相关的对话历史,并结合原始提问,创造信息丰富的prompt,指导模型生成准确输出。本质上应用了情境学习的原理。

大模型知识库的架构图如下图所示:

04

StreamlitWe优势

相较于常见的Flask和Django等Web框架,Streamlit具有以下优势:

快速开发: Streamlit是专为数据分析和可视化应用设计的Python框架,提供了简单的API和组件库,使得开发者能够快速构建出美观的数据探索应用。

无需关注布局与样式: Streamlit自动管理UI布局,简化了前端开发流程,使开发人员能够更加专注于业务逻辑和数据处理。

实时更新: Streamlit支持实时数据流,当后端数据发生变化时,Web应用会立即响应并更新视图,为用户提供沉浸式的交互体验。

05

LangChain接入LLM

LangChain是一个可扩展的语言模型接口,旨在帮助开发者轻松集成高质量的LLM,如GPT-4,智谱GLM、通义千问、文心一言、讯飞星火。我们将通过LangChain将LLM融入到知识库系统中,主要实现以下功能:

知识抽取: 对输入文本进行语义分析和理解,提取关键知识点及实体关系,形成结构化的知识图谱。

知识问答: 基于LLM的强大自然语言处理能力,实现精确的问题解答和推理。

自动摘要: 自动生成长篇文档的精炼概述,便于用户快速浏览和获取核心信息。

from langchain.prompts.chat import ChatPromptTemplate

template = "你是一个翻译助手,可以帮助我将 {input_language} 翻译成 {output_language}."

human_template = "{text}"

chat_prompt = ChatPromptTemplate.from_messages([

("system", template),

("human", human_template),

])

text = "我带着比身体重的行李,\

游入尼罗河底,\

经过几道闪电 看到一堆光圈,\

不确定是不是这里。\

"

messages = chat_prompt.format_messages(input_language="中文", output_language="英文", text=text)

messages

[SystemMessage(content='你是一个翻译助手,可以帮助我将 中文 翻译成 英文.'),

HumanMessage(content='我带着比身体重的行李,游入尼罗河底,经过几道闪电 看到一堆光圈,不确定是不是这里。')]

output = llm.invoke(messages)

output

AIMessage(content='I carried luggage heavier than my body and dived into the bottom of the Nile River. After passing through several flashes of lightning, I saw a pile of halos, not sure if this is the place.')

06

向量数据库检

向量数据库通过将文本数据映射为高维向量空间中的点,实现了基于语义相似度的检索方法。在我们的知识库系统中,具体应用包括:

知识表示: 使用预训练词嵌入模型将知识实体转换为向量形式,建立基于向量的空间索引。

高效检索: 用户输入查询后,计算其与知识库中所有条目的向量距离,从而找到最相关的知识内容。

可拓展性: 随着知识库的增长,向量数据库仍能保持良好的性能和准确性,适用于大规模知识图谱的检索任务。

07

结语

搭建一个本地知识库不仅能提升语言大模型在特定领域的表现,还能增强其处理复杂问题的能力。通过明确需求、精心收集和整理数据、选择合适的存储方案、建立高效的索引系统,以及不断维护和更新知识库,您可以显著提升模型的效能,满足特定领域的需求。

如何学习大模型

现在社会上大模型越来越普及了,已经有很多人都想往这里面扎,但是却找不到适合的方法去学习。

作为一名资深码农,初入大模型时也吃了很多亏,踩了无数坑。现在我想把我的经验和知识分享给你们,帮助你们学习AI大模型,能够解决你们学习中的困难。

我已将重要的AI大模型资料包括市面上AI大模型各大白皮书、AGI大模型系统学习路线、AI大模型视频教程、实战学习,等录播视频免费分享出来,需要的小伙伴可以扫取。

一、AGI大模型系统学习路线

很多人学习大模型的时候没有方向,东学一点西学一点,像只无头苍蝇乱撞,我下面分享的这个学习路线希望能够帮助到你们学习AI大模型。

二、AI大模型视频教程

三、AI大模型各大学习书籍

四、AI大模型各大场景实战案例

五、结束语

学习AI大模型是当前科技发展的趋势,它不仅能够为我们提供更多的机会和挑战,还能够让我们更好地理解和应用人工智能技术。通过学习AI大模型,我们可以深入了解深度学习、神经网络等核心概念,并将其应用于自然语言处理、计算机视觉、语音识别等领域。同时,掌握AI大模型还能够为我们的职业发展增添竞争力,成为未来技术领域的领导者。

再者,学习AI大模型也能为我们自己创造更多的价值,提供更多的岗位以及副业创收,让自己的生活更上一层楼。

因此,学习AI大模型是一项有前景且值得投入的时间和精力的重要选择。