文章介绍了REAPER(Reasoning based Retrieval Planning for Complex RAG Systems),这是一种基于大型语言模型(LLM)的规划器,用于在复杂的对话系统中生成检索计划。REAPER旨在解决在大规模异构数据存储中进行有效证据检索的问题,尤其是在需要多步骤检索的情况下。传统的RAG(Retrieval Augmented Generation)系统通常采用链式思考(Chain-of-Thought, CoT)的方式,将推理和检索步骤交织在一起处理复杂的查询任务,但这种方式会增加系统的响应时间。REAPER能够显著降低这种延迟,并且比基于分类的方法更容易扩展到新的使用场景。

该研究展示了REAPER在零售对话助理中的应用效果,这类助手需要从多个来源如产品评论、信息页面等检索信息来回答客户的问题。这些对话系统通常被训练以理解产品目录和开放数据源,以便于帮助用户发现产品。对于复杂的对话系统来说,它们需要从可能包含PB级别的异构文档的多个索引中检索证据。REAPER通过决定查询哪些索引以及何时让LLM直接利用其预训练知识来回答问题,从而优化了检索过程。此外,REAPER还考虑到了多步骤检索的情况,例如当用户询问关于他们特定订单的问题时,系统首先需要找到相关的订单信息,然后再获取与该订单相关的产品信息。

RAG框架是一种用于复杂对话系统的架构,它通过从大型异构数据存储中检索相关证据来辅助生成事实性的回答。这些数据存储通常被组织成多个索引或API,而不是单一的数据源。在给定查询的情况下,需要从一个或少量可能的检索来源中获取相关的证据。

l多跳问答和生成

多跳问答涉及在生成最终答案之前执行一系列推理和检索步骤。例如,在零售对话系统中,当客户询问关于他们过去订单的问题时,系统首先需要检索正确的订单记录,然后根据该订单上下文检索与问题相关的证据。这种链式思考(Chain-of-Thought, CoT)任务需要在推理和检索之间交织操作。

l密集检索方法

密集检索方法是一种用于开放域问答的技术,其中使用编码器模型将文档嵌入到稠密向量空间中。查询也被转换为稠密向量,然后使用近似最近邻搜索算法来找到最相关的文档。这种方法比传统的稀疏检索技术(如TF-IDF或BM25)在性能上有所提高。

l对话系统中的知识增强

对话系统中的知识增强是指利用外部知识源来改进系统的响应质量。这可以通过检索相关证据并将其整合到语言模型的生成过程中来实现。例如,一个购物助手可以被训练以使用产品目录和开放数据源,以便在回答用户查询时提供更准确的信息,帮助用户发现合适的产品。

1 PEAPER的设计

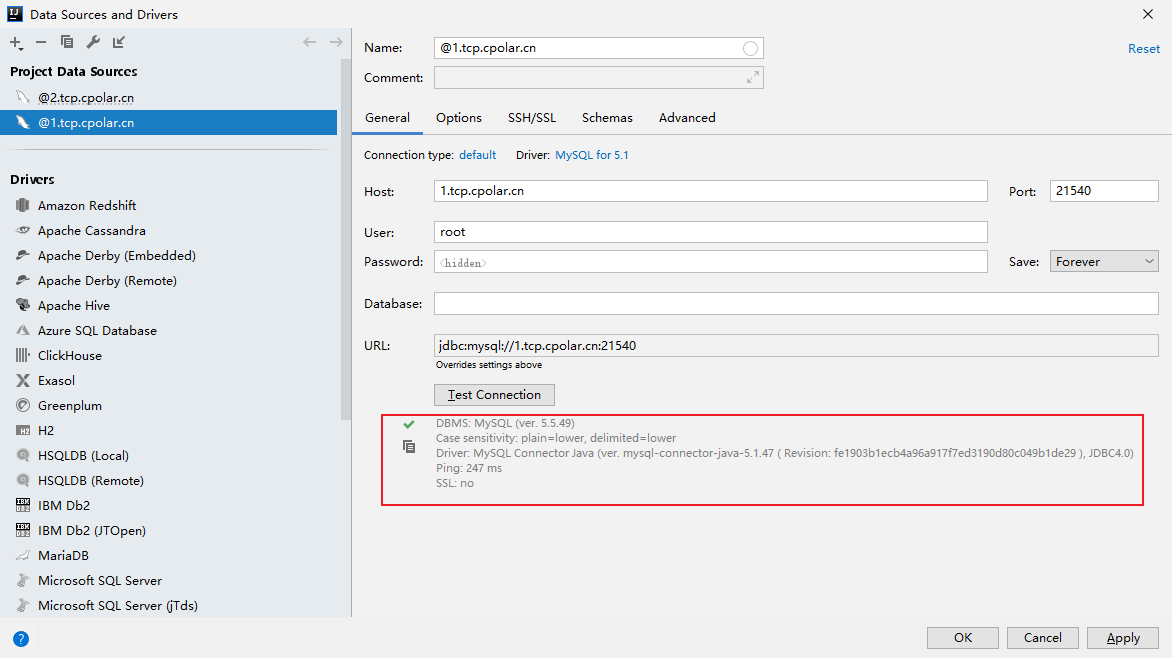

REAPER是一个旨在提升复杂查询处理效率的系统,特别是对于需要从多种异构数据源检索证据的对话系统。它通过一个小规模语言模型快速生成完整的检索计划,包括所需工具的选择、调用顺序及参数设置,从而减少了处理延迟。REAPER在工具序列选择上的准确率达到95%,在参数生成上的准确率为92%,并且易于扩展至新的数据源和应用场景。作为一个独立的规划器,REAPER专注于优化检索流程,进而帮助最终的回答生成模型提供更高质量的响应。

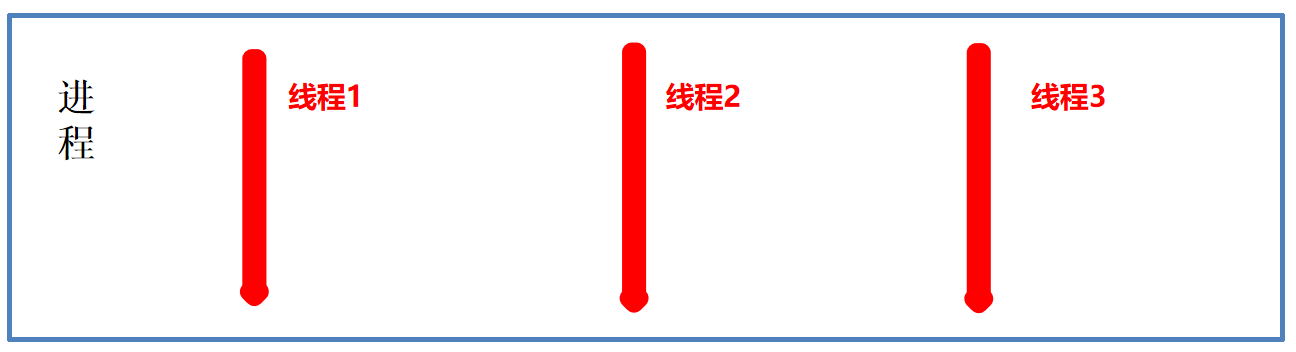

2 系统架构

(1)输入:

用户查询以及相关的上下文信息作为REAPER的输入。

上下文信息可以包括产品信息、对话历史、提问的时间、用户信息等。

(2)工具理解和调用:

REAPER需要理解所有可用的工具,这些工具用于生成证据。

REAPER生成的计划包括工具的选择、调用顺序和传递给每个工具的参数。

(3)检索计划生成:

REAPER通过Chain-of-Thought (CoT) 推理生成检索计划。

单步或多步检索计划可以由REAPER生成,取决于查询的复杂性。

(4)证据检索:

基于REAPER生成的计划,相应的工具被调用来从不同的数据源中检索证据。

(5)响应生成:

一个较大的语言模型使用从REAPER生成的计划中获取的证据来生成适当的响应。

对于数据处理部分,大量异构数据存储通常被构建成多个索引或API,而不是单一的大型数据源。REAPER能够处理这种复杂的数据结构,有效地从一个或几个可能的检索源中检索相关证据。

3 结语

文章介绍了一种名为REAPER的推理基础检索规划方法,用于高效生成复杂查询所需的检索计划,以支持基于RAG的对话系统,通过减少延迟并保持响应质量。

论文题目: REAPER: Reasoning based Retrieval Planning for Complex RAG Systems

论文链接: https://arxiv.org/abs/2407.18553

PS: 欢迎大家扫码关注公众号_,我们一起在AI的世界中探索前行,期待共同进步!