论文名称:Large Kernel CNNs from a Weakly Supervised ObjectLocalization Perspective

论文地址:[2403.06676] CAM Back Again: Large Kernel CNNs from a Weakly Supervised Object Localization Perspective (arxiv.org)

出发点

据报道,大尺度卷积核的cnn在下游视觉任务和分类性能方面表现良好,表现优异的原因被认为是由于大核产生的大有效接受场(ERF),然而这一观点在当前尚未得到充分的验证。作者选择弱监督对象定位(weakly supervised object localization简称WSOL)作为一个新的角度探索大卷积核CNN能力。作者研究比较了现代大型内核cnn ConvNeXt、RepLKNet和SLaK,以测试ERF大小对提高下游任务性能很重要的朴素期望的有效性。作者发现现代CNN对被激活物体局部区域的CAM问题具有鲁棒性,这在WSOL中已经被讨论了很长时间。

主要贡献

1、具体来说,作者表明很难将erf的大小定位为性能改进的主要因素,至少对于WSOL来说是这样,并且大型内核cnn的高性能是由于改进的特征映射。

2、作者发现上面描述的特征映射改进有效地避免了激活对象局部区域的CAM问题,这个问题在WSOL中已经讨论了很长时间。

3、在CUB-200-2011数据集上的WSOL实验表明,简单地将最新的大核CNN与最经典的WSOL方法(CAM)和简单的数据增强技术相结合,可以获得与最先进的基于CNN的WSOL方法相当的性能。此外,基于我们的发现提出的新的简单方法比基于cnn的最先进的分数高出0.43%。

主要实验

1、ConvNeXt、RepLKNet、SLaK和经典CAM的简要知识

1)ConvNeXt架构图(ConvNeXt详细解答)

2) RepLKNet架构(RepLkNet详解)

3)SlaK详解

4)经典的CAM (详解)

用卷积神经网络(CNN)最后一层的特征图来生成一个热图,突出显示图像中对分类结果有贡献的区域。

2、传统CNN与和最新CNN实验

1)实验结果

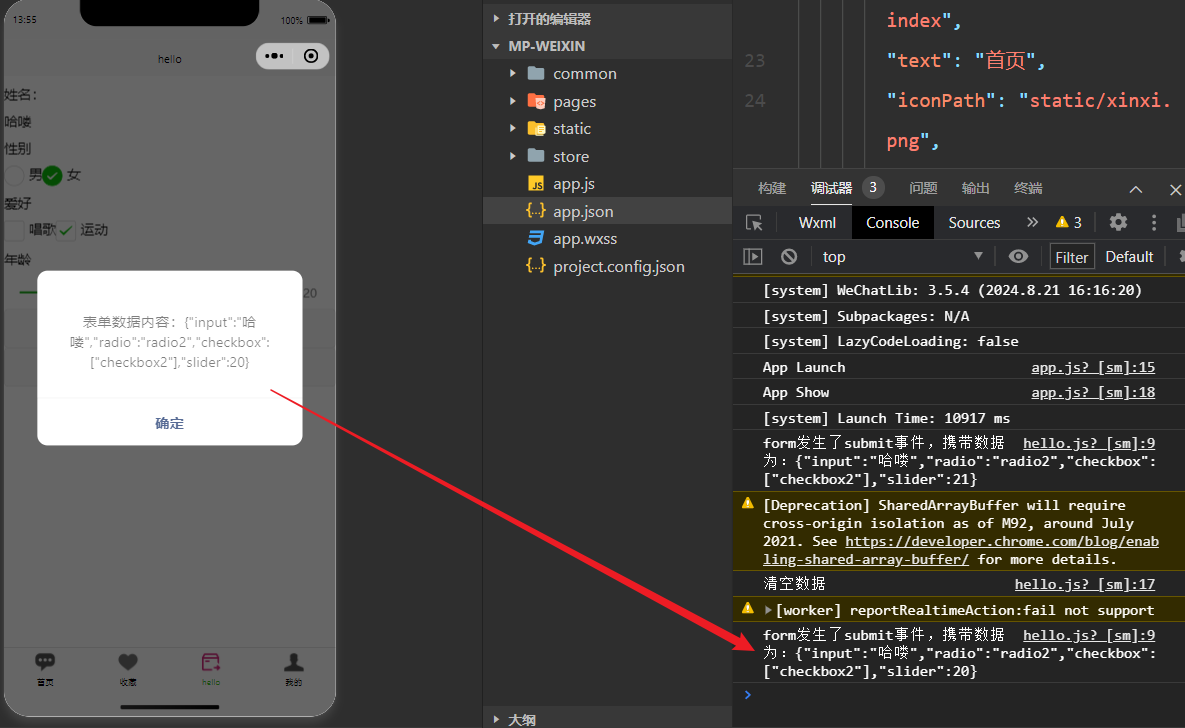

实验1证明了简单地将最新的大核cnn与最经典的WSOL方法(CAM)和简单的数据增强方法相结合,可以获得与最先进的基于cnn的WSOL方法相当的性能。下图显示了传统CNN (ResNet50[16])和最新CNN在CUB-2002011数据集上的WSOL得分。

下表显示了我们的最佳得分和其他基于cnn的WSOL方法的得分。我们的带有RepLKNet骨干网的CAM得分明显优于带有ResNet骨干网的wsol优化CAM,击败了所有2021年之前的方法。我们的模型与较新的WSOL方法相比也具有竞争力。由于CAM存在各种问题,例如倾向于只激活对象的局部区域,因此尝试了各种改进,如表1所示。这些改进包括从数据增强策略到更复杂的训练方法和后处理。然而,我们已经证明,简单地将最新的大核cnn与最经典的WSOL方法(CAM)和简单的数据增强方法相结合,可以获得与最先进的基于cnn的WSOL方法相当的性能。

2)CAM在WSQL任务中遇到的问题、产生的原因和如何解决

问题1:CAM倾向于生成局部激活的映射,是不正确的定位(如下图1,CAM得到的只有鸟的头部)

产生上述问题的原因有两个:1)由于GAP层的存在,激活区域和权重的乘积对logit有贡献,CNN训练倾向于增加激活对识别重要的局部区域的特征映射对应的权重。这种效应增强了局部特征映射对CAM的贡献。2)如果在目标区域(特别是对分类不重要的区域)激活负权重对应的特征映射,则定位将进一步缩小到目标的可识别区域。上图1用实际的特征图说明了这些问题。

解决1:现代CNN模型可以解决CAM存在的问题1(效果图2如下)

对于ConvNet、RePLKNet和SLak生成的CAM,我们可以看到,特别是ConvNeXt和RepLKNet生成的CAM,整个对象被激活而不是局部。

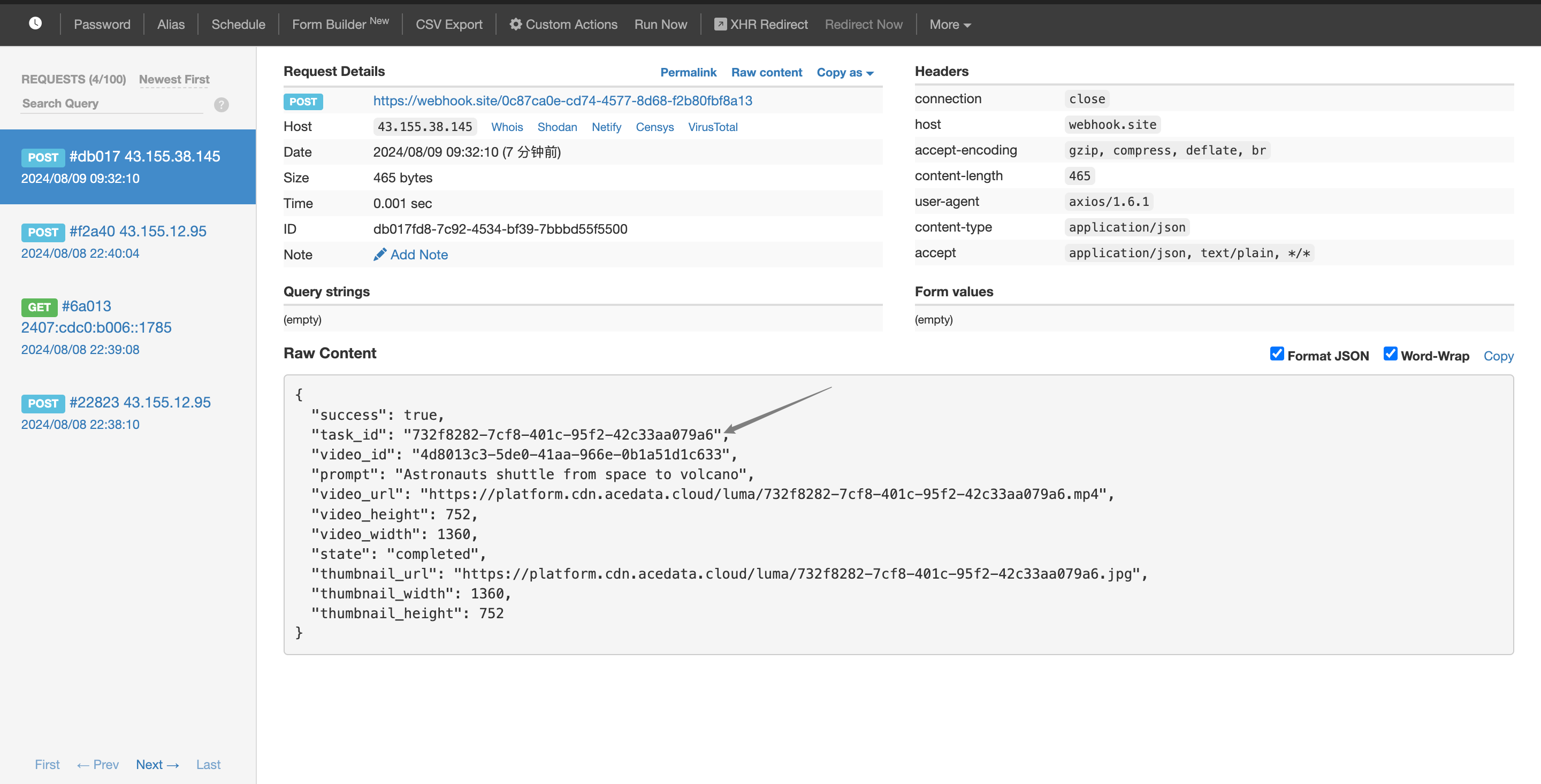

问题2:CAM在图1中Fj所示的负权重问题

解决2:现代CNN模型解决CAM在图1中Fj所示的负权重问题(效果图3如下)

上图3显示了三种不同最新cnn的大正负权特征图。下面,我们将正负权值对应的特征映射分别称为Fpos和Fneg。ConvNeXt和SLaK激活了许多Fneg,而RepLKNet激活的地图较少。Fneg具有抑制正确类别的最终logit激活的作用,不应该在分类任务中激活它。因此,从分类任务的角度来看,RepLKNet特征映射处于理想状态。对于WSOL任务来说,这种非激活状态也是避免这种局部化问题所需要的。RepLKNet似乎避免了这个问题,因为它倾向于自动停用Fneg。

问题3:激活面积大小和权重大小的问题

解决3:现代cnn如何避免图2中Fi的问题即激活面积大小和权重大小的问题(效果图4如下)

ConvNeXt和RepLKNet产生的CAMs往往会被全局激活(如图2)。这可能是由于显著改进了特征映射本身的全局性,从而减少了迄今为止所描述的问题的影响。为了证实这一点,我们对得到的特征图进行了主成分分析。上图4显示了对鸟类图像生成的特征图进行主成分分析得到的第一主成分(以下简称PC1)的特征。 通过生成全局激活的特征图,ConvNeXt和RepLKNet避免了由于激活区域和权重的大小而导致的局部激活问题。从图4中,我们观察到PC1在ConvNeXt中倾向于激活物体周围的全局区域。另一方面,RepLKNet的PC1可以不浪费地将物体包裹起来,使其具有理想的定位映射形状。SLaK的PC1倾向于局部激活,还有一个明显的趋势是激活与物体无关的区域。

因此,通过生成全局激活的特征图,ConvNeXt和RepLKNet避免了由于激活区域和权重的大小而导致的局部激活问题。

疑惑解答

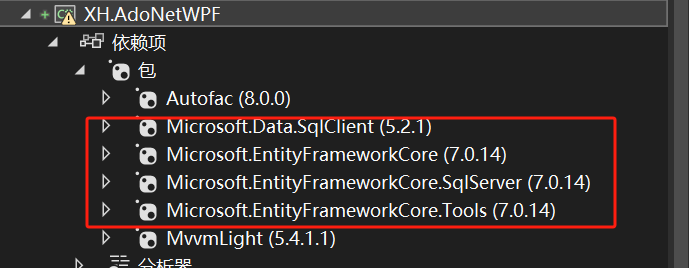

1、内核大小越大,ERF越大吗? 最新CNN模型的ERF总体上比经典CNN模型(如ResNet)大得多,但我们观察到这些报告模型的核大小不一定是ERF大小的主要决定因素。

2、ERF越大,WSOL得分就越高吗?在最新的CNN模型中,ERF大小对下游任务的性能很重要,很难将ERF大小定位为性能提升的主要驱动因素。

3、为什么CAM对于ConvNeXt和RepLKNet趋向于全局,而对于SLaK趋向于局部?GAP值反映了通过全局池化激活区域的面积。对于SLaK, GAP值和权重之间的关系分布为以原点为中心的二维高斯分布。另一方面,ConvNeXt和RepLKNet在GAP值的方向上具有广泛分布的偏差。SLaK的高斯形状与cnn的一般趋势非常相似,特征图中激活区域越小(越大),权重就越大(越小)。因此,由于本文实验部分问题3解释的相同原因,从初始化开始,SLaK固有地倾向于产生局部激活的cam。另一方面,在ConvNeXt和RepLKNet的图中,大权重并不一定意味着小GAP值,从而避免了上面提到的一般CNN趋势。因此,在初始化时,就已经表明ConvNeXt和RepLKNet具有强烈的生成全局激活特征映射的倾向。

总结

1、与最新的大核cnn相结合时,简单的CAM方法在WSOL任务中的表现优于最先进的基于cnn的WSOL方法。

2、提出了一些材料证明无法将ERF的大小作为高性能背后的主要因素。

3、提供了一种新的观点,即WSOL任务中的高性能是由于体系结构的固有能力(例如,有助于生成具有大GAP值或激活区域的特征图的结构)以及特征图的改进。改进的feature map有效地解决了WSOL中讨论已久的被激活物体局部区域的CAM问题。