1 AI大模型介绍

chat-gpt、sora、sd、文心一言(GAI,生成式AI)等等,这些是大模型嘛,准确来说这些只是大模型落地的产品;“大模型”通常指的是拥有大量参数的深度学习模型;因此对计算资源要求很高,入门门槛也比较高。作为一个普通人我们能做的就是在预训练的模型基础上然后做下游任务。如何落地是我们关心的。遇到什么问题,如何解决是我们学习的方法论。

目前大模型的岗位:

- AI 产品策划;

- Ai大模型应用开发;

- AI大模型训练/评测;

- AI大模型算法;

- Ai大模型专家;

1.1 大模型的特点

参数量大:

- 大模型通常具有数百万至数十亿的参数。例如,GPT-3 拥有超过 1750 亿个参数,而 PaLM(Pathways Language Model)更是达到了 5400 亿个参数。

训练数据规模大:

- 大模型通常是在海量数据上训练的,数据集可能包含数万亿个标记(token)。

计算资源要求高:

- 训练大模型通常需要大量的计算资源,包括高性能的 GPU 或 TPU 集群。例如,训练 GPT-3 需要数千张 GPU 并行运算。

多模态能力:

- 一些最新的大模型不仅限于文本数据,还能处理图像、音频等多种模态的数据,实现跨模态的表示学习。

强大的泛化能力:

- 大模型往往能够在未见过的数据上表现出良好的泛化能力,即使是在没有经过特定任务训练的情况下也能取得不错的结果。

零样本和少样本学习:

- 一些大模型能够实现零样本(zero-shot)和少样本(few-shot)学习,即在没有或仅有少量标注数据的情况下就能执行新任务。

1.2 大模型幻觉(胡说八道)

针对不同的业务场景做对策;微调(成本很高)、RAG;

微调

1.2.1 PE工程

Prompt引导LLM回答;

1.2.2 RAG检索增强生成

构建知识库:

- load创建或选择一个包含大量相关文本的数据集。

- 对数据集中的每个文档进行预处理,如分词、清洗、去除停用词等。

- split将文档拆分成较小的段落或句子,形成片段(chunk)。

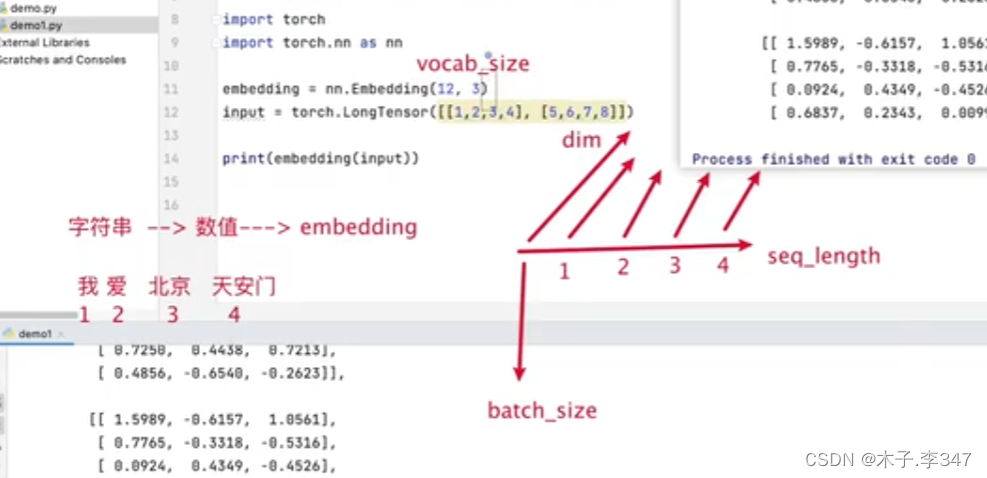

- Embedding对每个片段进行向量化,通常是通过一个预先训练好的嵌入模型(如 BERT)将其转换为向量表示。

- Store 将这些向量存储在一个专门的向量数据库中,便于后续的快速检索。

用户查询:

- 用户提出一个查询或者问题。

查询向量化:

- 使用相同的嵌入模型将用户查询转换为向量表示。

相似性检索:

- 利用向量数据库的相似性搜索功能,寻找与查询向量最相似的前K个片段。

- 这些片段通常被称为上下文(context),因为它们为生成的响应提供了背景信息。

生成响应:

- 将查询及其检索到的上下文一起作为输入(高效Prompt)传递给生成模型。

成功率最高成本最低;不需要改变大模型,只是在原有的基础上扩展知识,搭建一套检索库;

检索库:

- 向量检索库:只是向量的高校检索;

- ES;

1.2.2.1 如何对文本切割

随便切割?太大太小都不好。

基于知识图谱:保证完整性;

1.2.3 fine-tune

咨询业务:需要模型具备专业的能力,用户的体验要高(响应时间),基于一个预训练的模型做训练;垂直模型;

技术:Lora / QLora;

LangChain