文章目录

- 前言

- 一、数据收集

- 二、数据预处理

- 1、特征选择与构建

- 2、数据清洗与预处理

- 三、模型选择

- 1、模型选择

- 2、模型训练

- 四、模型评估与优化

- 1、模型评估

- 2、模型优化:

- 五、模型解释与部署

- 1、模型解释

- 2、模型部署

- 六、代码解读及实现

- 1. 数据准备

- 2.数据预处理

- 3、模型构建

- 4、数据划分

- 5、模型训练

- 6、模型预测与评估

- 7、模型优化(可选)

- 总结

前言

机器学习模型是一种强大的工具,它可以通过学习过去的数据来预测未来的结果。在各个领域,将机器学习模型用于预测分析已经成为一种趋势。无论是金融、医疗、销售还是制造业,机器学习模型的应用都可以帮助我们做出更准确的决策。在本文中,我将简单介绍如何使用机器学习模型进行角球数预测分析,并提供一些实用的技巧和步骤。

一、数据收集

- 收集历史足球比赛数据,包括但不限于每场比赛的角球数、球队信息(如主客场、球队实力、球员状态)、比赛结果、天气条件、球场类型等。

- 数据来源可以是专业的体育数据提供商网站、API接口或公开数据库。

二、数据预处理

- 清洗数据:去除重复项、缺失值处理(填充或删除)、异常值检测与处理。

- 特征工程:根据业务需求提取并构建有效的预测特征,如球队历史角球能力、近期比赛状态、对手实力对比、历史交锋记录等。

- 数据编码:将分类变量(如球队ID、球场类型)转换为数值型特征,便于模型处理。

- 数据划分:将数据集划分为训练集和测试集,通常比例为70%训练集、30%测试集。

1、特征选择与构建

- 基础特征:包括每支球队的历史平均角球数、近期比赛角球数、主客场因素、球队实力评分(如根据历史胜率、进球数等计算)。

- 交互特征:考虑球队之间的历史交锋记录中的角球数、对手近期的防守/进攻风格(是否倾向于防守反击,从而影响角球机会)。

- 环境特征:天气条件(如雨雪天气可能影响比赛节奏和角球机会)、球场类型(如宽大球场可能增加长传冲吊和角球机会)。

- 技术统计特征:如控球率、射门次数、犯规次数等,这些可能间接影响角球数。

2、数据清洗与预处理

- 处理缺失值:对于缺失的数据,根据业务逻辑选择填充(如使用均值、中位数、众数填充,或基于其他特征预测填充)、插值或删除。

- 异常值检测与处理:识别并处理异常值,如通过箱型图、Z-score等方法识别,并决定是保留、删除还是调整。

- 数据编码:将分类变量转换为数值型特征,如使用独热编码(One-Hot Encoding)或标签编码(Label Encoding)。

三、模型选择

1、模型选择

- 根据问题的回归性质,选择适合的机器学习回归模型。常见的回归模型包括线性回归、决策树回归、随机森林回归、梯度提升树(GBDT)、XGBoost等。

- 初始可尝试多个模型,并通过交叉验证(如K折交叉验证)评估其性能,选择表现最佳的模型。

2、模型训练

- 使用训练集数据训练选定的模型,注意设置合理的超参数(如随机森林的树的数量、树的深度等)。

- 采用网格搜索、随机搜索或贝叶斯优化等方法调整模型参数,以优化模型在验证集上的表现。

四、模型评估与优化

1、模型评估

- 使用测试集评估模型性能,关注评估指标如均方误差(MSE)、均方根误差(RMSE)、平均绝对误差(MAE)等。

- 可视化预测结果与实际结果的对比,分析模型的偏差和误差分布。 评估模型的稳定性和泛化能力,确保模型在不同数据集上表现一致。

2、模型优化:

- 根据评估结果对模型进行进一步优化,如增加特征数量、调整特征权重、改进特征选择方法等。

- 尝试使用集成学习方法(如Stacking、Blending)结合多个模型的预测结果,以提升整体预测性能。

考虑使用正则化技术(如L1/L2正则化)减少过拟合风险。

五、模型解释与部署

1、模型解释

- 解读模型特征重要性,理解哪些因素对角球数预测影响最大。这有助于理解模型的工作原理,并为后续的数据收集和处理提供指导。

- 使用部分依赖图(PDP)、SHAP值等工具进一步解释模型预测结果。

2、模型部署

- 将训练好的模型部署到线上系统或API服务中,以便实时接收新比赛数据并进行角球数预测。

- 监控模型性能,定期更新模型以适应数据变化。同时,建立模型监控机制,及时发现并处理潜在的预测偏差。

六、代码解读及实现

1. 数据准备

- 创建示例数据:首先,我们创建了一个包含假设足球比赛数据的DataFrame,其中包含了主队、客队、两队的历史平均角球数、比赛类型、天气条件、球场类型以及目标变量(总角球数)。

- 定义特征:我们将特征分为数值特征和分类特征。数值特征包括两队的历史平均角球数,而分类特征包括主队、客队、比赛类型、天气条件和球场类型。

2.数据预处理

- 数值特征处理:对于数值特征,我们使用SimpleImputer进行缺失值填充,这里选择均值填充。

- 分类特征处理:对于分类特征,我们首先使用SimpleImputer进行缺失值填充,这里选择众数填充,因为分类特征中的缺失值很难用均值或中位数来合理估计。然后,我们使用OneHotEncoder对分类特征进行独热编码,以便机器学习模型能够处理它们。

- ColumnTransformer:我们使用ColumnTransformer来应用不同的预处理步骤到不同的特征集上。这是为了简化流程,使得我们可以同时处理数值特征和分类特征。

3、模型构建

- 选择模型:我们选择RandomForestRegressor作为我们的预测模型,因为它在处理回归问题时表现良好,并且能够处理多种类型的特征。

- 创建管道:我们使用Pipeline将预处理步骤和模型训练步骤组合在一起。这样做的好处是我们可以一次性地训练整个流程,而无需单独处理每个步骤。

4、数据划分

我们使用train_test_split函数将数据集划分为训练集和测试集。这是为了评估模型在未见过的数据上的性能。

5、模型训练

我们使用训练集数据来训练管道中的模型。在这个过程中,预处理步骤会首先被应用,然后模型会在预处理后的数据上进行训练。

6、模型预测与评估

我们使用测试集数据来评估模型的性能。首先,我们对测试集数据进行预测,然后计算预测结果与实际结果之间的均方误差(MSE)、均方根误差(RMSE)和平均绝对误差(MAE)。

7、模型优化(可选)

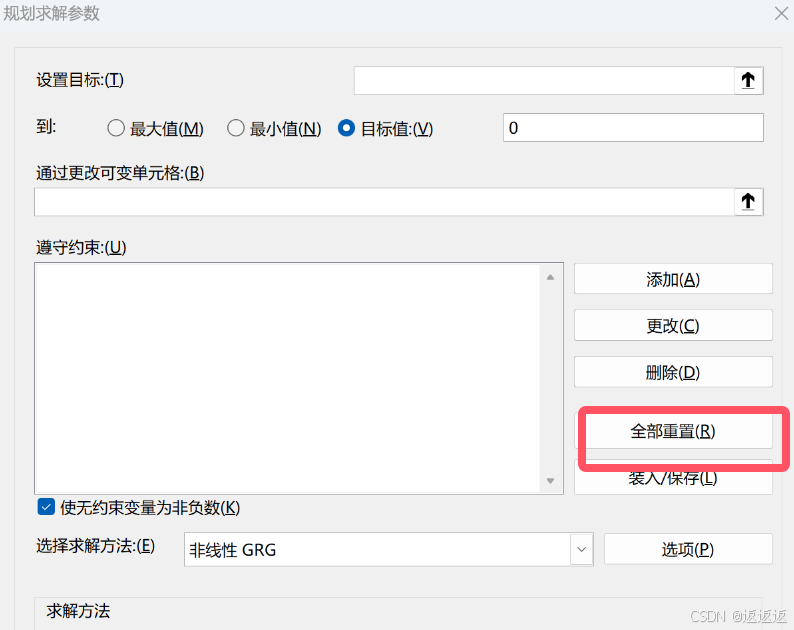

- 为了进一步提高模型的性能,我们可以使用GridSearchCV进行超参数调优。我们定义了一个参数网格,其中包含了我们想要尝试的不同超参数组合。然后,GridSearchCV会尝试这些组合,并使用交叉验证来评估每种组合的性能,最终选择性能最好的一组超参数。

- 在这个过程中,GridSearchCV会自动处理数据的划分、模型的训练和评估,以及超参数的调整。最终,我们可以得到一组最优的超参数,以及使用这组超参数时模型在交叉验证集上的最佳性能。

import pandas as pd

import numpy as np

from sklearn.model_selection import train_test_split, GridSearchCV

from sklearn.ensemble import RandomForestRegressor

from sklearn.metrics import mean_squared_error, mean_absolute_error

from sklearn.preprocessing import LabelEncoder, OneHotEncoder

from sklearn.compose import ColumnTransformer

from sklearn.pipeline import Pipeline

from sklearn.impute import SimpleImputer

# 假设数据加载(实际中应从文件或数据库加载)

# 这里我们创建一个示例DataFrame

data = {

'home_team': ['TeamA', 'TeamB', 'TeamC', 'TeamA', 'TeamB'],

'away_team': ['TeamB', 'TeamA', 'TeamD', 'TeamC', 'TeamC'],

'home_corner_avg': [5.0, 6.5, 7.2, 4.8, 6.0],

'away_corner_avg': [6.2, 4.9, 5.5, 7.1, 5.8],

'match_type': ['League', 'Friendly', 'League', 'Cup', 'League'],

'weather': ['Sunny', 'Rainy', 'Sunny', 'Cloudy', 'Sunny'],

'pitch_type': ['Grass', 'Grass', 'Artificial', 'Grass', 'Artificial'],

'total_corners': [8, 7, 10, 9, 8] # 目标变量

}

df = pd.DataFrame(data)

# 数据预处理

# 定义数值特征和分类特征

numeric_features = ['home_corner_avg', 'away_corner_avg']

categorical_features = ['home_team', 'away_team', 'match_type', 'weather', 'pitch_type']

# 编码器

numeric_transformer = SimpleImputer(strategy='mean') # 数值型特征使用均值填充缺失值

categorical_transformer = Pipeline(steps=[

('imputer', SimpleImputer(strategy='most_frequent')), # 分类特征使用众数填充缺失值

('onehot', OneHotEncoder(handle_unknown='ignore')) # 独热编码

])

# 预处理步骤

preprocessor = ColumnTransformer(

transformers=[

('num', numeric_transformer, numeric_features),

('cat', categorical_transformer, categorical_features),

])

# 创建管道,包括预处理和模型

model = RandomForestRegressor(n_estimators=100, random_state=42)

pipeline = Pipeline(steps=[('preprocessor', preprocessor),

('model', model)])

# 划分数据集

X = df.drop('total_corners', axis=1)

y = df['total_corners']

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 模型训练

pipeline.fit(X_train, y_train)

# 模型预测与评估

y_pred = pipeline.predict(X_test)

mse = mean_squared_error(y_test, y_pred)

rmse = mse ** 0.5

mae = mean_absolute_error(y_test, y_pred)

print(f'RMSE: {rmse:.2f}')

print(f'MAE: {mae:.2f}')

# (可选)模型优化:使用GridSearchCV进行超参数调优

param_grid = {

'model__n_estimators': [50, 100, 200],

'model__max_depth': [None, 10, 20, 30],

'model__min_samples_split': [2, 5, 10],

}

grid_search = GridSearchCV(pipeline, param_grid, cv=5, scoring='neg_mean_squared_error', verbose=2)

grid_search.fit(X_train, y_train)

print(f'Best parameters: {grid_search.best_params_}')

print(f'Best RMSE: {np.sqrt(-grid_search.best_score_):.2f}')

鸣谢:数据分析平台提供的数据

总结

总而言之,使用机器学习模型进行预测分析是一项复杂但强大的工作。通过数据准备、选择合适的算法、训练和验证模型、预测分析以及技巧和注意事项的考虑,我们可以获得准确的预测结果,并为业务决策提供有益的见解。随着机器学习技术的不断发展,机器学习模型在预测分析中的应用将变得越来越广泛,并为我们带来更多的机会和挑战。