全名:Show-o: One Single Transformer to Unify Multimodal Understanding and Generation

8月22发表的,一个名为Show-o的统一变换器(transformer)

论文地址:2408.12528v2 (arxiv.org)

项目地址:GitHub - showlab/Show-o: Repository for Show-o, One Single Transformer to Unify Multimodal Understanding and Generation.

能够同时处理多模态理解和生成任务。Show-o模型的创新之处在于它将自回归(autoregressive)和(离散)扩散(diffusion)建模融合在一起,以适应各种不同和混合模态的输入和输出。

摘要:

我们提出了一个统一的转换器,即 Show-o,它统一了多模态理解和生成。与完全自回归模型不同,Show-o 统一了自回归和(离散)扩散建模,以自适应地处理各种混合模态的输入和输出。统一模型灵活地支持广泛的视觉语言任务,包括视觉问答、文本到图像生成、文本引导修复/外推和混合模态生成。在各种基准测试中,它展示了与现有单个模型相当或更好的性能,这些模型具有等效或更多为理解或生成而定制的参数。这显著凸显了其作为下一代基础模型的潜力。

听着很厉害,不同模态完全混合

1. 引言 (Introduction)

- 报告首先指出了多模态智能的两个关键支柱:理解和生成,并提到了近期在这两个领域的显著进展。

展示了 Show-o 与跨各个领域的现有再现方法之间的模型特征的比较。可以观察到,Show-o 是一个统一的模型,它灵活地涉及现有的先进技术,以全面解决多模态理解和生成问题。

现有的尝试主要独立地处理每个领域,并且经常涉及分别负责理解和生成的单个模型(如图 1(c) 左侧所示)。

“Vision” 和 “Language” 表示来自特定输入模态的表示。在这种情况下,“Diffusion” 代表连续和离散的 diffusion。

- 作者提出了一个问题:是否可以用单个变换器处理多模态理解和生成。

在这里,我们设想了一种新的范式,即文本表示为离散标记,并与大型语言模型 (LLM) 相同进行自回归建模,并且连续图像像素使用去噪扩散进行建模。然而,由于离散文本标记和连续图像表示之间存在显着差异,因此将这两种不同的技术集成到一个网络中并非易事。另一个挑战在于,现有的最先进的扩散模型通常依赖于两个不同的模型,即文本编码器对文本条件信息进行编码,而去噪网络用于预测噪声。

本文的主要贡献可以概括为:

• 我们提出了一个统一的模型,即 Show-o,它使用一个转换器统一了多模态理解和生成。

• Show-o 创新性地将自回归和(离散)扩散建模统一在一个转换器中,展示了在独特处理文本和图像方面的多功能性。

• 作为一个统一的模型,Show-o 在多模态理解和生成基准中表现出与具有同等或更多参数的个体基线模型相当甚至更好的性能。

• Show-oinntly 支持各种下游应用程序,如基于文本的修复和外推,无需任何微调。此外,它还展示了混合模态生成的可能性。• 我们探讨了不同类型的表示(离散或连续)对多模态理解的影响,为在统一模型的现有功能下改进多模态提供了有价值的见解。

2. 相关工作 (Related Work)

- 报告回顾了多模态理解、视觉生成以及统一视觉-语言基础模型的研究进展。

3. 方法论 (Methodology)

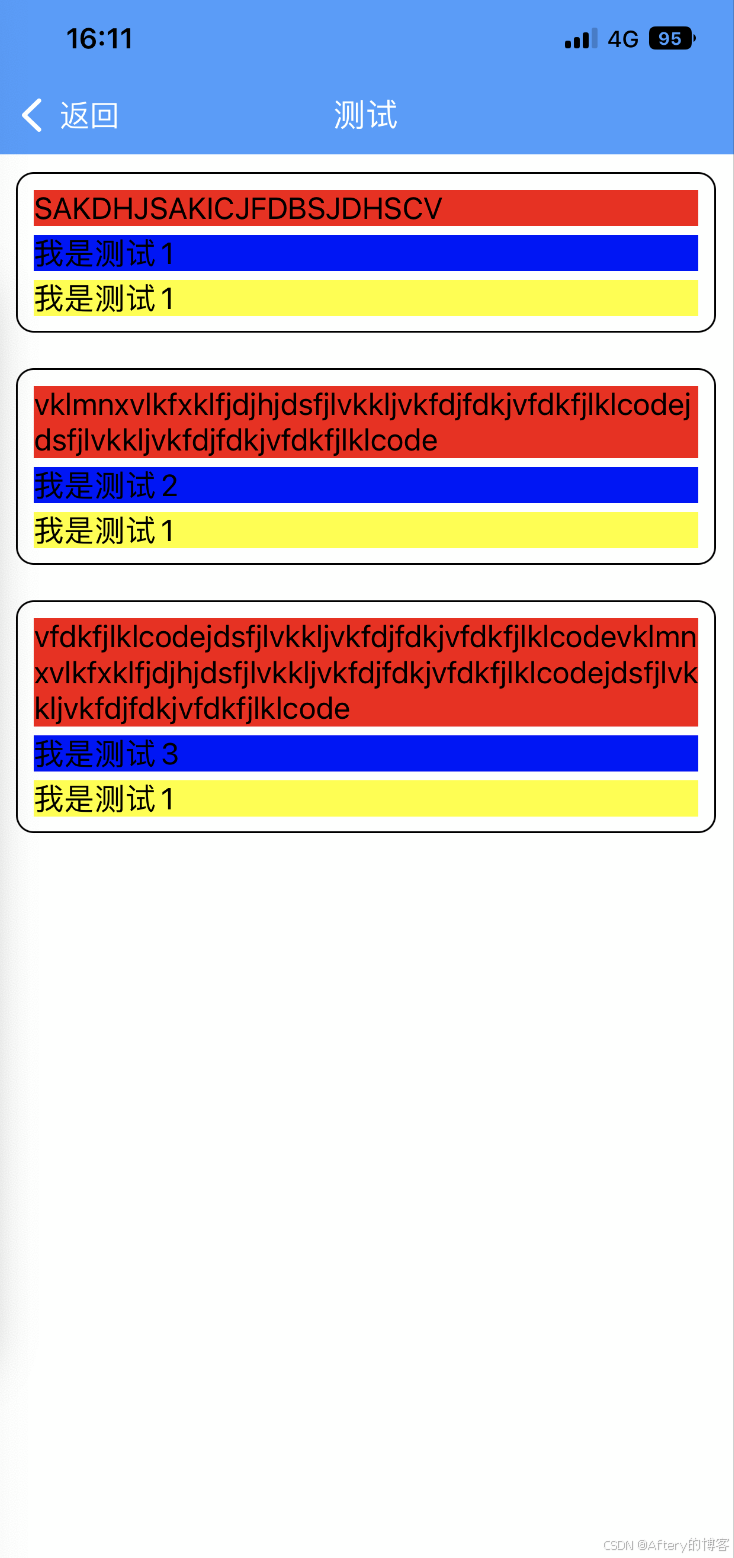

Show-o 概述。输入数据(无论其模态如何)都会被标记化,然后提示到格式化的输入序列中。Show-o 通过全神贯注在(离散)去噪扩散建模中用因果注意力和图像词元自回归地处理文本词元,然后生成所需的输出。具体来说,Show-o 能够处理图像描述、视觉问答、文本到图像生成、文本引导修复/外推和混合模态生成。

3.1 标记化 (Tokenization)

- 文本标记化:使用预训练的大型语言模型(LLM)相同的分词器进行文本数据的标记化。

- 图像标记化:使用MAGVIT-v2量化器将图像编码为离散的标记。图像被量化为16x16的标记网格,每个标记对应一个嵌入向量。

-

用于多模态理解的可选输入

3.2 架构 (Architecture)

- Show-o模型基于预训练的LLM,并且对架构进行了微小的改动,主要是在每个注意力层前添加了QK-Norm操作,以提高模型的稳定性和性能。

- 模型的嵌入层被扩展,以包含8192个新的可学习嵌入,用于离散图像标记。

3.3 统一提示策略 (Unified Prompting)

- 设计了一种统一的提示格式,将图像和文本标记组合成一个序列,以适应不同类型的任务,如多模态理解、文本到图像的生成等。

- 使用特殊的任务标记和开始/结束标记来明确序列的开始和结束。

-

建议的统一提示格式的图示

3.4 全注意力机制 (Omni-Attention Mechanism)

- Show-o采用了一种新颖的注意力机制,能够根据输入序列的类型自适应地应用因果注意力或全注意力。

- 文本标记使用因果注意力,而图像标记使用全注意力,允许每个图像标记与序列中的所有其他标记交互。

全能关注机制(深色方块代表“允许参加”,而白色方块表示“阻止参加”)。它是一种多功能的注意力机制,具有因果性和充分注意力,可根据输入序列的格式自适应地混合和变化。如 (a)、(b) 和 (c) 所示,在包含文本和图像标记的序列中,全向注意力机制使用因果注意处理文本标记,而使用完全注意处理图像标记。此外,关于输入序列,(a) 文本标记可以关注所有前面的图像标记,(b) 图像标记可以访问所有先前的文本标记,以及 (c) 在仅提供文本标记的情况下,注意力会降级为因果注意力。

3.5 训练目标 (Training Objectives)

- Next Token Prediction (NTP):使用标准的语言表达模型目标,最大化文本标记的预测概率。

- Mask Token Prediction (MTP):采用生成掩码模型的方法,随机掩盖图像标记,并训练模型预测原始值。从未掩码标记和前面的文本标记的掩码标记中重建原始图像标记:

3.6 训练流程 (Training Pipeline)

- 第一阶段:图像标记嵌入和像素依赖性学习。使用RefinedWeb数据集进行语言模型训练,使用ImageNet-1K数据集进行类条件图像生成和图像描述训练。

- 第二阶段:图像-文本对齐训练。在35M图像-文本对上进行文本到图像的生成训练。

- 第三阶段:高质量数据微调。使用过滤的高质量图像-文本对和指令数据进行微调,以提高特定任务的性能。

4. 实验 (Experiments)

- 数据集:使用了三种类型的数据集,包括文本数据、图像数据和图像-文本对。

- 评估:在多个基准上评估Show-o模型,包括多模态理解(如图像描述和视觉问答)和视觉生成(如文本到图像的生成)。

- 实现细节:描述了模型的训练细节,包括使用的优化器、学习率调度、批次大小等。

5. 结论 (Conclusion)

- Show-o模型成功地将多模态理解和生成任务统一到一个变换器框架中,展示了其作为下一代基础模型的潜力。