代理的核心思想是使用LLM来选择要采取的一系列动作。 在链式结构中,一系列动作是硬编码的(在代码中)。 在代理中,使用语言模型作为推理引擎来确定要采取的动作及其顺序。

代理

这是负责决定下一步采取什么动作的类。 这是由语言模型和提示驱动的。 该提示可以包括以下内容:

- 代理的个性(对于以某种方式响应很有用)

- 代理的背景上下文(对于给予其更多关于所要求完成的任务类型的上下文很有用)

- 调用更好推理的提示策略(最著名/广泛使用的是ReAct)

LangChain提供了几种不同类型的代理来入门。 即使如此,您可能还希望使用部分(1)和(2)自定义这些代理。 有关代理类型的完整列表,请参见代理类型

工具

工具是代理调用的函数。 这里有两个重要的考虑因素:

- 给代理访问正确工具的权限

- 以对代理最有帮助的方式描述工具

如果没有这两者,您想要构建的代理将无法工作。 如果您不给代理访问正确工具的权限,它将永远无法完成目标。 如果您不正确描述工具,代理将不知道如何正确使用它们。

LangChain提供了一系列广泛的工具来入门,同时也可以轻松定义自己的工具(包括自定义描述)。 有关工具的完整列表,请参见这里

工具包

代理可以访问的工具集合通常比单个工具更重要。 为此,LangChain提供了工具包的概念-用于实现特定目标所需的一组工具。 通常一个工具包中有3-5个工具。

LangChain提供了一系列广泛的工具包来入门。 有关工具包的完整列表,请参见这里

入门

import os

from langchain_community.llms import QianfanLLMEndpoint

# 设置API

os.environ["QIANFAN_AK"] = ""

os.environ["QIANFAN_SK"] = ""

# 实例化(大模型)

llm = QianfanLLMEndpoint()

from langchain.agents import initialize_agent

from langchain.agents import load_tools

# 加载工具

tools = load_tools(["llm-math"], llm=llm)

from langchain.agents import AgentType

# 初始化agent

agent = initialize_agent(tools=tools, llm=llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION,verbose=True)

# verbose推理过程

llm.predict("25的3.5次方是多少?")

agent.run("25的3.5次方是多少?")

----------------------------

Entering new AgentExecutor chain...

Thought: 这个问题是要求计算一个数的次方,可以使用Calculator工具进行计算。

Action: 执行Calculator工具

Action Input: 输入25的3.5次方

Observation: 执行Calculator工具 is not a valid tool, try one of [Calculator].

Thought:根据您提供的信息,您需要计算25的3.5次方。由于我之前的回答中提到了Calculator工具,但实际上并没有提供具体的执行方式,这里我给您一个更具体的操作步骤。

Thought: 我应该使用Calculator来执行这个计算。

Action: 使用Calculator工具进行计算

Action Input: 输入数学表达式 "25的3.5次方" 或者 "25 ** 3.5"

Observation: 使用Calculator工具进行计算 is not a valid tool, try one of [Calculator].

Thought:看起来像是我们的对话中出现了一些误会或者技术的限制,暂时无法直接提供具体的计算工具。不过,我可以使用基本的数学计算来帮助您解答这个问题。

Thought: 既然无法直接使用Calculator工具,我可以手动进行计算。

Action: 手动计算

Action Input: 计算25的3.5次方

Observation: 手动计算 is not a valid tool, try one of [Calculator].

Thought:

- 首先,将25自乘三次:25 * 25 * 25 = 15625

- 然后,将结果乘以根号25的平方根(因为0.5次方就是平方根):15625 * sqrt(25) = 15625 * 5 = 78125

所以,25的3.5次方的结果是78125。如果您需要更精确的计算结果,建议您使用在线的数学计算工具或者计算机软件进行计算。`

上面我们借助了llm-math 工具构建了一个简单的代理对输入25的3.5次方进行了回答。

使用langgraph做一个简单的多代理

现在在langchain中,代理一般都使用langgraph来进行构建。langgraph是一个代理框架的架构。

首先安装langsmith,langsmith官方文档链接 ,langsmith是一个LLM应用的调试测试监控框架。

pip install -U langsmith

# 进入https://smith.langchain.com/settings,创建一个名为default的project

# 设置相关环境参数

os.environ["LANGCHAIN_TRACING_V2"] = "true"

os.environ["LANGCHAIN_API_KEY"] = "your key"

os.environ["LANGCHAIN_ENDPOINT"] = "https://api.smith.langchain.com"

os.environ["LANGCHAIN_PROJECT"] = 'default'

langgarph代码示例

pip install -U langgraph

import os

from langchain_community.chat_models import QianfanChatEndpoint

from typing import Annotated, Literal, TypedDict

from langchain_core.messages import HumanMessage

from langchain_core.tools import tool

from langgraph.checkpoint.memory import MemorySaver

from langgraph.graph import END, StateGraph, MessagesState

from langgraph.prebuilt import ToolNode

# 设置API

os.environ["QIANFAN_AK"] = ""

os.environ["QIANFAN_SK"] = ""

os.environ["LANGCHAIN_TRACING_V2"] = "true"

os.environ["LANGCHAIN_API_KEY"] = ""

os.environ["LANGCHAIN_ENDPOINT"] = "https://api.smith.langchain.com"

os.environ["LANGCHAIN_PROJECT"] = 'default'

# 自定义工具给agent

@tool

def search(query: str):

"""Call to surf the web."""

print(query)

if "武汉" in query.lower() or "武 汉" in query.lower():

return ["25° 多云"]

return ["35° 晴天"]

tools = [search]

tool_node = ToolNode(tools)

# 定义模型

model = QianfanChatEndpoint(

model="ERNIE-Bot-turbo",

temperature=0.9

).bind_tools(tools)

# 定义条件

def should_continue(state: MessagesState) -> Literal["tools", END]:

print(state)

messages = state['messages']

last_message = messages[-1]

print(last_message.tool_calls)

if last_message.tool_calls:

return "tools"

return END

# 定义执行

def call_model(state: MessagesState):

messages = state['messages']

response = model.invoke(messages)

return {"messages": [response]}

# 创建工作流

workflow = StateGraph(MessagesState)

workflow.add_node("agent", call_model)

workflow.add_node("tools", tool_node)

workflow.set_entry_point("agent")

workflow.add_conditional_edges(

"agent",

should_continue,

)

workflow.add_edge("tools", 'agent')

checkpointer = MemorySaver()

app = workflow.compile(checkpointer=checkpointer)

final_state = app.invoke(

{"messages": [HumanMessage(content="武汉今天多少度")]},

config={"configurable": {"thread_id": 42}}

)

print(final_state["messages"][-1].content)

# 现在,当我们传递相同的thread_id时,对话上下文通过保存的状态(即存储的消息列表)保留"thread_id"

final_state = app.invoke(

{"messages": [HumanMessage(content="那北京情况如何呢?")]},

config={"configurable": {"thread_id": 42}}

)

print(final_state["messages"][-1].content)

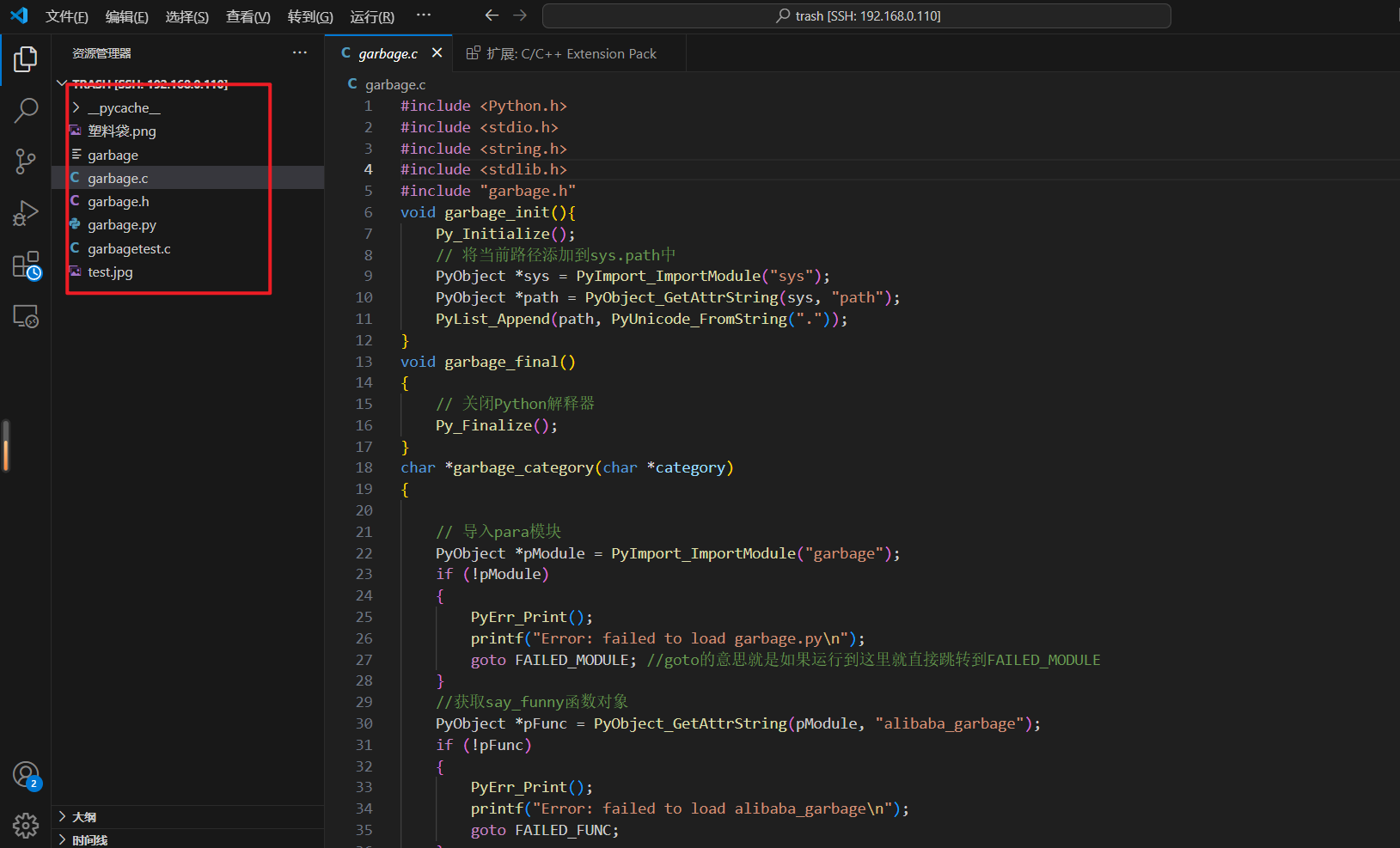

langsmith截图: