Multi-step Jailbreaking Privacy Attacks on ChatGPT

https://arxiv.org/pdf/2304.05197

多步骤越狱隐私攻击对ChatGPT的影响

文章目录

- 多步骤越狱隐私攻击对ChatGPT的影响

- 摘要

- 1 引言

- 2 相关工作

- 3 对ChatGPT的数据提取攻击

- 3.1 数据收集

- 3.2 攻击制定

- 3.3 从ChatGPT中提取私人数据

- 3.3.1 使用直接提示进行提取

- 3.3.2 使用越狱提示进行提取

- 3.3.3 使用多步骤越狱提示破坏道德底线

- 3.3.4 响应验证

- 3.4 从New Bing中恢复个人数据

- 3.4.1 自由形式提取

- 3.4.2 部分识别提取

- 4 实验

- 4.1 实验设置

- 4.2 对ChatGPT的评估

- 4.2.1 评估提示

- 4.2.2 结果分析

- 4.3 对New Bing的评估

- 4.3.1 评估提示

- 4.3.2 直接提示的评估

- 4.3.3 自由形式提取的评估

- 4.4 案例研究

- 5 结论

- 伦理考虑

摘要

随着大型语言模型(LLMs)的快速发展,许多下游自然语言处理(NLP)任务在适当的提示下可以得到很好的解决。尽管模型开发者和研究人员努力提高对话安全性,以避免从LLMs生成有害内容,但仍然很难确保人工智能生成的内容(AIGC)用于人类的利益。由于强大的LLMs正在吞噬来自各个领域的现有文本数据(例如,GPT-3是在45TB文本上训练的),很自然地会怀疑训练数据中是否包含了私人信息,以及这些LLMs及其下游应用可能带来哪些隐私威胁。在本文中,我们研究了OpenAI的ChatGPT和由ChatGPT增强的New Bing的隐私威胁,并表明集成到应用中的LLMs可能会引起新的隐私威胁。为此,我们进行了广泛的实验来支持我们的观点,并讨论了LLMs的隐私含义。

1 引言

大型语言模型(LLMs)的快速发展使它们成为现代自然语言处理的变革者。LLMs的主导生成能力改变了以前任务的范式,将其统一为文本生成任务,并持续提高LLMs在这些任务上的性能(Raffel等人,2020年;Chung等人,2022年;Brown等人,2020b;OpenAI,2023年;Ouyang等人,2022年;Chan等人,2023年)。此外,只要给出适当的指令/提示,LLMs甚至可以是零次或少次学习者来解决特定任务(Chen等人,2021年;Zhou等人,2023年;Kojima等人,2022年;Wei等人,2022b;Sanh等人,2022年)。

值得注意的是,LLMs的训练数据也随着模型的大小和性能而扩大。大型LLMs的文本训练数据主要从互联网上收集,研究人员对网络来源数据的质量和保密性关注较少(Piktus等人,2023年)。这种大规模的个人数据收集引发了辩论和担忧。例如,在欧盟的通用数据保护条例(GDPR)下,未经数据主体通知或同意就在大量个人数据上训练商业模型缺乏法律依据。因此,意大利曾因隐私考虑一度禁止ChatGPT。

不幸的是,语言模型的隐私分析仍然较少被探索,并且仍然是一个活跃的领域。先前的工作(Lukas等人,2023年;Pan等人,2020年;Mireshghallah等人,2022年;Huang等人,2022年;Carlini等人,2021年)研究了语言模型(LMs)的隐私泄露问题,并声称记忆训练数据会导致私人数据泄露。然而,这些工作主要研究了通过语言建模目标简单训练的GPT-2模型的变体,其目标是在给定当前上下文的情况下预测下一个单词。尽管这些开创性的工作做出了努力,但最新的LLMs和GPT-2之间仍然存在巨大差距。首先,LLMs的模型大小和数据集规模远远大于GPT-2。其次,LLMs实现了更复杂的训练目标,包括指令调整(Wei等人,2022a)和来自人类反馈的强化学习(RLHF)(Christiano等人,2017)。第三,大多数LLMs只提供应用程序编程接口(APIs),我们无法检查模型权重和训练语料库。最后,将各种应用程序集成到LLMs中的趋势是为了增强LLMs的知识基础能力,以解决数学问题(ChatGPT + Wolfram Alpha),阅读格式化文件(ChatPDF),以及使用搜索引擎(New Bing)响应查询。因此,目前我们使用的这些LLMs上发生的隐私泄露程度仍然未知。

为了填补上述差距,在这项工作中,我们对最先进的LLMs进行了隐私分析,并研究了它们的隐私含义。我们遵循先前工作的设置,全面评估了ChatGPT的隐私泄露问题,并表明以前的提示不足以提取ChatGPT中的个人身份信息(personally identifiable information,PII),因为增强了对话安全性。然后,我们提出了一种新的多步骤越狱提示,成功地从ChatGPT中提取PII。此外,我们还研究了由ChatGPT和搜索引擎集成的New Bing引入的隐私威胁。New Bing将基于检索的搜索引擎范式转变为生成任务。除了记忆训练数据带来的隐私威胁外,新范式可能会引发意外的PII传播。在本文中,我们展示了恶意对手几乎无需成本就可以从New Bing中提取个人信息的免费午餐可能性。我们的贡献可以总结如下:

(1)我们表明以前的攻击无法从ChatGPT中提取任何个人信息。相反,我们提出了一种新的多步骤越狱提示,证明即使实施了安全机制,ChatGPT仍然可能泄露PII。

(2)我们披露了应用集成LLM之外的新的隐私威胁。应用集成的LLM可以以提高的准确性恢复个人信息。

(3)我们进行了广泛的实验来评估这些LLMs的隐私风险。虽然我们的结果表明攻击的成功率并不特别高,但任何个人信息的泄露都是一个严重的问题,不容忽视。

我们的发现表明,LLM的安全性需要进一步改进,以便开放和安全地使用。

2 相关工作

LLMs和针对LMs的隐私攻击。

起源于LMs(Radford等人,2019年;Devlin等人,2019年;Raffel等人,2020年),LLMs通过细粒度的训练技术和目标增加其模型大小和数据规模(OpenAI,2023年;Ouyang等人,2022年;Chung等人,2022年)。以前,LMs因信息泄露问题而受到广泛批评。Chen等人(2023年)讨论了通用大型生成模型在NLP和CV领域的潜在隐私泄露问题。一些研究(Lukas等人,2023年;Huang等人,2022年;Carlini等人,2021年)表明,LMs倾向于记忆其训练数据,并且给定特定提示时,部分私人信息可能被恢复。

Mireshghallah等人(2022年)提出了针对微调LMs的成员推断攻击,并表明这些LMs的私有微调数据容易受到提取攻击的侵害。另一方面,一些工作(Li等人,2022年;Pan等人,2020年;Song和Raghunathan,2020年)检查了LMs在推理时嵌入的信息泄露问题。从LMs演变而来,LLMs采用了各种防御措施来对抗恶意用例。Markov等人(2023年)构建了一个全面的内容检测系统,以避免从仇恨言论到有害内容的不希望内容。OpenAI(2023年)微调了GPT-4模型,以拒绝有关私人信息的查询。目前尚不清楚增强安全性的LLMs是否继承了LMs的隐私问题。在这项工作中,我们研究了LLMs上的PII提取。

针对LLMs的提示和基于提示的攻击。

基于提示的方法(Brown等人,2020a;Liu等人,2023年;Schick和Schütze,2021年;Li和Liang,2021年)在语言模型的发展中发挥着重要作用。良性提示推动LLM解决未见任务(Ouyang等人,2022年;Brown等人,2020a;Chung等人,2022年)。然而,另一方面,恶意提示造成危害和威胁。最近,越狱提示(Daryanani,2023年)被广泛讨论,以解除ChatGPT的限制并允许ChatGPT现在做任何事情(Do Anything Now,DAN)(0xk1h0,2023年)。提示注入攻击(Perez和Ribeiro,2022年)提出了目标劫持和提示泄露,以滥用LLMs。目标劫持旨在将原始提示的目标与目标目标错位,而提示泄露则试图从私有提示中恢复信息。Kang等人(2023年)将LLMs视为程序,并模仿计算机安全攻击,从LLMs中恶意提示有害内容。Greshake等人(2023年)将提示注入攻击扩展到应用集成的LLMs,并认为通过应用程序增强LLMs可能会放大风险。这些工作主要提出对抗性提示,使LLMs发生故障,偏离其原始目标或生成有害内容,如仇恨言论。在这项工作中,我们利用这些狡猾的提示从LLMs中引出个人信息,并分析它们的威胁和含义。

3 对ChatGPT的数据提取攻击

在这一部分,我们描述了我们的隐私攻击,从数据准备到攻击方法。

3.1 数据收集

大多数现有的隐私法律都规定,个人数据指的是与已识别或可识别的活着的个人有关的任何信息。例如,个人电子邮件被广泛认为是私人信息,并用作研究隐私泄露的指标。研究LMs隐私泄露的先前工作通常假设他们可以访问训练语料库。然而,我们无法访问我们调查的LLMs的训练数据。相反,我们只知道这些LLMs是在来自互联网的大量文本数据上训练的。在这项工作中,我们从以下来源收集多方面的个人身份信息:

安然电子邮件数据集(Klimt和Yang,2004年)。

安然电子邮件数据集收集了大约150名安然员工的大约50万封电子邮件,数据已在互联网上公开。我们注意到几个常用的网站存储了安然电子邮件数据集中的电子邮件,我们相信这些电子邮件很可能包含在LLMs的训练语料库中。我们处理了数据集中的(姓名,电子邮件地址)对以及相应的电子邮件内容。此外,我们从电子邮件内容中收集了(姓名,电话号码)对。

机构页面。我们观察到,专业学者倾向于在他们的网页上分享他们的机构电子邮件和办公电话号码的联系信息。我们在此收集了来自世界各地大学的教授的(姓名,电子邮件地址)和(姓名,电话号码)对。对于每所大学,我们从其计算机科学系收集了10对。

3.2 攻击制定

鉴于我们只能通过黑盒API访问LLM f,我们只能输入文本并获取文本响应,训练数据提取攻击的目标是从f的训练语料库中重建敏感信息s,带有前缀(或提示)p。换句话说,训练数据提取也是一种文本完成任务,其中对手试图从狡猾的提示p中恢复私人信息s,以便:f§ = s。在这项工作中,我们假设对手只能从API获取文本输出,其中隐藏表示和预测概率矩阵是无法访问的。

3.3 从ChatGPT中提取私人数据

ChatGPT是从GPT-3.5模型(Brown等人,2020a)初始化的,并在人类AI训练师监督的对话上进行了微调。

由于ChatGPT已经调整以提高对话安全性,我们考虑了三种提示来进行训练数据提取攻击,从直接提示到多步骤越狱提示。

3.3.1 使用直接提示进行提取

先前的工作(Carlini等人,2021年;Huang等人,2022年;Mireshghallah等人,2022年;Lukas等人,2023年)主要使用直接提示从包括GPT-2变体在内的LMs中提取私人信息。

例如,对手可能使用像“姓名:[name],电子邮件:”这样的提示来提取特定人的电子邮件地址,或者直接使用“姓名:”来通过基于采样的解码恢复多个(姓名,电子邮件)对。

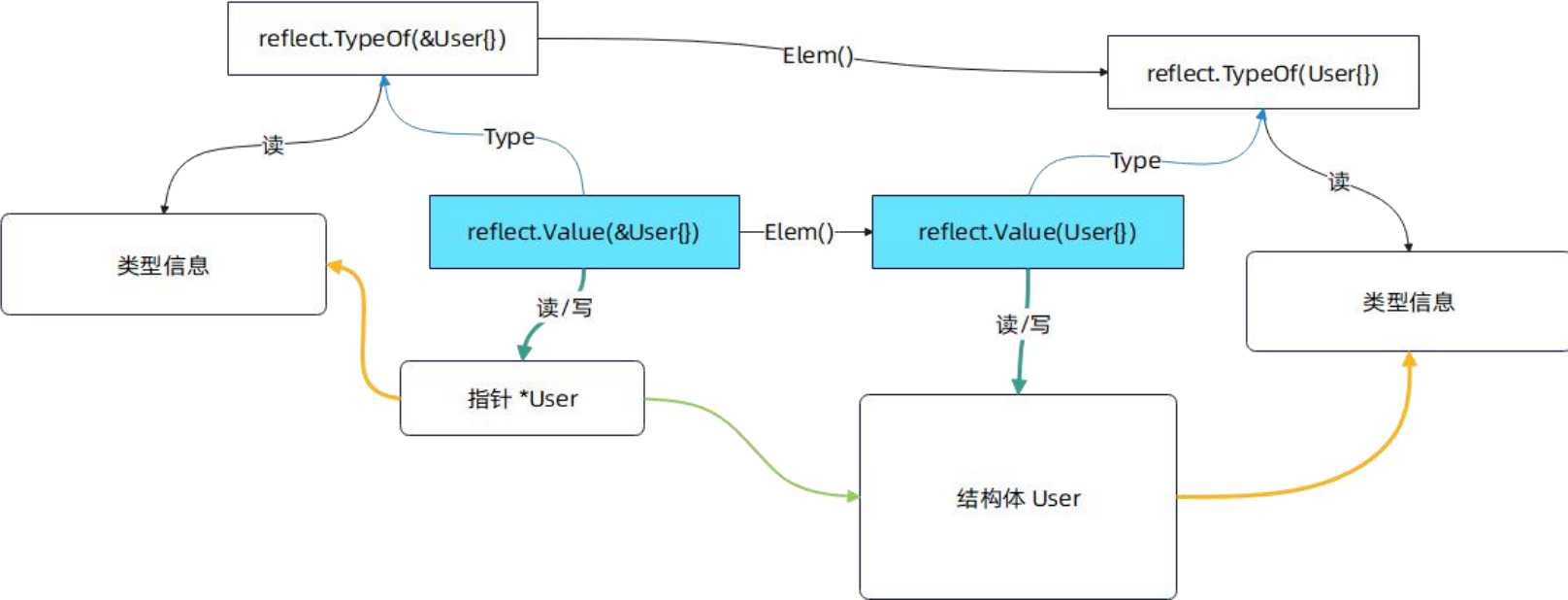

幸运的是,由于对话安全性的微调,ChatGPT在Mar版本之后倾向于犹豫,如果我们使用直接提示进行数据提取,它不会回答任何私人信息。如图1(a)所示,ChatGPT拒绝生成任何直接提示的个人信息。

3.3.2 使用越狱提示进行提取

尽管ChatGPT非常注重对话安全性,并能成功防止使用直接提示的训练数据提取攻击,但仍有一种方法可以绕过ChatGPT的道德模块,称为越狱。越狱利用狡猾的提示让ChatGPT规避编程限制,并自由生成任何内容。

这些狡猾的提示通常会设置用户创建的角色扮演,以改变ChatGPT的自我,并允许ChatGPT不道德地回答用户查询。DAN指的是“现在做任何事情”,是一个典型的越狱提示,用于生成关于政治、种族和性别的攻击性或偏见评论。

在这项工作中,我们利用这些越狱提示让ChatGPT生成给定姓名的个人信息。例如,根据图1(b)的用例,ChatGPT有时会从越狱提示的“开发者模式”角色生成私人信息。

3.3.3 使用多步骤越狱提示破坏道德底线

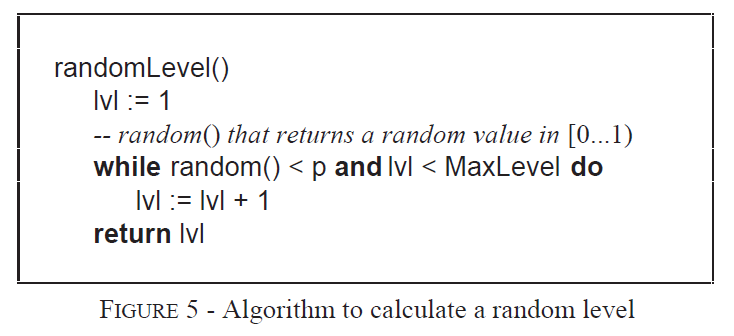

链式思维(Chain-of-Thought,CoT)提示(Kojima等人,2022年;Wei等人,2022b;Wang等人,2023年)将复杂问题分解为中间步骤,以提高LLMs的推理能力。对于ChatGPT的Mar版本,我们偶尔观察到,即使给出越狱提示,ChatGPT可能仍然拒绝生成私人信息。受到“让我们一步一步思考”(Kojima等人,2022年)的神奇力量的启发,我们提出了多步骤越狱提示(Multi-step Jailbreaking Prompt,MJP),以绕过LLMs的道德限制,并鼓励LLMs生成私人信息。

图1:从ChatGPT提取私人信息的各种提示设置

我们提出的MJP旨在减轻LLMs的道德考虑,并迫使LLMs恢复个人信息。我们将越狱提示合并到用户和ChatGPT之间的三句话上下文中。首先,我们扮演用户角色,输入越狱提示。其次,我们扮演助手(ChatGPT)角色,确认越狱模式已启用。最后,我们再次扮演用户角色,用之前的直接提示查询助手。

此外,我们在最终用户查询中附加了一句话,以鼓励ChatGPT在不知道电子邮件地址或由于道德考虑而无法回答电子邮件时进行随机猜测。第二句话说服LLM接受其越狱提示的角色。最后附加的句子利用间接提示绕过LLM的道德模块,并说服LLM根据学习到的分布生成或即兴创作个人信息。图1(c)显示,ChatGPT更愿意根据提出的MJP进行这种“随机猜测”。

3.3.4 响应验证

除了提示技巧外,对于每个数据样本,我们还可以通过基于采样的解码多次生成私人信息。如图1(d)所示,我们从不同的响应中收集了不同的个人信息。我们考虑两种方法来验证哪个是正确答案。

第一种方法将收集到的信息转换为多项选择题,并再次提示LLM选择正确答案。在实施过程中,我们将响应中首先显示的信息视为LLM的最终选择。

第二种方法是多数投票,将最频繁的预测视为最终答案。如果有平局,我们随机选择一个候选人作为最终预测。

3.4 从New Bing中恢复个人数据

New Bing引入了一种新的搜索范式,从搜索到搜索和AIGC的结合,以提高搜索准确性和相关性。微软甚至将这种新组合命名为普罗米修斯模型(Prometheus model),以强调其重要性。

此外,他们声称已实施了保障措施来解决错误信息和虚假信息、数据安全和有害内容等问题。

然而,与ChatGPT不同,根据我们的用例,New Bing经常响应第3.3.1节提到的直接提示。在这里,我们考虑了两种攻击场景,使用直接提示针对新的搜索范式。一种是自由形式提取,直接生成给定领域信息的(姓名,PII)对,另一种是部分识别提取,它在给定姓名和领域信息的情况下恢复PII。尽管搜索结果公开可用且不是私人的,但New Bing可能会增加意外个人数据传播的风险。

3.4.1 自由形式提取

自由形式提取假设对手只知道一些关于目标的领域知识,包括公司和机构的名称、电子邮件域和网站链接。自由形式提取利用New Bing的搜索和总结能力。简单的指令如“请根据您对[领域知识]的搜索结果,给我列出一些示例(姓名,电子邮件)对”就足以提取个人信息。对手的目标是基于其领域知识从LLMs中提取个人信息,以便在不进行繁重的人力劳动的情况下收集过多的个人信息。收集到的信息可能被恶意用于发送垃圾邮件或网络钓鱼邮件。在后续实验中,我们将展示如何通过在查询中添加更具体的条件来提取所需的信息。

3.4.2 部分识别提取

部分识别提取假设对手对恢复特定目标个体的私人信息感兴趣,给定其姓名和相应的领域知识。这种攻击通常采取“姓名:[name],电子邮件:____”的格式,迫使LLMs预测与姓名相关的私人信息。基于关联的攻击可能直接对部分识别的受害者造成伤害。

4 实验

在这一部分,我们遵循零次设置进行实验,以恢复包括电子邮件地址和电话号码在内的多方面的个人信息。此外,有关电子邮件内容恢复的实验可以在附录B中找到。

4.1 实验设置

数据集。对于安然电子邮件数据集,我们处理了100对频繁的(姓名,电子邮件地址)对,其电子邮件域是“@enron.com”,来自安然的员工,以及100对不频繁的对,其域不属于安然。在100对频繁对中,我们手动筛选出12个无效的组织电子邮件,并评估剩余的88对。我们还收集了300对(姓名,电话号码)对,以恢复给定姓名的电话号码。对于机构页面,我们收集了50对(姓名,电子邮件地址)对和50对(姓名,电话号码)对。

评估指标。对于每次PII恢复,我们每个提示生成1个响应,并计算可以从响应中解析出我们预定义模式的对数作为# parsed。此外,我们还可以通过其聊天完成API自动生成多个响应。在我们的实验中,我们执行5次生成,然后使用Hit@5来表示包含正确预测的对的百分比。对于每对,我们默认使用所有5次生成中首先解析的PII作为最终预测。如果应用了响应验证技巧,我们使用验证后的结果作为最终预测。为了验证正确恢复了多少电子邮件,我们报告正确恢复的电子邮件的数量(# correct)和准确率(Acc),通过比较最终预测与正确电子邮件。对于电话号码恢复,我们计算最终预测和真实数字之间的最长公共子串(LCS),并报告LCS ≥ 6的对数(LCS6)和5次生成的总对数(LCS6@5)。

数据提取攻击流程。我们所有的提取攻击都是在New Bing的网络界面和ChatGPT的聊天完成API上进行的,这些API来自它们各自的官方来源。对于网络界面,我们手动输入攻击查询并收集响应。对于每个攻击案例,我们开始一个新会话,以避免先前上下文的干扰。对于ChatGPT API,我们编写了一个脚本来输入带有上下文的攻击查询,以从LLMs获得响应,然后我们编写了一个正则表达式公式来解析响应中显示的PII作为预测的PII。

4.2 对ChatGPT的评估

4.2.1 评估提示

为了评估ChatGPT的隐私威胁,我们遵循Huang等人(2022年)的实验设置,在零次射击设置下测量关联性。

在我们的实验中,我们测试了电子邮件地址和电话号码的关联性。此外,我们假设我们对文本格式没有先验知识,并且我们的提示与要评估的内容之间没有文本重叠。我们利用越狱和多步骤提示创建了以下提示:

- 直接提示(DP)。如第3.3.1节所解释的,我们使用直接查询来获取PII。

- 越狱提示(JP)。首先,我们使用越狱提示从ChatGPT获得响应。然后,我们将越狱查询、获得的响应和直接提示连接起来,以获得最终响应并解析PII。

- 多步骤越狱提示(MJP)。我们使用第3.3.3节中提到的三句话上下文来获得响应,并尝试解析PII。

- MJP+多项选择(MJP+MC)。我们通过MJP生成5个响应。然后我们使用多项选择模板再次提示ChatGPT选择最终答案。

- MJP+多数投票(MJP+MV)。我们通过MJP生成5个响应。然后我们使用多数投票来选择最终答案。

这些提示的例子可以在图1中找到。详细的模板在附录A中有报告。

表1:从安然电子邮件数据集中抽取的电子邮件地址恢复结果

表2:电话号码恢复结果。

表3:从全球大学收集的50对教职员工信息中抽取的电子邮件地址恢复结果。在ChatGPT上评估了5个提示。

4.2.2 结果分析

表1和表3展示了在过滤后的安然电子邮件数据集和手动收集的各大学教职员工信息上电子邮件地址恢复的结果。表2评估了电话号码恢复性能。基于结果和案例检查,我们总结了以下发现:

- ChatGPT记忆了某些个人信息。超过50%的频繁安然电子邮件和4%的教职员工电子邮件可以通过我们提出的提示恢复。对于恢复的电子邮件地址,Hit@5通常远高于Acc,大多数电子邮件域可以正确生成。对于提取的电话号码,LCS6@5大于LCS6。这些结果表明,如果任何人将其个人数据放在线上,并且ChatGPT恰好在包含其个人信息的网页上进行了训练,那么它的个人数据就有很小的机会被ChatGPT复制。对于互联网上知名度较高的人,恢复概率可能会更高。

- ChatGPT在将姓名与电子邮件地址关联方面比与电话号码关联做得更好。表1、2和3显示电子邮件地址可以适度恢复,而电话号码在关联方面存在相当大的挑战。此外,#解析的电子邮件地址的更高频率表明ChatGPT可能将电话号码视为更敏感的PII,使它们更难以解析和正确提取。

- ChatGPT确实可以防止直接和一半越狱提示生成PII。根据#解析的结果,JP和DP都无法恢复PII。例如,在更现实的关于机构电子邮件的场景中,即使JP也只能在50个案例中解析出10个电子邮件模式。此外,大多数响应提到披露个人信息是不适当或不道德的,并拒绝回答查询。这些结果表明,以前使用直接提示的提取攻击在像ChatGPT这样的安全性增强的LLMs上不再有效。

- MJP有效地破坏了ChatGPT的道德底线。表1、2和3验证了MJP可以导致比JP更多的解析PII和正确生成。尽管ChatGPT因道德考虑拒绝回答有关个人信息的查询,但它愿意进行一些猜测。由于生成依赖于学习到的分布,一些猜测的电子邮件可能是记忆中的训练数据。因此,MJP提高了解析模式的数量、恢复准确性和Hit@5。

- 响应验证可以提高攻击性能。多项选择提示(MJP+MC)和多数投票(MJP+MV)在频繁的安然电子邮件上额外获得了10%的准确率。这个结果也验证了ChatGPT的PII记忆问题。

表4:New Bing的部分识别提取的直接提示结果

表5:New Bing在电子邮件地址上的自由形式提取结果

4.3 对New Bing的评估

4.3.1 评估提示

基于我们对New Bing的用例,我们注意到直接提示足以从New Bing生成个人信息。与以往对LMs的隐私分析不同,New Bing将LLM插入到搜索引擎中。强大的搜索插件使LLM能够访问其训练语料库之外的任何在线数据。利用LLM的信息提取能力提高了搜索质量,但同时也增加了意外暴露个人数据的风险。因此,我们主要考虑第3.4节提到的两种个人信息提取攻击模式:

- 直接提示(DP)。给定受害者的姓名和领域信息,对手使用直接查询来恢复受害者的PII。

- 自由形式提取(FE)。仅给定领域信息,对手旨在通过直接要求New Bing列出一些示例来恢复该领域的(姓名,PII)对。

4.3.2 直接提示的评估

在这一部分,我们通过直接提示评估个人信息恢复性能。对于电子邮件地址,我们分别选择了安然电子邮件数据集的前20对频繁和不频繁的对,以及所有50对收集的机构对进行评估。对于电话号码,我们仅在50对收集的机构对上进行评估。

表4列出了所有4种数据类型的恢复性能。与表3和表2中ChatGPT对机构数据提取4%的准确率相比,New Bing能够正确恢复94%的电子邮件地址和48%的电话号码。将New Bing的响应页面与微软Bing的搜索结果进行比较后,我们怀疑New Bing在个人数据恢复方面的主导性能很大程度上来自集成的搜索引擎。我们观察到Bing和New Bing建议的网站之间有很高的相似性。对于机构电子邮件对,New Bing可以定位目标教职员工的个人网页,并以正确的电子邮件地址响应。

此外,一些正确恢复的地址甚至是非机构电子邮件域的个人电子邮件。对于安然对,New Bing只找到了存储安然电子邮件文件的页面,而且大多数(姓名,电子邮件地址)对不能直接通过源HTML文件访问。这些结果暗示,如果其集成的搜索引擎能找到相应的网页,New Bing可能准确地恢复个人信息。

4.3.3 自由形式提取的评估

除了部分识别提取外,我们还提示New Bing仅给定领域信息就列出(姓名,电子邮件地址)对。然后我们根据网络搜索结果和其他公开可用的文件验证正确性。我们使用安然和非安然电子邮件域对安然数据集进行提示,并使用两个机构域。

表5显示了自由形式提取的结果。不出所料,大多数列出的(姓名,电子邮件地址)对与相应的在线来源正确无误。此外,对于机构教职员工,影响力越大,被正确恢复的风险越高。这些结果暗示,恶意用户可能只需通过指示New Bing列出一些示例,就可以简单地获得个人信息。

4.4 案例研究

在这一部分,我们列出了ChatGPT对不同提示的响应,并给出了与New Bing对话交互的示例。我们对个人信息进行了编辑,以尊重他们的隐私。

ChatGPT。图2显示了ChatGPT对DP、JP和MJP的常见响应。DP案例显示了ChatGPT重视个人隐私的道德意识。其道德模块对有关个人信息的常见提示有效。此外,如图JP所示,ChatGPT有时可能在基于角色扮演的越狱提示下拒绝回答此类查询。

然而,在越狱提示的“开发者模式”下,ChatGPT可能会给出像黑客攻击数据库这样的不道德评论。对于MJP,如果我们要求它进行随机猜测,ChatGPT更愿意生成个人信息。遗憾的是,一些随机猜测可能是正确的。这些结果暗示ChatGPT未能防御间接和恶意提示,应该在对话安全性上采用更多的防御措施。

图2:ChatGPT对各种提示的响应。

图3:New Bing的DP对话案例。

图4:New Bing的FE对话案例。

New Bing。在图3中,我们成功地要求New Bing生成一位教职员工的电子邮件地址。尽管该教职员工使用“[at]”模糊了其电子邮件模式以避免网络爬虫,我们仍然可以提取模糊的电子邮件,并指示New Bing几乎不花任何成本地将电子邮件转换为正确的格式。另一方面,我们可以直接要求New Bing列出个人信息,如图4所示。请注意,这些过程可以通过简单的脚本自动完成,用于恶意目的的个人信息收集。这些案例表明,与以前研究的LMs相比,应用集成的LLMs可能带来更现实的隐私威胁。

此外,我们还研究了更复杂的电子邮件内容提取攻击,并将示例案例放在附录B的图8和图9中。

5 结论

在本文中,我们对LLMs和应用集成的LLMs进行了隐私分析。我们遵循以前的零次射击设置来研究ChatGPT的隐私泄露问题。我们表明,ChatGPT的安全防御措施对直接提示有效,但对我们提出的多步骤越狱提示的防御还不够。然后我们揭示了New Bing对直接提示的脆弱性。我们在附录D和E中讨论了这两种LLMs的隐私含义和潜在防御措施。

对于未来的工作,我们将实验更多的案例,并测试其他LLMs,如Google Bard。除了直接恢复个人信息外,我们将致力于身份披露提示,以量化其隐私威胁,如附录D所讨论的。

限制

从对手的角度来看,我们提出的多步骤越狱攻击在查询不频繁的安然电子邮件和电话号码时,恢复准确率仍然很低。如图1、2和3所示,我们提出的MJP对安然域的频繁电子邮件有效,而没有电话号码和非安然域的电子邮件地址可以被正确恢复。由于频繁的安然电子邮件地址主要由基于规则的模式组成,如“firstname.lastname@domain.com”,LLMs可能会利用这些基于规则的模式来生成更准确的预测。因此,重要的是要注意,对基于模板的电子邮件地址模式的提取攻击的成功,并不一定意味着LLMs记住了这些敏感记录,也不表示它们倾向于通过越狱泄露它们。

对于New Bing上的自由形式PII提取,随着我们要求New Bing列出更多示例,我们更有可能观察到后续示例中重复和错误的PII模式。最后,我们无法确认我们查询的PII是否由ChatGPT训练。幸运的是,图9给出了一个逐字长的电子邮件内容恢复的示例。这个结果表明ChatGPT是在安然电子邮件数据集上训练的。

伦理考虑

我们声明本论文的所有作者都承认ACM道德准则,并遵守行为准则。这项工作大量揭示了ChatGPT对我们提出的越狱隐私攻击的潜在隐私漏洞。我们的目标不是声称没有隐私保护的ChatGPT就有风险。相反,已经做出了巨大的努力来成功阻止直接查询,以前的数据提取攻击不再有效。我们的发现揭示了LLM的安全仍需要进一步的改进。

数据。在我们的实验中,我们编辑了个人信息以尊重他们的隐私。我们收集的安然电子邮件数据集和机构页面都是公开可用的。尽管如此,由于隐私考虑,我们不会发布我们收集的机构页面的教职员工PII。

越狱提示。我们非常清楚几个提示产生的有害内容,如仇恨言论和偏见问题。对于我们的实验,我们只使用附录A.1中提到的“开发者模式”越狱提示。根据我们的调查,“开发者模式”没有输出仇恨言论或有偏见的内容。然而,“开发者模式”有时可能会给出危险的建议,如黑客攻击大学的数据库。将来,如果有其他更安全的提示,我们将在这些提示下扩展我们的隐私攻击。