每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/

微软发布了三款全新的Phi 3.5模型,分别是Phi-3.5-mini-instruct(38亿参数)、Phi-3.5-MoE-instruct(419亿参数)和Phi-3.5-vision-instruct(41.5亿参数)。这三款模型分别针对基本/快速推理、更强大的推理以及视觉(图像和视频分析)任务进行了优化。https://huggingface.co/microsoft

这些模型已在Hugging Face平台上发布,开发者可以免费下载、使用,并根据需要进行微调。值得注意的是,所有模型都采用微软品牌的MIT许可,这意味着开发者可以自由进行商业用途和修改,无需受到任何限制。

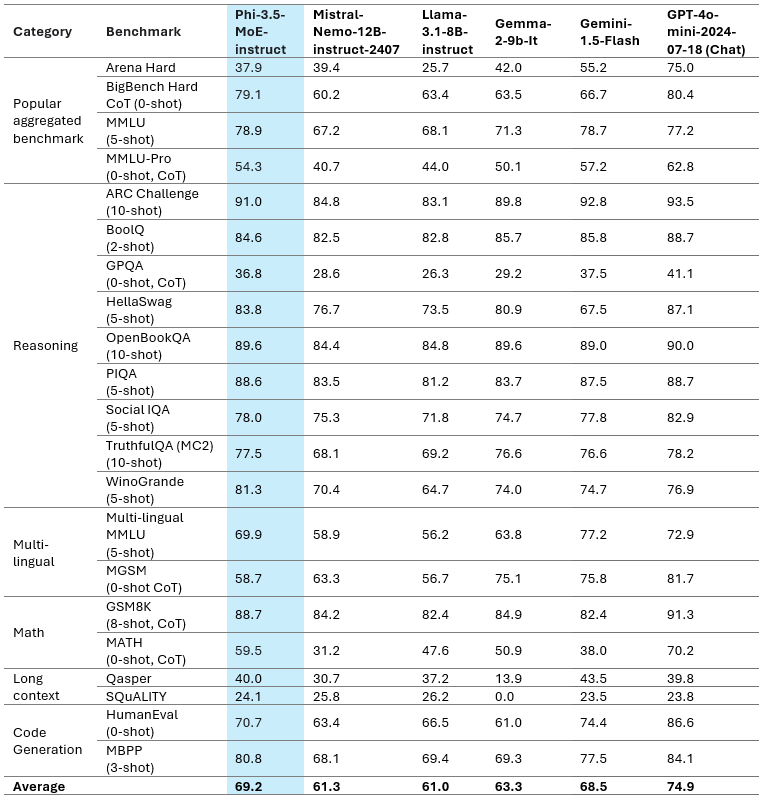

令人惊叹的是,这三款模型在多个第三方基准测试中表现出接近最先进水平,甚至在某些情况下超越了谷歌的Gemini 1.5 Flash、Meta的Llama 3.1,甚至是OpenAI的GPT-4o。结合其开放的许可条款,微软因此在社交媒体平台X上获得了广泛赞誉。

接下来,让我们简要回顾一下这些新模型,根据它们在Hugging Face上的发布说明进行分析。

Phi-3.5 Mini Instruct:优化计算资源受限环境

Phi-3.5 Mini Instruct模型是一款轻量级的AI模型,拥有38亿参数,专为遵循指令和支持128k上下文长度的任务而设计。这款模型非常适合那些需要强大推理能力但受限于内存或计算资源的场景,包括代码生成、数学问题解决和逻辑推理任务。

尽管模型体积小巧,但Phi-3.5 Mini Instruct在多语言和多轮对话任务中的表现仍然相当出色,相较于其前代产品有显著提升。在多项基准测试中表现接近最先进水平,并在长上下文代码理解的RepoQA基准测试中超过了其他类似规模的模型,如Llama-3.1-8B-instruct和Mistral-7B-instruct。

Phi-3.5 MoE:微软的“专家混合”模型

Phi-3.5 MoE模型代表微软首次推出的“专家混合”(Mixture of Experts)模型类别,结合了多种不同模型类型,每个子模型专门处理不同任务。该模型拥有42亿激活参数,支持128k上下文长度,为高需求应用提供可扩展的AI性能。

值得注意的是,Phi-3.5 MoE在各种推理任务中表现出色,尤其是在代码、数学和多语言理解方面,经常在特定基准测试中超越更大规模的模型。它在5次测试的MMLU(大规模多任务语言理解)基准测试中也表现出色,在STEM、人文、社会科学等多个学科领域都超过了GPT-4o mini。

MoE模型的独特架构使其在处理多语言的复杂AI任务时保持高效。

Phi-3.5 Vision Instruct:先进的多模态推理

这三款模型的最后一款是Phi-3.5 Vision Instruct模型,它将文本和图像处理能力结合在一起,特别适合执行图像理解、光学字符识别、图表和表格理解以及视频摘要等任务。与其他Phi-3.5系列模型一样,Vision Instruct支持128k上下文长度,使其能够处理复杂的多帧视觉任务。

微软指出,该模型是使用合成和过滤过的公开数据集训练的,重点放在高质量、推理密集型数据上。

新Phi三人组的训练

Phi-3.5 Mini Instruct模型使用512个H100-80G GPU在10天内处理了3.4万亿个token进行训练,而Vision Instruct模型则使用256个A100-80G GPU在6天内处理了5000亿个token。

至于Phi-3.5 MoE模型,由于其专家混合架构,它使用了512个H100-80G GPU,在23天内处理了4.9万亿个token。

开源MIT许可

所有三款Phi-3.5模型都以MIT许可发布,展现了微软对开源社区的支持。该许可允许开发者自由使用、修改、合并、发布、分发、再授权或销售该软件副本。

许可还包含免责声明,指出该软件“按原样”提供,不附带任何形式的保证。微软和其他版权持有者不对因使用该软件而产生的任何索赔、损害或其他责任负责。

微软发布Phi-3.5系列标志着多语言和多模态AI开发的一个重大进展。通过在开源许可下提供这些模型,微软赋予开发者将最先进的AI功能集成到其应用中的能力,促进了商业和研究领域的创新。