想象一下,你正站在一座巨大的图书馆前。这座图书馆里存放着你公司所有的数据。但是,书籍杂乱无章,没有分类,没有索引。你如何才能快速找到所需的信息?这就是数据仓库建模要解决的问题。本文将带你深入了解数据仓库建模的主要步骤,让你掌握如何将杂乱的数据转化为有序、高效、易用的信息宝库。

目录

- 什么是数据仓库建模?

- 步骤一:需求分析

- 关键活动:

- 示例:电商公司需求分析

- 需求分析的重要性

- 步骤二:数据源识别与分析

- 关键活动:

- 示例:电商公司数据源分析

- 数据源分析的挑战与解决方案

- 数据源分析的代码示例

- 步骤三:维度建模

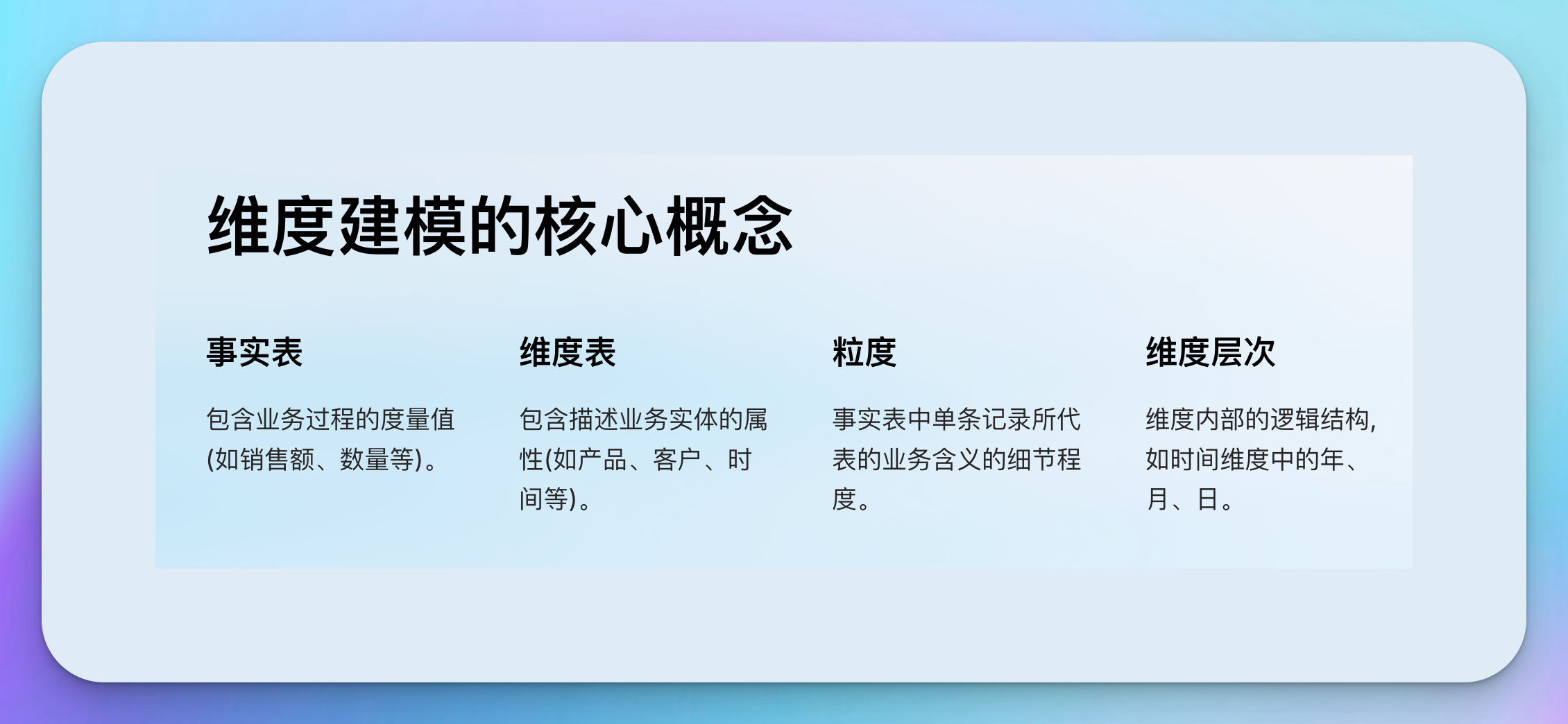

- 维度建模的核心概念:

- 维度建模步骤:

- 示例:电商销售数据的维度模型

- 维度建模的关键考虑因素:

- 维度模型的SQL实现示例:

- 维度建模的优势:

- 维度建模的挑战:

- 维度建模最佳实践:

- 步骤四:物理模型设计

- 物理模型设计的主要任务:

- 1. 选择适当的数据库平台

- 2. 表结构设计

- 3. 索引策略

- 4. 分区策略

- 5. 聚合表设计

- 6. 数据类型优化

- 7. 压缩策略

- 8. 物化视图

- 9. 安全性设计

- 10. 存储过程和函数

- 物理模型设计的最佳实践:

- 步骤五:ETL流程设计

- ETL流程的主要组成部分:

- 1. 数据提取策略

- 2. 数据转换逻辑

- 3. 数据加载策略

- 4. 错误处理和日志记录

- 5. 调度和编排

- 6. 数据质量管理

- 7. 性能优化

- 8. 元数据管理

- 9. 版本控制和变更管理

- 10. 安全性和合规性

- ETL设计最佳实践:

- 步骤六:模型实现与测试

- 模型实现

- 1. 数据库对象创建

- 2. ETL作业开发

- 3. 调度作业配置

- 4. 安全性实施

- 5. 监控和日志机制搭建

- 测试

- 单元测试

- 集成测试

- 性能测试

- 模型实现与测试的最佳实践:

- 步骤七:性能优化

- 1. 查询优化

- a. 索引策略

- b. 统计信息更新

- c. 查询重写

- 2. 分区策略

- a. 范围分区

- b. 列存储索引

- 3. 物化视图

- 4. 内存优化

- a. 内存优化表

- b. 缓存层

- 5. 并行处理

- a. 并行查询

- b. 分布式处理

- 6. 硬件优化

- a. SSD存储

- b. 增加内存

- c. 多核CPU

- 7. 监控和调优

- a. 性能监控

- b. 查询计划分析

- 性能优化的最佳实践:

- 步骤八:文档编写与维护

- 1. 系统架构文档

- 2. 数据模型文档

- 3. ETL流程文档

- 4. 数据质量文档

- 5. 用户指南

- 6. 运维手册

- 结论

什么是数据仓库建模?

数据仓库建模是一个系统化的过程,旨在设计和构建一个高效、可扩展的数据存储和分析环境。它的目标是将来自不同源系统的数据整合到一个统一的、面向主题的、随时间变化的数据集合中,以支持企业的决策制定过程。

数据仓库建模不仅仅是创建表格和定义关系,它更是一门艺术,需要平衡业务需求、技术限制和未来的可扩展性。一个优秀的数据仓库模型可以:

- 提供快速的查询性能

- 支持复杂的分析需求

- 适应业务的变化和增长

- 保持数据的一致性和准确性

接下来,让我们深入探讨数据仓库建模的每个主要步骤。

步骤一:需求分析

需求分析是数据仓库建模的基石。在这个阶段,我们需要与业务用户和利益相关者紧密合作,了解他们的需求,确定数据仓库需要解决的问题和支持的决策。

关键活动:

-

用户访谈: 与各个部门的关键用户进行面对面的访谈,了解他们的日常工作,遇到的数据相关问题,以及理想的解决方案。

-

需求文档化: 将收集到的需求整理成结构化的文档,包括:

- 业务问题描述

- 所需的关键指标(KPI)

- 数据粒度要求

- 报表和分析需求

- 数据更新频率要求

-

优先级排序: 与业务方共同评估各项需求的重要性和紧急程度,确定实施的优先顺序。

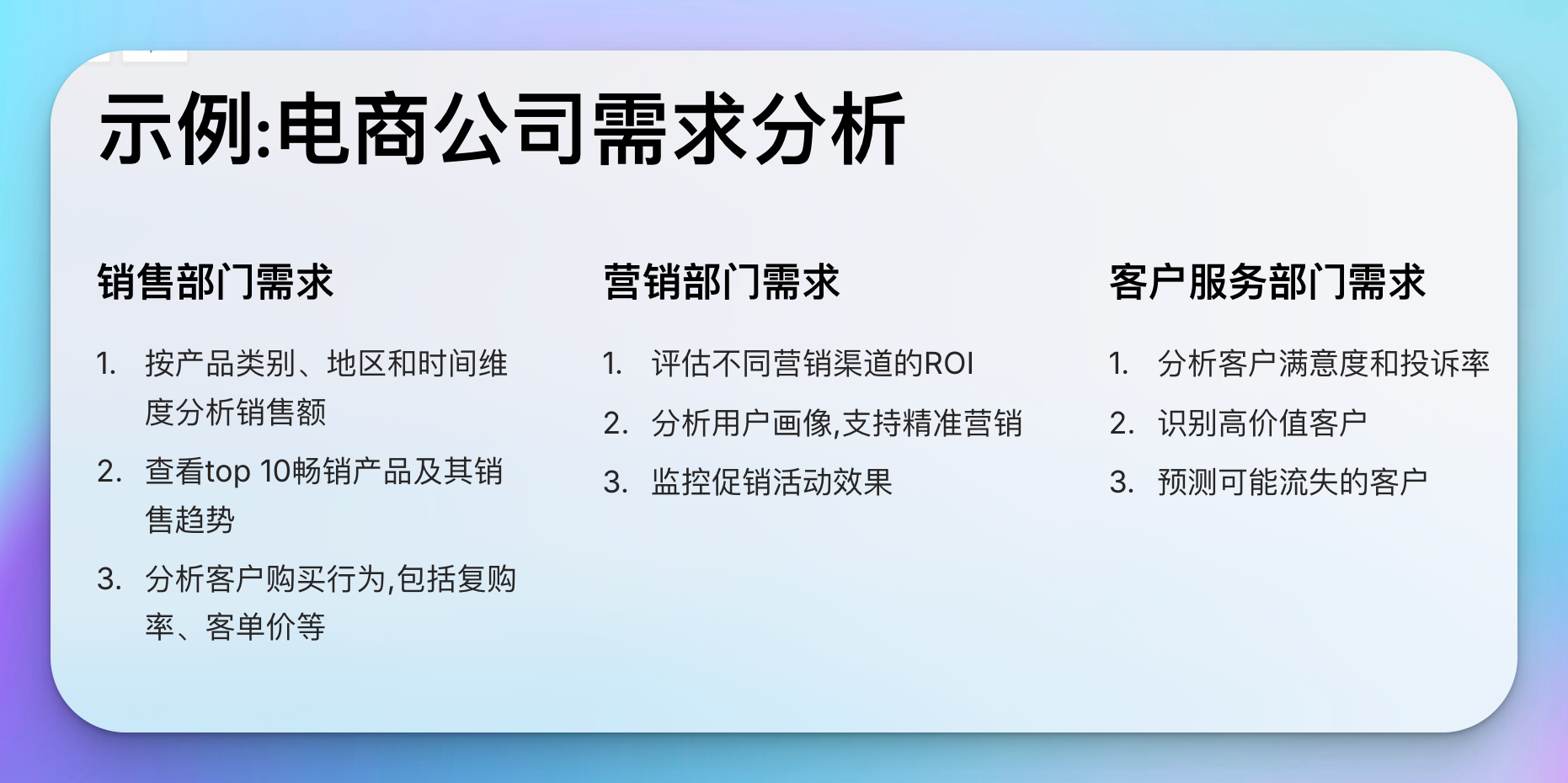

示例:电商公司需求分析

假设我们正在为一家电商公司设计数据仓库。通过与销售、营销和客户服务部门的访谈,我们可能会得到以下需求:

1. 销售部门需求:

- 按产品类别、地区和时间维度分析销售额

- 查看top 10畅销产品及其销售趋势

- 分析客户购买行为,包括复购率、客单价等

2. 营销部门需求:

- 评估不同营销渠道的ROI

- 分析用户画像,支持精准营销

- 监控促销活动效果

3. 客户服务部门需求:

- 分析客户满意度和投诉率

- 识别高价值客户

- 预测可能流失的客户

需求分析的重要性

精确的需求分析能够:

- 确保数据仓库的设计与业务目标一致

- 避免资源浪费在不必要的功能上

- 为后续的维度建模提供清晰的指导

记住,需求分析是一个迭代的过程。随着项目的进行,可能会发现新的需求或者需要调整优先级。保持与业务用户的持续沟通至关重要。

步骤二:数据源识别与分析

在明确了业务需求之后,下一步是识别和分析可以满足这些需求的数据源。这个步骤对于确保数据仓库中的数据质量和完整性至关重要。

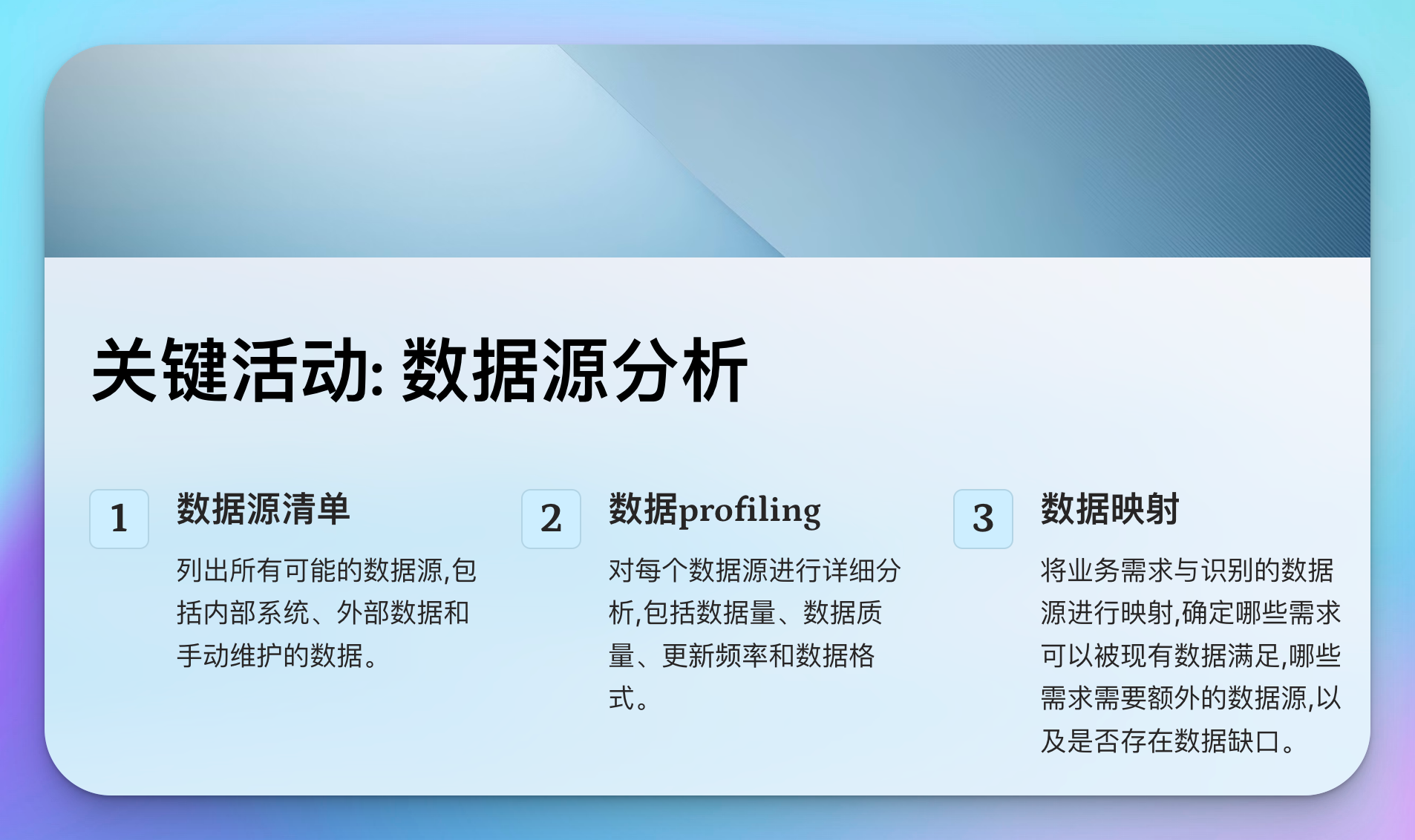

关键活动:

-

数据源清单: 列出所有可能的数据源,包括:

- 内部系统(如ERP、CRM、HR系统等)

- 外部数据(如市场研究数据、社交媒体数据等)

- 手动维护的数据(如Excel表格)

-

数据profiling: 对每个数据源进行详细分析,包括:

- 数据量和增长率

- 数据质量(准确性、完整性、一致性)

- 更新频率

- 数据格式和结构

-

数据映射: 将业务需求与识别的数据源进行映射,确定:

- 哪些需求可以被现有数据满足

- 哪些需求需要额外的数据源

- 是否存在数据缺口

示例:电商公司数据源分析

继续我们的电商公司示例,以下是可能的数据源分析结果:

1. 交易系统(Oracle数据库):

- 包含订单、产品、客户基本信息

- 数据量:每日约100万笔新交易

- 更新频率:实时

- 数据质量:高,但存在少量重复订单需清洗

2. CRM系统(Salesforce):

- 包含客户详细信息、互动历史

- 数据量:500万客户记录

- 更新频率:每小时

- 数据质量:中等,存在部分字段缺失问题

3. 营销系统(自研):

- 包含营销活动、渠道、效果数据

- 数据量:每月约1000个活动

- 更新频率:每日

- 数据质量:良好,但历史数据不完整

4. 客户服务系统(Zendesk):

- 包含客户反馈、投诉记录

- 数据量:每日约5000条新记录

- 更新频率:实时

- 数据质量:高,但需要进行情感分析

5. 外部数据(社交媒体API):

- 包含品牌提及、用户评论

- 数据量:不稳定,平均每日10万条

- 更新频率:准实时

- 数据质量:低,需要大量清洗和结构化处理

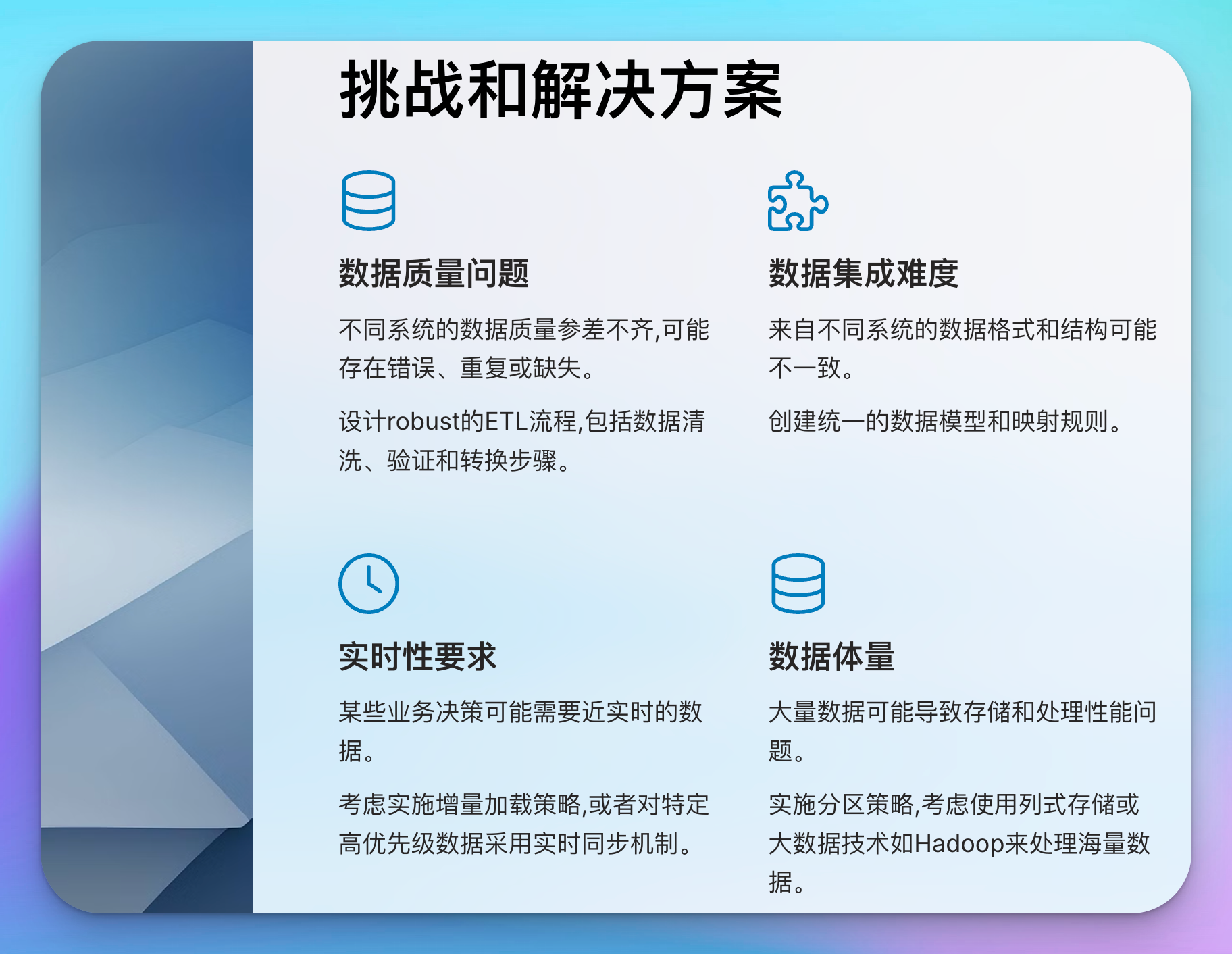

数据源分析的挑战与解决方案

-

数据质量问题:

- 挑战:不同系统的数据质量参差不齐,可能存在错误、重复或缺失。

- 解决方案:设计robust的ETL流程,包括数据清洗、验证和转换步骤。对于关键数据,考虑实施主数据管理(MDM)策略。

-

数据集成难度:

- 挑战:来自不同系统的数据格式和结构可能不一致。

- 解决方案:创建统一的数据模型和映射规则。考虑使用数据集成工具如Informatica或Talend来简化集成过程。

-

实时性要求:

- 挑战:某些业务决策可能需要近实时的数据。

- 解决方案:考虑实施增量加载策略,或者对特定高优先级数据采用实时同步机制。

-

数据体量:

- 挑战:大量数据可能导致存储和处理性能问题。

- 解决方案:实施分区策略,考虑使用列式存储或大数据技术如Hadoop来处理海量数据。

数据源分析的代码示例

以下是一个使用Python进行简单数据profiling的示例代码:

import pandas as pd

import numpy as np

def analyze_data_source(file_path, source_name):

# 读取数据

df = pd.read_csv(file_path)

# 基本信息

print(f"数据源: {source_name}")

print(f"记录数: {len(df)}")

print(f"字段数: {len(df.columns)}")

# 数据类型

print("\n数据类型:")

print(df.dtypes)

# 缺失值分析

print("\n缺失值比例:")

print(df.isnull().sum() / len(df))

# 基本统计

print("\n数值字段统计:")

print(df.describe())

# 唯一值分析

print("\n分类字段唯一值数量:")

for col in df.select_dtypes(include=['object']):

print(f"{col}: {df[col].nunique()}")

# 使用示例

analyze_data_source('transactions.csv', '交易系统')

这段代码可以帮助我们快速了解数据源的基本特征,包括数据量、字段类型、缺失值情况等,为后续的数据建模提供重要参考。

数据源识别与分析是数据仓库建模的关键环节。它不仅帮助我们了解可用的数据资产,还能揭示潜在的数据质量问题和集成挑战。通过全面细致的数据源分析,我们可以为后续的维度建模和ETL设计奠定坚实的基础。

步骤三:维度建模

维度建模是数据仓库设计中最关键的步骤之一。它将复杂的业务需求转化为结构化的、易于理解和查询的数据模型。维度模型通常采用星型模式或雪花模式,由事实表和维度表组成。

维度建模的核心概念:

- 事实表: 包含业务过程的度量值(如销售额、数量等)。

- 维度表: 包含描述业务实体的属性(如产品、客户、时间等)。

- 粒度: 事实表中单条记录所代表的业务含义的细节程度。

- 维度层次: 维度内部的逻辑结构,如时间维度中的年、月、日。

维度建模步骤:

-

确定业务过程: 根据需求分析,识别需要建模的核心业务过程(如销售、库存、客户服务等)。

-

声明粒度: 为每个业务过程确定适当的粒度级别。

-

识别维度: 确定描述每个业务过程的维度。

-

识别事实: 确定需要度量的业务指标。

-

设计维度表: 详细设计每个维度表,包括属性、层次结构等。

-

设计事实表: 设计事实表,包括外键和度量值。

示例:电商销售数据的维度模型

让我们以电商公司的销售数据为例,设计一个星型模式的维度模型:

1. 业务过程: 销售订单

2. 粒度: 单个订单项(一个订单中的一个产品)

3. 维度:

- 时间维度

- 产品维度

- 客户维度

- 地理维度

- 促销维度

4. 事实:

- 销售金额

- 销售数量

- 折扣金额

- 利润

5. 维度表设计:

时间维度(DIM_TIME):

- 时间键(主键)

- 日期

- 年

- 季度

- 月

- 周

- 是否节假日

产品维度(DIM_PRODUCT):

- 产品键(主键)

- 产品ID

- 产品名称

- 品类

- 子类

- 品牌

- 单位成本

- 建议零售价

客户维度(DIM_CUSTOMER):

- 客户键(主键)

- 客户ID客户维度(DIM_CUSTOMER):

- 客户键(主键)

- 客户ID

- 客户名称

- 客户类型(个人/企业)

- 注册日期

- 年龄段

- 性别

- 会员等级

地理维度(DIM_GEOGRAPHY):

- 地理键(主键)

- 国家

- 省/州

- 城市

- 邮政编码

促销维度(DIM_PROMOTION):

- 促销键(主键)

- 促销ID

- 促销名称

- 促销类型

- 开始日期

- 结束日期

- 折扣率

6. 事实表设计:

销售事实表(FACT_SALES):

- 订单项ID(主键)

- 时间键(外键)

- 产品键(外键)

- 客户键(外键)

- 地理键(外键)

- 促销键(外键)

- 订单ID

- 销售金额

- 销售数量

- 折扣金额

- 利润

维度建模的关键考虑因素:

-

缓慢变化维度(SCD)处理:

维度属性可能随时间变化,如客户地址、产品价格等。我们需要决定如何处理这些变化:- 类型1: 直接覆盖旧值

- 类型2: 保留历史记录,创建新行

- 类型3: 增加新列保存当前值

示例: 对于客户维度中的会员等级,我们可能选择使用类型2 SCD,以便跟踪客户等级的变化历史。

-

退化维度:

有时,一些低基数的属性可以直接包含在事实表中,而不需要创建单独的维度表。示例: 订单状态(已付款、已发货、已完成等)可以作为退化维度直接存储在销售事实表中。

-

桥接表:

用于处理多对多关系或复杂层次结构。示例: 如果一个订单可以应用多个促销,我们可能需要一个桥接表来连接销售事实表和促销维度表。

-

一致性维度:

确保跨多个事实表的共同维度保持一致。示例: 产品维度应在销售、库存、采购等多个事实表中保持一致。

-

日期维度的特殊处理:

日期维度通常需要预先生成,包含丰富的属性以支持各种时间相关的分析。

维度模型的SQL实现示例:

以下是基于上述星型模式的部分SQL创建语句:

-- 创建时间维度表

CREATE TABLE DIM_TIME (

time_key INT PRIMARY KEY,

date DATE,

year INT,

quarter INT,

month INT,

week INT,

is_holiday BOOLEAN

);

-- 创建产品维度表

CREATE TABLE DIM_PRODUCT (

product_key INT PRIMARY KEY,

product_id VARCHAR(50),

product_name VARCHAR(100),

category VARCHAR(50),

subcategory VARCHAR(50),

brand VARCHAR(50),

unit_cost DECIMAL(10,2),

retail_price DECIMAL(10,2)

);

-- 创建客户维度表

CREATE TABLE DIM_CUSTOMER (

customer_key INT PRIMARY KEY,

customer_id VARCHAR(50),

customer_name VARCHAR(100),

customer_type VARCHAR(20),

registration_date DATE,

age_group VARCHAR(20),

gender VARCHAR(10),

membership_level VARCHAR(20)

);

-- 创建销售事实表

CREATE TABLE FACT_SALES (

order_item_id BIGINT PRIMARY KEY,

time_key INT,

product_key INT,

customer_key INT,

geography_key INT,

promotion_key INT,

order_id VARCHAR(50),

sales_amount DECIMAL(12,2),

quantity INT,

discount_amount DECIMAL(10,2),

profit DECIMAL(10,2),

FOREIGN KEY (time_key) REFERENCES DIM_TIME(time_key),

FOREIGN KEY (product_key) REFERENCES DIM_PRODUCT(product_key),

FOREIGN KEY (customer_key) REFERENCES DIM_CUSTOMER(customer_key),

FOREIGN KEY (geography_key) REFERENCES DIM_GEOGRAPHY(geography_key),

FOREIGN KEY (promotion_key) REFERENCES DIM_PROMOTION(promotion_key)

);

维度建模的优势:

- 直观性: 星型或雪花模型结构简单,易于业务用户理解。

- 查询性能: 通过降低表的数量和预先计算聚合,提高查询速度。

- 灵活性: 易于添加新的维度或修改现有维度,以适应业务变化。

- 一致性: 提供了一个统一的数据视图,确保跨部门的报告一致性。

维度建模的挑战:

- 数据冗余: 维度表中可能存在数据重复,需要权衡存储成本和查询性能。

- 维护复杂性: 随着维度和事实表的增加,模型可能变得复杂,需要仔细管理。

- 历史数据处理: 处理缓慢变化维度可能会增加模型的复杂性和存储需求。

- 粒度选择: 选择过粗的粒度可能无法满足详细分析需求,选择过细则可能影响性能。

维度建模最佳实践:

- 从高层需求出发: 始终以业务需求为导向,避免过度设计。

- 保持简单: 尽可能使用星型模式,只在必要时采用雪花模式。

- 标准化命名: 采用一致的命名约定,提高模型的可读性。

- 考虑未来扩展: 在设计时预留扩展空间,以适应未来的需求变化。

- 性能优化: 合理使用索引、分区等技术,提升查询性能。

- 数据质量: 在ETL过程中加入数据质量检查,确保维度模型中的数据准确性。

维度建模是一个迭代的过程,需要与业务用户密切合作,不断调整和优化。一个优秀的维度模型不仅能满足当前的分析需求,还能为未来的业务发展提供灵活性和可扩展性。

步骤四:物理模型设计

在完成逻辑层面的维度建模后,下一步是将概念模型转化为实际的数据库结构。物理模型设计关注如何在特定的数据库管理系统中最优地实现逻辑模型,以满足性能、可伸缩性和维护性的要求。

物理模型设计的主要任务:

- 选择适当的数据库平台

- 表结构设计

- 索引策略

- 分区策略

- 聚合表设计

- 数据类型优化

让我们详细探讨每个任务:

1. 选择适当的数据库平台

选择数据库平台需要考虑多个因素:

- 数据量和增长趋势

- 查询复杂度和响应时间要求

- 并发用户数

- 预算和现有技术栈

- 团队的技术能力

常见的数据仓库平台包括:

- 传统关系型数据库: Oracle, SQL Server, PostgreSQL

- 列式存储数据库: Vertica, Amazon Redshift

- 云原生数据仓库: Snowflake, Google BigQuery

- 大数据解决方案: Hadoop生态系统 (Hive, Impala)

示例决策过程:

考虑因素:

1. 数据量: 预计5年内增长到50TB

2. 查询模式: 主要是复杂的分析查询,需要快速响应

3. 用户数: 100-200并发用户

4. 预算: 中等,倾向于可预测的成本模型

5. 团队技能: 熟悉SQL,但缺乏大数据经验

基于以上因素,我们可能会选择Snowflake作为数据仓库平台:

- 可扩展性好,能处理大数据量

- 列式存储适合分析查询

- 支持高并发

- 按使用付费,成本可控

- 使用标准SQL,学习曲线平缓

2. 表结构设计

将逻辑模型转化为物理表结构时,需要考虑:

- 主键策略: 自然键vs代理键

- 外键关系: 是否在物理层实施

- 列命名规范

- 表命名规范

示例:销售事实表的物理设计

CREATE TABLE fact_sales (

sales_key BIGINT IDENTITY(1,1) PRIMARY KEY,

order_date_key INT NOT NULL,

product_key INT NOT NULL,

customer_key INT NOT NULL,

geography_key INT NOT NULL,

promotion_key INT,

order_id VARCHAR(50) NOT NULL,

sales_amount DECIMAL(12,2) NOT NULL,

quantity INT NOT NULL,

discount_amount DECIMAL(10,2) NOT NULL,

profit DECIMAL(10,2) NOT NULL,

CONSTRAINT fk_date FOREIGN KEY (order_date_key) REFERENCES dim_date(date_key),

CONSTRAINT fk_product FOREIGN KEY (product_key) REFERENCES dim_product(product_key),

CONSTRAINT fk_customer FOREIGN KEY (customer_key) REFERENCES dim_customer(customer_key),

CONSTRAINT fk_geography FOREIGN KEY (geography_key) REFERENCES dim_geography(geography_key),

CONSTRAINT fk_promotion FOREIGN KEY (promotion_key) REFERENCES dim_promotion(promotion_key)

);

3. 索引策略

合理的索引可以显著提升查询性能,但也会增加存储空间和影响写入性能。常见的索引类型包括:

- 聚集索引

- 非聚集索引

- 位图索引

- 分区索引

索引设计示例:

-- 在事实表的日期键上创建聚集索引

CREATE CLUSTERED INDEX ix_fact_sales_date ON fact_sales(order_date_key);

-- 在常用的维度键上创建非聚集索引

CREATE NONCLUSTERED INDEX ix_fact_sales_product ON fact_sales(product_key);

CREATE NONCLUSTERED INDEX ix_fact_sales_customer ON fact_sales(customer_key);

-- 在低基数列上创建位图索引(Oracle语法)

CREATE BITMAP INDEX ix_fact_sales_promotion ON fact_sales(promotion_key);

4. 分区策略

分区可以提高大表的查询性能和管理效率。常见的分区策略包括:

- 范围分区

- 列表分区

- 哈希分区

分区设计示例:

-- 按日期范围分区(PostgreSQL语法)

CREATE TABLE fact_sales (

sales_key BIGINT,

order_date_key INT,

-- 其他列...

) PARTITION BY RANGE (order_date_key);

CREATE TABLE fact_sales_2023 PARTITION OF fact_sales

FOR VALUES FROM (20230101) TO (20240101);

CREATE TABLE fact_sales_2024 PARTITION OF fact_sales

FOR VALUES FROM (20240101) TO (20250101);

5. 聚合表设计

聚合表存储预计算的汇总数据,可以显著提升常用查询的性能。

聚合表示例:

CREATE TABLE agg_daily_sales (

date_key INT,

product_key INT,

total_sales DECIMAL(15,2),

total_quantity INT,

total_profit DECIMAL(15,2),

PRIMARY KEY (date_key, product_key)

);

-- 填充聚合表的存储过程

CREATE PROCEDURE sp_update_daily_sales AS

BEGIN

TRUNCATE TABLE agg_daily_sales;

INSERT INTO agg_daily_sales (date_key, product_key, total_sales, total_quantity, total_profit)

SELECT

order_date_key,

product_key,

SUM(sales_amount) as total_sales,

SUM(quantity) as total_quantity,

SUM(profit) as total_profit

FROM fact_sales

GROUP BY order_date_key, product_key;

END;

6. 数据类型优化

选择合适的数据类型可以优化存储空间和查询性能:

- 使用最小的数值类型: 如TINYINT代替INT(适用时)

- 定长vs变长字符串: 固定长度使用CHAR,变长使用VARCHAR

- 日期和时间: 使用DATE而不是DATETIME(如果不需要时间精度)

- 精确数值vs近似数值: 金额使用DECIMAL,而不是FLOAT

数据类型优化示例:

CREATE TABLE dim_product (

product_key INT PRIMARY KEY,

product_id CHAR(10) NOT NULL, -- 假设产品ID总是10个字符

product_name VARCHAR(100) NOT NULL,

category VARCHAR(50) NOT NULL,

subcategory VARCHAR(50) NOT NULL,

brand VARCHAR(50) NOT NULL,

unit_cost DECIMAL(10,2) NOT NULL,

retail_price DECIMAL(10,2) NOT NULLintroduction_date DATE NOT NULL,

is_active BIT NOT NULL DEFAULT 1

);

7. 压缩策略

数据压缩可以减少存储需求并提高I/O性能,但可能会增加CPU开销。许多现代数据库系统提供了内置的压缩功能。

压缩策略示例(SQL Server语法):

-- 对整个表启用页面压缩

ALTER TABLE fact_sales REBUILD PARTITION = ALL WITH (DATA_COMPRESSION = PAGE);

-- 对特定列启用列存储压缩

CREATE COLUMNSTORE INDEX ix_cs_fact_sales

ON fact_sales (order_date_key, product_key, sales_amount, quantity);

8. 物化视图

物化视图是预先计算并存储的查询结果,可以显著提高复杂查询的性能。

物化视图示例(Oracle语法):

CREATE MATERIALIZED VIEW mv_monthly_sales

BUILD IMMEDIATE

REFRESH COMPLETE ON DEMAND

ENABLE QUERY REWRITE

AS

SELECT

TO_CHAR(d.date, 'YYYY-MM') as month,

p.category,

SUM(f.sales_amount) as total_sales,

SUM(f.quantity) as total_quantity

FROM

fact_sales f

JOIN dim_date d ON f.order_date_key = d.date_key

JOIN dim_product p ON f.product_key = p.product_key

GROUP BY

TO_CHAR(d.date, 'YYYY-MM'),

p.category;

9. 安全性设计

数据安全是物理模型设计中不可忽视的一环,包括:

- 访问控制: 用户权限管理

- 数据加密: 敏感数据的存储和传输加密

- 审计跟踪: 记录重要操作

安全设计示例:

-- 创建角色

CREATE ROLE sales_analyst;

-- 授予权限

GRANT SELECT ON fact_sales TO sales_analyst;

GRANT SELECT ON dim_product TO sales_analyst;

-- 创建用户并分配角色

CREATE USER john_doe WITH PASSWORD 'complex_password';

GRANT sales_analyst TO john_doe;

-- 加密敏感列(SQL Server语法)

ALTER TABLE dim_customer

ALTER COLUMN credit_card_number varbinary(200) ENCRYPTED WITH (COLUMN_ENCRYPTION_KEY = MyCEK, ENCRYPTION_TYPE = Deterministic, ALGORITHM = 'AEAD_AES_256_CBC_HMAC_SHA_256');

-- 启用审计(PostgreSQL语法)

CREATE TABLE audit_log (

audit_id SERIAL PRIMARY KEY,

table_name VARCHAR(50),

operation VARCHAR(10),

user_name VARCHAR(50),

operation_time TIMESTAMP,

old_values JSON,

new_values JSON

);

CREATE OR REPLACE FUNCTION audit_trigger_func() RETURNS TRIGGER AS $body$

BEGIN

IF (TG_OP = 'DELETE') THEN

INSERT INTO audit_log (table_name, operation, user_name, operation_time, old_values)

VALUES (TG_TABLE_NAME, 'DELETE', current_user, current_timestamp, row_to_json(OLD));

ELSIF (TG_OP = 'UPDATE') THEN

INSERT INTO audit_log (table_name, operation, user_name, operation_time, old_values, new_values)

VALUES (TG_TABLE_NAME, 'UPDATE', current_user, current_timestamp, row_to_json(OLD), row_to_json(NEW));

ELSIF (TG_OP = 'INSERT') THEN

INSERT INTO audit_log (table_name, operation, user_name, operation_time, new_values)

VALUES (TG_TABLE_NAME, 'INSERT', current_user, current_timestamp, row_to_json(NEW));

END IF;

RETURN NULL;

END;

$body$ LANGUAGE plpgsql;

CREATE TRIGGER audit_fact_sales

AFTER INSERT OR UPDATE OR DELETE ON fact_sales

FOR EACH ROW EXECUTE FUNCTION audit_trigger_func();

10. 存储过程和函数

存储过程和函数可以封装复杂的业务逻辑,提高代码复用性和维护性。

存储过程示例(用于刷新聚合表):

CREATE PROCEDURE sp_refresh_agg_tables

AS

BEGIN

-- 刷新日销售聚合表

TRUNCATE TABLE agg_daily_sales;

INSERT INTO agg_daily_sales (date_key, product_key, total_sales, total_quantity, total_profit)

SELECT

order_date_key,

product_key,

SUM(sales_amount) as total_sales,

SUM(quantity) as total_quantity,

SUM(profit) as total_profit

FROM fact_sales

GROUP BY order_date_key, product_key;

-- 刷新月销售聚合表

TRUNCATE TABLE agg_monthly_sales;

INSERT INTO agg_monthly_sales (year_month, category, total_sales, total_quantity)

SELECT

FORMAT(d.date, 'yyyy-MM') as year_month,

p.category,

SUM(f.sales_amount) as total_sales,

SUM(f.quantity) as total_quantity

FROM

fact_sales f

JOIN dim_date d ON f.order_date_key = d.date_key

JOIN dim_product p ON f.product_key = p.product_key

GROUP BY

FORMAT(d.date, 'yyyy-MM'),

p.category;

END;

物理模型设计的最佳实践:

-

性能与可维护性平衡: 不要过度优化,保持模型的可理解性和可维护性。

-

考虑数据加载性能: 设计时不仅要考虑查询性能,还要兼顾数据加载和更新的效率。

-

预留扩展空间: 为未来可能的需求变化预留一定的扩展空间。

-

文档化: 详细记录物理模型的设计决策和原因,便于后续维护和知识传承。

-

测试驱动设计: 使用真实的查询模式和数据量进行测试,验证设计的有效性。

-

定期review和优化: 随着数据量和查询模式的变化,定期回顾和优化物理模型。

-

遵循命名约定: 制定并严格遵循一致的命名约定,提高代码可读性。

-

版本控制: 使用版本控制系统管理数据库脚本,便于跟踪变更和回滚。

物理模型设计是一个需要平衡多方面因素的复杂过程。它需要深入理解业务需求、数据特征和技术平台的特性。一个优秀的物理模型不仅能满足当前的性能需求,还应具有足够的灵活性以适应未来的变化。在设计过程中,与业务用户、DBA和ETL开发人员的密切合作是确保设计成功的关键。

步骤五:ETL流程设计

ETL(Extract, Transform, Load)是数据仓库实施中的关键环节,负责将数据从源系统提取、转换并加载到数据仓库中。一个well-designed的ETL流程不仅能确保数据的及时性和准确性,还能提高整个数据仓库的性能和可维护性。

ETL流程的主要组成部分:

- 提取(Extract): 从源系统获取数据

- 转换(Transform): 清洗、整合和转换数据

- 加载(Load): 将处理后的数据加载到目标数据仓库

让我们详细探讨ETL流程设计的各个方面:

1. 数据提取策略

数据提取需要考虑以下因素:

- 源系统的类型(关系型数据库、文件、API等)

- 数据量

- 提取频率

- 源系统的可用性和性能影响

常见的提取方法包括:

a) 全量提取: 每次提取所有数据

b) 增量提取: 只提取自上次提取以来发生变化的数据

c) 变更数据捕获(CDC): 实时或准实时捕获源系统的数据变化

示例:使用SQL Server的CDC功能进行增量提取

-- 在源数据库中启用CDC

EXEC sys.sp_cdc_enable_db;

-- 为特定表启用CDC

EXEC sys.sp_cdc_enable_table

@source_schema = N'dbo',

@source_name = N'orders',

@role_name = NULL;

-- 在ETL作业中使用CDC函数提取变更数据

DECLARE @from_lsn binary(10), @to_lsn binary(10);

SET @from_lsn = sys.fn_cdc_get_min_lsn('dbo_orders');

SET @to_lsn = sys.fn_cdc_get_max_lsn();

SELECT * FROM cdc.fn_cdc_get_all_changes_dbo_orders

(@from_lsn, @to_lsn, N'all');

2. 数据转换逻辑

数据转换是ETL过程中最复杂的部分,可能涉及多种操作:

- 数据清洗: 处理空值、异常值、重复数据等

- 数据标准化: 统一格式、单位等

- 数据集成: 合并来自不同源的数据

- 数据计算: 生成派生字段、聚合计算等

- 数据映射: 将源系统的代码映射到数据仓库的维度值

示例:使用SQL进行数据转换

-- 清洗和标准化客户数据

INSERT INTO dim_customer (customer_id, customer_name, email, phone)

SELECT

customer_id,

UPPER(TRIM(first_name)) + ' ' + UPPER(TRIM(last_name)) AS customer_name,

LOWER(TRIM(email)) AS email,

CASE

WHEN LEN(phone) = 10 THEN

'(' + SUBSTRING(phone, 1, 3) + ') ' +

SUBSTRING(phone, 4, 3) + '-' +

SUBSTRING(phone, 7, 4)

ELSE phone

END AS phone

FROM source_customer

WHERE customer_id NOT IN (SELECT customer_id FROM dim_customer);

-- 计算派生字段并进行聚合

INSERT INTO fact_daily_sales (date_key, product_key, total_sales, total_quantity, avg_price)

SELECT

CONVERT(INT, CONVERT(VARCHAR, order_date, 112)) AS date_key,

product_id AS product_key,

SUM(sale_amount) AS total_sales,

SUM(quantity) AS total_quantity,

AVG(sale_amount / quantity) AS avg_price

FROM source_orders

GROUP BY CONVERT(INT, CONVERT(VARCHAR, order_date, 112)), product_id;

3. 数据加载策略

数据加载策略需要考虑:

- 加载方式: 批量加载vs实时加载

- 加载频率: 每日、每小时、准实时等

- 错误处理和恢复机制

- 并发控制和事务管理

常见的加载策略包括:

a) 完全刷新: 删除目标表中的所有数据,然后加载新数据

b) 增量更新: 只插入或更新变化的数据

c) Merge操作: 同时处理插入、更新和删除

示例:使用MERGE语句进行增量更新

MERGE INTO dim_product AS target

USING (SELECT * FROM staging_product) AS source

ON (target.product_id = source.product_id)

WHEN MATCHED AND (

target.product_name <> source.product_name OR

target.category <> source.category OR

target.price <> source.price

) THEN

UPDATE SET

target.product_name = source.product_name,

target.category = source.category,

target.price = source.price,

target.last_updated = GETDATE()

WHEN NOT MATCHED THEN

INSERT (product_id, product_name, category, price, create_date, last_updated)

VALUES (source.product_id, source.product_name, source.category, source.price, GETDATE(), GETDATE());

4. 错误处理和日志记录

健壮的ETL流程应该能够优雅地处理各种异常情况,并提供详细的日志以便于问题诊断和审计。

示例:使用Try-Catch块和日志记录

CREATE TABLE etl_log (

log_id INT IDENTITY PRIMARY KEY,

process_name VARCHAR(100),

start_time DATETIME,

end_time DATETIME,

status VARCHAR(20),

error_message VARCHAR(MAX)

);

CREATE PROCEDURE sp_load_dim_product

AS

BEGIN

DECLARE @start_time DATETIME = GETDATE();

DECLARE @error_message VARCHAR(MAX);

BEGIN TRY

BEGIN TRANSACTION;

-- ETL逻辑

MERGE INTO dim_product AS target

USING (SELECT * FROM staging_product) AS source

ON (target.product_id = source.product_id)

-- MERGE语句的其余部分...

COMMIT TRANSACTION;

INSERT INTO etl_log (process_name, start_time, end_time, status)

VALUES ('Load Dim Product', @start_time, GETDATE(), 'Success');

END TRY

BEGIN CATCH

ROLLBACK TRANSACTION;

SET @error_message = ERROR_MESSAGE();

INSERT INTO etl_log (process_name, start_time, end_time, status, error_message)

VALUES ('Load Dim Product', @start_time, GETDATE(), 'Failed', @error_message);

-- 可以选择重新抛出异常或者发送警报

THROW;

END CATCH;

END;

5. 调度和编排

ETL作业### 5. 调度和编排

ETL作业的调度和编排是确保数据及时更新和保持一致性的关键。这涉及到:

- 作业依赖关系管理

- 执行频率设置

- 并行处理

- 失败重试机制

许多ETL工具和平台提供了内置的调度功能,例如SQL Server Integration Services (SSIS)的包执行实用工具,或Apache Airflow这样的开源工作流管理平台。

示例:使用Apache Airflow定义ETL DAG(有向无环图)

from airflow import DAG

from airflow.operators.python_operator import PythonOperator

from datetime import datetime, timedelta

default_args = {

'owner': 'data_engineer',

'depends_on_past': False,

'start_date': datetime(2023, 1, 1),

'email_on_failure': False,

'email_on_retry': False,

'retries': 1,

'retry_delay': timedelta(minutes=5),

}

dag = DAG(

'daily_sales_etl',

default_args=default_args,

description='Daily ETL process for sales data',

schedule_interval=timedelta(days=1),

)

def extract_sales_data():

# 提取逻辑

pass

def transform_sales_data():

# 转换逻辑

pass

def load_sales_data():

# 加载逻辑

pass

t1 = PythonOperator(

task_id='extract_sales_data',

python_callable=extract_sales_data,

dag=dag,

)

t2 = PythonOperator(

task_id='transform_sales_data',

python_callable=transform_sales_data,

dag=dag,

)

t3 = PythonOperator(

task_id='load_sales_data',

python_callable=load_sales_data,

dag=dag,

)

t1 >> t2 >> t3

6. 数据质量管理

确保数据质量是ETL过程中的重要组成部分。这包括:

- 数据完整性检查

- 业务规则验证

- 一致性检查

- 异常值检测

示例:使用SQL实现简单的数据质量检查

-- 检查空值

SELECT COUNT(*) AS null_count

FROM fact_sales

WHERE order_id IS NULL OR customer_id IS NULL OR product_id IS NULL;

-- 检查数值范围

SELECT COUNT(*) AS invalid_quantity

FROM fact_sales

WHERE quantity <= 0 OR quantity > 1000;

-- 检查日期有效性

SELECT COUNT(*) AS future_orders

FROM fact_sales

WHERE order_date > GETDATE();

-- 检查参照完整性

SELECT COUNT(*) AS orphan_records

FROM fact_sales f

LEFT JOIN dim_product p ON f.product_id = p.product_id

WHERE p.product_id IS NULL;

-- 检查唯一性约束

SELECT order_id, COUNT(*)

FROM fact_sales

GROUP BY order_id

HAVING COUNT(*) > 1;

7. 性能优化

ETL性能优化是确保数据及时可用的关键。一些常用的优化技术包括:

- 并行处理

- 批量操作

- 索引优化

- 分区切换

- 使用高性能数据加载工具(如SQL Server的BULK INSERT)

示例:使用分区切换实现快速加载

-- 创建临时表来存储新数据

CREATE TABLE fact_sales_temp (

-- 列定义与fact_sales相同

) ON sales_fg1 (order_date);

-- 加载新数据到临时表

INSERT INTO fact_sales_temp

SELECT * FROM staging_sales;

-- 切换分区

ALTER TABLE fact_sales SWITCH PARTITION 2 TO fact_sales_temp PARTITION 2;

-- 删除旧数据

TRUNCATE TABLE fact_sales_temp;

8. 元数据管理

元数据管理对于ETL过程的可维护性和可追踪性至关重要。这包括:

- 源到目标的映射信息

- 转换规则文档

- 作业执行历史

- 数据血缘追踪

示例:使用表来存储元数据

-- 创建元数据表

CREATE TABLE etl_metadata (

metadata_id INT IDENTITY PRIMARY KEY,

source_table VARCHAR(100),

target_table VARCHAR(100),

column_name VARCHAR(100),

transformation_rule VARCHAR(MAX),

last_updated DATETIME,

updated_by VARCHAR(50)

);

-- 插入元数据

INSERT INTO etl_metadata (source_table, target_table, column_name, transformation_rule, last_updated, updated_by)

VALUES

('source_orders', 'fact_sales', 'total_amount', 'SUM(unit_price * quantity)', GETDATE(), 'ETL_PROCESS'),

('source_customers', 'dim_customer', 'full_name', 'CONCAT(first_name, '' '', last_name)', GETDATE(), 'ETL_PROCESS');

9. 版本控制和变更管理

随着业务需求的变化,ETL流程也需要相应调整。实施版本控制和变更管理可以:

- 跟踪ETL脚本的变更历史

- 便于回滚到之前的版本

- 支持多人协作开发

推荐使用Git等版本控制系统来管理ETL脚本和配置文件。

10. 安全性和合规性

ETL流程通常会处理敏感数据,因此需要特别注意安全性和合规性:

- 数据传输加密

- 敏感数据脱敏

- 访问控制和审计

- 遵守数据保护法规(如GDPR、CCPA等)

示例:使用SQL Server的动态数据脱敏功能

-- 在客户维度表中为信用卡号添加动态数据脱敏

ALTER TABLE dim_customer

ALTER COLUMN credit_card_number ADD MASKED WITH (FUNCTION = 'partial(0,"XXXX-XXXX-XXXX-",4)');

-- 授予特定用户查看未脱敏数据的权限

GRANT UNMASK TO data_analyst;

ETL设计最佳实践:

-

模块化设计: 将ETL流程分解为可重用的组件,提高维护性和可扩展性。

-

增量处理: 尽可能使用增量处理而不是全量处理,以提高效率。

-

错误处理: 实现健壮的错误处理和日志记录机制,便于问题诊断和恢复。

-

可重启性: 设计能够从失败点重新启动的ETL作业,避免重复处理。

-

参数化: 使用参数化脚本,提高灵活性和可重用性。

-

测试驱动开发: 为ETL流程编写单元测试和集成测试,确保数据质量。

-

监控和告警: 实施全面的监控和告警机制,及时发现和解决问题。

-

文档化: 详细记录ETL流程的设计、实现和操作指南。

-

性能基准: 建立性能基准,定期评估和优化ETL性能。

-

持续改进: 定期回顾和优化ETL流程,适应不断变化的业务需求和数据特征。

ETL流程设计是数据仓库项目中最耗时和最具挑战性的部分之一。它需要深入理解业务需求、数据特征和技术平台的特性。一个well-designed的ETL流程不仅能确保数据的及时性和准确性,还能为整个数据仓库的成功奠定基础。在设计和实施过程中,与业务用户、数据架构师和DBA的密切合作是确保成功的关键。

步骤六:模型实现与测试

在完成了逻辑模型设计、物理模型设计和ETL流程设计之后,下一步是将这些设计付诸实施并进行全面测试。这个阶段的目标是构建一个功能完备、性能优良、可靠稳定的数据仓库系统。

模型实现

模型实现涉及以下几个主要方面:

-

数据库对象创建:

- 创建表、视图、索引、存储过程等

- 实施分区策略

- 设置约束和触发器

-

ETL作业开发:

- 编写数据提取脚本

- 实现数据转换逻辑

- 开发数据加载程序

-

调度作业配置:

- 设置ETL作业的执行计划

- 配置作业依赖关系

-

安全性实施:

- 创建用户和角色

- 设置对象级别的权限

- 实施数据加密(如果需要)

-

监控和日志机制搭建:

- 配置性能监控工具

- 实现日志记录系统

让我们通过一些具体的例子来说明这些实现步骤:

1. 数据库对象创建

使用SQL脚本创建表、索引和约束:

-- 创建维度表

CREATE TABLE dim_customer (

customer_key INT IDENTITY(1,1) PRIMARY KEY,

customer_id VARCHAR(20) NOT NULL,

customer_name VARCHAR(100) NOT NULL,

email VARCHAR(100),

phone VARCHAR(20),

address VARCHAR(200),

city VARCHAR(50),

country VARCHAR(50),

create_date DATE NOT NULL,

update_date DATE NOT NULL

);

-- 创建事实表

CREATE TABLE fact_sales (

sale_key BIGINT IDENTITY(1,1) PRIMARY KEY,

order_date_key INT NOT NULL,

customer_key INT NOT NULL,

product_key INT NOT NULL,

promotion_key INT,

employee_key INT NOT NULL,

store_key INT NOT NULL,

order_number VARCHAR(20) NOT NULL,

quantity INT NOT NULL,

unit_price DECIMAL(10,2) NOT NULL,

discount_amount DECIMAL(10,2) NOT NULL,

total_amount DECIMAL(10,2) NOT NULL,

CONSTRAINT fk_fact_sales_date FOREIGN KEY (order_date_key) REFERENCES dim_date(date_key),

CONSTRAINT fk_fact_sales_customer FOREIGN KEY (customer_key) REFERENCES dim_customer(customer_key),

CONSTRAINT fk_fact_sales_product FOREIGN KEY (product_key) REFERENCES dim_product(product_key),

CONSTRAINT fk_fact_sales_promotion FOREIGN KEY (promotion_key) REFERENCES dim_promotion(promotion_key),

CONSTRAINT fk_fact_sales_employee FOREIGN KEY (employee_key) REFERENCES dim_employee(employee_key),

CONSTRAINT fk_fact_sales_store FOREIGN KEY (store_key) REFERENCES dim_store(store_key)

);

-- 创建索引

CREATE NONCLUSTERED INDEX ix_fact_sales_date ON fact_sales(order_date_key);

CREATE NONCLUSTERED INDEX ix_fact_sales_customer ON fact_sales(customer_key);

CREATE NONCLUSTERED INDEX ix_fact_sales_product ON fact_sales(product_key);

-- 实施分区

ALTER TABLE fact_sales

ADD CONSTRAINT ck_fact_sales_date CHECK (order_date_key >= 20230101 AND order_date_key < 20240101);

-- 创建分区函数和方案

CREATE PARTITION FUNCTION pf_sales_date (INT)

AS RANGE RIGHT FOR VALUES (20230401, 20230701, 20231001);

CREATE PARTITION SCHEME ps_sales_date

AS PARTITION pf_sales_date

TO (fg_q1, fg_q2, fg_q3, fg_q4);

-- 使用分区方案创建表

CREATE TABLE fact_sales_2023 (

-- 列定义与fact_sales相同

)

ON ps_sales_date(order_date_key);

2. ETL作业开发

使用SQL Server Integration Services (SSIS)开发ETL包:

public void Main()

{

// 创建连接管理器

ConnectionManager sourceConn = Dts.Connections.Add("OLEDB");

sourceConn.ConnectionString = "Data Source=SourceServer;Initial Catalog=SourceDB;Integrated Security=SSPI;";

ConnectionManager destConn = Dts.Connections.Add("OLEDB");

destConn.ConnectionString = "Data Source=DestServer;Initial Catalog=DataWarehouse;Integrated Security=SSPI;";

// 创建数据流任务

TaskHost dataFlowTask = Dts.Tasks.Add("SSIS.Pipeline");

dataFlowTask.Name = "Load Customer Dimension";

// 配置源组件

IDTSComponentMetaData100 sourceComponent = dataFlowTask.ComponentMetaDataCollection.New();

sourceComponent.ComponentClassID = "DTSAdapter.OleDbSource";

sourceComponent.Name = "Source - Customer";

// 设置源查询

sourceComponent.SetComponentProperty("SqlCommand", "SELECT * FROM Customers");

sourceComponent.RuntimeConnectionCollection[0].ConnectionManagerID = sourceConn.ID;

// 配置目标组件

IDTSComponentMetaData100 destComponent = dataFlowTask.ComponentMetaDataCollection.New();

destComponent.ComponentClassID = "DTSAdapter.OleDbDestination";

destComponent.Name = "Destination - Dim Customer";

destComponent.SetComponentProperty("TableOrViewName", "[dbo].[dim_customer]");

destComponent.RuntimeConnectionCollection[0].ConnectionManagerID = destConn.ID;

// 连接源和目标

dataFlowTask.PathCollection.New().AttachPathAndPropagateNotifications(sourceComponent.OutputCollection[0], destComponent.InputCollection[0]);

Dts.TaskHost.Execute();

}

3. 调度作业配置

使用SQL Server Agent创建作业和调度:

使用SQL Server Agent创建作业和调度:

```sql

-- 创建作业

EXEC msdb.dbo.sp_add_job

@job_name = N'Daily_ETL_Job',

@enabled = 1,

@description = N'Daily ETL process for data warehouse';

-- 添加作业步骤

EXEC msdb.dbo.sp_add_jobstep

@job_name = N'Daily_ETL_Job',

@step_name = N'Load Dimensions',

@subsystem = N'SSIS',

@command = N'/FILE "C:\ETL\LoadDimensions.dtsx"',

@retry_attempts = 3,

@retry_interval = 5;

EXEC msdb.dbo.sp_add_jobstep

@job_name = N'Daily_ETL_Job',

@step_name = N'Load Facts',

@subsystem = N'SSIS',

@command = N'/FILE "C:\ETL\LoadFacts.dtsx"',

@retry_attempts = 3,

@retry_interval = 5;

-- 创建调度

EXEC msdb.dbo.sp_add_schedule

@schedule_name = N'Daily at 2 AM',

@freq_type = 4,

@freq_interval = 1,

@active_start_time = 020000;

-- 将调度附加到作业

EXEC msdb.dbo.sp_attach_schedule

@job_name = N'Daily_ETL_Job',

@schedule_name = N'Daily at 2 AM';

4. 安全性实施

设置用户、角色和权限:

-- 创建登录

CREATE LOGIN [ETL_User] WITH PASSWORD = 'ComplexPassword123!';

-- 创建数据库用户

USE DataWarehouse;

CREATE USER [ETL_User] FOR LOGIN [ETL_User];

-- 创建角色

CREATE ROLE ETL_Role;

-- 将用户添加到角色

ALTER ROLE ETL_Role ADD MEMBER [ETL_User];

-- 授予权限

GRANT SELECT, INSERT, UPDATE, DELETE ON SCHEMA::dbo TO ETL_Role;

GRANT EXECUTE ON SCHEMA::dbo TO ETL_Role;

-- 对敏感列实施行级安全性

CREATE FUNCTION dbo.fn_securitypredicate(@SalesRepID AS int)

RETURNS TABLE

WITH SCHEMABINDING

AS

RETURN SELECT 1 AS fn_securitypredicate_result

WHERE @SalesRepID = CONVERT(int, CURRENT_USER) OR CURRENT_USER = 'dbo';

CREATE SECURITY POLICY SalesDataFilter

ADD FILTER PREDICATE dbo.fn_securitypredicate(SalesRepID)

ON dbo.FactSales;

5. 监控和日志机制搭建

实现自定义日志表和存储过程:

-- 创建日志表

CREATE TABLE dbo.ETL_Log (

LogID INT IDENTITY(1,1) PRIMARY KEY,

ProcessName VARCHAR(100),

StartTime DATETIME,

EndTime DATETIME,

Status VARCHAR(20),

RowsProcessed INT,

ErrorMessage VARCHAR(MAX)

);

-- 创建日志记录存储过程

CREATE PROCEDURE dbo.sp_LogETLProcess

@ProcessName VARCHAR(100),

@Status VARCHAR(20),

@RowsProcessed INT = NULL,

@ErrorMessage VARCHAR(MAX) = NULL

AS

BEGIN

IF @Status = 'Start'

BEGIN

INSERT INTO dbo.ETL_Log (ProcessName, StartTime, Status)

VALUES (@ProcessName, GETDATE(), @Status);

END

ELSE

BEGIN

UPDATE dbo.ETL_Log

SET EndTime = GETDATE(),

Status = @Status,

RowsProcessed = @RowsProcessed,

ErrorMessage = @ErrorMessage

WHERE ProcessName = @ProcessName

AND EndTime IS NULL;

END

END;

-- 在ETL过程中使用日志记录

EXEC dbo.sp_LogETLProcess @ProcessName = 'Load Dim_Customer', @Status = 'Start';

-- ETL逻辑

EXEC dbo.sp_LogETLProcess @ProcessName = 'Load Dim_Customer', @Status = 'Complete', @RowsProcessed = 1000;

测试

全面的测试是确保数据仓库质量的关键。测试应该涵盖以下几个方面:

-

单元测试:

- 测试各个ETL组件

- 验证转换逻辑

- 检查错误处理

-

集成测试:

- 测试端到端的ETL流程

- 验证数据在各个阶段的一致性

-

系统测试:

- 测试整个数据仓库系统

- 验证所有组件的协同工作

-

性能测试:

- 测试大数据量下的ETL性能

- 验证查询响应时间

- 测试并发用户场景

-

用户验收测试(UAT):

- 业务用户验证数据的准确性和完整性

- 测试报表和分析功能

让我们看一些具体的测试示例:

单元测试

使用tSQLt框架进行单元测试:

CREATE PROCEDURE testCustomerDimension.[test that new customers are correctly inserted]

AS

BEGIN

-- Arrange

EXEC tSQLt.FakeTable 'dbo.dim_customer';

INSERT INTO dbo.stg_customer (customer_id, customer_name, email)

VALUES (1, 'John Doe', 'john@example.com');

-- Act

EXEC dbo.sp_load_dim_customer;

-- Assert

SELECT customer_id, customer_name, email

INTO #Expected

FROM (VALUES (1, 'John Doe', 'john@example.com')) AS x(customer_id, customer_name, email);

EXEC tSQLt.AssertEqualsTable '#Expected', 'dbo.dim_customer';

END;

集成测试

测试端到端的ETL流程:

import pyodbc

import pandas as pd

from datetime import datetime, timedelta

def test_etl_end_to_end():

# 连接到源数据库和数据仓库

source_conn = pyodbc.connect('DRIVER={SQL Server};SERVER=source_server;DATABASE=source_db;UID=user;PWD=password')

dw_conn = pyodbc.connect('DRIVER={SQL Server};SERVER=dw_server;DATABASE=data_warehouse;UID=user;PWD=password')

# 获取源数据

source_data = pd.read_sql("SELECT * FROM orders WHERE order_date >= DATEADD(day, -1, GETDATE())", source_conn)

# 运行ETL作业

etl_job = subprocess.Popen(["dtexec", "/File", "C:\ETL\DailyETL.dtsx"])

etl_job.wait()

# 验证数据仓库中的数据

dw_data = pd.read_sql("SELECT * FROM fact_sales WHERE order_date >= DATEADD(day, -1, GETDATE())", dw_conn)

# 比较源数据和数据仓库数据

assert len(source_data) == len(dw_data), "Row count mismatch"

assert source_data['total_amount'].sum() == dw_data['sales_amount'].sum(), "Total sales amount mismatch"

print("End-to-end ETL test passed successfully")

if __name__ == "__main__":

test_etl_end_to_end()

性能测试

使用SQL Server Distributed Replay进行性能测试:

- 捕获工作负载:

ostress -S YourServerName -d YourDatabaseName -Q "SELECT * FROM fact_sales WHERE order_date BETWEEN '2023-01-01' AND '2023-12-31'" -n10 -r5 -o C:\PerformanceTest\Workload

- 预处理捕获的跟踪:

preprocess /i:C:\PerformanceTest\Workload.trc /o:C:\PerformanceTest\Workload_Preprocessed

- 重放工作负载:

dreplay start /controller:YourControllerName /input:C:\PerformanceTest\Workload_Preprocessed

- 分析结果:

使用SQL Server Profiler或者Extended Events来捕获重放期间的性能数据,然后使用以下查询分析结果:

SELECT

CAST(qst.total_elapsed_time / 1000000.0 AS DECIMAL(28, 2)) AS [Average CPU Time (s)],

CAST(qst.total_elapsed_time * 1.0 / qst.execution_count / 1000000.0 AS DECIMAL(28, 2)) AS [Average Elapsed Time (s)],

qst.execution_count,

SUBSTRING(CAST(qp.query_plan AS NVARCHAR(MAX)), 1, 2000) AS query_plan_snippet

FROM

sys.dm_exec_query_stats AS qst

CROSS APPLY

sys.dm_exec_sql_text(qst.sql_handle) AS qst2

CROSS APPLY

sys.dm_exec_query_plan(qst.plan_handle) AS qp

WHERE

qst2.text LIKE '%fact_sales%'

ORDER BY

qst.total_elapsed_time DESC;

模型实现与测试的最佳实践:

-

版本控制: 使用Git等版本控制系统管理所有脚本和配置文件。

-

自动化: 尽可能自动化部署和测试过程,使用CI/CD工具如Jenkins或Azure DevOps。

-

环境管理: 维护开发、测试和生产环境的一致性,使用基础设施即代码(IaC)工具如Terraform。

-

代码审查: 实施严格的代码审查流程,确保代码质量和最佳实践的遵循。

-

文档化: 详细记录模型实现的每个方面,包括设计决策、配置细节和操作手册。

-

性能基准: 建立性能基准,并在每次重大变更后进行性能测试。

-

安全第一: 在开发和测试阶段就考虑安全性,不要将其作为事后考虑。

-

数据质量门槛: 在ETL过程中实施数据质量检查,确保只有高质量的数据才能进入数据仓库。

-

监控和告警: 实施全面的监控和告警机制,及时发现和解决问题。

-

用户培训: 为最终用户提供培训,确保他们能够有效地使用数据仓库。

模型实现与测试是将数据仓库设计转化为实际可用系统的关键阶段。通过仔细的规划、严格的测试和持续的优化,我们可以构建一个高质量、高性能、可靠的数据仓库系统,为业务决策提供强有力的支持。

步骤七:性能优化

在数据仓库建模的最后阶段,性能优化扮演着至关重要的角色。它确保数据仓库能够有效地处理大量数据,并在合理的时间内响应复杂的查询。让我们深入探讨性能优化的各个方面:

1. 查询优化

查询优化是提升数据仓库性能的核心。它涉及以下几个方面:

a. 索引策略

- 创建适当的索引以加速查询

- 平衡索引数量与维护开销

示例:为常用查询条件创建索引

-- 为日期和产品列创建复合索引

CREATE NONCLUSTERED INDEX IX_FactSales_Date_Product

ON FactSales (OrderDateKey, ProductKey)

INCLUDE (SalesAmount);

-- 为低基数列创建过滤索引

CREATE NONCLUSTERED INDEX IX_FactSales_HighValueSales

ON FactSales (CustomerKey, SalesAmount)

WHERE SalesAmount > 10000;

b. 统计信息更新

- 定期更新统计信息以确保查询优化器做出正确的决策

示例:更新统计信息的存储过程

CREATE PROCEDURE dbo.sp_UpdateStatistics

AS

BEGIN

DECLARE @TableName NVARCHAR(128)

DECLARE @sql NVARCHAR(500)

DECLARE tableCursor CURSOR FOR

SELECT table_name

FROM information_schema.tables

WHERE table_type = 'BASE TABLE'

OPEN tableCursor

FETCH NEXT FROM tableCursor INTO @TableName

WHILE @@FETCH_STATUS = 0

BEGIN

SET @sql = 'UPDATE STATISTICS ' + @TableName + ' WITH FULLSCAN'

EXEC sp_executesql @sql

FETCH NEXT FROM tableCursor INTO @TableName

END

CLOSE tableCursor

DEALLOCATE tableCursor

END

c. 查询重写

- 重写复杂查询以提高效率

- 使用子查询、公共表表达式(CTE)等技术优化查询结构

示例:使用CTE优化复杂查询

-- 优化前

SELECT c.CustomerName, p.ProductName, SUM(f.SalesAmount) as TotalSales

FROM FactSales f

JOIN DimCustomer c ON f.CustomerKey = c.CustomerKey

JOIN DimProduct p ON f.ProductKey = p.ProductKey

WHERE f.OrderDateKey BETWEEN 20230101 AND 20231231

GROUP BY c.CustomerName, p.ProductName

HAVING SUM(f.SalesAmount) >

(SELECT AVG(SalesAmount) FROM FactSales

WHERE OrderDateKey BETWEEN 20230101 AND 20231231);

-- 优化后

WITH SalesData AS (

SELECT CustomerKey, ProductKey, SUM(SalesAmount) as TotalSales

FROM FactSales

WHERE OrderDateKey BETWEEN 20230101-- 优化后

WITH SalesData AS (

SELECT CustomerKey, ProductKey, SUM(SalesAmount) as TotalSales

FROM FactSales

WHERE OrderDateKey BETWEEN 20230101 AND 20231231

GROUP BY CustomerKey, ProductKey

),

AvgSales AS (

SELECT AVG(TotalSales) as AvgSalesAmount

FROM SalesData

)

SELECT c.CustomerName, p.ProductName, sd.TotalSales

FROM SalesData sd

JOIN DimCustomer c ON sd.CustomerKey = c.CustomerKey

JOIN DimProduct p ON sd.ProductKey = p.ProductKey

CROSS JOIN AvgSales

WHERE sd.TotalSales > AvgSales.AvgSalesAmount;

2. 分区策略

分区可以显著提高大表的查询性能和管理效率。

a. 范围分区

- 基于日期或数值范围进行分区

示例:按年份分区销售事实表

-- 创建分区函数

CREATE PARTITION FUNCTION pf_SalesByYear (INT)

AS RANGE RIGHT FOR VALUES (20210101, 20220101, 20230101);

-- 创建分区方案

CREATE PARTITION SCHEME ps_SalesByYear

AS PARTITION pf_SalesByYear

TO (fg_sales_2020, fg_sales_2021, fg_sales_2022, fg_sales_2023);

-- 创建分区表

CREATE TABLE FactSales (

SalesKey BIGINT IDENTITY(1,1),

OrderDateKey INT,

CustomerKey INT,

ProductKey INT,

SalesAmount DECIMAL(18,2),

-- 其他列...

CONSTRAINT PK_FactSales PRIMARY KEY NONCLUSTERED (SalesKey, OrderDateKey)

)

ON ps_SalesByYear(OrderDateKey);

b. 列存储索引

- 对于大量读取操作的表,使用列存储索引可以显著提高性能

示例:为事实表创建列存储索引

CREATE CLUSTERED COLUMNSTORE INDEX CCI_FactSales

ON FactSales;

3. 物化视图

物化视图(在SQL Server中称为索引视图)可以预先计算和存储常用的聚合结果,从而加速查询。

示例:创建索引视图

CREATE VIEW vw_MonthlySalesSummary

WITH SCHEMABINDING

AS

SELECT

d.CalendarYear,

d.CalendarMonth,

p.ProductCategory,

SUM(f.SalesAmount) AS TotalSales,

COUNT_BIG(*) AS SalesCount

FROM

dbo.FactSales f

JOIN dbo.DimDate d ON f.OrderDateKey = d.DateKey

JOIN dbo.DimProduct p ON f.ProductKey = p.ProductKey

GROUP BY

d.CalendarYear,

d.CalendarMonth,

p.ProductCategory;

CREATE UNIQUE CLUSTERED INDEX IX_vw_MonthlySalesSummary

ON vw_MonthlySalesSummary (CalendarYear, CalendarMonth, ProductCategory);

4. 内存优化

利用内存优化技术可以显著提高数据访问速度。

a. 内存优化表

- 将热点数据存储在内存中

示例:创建内存优化表(SQL Server)

CREATE TABLE dbo.HotProducts

(

ProductKey INT NOT NULL PRIMARY KEY NONCLUSTERED,

ProductName NVARCHAR(100) NOT NULL,

UnitPrice MONEY NOT NULL

)

WITH (MEMORY_OPTIMIZED = ON, DURABILITY = SCHEMA_AND_DATA);

b. 缓存层

- 实现应用层缓存,减少对数据库的直接访问

示例:使用Redis作为缓存层(C#)

using StackExchange.Redis;

public class ProductCache

{

private static ConnectionMultiplexer redis = ConnectionMultiplexer.Connect("localhost");

public static async Task<string> GetProductNameAsync(int productKey)

{

var db = redis.GetDatabase();

string cacheKey = $"product:{productKey}:name";

string cachedName = await db.StringGetAsync(cacheKey);

if (!string.IsNullOrEmpty(cachedName))

{

return cachedName;

}

// 如果缓存中没有,从数据库获取

string productName = await GetProductNameFromDbAsync(productKey);

// 将结果存入缓存,设置过期时间为1小时

await db.StringSetAsync(cacheKey, productName, TimeSpan.FromHours(1));

return productName;

}

private static async Task<string> GetProductNameFromDbAsync(int productKey)

{

// 实现从数据库获取产品名称的逻辑

}

}

5. 并行处理

利用并行处理可以显著提高大规模数据处理的效率。

a. 并行查询

- 启用数据库的并行查询功能

示例:在SQL Server中启用并行查询

-- 设置最大并行度

EXEC sp_configure 'max degree of parallelism', 8;

RECONFIGURE WITH OVERRIDE;

-- 在查询中指定并行度

SELECT /*+ MAXDOP(4) */ *

FROM FactSales

WHERE SalesAmount > 10000;

b. 分布式处理

- 使用分布式计算框架处理大规模数据

示例:使用Apache Spark处理大规模数据(Scala)

import org.apache.spark.sql.SparkSession

val spark = SparkSession.builder()

.appName("Sales Analysis")

.config("spark.some.config.option", "some-value")

.getOrCreate()

val salesDF = spark.read

.format("jdbc")

.option("url", "jdbc:sqlserver://server:1433;databaseName=DW")

.option("dbtable", "FactSales")

.option("user", "username")

.option("password", "password")

.load()

val result = salesDF

.groupBy("ProductKey")

.sum("SalesAmount")

.orderBy(desc("sum(SalesAmount)"))

.limit(10)

result.show()

6. 硬件优化

选择合适的硬件配置可以从根本上提升数据仓库的性能。

a. SSD存储

- 使用SSD存储关键表和索引,提高I/O性能

b. 增加内存

- 增加服务器内存,允许更多数据缓存在内存中

c. 多核CPU

- 使用多核CPU以支持并行查询和处理

7. 监控和调优

持续监控和调优是保持数据仓库高性能的关键。

a. 性能监控

- 使用数据库内置的性能监控工具

示例:使用SQL Server Dynamic Management Views (DMVs)监控性能

-- 查找最耗资源的查询

SELECT TOP 10

qs.total_elapsed_time / qs.execution_count AS avg_elapsed_time,

qs.total_elapsed_time,

qs.execution_count,

SUBSTRING(qt.text, qs.statement_start_offset/2 + 1,

(CASE WHEN qs.statement_end_offset = -1

THEN LEN(CONVERT(NVARCHAR(MAX), qt.text)) * 2

ELSE qs.statement_end_offset END - qs.statement_start_offset)/2

) AS query_text

FROM

sys.dm_exec_query_stats qs

CROSS APPLY

sys.dm_exec_sql_text(qs.sql_handle) qt

ORDER BY

avg_elapsed_time DESC;

b. 查询计划分析

- 分析和优化关键查询的执行计划

示例:使用SQL Server的查询存储来分析查询计划

-- 启用查询存储

ALTER DATABASE YourDatabaseName

SET QUERY_STORE = ON;

-- 分析查询性能回归

SELECT

qsq.query_id,

qsp.plan_id,

qsp.compatibility_level,

qsrs.avg_duration,

qsrs.avg_logical_io_reads,

qsrs.count_executions,

qst.query_sql_text

FROM

sys.query_store_query qsq

JOIN

sys.query_store_plan qsp ON qsq.query_id = qsp.query_id

JOIN

sys.query_store_runtime_stats qsrs ON qsp.plan_id = qsrs.plan_id

JOIN

sys.query_store_query_text qst ON qsq.query_text_id = qst.query_text_id

WHERE

qsq.query_id IN (

SELECT TOP 10 query_id

FROM sys.query_store_runtime_stats

GROUP BY query_id

ORDER BY AVG(avg_duration) DESC

);

性能优化的最佳实践:

-

循序渐进: 从最简单、影响最大的优化开始,逐步进行更复杂的优化。

-

基准测试: 在进行任何优化之前,先建立性能基准,以便评估优化效果。

-

全面考虑: 优化时要考虑查询性能、数据加载性能和存储效率的平衡。

-

持续监控: 实施持续的性能监控,及时发现和解决问题。

-

定期维护: 定期进行统计信息更新、索引重建等维护工作。

-

版本控制: 对优化脚本进行版本控制,以便在需要时回滚更改。

-

文档化: 详细记录每次优化的原因、方法和结果,为未来的优化提供参考。

-

用户反馈: 收集并重视最终用户的反馈,他们是性能问题的直接感受者。

-

负载测试: 在生产环境的镜像上进行全面的负载测试,模拟真实的使用场景。

-

新技术评估: 持续关注和评估新的数据库技术和优化方法。

性能优化是一个持续的过程,需要数据库管理员、开发人员和业务用户的共同努力。通过系统的方法和持续的改进,我们可以构建一个高性能、可扩展的数据仓库系统,为业务决策提供强有力的支持。

步骤八:文档编写与维护

文档编写和维护是数据仓库项目中常被忽视但极其重要的一环。完善的文档不仅能帮助团队成员理解系统架构和设计决策,还能为未来的维护和升级提供重要参考。让我们详细探讨数据仓库文档编写的各个方面:

1. 系统架构文档

系统架构文档应该提供数据仓库的整体视图,包括:

- 系统组件概览

- 数据流图

- 技术栈选择及理由

- 系统边界和接口定义

示例:使用Markdown格式的系统架构文档片段

# 数据仓库系统架构

## 1. 系统概览

我们的数据仓库系统采用了三层架构:

1. 数据源层: 包括各业务系统的数据库和外部数据源

2. ETL层: 使用SQL Server Integration Services (SSIS)进行数据抽取、转换和加载

3. 数据仓库层: 基于SQL Server 2019实现,包括ODS、DW和数据集市

## 2. 数据流图

[插入数据流图]

## 3. 技术栈选择

- 数据库: SQL Server 2019 Enterprise Edition

- 理由: 强大的列存储索引功能,与现有Microsoft技术栈集成度高

- ETL工具: SQL Server Integration Services (SSIS)

- 理由: 与SQL Server无缝集成,团队已有相关经验

- 报表工具: Power BI

- 理由: 用户友好的界面,强大的数据可视化能力

## 4. 系统接口

### 4.1 数据输入接口

- 销售系统: 每日增量导入

- 库存系统: 每小时全量同步

- 客户CRM: 实时API调用

### 4.2 数据输出接口

- REST API: 为移动应用提供实时数据访问

- ODBC连接: 为传统报表工具提供数据访问

2. 数据模型文档

数据模型文档应详细描述数据仓库的逻辑和物理模型,包括:

- 维度模型图

- 表结构定义

- 字段说明

- 关系和约束

示例:使用Markdown格式的数据模型文档片段

# 数据模型文档

## 1. 维度模型概览

[插入星型模式图]

## 2. 事实表

### 2.1 销售事实表 (FactSales)

| 列名 | 数据类型 | 描述 | 外键 |

|------|----------|------|------|

| SalesKey | BIGINT | 主键 | |

| OrderDateKey | INT | 订单日期 | DimDate(DateKey) |

| CustomerKey | INT | 客户 | DimCustomer(CustomerKey) |

| ProductKey | INT | 产品 | DimProduct(ProductKey) |

| SalesAmount | DECIMAL(18,2) | 销售金额 | |

| Quantity | INT | 销售数量 | |

## 3. 维度表

### 3.1 客户维度 (DimCustomer)

| 列名 | 数据类型 | 描述 | 备注 |

|------|----------|### 3.1 客户维度 (DimCustomer)

| 列名 | 数据类型 | 描述 | 备注 |

|------|----------|------|------|

| CustomerKey | INT | 主键 | 代理键 |

| CustomerID | VARCHAR(20) | 客户ID | 业务键 |

| CustomerName | VARCHAR(100) | 客户名称 | |

| CustomerType | VARCHAR(20) | 客户类型 | 个人/企业 |

| Email | VARCHAR(100) | 电子邮件 | |

| Phone | VARCHAR(20) | 联系电话 | |

| Address | VARCHAR(200) | 地址 | |

| City | VARCHAR(50) | 城市 | |

| Country | VARCHAR(50) | 国家 | |

| EffectiveDate | DATE | 生效日期 | SCD Type 2 |

| EndDate | DATE | 失效日期 | SCD Type 2 |

## 4. 关系和约束

- FactSales.OrderDateKey -> DimDate.DateKey (外键约束)

- FactSales.CustomerKey -> DimCustomer.CustomerKey (外键约束)

- FactSales.ProductKey -> DimProduct.ProductKey (外键约束)

## 5. 索引策略

### 5.1 FactSales表索引

1. 聚集索引: (OrderDateKey, ProductKey)

- 理由: 支持按日期和产品的常见查询模式

2. 非聚集索引: (CustomerKey) INCLUDE (SalesAmount)

- 理由: 支持按客户的销售额统计查询

### 5.2 DimCustomer表索引

1. 聚集索引: CustomerKey (主键)

2. 非聚集索引: CustomerID (业务键)

- 理由: 支持通过业务键快速查找客户信息

## 6. 分区策略

FactSales表按OrderDateKey列进行范围分区,每年一个分区。

- 分区函数:

```sql

CREATE PARTITION FUNCTION PF_Sales_Yearly (INT)

AS RANGE RIGHT FOR VALUES (20220101, 20230101, 20240101);

- 分区方案:

CREATE PARTITION SCHEME PS_Sales_Yearly AS PARTITION PF_Sales_Yearly TO (FG_Sales_2021, FG_Sales_2022, FG_Sales_2023, FG_Sales_2024);

理由: 通过分区提高查询性能和数据管理效率,特别是对于按时间范围的查询和历史数据归档。

3. ETL流程文档

ETL流程文档应详细描述数据从源系统到数据仓库的流转过程,包括:

- ETL作业概览

- 数据源到目标的映射

- 转换逻辑说明

- 调度计划

- 错误处理机制

示例:使用Markdown格式的ETL流程文档片段

# ETL流程文档

## 1. ETL作业概览

| 作业名称 | 描述 | 频率 | 依赖作业 |

|----------|------|------|----------|

| Load_DimCustomer | 加载客户维度 | 每日 | - |

| Load_DimProduct | 加载产品维度 | 每日 | - |

| Load_FactSales | 加载销售事实表 | 每日 | Load_DimCustomer, Load_DimProduct |

## 2. 数据源到目标的映射

### 2.1 客户维度 (DimCustomer)

| 源表 | 源列 | 目标表 | 目标列 | 转换逻辑 |

|------|------|--------|--------|----------|

| CRM.Customers | CustomerID | DimCustomer | CustomerID | 直接映射 |

| CRM.Customers | FirstName + ' ' + LastName | DimCustomer | CustomerName | 字符串连接 |

| CRM.Customers | CustomerType | DimCustomer | CustomerType | CASE语句映射 |

## 3. 转换逻辑说明

### 3.1 客户类型映射

```sql

CASE

WHEN CustomerType = 'I' THEN 'Individual'

WHEN CustomerType = 'C' THEN 'Corporate'

ELSE 'Unknown'

END AS CustomerType

## 4. 调度计划

| 作业名称 | 开始时间 | 预计持续时间 | 超时处理 |

|----------|----------|--------------|----------|

| Load_DimCustomer | 01:00 AM | 30分钟 | 2小时后自动终止 |

| Load_DimProduct | 01:30 AM | 20分钟 | 1小时后自动终止 |

| Load_FactSales | 02:00 AM | 2小时 | 6小时后自动终止 |

## 5. 错误处理机制

1. 日志记录: 所有ETL作业的执行状态和错误信息记录到`ETL_Log`表

2. 告警机制: 作业失败时通过邮件通知DBA团队

3. 重试策略: 失败作业自动重试3次,每次间隔10分钟

4. 数据一致性检查: 每个作业结束后进行行数平衡检查

4. 数据质量文档

数据质量文档应描述确保数据仓库数据质量的措施,包括:

- 数据质量规则

- 数据清洗流程

- 数据验证检查点

- 数据质量监控指标

示例:使用Markdown格式的数据质量文档片段

# 数据质量文档

## 1. 数据质量规则

### 1.1 通用规则

- 所有维度表必须有有效的代理键

- 所有外键必须有对应的维度记录

- 数值字段不允许为负(除特殊情况,如退款金额)

### 1.2 特定规则

#### 客户维度 (DimCustomer)

- Email地址必须符合有效格式

- 电话号码必须为10位数字(美国)

#### 销售事实表 (FactSales)

- SalesAmount必须等于UnitPrice * Quantity - DiscountAmount

- OrderDate不能晚于当前日期

## 2. 数据清洗流程

1. 空值处理:

- 对于必填字段,拒绝空值记录

- 对于可选字段,用预定义的默认值替代空值

2. 格式标准化:

- 客户名称转换为大写

- 日期统一转换为YYYY-MM-DD格式

3. 重复数据处理:

- 基于业务键(如OrderID)检测并删除重复记录

## 3. 数据验证检查点

| 检查点 | 描述 | 频率 | 阈值 |

|--------|------|------|------|

| CP001 | FactSales中孤立的外键检查 | 每日 | 0条 |

| CP002 | DimCustomer中无效Email地址检查 | 每周 | <1% |

| CP003 | FactSales中SalesAmount计算错误检查 | 每日 | 0条 |

## 4. 数据质量监控指标

1. 数据完整性: (有效记录数 / 总记录数) * 100%

2. 数据准确性: (正确值记录数 / 总记录数) * 100%

3. 数据一致性: (主数据源与数据仓库匹配记录数 / 总记录数) * 100%

4. 数据及时性: 数据可用时间 - 数据生成时间

## 5. 数据质量报告

每周生成数据质量报告,包括:

- 各检查点的通过率

- 数据质量指标趋势图

- 主要数据质量问题及解决计划

5. 用户指南

用户指南应该帮助最终用户理解和使用数据仓库,包括:

- 数据字典

- 常见查询示例

- 报表使用指南

- 数据解释说明

示例:使用Markdown格式的用户指南片段

# 数据仓库用户指南

## 1. 数据字典

### 1.1 销售分析

| 指标名称 | 描述 | 计算公式 | 使用注意事项 |

|----------|------|----------|--------------|

| 销售额 | 商品的销售总金额 | SUM(SalesAmount) | 包含税费和运费 |

| 销售数量 | 销售的商品数量 | SUM(Quantity) | - |

| 平均单价 | 商品的平均售价 | SUM(SalesAmount) / SUM(Quantity) | 不考虑折扣影响 |

| 毛利率 | 销售毛利占销售额的比例 | (SUM(SalesAmount) - SUM(CostAmount)) / SUM(SalesAmount) | 不考虑运营成本 |

## 2. 常见查询示例

### 2.1 按产品类别的月度销售趋势

```sql

SELECT

d.CalendarYear,

d.CalendarMonth,

p.ProductCategory,

SUM(f.SalesAmount) AS TotalSales

FROM

FactSales f

JOIN DimDate d ON f.OrderDateKey = d.DateKey

JOIN DimProduct p ON f.ProductKey = p.ProductKey

GROUP BY

d.CalendarYear,

d.CalendarMonth,

p.ProductCategory

ORDER BY

d.CalendarYear,

d.CalendarMonth,

p.ProductCategory;

## 3. 报表使用指南

### 3.1 销售仪表板

1. 访问Power BI报表服务器: https://powerbi.yourcompany.com

2. 导航到"销售分析"文件夹

3. 打开"销售仪表板"报表

4. 使用顶部的过滤器选择日期范围和产品类别

5. 仪表板包括以下视图:

- 销售趋势图

- 产品类别销售占比

- 销售额对比

## 4. 数据解释说明

### 4.1 销售额计算

- 销售额包含商品销售价格、税费和运费

- 退货会导致负的销售额

- 促销折扣直接反映在销售额中

- 不同货币的销售额已统一转换为美元

### 4.2 客户分类

- 新客户: 首次购买的客户

- 活跃客户: 过去12个月内有购买记录的客户

- 流失客户: 超过12个月没有购买记录的客户

注意: 客户状态每日更新,分析时请注意时间点的选择。

6. 运维手册

运维手册应该为DBA和系统管理员提供管理和维护数据仓库的指导,包括:

- 日常维护任务

- 备份和恢复程序

- 性能监控和调优指南

- 故障排除流程

示例:使用Markdown格式的运维手册片段

# 数据仓库运维手册

## 1. 日常维护任务

| 任务 | 频率 | 描述 | 执行命令/脚本 |

|------|------|------|---------------|

| 统计信息更新 | 每日 | 更新表的统计信息以优化查询性能 | EXEC sp_updatestats; |

| 检查作业运行状态 | 每日 | 检查SQL Agent作业的执行状况 | EXEC msdb.dbo.sp_help_job; |

| 清理日志文件 | 每周 | 删除过期的日志文件 | EXEC sp_cycle_errorlog; |

## 2. 备份和恢复程序

### 2.1 备份策略

- 全量备份: 每日凌晨2:00

- 差异备份: 每6小时一次

- 事务日志备份: 每15分钟一次

### 2.2 备份脚本

```sql

-- 全量备份

BACKUP DATABASE [DataWarehouse] TO DISK = N'D:\Backup\DataWarehouse_Full.bak'

WITH COMPRESSION, CHECKSUM, STATS = 10

-- 差异备份

BACKUP DATABASE [DataWarehouse] TO DISK = N'D:\Backup\DataWarehouse_Diff.bak'

WITH DIFFERENTIAL, COMPRESSION, CHECKSUM, STATS = 10

-- 日志备份

BACKUP LOG [DataWarehouse] TO DISK = N'D:\Backup\DataWarehouse_Log.trn'

WITH COMPRESSION, CHECKSUM, STATS = 10

### 2.3 恢复程序

1. 停止所有连接到数据仓库的应用

2. 还原最新的全量备份

3. 还原最新的差异备份(如果有)

4. 依次还原所有后续的日志备份

5. 将数据库设置为可用状态

6. 验证数据完整性

7. 重新启动应用连接

## 3. 性能监控和调优指南

### 3.1 关键性能指标 (KPIs)

- CPU使用率: 应保持在80%以下

- 内存使用率: 应保持在90%以下

- 磁盘I/O延迟: 应低于20ms

- 长时间运行的查询: 运行时间超过5分钟的查询

###### 3.2 性能监控查询

```sql

-- 检查CPU使用率

SELECT TOP(10)

GETDATE() AS [Collection_Time],

record.value('(./Record/@id)[1]', 'int') AS [Record_ID],

record.value('(./Record/SchedulerMonitorEvent/SystemHealth/ProcessUtilization)[1]', 'int') AS [CPU_Utilization]

FROM (

SELECT [timestamp], CONVERT(xml, record) AS [record]

FROM sys.dm_os_ring_buffers

WHERE ring_buffer_type = N'RING_BUFFER_SCHEDULER_MONITOR'

AND record LIKE '%<SystemHealth>%'

) AS x

ORDER BY [Collection_Time] DESC;

-- 检查内存使用情况

SELECT

(total_physical_memory_kb / 1024) AS Total_Physical_Memory_MB,

(available_physical_memory_kb / 1024) AS Available_Physical_Memory_MB,

(total_page_file_kb / 1024) AS Total_Page_File_MB,

(available_page_file_kb / 1024) AS Available_Page_File_MB,

(system_cache_kb / 1024) AS System_Cache_MB

FROM sys.dm_os_sys_memory;

-- 检查磁盘I/O延迟

SELECT

DB_NAME(fs.database_id) AS [Database Name],

CAST(fs.io_stall_read_ms/(1.0 + fs.num_of_reads) AS NUMERIC(10,1)) AS [Average Read Latency (ms)],

CAST(fs.io_stall_write_ms/(1.0 + fs.num_of_writes) AS NUMERIC(10,1)) AS [Average Write Latency (ms)]

FROM sys.dm_io_virtual_file_stats(NULL, NULL) AS fs

ORDER BY [Average Read Latency (ms)] DESC;

-- 检查长时间运行的查询

SELECT

qs.execution_count,

qs.total_elapsed_time / qs.execution_count AS avg_elapsed_time,

SUBSTRING(qt.text, qs.statement_start_offset/2,

(CASE WHEN qs.statement_end_offset = -1

THEN LEN(CONVERT(NVARCHAR(MAX), qt.text)) * 2

ELSE qs.statement_end_offset END - qs.statement_start_offset)/2

) AS query_text

FROM sys.dm_exec_query_stats qs

CROSS APPLY sys.dm_exec_sql_text(qs.sql_handle) qt

WHERE qs.total_elapsed_time / qs.execution_count > 300000 -- 5分钟

ORDER BY avg_elapsed_time DESC;

### 3.3 性能调优步骤

1. 识别性能问题:使用上述查询定期检查系统性能。

2. 分析问题根因:使用SQL Server Profiler或扩展事件收集详细信息。

3. 制定优化方案:可能包括索引优化、查询重写、资源分配调整等。

4. 实施优化:在测试环境验证后,在生产环境小心实施。

5. 验证效果:比较优化前后的性能指标。

6. 文档记录:记录所做的更改及其影响。

## 4. 故障排除流程

### 4.1 常见问题及解决方案

| 问题 | 可能原因 | 解决方案 |

|------|----------|----------|

| ETL作业失败 | 源数据问题 | 检查源系统日志,与源系统管理员协调 |

| | 网络连接问题 | 检查网络连接,可能需要IT支持 |

| | 磁盘空间不足 | 清理临时文件,考虑扩展存储 |

| 查询性能下降 | 统计信息过时 | 更新统计信息 |

| | 索引碎片 | 重建或重组索引 |

| | 参数嗅探问题 | 使用查询提示或重写查询 |

| 数据不一致 | ETL逻辑错误 | 审查并修正ETL逻辑 |

| | 并发更新冲突 | 实施适当的锁定策略 |

### 4.2 紧急响应流程

1. 问题报告:记录问题描述、影响范围和紧急程度。

2. 初步评估:快速评估问题的严重性和可能原因。

3. 升级决策:根据影响决定是否需要升级到高级支持。

4. 问题隔离:尝试将问题隔离到特定组件或模块。

5. 应用修复:实施临时修复或永久解决方案。

6. 验证解决:确认问题已解决,系统恢复正常。

7. 根本原因分析:深入分析问题根源,防止再次发生。

8. 文档和报告:记录整个过程,更新知识库。

### 4.3 联系信息

| 角色 | 姓名 | 联系方式 |

|------|------|----------|

| 主要DBA | Jane Doe | 电话: 123-456-7890, 邮箱: jane.doe@example.com |

| 备份DBA | John Smith | 电话: 098-765-4321, 邮箱: john.smith@example.com |

| 网络管理员 | Mike Johnson | 电话: 111-222-3333, 邮箱: mike.johnson@example.com |

| 存储管理员 | Sarah Brown | 电话: 444-555-6666, 邮箱: sarah.brown@example.com |

## 5. 变更管理

### 5.1 变更流程

1. 提出变更请求:描述变更内容、原因和预期效果。

2. 影响评估:评估变更对系统和用户的潜在影响。

3. 审批:根据变更的规模和影响获得相应级别的审批。

4. 制定计划:详细规划变更步骤,包括回滚方案。

5. 测试:在非生产环境中全面测试变更。

6. 实施:在维护窗口期间实施变更。

7. 验证:确认变更成功,系统功能正常。

8. 文档更新:更新相关文档以反映变更。

### 5.2 版本控制

- 使用Git管理所有数据库脚本和配置文件。

- 对每个重大变更创建新的版本标签。

- 保持清晰的提交信息,描述每次变更的内容和原因。

## 6. 容量规划

### 6.1 监控指标

- 数据增长率:每月数据量增长百分比

- 存储使用率:已用存储空间占总存储空间的百分比

- 查询复杂度:平均查询执行时间的变化趋势

- 并发用户数:高峰时段的活跃用户数

### 6.2 容量评估流程

1. 收集历史数据:分析过去12个月的数据增长和性能趋势。

2. 预测未来需求:基于历史数据和业务计划预测未来6-12个月的需求。

3. 识别瓶颈:确定可能的性能瓶颈(CPU、内存、存储、网络)。

4. 制定扩展计划:根据预测制定硬件升级或架构调整计划。

5. 成本分析:评估扩展计划的成本和收益。

6. 审批和实施:获得管理层审批后实施扩展计划。

### 6.3 扩展策略

- 垂直扩展:升级现有服务器的CPU、内存或存储。

- 水平扩展:添加更多服务器,实现负载均衡。

- 数据归档:将历史数据移至归档存储,减轻主系统负担。

- 查询优化:优化慢查询,提高系统整体性能。

## 7. 安全管理

### 7.1 访问控制

- 实施最小权限原则

- 定期审查用户权限

- 使用角色基础访问控制(RBAC)

### 7.2 数据加密

- 使用透明数据加密(TDE)保护静态数据

- 配置SSL/TLS确保数据传输安全

### 7.3 审计

- 启用SQL Server Audit,记录关键数据访问和修改操作

- 定期审查审计日志,识别潜在的安全威胁

### 7.4 漏洞管理

- 定期应用数据库和操作系统补丁

- 进行定期的安全扫描,识别潜在漏洞

## 8. 灾难恢复

### 8.1 灾难恢复计划

1. 风险评估:识别潜在的灾难场景

2. 业务影响分析:确定关键业务流程和可接受的停机时间

3. 恢复策略:制定详细的恢复步骤

4. 角色和责任:明确每个团队成员在灾难恢复过程中的职责

5. 通信计划:建立在灾难期间与利益相关者沟通的流程

6. 测试和演练:定期测试灾难恢复计划的有效性

### 8.2 备份策略

- 全量备份:每日凌晨2:00

- 差异备份:每6小时一次

- 事务日志备份:每15分钟一次

- 定期验证备份的完整性

- 将备份存储在异地

### 8.3 高可用性配置

- 使用SQL Server Always On可用性组

- 配置同步提交的主备服务器

- 实施自动故障转移

### 8.4 恢复时间目标(RTO)和恢复点目标(RPO)

- RTO: 4小时(从灾难发生到系统恢复运行的时间)

- RPO: 15分钟(可接受的数据丢失量)

通过这份全面的运维手册,数据仓库管理团队可以有效地维护系统,处理日常操作,应对紧急情况,并确保数据仓库的长期健康和性能。定期更新和优化这份手册对于适应不断变化的业务需求和技术环境至关重要。

结论

数据仓库建模是一个复杂而又重要的过程,涉及多个关键步骤:

- 需求分析

- 数据源识别与分析

- 维度建模

- 物理模型设计

- ETL流程设计

- 模型实现与测试

- 性能优化

- 文档编写与维护

每一个步骤都需要仔细规划和执行,以确保最终的数据仓库能够满足业务需求,提供高性能的数据访问和分析能力。在整个过程中,与业务用户的密切合作,对技术细节的深入理解,以及对未来需求的前瞻性考虑都是成功的关键因素。

此外,数据仓库不是一个一次性的项目,而是需要持续维护和优化的系统。随着业务的发展和技术的进步,数据仓库也需要不断演进。定期的性能评估、数据质量审查、用户反馈收集等都是保持数据仓库长期有效性的重要措施。

最后,完善的文档不仅是项目交付的重要组成部分,也是确保数据仓库长期可维护性的关键。无论是技术文档还是用户指南,都应该清晰、详细,并且保持更新。

通过遵循这些步骤和最佳实践,我们可以构建一个强大、灵活、可扩展的数据仓库,为企业的数据驱动决策提供坚实的基础。