- 前言

紧随《AES解密侵犯隐私案件数据》一文的讨论,本文将深入探讨数据解密后的处理工作。解密只是数据恢复的第一步,确保数据的准确性和分析的有效性同样重要。本文将重点介绍数据去重技术,阐述在解密数据后如何细致地进行去重处理,去除冗余信息,以提高分析的精确度和可靠性。这一过程对于深化案件调查和加强法律分析至关重要,同时为类似情况的数据分析提供了重要的参考价值。

文章关键词:电子数据取证、手机取证、计算机取证、计算机仿真、云取证

- 测试环境

PyBloom-Live是一个Python库,用于实现布隆过滤器(Bloom Filter)的数据结构,这在处理大数据集时非常有用。布隆过滤器可以高效地判断一个元素是否在一个集合中,特别是当集合太大而无法存储在内存中时。它通过哈希函数将数据项映射到一个位数组上,从而实现快速地去重和查找操作。PyBloom-Live库支持实时更新和查询,允许动态地添加和检查元素,非常适合需要快速去重的场景。

安装方法->Pycharm终端输入如下命令:

pip install pybloom-live

编写代码之前需要先导入PyBloom-Live 库,如下代码所示:

from pybloom_live import BloomFilter

- 操作步骤

在数据解密工作顺利完成之后,接下来的关键步骤是进行数据去重,特别是针对身份证号码这类关键信息。为了高效完成这一任务,我们可以采用两种不同的方法相互验证。第一种方法是通过编写Python代码,运用pybloom-live库提供的布隆过滤器。布隆过滤器以其高空间效率和快速查询特性,能够帮助我们迅速识别重复项,是一种在数据处理中实现去重的先进技术;第二种去重方法是利用EmEditor软件。EmEditor不仅是一款高效的文本编辑器,支持处理大型文件,而且具备专门的去重工具。通过这款软件,用户可以直观且方便地对数据进行清洗,确保每条身份证号码的唯一性。这两种方法各有所长,可以根据实际情况选择最合适的去重策略,以保障数据的准确性和有效性。

(1)数据去重-代码去重

在进行数据去重之前,对布隆过滤器的基本原理有所了解至关重要。布隆过滤器由Burton Howard Bloom于1970年设计,它是一种用于快速检测元素是否可能存在于一个集合中的高效数据结构。该结构由一个长二进制数组和一组随机哈希函数构成,以其卓越的空间效率和查询速度而著称,特别适合处理大规模数据集。尽管布隆过滤器存在误报的可能,并且一旦元素加入后难以删除,但其性能优势在许多场景下仍然使其成为一个极具吸引力的选择。

布隆过滤器它能够以高概率告诉我们一个元素“一定不存在”或“可能存在”于某个集合中。这种特性使得布隆过滤器在去重操作中非常有用:如果布隆过滤器确认某个元素不存在,则我们可以确信它确实不在集合中;如果它提示元素可能存在,则我们可能需要进一步验证。这种方法允许我们在处理大量数据时快速且高效地识别并排除重复项。

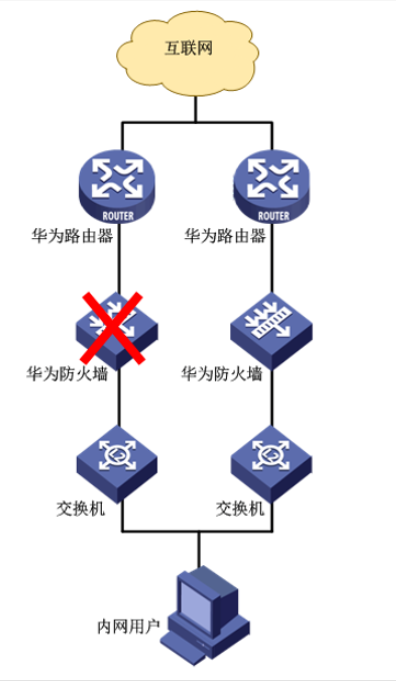

接下来,我将阐述布隆过滤器的去重机制。在此机制中,我们设定位数组的长度为m,同时采用k个哈希函数来实现元素的唯一性检验。

以上图为例,详细解释布隆过滤器的去重原理。设想我们有一个集合{x,y,z},并且定义了三个哈希函数。开始时,我们初始化一个位数组,其所有位初始状态均为0。随后,集合中的每个元素通过这三个哈希函数进行映射,每个元素都会在位数组上产生一个唯一的哈希值,代表数组中的一个位置,我们将这些位置上的值设置为1。

当需要判断元素W是否属于该集合时,我们采用相同的过程:将W通过三个哈希函数映射到位数组上的三个位置。如果这三个位置中任何一个不是1,我们可以断定W不在集合中。然而,如果这三个位置都是1,我们只能说W可能在集合中,因为存在误判的可能性。

这种误判的原因是,不同的元素可能通过哈希映射到相同的位置。例如,如果有多个元素映射到位数组的第4、5和6个位置,并且这些位置都被标记为1,即使元素W不在集合中,它也可能映射到这些已经被其他元素标记的位置。因此,尽管所有三个位置都是1,也不能保证W一定存在于集合中,这就是布隆过滤器无法完全消除误判率的原因。

代码核心编写思路在于利用布隆过滤器的概率数据结构来快速识别并排除重复数据。首先通过detect_encoding函数检测输入文件的编码格式,确保正确读取文件内容。接着,定义了一个生成器函数read_lines,它以指定的块大小逐行读取文件,有效处理大文件并减少内存占用。

在remove_duplicates函数中,使用ScalableBloomFilter类创建了一个布隆过滤器实例,该实例通过mmh3.hash哈希函数提供快速的数据哈希处理能力。代码逐行读取输入文件,对每一行数据进行清洗和分割,然后使用布隆过滤器判断关键列(本例中为第三列)是否已存在。若该数据未出现过,则写入输出文件;若已存在,则记录到重复值文件中。此外,代码中使用了tqdm库来显示进度条,为取证人员提供了直观的进度反馈。

在代码实例中,ScalableBloomFilter类的初始化采用了三个关键参数,以确保布隆过滤器的性能和灵活性:

- initial_capacity=100000000:

此参数界定了布隆过滤器的初始存储容量,即它能够处理的预期元素数量。在本例中,该值设定为100000000,表明过滤器被优化以容纳高达1亿个元素。注意该值的增加将线性提升内存消耗,但相应地降低了误判(false positives)的可能性。

- error_rate=0.001:

该参数指定了布隆过滤器操作时可接受的最大误报率。在此例中,设定为0.001,表示在极端情况下,过滤器错误地认定一个不存在的元素存在的比率不会超过0.001%。降低此比率将需要更多的内存和哈希函数,以提高判断的准确性。

- mode=ScalableBloomFilter.SMALL_SET_GROWTH):

此参数决定了布隆过滤器的内存增长策略。ScalableBloomFilter.SMALL_SET_GROWTH选项使得过滤器在初始阶段对内存的需求较小,随着插入元素数量的增加,其内存占用将逐步扩展。这种模式特别适合于元素数量起始较小但有增长潜力的应用场景。

(2)数据去重-软件去重

EmEditor是一款功能强大的文本编辑器,它不仅支持超大型文件的快速编辑,还提供了实用的数据去重工具。使用EmEditor进行去重操作非常简单:用户只需打开包含重复数据的文件,利用编辑器提供的去重功能,即可快速识别并删除重复的行或项目。这一过程不仅节省了大量手动检查和删除重复项的时间,而且提高了数据处理的准确性和效率。EmEditor的这一特性特别适合处理包含大量记录的数据文件,使得它成为数据清洗和预处理工作中的理想选择。

在进行大数据去重处理时,仅依赖单一方法可能存在误差,因此我们应采用多种方法进行去重,并通过比较这些方法得到的结果来相互验证,这种方法论确保了去重的准确性和可靠性。

- 总结

在本文中,我们重点讨论了大数据环境下去重技术的重要性和实施策略。特别强调了在处理大规模数据集时,单一的去重方法可能存在局限性和误差。为了确保数据的准确性和分析的有效性,必须采用多种去重方法相互验证。通过结合布隆过滤器的概率性判断和EmEditor软件的直观操作,我们能够更全面地识别和排除数据中的重复项。这种多方法交叉验证的策略,不仅提高了去重过程的准确性,也增强了结果的可信度。