深度学习(DL)是人工智能(AI)的基本组成部分。它的目标是使机器能够执行需要决策机制的任务,这些决策机制往往近似于人类推理。深度学习模型是许多先进应用的核心,例如医疗诊断和自动驾驶汽车。不幸的是,像所有其他系统一样,它们也存在可能会被网络罪犯利用的漏洞。例如,单像素攻击就是破坏模型准确性的最有效方法之一,这种方法只需修改图像的一个像素就能轻松欺骗高级深度学习模型。

本文解释了单像素攻击的运行原理,它们在许多领域可能产生的影响及防范策略,以提高人工智能系统的可靠性和安全性。

深度学习简介

深度学习是人工智能的一个子集,涉及训练神经网络来识别数据中的模式。这些神经网络会模仿人类大脑的结构和功能,使它们能够从大量数据中学习,并做出预测或决策。例如,深度学习模型可以识别图像中的物体,理解口语(自然语言处理/ NLP),甚至可以从医学图像中诊断疾病。

为了充分理解深度学习技术的重要性,这里有几个实际应用的例子:

1. 医疗健康:医学成像

深度学习模型广泛应用于医学影像的处理和理解,以检测癌症等疾病。例如,卷积神经网络(CNN)正被应用于对乳房x光照片的分析,以检测乳腺癌。这项技术提供了高度准确的恶性肿瘤识别。

通过为放射科医生提供第二意见,它可以帮助降低人为错误的风险。

2. 自主驾驶

自动驾驶汽车依靠深度学习算法来实时处理来自传感器和摄像头的数据。这些模型用于目标检测、车道识别和决策。例如,特斯拉的自动驾驶仪使用深度学习来处理数据并对车辆的环境做出反应,确保安全导航和驾驶。

3. 自然语言处理

深度学习是自然语言处理(NLP)的重要组成部分。在生成式人工智能(GenAI)出现之前,深度学习推动了会话技术的进步,例如聊天机器人和虚拟助手,如谷歌助手和亚马逊Alexa。这些系统使用深度学习来理解和处理人类语言,以便它们可以回答问题,执行任务,甚至与用户进行对话。

还有很多其他的例子。在金融领域,深度学习模型正被用于通过分析交易模式和识别欺诈异常来检测欺诈活动。在零售领域,亚马逊(Amazon)或Netflix等平台正在使用深度学习来提供个性化推荐,通过分析用户行为、偏好和购买历史来改善用户体验,同时增加销售额。

所有这些都说明了深度学习在各个领域的影响程度,以及这项技术对于提高复杂任务的效率和准确性的重大意义。

深度学习攻击动机

正如我们刚刚看到的,深度学习模型是广泛应用的强大工具。然而,它们很容易受到攻击。网络罪犯可以瞄准这些模型,使它们做出错误的决定,这可能会产生严重的后果。例如,通过操纵自动驾驶汽车的神经网络,攻击者可能会引导汽车误解信号,危及车内人员。

在现实场景中,研究人员展示了用于检测乳腺癌的深度学习模型的脆弱性。通过修改医学图像中的单个像素,他们能够欺骗IBM CODAIT MAX乳腺癌检测器做出错误诊断。这个例子突出了这类攻击对卫生等关键领域的严重影响。

据《中国医学工程学报》所述,ReFace攻击可以在传输攻击设置中成功欺骗商业人脸识别服务,并将AWS SearchFaces API的人脸识别准确率从82%降低到16.4%,将Azure人脸验证准确率从91%降低到50.1%。

单像素攻击(One-Pixel Attack)概述

单像素攻击通过改变输入图像的单个像素来攻击深度学习模型,导致模型对图像进行错误分类。这种攻击使用差分进化算法来识别要修改的最优像素。该方法在不知道模型内部参数的情况下仍然有效。

单像素攻击在许多领域都会带来严重风险。例如,在医学成像中,它们可能导致错误的诊断,就像乳腺癌探测器的情况一样。在网络安全领域,它们可以欺骗面部识别系统。

单像素攻击机制

正如我们现在所理解的,单像素攻击是一种对抗性攻击,它通过修改输入图像的单个像素来利用深度神经网络的脆弱性,从而导致错误分类。

对抗性攻击

对抗性攻击包括对输入数据进行微小的故意更改,以欺骗机器学习模型做出错误的预测或决策。除了图像之外,这可以通过许多不同的方式发生。

例如,在文本数据中,攻击者可以改变单词或字符来欺骗语言模型。在音频数据中,他们可以添加细微的噪音来欺骗语音识别系统。在网络安全中,对抗性攻击可能涉及轻微修改恶意软件的代码,以绕过杀毒软件。同样地,在金融系统中,攻击者可以操纵市场数据,欺骗交易算法进行错误的交易。

单像素攻击

单像素攻击则利用了深度神经网络复杂的决策过程。他们使用差分进化算法来识别像素的最佳修改,使错误分类的概率最大化。差分进化算法迭代地搜索可能的像素修改空间。它使用随时间发展的候选解决方案。

单像素攻击的成功是由于深度神经网络(DNN)对微小扰动的敏感性。深度神经网络很容易被人类注意不到的微小变化所欺骗。差分进化算法的工作原理是生成一组潜在的解,然后组合和修改这些解以找到最佳的候选解。每个候选解代表一个潜在的像素变化,算法评估每个变化对网络分类结果的影响。通过不断改进解的总体,算法最终获取能够导致错误分类的像素变化。

单像素攻击运行原理

执行单像素攻击通常涉及使用差分进化算法,这是一种基于给定质量度量迭代改进候选解决方案的优化方法。下面是该过程的详细描述:

1. 初始化

该算法首先生成一组候选解。在单像素攻击的情况下,每个候选对象表示对图像中单个像素的潜在修改。这些候选对象通常在图像的尺寸和颜色值的限制内随机初始化。

2. 突变与交叉

对于每个候选解,算法执行变异和交叉操作以创建新的候选解。突变包括从种群中选择三个不同的候选者,并通过将这两个候选者之间的加权差加到第三个候选者中来创建一个新的候选者。然后交叉将这个突变的候选者与原始候选者结合,产生一个试验候选者。该方法产生了候选种群的多样性,使算法能够更有效地探索解决方案。

3. 选择

根据其对神经网络分类结果的影响来评估试验候选。如果试验候选比原始候选更有效地导致模型对图像进行错误分类(或增加目标错误分类的概率),则它将取代总体中的后者。这个选择过程是由适应度函数(fitness function)指导的,在这种情况下,适应度函数会衡量错误分类的概率。

4. 迭代

突变、交叉和选择步骤在几次迭代中重复。随着每次迭代,种群不断进化,候选物种在导致错误分类方面变得越来越有效。这个过程一直持续,直到算法以高度置信度识别出导致所需错误分类的变化。

5. 结果

最终的结果是修改后的图像,改变了一个像素,成功地欺骗了神经网络,使其做出了错误的预测。

优化变体

有几种变体可以改进单像素攻击。

其中一种优化涉及在DNN网络的形成阶段加入后门。这种方法产生了后续可以利用的漏洞,使网络更容易受到单像素攻击。

另一种变体是使用关键像素迭代(CriPI)算法,该算法识别并瞄准最有可能影响网络性能的像素。这些算法使用许多不同的技术,包括基于梯度的方法和启发式搜索策略,来识别最重要的像素。

可视化技术,如逆境图(adversity map)和激活图(activation map),在优化单像素攻击中也起着至关重要的作用。

逆境图突出了图像中对干扰最敏感的区域,鼓励攻击者将精力集中在这些区域。激活图则显示了图像的不同部分如何激活网络中的神经元,揭示了哪些像素的影响最大。

通过将这些可视化工具与优化算法相结合,攻击者可以设计更有效的中断,从而增加成功攻击的机会。

单像素攻击在各领域的应用

单像素攻击在许多领域都被证明是有效的。例如,在医学成像领域,这些攻击可以欺骗用于诊断疾病的人工智能模型,正如上述IBM CODAIT的MAX乳腺癌检测器导致错误的分类。在网络安全领域,单像素攻击对人脸识别系统构成了特殊的威胁。

人脸识别

通过修改单个像素,攻击者可以使这些系统错误地识别个人,从而危及安全性。

在一项研究中提出了人脸识别背景下的一个值得注意的单像素攻击案例,该研究探索了如何将对抗性扰动应用于人脸识别模型。当然,目标是尽可能地降低它们的性能。

通过修改单个像素,攻击可以导致人脸识别系统错误识别或无法准确识别个人。这项研究表明,即使是很小的不利修改,面部识别技术也很脆弱。

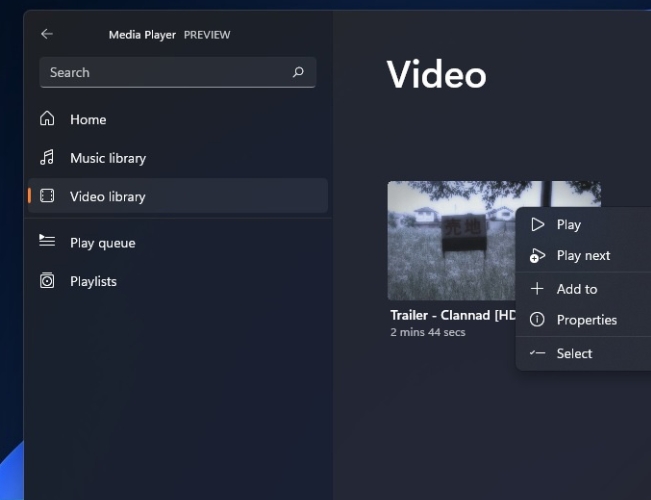

【使用文中提出的算法创建的单像素攻击,成功地欺骗了三种类型的DNN训练的CIFAR-10数据集:AllConv、NiN、VGG。】

这种类型的漏洞可以扩展到依赖图像识别的其他应用程序,例如自动驾驶。在这些系统中,攻击可能导致车辆误解道路标志,从而生成错误甚至危险的驾驶决策。

防御机制

为了降低单像素攻击的风险,已经开发了几种防御机制,包括补丁选择降噪器(PSD)和多重初始化CNN。这些方法通过解决深度学习模型对输入数据中微小扰动的脆弱性,提高了深度学习模型的鲁棒性。

补丁选择降噪器

一种有效的方法是补丁选择降噪器(PSD),它从图像的部分补丁中去除潜在的攻击像素。PSD识别并消除具有异常模式的像素,从而减轻攻击的影响。这种方法特别有效,因为它专注于图像的小区域,使攻击者更难以成功地进行破坏。

多重初始化卷积神经网络

在另一种方法中,多重初始化卷积神经网络(Multi-Initialized cnn)通过形成具有不同初始化的同一网络的多个实例来提高模型的弹性。

每次初始化都会导致网络权重和偏置的配置略有不同。在推理过程中,最终的预测是通过聚合这些多个实例的输出来确定的,例如通过多数投票或平均。这种集成方法降低了单个像素扰动系统性地误导网络中所有实例的概率。

多个初始化的不同响应增加了模型的整体鲁棒性,使其对微小扰动(如在单像素攻击中引入的扰动)不那么敏感。

值得注意的是,尽管取得了这些进展,但许多防御策略仍然容易受到适应性攻击。攻击者仍在不断改进他们的技术来应对现有的防御机制。这进一步凸显了在这一领域进行持续研究和发展的必要性和重要性。

对模型安全性和准确性的影响

毫无疑问,单像素攻击确实会损害缺陷检测模型的准确性和可靠性,特别是在工业环境中。

这些攻击可能会导致误报或漏报,从而导致制造成本增加和盈利能力降低。例如,制造工厂的缺陷检测系统可能由于单像素攻击而错误地将有缺陷的产品分类为无缺陷产品,从而导致产品召回和经济损失。

在人工智能应用中,健壮的安全措施的重要性是众所周知的。像单像素攻击这样的对抗性攻击让人们对关键应用程序核心人工智能的可靠性产生了质疑。它们不仅会削弱它们的有效性,还会让企业对它们的信心受到质疑。

结语

单像素攻击的有效性凸显了人工智能发展中的一个基本紧张关系:模型复杂性和鲁棒性之间的权衡。

随着深度学习模型变得越来越复杂,它们也会对细微的扰动变得更加敏感。这种悖论要求我们重新评估我们的人工智能设计方法,在关键应用中可能倾向于更简单、更可解释的模型。它还强调需要一个完整的人工智能安全方法,超越简单的模型架构,包括数据完整性、系统设计和操作保障。

随着人工智能日益深入我们的日常生活,我们必须确保其在面对此类攻击时的弹性。看来,这不仅是一项技术挑战,也是一项社会要求。

原文链接:

The One-Pixel Threat: Minuscule Changes Fool DL - DZone

![[数据集][目标检测]光伏发电板红外图像鸟粪检测数据集VOC+YOLO格式173张1类别](https://i-blog.csdnimg.cn/direct/53a5e687baa041c2903b38881bbc3987.png)