这是我的第345篇原创文章。

一、引言

ROC曲线是用于评估二分类模型性能的工具,它展示了模型在不同阈值下的真阳性率与假阳性率之间的关系,但是标准的ROC并不能运用于多分类任务种,于是扩展出了宏平均ROC曲线。

宏平均ROC曲线是多分类问题中对ROC曲线的扩展,在多分类任务中,我们需要计算每一类别相对于其他所有类别的ROC曲线,然后对所有这些ROC曲线进行平均,从而得到宏平均ROC曲线,其主要步骤如下:

-

逐类计算ROC曲线:对于每个类别,将其视为正类,其他所有类别视为负类,计算出相应的ROC曲线,也就是可以看作对每个类别进行独热编码

-

计算AUC值:计算每个类别对应的AUC值

-

平均化:对所有类别的AUC值进行平均,从而得到宏平均AUC值,同时,将各类别的ROC曲线取平均,得到宏平均ROC曲线

宏平均ROC曲线的优点在于它平等地考虑了每个类别的性能,适用于类别数量不平衡的情况,不过,由于它对所有类别进行了简单平均,如果某些类别比其他类别更加重要,宏平均ROC可能无法完全反映分类器的实际性能。

二、实现过程

2.1 准备数据

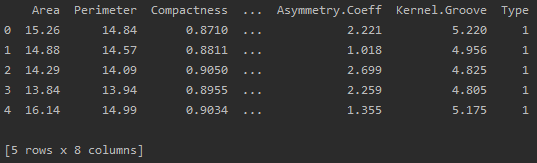

data = pd.read_csv(r'data.csv')

df = pd.DataFrame(data)

print(df.head())该多分类数据存在3个类别:

2.2 提取目标变量

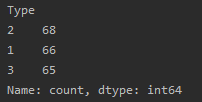

target = 'Type'

features = df.columns.drop(target)

print(data["Type"].value_counts()) # 顺便查看一下样本是否平衡

2.3 划分数据集

# df = shuffle(df)

X_train, X_test, y_train, y_test = train_test_split(df[features], df[target], test_size=0.2, random_state=0)2.4 归一化

mm1 = MinMaxScaler() # 特征进行归一化

X_train_m = mm1.fit_transform(X_train)2.5 模型的构建

model = RandomForestClassifier()2.6 模型的训练

model.fit(X_train_m, y_train)2.7 模型的推理

X_test_m = mm1.transform(X_test)

y_pred = model.predict(X_test_m)

y_scores = model.predict_proba(X_test_m)

print(y_pred)

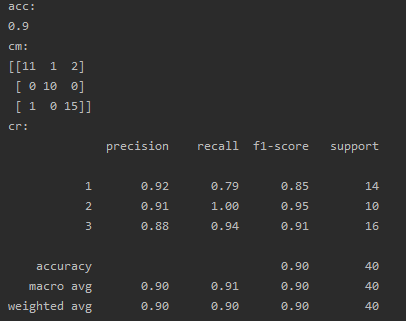

acc = accuracy_score(y_test, y_pred) # 准确率acc

print(f"acc: \n{acc}")

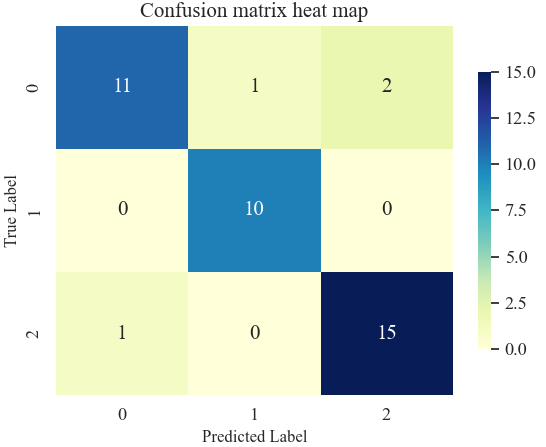

cm = confusion_matrix(y_test, y_pred) # 混淆矩阵

print(f"cm: \n{cm}")

cr = classification_report(y_test, y_pred) # 分类报告

print(f"cr: \n{cr}")![]()

2.8 模型的评价

acc = accuracy_score(y_test, y_pred) # 准确率acc

print(f"acc: \n{acc}")

cm = confusion_matrix(y_test, y_pred) # 混淆矩阵

print(f"cm: \n{cm}")

cr = classification_report(y_test, y_pred) # 分类报告

print(f"cr: \n{cr}")结果:

把混淆矩阵进行可视化:

2.9 绘制ROC曲线

计算宏平均ROC:

# 将y标签转换成one-hot形式

ytest_one_rf = label_binarize(y_test, classes=[1, 2, 3])

# 宏平均法计算AUC

rf_AUC = {}

rf_FPR = {}

rf_TPR = {}

for i in range(ytest_one_rf.shape[1]):

rf_FPR[i], rf_TPR[i], thresholds = roc_curve(ytest_one_rf[:, i], y_scores[:, i])

rf_AUC[i] = auc(rf_FPR[i], rf_TPR[i])

print(rf_AUC)

# 合并所有的FPR并排序去重

pass

# 计算宏平均TPR

rf_TPR_all = np.zeros_like(rf_FPR_final)

for i in range(ytest_one_rf.shape[1]):

rf_TPR_all += np.interp(rf_FPR_final, rf_FPR[i], rf_TPR[i])

rf_TPR_final = rf_TPR_all / ytest_one_rf.shape[1]

# 计算最终的宏平均AUC

rf_AUC_final = auc(rf_FPR_final, rf_TPR_final)

AUC_final_rf = rf_AUC_final # 最终AUC

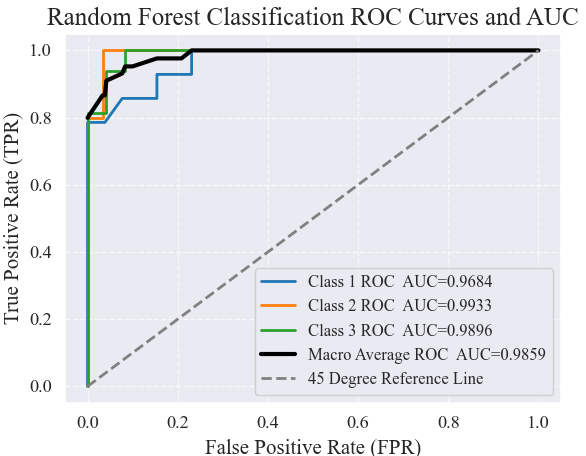

print(f"Macro Average AUC with Random Forest: {AUC_final_rf}")利用随机森林模型对测试集进行预测,并计算每个类别的预测概率。然后,将实际标签 ytest 转换为 one-hot 编码形式,以便进行多分类的 ROC 曲线分析,接着,通过逐类别计算 ROC 曲线和 AUC 值,并保存到字典中,最后,通过合并所有类别的 FPR 值并计算宏平均 TPR,从而得到最终的宏平均 AUC 值,用于评估随机森林模型在多分类任务中的整体性能。

绘制随机森林分类器在多分类任务中的 ROC 曲线,并计算并展示了每个类别的 AUC 值以及宏平均 ROC 曲线的 AUC:

plt.figure(figsize=(10, 5), dpi=300)

# 使用不同的颜色和线型

plt.plot(rf_FPR[0], rf_TPR[0], color='#1f77b4', linestyle='-', label='Class 1 ROC AUC={:.4f}'.format(rf_AUC[0]), lw=2)

plt.plot(rf_FPR[1], rf_TPR[1], color='#ff7f0e', linestyle='-', label='Class 2 ROC AUC={:.4f}'.format(rf_AUC[1]), lw=2)

plt.plot(rf_FPR[2], rf_TPR[2], color='#2ca02c', linestyle='-', label='Class 3 ROC AUC={:.4f}'.format(rf_AUC[2]), lw=2)

# 宏平均ROC曲线

plt.plot(rf_FPR_final, rf_TPR_final, color='#000000', linestyle='-', label='Macro Average ROC AUC={:.4f}'.format(rf_AUC_final), lw=3)

# 45度参考线

plt.plot([0, 1], [0, 1], color='gray', linestyle='--', lw=2, label='45 Degree Reference Line')

plt.xlabel('False Positive Rate (FPR)', fontsize=15)

plt.ylabel('True Positive Rate (TPR)', fontsize=15)

plt.title('Random Forest Classification ROC Curves and AUC', fontsize=18)

plt.grid(linestyle='--', alpha=0.7)

plt.legend(loc='lower right', framealpha=0.9, fontsize=12)

plt.savefig('RF_optimized.pdf', format='pdf', bbox_inches='tight')

plt.show()结果:

作者简介:

读研期间发表6篇SCI数据挖掘相关论文,现在某研究院从事数据算法相关科研工作,结合自身科研实践经历不定期分享关于Python、机器学习、深度学习、人工智能系列基础知识与应用案例。致力于只做原创,以最简单的方式理解和学习,关注我一起交流成长。需要数据集和源码的小伙伴可以关注底部公众号添加作者微信。

![[C++] C++11详解 (一)](https://i-blog.csdnimg.cn/direct/162083f688e54458963640439ee57f22.png)