你是否曾经在处理海量数据时感到力不从心?是否在重复编写相似代码时感到厌烦?如果是,那么Databricks中的自定义函数可能就是你一直在寻找的救星。在接下来的5分钟里,让我们一起探索如何利用这个强大的工具来revolutionize你的大数据开发工作流程。

目录

- 为什么要在Databricks中使用自定义函数?

- Databricks中自定义函数的类型

- 如何在Databricks中创建自定义函数

- 3.1 Python UDF

- 3.2 Pandas UDF

- 3.3 SQL UDF

- 自定义函数的性能优化

- 自定义函数的最佳实践

- 常见问题和解决方案

- 结语

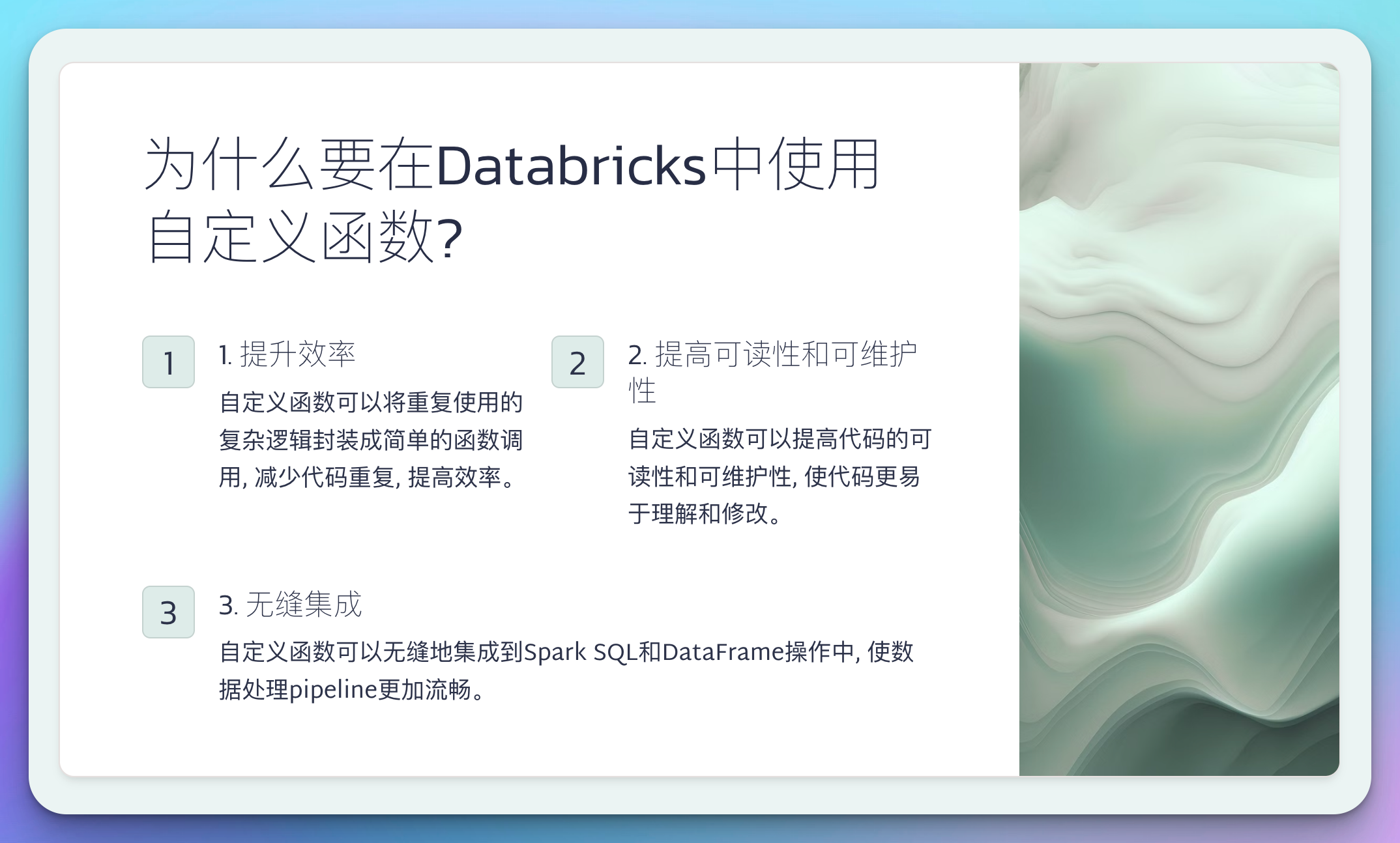

为什么要在Databricks中使用自定义函数?

在大数据开发的世界里,效率就是生命。而Databricks的自定义函数(User-Defined Functions, UDFs)正是提升效率的利器。想象一下,你可以将那些反复使用的复杂逻辑封装成一个简单的函数调用,是不是很酷?

自定义函数不仅可以大大减少代码重复,还能提高代码的可读性和可维护性。更重要的是,它们能够seamlessly地集成到Spark SQL和DataFrame操作中,让你的数据处理pipeline更加流畅。

让我们来看一个简单的例子。假设你经常需要将温度从摄氏度转换为华氏度:

# 未使用自定义函数

df = spark.createDataFrame([(0,), (10,), (20,), (30,)], ["celsius"])

df_fahrenheit = df.withColumn("fahrenheit", (df.celsius * 9/5) + 32)

# 使用自定义函数

from pyspark.sql.functions import udf

from pyspark.sql.types import DoubleType

@udf(returnType=DoubleType())

def celsius_to_fahrenheit(celsius):

return (celsius * 9/5) + 32

df_fahrenheit = df.withColumn("fahrenheit", celsius_to_fahrenheit(df.celsius))

看到区别了吗?使用自定义函数后,我们的代码变得更加清晰,而且可以在任何需要的地方重复使用这个转换逻辑。

Databricks中自定义函数的类型

Databricks支持多种类型的自定义函数,以满足不同的需求:

- Python UDF: 使用Python编写,适用于简单的操作。

- Pandas UDF: 利用Pandas库的高性能,适用于复杂的数据操作。

- SQL UDF: 直接在SQL查询中使用,适用于SQL重度用户。

每种类型都有其特定的用途和优势。接下来,我们将深入探讨如何创建和使用这些不同类型的自定义函数。

如何在Databricks中创建自定义函数

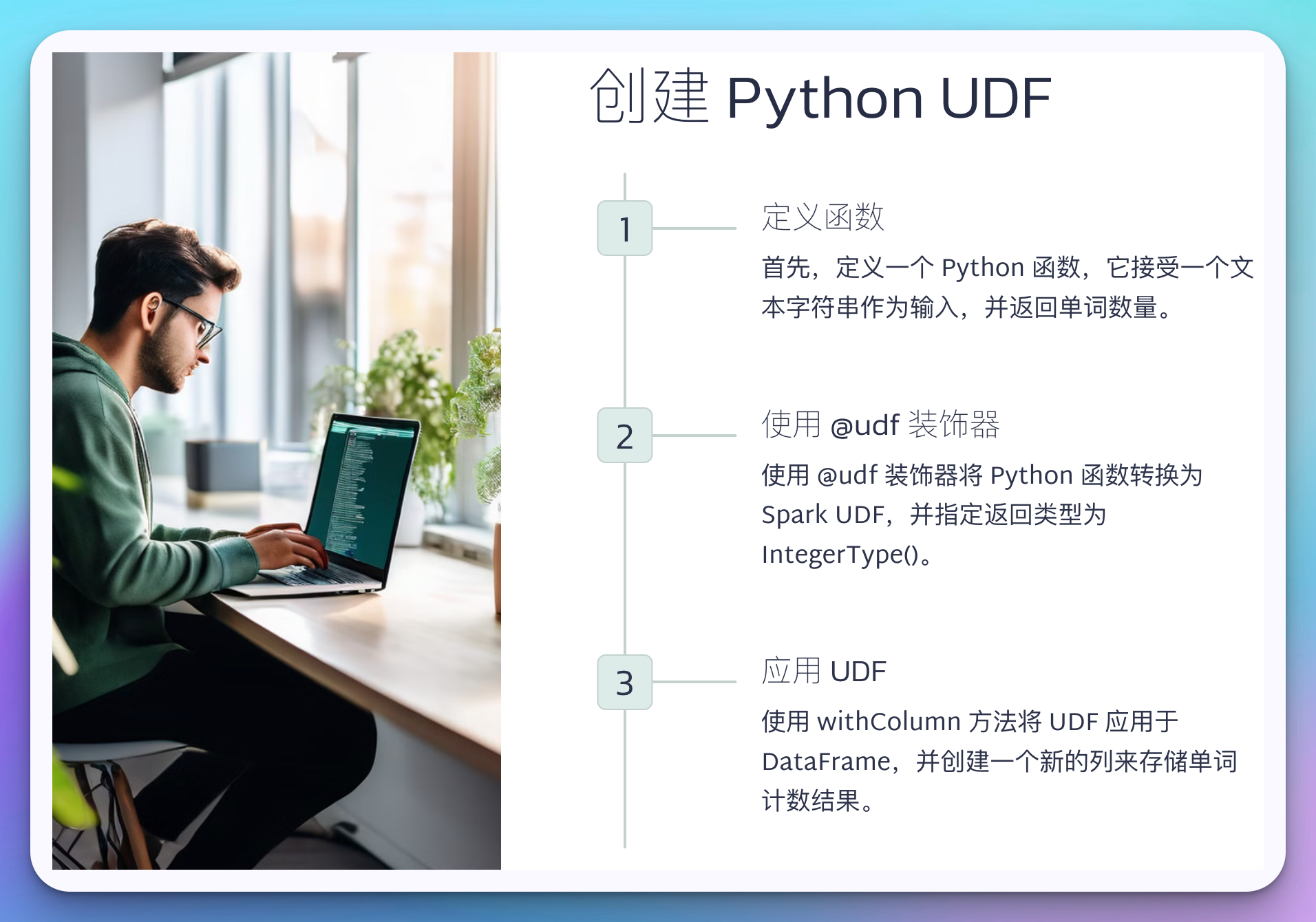

3.1 Python UDF

Python UDF是最简单和最常用的自定义函数类型。它们易于编写,适用于大多数简单到中等复杂度的操作。

让我们创建一个稍微复杂一点的Python UDF,用于计算给定文本中的单词数:

from pyspark.sql.functions import udf

from pyspark.sql.types import IntegerType

@udf(returnType=IntegerType())

def word_count(text):

if text is None:

return 0

return len(text.split())

# 创建示例DataFrame

df = spark.createDataFrame([

("Hello world",),

("This is a longer sentence",),

(None,),

("Databricks is awesome for big data",)

], ["text"])

# 应用UDF

result_df = df.withColumn("word_count", word_count(df.text))

# 显示结果

result_df.show(truncate=False)

输出结果:

+-----------------------------------+----------+

|text |word_count|

+-----------------------------------+----------+

|Hello world |2 |

|This is a longer sentence |5 |

|null |0 |

|Databricks is awesome for big data |6 |

+-----------------------------------+----------+

在这个例子中,我们定义了一个word_count函数,它接受一个文本字符串作为输入,并返回单词数量。我们使用@udf装饰器将这个Python函数转换为Spark UDF,并指定返回类型为IntegerType()。

注意我们如何处理了None值,这在处理真实世界的数据时非常重要。始终记住要考虑边界情况和异常情况。

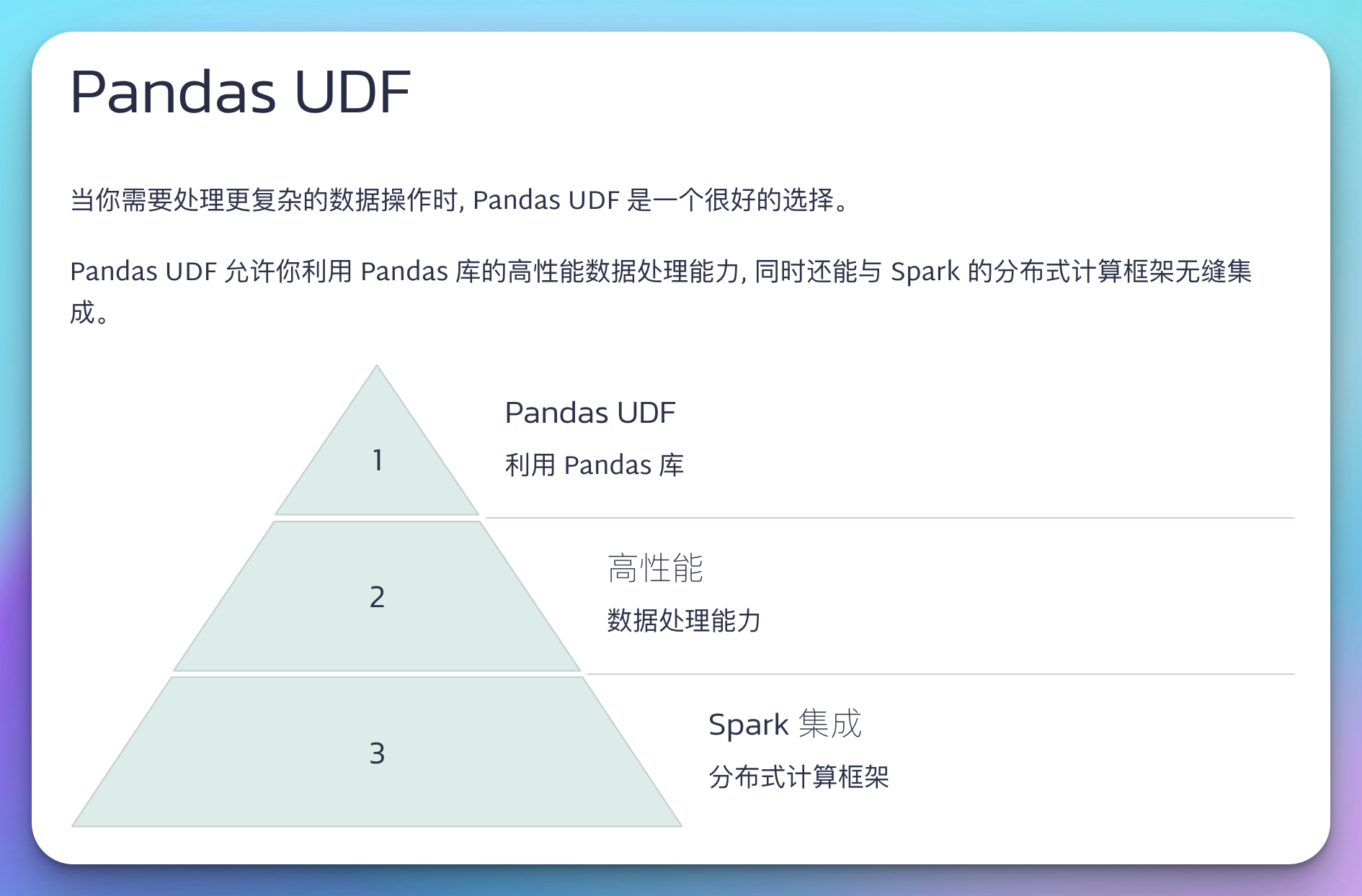

3.2 Pandas UDF

当你需要处理更复杂的数据操作时,Pandas UDF是一个很好的选择。Pandas UDF允许你利用Pandas库的高性能数据处理能力,同时还能与Spark的分布式计算框架无缝集成。

让我们创建一个Pandas UDF来计算移动平均值:

import pandas as pd

from pyspark.sql.functions import pandas_udf

from pyspark.sql.types import DoubleType

@pandas_udf(DoubleType())

def moving_average(values: pd.Series, window: int) -> pd.Series:

return values.rolling(window=window, min_periods=1).mean()

# 创建示例DataFrame

df = spark.createDataFrame([

(1, 10.0),

(2, 20.0),

(3, 15.0),

(4, 30.0),

(5, 25.0),

(6, 40.0)

], ["id", "value"])

# 应用Pandas UDF

window_size = 3

result_df = df.withColumn("moving_avg", moving_average(df.value, window_size))

# 显示结果

result_df.show()

输出结果:

+---+-----+------------------+

| id|value| moving_avg|

+---+-----+------------------+

| 1| 10.0| 10.0|

| 2| 20.0| 15.0|

| 3| 15.0| 15.0|

| 4| 30.0|21.666666666666668|

| 5| 25.0| 23.33333333333333|

| 6| 40.0| 31.66666666666667|

+---+-----+------------------+

在这个例子中,我们定义了一个moving_average函数,它使用Pandas的rolling函数计算移动平均值。我们使用@pandas_udf装饰器将这个函数转换为Pandas UDF。

注意Pandas UDF的语法与Python UDF略有不同。这里我们明确指定了输入和输出的类型都是pd.Series。这种类型提示不仅提高了代码的可读性,还能帮助Spark优化执行计划。

Pandas UDF特别适合于需要在一组值上进行操作的场景,比如时间序列分析、统计计算等。它能够充分利用Pandas的向量化操作,大大提高处理效率。

3.3 SQL UDF

如果你更喜欢使用SQL进行数据处理,Databricks也支持创建SQL UDF。这种类型的UDF直接在SQL查询中定义和使用,非常适合那些习惯于SQL的数据分析师和工程师。

让我们创建一个SQL UDF来计算给定数字的阶乘:

-- 创建SQL UDF

CREATE OR REPLACE FUNCTION factorial(n INT)

RETURNS INT

RETURN

CASE

WHEN n <= 1 THEN 1

ELSE n * factorial(n-1)

END;

-- 创建示例表

CREATE OR REPLACE TEMPORARY VIEW numbers AS

SELECT 1 AS n

UNION ALL SELECT 2

UNION ALL SELECT 3

UNION ALL SELECT 4

UNION ALL SELECT 5;

-- 使用SQL UDF

SELECT n, factorial(n) AS factorial_n

FROM numbers

ORDER BY n;

输出结果:

+---+-----------+

| n|factorial_n|

+---+-----------+

| 1| 1|

| 2| 2|

| 3| 6|

| 4| 24|

| 5| 120|

+---+-----------+

在这个例子中,我们首先定义了一个名为factorial的SQL UDF。这个函数使用递归方法计算阶乘。然后,我们创建了一个临时视图numbers,并在查询中使用我们的UDF。

SQL UDF的一大优势是它可以直接在SQL查询中使用,无需切换到Python环境。这对于那些主要使用SQL进行数据分析的用户来说非常方便。

但是要注意,SQL UDF通常比Python UDF或Pandas UDF的性能稍差,特别是在处理复杂逻辑时。因此,在选择使用SQL UDF时,要权衡便利性和性能需求。

自定义函数的性能优化

虽然自定义函数为我们提供了强大的功能,但如果使用不当,也可能成为性能瓶颈。以下是一些优化自定义函数性能的技巧:

-

选择正确的UDF类型: 对于简单操作,使用Python UDF;对于复杂的数据操作,特别是涉及到向量化操作时,使用Pandas UDF。

-

最小化数据传输: UDF的执行涉及到数据从Spark执行器到UDF执行环境的序列化和反序列化。尽量在UDF内部完成尽可能多的操作,减少数据传输。

-

使用广播变量: 如果你的UDF需要使用大型查找表或配置数据,考虑使用Spark的广播变量。

-

批处理: Pandas UDF默认就是批处理的,但对于Python UDF,你可以使用

pandas_udf的PandasUDFType.SCALAR类型来实现批处理。 -

避免在UDF中使用全局变量: 这可能导致不必要的数据shuffle。

让我们通过一个例子来说明如何优化UDF:

from pyspark.sql.functions import pandas_udf, PandasUDFType

import pandas as pd

# 假设这是一个大型查找表

lookup_table = {i: f"value_{i}" for i in range(1000000)}

# 使用广播变量

broadcast_lookup = spark.sparkContext.broadcast(lookup_table)

@pandas_udf("string", PandasUDFType.SCALAR)

def optimized_lookup(keys: pd.Series) -> pd.Series:

# 使用广播变量进行查找

return keys.map(lambda x: broadcast_lookup.value.get(x, "not_found"))

# 创建示例DataFrame

df = spark.createDataFrame([(i,) for i in range(10)], ["key"])

# 应用优化后的UDF

result_df = df.withColumn("value", optimized_lookup(df.key))

# 显示结果

result_df.show()

在这个例子中,我们使用了几种优化技巧:

- 我们使用了

pandas_udf来创建一个批处理UDF,这比传统的Python UDF更高效。 - 我们使用了广播变量来分发大型查找表,避免了在每个任务中重复序列化和反序列化这个大表。

- 我们在UDF内部使用了Pandas的向量化操作(

map),这比循环遍历每个元素要快得多。

通过这些优化,我们的UDF可以更高效地处理大量数据。

自定义函数的最佳实践

在Databricks中使用自定义函数时,遵循一些最佳实践可以帮助你写出更好的代码:

-

保持函数简单: 每个函数应该只做一件事,并且做好这件事。复杂的函数难以理解和维护。

-

适当的错误处理: 在函数中加入适当的错误处理逻辑,以防止因为异常数据导致整个作业失败。

-

详细的文档: 为你的函数添加清晰的文档字符串,说明函数的用途、参数和返回值。

-

测试: 在将UDF应用到大型数据集之前,先在小的数据样本上测试。

-

版本控制: 将你的UDF代码纳入版本控制系统,方便追踪修改和协作。

-

命名规范: 使用有意义的函数名和变量名,遵循PEP 8命名规范。

让我们通过一个例子来说明这些最佳实践:

from pyspark.sql.functions import udf

from pyspark.sql.types import StringType

import re

@udf(returnType=StringType())

def clean_and_standardize_text(text: str) -> str:

"""

清理并标准化输入文本。

此函数执行以下操作:

1. 将文本转换为小写

2. 移除所有非字母数字字符

3. 将多个空格替换为单个空格

4. 去除首尾空白字符

参数:

text (str): 需要清理的输入文本

返回:

str: 清理和标准化后的文本

异常:

TypeError: 如果输入不是字符串类型

"""

if not isinstance(text, str):

raise TypeError("Input must be a string")

try:

# 转换为小写

text = text.lower()

# 移除非字母数字字符

text = re.sub(r'[^a-z0-9\s]', '', text)

# 将多个空格替换为单个空格

text = re.sub(r'\s+', ' ', text)

# 去除首尾空白字符

return text.strip()

except Exception as e:

# 记录错误,但返回原始输入,以避免任务失败

print(f"Error processing text: {e}")

return text

# 创建示例DataFrame

df = spark.createDataFrame([

("Hello, World! 123",),

(" Data Science is AWESOME!!! ",),

("Python & Spark",),

(None,)

], ["text"])

# 应用UDF

result_df = df.withColumn("cleaned_text", clean_and_standardize_text(df.text))

# 显示结果

result_df.show(truncate=False)

这个例子展示了以下最佳实践:

- 函数简单明了:函数只做一件事 - 清理和标准化文本。

- 错误处理:我们检查了输入类型,并在处理过程中捕获了可能的异常。

- 详细文档:函数有清晰的文档字符串,解释了它的用途、参数和返回值。

- 命名规范:函数名

clean_and_standardize_text清楚地表明了其功能。

通过遵循这些最佳实践,我们创建了一个健壮、可读、可维护的UDF。

常见问题和解决方案

在使用Databricks自定义函数时,开发者可能会遇到一些常见问题。让我们探讨其中的一些问题及其解决方案:

- 性能问题

问题:UDF执行速度慢,特别是在处理大型数据集时。

解决方案:

- 使用Pandas UDF代替普通Python UDF

- 减少UDF内的数据移动

- 考虑使用内置函数代替UDF(如果可能的话)

示例:

from pyspark.sql.functions import pandas_udf

from pyspark.sql.types import DoubleType

import pandas as pd

# 低效的Python UDF

@udf(returnType=DoubleType())

def slow_square(x):

return float(x ** 2)

# 高效的Pandas UDF

@pandas_udf(DoubleType())

def fast_square(x: pd.Series) -> pd.Series:

return x ** 2

# 创建示例DataFrame

df = spark.range(1000000)

# 比较性能

%time df.withColumn("squared_slow", slow_square(df.id)).count()

%time df.withColumn("squared_fast", fast_square(df.id)).count()

- 序列化错误

问题:在UDF中使用不可序列化的对象时出现错误。

解决方案:

- 确保UDF中使用的所有对象都是可序列化的

- 使用

@pandas_udf并在函数内部创建不可序列化的对象

示例:

from pyspark.sql.functions import pandas_udf

from pyspark.sql.types import StringType

import pandas as pd

import nltk

# 这会失败,因为nltk.tokenize.word_tokenize不可序列化

@udf(returnType=StringType())

def tokenize_udf_wrong(text):

return " ".join(nltk.tokenize.word_tokenize(text))

# 这样可以工作

@pandas_udf(StringType())

def tokenize_udf_correct(text: pd.Series) -> pd.Series:

nltk.download('punkt', quiet=True)

return text.apply(lambda x: " ".join(nltk.tokenize.word_tokenize(x)))

# 创建示例DataFrame

df = spark.createDataFrame([("Hello world!",), ("How are you?",)], ["text"])

# 应用正确的UDF

result_df = df.withColumn("tokenized", tokenize_udf_correct(df.text))

result_df.show(truncate=False)

- 数据类型不匹配

问题:UDF的返回类型与预期不符。

解决方案:

- 明确指定UDF的返回类型

- 在UDF内部进行适当的类型转换

示例:

from pyspark.sql.functions import udf

from pyspark.sql.types import IntegerType, StringType

# 错误的UDF - 返回类型不匹配

@udf(returnType=IntegerType())

def length_udf_wrong(text):

return len(text) # 这会失败,因为Python的len()返回一个整数,但Spark期望一个可为null的整数

# 正确的UDF

@udf(returnType=IntegerType())

def length_udf_correct(text):

if text is None:

return None

return len(text)

# 创建示例DataFrame

df = spark.createDataFrame([("hello",), (None,), ("world",)], ["text"])

# 应用正确的UDF

result_df = df.withColumn("length", length_udf_correct(df.text))

result_df.show()

通过理解这些常见问题和解决方案,你可以更有效地在Databricks中使用自定义函数,避免常见的陷阱,并编写更高效、更可靠的代码。

结语

在这篇博客中,我们深入探讨了Databricks中自定义函数的世界。从基本的Python UDF到高性能的Pandas UDF,再到灵活的SQL UDF,我们已经涵盖了广泛的主题。我们学习了如何创建这些函数,如何优化它们的性能,以及如何遵循最佳实践来编写高质量的代码。

自定义函数是Databricks生态系统中的一个强大工具。它们允许我们将复杂的逻辑封装在可重用的单元中,大大提高了代码的可读性和可维护性。通过正确使用UDF,我们可以显著提升数据处理的效率和灵活性。

然而,重要的是要记住,UDF并不是万能的解决方案。在某些情况下,使用Spark的内置函数或者重新设计数据处理流程可能是更好的选择。作为开发者,我们需要权衡使用UDF的便利性和潜在的性能影响。

最后,我鼓励你在自己的Databricks项目中尝试使用自定义函数。从小规模开始,逐步扩大应用范围。记住要经常测试和优化你的UDF,以确保它们在大规模数据集上也能高效运行。

随着你在Databricks中积累更多经验,你会发现自定义函数是你工具箱中不可或缺的一部分,能够帮助你更有效地处理各种数据挑战。

祝你在Databricks的旅程中一切顺利,happy coding!