目录

一、BeautifulSoup简介

1.1 安装BeautifulSoup

1.2 引入BeautifulSoup

二、基本使用

2.1 实例化BeautifulSoup对象

2.2 解析HTML文档

2.2.1 查找标签

2.2.2 获取标签属性和内容

2.3 异常处理

三、进阶使用

3.1 复杂标签查找

3.1.1 CSS选择器

3.1.2 正则表达式

3.2 嵌套和父子关系

3.3 过滤器和属性

四、案例实践

4.1 案例背景

4.2 分析网页结构

4.3 编写爬虫代码

4.4 注意事项

五、总结

在当今大数据时代,信息获取和处理的能力尤为重要。网页爬虫作为一种自动化的信息抓取工具,能够有效地从互联网中提取所需数据。Python以其简洁的语法和强大的库支持,成为了网页爬虫开发的首选语言之一。其中,BeautifulSoup库因其简单易用、功能强大,被广泛用于解析HTML和XML文档。

本文将详细介绍如何使用Python的BeautifulSoup库进行网页爬虫开发,通过丰富的案例和代码,帮助新手朋友快速上手。

一、BeautifulSoup简介

BeautifulSoup是一个可以从HTML或XML文件中提取数据的Python库。它基于解析器将复杂的HTML文档转换为易于理解的树形结构,允许开发者使用简单的方法定位和操作网页元素。BeautifulSoup自动将输入文档转换为Unicode编码,并可以将输出文档转换为UTF-8编码,大大简化了编码问题的处理。

1.1 安装BeautifulSoup

BeautifulSoup不是Python的标准库,因此需要通过pip进行安装。这里我们使用BeautifulSoup 4(简称BS4),因为它是目前最常用且更新最活跃的版本。

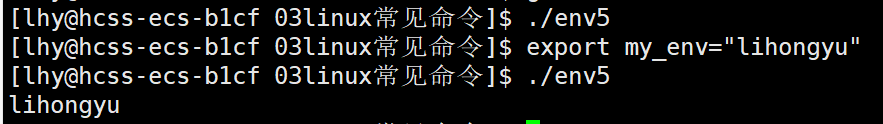

在Linux系统中,可以使用以下命令安装:

sudo apt-get install python3-bs4在macOS和Windows系统中,通常需要先安装pip,然后使用以下命令安装BeautifulSoup 4:

pip install beautifulsoup4此外,BeautifulSoup还需要一个解析器来解析HTML或XML文档。Python自带了html.parser,但也可以选择更强大的第三方解析器如lxml和html5lib。如果需要这些解析器,可以使用pip进行安装:

pip install lxml

pip install html5lib1.2 引入BeautifulSoup

在Python脚本中,首先需要引入BeautifulSoup库:

from bs4 import BeautifulSoup二、基本使用

2.1 实例化BeautifulSoup对象

在使用BeautifulSoup之前,需要实例化一个BeautifulSoup对象,并将要解析的HTML或XML文档作为第一个参数传入。第二个参数指定解析器,常用的有html.parser、lxml和html5lib。

from urllib.request import urlopen

from bs4 import BeautifulSoup

url = 'http://example.com'

html = urlopen(url).read()

soup = BeautifulSoup(html, 'html.parser')2.2 解析HTML文档

实例化BeautifulSoup对象后,就可以使用它提供的方法来解析和查找HTML文档中的元素了。

2.2.1 查找标签

BeautifulSoup提供了多种查找标签的方法,其中最常用的是find()和find_all()。

find(name, attrs, recursive, string, **kwargs):返回文档中匹配的第一个标签。

find_all(name, attrs, recursive, string, limit, **kwargs):返回文档中所有匹配的标签,结果是一个列表。

例如,查找文档中所有的<a>标签:

a_tags = soup.find_all('a')

for tag in a_tags:

print(tag.get('href'))2.2.2 获取标签属性和内容

可以通过.get()方法获取标签的属性,如<a>标签的href属性。获取标签内的文本内容,可以使用.string或.get_text()方法。

first_a_tag = soup.find('a')

print(first_a_tag.get('href')) # 获取href属性

print(first_a_tag.string) # 获取标签内的文本内容

print(first_a_tag.get_text()) # 等同于.string,但可以处理嵌套标签2.3 异常处理

在网页爬虫中,经常会遇到网络问题、数据格式错误等问题。因此,在编写爬虫时,必须添加异常处理逻辑,确保程序的健壮性。

from urllib.request import urlopen

from urllib.error import HTTPError, URLError

from bs4 import BeautifulSoup

try:

html = urlopen('http://example.com')

soup = BeautifulSoup(html.read(), 'html.parser')

# 处理解析后的soup对象

except HTTPError as e:

print(f"HTTP Error: {e.code}")

except URLError as e:

print(f"URL Error: {e.reason}")

except Exception as e:

print(f"An error occurred: {e}")三、进阶使用

3.1 复杂标签查找

除了基于标签名称的查找,BeautifulSoup还提供了基于CSS选择器和正则表达式的高级查找方法。

3.1.1 CSS选择器

CSS选择器允许你使用类似于CSS的语法来查找标签。这极大地增强了查找的灵活性和准确性。

# 使用CSS选择器查找所有class为"item"的div标签

divs = soup.select('div.item')

for div in divs:

print(div.get_text())

# 查找id为"header"的标签

header = soup.select_one('#header') # select_one返回第一个匹配的标签

print(header.get_text())3.1.2 正则表达式

在find_all()方法中,可以使用正则表达式来匹配标签的名称。

import re

# 查找所有以"h"开头的标签

for tag in soup.find_all(re.compile('^h')):

print(tag.name)3.2 嵌套和父子关系

在HTML文档中,标签之间常常存在嵌套关系。BeautifulSoup提供了.parent、.children、.contents、.next_sibling、.previous_sibling等方法来处理这些关系。

# 查找第一个<a>标签的父标签

a_tag = soup.find('a')

parent_tag = a_tag.parent

print(parent_tag.name)

# 遍历某个标签的所有子标签

for child in soup.find('div').children:

print(child.name)

# 访问标签的下一个兄弟标签

next_sibling = a_tag.next_sibling

if next_sibling and next_sibling.name:

print(next_sibling.name)3.3 过滤器和属性

在查找标签时,可以通过attrs参数指定过滤条件,进一步精确查找。

# 查找所有href属性包含"example"的<a>标签

a_tags = soup.find_all('a', href=re.compile('example'))

for tag in a_tags:

print(tag.get('href'))

# 或者使用lambda函数

a_tags = soup.find_all(lambda tag: tag.name == 'a' and 'example' in tag.get('href', ''))

for tag in a_tags:

print(tag.get('href'))四、案例实践

下面,我们将通过一个具体的案例来展示如何使用BeautifulSoup进行网页爬虫。

4.1 案例背景

假设我们需要从一个新闻网站(例如http://news.example.com)抓取所有新闻的标题和链接。

4.2 分析网页结构

首先,我们需要访问目标网站,并使用浏览器的开发者工具(如Chrome的DevTools)来分析网页的HTML结构,确定新闻标题和链接所在的标签及属性。

假设每条新闻都用一个<div>标签包裹,且这个<div>标签有一个特定的class(比如news-item),新闻的标题在<h2>标签内,链接在<a>标签的href属性中。

4.3 编写爬虫代码

from urllib.request import urlopen

from bs4 import BeautifulSoup

def fetch_news(url):

try:

html = urlopen(url).read()

soup = BeautifulSoup(html, 'html.parser')

# 查找所有新闻项

news_items = soup.find_all('div', class_='news-item')

# 遍历新闻项,提取标题和链接

for item in news_items:

title = item.find('h2').get_text()

link = item.find('a').get('href')

print(f"Title: {title}, Link: {link}")

except Exception as e:

print(f"An error occurred: {e}")

# 调用函数

fetch_news('http://news.example.com')4.4 注意事项

尊重网站的robots.txt文件,避免对网站造成不必要的负担。

处理网络异常和HTML解析异常,确保程序的健壮性。

遵守相关法律法规,不要抓取涉及个人隐私或版权保护的数据。

五、总结

通过本文,我们详细介绍了Python中使用BeautifulSoup库进行网页爬虫的基本知识和进阶技巧。从BeautifulSoup的安装和引入,到基本的标签查找和属性提取,再到高级的CSS选择器、正则表达式查找和父子关系处理,最后通过一个具体的