NEO 半导体公司,一家专注于 3D DRAM 和 3D NAND 内存的公司,最近推出了其最新的 3D X-AI 芯片技术,这项技术有可能取代目前在 AI GPU 加速器中使用的高带宽内存 (HBM)。

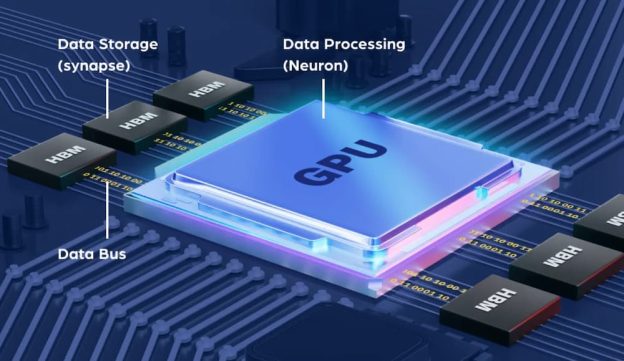

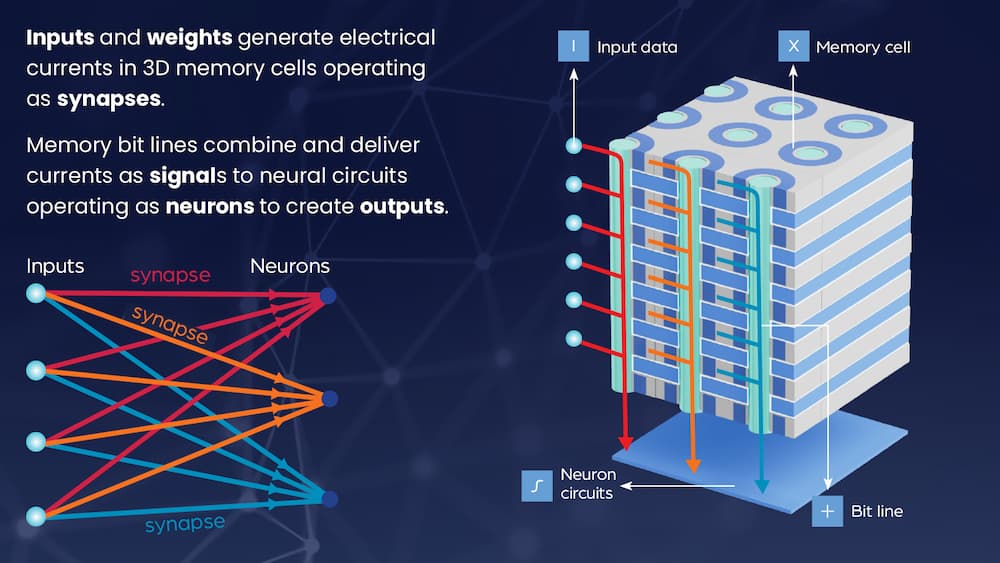

据报道,这款 3D DRAM 集成了 AI 处理能力,能够在内存中直接处理和生成数据,无需额外的数学运算输出。当大量数据在内存和处理器之间传输时,它可以减少数据总线的问题,从而增强 AI 性能并降低功耗。

3D X-AI 芯片有一个内置的神经电路层,可以在同一芯片上的 300 层内存中处理数据。NEO 半导体声称,借助 8,000 个神经元电路在内存中进行 AI 处理,3D 内存的性能可以提高 100 倍,内存密度比当前的 HBM 高 8 倍。通过减少 GPU 中处理的数据量,可以将功耗降低 99%。

单个 3D X-AI 芯片包含 300 层 3D DRAM 单元和一层带有 8,000 个神经元的神经电路层,容量为 128GB,每个芯片支持高达 10 TB/s 的 AI 处理能力。使用 12 个 3D X-AI 芯片堆叠并采用 HBM 封装技术,可以实现 120 TB/s 的处理吞吐量。因此,NEO 估计这种配置可能会带来高达 100 倍的性能提升。

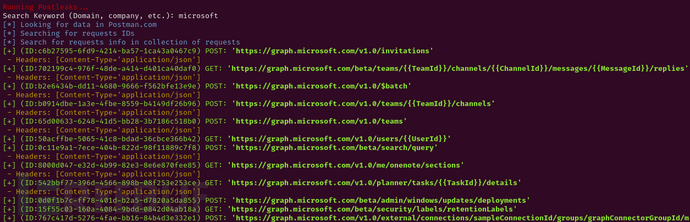

NEO 半导体的创始人兼首席执行官 Andy Hsu 指出,现有的 AI 芯片由于架构和技术上的低效,浪费了大量的性能和功耗。现有的 AI 芯片架构将数据存储在 HBM 中,并依赖 GPU 进行所有计算。

他进一步声称,数据存储和处理架构的分离使得数据总线成为不可避免的性能瓶颈,导致大数据传输期间的性能受限和高功耗。

据 Hsu 称,3D X-AI 可以在每个 HBM 芯片内部进行 AI 处理,这可能会大幅减少 HBM 和 GPU 之间的数据传输,从而显著提高性能并降低功耗。

许多公司正在研究提高处理速度和通信吞吐量的技术。随着半导体的速度和效率不断提高,组件间传输信息的数据总线将成为瓶颈。因此,这类技术将使所有组件一起加速。

根据 tom's hardware 的报道,像台积电 (TSMC)、英特尔 (Intel) 和 Innolux 这样的公司已经在探索光学技术,寻求主板内部更快的通信。通过将部分 AI 处理从 GPU 转移到 HBM,NEO 半导体可能会减轻 GPU 的负担,并可能实现比现有的高功耗 AI 加速器更好的效率。