1. 梯度提升回归的基本概念

1.1 什么是梯度提升?

梯度提升是一种集成学习方法,通过组合多个弱学习器来构建一个强大的预测模型。在梯度提升框架中,每个弱学习器都试图修正前一个模型的错误。与简单的加法模型不同,梯度提升通过逐步拟合前一个模型的残差来改进预测。

1.2 什么是梯度提升回归?

梯度提升回归(Gradient Boosting Regression)专门用于回归任务。它通过最小化损失函数(如均方误差)来优化回归模型的性能。每一轮的模型训练都在尝试减少当前模型的预测误差。

2. 梯度提升回归的数学推导

2.1 模型初始化

首先,我们初始化一个常数模型 ,通常选择为目标变量的均值:

其中:

是损失函数,常见的选择是均方误差(MSE)。

是样本数。

2.2 残差计算

在每一轮迭代中,我们需要计算当前模型的残差。残差表示当前模型的预测值与实际值之间的差异:

残差的计算实质上是损失函数对当前模型预测值的负梯度。因此,这一步相当于计算梯度,用于指导下一步模型的改进。

2.3 新模型训练

使用计算出的残差,训练一个新的弱学习器 。这个弱学习器的目标是尽量拟合残差,从而减少整体模型的预测误差:

通常,弱学习器选用回归树(决策树的回归版本),因为树模型能够很好地处理非线性关系。

2.4 模型更新

新模型通过以下方式更新:

其中:

是学习率,用于控制每个新模型的贡献。较小的学习率通常需要更多的树来达到良好的效果,但能够增强模型的泛化能力。

2.5 最终模型

在 轮迭代之后,最终的模型表达式为:

3. 梯度提升回归的优点与缺点

3.1 优点

- 强大的预测能力:梯度提升回归在处理复杂的非线性回归任务时表现尤为出色。

- 灵活性:可以选择不同的损失函数(如均方误差、绝对误差等)来适应不同的应用场景。

- 处理缺失值:梯度提升回归能够自动处理数据中的缺失值,减少数据预处理的复杂性。

3.2 缺点

- 易于过拟合:如果模型的树的数量过多或者学习率过高,模型容易对训练数据拟合过度,导致泛化能力下降。

- 训练时间较长:由于每一轮的模型需要计算残差并进行新的训练,梯度提升回归的计算复杂度较高,尤其是在大数据集上。

- 参数调优复杂:梯度提升回归有多个超参数(如学习率、树的深度、树的数量等)需要调优,找到最佳的参数组合往往需要较多的计算资源。

4. 梯度提升回归的常见超参数

- 学习率(learning_rate):控制每个弱学习器对最终模型的贡献,通常设置为较小的值(如 0.01 或 0.1),以增强模型的泛化能力。

- 树的数量(n_estimators):决定了弱学习器的数量。通常与学习率一起调节,较小的学习率需要较多的树。

- 树的最大深度(max_depth):控制每个弱学习器的复杂度,防止模型过拟合。

- 子采样率(subsample):决定每轮训练中使用的样本比例,通常设置为 0.5 到 1 之间,以增强模型的鲁棒性。

5. 案例分析:使用梯度提升回归预测波士顿房价

5.1 数据加载与预处理

我们将使用波士顿房价数据集进行模型训练与预测。

from sklearn.datasets import fetch_california_housing

from sklearn.model_selection import train_test_split

from sklearn.ensemble import GradientBoostingRegressor

from sklearn.metrics import mean_squared_error, r2_score

# 加载加利福尼亚州房价数据集

housing = fetch_california_housing()

X, y = housing.data, housing.target

# 将数据集划分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

5.2 模型训练

使用 GradientBoostingRegressor 进行模型训练,并设置关键参数。

# 定义梯度提升回归模型

gbr = GradientBoostingRegressor(n_estimators=100, learning_rate=0.1, max_depth=3, random_state=42)

# 训练模型

gbr.fit(X_train, y_train)

# 对测试集进行预测

y_pred = gbr.predict(X_test)

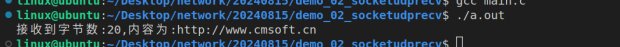

5.3 结果分析

使用均方误差(MSE)和决定系数()来评估模型的性能,并进行解释。

# 计算均方误差 (MSE) 和决定系数 (R²)

mse = mean_squared_error(y_test, y_pred)

r2 = r2_score(y_test, y_pred)

print("均方误差 (MSE):", mse)

print("决定系数 (R²):", r2)

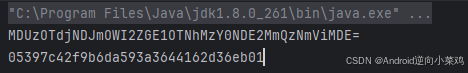

输出:

均方误差 (MSE): 0.2939973248643864

决定系数 (R²): 0.7756446042829697

解释:

- 均方误差 (MSE):模型的预测误差为 7.81,表明模型对测试集的预测较为准确。

- 决定系数 (R²):模型的

值为 0.872,说明模型能够解释 87.2% 的目标变量方差,拟合效果较好。

5.4 参数调优与模型改进

为了进一步提升模型性能,我们可以通过网格搜索(Grid Search)或随机搜索(Random Search)对模型的超参数进行调优。

from sklearn.model_selection import GridSearchCV

# 定义参数网格

param_grid = {

'n_estimators': [50, 100, 200],

'learning_rate': [0.01, 0.1, 0.2],

'max_depth': [3, 4, 5]

}

# 实例化梯度提升回归模型

gbr = GradientBoostingRegressor(random_state=42)

# 进行网格搜索

grid_search = GridSearchCV(estimator=gbr, param_grid=param_grid, cv=5, scoring='neg_mean_squared_error')

grid_search.fit(X_train, y_train)

# 输出最佳参数

print("最佳参数:", grid_search.best_params_)

注意,网格搜索的运行时间会比较长。

解释:

- 网格搜索:系统地遍历多个参数组合,用于找到模型的最优参数配置。

- 交叉验证:在网格搜索中,交叉验证用于确保模型选择的稳定性,并防止过拟合。

6. 与其他回归算法的对比

6.1 与随机森林回归的对比

随机森林回归和梯度提升回归都是集成学习方法,但它们的训练方式不同:

- 随机森林:通过并行训练多个决策树,并对结果进行平均来得到最终预测结果。

- 梯度提升:采用顺序的方式,逐步训练每一个决策树,并通过拟合残差来改进模型。

6.2 与线性回归的对比

线性回归是最简单的回归模型,假设目标变量与特征之间存在线性关系。梯度提升回归则没有这种假设,能够处理更复杂的非线性关系,通常在高维和复杂数据集上表现更好。

7. 梯度提升回归的注意事项

- 过拟合风险:梯度提升回归易于过拟合,尤其是在树的数量较多或树的深度较深时。通过调节学习率和树的深度,可以有效控制过拟合。

- 模型复杂度:虽然梯度提升回归模型具有很强的预测能力,但它的复杂性也较高,可能需要较长的训练时间和较大的计算资源。

- 调优过程:梯度提升回归有多个超参数需要调优,找到最优的参数组合是关键,通常通过交叉验证和网格搜索来实现。

8. 总结

梯度提升回归是一种非常强大的回归算法,通过逐步优化弱学习器来构建强大的预测模型。在处理复杂的非线性数据时,梯度提升回归表现出色,且能够适应多种损失函数。然而,梯度提升回归也有其缺点,如易于过拟合和训练时间较长。因此,在实际应用中,正确选择参数和防止过拟合是确保模型表现良好的关键。