超简单理解LSTM和GRU模型

news2026/2/15 18:31:02

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/2042577.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

成功的秘诀:客户推荐推动 SaaS 成功的4个原因

在竞争激烈的SaaS市场中,脱颖而出并非易事。客户推荐合作伙伴关系正是这样一种强大的营销渠道,它利用口碑传播的力量,将满意的客户转变为品牌倡导者,从而显著提升品牌信誉和市场影响力。

您的 SaaS 品牌应该接受客户推荐营销的4 …

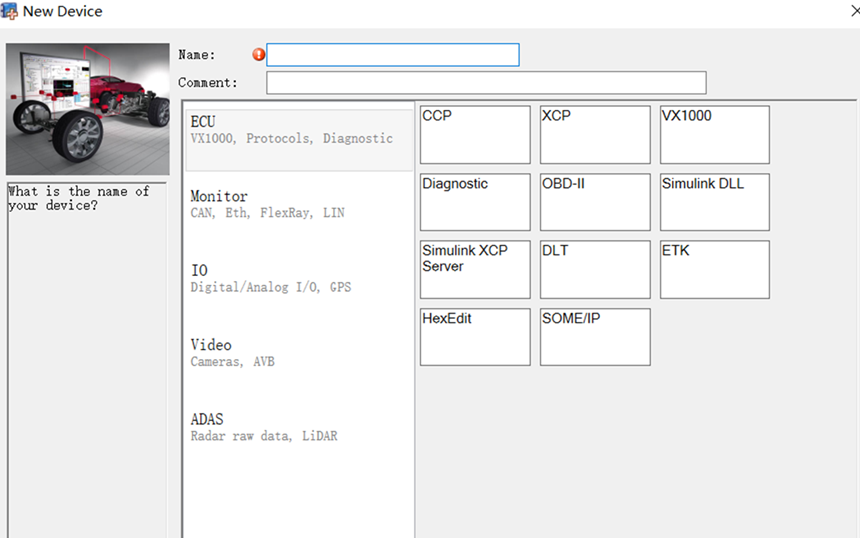

车载测试与分析的利器之CANoe

连接汽车神经网络的专家 CANoe不仅是一款强大的总线分析工具,它还集成了仿真、标定和诊断功能,为汽车工程师提供了全方位的车载网络解决方案。从基础的信号监测到复杂的网络交互测试,CANoe凭借其灵活性和高效性,成为了车载测试工程…

浏览器后门:保护影子 IT 的新前线

浏览器扩展是网络犯罪分子的主要目标。这不仅仅是消费者的问题,也是企业对抗影子 IT 的新领域。

最终,扩展权限越多,攻击面就越大。研究表明,平均每个企业的生态系统中都有近 1500 个浏览器扩展程序 - 即使是一个不良插件也可能导…

线上o2o商城小程序源码系统 带完整的安装代码包以及搭建部署教程

系统概述

在数字化时代,线上线下融合(O2O)的商业模式已成为推动零售业发展的新引擎。为了满足商家快速构建高效、便捷、用户友好的电商平台需求,我们精心研发了一款线上O2O商城小程序源码系统。该系统不仅配备了完整的安装代码包…

STM32F103-固件库开发-keil一些警告解决-中断机制-NVIC-简单按钮电灯流程及其代码;

1、固件库和HAL库

固件库(Standard Peripheral Library,通常被称为SPL)和HAL库(Hardware Abstraction Layer,硬件抽象层)都是STMicroelectronics(ST)为STM32系列微控制器提供的软件…

腾讯云AI代码助手:智能编程的新篇章,大家的代码开发伙伴

文章目录 一、前言二、开发环境介绍三、腾讯云AI代码助手使用实例1、案例一:代码补全2、案例二:代码注释和解释等3、案例三:与AI对话实现需求 四、获得的帮助与提升五、建议六、结语 一、前言

随着人工智能技术的飞速发展,其在各…

自制神之嘴: fish-speech 容器镜像 (文本转语音 AI 大模型)

穷, 没有 N 卡 ! 穷, 没有 N 卡 ! 穷, 没有 N 卡 !! (重要的事情说 3 遍. )

最近发现了一个很新的 AI (神经网络) 文本转语音大模型: https://speech.fish.audio/

fish-speech 可以根据输入的文本, 生成高质量的人类说话声音, 效果挺好的. fish-speech 官方已经提供了容器 (d…

2.3 不同数据库管理系统的比较与应用场景

欢迎来到我的博客,很高兴能够在这里和您见面!欢迎订阅相关专栏: 工💗重💗hao💗:野老杂谈 ⭐️ 全网最全IT互联网公司面试宝典:收集整理全网各大IT互联网公司技术、项目、HR面试真题.…

[LitCTF 2024]浏览器也能套娃?

题目有标志SSRF SSRF(Server-Side Request Forgery:服务器端请求伪造) 是一种由攻击者构造形成由服务端发起请求的一个安全漏洞。一般情况下,SSRF攻击的目标是从外网无法访问的内部系统。(正是因为它是由服务端发起的,所以它能够请求到与它相…

[算法题]01 矩阵

题目链接: 01 矩阵

多源BFS类型题, 即给定多个起点, 判断从哪个起点走到终点距离最短, 一般解题思路为将所有起点看成一个"起点", 由此"起点"做bfs得到题解, 实际代码编写将所有起点都入队列, 每次都对所有起点做一层扩展.

题解思路:

从1往0处走寻找最短…

kali-linux 常用命令大集合(目录、文件查看与编辑,登录、电源、帮助等相关命令详解)

目录

目录查看-ls

帮助命令

帮助命令:whatis

帮助命令:help

帮助命令:man

帮助命令:info

登录命令

登录命令:login

登录命令:last

登录命令:exit 切换用户:su/sudo

命令-…

嵌入式学习day17(顺序表)

大纲 线性表是最基本、最简单、也是最常用的一种数据结构,可以存储逻辑关系为线性的数据。线性表(linear list)是数据结构的一种,一个线性表是n个具有相同特性的数据元素的有限序列。 分类: 顺序表、单向链表、单向循环…

WhatsApp代理地址:如何成功连接WhatsApp?

所有外贸人都非常需要通过WhatsApp与客户沟通,简直是搞钱“生命线”!但是,很多老板在后台抱怨说自己一直登不进去,99.99%是你网络问题。很多外贸人找的代理IP来路不明或者滥竽充数,要和很多人一起共用IP或者IP地址总是…

【PGCCC】使用 Postgres 递归 CTE 进行图形检索

您是否知道可以将 Postgres 用作某些用例的图形数据库?

假设您有如下图表: 我们可以在 NetworkX 中构建此图: 1import networkx as nx23G nx.Graph()45G.add_edges_from([6 ("A", "B"),7 ("A", "…

HAproxy 七层负载均衡调度器详解及配置

HAproxy 七层负载均衡

负载均衡技术

负载均衡(Load Balance):一种服务,或基于硬件设备实现的高可用的反向代理技术,是指将特定的业务流量分摊给一个或多个后端的特定服务器或设备,实现高并发处理业务流量…

![[LitCTF 2024]浏览器也能套娃?](https://i-blog.csdnimg.cn/direct/dcc10e1d4a7c4b47a7fbac293813fac3.png)

![[算法题]01 矩阵](https://i-blog.csdnimg.cn/direct/d12b2c8547c6415b81309f39350696fa.png)