日前,高通技术标准高级总监托马斯·斯托克哈默尔(Thomas Stockhammer)和高通技术标准总监伊梅德·布亚齐兹(Imed Bouazizi)撰文分享了ISO和Khronos之间是如何紧密合作,并最终开发出MPEG-I Scene Description ISO/IEC 23090标准,包括将glTF 2.0纳入MPEG-I Scene Description的过程,以及内容创建者和开发者可以如何开始使用这个新标准来开发交互式实时应用。下面是具体的整理:

添加图片注释,不超过 140 字(可选)

标准开发是标准开发组织之内和之外的高度协作性工作。我们在3GPP和MPEG工作组中都非常活跃,而我们在3GPP方面的工作启发着我们在解决MPEG中出现的一个新挑战:XR应用的交互式场景描述。

最终,我们对可用于最后一英里的XR场景描述,并解决各种设备问题(包括未来的轻量级移动AR设备)的场景描述格式的追寻之旅促使我们与Khronos密切合作,并在MPEG-I Scene Description中开发一套glTF 2.0扩展。新完成的MPEG-I Scene Description ISO/IEC 23090标准基于glTF 2.0,并采用MPEG供应商扩展框架。

在glTF会议演示中,我们分享了引导我们开发glTF的用例和需求,并详细介绍了扩展的架构。下面这篇博客总结了所述演示,解释了将glTF 2.0纳入MPEG-I Scene Description的过程,以及内容创建者和开发者可以如何开始使用这个新标准来开发交互式实时应用。

用例

元宇宙应用要求多人能够同时访问和共享动态场景。理想情况下,用户应该能够拥有类似的体验,不受个人硬件、计算或网络限制的影响。我们根据两个离散的用例来处理这个挑战。

首先,我们着眼于在AR/VR/MR中访问交互式3D场景的娱乐需求,如游戏,电影和戏剧等。这个用例需要考虑如下事项:

-

需要共同下载或流式传输,同时并行渲染的静态和动态对象。

-

巨大的容量和数据量,给网络带来压力。

-

使用各种输入类型的交互式和沉浸式体验,包括控制器,身体动作和双手等。

-

不同的媒体,包括3D和2D视觉信息、音频、触觉信息等。

-

多种访问机制,包括下载和智能串流。

-

各种硬件,从强大的游戏PC到相对有限的移动设备。

另外,我们研究了XR呼叫和会议的新兴应用,目的是将现有的基于IMS和webRTC的电话服务扩展为具有AR支持的沉浸式多用户体验。这种应用涉及创建共享的虚拟现实或混合现实空间,并允许用户在其中进行交互:而远程用户可以使用逼真的3D Avatar加入会议,并贡献2D和3D内容。

过程

两个用例共享相同的high-level过程:

-

使用单一的中央场景合成功能,场景可以在不同的参与者之间共享。

-

参与者和节点添加到场景中。

-

场景会随着新用户的加入、新对象的添加和新asset的共享而动态更新。

-

参与者可以与动画,动作,Avatar等进行交互,从而触发将场景更新分发给所有参与者。

添加图片注释,不超过 140 字(可选)

为了促进跨不同硬件的用例,我们需要一种交换格式来动态地描述场景,为场景做出贡献,并聚合对象。

目标设备

添加图片注释,不超过 140 字(可选)

我们的目标设备是AR眼镜参考。这款参考设备是一副非常基础的AR眼镜,处理能力、功耗和重量都有限。这是一种用户可以长时间佩戴或定期佩戴的设备。我们希望在这种类型的目标设备访问丰富和轻量级的场景。

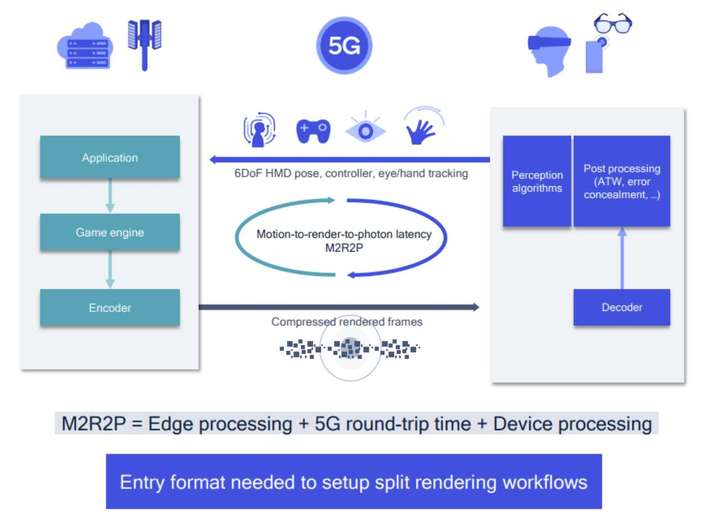

我们期望分布式计算架构成为这种设备访问复杂、动态场景的主要组件。使用这种方法,开发者可以在网络服务器操作游戏引擎,将场景“预烘培”成设备可以渲染的格式。在最简单的形式中,Split-Rendering拆分渲染架构可能只使用运行时应用进行一定的后处理。

添加图片注释,不超过 140 字(可选)

这种方法分割了运行应用所需的GPU功率。然而,由于需要追踪身体运动并实现交互性和沉浸感,实时应用同时必须在延迟受限的环境中运行。所以,拆分渲染工作流需要一种会话描述输入格式,以确保渲染帧内场景和对象的适当同步功能交换和描述。这种输入格式预计将由XR播放器端点处理,根据输入点文档中的信息设置交付、解码和渲染的管道。

选择glTF

在为MPEG中的沉浸式媒体指定技术的早期过程中,已经确定了对沉浸式体验的灵活和动态场景描述解决方案的需求。在寻找解决这一差距的方案时,MPEG回顾了现有技术,以确定具有成功部署和广泛使用历史的格式。然后小组评估它们是否能够满足所确定的需求,或者是否需要从零定义新的格式。

我们对消费者设备的最后一英里分布问题特别感兴趣,这需要我们降低复杂性,扁平化架构,并压缩组件以实现有效的网络使用。一种有效的方法需要适应设备和网络,支持纹理、光照烘焙等功能。

glTF作为一个典型的选择脱颖而出。glTF 2.0已经提供了大量的基线功能:它标准化了3D场景和模型的创建,是一个开放的标准。它通常称为“3D的JPEG”,具有实现我们目的所需的众多功能。我们面临的挑战是确定我们是否可以扩展glTF来集成新的实时媒体元素,如动态点云、动态网格和2D内容。我们想开发类似于“面向XR和元宇宙的HTML5”。使用现有的编解码器,HTML5在整合实时多媒体元素和支持不同消费环境和地理位置的同时,使得Web的媒体更加适合移动设备。我们设想通过扩展glTF,以类似的方式来确保MPEG对XR更友好。

至关重要的是,使用glTF将MPEG扩展到XR将为3D体验创建一个供应商中立的入口点,这样用户就不需要依赖专有的应用或平台。基于标准的方法是灵活和可分发的,支持高度可移植和可互操作的共享体验。

现在,通过与Khronos的紧密合作,我们已经完成了第一个版本的MPEG-I Scene Description ISO/IEC 23090,将glTF 2.0集成到MPEG供应商扩展框架中。

MPEG场景描述架构

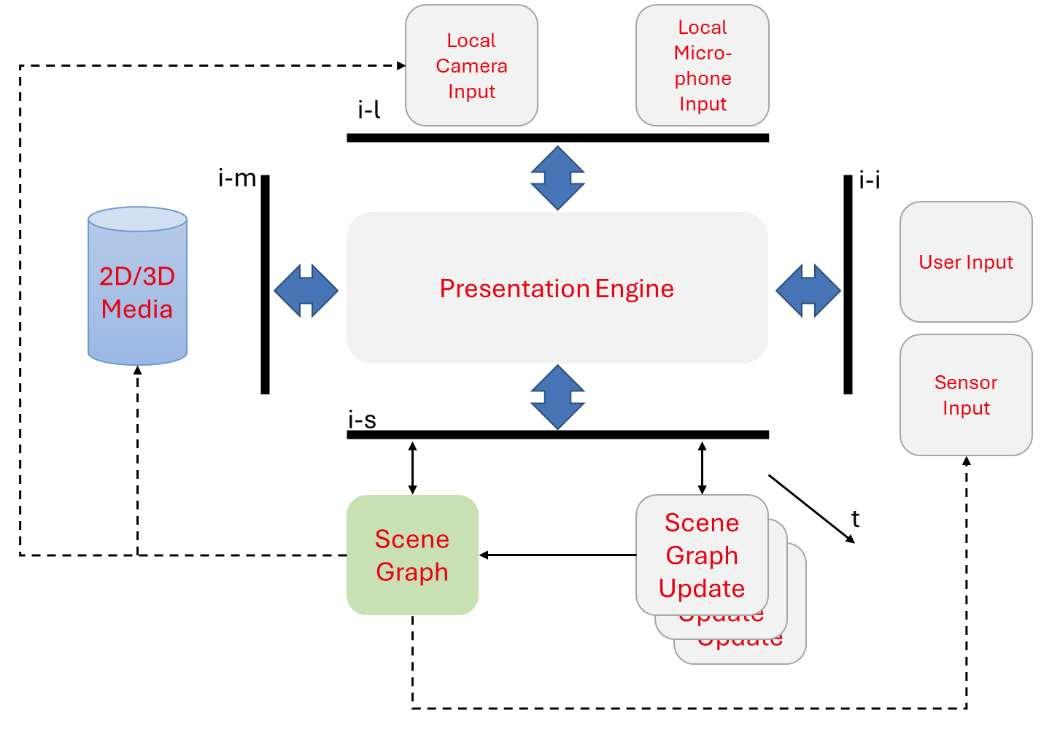

表示引擎是MPEG场景描述架构的核心。它类似于HTML应用程序中的浏览器:表示引擎旨在跨各种平台和设备提供一致的体验。

添加图片注释,不超过 140 字(可选)

用户进入沉浸式体验的切入点是场景描述文档或场景图。表示引擎从称为S接口的单独接口检索场景图和任何后续场景更新。例如,在我们的会议室用例中,所有的交互(用户加入和离开、分享内容、改变姿势等等)都是场景更新,然后镜像为共享环境的当前状态。

接下来,表示引擎与媒体访问函数通信,告诉它需要加载什么媒体和数据集,包括它们的所有组件。场景图包含了如何访问所有组件的描述,然后将信息转发给媒体访问函数以加载媒体。

额外的接口处理本地交互和交互体验,这是我们目标实现的沉浸式体验的核心。

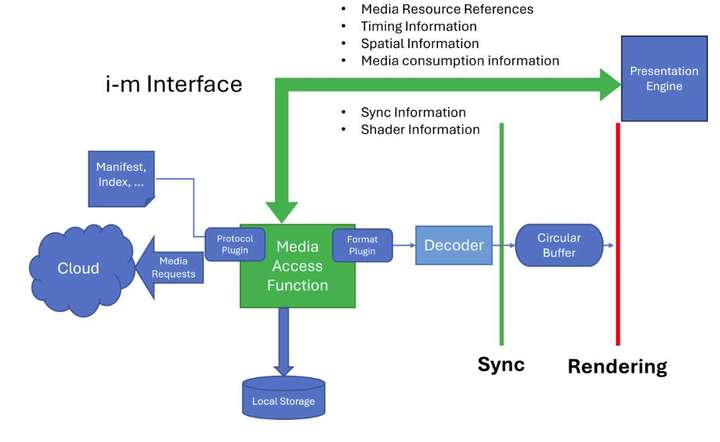

添加图片注释,不超过 140 字(可选)

从上图可以看到表示引擎和媒体访问功能之间接口的详细视图。这个接口记录在ISO/IEC specification 2390, Part 14,其中定义了架构、接口和API,例如Media Access Function API和Buffer API。我们的目标是将媒体层与表示引擎分开。理想情况下,表示引擎应该不受HEVC或AV1等网格或视频纹理压缩技术的影响。

添加图片注释,不超过 140 字(可选)

Media Access Function API接收媒体描述及其位置,为所引用的媒体寻求最佳编码或访问路径。它建立了一个特定于媒体格式的管道,确保通过Buffer接口将原始媒体交付给表示引擎。然后,接口将解码和解密的媒体存储在Buffer中,而Buffer的描述在场景图中提供。场景描述提供了对glTF访问器和Buffer等功能的理解,确保表示引擎可以毫不费力地获取和呈现数据。

Media Access Function API的核心功能之一是优化。根据网络变化或用户在虚拟场景中的视点等因素,它可能决定不获取视图之外的特定场景元素或调整所获取媒体的细节级别。这个AP同时允许你提供时间、空间、同步、着色器和媒体消耗数据。

添加图片注释,不超过 140 字(可选)

例如,一个动态网格可能有一个需要视频纹理的组件。Media Access Function获得确实纹理可用的请求,查看替代方案,并构造针对特定访问技术定制的媒体管道。管道获取和解码媒体,如果需要,执行必要的后处理,如YUV到RGB转换。然后,它将媒体传递到Buffer,以供表示引擎检索。

MPEG-I Scene Description ISO/IEC 23090的第一阶段

在第一阶段,MPEG工作组的目标是为glTF引入一个动态的、基于时间的维度。这将支持动态媒体形式,如视频纹理、音频、动态网格和点云。

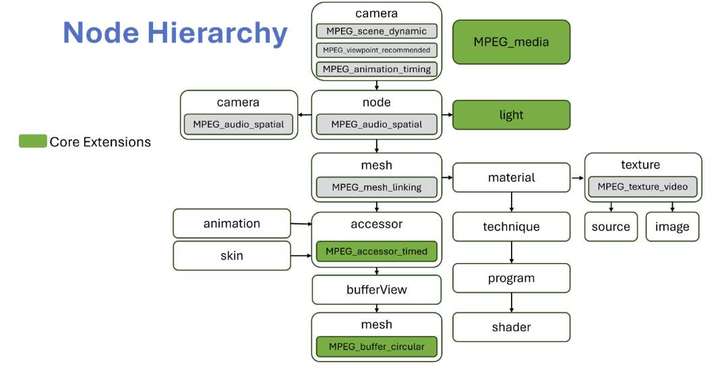

添加图片注释,不超过 140 字(可选)

在上面的插图中,三个关键的glTF扩展是绿色阴影,而依赖的扩展是灰色阴影。关键扩展包括:

-

MPEG_Media:定义对外部引用媒体的访问。

-

MPEG_accessor_timed:通知表示引擎访问器指向一个动态缓冲区。这个扩展使得表示引擎能够预期元数据可能在帧与帧之间发生变化,包括顶点数量等信息。

-

MPEG_buffer_circular:并发读写操作发生的动态缓冲区。Media Access Function写入缓冲区,而表示引擎同时从中读取。

MPEG_Media扩展提供了详细的媒体描述、播放指令和访问方法。你可以添加任意多的可选访问路径,以支持各种目标设备的可选编码或不同的媒体格式。这种灵活性意味着媒体访问功能必须智能地选择最合适的替代方案。

你可以访问各种媒体源,从使用DASH的动态流媒体集到通过WebRTC的实时媒体,甚至是本地存储的内容。系统必须解决多种挑战,包括加密内容的解密或格式之间的转换。目标始终是满足表示引擎的期望。

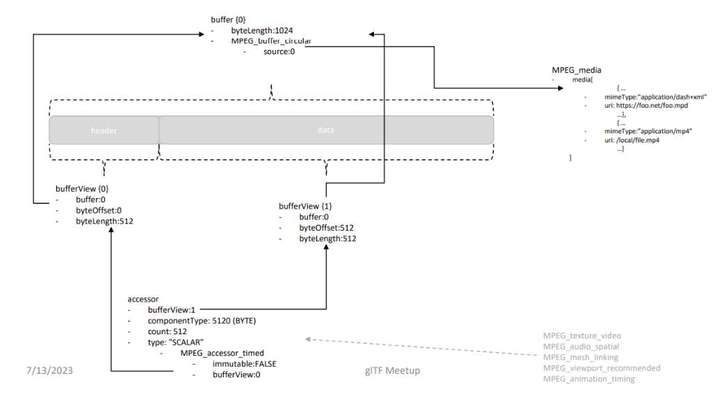

添加图片注释,不超过 140 字(可选)

MPEG_buffer_circular和MPEG_accessor_timed扩展一起工作以确保同步并防止冲突。MPEG_buffer_circular支持缓冲区管理,它告诉表示引擎为媒体管道创建一个具有推荐帧数的循环缓冲区。目标是防止由于读写过程之间的速度差异而导致的丢帧。

添加图片注释,不超过 140 字(可选)

目前,glTF使用静态缓冲区。MPEG_accessor_timed扩展引入了对动态缓冲区的支持,从而启用实时和流媒体。可以设置不同的访问器参数,从而提供基于潜在数据动态的灵活性。例如,在视频纹理的情况下,特定参数,如视频宽度和高度,即便在自适应流媒体播放时都保持一致。所以,它们标记为静态。

相反,在像动态网格这样的情况下,所有参数,如顶点和面的数量,都可能在帧与帧之间发生变化。MPEG_accessor_timed允许你访问另一个包含动态参数的缓冲区视图,允许描述这种频繁的更改。

MPEG_accessor_timed有Accessor和bufferView字段的header,而它们可能会随着时间的推移而改变:

Accessor信息:

-

componentType

-

bufferView

-

type

-

normalized

-

byteOffset

-

count

-

max

-

min

bufferView信息:

-

bufferViewByteOffset

-

bufferViewByteLength

-

bufferViewByteStride

这种动态缓冲区的使用是可选的,从而增加了适应性,而且没有不必要的复杂性。

视频纹理是最早使用这个概念的扩展之一:定时访问器告诉呈现引擎,它需要启动一个动态缓冲区来访问视频纹理。如果设备或系统不支持视频纹理,它可以默认为常规静态图像占位符。

MPEG_audio_spatial

MPEG工作组同时为空间音频创建了glTF扩展,以实现更身临其境的体验。在当前的扩展中,支持的格式包括基于单对象的源和HOA。

音频源可以与效果相关联。当前版本的规范支持混响。

MPEG_audio_spatial允许你使用“audio listener”节点跟踪用户的位置。我们建议将“audio listener”添加为场景camera的子节点或camera的扩展。这允许MPEG_audio_spatial根据用户的移动进行调整,并提供真实的声音方向。

额外的第一阶段

MPEG-I Scene Description ISO/IEC 23090的第一阶段开发同时包括各种相关的glTF扩展,支持主要扩展的功能:

-

MPEG_scene_dynamic:表示场景描述文档将更新。

-

MPEG_viewport_recommended:提供动态变化的信息,包括节点和相机对象的平移和旋转,以及camera对象的intrinsic camera参数。

-

MPEG_animation_timing:提供MPEG媒体时间线和glTF 2.0定义的动画时间线之间的对齐。

演示

MPEG工作组正在致力于开源MPEG-I Scene Description ISO/IEC 23090的Unity Player实现。你可以通过YouTube(https://www.youtube.com/watch?v=U9VgiYORNrA)查看所述实现的简短演示。

值得一提的是,工作组同时致力于Blender的实现,这样你就可以使用MPEG-I场景描述来创作和导出场景。

第二阶段和未来的glTF扩展

添加图片注释,不超过 140 字(可选)

在第二阶段,MPEG工作组将开发额外的glTF扩展,并旨在通过整合新功能来丰富用户体验,从而弥合MPEG- i和glTF与我们目标XR用例之间的任何现有差距。第二阶段引入对以下方面的支持:

-

增强现实

-

增强交互性

-

动态照明

-

触觉反馈

-

六自由度

-

改进的音频

MPEG_scene_anchor和MPEG_node_anchor确保扩展现实中的平滑功能,允许AR用户将虚拟场景锚定到现实世界,使其感觉像是房间或办公室的一部分。

这样做的目的是确保场景描述传达给接收者关于环境中特定的“可追踪物”。这可能是熟悉的功能,如地板,但同时可能是特定于应用的元素,如二维码。这种指导有助于将虚拟场景锚定在现实世界中。

MPEG_scene_interactivity和MPEG_node_interactivity基于将触发器链接到操作的行为进行操作。触发器可以是碰撞、接近用户输入或对象可见性等事件。动作可以包括激活或转换对象、启动动画、改变材质或启动触觉反馈。

MPEG工作组同时在通过MPEG_node_avatar集成Avatar。在其核心,Avatar本质上是网格,潜在的动态或动画。Avatar可以实现交互性。它们就像你的数字孪生,允许你用双手与对象交互,比如打开电视、开门或关灯。对虚拟角色进行分割非常重要,这样就可以识别出特定的身体部位以便进行交互,比如手或手指。这个扩展将利用由VRM Consortium等开发的基于glTF的表示格式,并使这样的Avatar集成到交互场景。

另外,我们正通过MPEG_dynamic_light_texture_based开发动态照明。在AR应用程序中,这个扩展将允许你监控当前的光线条件并相应地调整渲染。

触觉扩展MPEG_haptic和MPEG_material_haptic支持各种功能,如刚度,摩擦和温度。我们的目标是纳入当前和未来的触觉响应。我们的系统支持基于触发器的多种触觉体验,例如虚拟对象的纹理。例如,用手触摸数字墙可能会根据其纹理(平滑或粗糙)提供特定的触觉反馈。

MPEG工作组同时在加强我们的音频支持。我们的目标是集成一个六自由度音频解决方案,以提供更加身临其境的声音体验。系统将考虑声学材质等因素,为音频提供类似于PBR的体验。

总结

glTF已证明是一种有效且易于扩展的MPEG 3D格式,可将XR应用的交互式场景描述与新完成的MPEG- i ISO/IEC 23090标准集成。ISO的MPEG工作组期待着扩大与Khronos的合作,继续扩展glTF,将交互式3D和流媒体世界结合在一起。