目录

- 什么是数据编制?

- 数据编制的重要性

- 数据编制的基本流程

- 1. 数据收集

- 2. 数据清洗

- 3. 数据转换

- 4. 数据结构化

- 5. 数据集成

- 6. 数据验证

- 数据编制的最佳实践

- 1. 制定数据标准

- 2. 自动化流程

- 3. 版本控制

- 4. 数据质量监控

- 5. 文档化

- 6. 安全性和隐私保护

- 数据编制中的常见挑战及解决策略

- 1. 数据质量问题

- 2. 数据规模和性能

- 3. 数据一致性

- 4. 数据隐私和合规性

- 5. 数据版本控制和可追溯性

- 数据编制工具和技术

- 1. 编程语言和库

- 2. 大数据处理框架

- 3. ETL工具

- 4. 数据质量工具

- 5. 版本控制和数据沿袭

- 6. 数据可视化工具

- 7. 数据编目和元数据管理

- 数据编制的未来趋势

- 1. 自动化和AI驱动的数据编制

- 2. 实时数据编制

- 3. 数据编制的无代码/低代码解决方案

- 4. 联邦数据编制

- 5. 可解释性和透明度

- 结论

在大数据时代,我们每天都在接触和产生海量数据。但是,原始数据往往杂乱无章、缺乏结构,难以直接应用于决策和分析。这就是数据编制发挥重要作用的地方。数据编制是将原始数据转化为有组织、易理解、可用于分析的形式的过程。它是数据处理和分析的基础,对于充分发挥数据价值至关重要。

本文将深入探讨数据编制的概念、流程、方法和最佳实践,帮助你全面理解这一关键的数据处理环节。无论你是数据分析师、数据科学家,还是对数据处理感兴趣的读者,相信这篇文章都能为你提供有价值的见解。

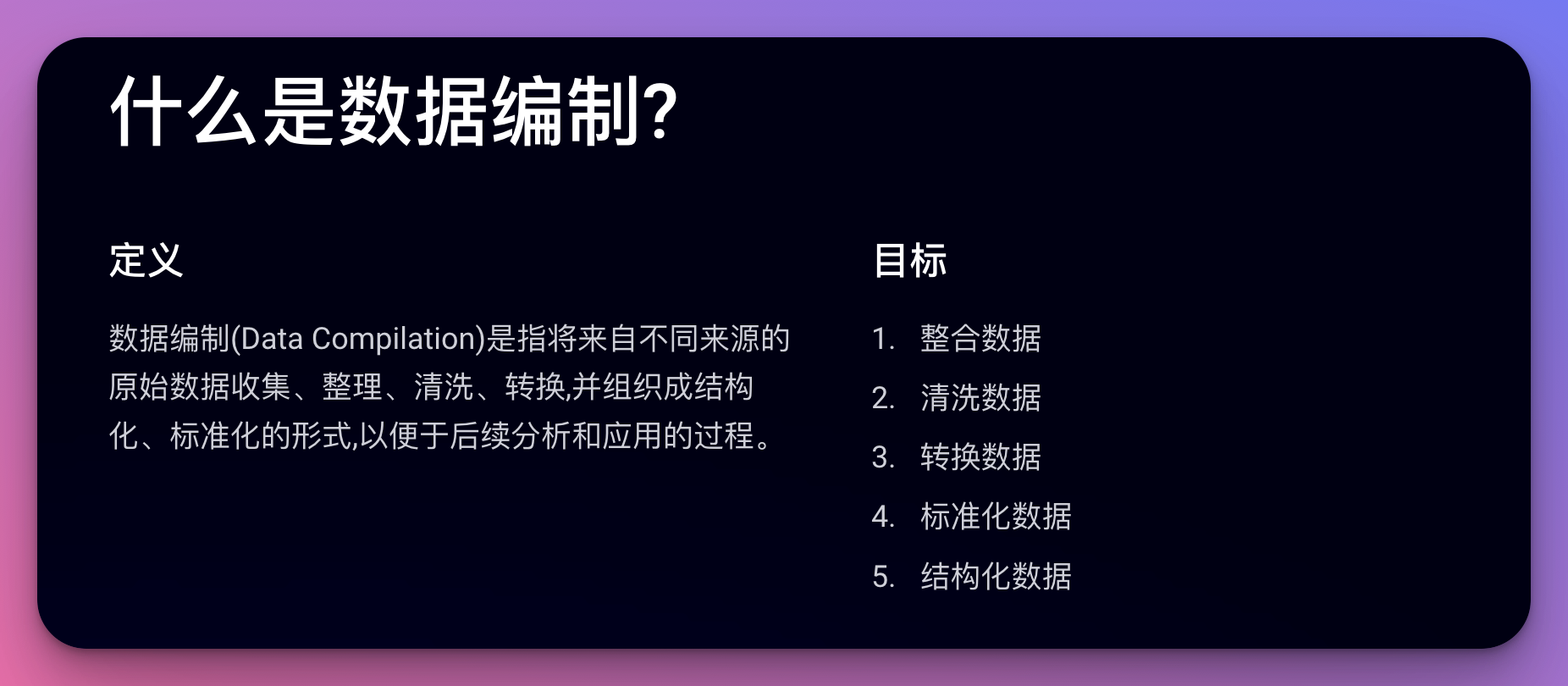

什么是数据编制?

数据编制(Data Compilation)是指将来自不同来源的原始数据收集、整理、清洗、转换,并组织成结构化、标准化的形式,以便于后续分析和应用的过程。它是数据预处理的重要组成部分,为数据分析和挖掘奠定基础。

数据编制的主要目标包括:

- 整合数据:将分散在不同来源的数据汇总到一起。

- 清洗数据:识别和处理错误、重复、缺失等问题。

- 转换数据:将数据转换为适合分析的格式和结构。

- 标准化数据:统一数据的格式、单位、编码等。

- 结构化数据:为非结构化或半结构化数据赋予明确的结构。

通过数据编制,我们可以将杂乱无章的原始数据转化为高质量、易于使用的数据集,为后续的数据分析和决策提供可靠的基础。

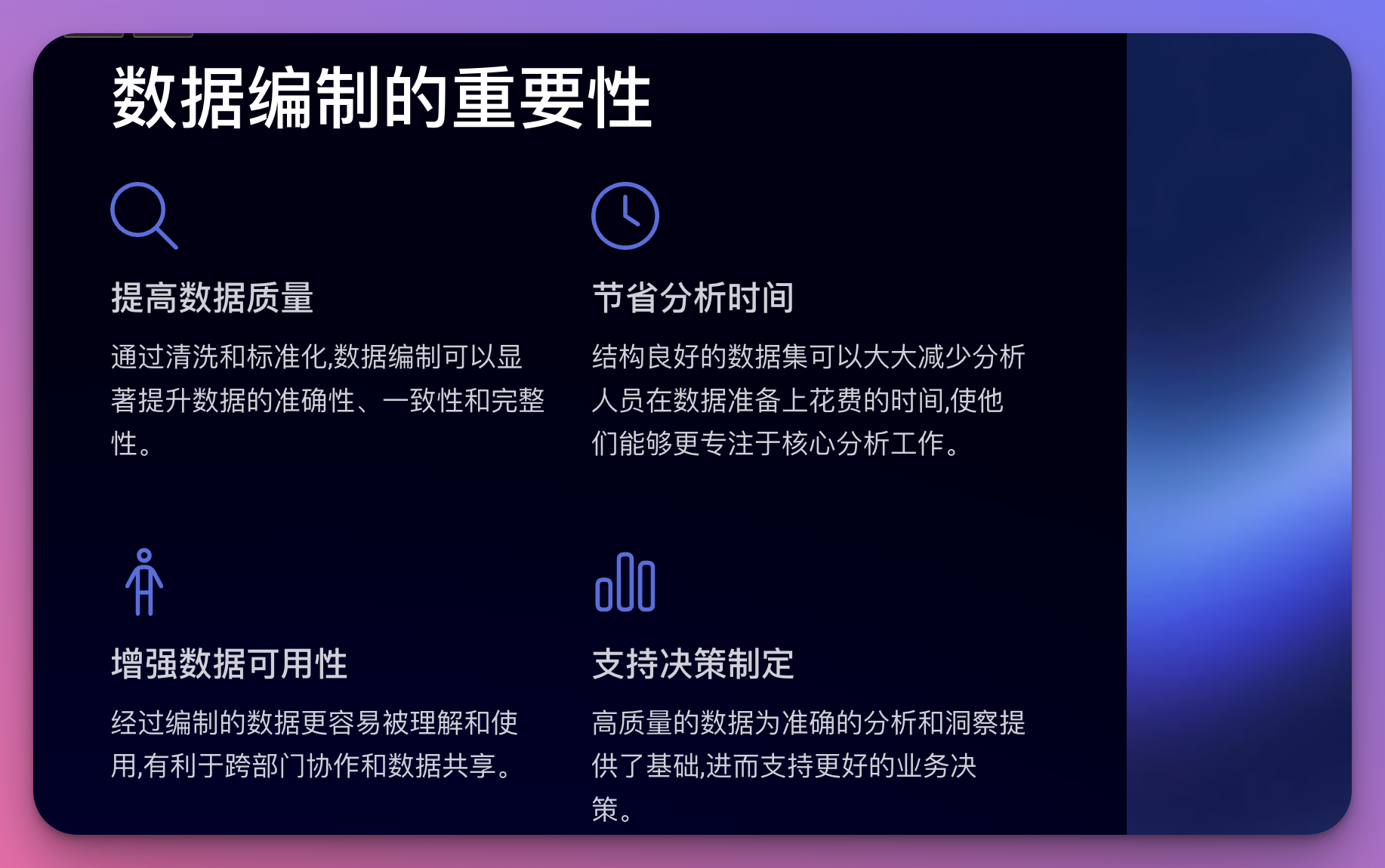

数据编制的重要性

在进入具体的数据编制流程之前,让我们先来了解一下为什么数据编制如此重要:

-

提高数据质量:通过清洗和标准化,数据编制可以显著提升数据的准确性、一致性和完整性。

-

节省分析时间:结构良好的数据集可以大大减少分析人员在数据准备上花费的时间,使他们能够更专注于核心分析工作。

-

增强数据可用性:经过编制的数据更容易被理解和使用,有利于跨部门协作和数据共享。

-

支持决策制定:高质量的数据为准确的分析和洞察提供了基础,进而支持更好的业务决策。

-

促进数据集成:标准化的数据更容易与其他系统和数据源集成,实现更全面的数据视图。

-

确保合规性:通过规范化处理,可以确保数据符合相关的法律法规和行业标准。

-

提高分析效率:结构化的数据集能够更快速地进行查询和分析,提高整体的数据处理效率。

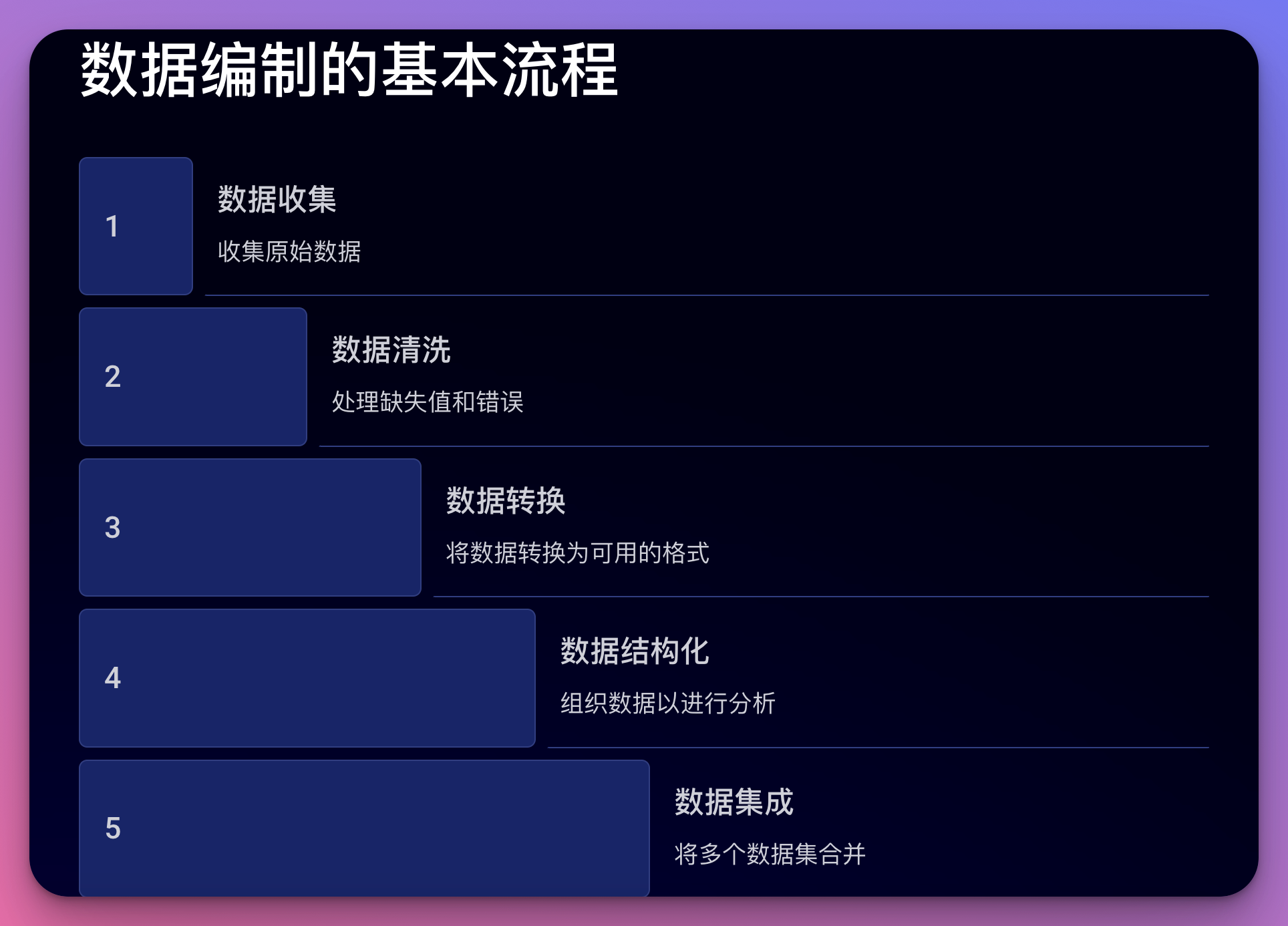

数据编制的基本流程

数据编制是一个系统性的过程,通常包括以下几个关键步骤:

1. 数据收集

首先需要从各种来源收集相关的原始数据。这些来源可能包括:

- 数据库系统

- 文件系统(CSV, Excel等)

- API接口

- 网络爬虫

- 传感器数据

- 手动输入

在这个阶段,重要的是要确保数据的完整性和真实性,同时要注意数据收集的合法性和道德性。

2. 数据清洗

收集到的原始数据通常存在各种问题,需要进行清洗:

- 处理缺失值:可以选择删除、填充平均值或使用高级插补技术。

- 去除重复数据:识别和删除重复的记录。

- 纠正错误数据:修正明显的错误,如年龄为负数等。

- 标准化格式:统一日期格式、数字精度等。

Python示例:使用pandas进行基本的数据清洗

import pandas as pd

import numpy as np

# 读取CSV文件

df = pd.read_csv('raw_data.csv')

# 处理缺失值

df['age'].fillna(df['age'].mean(), inplace=True)

# 去除重复行

df.drop_duplicates(inplace=True)

# 纠正错误数据

df.loc[df['age'] < 0, 'age'] = np.nan

# 标准化日期格式

df['date'] = pd.to_datetime(df['date'])

# 保存清洗后的数据

df.to_csv('cleaned_data.csv', index=False)

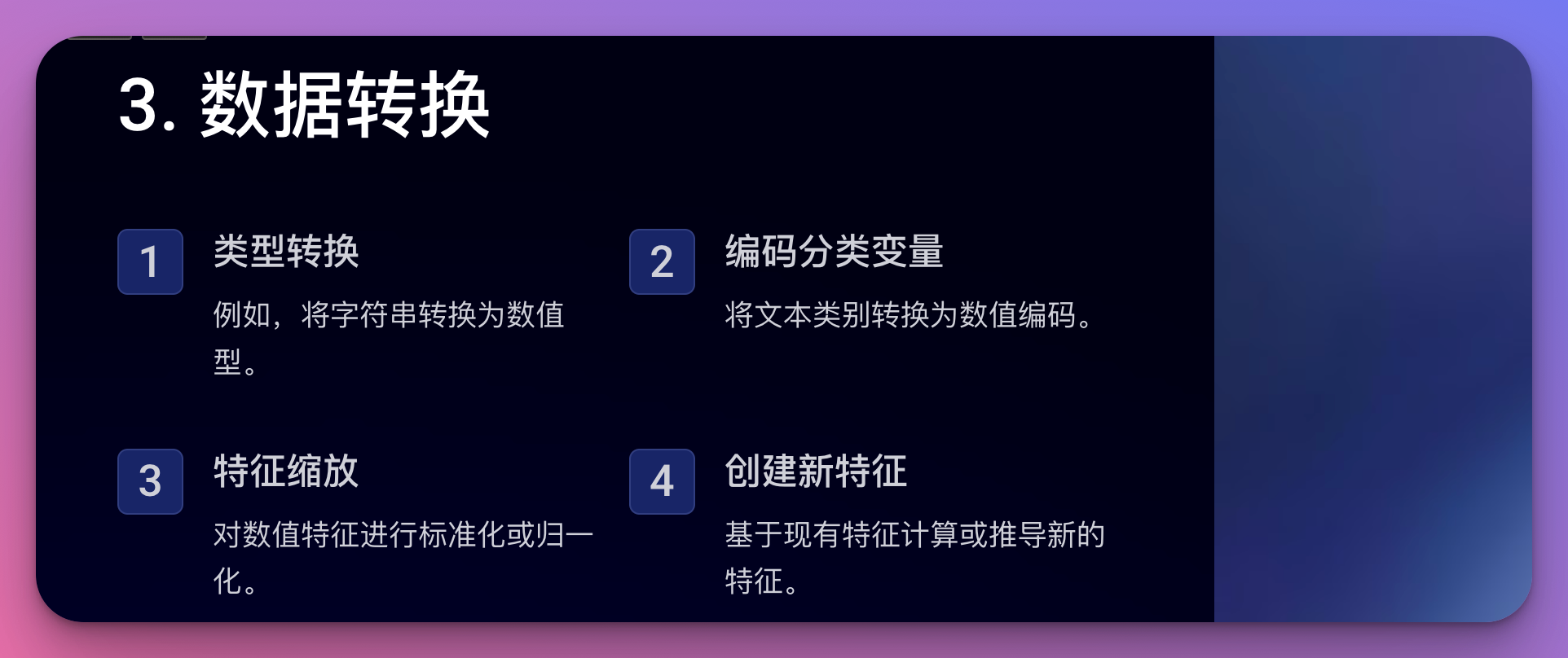

3. 数据转换

根据分析需求,可能需要对数据进行各种转换:

- 类型转换:如将字符串转换为数值型。

- 编码分类变量:将文本类别转换为数值编码。

- 特征缩放:对数值特征进行标准化或归一化。

- 创建新特征:基于现有特征计算或推导新的特征。

Python示例:数据转换操作

import pandas as pd

from sklearn.preprocessing import LabelEncoder, StandardScaler

# 读取清洗后的数据

df = pd.read_csv('cleaned_data.csv')

# 类型转换

df['income'] = df['income'].astype(float)

# 编码分类变量

le = LabelEncoder()

df['gender'] = le.fit_transform(df['gender'])

# 特征缩放

scaler = StandardScaler()

df['age_scaled'] = scaler.fit_transform(df[['age']])

# 创建新特征

df['income_per_age'] = df['income'] / df['age']

# 保存转换后的数据

df.to_csv('transformed_data.csv', index=False)

4. 数据结构化

对于非结构化或半结构化的数据,需要进行结构化处理:

- 文本数据:提取关键信息,转换为结构化字段。

- JSON/XML:解析并转换为表格形式。

- 图像/音频:提取元数据或特征,转换为结构化数据。

Python示例:处理JSON数据

import json

import pandas as pd

# 读取JSON文件

with open('data.json', 'r') as f:

json_data = json.load(f)

# 将JSON转换为DataFrame

df = pd.json_normalize(json_data)

# 处理嵌套结构

df['nested_field'] = df['nested_field'].apply(lambda x: x['sub_field'] if 'sub_field' in x else None)

# 保存为CSV

df.to_csv('structured_data.csv', index=False)

5. 数据集成

将来自不同来源的数据整合到一起:

- 数据合并:基于共同键合并多个数据集。

- 数据连接:将相关的数据集连接起来。

- 解决冲突:处理来自不同源的冲突数据。

Python示例:合并多个数据集

import pandas as pd

# 读取多个CSV文件

df1 = pd.read_csv('data1.csv')

df2 = pd.read_csv('data2.csv')

df3 = pd.read_csv('data3.csv')

# 基于共同列合并数据集

merged_df = pd.merge(df1, df2, on='id', how='outer')

merged_df = pd.merge(merged_df, df3, on='id', how='outer')

# 处理冲突数据

def resolve_conflict(row):

return row.dropna().iloc[0] if row.dropna().size > 0 else np.nan

merged_df = merged_df.groupby(merged_df.index).agg(resolve_conflict)

# 保存集成后的数据

merged_df.to_csv('integrated_data.csv', index=False)

6. 数据验证

在完成上述步骤后,需要对编制后的数据进行验证:

- 完整性检查:确保所有必要的字段都存在且有值。

- 一致性检查:验证数据是否符合预定的规则和约束。

- 准确性检查:抽样核实数据的准确性。

- 格式检查:确保数据格式符合预期。

Python示例:数据验证

import pandas as pd

import numpy as np

def validate_data(df):

# 完整性检查

missing_percentage = df.isnull().sum() / len(df) * 100

print("Missing data percentage:")

print(missing_percentage)

# 一致性检查

age_consistency = (df['age'] >= 0) & (df['age'] <= 120)

print(f"Age consistency: {age_consistency.mean()*100:.2f}%")

# 准确性检查 (示例:检查收入是否为正数)

income_accuracy = (df['income'] >= 0).mean() * 100

print(f"Income accuracy: {income_accuracy:.2f}%")

# 格式检查

date_format = df['date'].apply(lambda x: pd.to_datetime(x, errors='coerce')).notnull().mean() * 100

print(f"Date format correctness: {date_format:.2f}%")

# 读取编制后的数据

df = pd.read_csv('compiled_data.csv')

# 执行验证

validate_data(df)

数据编制的最佳实践

为了确保数据编制的质量和效率,以下是一些重要的最佳实践:

1. 制定数据标准

在开始数据编制之前,制定清晰的数据标准非常重要。这包括:

- 数据格式规范:如日期格式、数值精度等。

- 命名约定:字段名称、文件名称的统一规则。

- 编码标准:如何对分类变量进行编码。

- 数据类型定义:每个字段应使用的数据类型。

示例:数据标准文档片段

# 数据编制标准

## 1. 日期格式

所有日期字段应使用ISO 8601格式: YYYY-MM-DD

## 2. 数值精度

- 金额: 保留两位小数

- 百分比: 保留四位小数

## 3. 字段命名

- 使用小写字母和下划线

- 避免使用缩写,除非是广泛接受的缩写(如 id, url)

## 4. 分类变量编码

- 性别: 0=女性, 1=男性, 2=其他

- 是否: 0=否, 1=是

## 5. 缺失值处理

- 数值型: 使用 NaN

- 字符串: 使用空字符串 ""

2. 自动化流程

对于经常需要处理的数据,建立自动化的数据编制流程可以大大提高效率和一致性:

- 使用脚本或工作流工具自动执行重复性任务。

- 建立数据管道,实现从数据收集到验证的端到端自动化。

- 实现增量更新,只处理新增或变更的数据。

Python示例:自动化数据编制流程

import pandas as pd

import numpy as np

from sklearn.preprocessing import StandardScaler

import logging

logging.basicConfig(level=logging.INFO)

def collect_data(source):

logging.info(f"Collecting data from {source}")

# 实现数据收集逻辑

return pd.read_csv(source)

def clean_data(df):

logging.info("Cleaning data")

df.dropna(inplace=True)

df.drop_duplicates(inplace=True)

return df

def transform_data(df):

logging.info("Transforming data")

scaler = StandardScaler()

df['scaled_feature'] = scaler.fit_transform(df[['numeric_feature']])

return df

def validate_data(df):

logging.info("Validating data")

assert df.isnull().sum().sum() == 0, "Data contains null values"

assert len(df) > 0, "Dataset is empty"

return True

def main():

try:

df = collect_data('raw_data.csv')

df = clean_data(df)

df = transform_data(df)

if validate_data(df):

df.to_csv('compiled_data.csv', index=False)

logging.info("Data compilation completed successfully")

except Exception as e:

logging.error(f"Error in data compilation: {str(e)}")

if __name__ == "__main__":

main()

3. 版本控制

对数据编制过程进行版本控制,可以追踪数据的变化,并在必要时回滚到之前的版本:

- 使用版本控制系统(如Git)管理数据编制脚本。

- 为每个版本的数据集创建快照。

- 记录每次变更的详细日志。

示例:使用DVC(Data Version Control)进行数据版本控制

# 初始化DVC

dvc init

# 添加数据文件到DVC跟踪

dvc add data/raw_data.csv

# 提交更改

git add data/.gitignore data/raw_data.csv.dvc

git commit -m "Add raw data"

# 处理数据

python process_data.py

# 添加处理后的数据

dvc add data/processed_data.csv

# 提交更改

git add data/processed_data.csv.dvc

git commit -m "Add processed data"

# 推送数据到远程存储

dvc push

4. 数据质量监控

持续监控数据质量,及时发现和解决问题:

- 设置数据质量指标(如完整性、准确性、一致性)。

- 实施自动化的数据质量检查。

- 建立数据质量仪表板,实时监控关键指标。

- 设置警报机制,在数据质量异常时及时通知相关人员。

Python示例:实现简单的数据质量监控

import pandas as pd

import numpy as np

from datetime import datetime

import smtplib

from email.mime.text import MIMEText

def check_data_quality(df):

quality_metrics = {

'completeness': df.notnull().mean().mean() * 100,

'uniqueness': (1 - df.duplicated().sum() / len(df)) * 100,

'consistency': (df['age'] >= 0).mean() * 100,

'validity': df['email'].str.contains('@').mean() * 100

}

return quality_metrics

def send_alert(message):

sender = 'alert@example.com'

receivers = ['admin@example.com']

msg = MIMEText(message)

msg['Subject'] = 'Data Quality Alert'

msg['From'] = sender

msg['To'] = ', '.join(receivers)

try:

with smtplib.SMTP('localhost') as server:

server.sendmail(sender, receivers, msg.as_string())

print("Alert sent successfully")

except Exception as e:

print(f"Failed to send alert: {e}")

def monitor_data_quality():

df = pd.read_csv('latest_data.csv')

quality_metrics = check_data_quality(df)

threshold = 95 # 设定质量阈值

for metric, value in quality_metrics.items():

if value < threshold:

alert_message = f"Data quality alert: {metric} is below threshold. Current value: {value:.2f}%"

send_alert(alert_message)

# 记录质量指标

with open('quality_log.csv', 'a') as f:

f.write(f"{datetime.now()},{','.join(map(str, quality_metrics.values()))}\n")

if __name__ == "__main__":

monitor_data_quality()

5. 文档化

详细记录数据编制的每个步骤,包括:

- 数据源信息

- 数据处理逻辑

- 使用的工具和版本

- 已知的数据限制和注意事项

- 数据字典,解释每个字段的含义和格式

示例:数据编制文档模板

# 数据编制文档

## 1. 项目概述

- 项目名称: [项目名称]

- 目的: [描述数据编制的目的]

- 负责人: [负责人姓名]

## 2. 数据源

- 源1: [数据源名称]

- 类型: [如数据库, API, 文件等]

- 位置: [URL或文件路径]

- 更新频率: [如每日, 每周, 实时等]

## 3. 数据处理流程

1. 数据收集

- [描述如何收集数据]

2. 数据清洗

- [列出主要的清洗步骤]

3. 数据转换

- [描述主要的转换操作]

4. 数据集成

- [如何将多个数据源整合]

5. 数据验证

- [验证步骤和标准]

## 4. 使用的工具和版本

- Python: [版本号]

- pandas: [版本号]

- scikit-learn: [版本号]

- [其他相关工具和库]

## 5. 注意事项和限制

- [列出使用此数据集时需要注意的事项]

- [说明数据的任何已知限制]

## 6. 数据字典

| 字段名 | 类型 | 描述 | 示例 |

|--------|------|------|------|

| id | int | 唯一标识符 | 1001 |

| name | str | 用户姓名 | John Doe |

| age | int | 用户年龄 | 30 |

| ... | ... | ... | ... |

## 7. 更新历史

- [日期]: [更新描述]

- [日期]: [更新描述]

6. 安全性和隐私保护

在数据编制过程中,确保数据的安全性和隐私保护至关重要:

- 实施数据脱敏,如加密敏感信息。

- 遵守数据保护法规(如GDPR, CCPA)。

- 限制对原始数据的访问,实施严格的权限控制。

- 在数据传输和存储过程中使用加密。

Python示例:简单的数据脱敏操作

import pandas as pd

import hashlib

def hash_personal_info(value):

return hashlib.sha256(str(value).encode()).hexdigest()

def anonymize_data(df):

# 对个人身份信息进行哈希处理

df['name'] = df['name'].apply(hash_personal_info)

df['email'] = df['email'].apply(hash_personal_info)

# 删除直接标识符

df.drop('ssn', axis=1, inplace=True)

# 对年龄进行分组

df['age_group'] = pd.cut(df['age'], bins=[0, 18, 30, 50, 70, 100], labels=['0-18', '19-30', '31-50', '51-70', '70+'])

df.drop('age', axis=1, inplace=True)

return df

# 读取原始数据

df = pd.read_csv('raw_data.csv')

# 进行数据脱敏

anonymized_df = anonymize_data(df)

# 保存脱敏后的数据

anonymized_df.to_csv('anonymized_data.csv', index=False)

数据编制中的常见挑战及解决策略

在实际的数据编制过程中,我们常常会遇到各种挑战。以下是一些常见问题及其解决策略:

1. 数据质量问题

挑战:原始数据可能存在错误、缺失或不一致的情况。

解决策略:

- 实施严格的数据验证规则

- 使用统计方法检测异常值

- 采用高级的插补技术处理缺失数据

- 建立数据质量评分系统,持续监控数据质量

Python示例:处理异常值和缺失数据

import pandas as pd

import numpy as np

from scipy import stats

def handle_outliers_and_missing(df):

for column in df.select_dtypes(include=[np.number]).columns:

# 检测并处理异常值

z_scores = np.abs(stats.zscore(df[column]))

df[column] = df[column].mask(z_scores > 3, df[column].median())

# 处理缺失值

if df[column].isnull().sum() > 0:

if df[column].dtype == 'object':

df[column].fillna(df[column].mode()[0], inplace=True)

else:

df[column].fillna(df[column].median(), inplace=True)

return df

# 使用示例

df = pd.read_csv('data_with_issues.csv')

cleaned_df = handle_outliers_and_missing(df)

2. 数据规模和性能

挑战:处理大规模数据集时可能面临性能瓶颈。

解决策略:

- 使用分布式计算框架(如Apache Spark)

- 实现增量处理,只处理新增或变更的数据

- 优化数据存储结构,如使用列式存储

- 采用并行处理技术

示例:使用PySpark进行大规模数据处理

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, when

# 创建SparkSession

spark = SparkSession.builder.appName("LargeDataProcessing").getOrCreate()

# 读取大规模数据

df = spark.read.csv("hdfs://large_data.csv", header=True, inferSchema=True)

# 数据处理示例

processed_df = df.withColumn("age_group",

when(col("age") < 18, "0-17")

.when((col("age") >= 18) & (col("age") < 30), "18-29")

.when((col("age") >= 30) & (col("age") < 50), "30-49")

.otherwise("50+")

)

# 保存处理后的数据

processed_df.write.parquet("hdfs://processed_data.parquet")

# 停止SparkSession

spark.stop()

3. 数据一致性

挑战:来自不同源的数据可能存在格式、定义或值域的不一致。

解决策略:

- 建立统一的数据标准和字典

- 实施数据映射和转换规则

- 使用主数据管理(MDM)系统

- 实施数据治理流程

示例:数据一致性检查和转换

import pandas as pd

def ensure_consistency(df):

# 统一日期格式

date_columns = ['birth_date', 'registration_date']

for col in date_columns:

df[col] = pd.to_datetime(df[col], errors='coerce').dt.strftime('%Y-%m-%d')

# 统一类别编码

gender_mapping = {'M': 'Male', 'F': 'Female', '0': 'Male', '1': 'Female'}

df['gender'] = df['gender'].map(gender_mapping)

# 标准化数值范围

df['score'] = df['score'].clip(0, 100)

return df

# 使用示例

df1 = pd.read_csv('source1.csv')

df2 = pd.read_csv('source2.csv')

df1 = ensure_consistency(df1)

df2 = ensure_consistency(df2)

# 合并数据集

merged_df = pd.concat([df1, df2], ignore_index=True)

4. 数据隐私和合规性

挑战:确保数据编制过程符合数据保护法规和隐私要求。

解决策略:

- 实施数据脱敏技术

- 建立数据访问控制机制

- 记录数据处理活动日志

- 定期进行隐私影响评估

示例:实现数据脱敏和访问日志

import pandas as pd

import hashlib

import logging

from datetime import datetime

logging.basicConfig(filename='data_access.log', level=logging.INFO)

def hash_pii(value):

return hashlib.sha256(str(value).encode()).hexdigest()

def anonymize_data(df, pii_columns):

for col in pii_columns:

df[col] = df[col].apply(hash_pii)

return df

def log_access(user, action):

logging.info(f"{datetime.now()} - User: {user}, Action: {action}")

# 使用示例

df = pd.read_csv('sensitive_data.csv')

# 记录访问日志

log_access('data_analyst_1', 'accessed raw data')

# 脱敏处理

pii_columns = ['name', 'email', 'phone']

anonymized_df = anonymize_data(df, pii_columns)

# 保存脱敏后的数据

anonymized_df.to_csv('anonymized_data.csv', index=False)

# 记录处理日志

log_access('data_analyst_1', 'anonymized and saved data')

5. 数据版本控制和可追溯性

挑战:在数据编制过程中保持数据的版本控制和可追溯性。

解决策略:

- 使用专门的数据版本控制工具(如DVC)

- 实施数据沿袭(Data Lineage)追踪

- 保留数据处理的详细日志

- 建立数据集的版本命名约定

示例:使用DVC进行数据版本控制

# 初始化DVC项目

dvc init

# 添加原始数据

dvc add data/raw_data.csv

# 处理数据

python process_data.py

# 添加处理后的数据

dvc add data/processed_data.csv

# 提交更改

git add data/.gitignore data/*.dvc

git commit -m "Add raw and processed data"

# 创建一个标签

git tag -a "v1.0" -m "Initial data version"

# 推送数据和代码

dvc push

git push --tags

数据编制工具和技术

在数据编制过程中,有许多工具和技术可以帮助我们更高效地完成任务。以下是一些常用的工具和技术:

1. 编程语言和库

-

Python: 最受欢迎的数据处理语言之一

- pandas: 强大的数据操作和分析库

- NumPy: 科学计算库

- scikit-learn: 机器学习库,提供数据预处理功能

-

R: 统计计算和图形化的编程语言

- dplyr: 数据操作库

- tidyr: 数据整洁化库

-

SQL: 用于处理结构化数据的查询语言

2. 大数据处理框架

- Apache Spark: 分布式数据处理引擎

- Apache Flink: 流处理和批处理框架

- Apache Hadoop: 分布式存储和处理框架

3. ETL工具

- Apache NiFi: 数据流自动化工具

- Talend: 开源数据集成平台

- Informatica PowerCenter: 企业级数据集成平台

4. 数据质量工具

- Great Expectations: 数据验证和文档化工具

- Deequ: 基于Spark的数据质量验证库

- Apache Griffin: 大数据质量解决方案

5. 版本控制和数据沿袭

- DVC (Data Version Control): 专门用于数据和ML模型的版本控制工具

- Git LFS (Large File Storage): 用于大文件版本控制的Git扩展

- Apache Atlas: 数据治理和元数据管理框架

6. 数据可视化工具

- Tableau: 强大的数据可视化和商业智能工具

- Power BI: 微软的数据可视化平台

- D3.js: 用于创建动态、交互式数据可视化的JavaScript库

7. 数据编目和元数据管理

- Apache Atlas: 元数据管理和数据治理框架

- Collibra: 企业数据治理和目录平台

- Alation: 数据目录和协作平台

数据编制的未来趋势

随着技术的不断发展,数据编制领域也在不断演进。以下是一些值得关注的未来趋势:

1. 自动化和AI驱动的数据编制

人工智能和机器学习技术正在逐步应用到数据编制过程中,帮助自动化许多繁琐的任务:

- 自动数据清洗和异常检测

- 智能数据匹配和集成

- 自动特征工程

- 基于AI的数据质量评估

示例:使用机器学习进行异常检测

from sklearn.ensemble import IsolationForest

import pandas as pd

import numpy as np

def detect_anomalies(df, contamination=0.1):

# 选择数值型列

numeric_columns = df.select_dtypes(include=[np.number]).columns

# 创建并训练Isolation Forest模型

clf = IsolationForest(contamination=contamination, random_state=42)

clf.fit(df[numeric_columns])

# 预测异常

anomalies = clf.predict(df[numeric_columns])

# 将异常标记添加到原始数据框

df['is_anomaly'] = anomalies

return df

# 使用示例

df = pd.read_csv('data.csv')

df_with_anomalies = detect_anomalies(df)

# 查看异常数据

anomalies = df_with_anomalies[df_with_anomalies['is_anomaly'] == -1]

print(f"检测到 {len(anomalies)} 条异常数据")

2. 实时数据编制

随着实时分析需求的增加,实时数据编制变得越来越重要:

- 流处理技术的应用

- 增量数据处理

- 实时数据质量监控

- 低延迟数据集成

示例:使用Apache Flink进行实时数据处理

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.api.common.functions.MapFunction;

public class RealtimeDataProcessing {

public static void main(String[] args) throws Exception {

// 创建执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 从Kafka源读取数据

DataStream<String> input = env.addSource(new FlinkKafkaConsumer<>("input-topic", new SimpleStringSchema(), properties));

// 数据处理

DataStream<String> processed = input

.map(new MapFunction<String, String>() {

@Override

public String map(String value) throws Exception {

// 实现数据清洗和转换逻辑

return cleanAndTransform(value);

}

})

.filter(value -> value != null && !value.isEmpty());

// 将处理后的数据写入输出流

processed.addSink(new FlinkKafkaProducer<>("output-topic", new SimpleStringSchema(), properties));

// 执行作业

env.execute("Realtime Data Processing Job");

}

private static String cleanAndTransform(String value) {

// 实现数据清洗和转换逻辑

// ...

}

}

3. 数据编制的无代码/低代码解决方案

为了使数据编制更加accessible,无代码和低代码平台正在兴起:

- 可视化数据流设计工具

- 拖拽式数据转换界面

- 预制数据处理模板

- 自动代码生成

这些工具使得非技术人员也能参与到数据编制过程中,提高了整体的数据处理效率。

4. 联邦数据编制

随着数据隐私法规的加强和跨组织数据共享需求的增加,联邦数据编制成为一个新兴趋势:

- 分布式数据处理

- 隐私保护计算技术

- 跨组织数据集成

- 分散式数据治理

示例:使用PySyft进行联邦学习

import syft as sy

import torch

import torch.nn as nn

import torch.optim as optim

# 创建虚拟工作者

alice = sy.VirtualWorker(hook, id="alice")

bob = sy.VirtualWorker(hook, id="bob")

# 创建联邦数据集

federated_train_loader = sy.FederatedDataLoader(

datasets.MNIST('../data', train=True, download=True,

transform=transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.1307,), (0.3081,))

]))

.federate((alice, bob)),

batch_size=64, shuffle=True)

# 定义模型

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(1, 20, 5, 1)

self.conv2 = nn.Conv2d(20, 50, 5, 1)

self.fc1 = nn.Linear(4*4*50, 500)

self.fc2 = nn.Linear(500, 10)

def forward(self, x):

x = F.relu(self.conv1(x))

x = F.max_pool2d(x, 2, 2)

x = F.relu(self.conv2(x))

x = F.max_pool2d(x, 2, 2)

x = x.view(-1, 4*4*50)

x = F.relu(self.fc1(x))

x = self.fc2(x)

return F.log_softmax(x, dim=1)

model = Net()

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.5)

# 联邦学习训练循环

for epoch in range(10):

for batch_idx, (data, target) in enumerate(federated_train_loader):

model.send(data.location)

optimizer.zero_grad()

output = model(data)

loss = F.nll_loss(output, target)

loss.backward()

optimizer.step()

model.get()

if batch_idx % 100 == 0:

print('Train Epoch: {} [{}/{} ({:.0f}%)]\tLoss: {:.6f}'.format(

epoch, batch_idx * 64, len(federated_train_loader) * 64,

100. * batch_idx / len(federated_train_loader), loss.item()))

5. 可解释性和透明度

随着数据编制过程变得越来越复杂,确保过程的可解释性和透明度变得至关重要:

- 数据处理步骤的可视化

- 数据转换的详细日志

- 数据沿袭的图形化展示

- 自动生成数据处理文档

示例:使用OpenLineage跟踪数据沿袭

from openlineage.client import OpenLineageClient

from openlineage.client.run import RunEvent, RunState, Run, Job

from openlineage.client.facet import SqlJobFacet

# 创建OpenLineage客户端

client = OpenLineageClient.from_environment()

# 定义作业

job = Job(namespace="my_namespace", name="data_processing_job")

# 开始运行

run = Run(runId="unique_run_id")

client.emit(

RunEvent(

eventType=RunState.START,

eventTime="2023-08-06T10:00:00.000Z",

run=run,

job=job,

inputs=[],

outputs=[]

)

)

# 执行数据处理逻辑

# ...

# 结束运行

client.emit(

RunEvent(

eventType=RunState.COMPLETE,

eventTime="2023-08-06T10:15:00.000Z",

run=run,

job=job,

inputs=[],

outputs=[],

facets={

"sql": SqlJobFacet(query="SELECT * FROM source_table")

}

)

)

结论

数据编制是数据分析和机器学习项目中至关重要的一环。它将原始数据转化为可用于分析和决策的高质量数据集,为后续的数据科学工作奠定基础。随着数据量的不断增长和数据源的日益复杂,高效、准确的数据编制变得越来越重要。

本文详细介绍了数据编制的概念、流程、最佳实践以及未来趋势。我们探讨了从数据收集、清洗、转换到集成和验证的整个过程,并提供了大量实用的代码示例和工具推荐。同时,我们也讨论了数据编制中常见的挑战及其解决策略,如处理大规模数据、确保数据一致性和保护数据隐私等。

展望未来,数据编制领域正在朝着更加自动化、实时化和智能化的方向发展。AI驱动的数据处理、实时数据编制、无代码/低代码解决方案、联邦数据编制以及增强的可解释性和透明度都将成为未来的重要趋势。

作为数据专业人员,我们需要不断学习和适应这些新技术和趋势,以便更好地应对数据编制中的挑战,提高数据处理的效率和质量。同时,我们也要注意在追求技术创新的同时,始终保持对数据质量、数据安全和数据伦理的关注。

最后,希望这篇文章能够为你提供有价值的见解和实用技巧,帮助你在数据编制的道路上走得更远。记住,高质量的数据编制是一切数据驱动决策的基础,它的重要性怎么强调都不为过。让我们一起努力,不断提升数据编制的水平,为数据科学和人工智能的发展做出贡献!