AesExpert: Towards Multi-modality Foundation Model for Image Aesthetics Perception

GitHub

(arxiv.org)

动机

1. 要解决的问题

- 图像美学感知的高度抽象性:图像美学感知(IAP)的高度抽象性对当前的多模态大语言模型(MLLMs)提出了重大挑战。这些模型在理解图像的美学质量、属性(如颜色、光线、构图)、情感表达等方面存在显著不足。

- 缺乏标注的多模态美学数据:缺乏经过人类标注的多模态美学数据进一步加剧了MLLMs在美学感知能力上的不足。

- MLLMs在美学任务上的局限性:尽管MLLMs在一般性的视觉和语言理解任务上取得了显著进展,但在高度抽象的图像美学感知任务上仍存在明显局限,包括图像美学评估(IAA)、细粒度美学属性评价、美学情感分析及图像美学描述等。

- 实际应用需求:提升MLLMs的美学感知能力对于智能摄影、相册管理、照片推荐和图像增强等实际应用至关重要。

2. 解决问题的策略

- 构建多模态美学指令调优数据集(AesMMIT):通过收集人类对于图像美学的反馈并整理成指令形式的数据集,以此来训练MLLMs,使其更好地与人类的美学感知对齐。

- 基于AesMMIT数据集调优MLLMs:利用AesMMIT数据集对开源的通用基础模型进行调优,构建出具有多模态美学感知能力的AesExpert模型。

方法

1. AesMMIT数据集的构建

- 收集人类美学反馈:通过主观实验邀请人类受试者对图像进行美学感知和理解的直接反馈,反馈内容包括粗粒度美学评价、基于元素美学属性的细粒度推理和解释,以及更细粒度的美学感受描述。

- 具体步骤:

- 粗粒度美学评价:例如,“这张图片看起来很漂亮/不吸引人。”

- 细粒度推理和解释:基于元素美学属性(清晰度、颜色、光线、图像对象和构图等)的详细分析。

- 细粒度情感描述:例如,“新颖的拍摄视角,有趣的内容以及表达的情感。”

- 数据量:共收集到21,904张多源图像和88K条人类自然语言反馈。

- 具体步骤:

- 利用GPT细化反馈为指令数据:将人类反馈转化为指令跟随格式,包括开放性和多选式问答对。

- 指令覆盖维度:质量、属性、情感、解释、增强和上下文推理等。

- 问题类型:包括Yes-or-No、What、How、Why及其他开放式问题。

- 最终数据量:生成了包含409K条多类型指令的AesMMIT数据集。

2. AesExpert模型的构建

- 基于AesMMIT数据集的指令调优:采用指令调优方法,对开源的通用基础模型进行调优,使其不仅保留原有的通用知识,还具备美学感知能力。

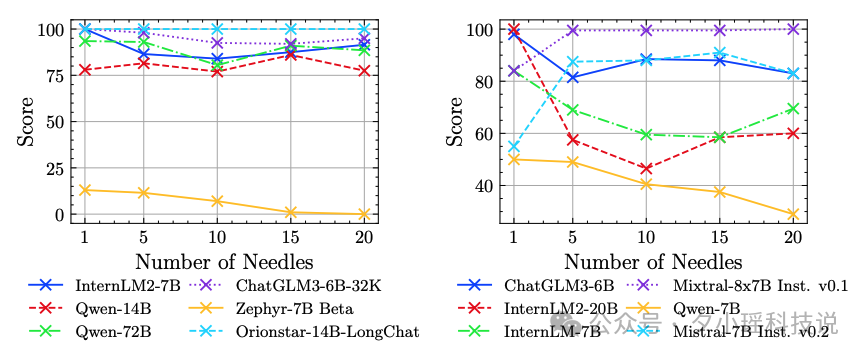

- 模型性能评估:通过广泛的实验证明,AesExpert模型在美学感知性能上显著优于最先进的MLLMs,包括GPT-4V和Gemini-Pro-Vision。

总结

本文针对图像美学感知任务中MLLMs的局限性,通过构建AesMMIT多模态美学指令调优数据集,并基于该数据集对开源基础模型进行调优,成功构建了AesExpert多模态美学专家模型。该方法不仅解决了当前MLLMs在美学感知上的不足,还为未来的美学相关任务提供了新的研究思路和实践方向。