前言

在这个迅猛发展且复杂多变的技术领域,掌握大型模型的理论核心并有效地将其应用于实践,对许多人来说是一项艰巨的任务。为此,《大规模语言模型:从理论到实践》一书应运而生。本书由复旦大学计算机科学技术学院知名教授张奇领衔的专家团队精心编著,结合了他们在自然语言处理领域的深厚研究功底,以及分布式系统和并行计算的教学经验,旨在引导读者深入探究大型模型的原理,并提供了实用的操作策略和实例分析,帮助读者迅速掌握要领,轻松应对技术挑战。

内容简介

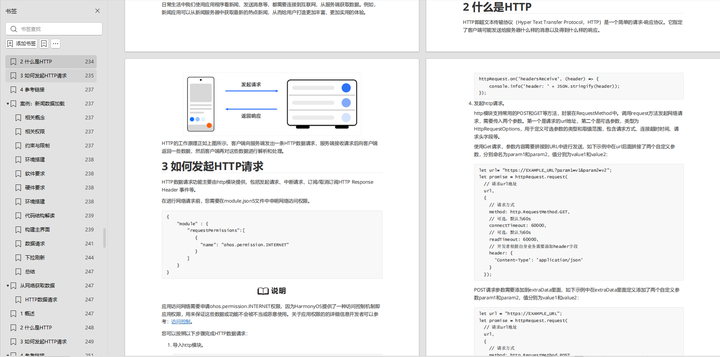

《大规模语言模型:从理论到实践》通过四个主要阶段——预训练、有监督微调、奖励建模和强化学习展开讲解,详细介绍了在每个阶段使用的关键算法、必要的数据处理方法、面临的挑战以及实践中的经验分享。从需要巨量数据和强大计算资源的预训练阶段,到精细化微调、奖励模型构建,再到通过强化学习进一步优化模型性能,本书不仅涵盖了技术的深度,也关注实际应用的广度。

此外,本书还探讨了如何将大语言模型与外部知识源结合,以及如何利用这些模型完成复杂任务和进行效果评估的方法。作为一本既适合初学者入门,也适合高年级本科生和研究生作为教材的书籍,作者团队努力全面呈现大模型研究的各个方面,同时避免了没有广泛共识的观点和结论,确保读者能够在当前快速发展的大模型领域获得坚实的理论基础和实践指导。

下载当前版本: 完整版本链接获取,可以V扫描下方二维码免费领取

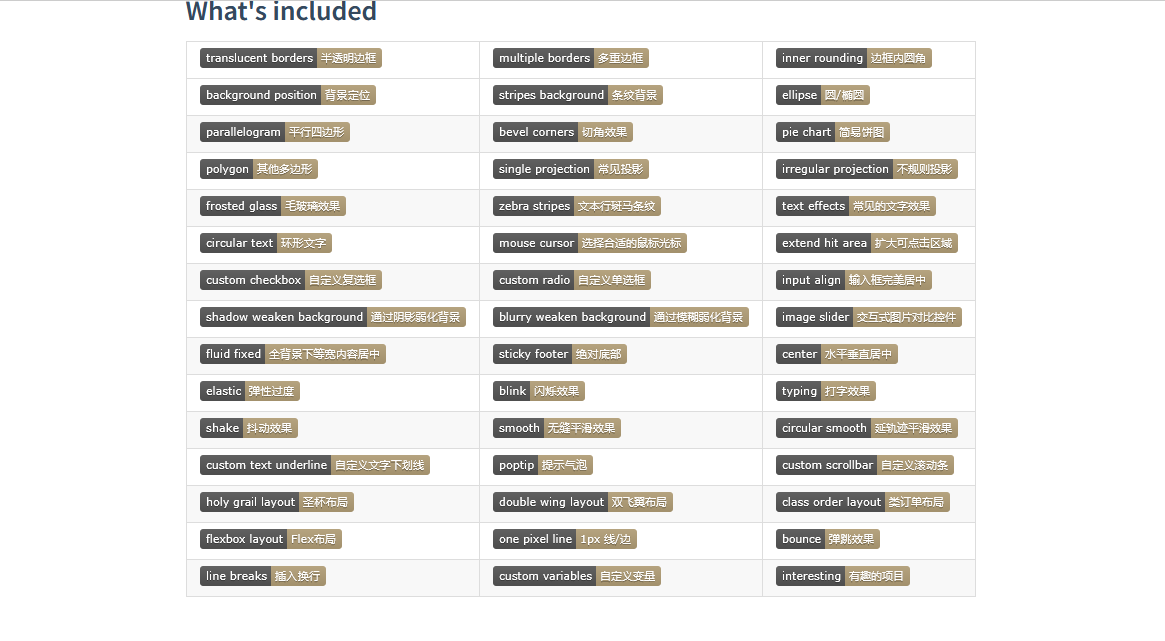

1、绪论

- 1.1 大规模语言模型基本概念

- 1.2 大规模语言模型发展历程

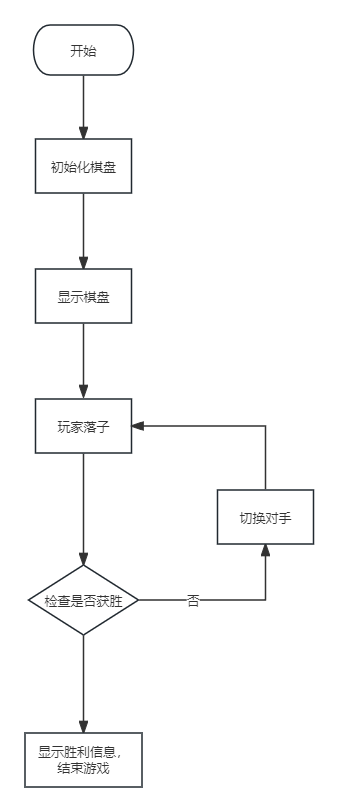

- 1.3 大规模语言模型构建流程

- 1.4 本书的内容安排

2 大语言模型基础

- 2.1 Transformer模型

- 2.2 生成式预训练语言模型GPT

- 2.3 大语言模型结构

3 语言模型训练数据

- 3.1 数据来源

- 3.2 数据处理

- 3.3 数据影响分析

- 3.4 开源数据集合

4 分布式训练

- 4.1 分布式训练概述

- 4.2 分布式训练并行策略

- 4.3 分布式训练的集群架构

- 4.4 DeepSpeed实践

5 有监督微调

- 5.1 提示学习和语境学习

- 5.2 高效模型微调

- 5.3 模型上下文窗口扩展

- 5.4 指令数据构建

- 5.5 Deepspeed-Chat SFT实践

6 强化学习

- 6.1 基于人类反馈的强化学习

- 6.2 奖励模型

- 6.3 近端策略优化

- 6.4 MOSS-RLHF实践

7 大语言模型应用

- 7.1 推理规划

- 7.2 综合应用框架

- 7.3 智能代理

- 7.4 多模态大模型

- 7.5 大语言模型推理优化

8 大语言模型评估

- 8.1 模型评估概述

- 8.2 大语言模型评估体系

- 8.3 大语言模型评估方法

- 8.4 大语言模型评估实践

下载当前版本: 完整版本链接获取,可以V扫描下方二维码免费领取