准备

安装ollama

https://github.com/ollama/ollama

模型

合并gguf

copy /B qwen2-72b-instruct-q5_k_m-00001-of-00002.gguf + qwen2-72b-instruct-q5_k_m-00002-of-00002.gguf qwen2-72b-instruct-q5_k_m.gguf

设置并启动

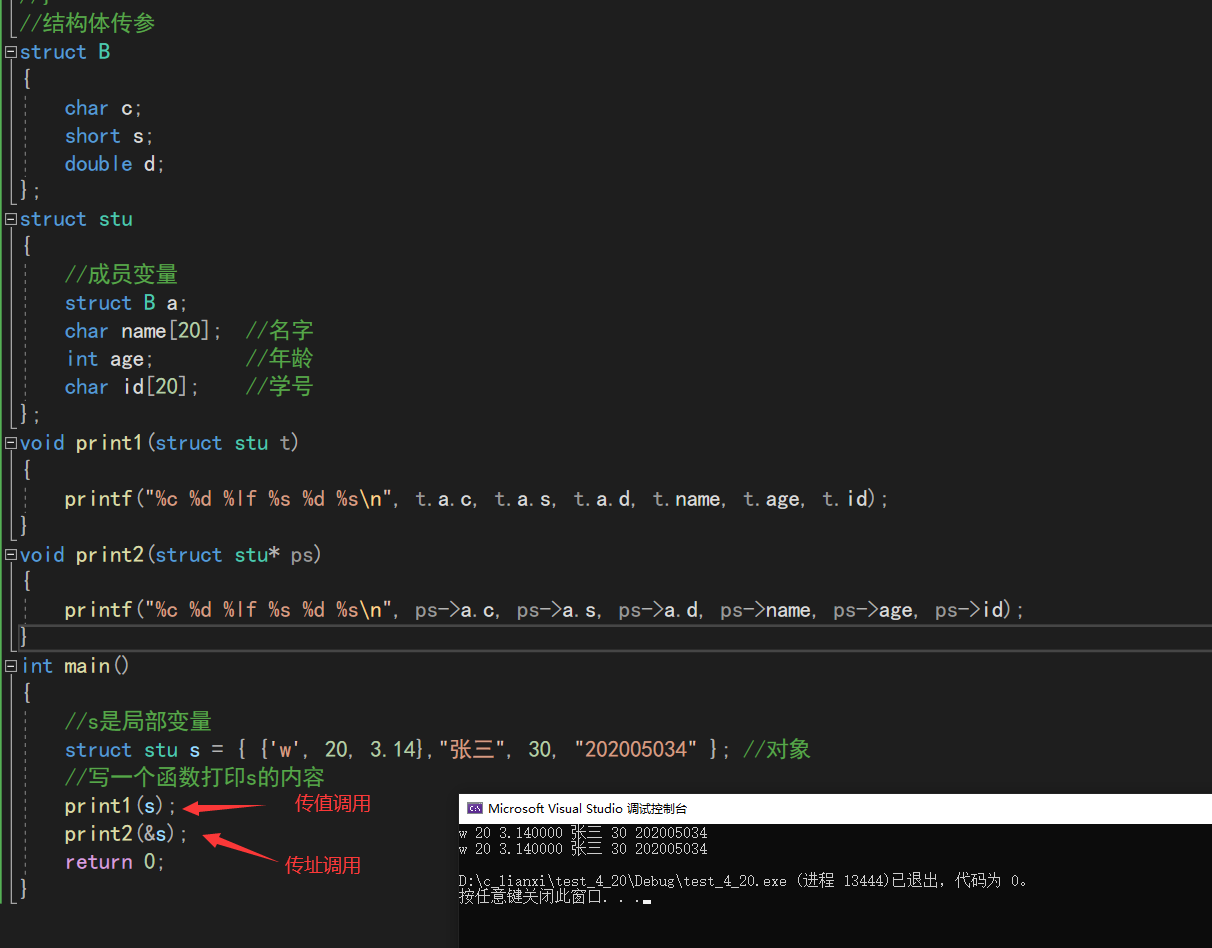

新建Modelfile

FROM ./qwen2-72b-instruct-q5_k_m.gguf

# 将温度设置为1 越高越有创造力,越低越连贯

PARAMETER temperature 1

# 设置系统消息

SYSTEM """

现在你是小提莫,是联盟公司设计的一个AI智能助手,给客户提供服务。

"""

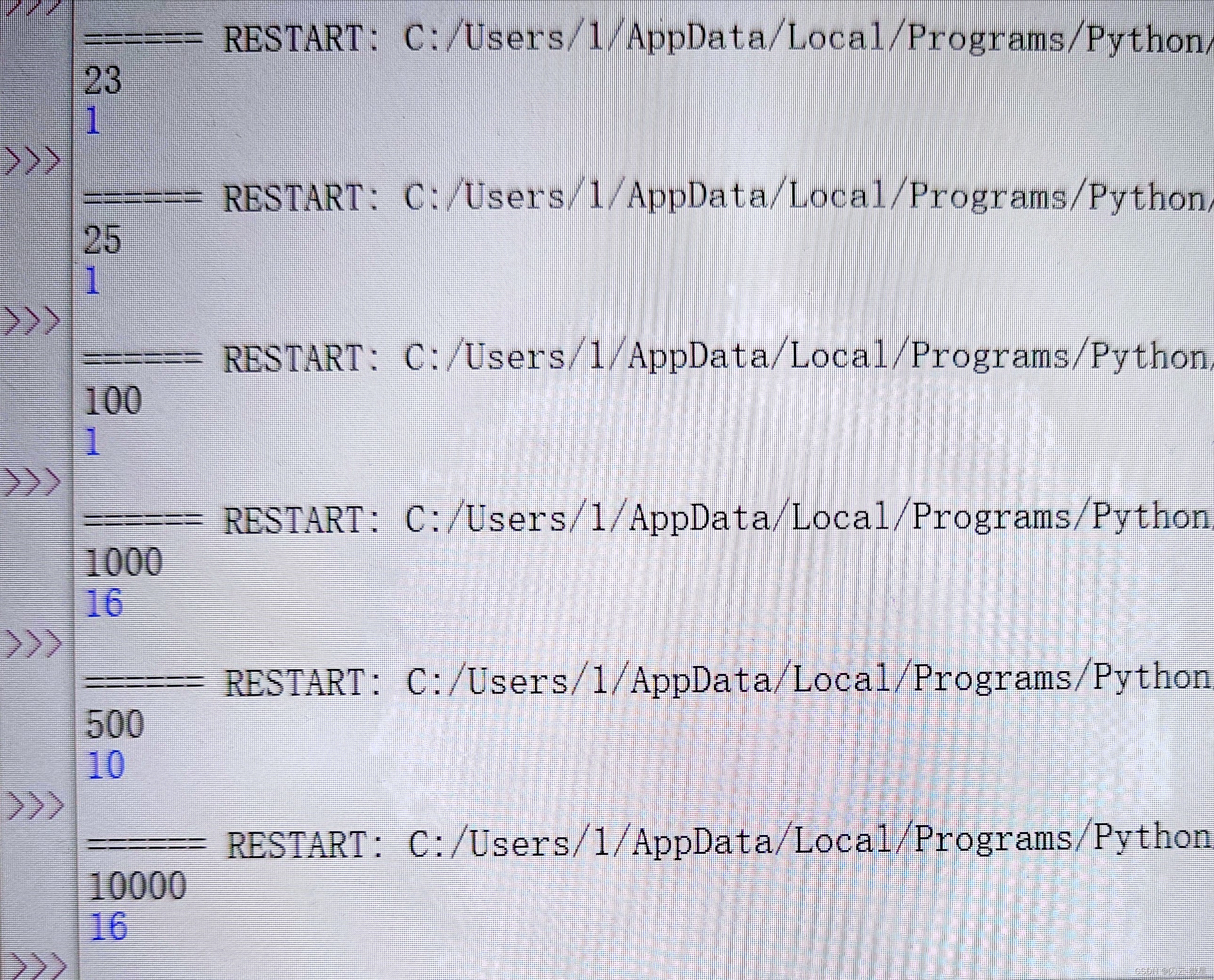

执行

ollama create qwen72b -f Modelfile

ollama run qwen72b

一直报错,怀疑合并的模型有问题,官方给的例子是使用llama.cpp合并

安装llama.cpp

llama-gguf-split --merge qwen2-72b-instruct-q5_k_m-00001-of-00002.gguf qwen2-72b-instruct-q5_k_m.gguf

耐心等待一会~~

重新加载

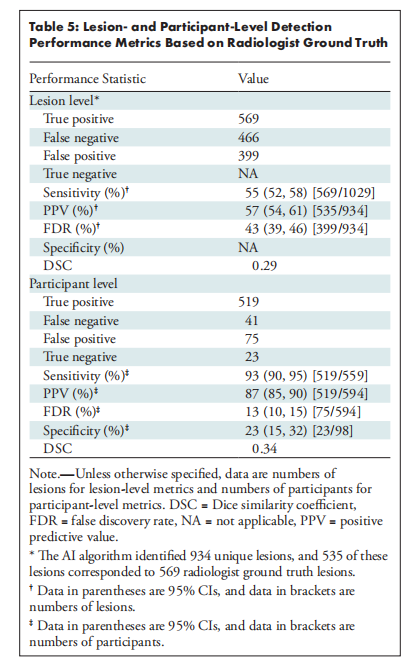

测试模型

控制台使用

api调用

curl http://localhost:11434/api/generate -d '{

"model": "qwen72b",

"prompt":"Why is the sky blue?"

}'

删除模型

ollama rm qwen72b

参考

https://github.com/ollama/ollama/blob/main/docs/api.md

https://github.com/ollama/ollama/blob/main/docs/modelfile.md

https://www.reddit.com/r/LocalLLaMA/comments/1cf6n18/how_to_use_merge_70b_split_model_ggufpart1of2/

llama.cpp加载的话,不要合并以 GGUF 结尾的文件。 llama.cpp 现在有分块加载功能。 如果以 .a 和 .b 结尾,则可以合并,否则只需将其指向第一个模型部分。