前言

在大语言模型(LLM)飞速发展的今天,LLMs 正不断地充实和改进我们周边的各种工具和应用。如果说现在基于 LLM 最火热的应用技术是什么,检索增强生成(RAG,Retrieval Augmented Generation)技术必占据重要的一席。RAG 最初是为了解决 LLM 的各类问题的产生的,但后面大家发现在现阶段的很多企业痛点上,使用RAG好像是更好的解决方案。在介绍 RAG 之前,我们先来看一下现在LLM存在的问题。

LLM的问题

尽管LLM拥有令人印象深刻的能力,但是它们还面临着一些问题和挑战:

- 幻觉问题:大模型的底层原理是基于概率,在没有答案的情况下经常会胡说八道,提供虚假信息。

- 时效性问题:规模越大(参数越多、tokens 越多),大模型训练的成本越高。类似 ChatGPT3.5,起初训练数据是截止到 2021 年的,对于之后的事情就不知道了。而且对于一些高时效性的事情,大模型更加无能为力,比如帮我看看今天晚上有什么电影值得去看?这种任务是需要去淘票票、猫眼等网站先去获取最新电影信息的,大模型本身无法完成这个任务。

- 数据安全:OpenAI 已经遭到过几次隐私数据的投诉,而对于企业来说,如果把自己的经营数据、合同文件等机密文件和数据上传到互联网上的大模型,那想想都可怕。既要保证安全,又要借助 AI 能力,那么最好的方式就是把数据全部放在本地,企业数据的业务计算全部在本地完成。而在线的大模型仅仅完成一个归纳的功能,甚至,LLM 都可以完全本地化部署。

解决这些挑战对于 LLMs 在各个领域的有效利用至关重要。一个有效的解决方案是集成检索增强生成(RAG)技术,该技术通过获取外部数据来响应查询来补充模型,从而确保更准确和最新的输出。主要表现方面如下:

- 有效避免幻觉问题:虽然无法 100% 解决大模型的幻觉问题,但通过 RAG 技术能够有效的降低幻觉,在软件系统中结合大模型提供幂等的API接口就可以发挥大模型的重大作用。

- 经济高效的处理知识&开箱即用:只需要借助信息检索和向量技术,将用户的问题和知识库进行相关性搜索结合,就能高效的提供大模型不知道的知识,同时具有权威性。

- 数据安全:企业的数据可以得到有效的保护,通过私有化部署基于 RAG 系统开发的AI产品,能够在体验AI带来的便利性的同时,又能避免企业隐私数据的泄漏。

上图展示了 RAG 如何使 ChatGPT 能够提供超出其初始训练数据的精确答案。

【一一AGI大模型学习 所有资源获取处一一】

①人工智能/大模型学习路线

②AI产品经理资源合集

③200本大模型PDF书籍

④超详细海量大模型实战项目

⑤LLM大模型系统学习教程

⑥640套-AI大模型报告合集

⑦从0-1入门大模型教程视频

⑧LLM面试题合集

什么是RAG

说了这么多,下面我们来介绍一下什么是 RAG 。

RAG 是检索增强生成(Retrieval Augmented Generation )的简称,它为大语言模型 (LLMs) 提供了从数据源检索信息的能力,并以此为基础生成回答。简而言之,RAG 结合了信息检索技术和大语言模型的提示功能,即模型根据搜索算法找到的信息作为上下文来查询回答问题。无论是查询还是检索的上下文,都会被整合到发给大语言模型的提示中。

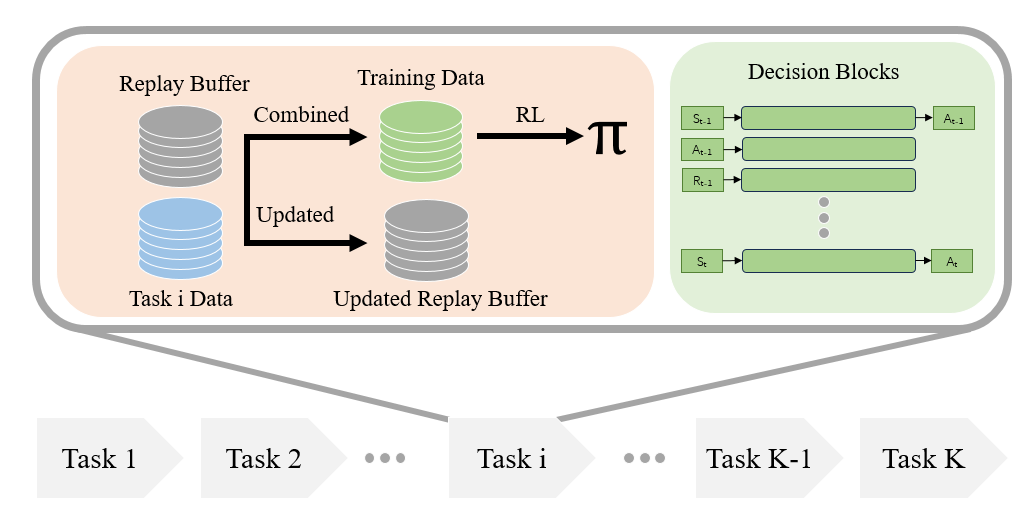

RAG 的架构如图中所示。它既不是一个特定的开源代码库,也不是某个特定的应用,是一个开发框架。

完整的 RAG 应用流程主要包含两个阶段:

- 数据准备阶段:(A)数据提取–> (B)分块(Chunking)–> (C)向量化(embedding)–> (D)数据入库

- 检索生成阶段:(1)问题向量化–> (2)根据问题查询匹配数据–> (3)获取索引数据 --> (4)将数据注入Prompt–> (5)LLM生成答案

下面让我们展开介绍一下这两个阶段的关键环节。

数据准备阶段

数据准备一般是一个离线的过程,主要是将私有数据向量化后构建索引并存入数据库的过程。主要包括:数据提取、文本分割、向量化、数据入库等环节。

1、数据提取:将 PDF、word、markdown、数据库和API等多种格式的数据,进行过滤、压缩、格式化等处理为同一个范式。

2、分块(Chunking):将初始文档分割成一定大小的块,尽量不要失去语义含义。将文本分割成句子或段落,而不是将单个句子分成多部分。有多种文本分割器实现能够完成此任务。比如根据换行、句号、问号、感叹号等切分文本,或者以其他的合适大小的 chunk 为原则进行分割。最终将语料分割成 chunk 块,在检索时会取相关性最高的 top_n。

3、向量化(embedding):将文本数据转化为向量矩阵的过程,该过程会直接影响到后续检索的效果。常用的 embedding 模型:[moka-ai/m3e-base]、[GanymedeNil/text2vec-large-chinese,也可以参考 Hugging Face 推出的嵌入模型排行榜 [MTEB Leaderboard]。

4、数据入库:数据向量化后构建索引,并写入向量数据库的过程可以概述为数据入库,适用于 RAG 场景的向量数据库包括:[facebookresearch/faiss](本地)、[Chroma]、[Elasticsearch]、[Milvus]等。一般可以根据业务场景、硬件、性能需求等多因素综合考虑,选择合适的数据库。

应用阶段

在应用阶段,根据用户的提问,将提问问题向量化处理,然后通过高效的检索方法,从向量数据库中召回与提问最相关的知识,并融入 Prompt;大模型参考当前提问和相关知识,生成相应的答案。关键环节包括:数据检索、注入 Prompt 等。

1、数据检索

常见的数据检索方法包括:相似性检索、全文检索等。以及可以结合多种检索方式,提升召回率。

- 相似性检索:即计算查询向量与所有存储向量的相似性得分,返回得分高的记录。常见的相似性计算方法包括:余弦相似性、欧氏距离、曼哈顿距离等。

- 全文检索:全文检索是一种比较经典的检索方式,在数据存入时,通过关键词构建倒排索引;在检索时,通过关键词进行全文检索,找到对应的记录。

RAG 文本检索环节中的主流方法是相似性检索(向量检索),即语义相关度匹配的方式。

2、注入 Prompt

Prompt 作为大模型的直接输入,是影响模型输出准确率的关键因素之一。在 RAG 场景中,Prompt 一般包括任务描述、背景知识(检索得到)、任务指令(一般是用户提问)等,根据任务场景和大模型性能,也可以在 Prompt 中适当加入其他指令优化大模型的输出。一个简单知识问答场景的 Prompt 如下所示:

prompt = f"""

Give the answer to the user query delimited by triple backticks ```{query}```\

using the information given in context delimited by triple backticks ```{context}```.\

If there is no relevant information in the provided context, try to answer yourself,

but tell user that you did not have any relevant context to base your answer on.

Be concise and output the answer of size less than 80 tokens.

"""

Prompt 的设计只有方法、没有语法,比较依赖于个人经验,在实际应用过程中,往往需要根据大模型的实际输出进行针对性的 Prompt 调优。

实践示例

那具体 RAG 怎么做呢?我们用一个简单的 LangChain 代码示例来展示 RAG 的使用。

环境准备

安装相关依赖

# 环境准备,安装相关依赖

pip install langchain sentence_transformers chromadb

本地数据加载

这个例子使用了保罗·格雷厄姆(Paul Graham)的文章"What I Worked On"的文本。下载文本后,放置到"./data"目录下。Langchain 提供了很多文件加载器,包括 word、csv、PDF、GoogleDrive、Youtube等,使用方法也很简单。这里直接使用 TextLoader 加载txt文本。

from langchain.document_loaders import TextLoader

loader = TextLoader("./data/paul_graham_essay.txt")

documents = loader.load()

文档分割(split_documents)

文档分割,借助 langchain 的字符分割器。代码中我们指定 chunk_size=500, chunk_overlap=10, 这样的意思就是我们每块的文档中是 500 个字符,chunk_overlap 表示字符重复的个数,这样可以避免语义被拆分后不完整。

# 文档分割

from langchain.text_splitter import CharacterTextSplitter

# 创建拆分器

text_splitter = CharacterTextSplitter(chunk_size=500, chunk_overlap=10)

# 拆分文档

documents = text_splitter.split_documents(documents)

向量化(embedding)

接下来对分割后的数据进行 embedding,并写入数据库。LangChain提供了许多嵌入模型的接口,例如 OpenAI、Cohere、Hugging Face、Weaviate等,请参考 LangChain 官网。这里选用 m3e-base 作为 embedding 模型,向量数据库选用 Chroma。

from langchain.embeddings import HuggingFaceBgeEmbeddings

from langchain.vectorstores import Chroma

# embedding model: m3e-base

model_name = "moka-ai/m3e-base"

model_kwargs = {'device': 'cpu'}

encode_kwargs = {'normalize_embeddings': True}

embedding = HuggingFaceBgeEmbeddings(

model_name=model_name,

model_kwargs=model_kwargs,

encode_kwargs=encode_kwargs

)

数据入库

将嵌入后的结果存储在 VectorDB 中,常见的 VectorDB包括 Chroma、weaviate和 FAISS等,这里使用 Chroma 来实现。Chroma与 LangChain 整合得很好,可以直接使用 LangChain 的接口进行操作。

# 指定 persist_directory 将会把嵌入存储到磁盘上。

persist_directory = 'db'

db = Chroma.from_documents(documents, embedding, persist_directory=persist_directory)

检索(Retrieve)

向量数据库被填充后,可以将其定义为检索器组件,该组件根据用户查询与嵌入式块之间的语义相似性获取附加上下文。

retriever = db.as_retriever()

增强(Augment)

接下来,为了将附加上下文与提示一起使用,需要准备一个提示模板。如下所示,可以轻松地从提示模板自定义提示。

from langchain.prompts import ChatPromptTemplate

template = """You are an assistant for question-answering tasks.

Use the following pieces of retrieved context to answer the question.

If you don't know the answer, just say that you don't know.

Use three sentences maximum and keep the answer concise.

Question: {question}

Context: {context}

Answer:

"""

prompt = ChatPromptTemplate.from_template(template)

生成(Generate)

最后,可以构建一个 RAG 流水线的链,将检索器、提示模板和LLM连接在一起。一旦定义了 RAG 链,就可以调用它。本地通过 ollama 运行的 llama3 来作为 LLM 使用。

from langchain_community.chat_models import ChatOllama

from langchain.schema.runnable import RunnablePassthrough

from langchain.schema.output_parser import StrOutputParser

llm = ChatOllama(model='llama3')

rag_chain = (

{"context": retriever, "question": RunnablePassthrough()}

| prompt

| llm

| StrOutputParser()

)

query = "What did the author do growing up?"

response = rag_chain.invoke(query)

print(response)

我这里的本地llama3环境下,输出为:

Before college, Paul Graham worked on writing and programming outside of school. He didn't write essays, but instead focused on writing short stories. His stories were not very good, having little plot and just characters with strong feelings.

从这个输出中,可以看到已经将我们提供的文本中的相关信息检索出来,并由 LLM 总结回答我们的问题了。

RAG 与微调

上面都是介绍的 RAG ,在这里顺便对比一下微调(Fine-tuning)。在大语言模型的优化措施中, RAG 和微调都是一种重要的技术。

可以把 RAG 想象成给模型提供一本参考书,让它根据问题去查找信息然后回答问题。这种方法适用于模型需要解答具体问题或执行特定信息检索任务的情况。但 RAG 并不适合于教会模型理解广泛的领域或学习新的语言、格式或风格。

而微调更像是让学生通过广泛学习来吸收知识。当模型需要模仿特定的结构、风格或格式时,微调就显得非常有用。它可以提高未经微调的模型的表现,使交互更加高效。

微调特别适用于强化模型已有的知识、调整或定制模型的输出,以及给模型下达复杂的指令。然而,微调并不适合于向模型中添加新的知识,或者在需要快速迭代新场景的情况下使用。

RAG 和微调可以相互补充,而非相互排斥,从而在不同层次上增强模型的能力。在特定情况下,结合这两种方法可以达到模型性能的最佳状态。

还有一个形象的对比来介绍 RAG 和微调, RAG 就相当于是开卷考试,考试的时候可以翻书, 可以随时翻到某一页来查找对应的知识点去回答。 微调相当于你一整个学期的学习,并在考试前进行了重点复习和记忆,考试时,凭借自己巩固的知识去答题。

总结

本文列举了LLM的问题。简单介绍了什么是 RAG ,以及 RAG 的流程。最后使用了一个简单的LangChain代码示例来展示 RAG 的使用。最后对比了 RAG 和微调的区别,方便大家选型。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓