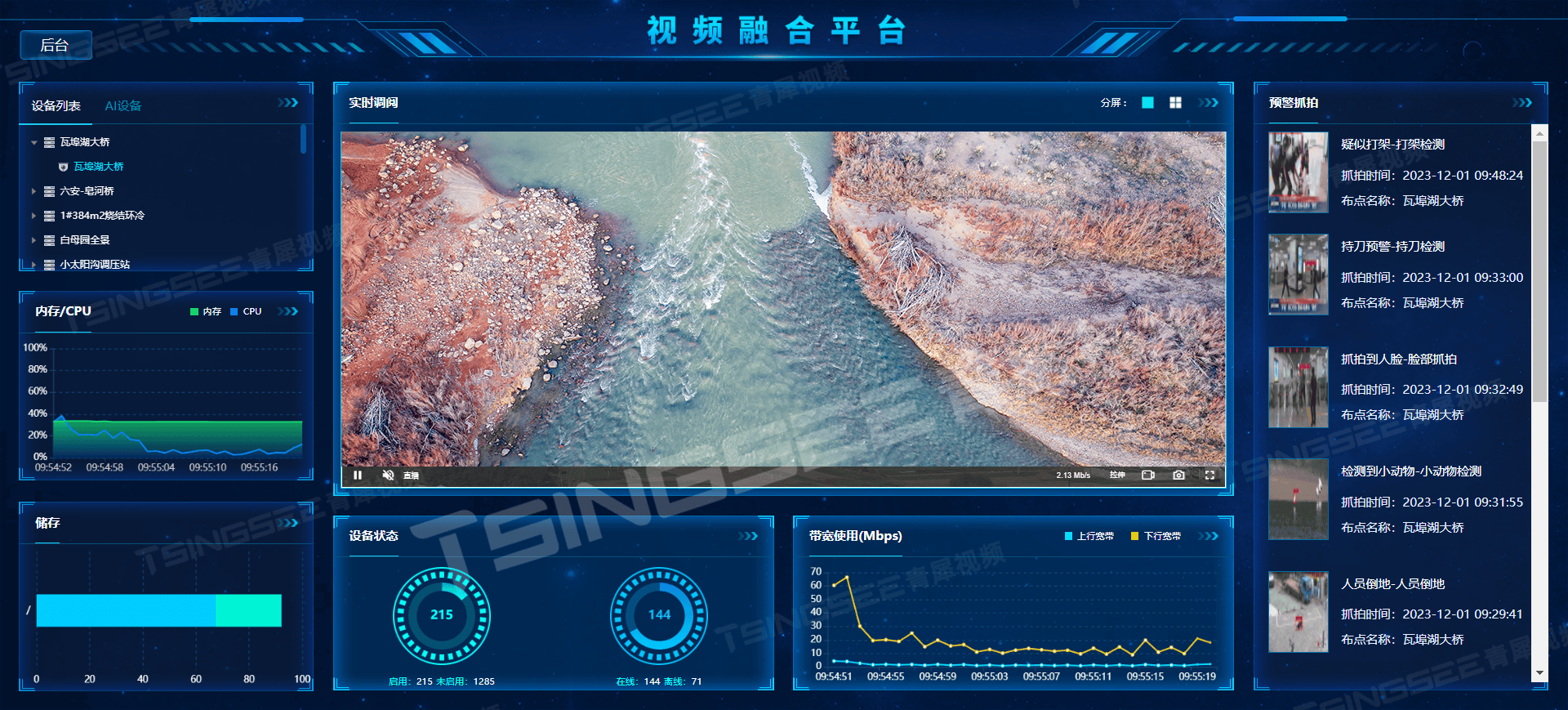

Vision Transformer图像分类

Vit是最新的用了transformer架构的图像模型,在很多比赛都获得了大奖,是非常优秀的架构。而且据说cnn其实只是vit的一个子集,cnn的卷积其实就是vit在很小的范围做了注意力机制。非常有意思

整个架构就好像这样

图片准备好,每个图也有标签,做些预处理,增加模型的泛化能力

transformer是用来处理一串文字序列到另外一串,其实图片也可以搞成一个个小的子图,每个子图就好像一个词,然后大图是一句话,这不就是用transformer做图片模型了。我是这样理解

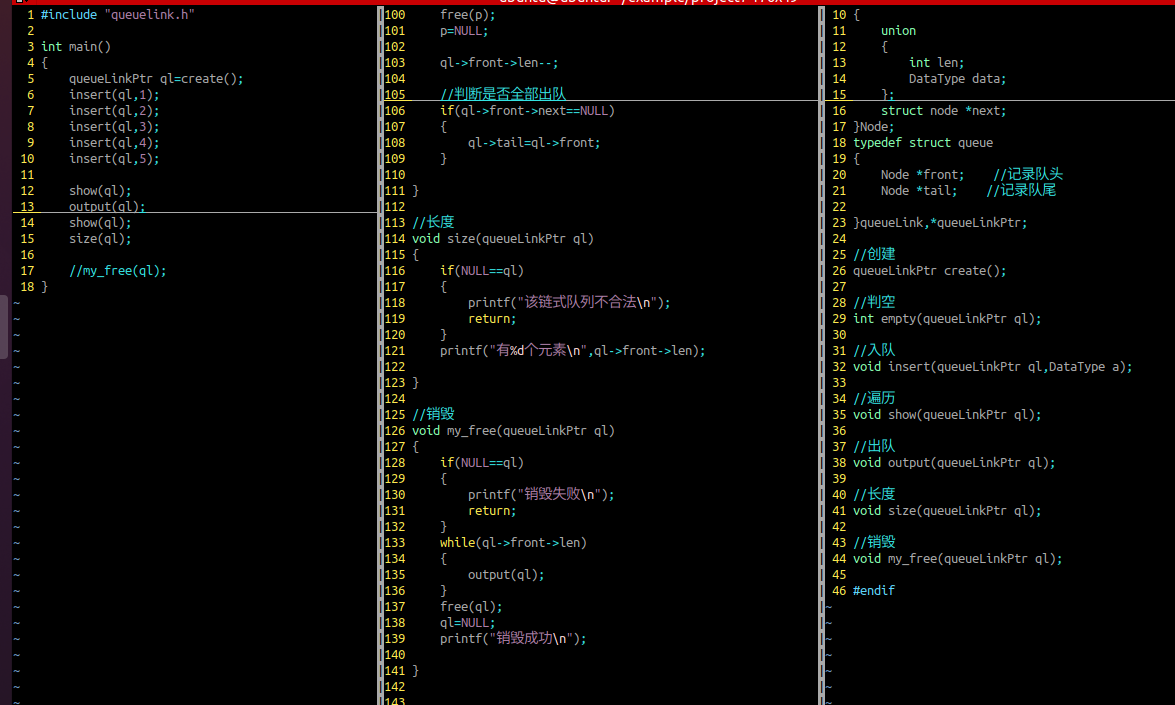

整个网络就看

最后分类为num_classes

训练时候的分类是这样的id,要转成人可读的字符

训练时候的分类是这样的id,要转成人可读的字符

metafile = os.path.join(data_path, “ILSVRC2012_devkit_t12/data/meta.mat”)

meta = io.loadmat(metafile, squeeze_me=True)[‘synsets’]

有这个matlab的文件要这样打开。把index映射到单词

训练完了区预测