论文阅读:(DETR)End-to-End Object Detection with Transformers

参考解读:

论文翻译:End-to-End Object Detection with Transformers(DETR)[已完结] - 怪盗kid的文章 - 知乎

指示函数(样子像空心1的一个数学符号)_语雀公式 指示函数-CSDN博客

Abstract

我们提出了一种将目标检测看作集合预测(set prediction)问题的新方法。我们的方法简化了目标检测的流水线,有效地消除了许多需要手工设计的组件,如非极大值抑制算法或锚框(anchor)生成算法这类需要根据任务显式编码的先验知识。新框架的主要组成部分被称为DEtection TRansformer或DETR,包括一个通过二部图匹配进行唯一预测的基于集合的全局损失,以及一个Transformer编码器-解码器结构。给定一个学习到的固定小规模的目标查询集,DETR推理目标和全局图像上下文之间的关系,直接并行输出最终的预测集。新模型在概念上很简单,不需要专门的库来支持。在具有挑战性的COCO目标检测数据集上,DETR达到了与Faster RCNN基线相当的准确性和运行时间性能。此外,它可以很容易以统一的方式推广到全景分割。我们发现它的表现明显优于有竞争力的基线算法。训练代码和预训练模型可在https://github.com/facebookresearch/detr找到.

1 Introduction

目标检测的目的是为每个感兴趣的目标预测一组边界框和类别标签。现代检测器以一种间接的方法解决这个集合预测任务,该方法在大量的建议框[36,5]、锚框[22]或窗口中心[52,45]中定义回归和分类问题。它们的性能受到以下因素的显著影响:压缩重复预测结果的后处理步骤、锚框集合的设计以及将目标框分配给锚框的启发式方法[51]。为了简化这些流水线,我们提出了一种直接预测集合的方法(set prediction approach)来绕过间接方法。这种端到端的理论已经在机器翻译或语音识别等复杂的结构化预测任务中取得了重大进展,但在目标检测方面尚未取得进展:以前的尝试[42,15,4,38]要么添加了其他形式的先验知识,要么没有证明在具有挑战性的基准上具有强大的基线竞争力。本文旨在弥合这一差距。

通过将目标检测看作直接的集合预测问题,我们简化了训练流水线。我们采用了一种基于transformer [46]的编-解码器结构,它是一种常用的序列预测结构。Transformer的自注意力机制(self-attention)显式地建模序列中所有元素之间的成对交互,使这些架构特别适合于特定约束下的集合预测,如删除重复预测结果。

我们的DEtection TRansformer (DETR,见图1)一次性预测所有目标;并通过集合损失函数进行端到端训练,该函数在预测结果和真实结果之间进行二部图匹配。DETR通过丢弃多个手工设计的编码了先验知识的组件,如空间锚框或非极大值抑制,从而简化了目标检测流水线。与大多数现有的检测方法不同,DETR不需要定制化任何层,因此可以在任何包含标准ResNet[14]和Transformer[46]之类的框架中轻松复制。

与以往大多数直接的集合预测工作相比,DETR的主要特点是将二部匹配损失和拥有(非自回归)并行解码的transformer结合起来[28,11,9,7](the conjunction of the bipartite matching loss and transformers with (non-autoregressive) parallel decoding [28,11,9,7].)。相比之下,以前的工作聚焦在使用RNN的自回归解码[42,40,29,35,41]。我们的匹配损失函数唯一地将一个预测结果分配给一个真实目标,并且针对预测对象(一个特定)的排列保持不变,因此我们可以并行地计算它们 (Our matching loss function uniquely assigns a prediction to a ground truth object, and is invariant to a permutation of predicted objects, so we can emit them in parallel.)。

我们在一个最流行的目标检测数据集COCO[23]上评估DETR,与一个非常有竞争力的Faster R-CNN基线[36]进行对比。Faster RCNN经历了许多设计迭代,其性能自最初发布以来得到了极大的改进。我们的实验表明,我们的新模型达到了相当的性能。更准确地说,DETR在大型目标上展示了明显更好的性能,这很可能是由transformer的非局部计算造成的。然而,它在小目标上的性能较低。我们希望未来的工作能像FPN[21]开发Faster R-CNN一样改善这方面。

DETR的训练设置在许多方面不同于标准的目标检测器。新模型需要超长的训练时间,并且得益于transformer中的解码损失(The new model requires extra-long training schedule and benefits from auxiliary decoding losses in the transformer.)。我们将全面地探讨哪些组件对解释性能至关重要(We thoroughly explore what components are crucial for the demonstrated performance.)。

DETR的设计理念很容易扩展到更复杂的任务。在我们的实验中,我们证明了在预训练好的DETR上进行训练的简单分割头(simple segmentation head)在全景分割[18]上的性能优于有竞争力的基线,全景分割[18]是一项具有挑战性的像素级识别任务,最近受到了广泛的欢迎。

3 The DETR model

对于检测任务中的直接集合预测(direct set prediction),有两个必要因素:

(1) 需要一个集合预测损失(set prediction loss)去迫使算法对预测结果和GT boxes做一个唯一的匹配操作;

(2) 一个可以一次性(in a single pass)预测一系列目标并对它们之间的关系进行建模的预测框架。

3.1 Object detection set prediction loss

在一次通过解码器的过程中,DETR推断出一个包含固定大小 N N N 个结果的预测集合,其中 N N N 被设置为明显大于图像中物体数量的数值。训练的主要难点之一是根据GT对预测对象(类别(class)、位置(position)、大小(size))进行评分。我们的损失产生了预测目标和真值目标之间的最佳二部匹配,然后优化特定目标 (边界框)的损失。

我们用

y

y

y 表示目标的真值集合,

y

^

=

{

y

^

i

}

i

=

1

N

\hat{y}=\{\hat{y}_i\}_{i=1}^N

y^={y^i}i=1N 表示

N

N

N 个预测结果的集合。假设

N

N

N 大于图像中的目标数量,我们也认为

y

y

y 是一个用 (

∅

\varnothing

∅) (无目标(no object))填充之后的大小为N的集合。为了在这两个集合之间找到一个二部匹配,我们寻找一个

N

N

N 个元素的排列

σ

∈

S

N

\sigma\in\mathfrak{S}_{N}

σ∈SN 使得开销最小(To find a bipartite matching between these two sets we search for a permutation of N elements

σ

∈

S

N

\sigma\in\mathfrak{S}_{N}

σ∈SN with the lowest cost ):

σ

^

=

arg

min

σ

∈

S

N

∑

i

N

L

m

a

t

c

h

(

y

i

,

y

^

σ

(

i

)

)

\hat{\sigma}=\arg\min_{\sigma\in\mathfrak{S}_N}\sum_i^N\mathcal{L}_{\mathrm{match}}(y_i,\hat{y}_{\sigma(i)})

σ^=argσ∈SNmini∑NLmatch(yi,y^σ(i))

其中

L

m

a

t

c

h

(

y

i

,

y

^

σ

(

i

)

)

\mathcal{L}_{\mathrm{match}} (y_{i},\hat{y}_{\sigma(i)})

Lmatch(yi,y^σ(i)) 是真值

y

i

y_i

yi 和下标为

σ

(

i

)

\sigma(i)

σ(i) 的预测之间的成对匹配代价(pair-wise matching cost)。根据前人的工作(如[42]),使用匈牙利算法有效地计算出这种最优分配。

匹配代价既考虑了类别的预测,也考虑了预测框和真值框的相似性。真值集合中的每个元素 i i i可以被看作是 y i = ( c i , b i ) y_i=(c_i,b_i) yi=(ci,bi) , c i c_i ci是目标类标签(可能是Ø ), b i ∈ [ 0 , 1 ] 4 b_i\in[0,1]^4 bi∈[0,1]4是一个向量,它定义了真值框中心坐标和其相对于图像大小的高度和宽度 (defines ground truth box center coordinates and its height and width relative to the image size) 。对于下标为 σ ( i ) σ(i) σ(i) 的预测,我们定义类别为 c i c_i ci 的概率为 p ^ σ ( i ) ( c i ) \hat{p}_{\sigma(i)}\left(c_i\right) p^σ(i)(ci) ,预测框为 b ^ σ ( i ) \hat{b}_{\sigma(i)} b^σ(i) 。我们用这些符号定义 L m a t c h ( y i , y ^ σ ( i ) ) \mathcal{L}_\mathrm{match}\left(y_i,\hat{y}_{\sigma(i)}\right) Lmatch(yi,y^σ(i))为

− 1 { c i ≠ ∅ } p ^ σ ( i ) ( c i ) + 1 { c i ≠ ∅ } L b o x ( b i , b ^ σ ( i ) ) . -1_{\{c_i\neq\varnothing\}}\hat{p}_{\sigma(i)}\left(c_i\right)+1_{\{c_i\neq\varnothing\}}\mathcal{L}_{\mathrm{box}}\left(b_i,\hat{b}_{\sigma(i)}\right). −1{ci=∅}p^σ(i)(ci)+1{ci=∅}Lbox(bi,b^σ(i)).

这种寻找匹配的过程与现代检测器中用于匹配提议框[36]或锚框[21]到真值目标的启发式分配规则相同。主要的区别是,我们需要找到一对一的匹配来进行直接的集合预测,而没有重复。

第二步是计算损失函数,即前一步所有匹配对的匈牙利损失。我们对损失的定义类似于一般的目标检测器的损失,即类预测的负对数似然和后面定义的检测框损失 L b o x ( ⋅ , ⋅ ) \mathcal{L}_{\mathrm{box~}}(\cdot,\cdot) Lbox (⋅,⋅)的线性组合:

L Hungarian ( y , y ^ ) = ∑ i = 1 N [ − log p ^ σ ^ ( i ) ( c i ) + 1 { c i ≠ ∅ } L box ( b i , b ^ σ ^ ( i ) ) ] \mathcal{L}_\text{Hungarian }(y,\hat{y})=\sum_{i=1}^N\left[-\log\hat{p}_{\hat{\sigma}(i)}\left(c_i\right)+1_{\{c_i\neq\varnothing\}}\mathcal{L}_\text{box}\:\left(b_i,\hat{b}_{\hat{\sigma}}(i)\right)\right] LHungarian (y,y^)=i=1∑N[−logp^σ^(i)(ci)+1{ci=∅}Lbox(bi,b^σ^(i))]

其中 σ ^ \hat{\sigma} σ^为公式(1)中计算的最优分配。在实践中,我们将 c i = ∅ c_i=\emptyset ci=∅时对数概率项的权重降低了10 倍,以缓解类别不平衡问题。这类似于Faster R-CNN训练程序如何通过子采样[36]来平衡正/负建议框。注意,目标和 φ \varphi φ之间的匹配代价并不依赖于预测,这意味着在这种情况下,代价是一个常量。在匹配代价中,我们使用概率 p ^ σ ^ ( i ) ( c i ) \hat{p}_{\hat{\sigma}(i)}\left(c_i\right) p^σ^(i)(ci)而不是对数概率。这使得类预测项与 L b o x ( ⋅ , ⋅ ) \mathcal{L}_\mathrm{box}\left(\cdot,\cdot\right) Lbox(⋅,⋅)可同单位度量,我们观察到更好的实验性能(This makes the class prediction term commensurable to L b o x ( ⋅ , ⋅ ) \mathcal{L}_\mathrm{box}\left(\cdot,\cdot\right) Lbox(⋅,⋅),and we observed better empirical performances.)。

其中 σ ^ \hat{\sigma} σ^为公式(1)中计算的最优分配。在实践中,我们将 c i = ∅ c_i=\varnothing ci=∅时对数概率项的权重降低了10倍,以缓解类别不平衡问题。这类似于Faster R-CNN训练程序如何通过子采样[36]来平衡正/负建议框。注意,目标和 ∅ \varnothing ∅ 之间的匹配代价并不依赖于预测,这意味着在这种情况下,代价是一个常量。在匹配代价中,我们使用概率 p ^ σ ^ ( i ) ( c i ) \hat{p}_{\hat{\sigma}(i)}\left(c_i\right) p^σ^(i)(ci)而不是对数概率。这使得类预测项与 L b o x ( ⋅ , ⋅ ) \mathcal{L}_\mathrm{box}\left(\cdot,\cdot\right) Lbox(⋅,⋅)可同单位度量,我们观察到更好的实验性能(This makes the class prediction term commensurable to L b o x ( ⋅ , ⋅ ) \mathcal{L}_\mathrm{box}\left(\cdot,\cdot\right) Lbox(⋅,⋅),and we observed better empirical performances.)。

**边界框的损失。**匹配代价和匈牙利损失的第二部分是

L

b

o

x

(

⋅

)

\mathcal{L}_{\mathrm{box}}\left(\cdot\right)

Lbox(⋅) , 它对边界框进行评分。不像许多检测器通过一些最初的猜测做边界框预测,我们直接做边界框预测。虽然这种方法简化了实现,但它提出了一个相对缩放损失的问题。最常用的L1损失对于小边界框和大边界框有不同的尺度,即使它们的相对误差是相似的 (The most commonly-used L1 Ioss will have different scales for small and large boxes even if their relative errors are similar. ) 。为了缓解这个问题,我们使用L1损失和尺度不变的广义loU损失[37]

L

i

o

u

(

⋅

,

⋅

)

\mathcal{L}_\mathrm{iou}\left(\cdot,\cdot\right)

Liou(⋅,⋅)的线性组合 (To mitigate this issue we use a linear combination of the L1 loss and the generalized IoU Ioss [37]

L

i

o

u

(

⋅

,

⋅

)

\mathcal{L}_{\mathrm{iou}}\left(\cdot,\cdot\right)

Liou(⋅,⋅) that is scaleinvariant.)。总的来说,我们的边界框损失

L

b

o

x

(

b

i

,

b

^

σ

(

i

)

)

\mathcal{L}_\mathrm{box}\left(b_i,\hat{b}_\sigma(i)\right)

Lbox(bi,b^σ(i))定义为

λ

i

o

u

\lambda _{\mathrm{iou}}

λiou

L

i

o

u

\mathcal{L} _{\mathrm{iou}}

Liou

(

b

i

,

b

^

σ

(

i

)

)

+

λ

L

1

∥

b

i

−

b

^

σ

(

i

)

∥

1

\left ( b_{i}, \hat{b} _{\sigma ( i) }\right ) + \lambda _{\mathrm{L} 1}\left \| b_{i}- \hat{b} _{\sigma ( i) }\right \| _{1}

(bi,b^σ(i))+λL1

bi−b^σ(i)

1,其中

λ

i

o

u

\lambda_\mathrm{iou}

λiou ,

λ

L

1

∈

R

\lambda _{\mathrm{L} 1}\in \mathbb{R}

λL1∈R为超参数。这两个损失是根据批处理中目标的数量规范化的 (These two losses are normalized by the number of objects inside the batch. )。

3.2 DETR architecture

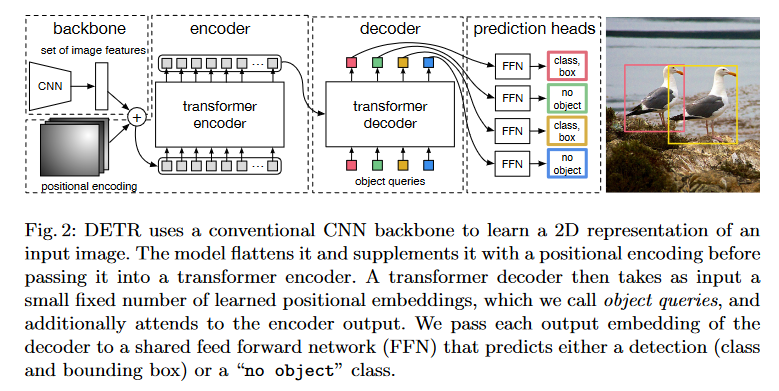

总体的DETR体系结构非常简单,如图2所示。它包含三个主要组成部分,我们将在下面描述:一个CNN主干提取一个紧凑的特征表示;一个编码器-解码器transformer;以及一个简单的前馈网络(FFN),用于做出最终的检测预测。

与许多现代检测器不同的是,DETR可以在任何深度学习框架中实现,框架只需提供一个通用的CNN主干和一个仅几百行代码的transformer架构。在PyTorch[31]中用不到50行代码就可以实现DETR的推理代码。我们希望我们方法的简单性将吸引新的研究人员加入目标检测的研究。

**主干网。**从初始图像 x i m g ∈ R 3 × H 0 × W 0 x_\mathrm{img}\in\mathbb{R}^{3\times H_0\times W_0} ximg∈R3×H0×W0 (3个彩色通道)开始,传统的CNN骨干生成一个低分辨率的 f ∈ R C × H × W f\in\mathbb{R}^{C\times H\times W} f∈RC×H×W激活映射。我们使用的典型值是 C = 2048 C=2048 C=2048 并且 H , W = H 0 32 , W 0 32 . H,W=\frac{H_0}{32},\frac{W_0}{32}. H,W=32H0,32W0.

**Transformer编码器。**首先,1x1卷积将高层激活映射 f f f 的通道维数从 C C C 降至更小的维数 d d d。创建一个新的特征地图 z 0 ∈ R d × H × W z_0\in\mathbb{R}^{d\times H\times W} z0∈Rd×H×W 。编码器需要一个序列作为输入,因此我们将$z_{0} $的空间维度压缩为一维,从而得到一个 d × H W d\times HW d×HW 特征图。每个编码器层都有一个标准的结构,由一个多头自注意模块和一个前馈网络(FFN)组成。由于transformer架构是对顺序不敏感的,我们用固定位置编码[30,3] 对其进行补充,并将其添加到每个注意层的输入中 (Since the transformer architecture is permutation-invariant, we supplement it with fixed positional encodings[30,3] that are added to the input of each attention layer. ) 。我们遵循[46]中补充材料中架构的详细定义。

**Transformer解码器。**解码器遵循transformer的标准架构,使用多头自注意力和编码器-解码器注意机制转换尺寸为 d d d 的 N N N 个嵌入。与原始transformer的不同之处在于,我们的模型在每个解码器层并行解码 N N N 个对象,而Vaswani等人[46]使用自回归模型,每次预测一个元素的输出序列。我们请不熟悉这些概念的读者参阅补充材料。由于解码器也是置换不变(permutation-invariant)的,所以 N N N 个输入嵌入必须不同才能产生不同的结果。(Since the decoder is also permutation-invariant, the N N N input embeddings must be different to produce different results. ) 这些输入嵌入是我们称之为对象查询 (object queries) 的学习出来的位置编码,与编码器类似,我们将它们添加到每个注意层的输入中。 N N N 个对象查询被解码器转换成一个输出嵌入。然后,通过前馈网络(将在下一小节中描述)将它们独立解码为框坐标和类标签,得到 N N N 个最终预测。对这些嵌入使用自注意力和编码器-解码器注意力,模型利用它们之间的成对关系对所有对象进行全局推理,同时能够使用整个图像作为上下文。

**预测前馈网络(FFNs)。**最后的预测是由一个带有ReLU激活函数和隐藏层维数为 d d d 的3层感知机和一个线性投影层计算的。FFN预测输入图像的归一化中心坐标、框的高度和宽度,线性层使用 softmax 函数预测类标签。由于我们预测了一个包含固定大小 N N N 个边界框的集合,其中 N N N 通常比图像中感兴趣的目标的实际数量大得多,因此使用一个额外的特殊类标签 ∅ \varnothing ∅来表示此位置没有检测到由标 (Since we predict a fixedsize set of N N N bounding boxes, where N N N is usually much larger than the actual number of objects of interest in an image, an additional special class label is used to represent that no object is detected within a slot.) 。这个类在标准目标检测方法中扮演着与背景类相似的角色。

**辅助解码损失。**在训练过程中,我们发现在解码器中使用辅助损耗(auxiliary losses)是很有帮助的,特别是有助于模型输出每个类的对象正确数量。每个解码器层的输出用共享层范数进行归一化,然后送到共享预测头(分类和盒预测)(The output of each decoder layer is normalized with a shared layer-norm then fed to the shared prediction heads (classification and box prediction).)。然后,我们像往常一样将匈牙利的损失用于监督。

4 Experiments

我们发现,与Faster R-CNN[36]和RetinaNet[22]相比,DETR在对COCO的定量评价中取得了具有竞争力的结果。然后,我们提供了一个针对架构和损失的详细的消融实验,有详细见解和定性的结果。最后,为了证明DETR是一个通用模型,我们给出了全景分割的结果,在固定的DETR模型上只训练了一个小的扩展(a small extension)。

数据集。我们在COCO 2017检测和全景分割数据集[23,17]上进行实验,其中包含118k训练图像和5k验证图像。每个图像都用边界框和全景分割进行标注。平均每幅图像有7个实例,在训练集中,在同一幅图像上每幅图像最多有63个实例,这些实例也有大有小。如果未特别说明,我们说的 A P AP AP 即为bbox A P AP AP,即在多个阈值上的积分度量(If not specified, we report AP as bbox AP, the integral metric over multiple thresholds. )。为了与其他模型进行比较,我们说明了最后一轮训练的验证 A P AP AP,而在消融中,我们报告了最后10轮训练的中位数(For comparison with other models we report validation AP at the last training epoch, and in ablations we report the median over the last 10 epochs. )。

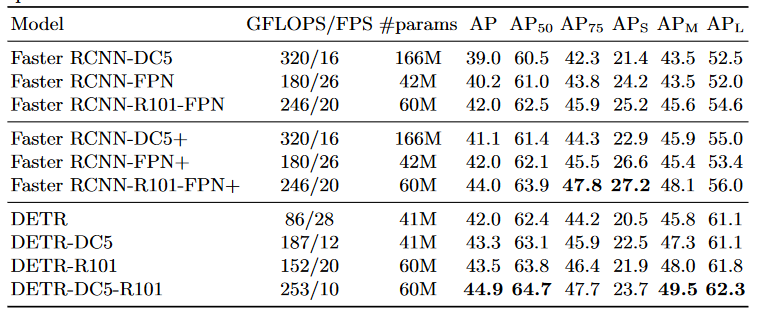

技术细节。我们用AdamW[25]训练DETR,设置初始transformer的学习率为 1 0 − 4 10^{-4} 10−4,主干网络的学习率为 1 0 − 5 10^{-5} 10−5 ,权重衰减为 1 0 − 4 10^{−4} 10−4 。所有transformer权重都用Xavier [10]初始化,骨干网使用来自torchvision的imagenet-pretraining ResNet模型[14],并使用冻结的batchnorm层。我们报告了两种不同的主干: ResNet- 50和ResNet-101的结果。相应的模型分别称为DETR和DETR-r101。根据文献[20],我们还增加了特征分辨率,方法是在主干网的最后阶段增加一个扩张,并从这一阶段的第一次卷积中删除一个步幅(Following [20], we also increase the feature resolution by adding a dilation to the last stage of the backbone and removing a stride from the first convolution of this stage. )。相应的模型分别称为DETR-DC5和DETR-DC5-r101(dilated C5 stage)。这种修改将分辨率提高了2倍,从而提高了小对象的性能,但编码器的自注意成本增加高达16倍,导致计算成本增加了2倍。表1给出了这些模型、Faster R-CNN和retinaNet的FLOPs的完整比较。

我们使用缩放增强,调整输入图像的大小,使短边至少为480个像素,最多为800个像素,长边最多为1333[49]。为了通过编码器的自注意帮助学习全局关系,我们还在训练期间应用随机裁剪增强,提高大约1个AP性能。具体地说,一个训练图像以0.5的概率被裁剪为一个随机矩形补丁,然后再次调整大小为800-1333。训练transformer时,默认dropout值为0.1。在推断时间,一些槽预测空类(At inference time, some slots predict empty class. )。为了优化 $ AP$,我们使用第二个最高得分的类别,使用相应的置信度覆盖这些槽的预测 (To optimize for AP, we override the prediction of these slots with the second highest scoring class, using the corresponding confidence. )。与过滤空槽相比,这将提高2个点的AP。其他训练超参数可以在附录中找到。在我们的消融实验中,我们使用300轮的训练计划,200轮后学习率下降10倍,其中单轮是对所有训练图像的一次遍历。在16个V100 GPU上训练300轮的基线模型需要3天,每个GPU 4张图像(因此总的批大小为64)。对于与Faster R-CNN相比较的较长的时间表,我们训练500轮,400轮后学习速率下降,AP提高了1.5个点(For the longer schedule used to compare with Faster R-CNN we train for 500 epochs with learning rate drop after 400 epochs, which improves AP by 1.5 points. )。

表1:在COCO验证集上与RetinaNet 和Faster R-CNN的比较,主干网包括ResNet-50和ResNet- 101。上面部分显示了Detectron2[49]模型的结果,中间部分显示了GIoU[37]、训练时随机裁剪和增长9 倍训练计划模型的结果(The top section shows results for models in Detectron2 [49], the middle section shows results for models with GIoU [37], random crops train-time augmentation, and the long 9x training schedule. )。DETR模型获得了与调优后的Faster R-CNN基线相当的结果,具有更低的 APS ,但大大改进了 APL 。我们使用torchscript模型来测量FLOPS和FPS。名称中没有R101的结果对应的是ResNet-50。