👉博__主👈:米码收割机

👉技__能👈:C++/Python语言

👉公众号👈:测试开发自动化【获取源码+商业合作】

👉荣__誉👈:阿里云博客专家博主、51CTO技术博主

👉专__注👈:专注主流机器人、人工智能等相关领域的开发、测试技术。

【python】python基于 Q-learning 算法的迷宫游戏(源码+论文)【独一无二】

目录

- 【python】python基于 Q-learning 算法的迷宫游戏(源码+论文)【独一无二】

- 一、设计要求

- 设计需求

- 二、设计思路

- 代码设计思路分析

- 1. 迷宫环境模块(MazeEnv 类)

- 1.1 初始化环境

- 1.2 重置环境

- 1.3 执行动作

- 1.4 获取状态和渲染环境

- 2. Q-learning 算法模块(QLearningAgent 类)

- 2.1 初始化代理

- 2.2 选择动作

- 2.3 学习和训练

- 3. 图形用户界面模块(MazeGUI 类)

- 3.1 初始化界面

- 3.2 界面设置和重置环境

- 3.3 更新位置和绘制迷宫

- 4. 主程序入口

- 总结

一、设计要求

设计需求

本项目旨在开发一个基于 Q-learning 算法的迷宫游戏,并通过 PyQt5 图形用户界面展示训练过程和结果。具体设计需求如下:

-

迷宫环境:

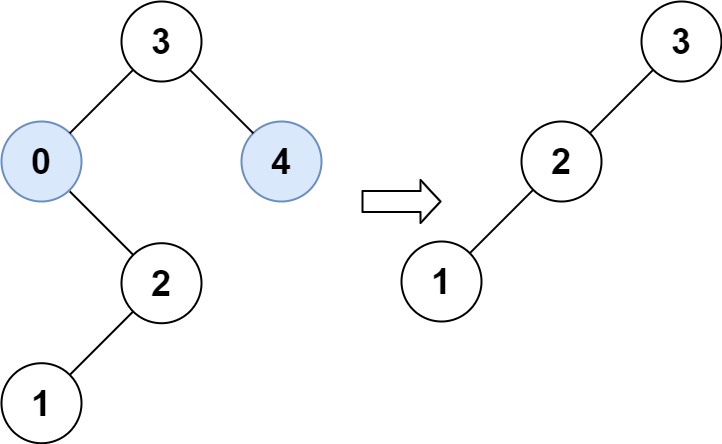

- 创建一个5x5网格的迷宫环境(MazeEnv 类),定义起始点(0,0)和目标点(4,4)。

- 实现环境的状态空间和动作空间,状态空间为网格中的每个位置,动作空间包括上下左右四个方向。

- 提供重置(reset)、执行动作(step)和渲染(render)方法:

- 重置方法将状态重置为起始点。

- 执行动作方法根据动作更新状态,判断是否到达目标点,并返回新的状态、奖励和是否结束标志。

- 渲染方法使用 NumPy 数组显示当前迷宫状态。

-

Q-learning 算法:

- 实现 Q-learning 代理(QLearningAgent 类),用于在迷宫中找到最优路径。

- 定义学习率、折扣因子和探索率,初始化 Q 表。

- 提供选择动作(choose_action)和学习(learn)方法:

- 选择动作方法根据 epsilon-greedy 策略选择动作。

- 学习方法根据 Q-learning 更新规则更新 Q 表。

- 提供训练方法(train),通过多次训练迭代优化策略。

👉👉👉 源码获取 关注【测试开发自动化】公众号,回复 “ 强化迷宫 ” 获取,拿来即用。👈👈👈

-

图形用户界面:

- 使用 PyQt5 创建图形用户界面(MazeGUI 类),展示迷宫和代理的动作。

- 设置窗口标题和尺寸,提供绘制迷宫和更新代理位置的方法。

- 定时器用于更新代理位置和重新绘制迷宫。

-

主程序入口:

- 初始化迷宫环境和 Q-learning 代理,并进行训练。

- 启动 PyQt5 应用程序,显示图形界面。

自动找迷宫出口:

👉👉👉 源码获取 关注【测试开发自动化】公众号,回复 “ 强化迷宫 ” 获取,拿来即用。👈👈👈

二、设计思路

代码设计思路分析

该项目的目的是实现一个迷宫游戏,并使用 Q-learning 算法进行训练,通过 PyQt5 提供图形用户界面展示游戏过程。代码主要分为以下几个模块:迷宫环境、Q-learning 算法、图形用户界面和主程序入口。以下是详细的设计思路分析:

1. 迷宫环境模块(MazeEnv 类)

功能描述:定义迷宫环境,包含网格大小、起始点、目标点、状态空间和动作空间。

1.1 初始化环境

class MazeEnv(gym.Env):

def __init__(self):

super(MazeEnv, self).__init__()

self.grid_size = 5

self.observation_space = spaces.Discrete(self.grid_size * self.grid_size)

self.action_space = spaces.Discrete(4) # 上下左右

# 代码略(至少十行)...

# 代码略(至少十行)...

- 设置网格大小为5x5。

- 定义状态空间和动作空间。

- 初始化起始点和目标点。

👉👉👉 源码获取 关注【测试开发自动化】公众号,回复 “ 强化迷宫 ” 获取,拿来即用。👈👈👈

1.2 重置环境

def reset(self):

self.state = self.start

return self._get_state()

- 将当前状态重置为起始点。

1.3 执行动作

def step(self, action):

x, y = self.state

if action == 0: # 上

y = max(y - 1, 0)

# 代码略(至少十行)...

# 代码略(至少十行)...

self.state = (x, y)

done = self.state == self.goal

reward = 1 if done else -0.1

return self._get_state(), reward, done, {}

- 根据动作更新状态。

- 判断是否达到目标点,返回新状态、奖励、是否结束标志和额外信息。

1.4 获取状态和渲染环境

def _get_state(self):

return self.state[0] * self.grid_size + self.state[1]

def render(self):

grid = np.zeros((self.grid_size, self.grid_size))

x, y = self.state

grid[x, y] = 1

print(grid)

- 将状态转换为离散值。

- 使用 NumPy 数组显示当前状态。

👉👉👉 源码获取 关注【测试开发自动化】公众号,回复 “ 强化迷宫 ” 获取,拿来即用。👈👈👈

2. Q-learning 算法模块(QLearningAgent 类)

功能描述:实现 Q-learning 算法,用于训练代理在迷宫中找到最优路径。

2.1 初始化代理

class QLearningAgent:

def __init__(self, env, learning_rate=0.1, discount_factor=0.9, epsilon=0.1):

self.env = env

self.q_table = defaultdict(lambda: np.zeros(env.action_space.n))

self.learning_rate = learning_rate

self.discount_factor = discount_factor

self.epsilon = epsilon

- 初始化学习率、折扣因子、探索率和 Q 表。

2.2 选择动作

def choose_action(self, state):

if random.uniform(0, 1) < self.epsilon:

return self.env.action_space.sample()

else:

return np.argmax(self.q_table[state])

- 根据 epsilon-greedy 策略选择动作。

2.3 学习和训练

👉👉👉 源码获取 关注【测试开发自动化】公众号,回复 “ 强化迷宫 ” 获取,拿来即用。👈👈👈

def learn(self, state, action, reward, next_state):

predict = self.q_table[state][action]

target = reward + self.discount_factor * np.max(self.q_table[next_state])

self.q_table[state][action] += self.learning_rate * (target - predict)

def train(self, episodes=1000):

for _ in range(episodes):

state = self.env.reset()

done = False

while not done:

action = self.choose_action(state)

next_state, reward, done, _ = self.env.step(action)

self.learn(state, action, reward, next_state)

state = next_state

- 更新 Q 表。

- 通过多次训练迭代优化策略。

👉👉👉 源码获取 关注【测试开发自动化】公众号,回复 “ 强化迷宫 ” 获取,拿来即用。👈👈👈

3. 图形用户界面模块(MazeGUI 类)

功能描述:使用 PyQt5 创建图形界面,展示迷宫和代理的动作。

3.1 初始化界面

class MazeGUI(QMainWindow):

def __init__(self, env, agent):

super().__init__()

self.env = env

self.agent = agent

self.initUI()

# 代码略(至少十行)...

# 代码略(至少十行)...

- 初始化界面,设置定时器,调用重置环境方法。

3.2 界面设置和重置环境

def initUI(self):

self.setWindowTitle('Maze Game with Q-Learning')

# 代码略(至少十行)...

# 代码略(至少十行)...

self.show()

def reset_env(self):

self.state = self.env.reset()

# 代码略(至少十行)...

# 代码略(至少十行)...

- 设置窗口标题和尺寸,显示窗口。

- 重置环境,开始定时器。

👉👉👉 源码获取 关注【测试开发自动化】公众号,回复 “ 强化迷宫 ” 获取,拿来即用。👈👈👈

3.3 更新位置和绘制迷宫

def update_position(self):

if not self.done:

action = self.agent.choose_action(self.state)

# 代码略(至少十行)...

# 代码略(至少十行)...

else:

self.timer.stop()

def paintEvent(self, event):

qp = QPainter()

# 代码略(至少十行)...

# 代码略(至少十行)...

def drawMaze(self, qp):

size = self.env.grid_size

cell_size = self.width() // size

# 代码略(至少十行)...

# 代码略(至少十行)...

# Draw agent

agent_x, agent_y = self.env.state

qp.setBrush(QColor(0, 0, 255))

qp.drawRect(agent_y * cell_size, agent_x * cell_size, cell_size, cell_size)

- 更新代理位置,绘制迷宫和代理。

👉👉👉 源码获取 关注【测试开发自动化】公众号,回复 “ 强化迷宫 ” 获取,拿来即用。👈👈👈

4. 主程序入口

功能描述:初始化环境和代理,启动图形界面。

if __name__ == '__main__':

env = MazeEnv()

agent = QLearningAgent(env)

agent.train(episodes=1000)

app = QApplication(sys.argv)

ex = MazeGUI(env, agent)

sys.exit(app.exec_())

- 创建环境和代理,训练代理。

- 启动 PyQt5 应用程序,显示图形界面。

总结

- 迷宫环境模块:定义迷宫环境,包含状态空间和动作空间,提供状态更新和渲染方法。

- Q-learning 算法模块:实现 Q-learning 算法,训练代理在迷宫中找到最优路径。

- 图形用户界面模块:使用 PyQt5 创建图形界面,展示迷宫和代理的动作。

- 主程序入口:初始化环境和代理,启动图形界面。

通过上述设计,该代码实现了一个功能完整的迷宫游戏,能够通过 Q-learning 算法进行训练,并实时展示训练过程和结果。

👉👉👉 源码获取 关注【测试开发自动化】公众号,回复 “ 强化迷宫 ” 获取,拿来即用。👈👈👈