项目概述

智能建筑管理系统(Intelligent Building Management System, IBMS)是一个集成多种技术的复杂系统,旨在通过智能化手段提升建筑的管理效率、节能效果和居住舒适度。该系统涉及嵌入式系统、物联网(IoT)、大数据分析、云计算等多个领域,构建出一个高效、可靠和智能的建筑环境。

系统设计

硬件设计

-

微控制器

- 采用ARM Cortex-M系列和ESP32微控制器作为核心控制单元,负责数据采集和处理。

-

传感器

- 温度传感器:监测室内外温度。

- 湿度传感器:监测环境湿度。

- CO2传感器:监测空气质量。

- 光照传感器:检测照明需求。

- 能耗传感器:实时监控能耗情况。

-

执行器

- 智能开关、阀门控制器等,用于自动化控制。

-

通信模块

- Wi-Fi、Zigbee、LoRa等,支持设备间的无线通信。

硬件架构示意图

软件设计

-

物联网协议

- 采用MQTT、CoAP、HTTP/HTTPS和Modbus等协议,确保设备间的有效通信。

-

嵌入式软件开发

- 使用C/C++进行底层开发,Python用于快速原型开发,基于FreeRTOS构建实时操作系统。

-

边缘计算

- 采用Docker容器化部署,利用Kubernetes管理分布式边缘节点,提高系统稳定性与扩展性。

-

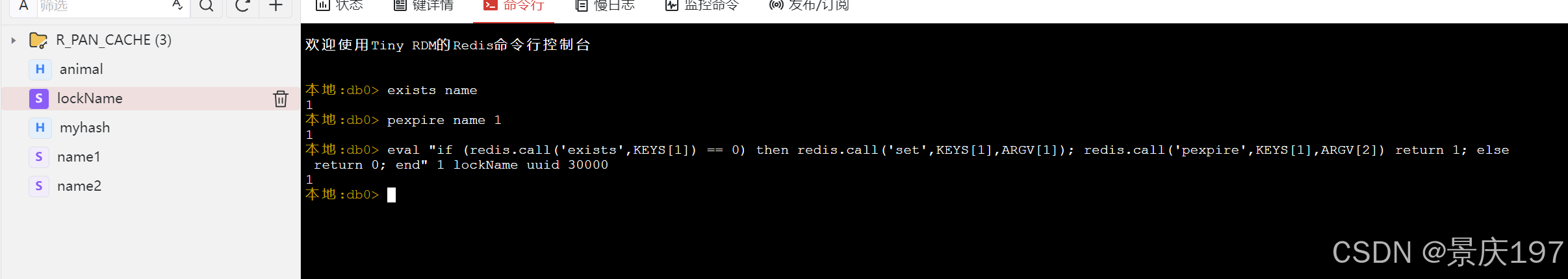

数据存储

- 使用时序数据库(InfluxDB、TimescaleDB)存储传感器数据,NoSQL数据库(MongoDB、Cassandra)进行非结构化数据存储,关系型数据库(PostgreSQL、MySQL)用于用户管理与应用数据存储。

-

大数据处理

- 采用Apache Hadoop和Apache Spark处理历史数据,利用Apache Flink进行实时数据处理。

-

数据分析与机器学习

- 使用Python(Pandas, NumPy, Scikit-learn)进行数据分析,深度学习框架(TensorFlow或PyTorch)用于构建预测模型。

-

数据可视化

- 使用Grafana、Tableau和D3.js进行数据展示,帮助管理人员实时监控建筑状态。

-

云平台

- 选择Amazon AWS、Microsoft Azure或Google Cloud Platform提供基础设施支持。

-

Web开发(管理界面)

- 前端使用React、Vue.js或Angular,后端使用Node.js、Django或Flask进行API开发。

硬件端代码

以下是一个简单的传感器数据采集和上传的代码实现示例。

代码示例

1. 传感器数据采集

#include <Wire.h>

#include <DHT.h>

#define DHTPIN 2 // DHT传感器连接引脚

#define DHTTYPE DHT11 // DHT 11类型传感器

DHT dht(DHTPIN, DHTTYPE); // 初始化DHT传感器

void setup() {

Serial.begin(9600); // 启动串口通信

dht.begin(); // 启动DHT传感器

}

void loop() {

// 读取温度和湿度数据

float h = dht.readHumidity();

float t = dht.readTemperature();

// 检查读取是否成功

if (isnan(h) || isnan(t)) {

Serial.println("读取失败!");

return;

}

Serial.print("湿度: ");

Serial.print(h);

Serial.print(" %\t");

Serial.print("温度: ");

Serial.print(t);

Serial.println(" *C");

// 延时2秒

delay(2000);

}代码讲解:

- 该代码使用DHT传感器读取温度和湿度数据。

- 在

setup()函数中初始化串口和传感器。 - 在

loop()函数中,代码每2秒钟读取一次温度和湿度信息。 - 通过

dht.readHumidity()和dht.readTemperature()函数获取湿度和温度数据。 - 使用

isnan()函数检查读取的数据是否有效,如果无效,则打印错误消息。 - 有效的数据将被打印到串口监视器,便于调试和监控。

2. 数据上传到云平台

以下是一个简单的Python代码示例,用于将传感器数据上传到云端(例如使用MQTT协议)。

import paho.mqtt.client as mqtt

import json

import time

# MQTT服务器配置

broker = "mqtt.example.com"

port = 1883

topic = "building/sensors"

# MQTT回调函数

def on_connect(client, userdata, flags, rc):

print("连接成功, 返回码: " + str(rc))

# 创建MQTT客户端

client = mqtt.Client()

client.on_connect = on_connect

# 连接到MQTT服务器

client.connect(broker, port, 60)

while True:

# 模拟传感器数据

sensor_data = {

"temperature": 22.5,

"humidity": 60.0

}

# 将数据转换为JSON格式

payload = json.dumps(sensor_data)

# 发布消息到指定主题

client.publish(topic, payload)

print("数据已发布: " + payload)

# 延时5秒

time.sleep(5)数据存储

1. 使用时序数据库(InfluxDB)

以下示例展示如何使用Python将传感器数据存储到InfluxDB中。

from influxdb import InfluxDBClient

import random

import time

# 创建InfluxDB客户端

client = InfluxDBClient(host='localhost', port=8086, database='building')

while True:

# 模拟传感器数据

temperature = random.uniform(20.0, 25.0) # 生成20-25之间的随机温度

humidity = random.uniform(30.0, 60.0 ) # 生成30-60之间的随机湿度

# 构造数据点

json_body = [

{

"measurement": "sensor_data",

"tags": {

"location": "office"

},

"fields": {

"temperature": temperature,

"humidity": humidity

}

}

]

# 写入数据到InfluxDB

client.write_points(json_body)

print(f"写入数据: 温度={temperature:.2f}, 湿度={humidity:.2f}")

# 延时5秒

time.sleep(5)

代码讲解:

- 该代码使用

influxdbPython库连接到InfluxDB。 - 在无限循环中,随机生成温度和湿度数据,并将这些数据格式化为JSON结构。

- 使用

client.write_points()方法将数据写入InfluxDB的sensor_data测量中。 - 通过

time.sleep(5)实现每5秒写入一次数据。

2. 使用NoSQL数据库(MongoDB)

以下示例展示如何使用Python将传感器数据存储到MongoDB中。

代码讲解:

- 该Python脚本使用Paho MQTT库创建MQTT客户端,与MQTT服务器建立连接。

- 在

on_connect回调函数中,打印连接状态。 - 使用

client.publish()方法将传感器模拟数据(温度和湿度)发布到指定的MQTT主题。 - 数据以JSON格式发送,便于后端系统解析和存储。

- 代码延时5秒后再次发送数据,形成数据流。

2. 使用NoSQL数据库(MongoDB)

以下示例展示如何使用Python将传感器数据存储到MongoDB中。

from pymongo import MongoClient

import random

import time

# 创建MongoDB客户端

client = MongoClient('localhost', 27017)

db = client['building']

collection = db['sensor_data']

while True:

# 模拟传感器数据

sensor_data = {

"temperature": random.uniform(20.0, 25.0),

"humidity": random.uniform(30.0, 60.0),

"timestamp": time.time()

}

# 插入数据到MongoDB

collection.insert_one(sensor_data)

print(f"插入数据: {sensor_data}")

# 延时5秒

time.sleep(5)

代码讲解:

- 使用

pymongo库连接到MongoDB数据库。 - 在无限循环中,生成一个包含温度、湿度和时间戳的字典。

- 使用

collection.insert_one()方法将数据插入到MongoDB的sensor_data集合中。 - 每5秒插入一次数据。

3. 使用关系型数据库(PostgreSQL)

以下示例展示如何使用Python将传感器数据存储到PostgreSQL中。

import psycopg2

import random

import time

# 连接到PostgreSQL数据库

conn = psycopg2.connect(

dbname="building",

user="your_username",

password="your_password",

host="localhost",

port="5432"

)

cur = conn.cursor()

# 创建表(如果不存在)

cur.execute('''

CREATE TABLE IF NOT EXISTS sensor_data (

id SERIAL PRIMARY KEY,

temperature FLOAT NOT NULL,

humidity FLOAT NOT NULL,

timestamp TIMESTAMP DEFAULT CURRENT_TIMESTAMP

)

''')

conn.commit()

while True:

# 模拟传感器数据

temperature = random.uniform(20.0, 25.0)

humidity = random.uniform(30.0, 60.0)

# 插入数据到PostgreSQL

cur.execute('''

INSERT INTO sensor_data (temperature, humidity)

VALUES (%s, %s)

''', (temperature, humidity))

conn.commit()

print(f"插入数据: 温度={temperature:.2f}, 湿度={humidity:.2f}")

# 延时5秒

time.sleep(5)

# 关闭连接

cur.close()

conn.close()代码讲解:

- 使用

psycopg2库连接到PostgreSQL数据库。 - 在程序启动时创建

sensor_data表(如果不存在)。 - 在无限循环中生成温度和湿度数据,使用

cur.execute()将数据插入到表中。 - 使用

conn.commit()提交事务,确保数据写入数据库。

大数据处理

1. 使用Apache Hadoop

以下是一个简单的Hadoop MapReduce示例,展示如何处理存储在HDFS中的传感器数据。

Mapper(mapper.py)

#!/usr/bin/env python

import sys

# Mapper:读取每一行数据,输出温度和湿度

for line in sys.stdin:

line = line.strip()

if line:

# 假设数据格式为: timestamp, temperature, humidity

timestamp, temperature, humidity = line.split(',')

print(f"{timestamp}\t{temperature}\t{humidity}")Reducer(reducer.py)

#!/usr/bin/env python

import sys

# Reducer:计算平均温度和湿度

total_temperature = 0

total_humidity = 0

count = 0

for line in sys.stdin:

line = line.strip()

if line:

_, temperature, humidity = line.split('\t')

total_temperature += float(temperature)

total_humidity += float(humidity)

count += 1

if count > 0:

avg_temperature = total_temperature / count

avg_humidity = total_humidity / count

print(f"Average Temperature: {avg_temperature:.2f}, Average Humidity: {avg_humidity:.2f}")

代码讲解:

mapper.py读取输入的传感器数据,每行数据格式为timestamp, temperature, humidity,并输出到标准输出。reducer.py接收Mapper的输出,计算温度和湿度的平均值,并将结果打印到标准输出。- 这个示例展示了Hadoop的基本MapReduce工作原理,适合批量处理历史数据。

2. 使用Apache Spark

以下是使用PySpark进行数据处理的示例,计算传感器数据的平均值。

from pyspark.sql import SparkSession

from pyspark.sql.functions import avg

# 创建Spark会话

spark = SparkSession.builder \

.appName("SensorDataProcessing") \

.getOrCreate()

# 读取CSV文件

df = spark.read.csv("hdfs://path/to/sensor_data.csv", header=True, inferSchema=True)

# 计算平均温度和湿度

avg_df = df.select(avg("temperature").alias("avg_temperature"), avg("humidity").alias("avg_humidity"))

# 显示结果

avg_df.show()

# 关闭Spark会话

spark.stop()

代码讲解:

- 使用

SparkSession创建Spark应用。 - 从HDFS中读取CSV格式的传感器数据,自动推断数据类型。

- 使用

avg()函数计算温度和湿度的平均值,并将结果显示。 avg_df.show()打印结果,便于查看数据处理结果。

3. 使用Apache Flink

以下是使用Apache Flink进行实时数据处理的示例,计算实时传感器数据的平均值。

from pyflink.datastream import StreamExecutionEnvironment

from pyflink.common.serialization import SimpleStringSchema

from pyflink.datastream import StreamExecutionEnvironment

from pyflink.datastream.connectors import KafkaSource

from pyflink.common import Types

# 创建Flink执行环境

env = StreamExecutionEnvironment.get_execution_environment()

# 读取数据流(假设数据从Kafka读取)

data_stream = env.add_source(KafkaSource.builder()

.set_bootstrap_servers("localhost:9092")

.set_topic("sensor_data")

.set_group_id("sensor_group")

.set_value_only_deserializer(SimpleStringSchema())

.build())

# 定义处理逻辑

def process_data(data):

# 解析数据

fields = data.split(',')

temperature = float(fields[1])

humidity = float(fields[2])

return (temperature, humidity)

# 转换数据流并计算平均值

avg_stream = data_stream \

.map(process_data) \

.key_by(lambda x: 0) \

.reduce(lambda x, y: (x[0] + y[0], x[1] + y[1])) \

.map(lambda x: (x[0] / 2, x[1] / 2)) # 计算平均值

# 输出结果

avg_stream.print()

# 启动Flink程序

env.execute("Sensor Data Average Calculation")代码讲解:

StreamExecutionEnvironment:创建Flink执行环境,作为数据流处理的上下文。KafkaSource:从Kafka读取数据流,假设传感器数据以CSV格式存储,格式为timestamp,temperature,humidity。process_data函数:解析输入数据,将温度和湿度转换为浮点数,返回一个元组。key_by(lambda x: 0):将所有数据分配到同一组,以便后续的聚合操作。reduce函数:累加温度和湿度的值。这里假设每次调用reduce的输入都是一对温度和湿度元组。- 第二个

map操作用于计算平均值(除以2,假设每次输入一对数据)。 avg_stream.print():打印计算出的平均值到控制台。env.execute():启动Flink程序。

数据分析与机器学习

1. 数据分析(使用Pandas)

以下示例展示如何使用Pandas分析传感器数据并计算温度和湿度的平均值。

import pandas as pd

# 从CSV文件读取传感器数据

df = pd.read_csv('sensor_data.csv')

# 显示数据的前5行

print(df.head())

# 计算平均温度和湿度

average_temperature = df['temperature'].mean()

average_humidity = df['humidity'].mean()

print(f"平均温度: {average_temperature:.2f}")

print(f"平均湿度: {average_humidity:.2f}")代码讲解:

- 使用

pandas库读取存储在CSV文件中的传感器数据。 df.head()显示数据的前5行,便于检查数据格式。- 使用

mean()函数计算温度和湿度的平均值,并打印结果。

2. 机器学习(使用Scikit-learn)

以下示例展示如何使用Scikit-learn构建一个简单的线性回归模型,预测温度。

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error, r2_score

# 从CSV文件读取传感器数据

df = pd.read_csv('sensor_data.csv')

# 准备特征和目标变量

X = df[['humidity']] # 特征:湿度

y = df['temperature'] # 目标:温度

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建线性回归模型

model = LinearRegression()

model.fit(X_train, y_train) # 训练模型

# 进行预测

predictions = model.predict(X_test)

# 打印预测结果

for actual, predicted in zip(y_test, predictions):

print(f"实际温度: {actual:.2f}, 预测温度: {predicted:.2f}")

# 评估模型性能

mse = mean_squared_error(y_test, predictions)

r2 = r2_score(y_test, predictions)

print(f"均方误差: {mse:.2f}")

print(f"R²得分: {r2:.2f}")

代码讲解:

- 使用

pandas库读取存储在CSV文件中的传感器数据。 - 特征变量

X是湿度,目标变量y是温度。 - 使用

train_test_split函数将数据划分为训练集(80%)和测试集(20%)。 - 创建线性回归模型

LinearRegression()并使用fit()方法在训练数据上训练模型。 - 使用模型的

predict()方法对测试集进行预测。 - 使用

mean_squared_error和r2_score评估模型性能,计算均方误差(MSE)和R²得分,并打印实际温度和预测温度的比较结果。

3. 深度学习(使用TensorFlow或PyTorch)

以下是使用TensorFlow构建一个简单的神经网络模型来预测传感器数据的示例。

import pandas as pd

import numpy as np

import tensorflow as tf

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

# 从CSV文件读取传感器数据

df = pd.read_csv('sensor_data.csv')

# 准备特征和目标变量

X = df[['humidity']].values # 特征:湿度

y = df['temperature'].values # 目标:温度

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 标准化特征

scaler = StandardScaler()

X_train = scaler.fit_transform(X_train)

X_test = scaler.transform(X_test)

# 创建神经网络模型

model = tf.keras.Sequential([

tf.keras.layers.Dense(64, activation='relu', input_shape=(X_train.shape[1],)),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(1) # 输出层

])

# 编译模型

model.compile(optimizer='adam', loss='mean_squared_error')

# 训练模型

model.fit(X_train, y_train, epochs=100, batch_size=32, verbose=1)

# 进行预测

predictions = model.predict(X_test)

# 打印预测结果

for actual, predicted in zip(y_test, predictions):

print(f"实际温度: {actual:.2f}, 预测温度: {predicted[0]:.2f}")

# 评估模型性能

mse = model.evaluate(X_test, y_test)

print(f"均方误差: {mse:.2f}")

代码讲解:

- 使用

pandas读取传感器数据,并准备特征和目标变量。 - 将数据分为训练集和测试集。

- 使用

StandardScaler进行标准化,确保输入特征的均值为0,标准差为1。 - 使用

tf.keras.Sequential构建一个简单的神经网络模型,包括两层隐藏层和一个输出层。 - 编译模型时指定优化器(Adam)和损失函数(均方误差)。

数据可视化

1. 使用Matplotlib和Seaborn可视化传感器数据

以下示例展示如何使用Matplotlib和Seaborn对传感器数据进行可视化。

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

# 从CSV文件读取传感器数据

df = pd.read_csv('sensor_data.csv')

# 设置绘图风格

sns.set(style='whitegrid')

# 绘制温度和湿度的散点图

plt.figure(figsize=(12, 6))

sns.scatterplot(data=df, x='humidity', y='temperature', color='blue', alpha=0.6)

plt.title('温度与湿度的关系')

plt.xlabel('湿度 (%)')

plt.ylabel('温度 (°C)')

plt.show()

代码讲解:

- 使用

pandas读取传感器数据。 - 使用

seaborn设置绘图风格。 - 创建一个散点图,x轴为湿度,y轴为温度,使用

scatterplot()函数进行绘制。 - 设置图表标题和坐标轴标签,最后通过

plt.show()显示图表。

2. 使用Grafana可视化时序数据

Grafana是一个强大的开源可视化工具,通常与时序数据库(如InfluxDB)配合使用。以下是使用Grafana可视化传感器数据的基本步骤:

-

安装Grafana:

- 可以通过Docker或直接在本地系统上安装Grafana。

-

连接InfluxDB:

- 在Grafana的管理界面中,添加数据源,选择InfluxDB,配置连接信息。

-

创建仪表盘:

- 在Grafana中创建一个新的仪表盘,添加图表面板。

- 使用InfluxQL或Flux查询语言从InfluxDB中查询传感器数据。

-

可视化数据:

- 根据需要选择合适的图表类型(如折线图、柱状图等)进行数据可视化。

3. 使用Tableau可视化数据

Tableau是一个用户友好的数据可视化工具,适合进行复杂数据分析和可视化。以下是使用Tableau可视化传感器数据的步骤:

-

导入数据:

- 将传感器数据导入Tableau,支持多种数据源,如Excel、CSV、数据库等。

-

创建视图:

- 使用拖放界面创建视图,选择维度(如时间、湿度)和度量(如温度)。

- 可以创建散点图、折线图、仪表等多种可视化类型。

-

交互式分析:

- 利用Tableau的过滤器和参数功能,实现交互式数据分析,用户可以根据需要选择不同的视图。

项目总结

智能建筑管理系统是一个跨领域的协同应用,涉及嵌入式系统、物联网、大数据、云计算等众多技术。通过整合这些技术,系统能够实现对建筑环境的实时监控和管理,提升了建筑的能源效率和用户的舒适度。

主要特点:

- 实时监控:通过传感器数据实时监测建筑环境。

- 智能控制:利用执行器实现自动化控制,提高管理效率。

- 数据分析:通过大数据技术和机器学习算法,挖掘潜在的节能机会。

- 灵活部署:基于云计算和边缘计算,系统具备良好的扩展性和可维护性。