目录

- 项目初始与项目演示

- HTTP服务器基础认识

- Reactor模式基础认识

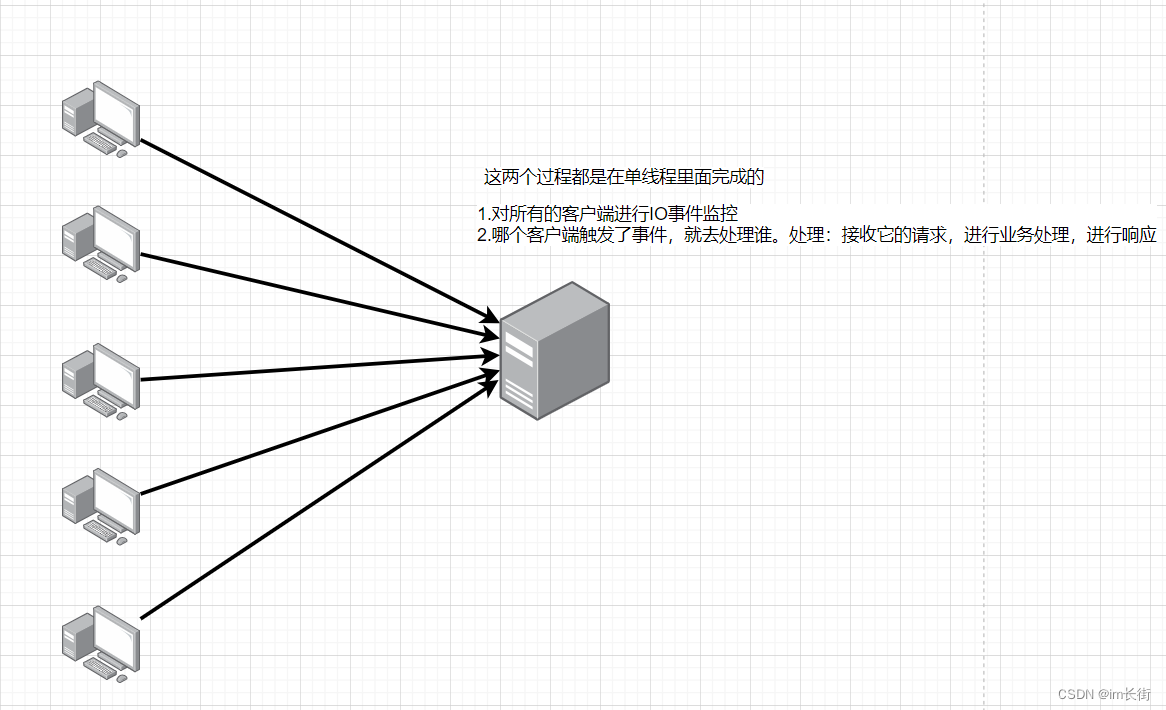

- 单Reactor单线程模式认识

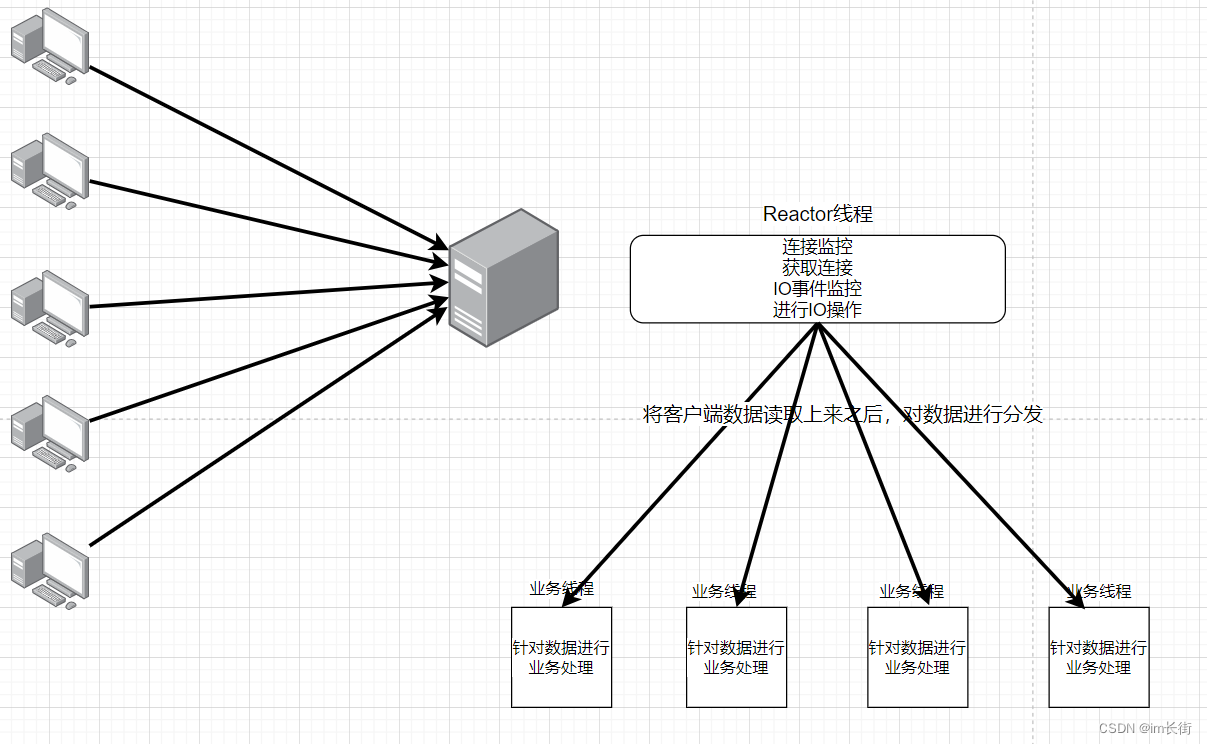

- 单Reactor多线程模式认识

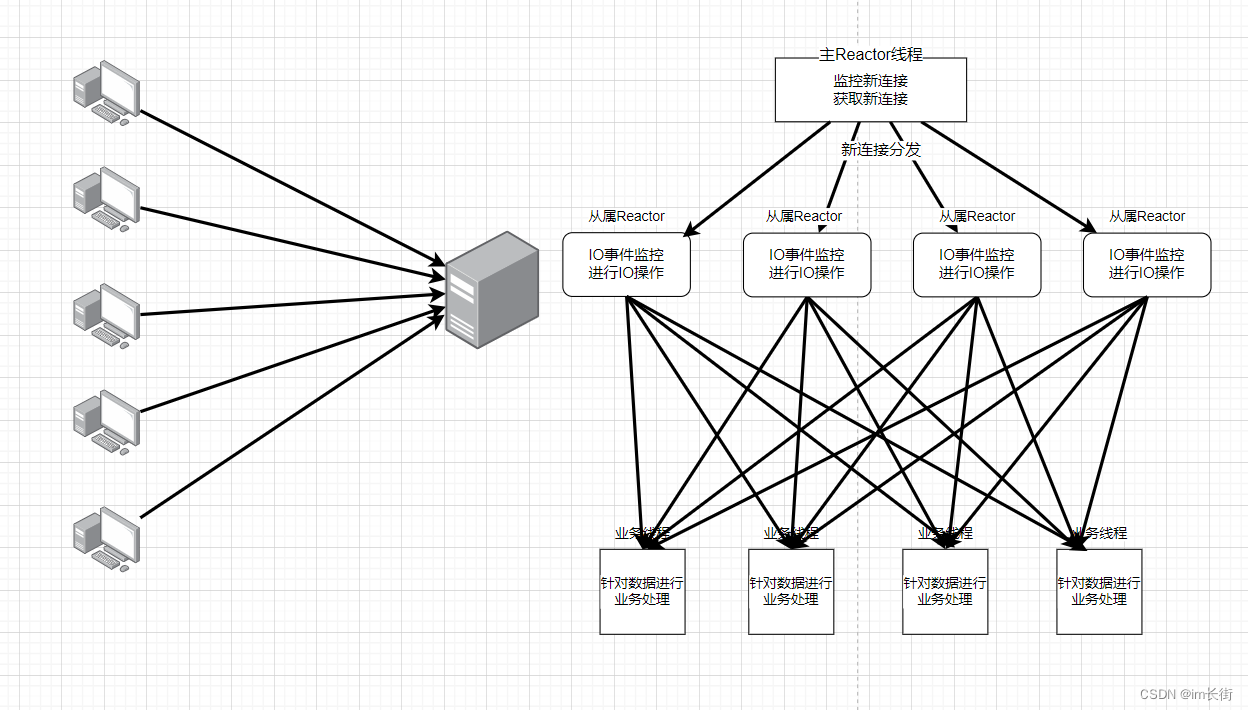

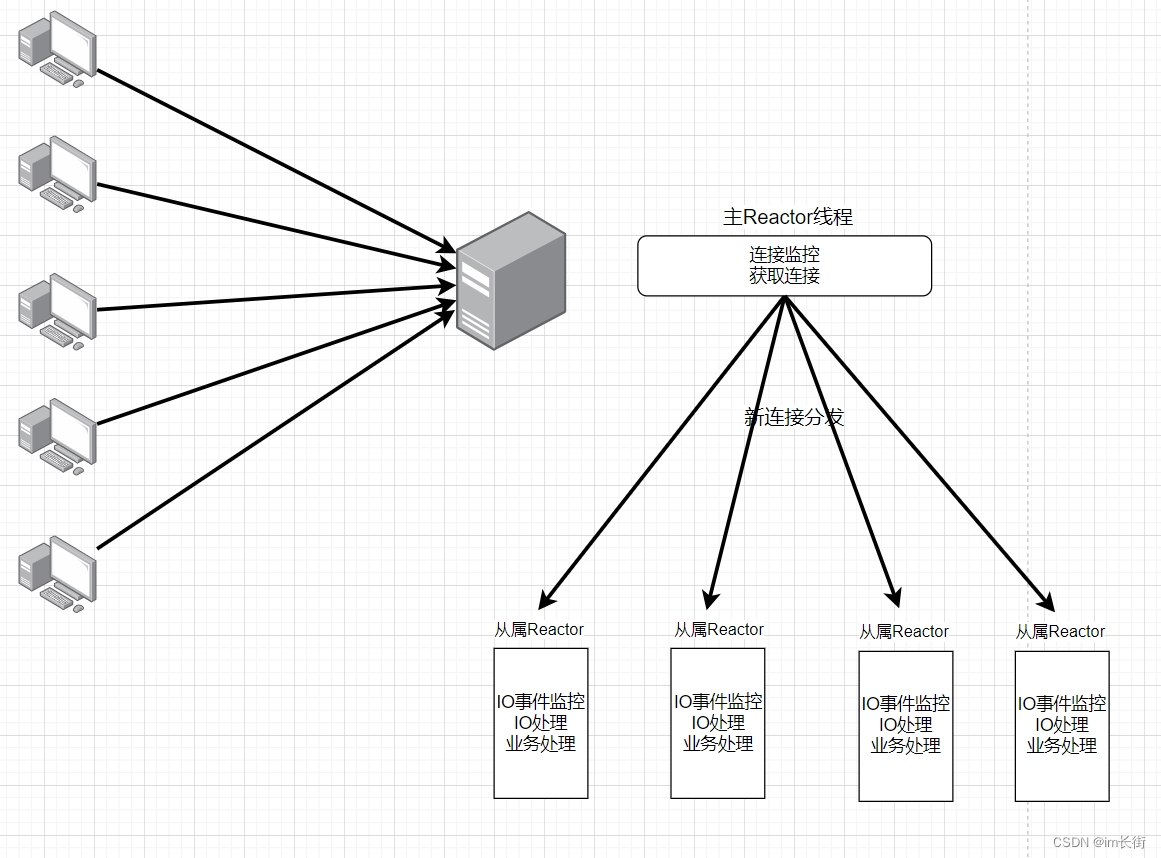

- 多Reactor多线程模式认识

- 目标定位

- 总体大模块划分

- server模块的管理思想

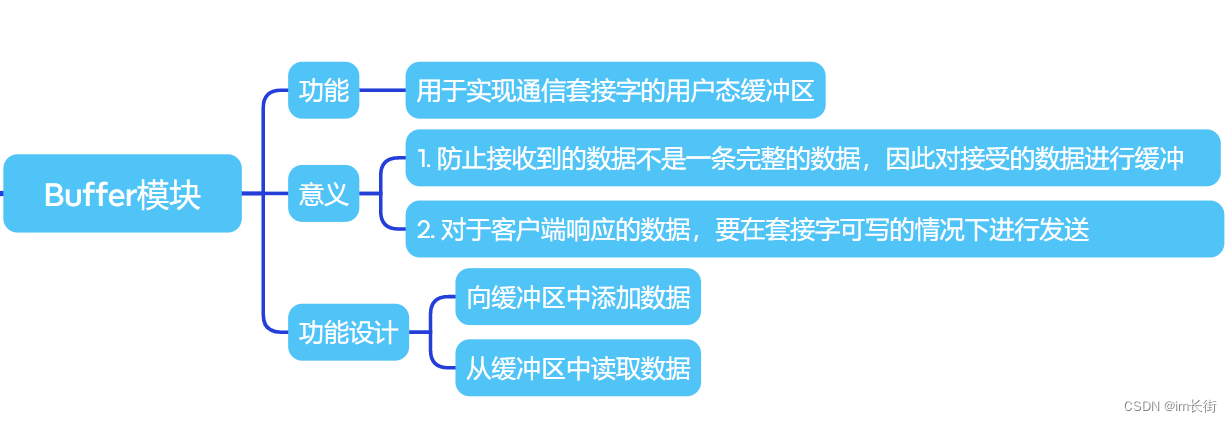

- Buffer子模块

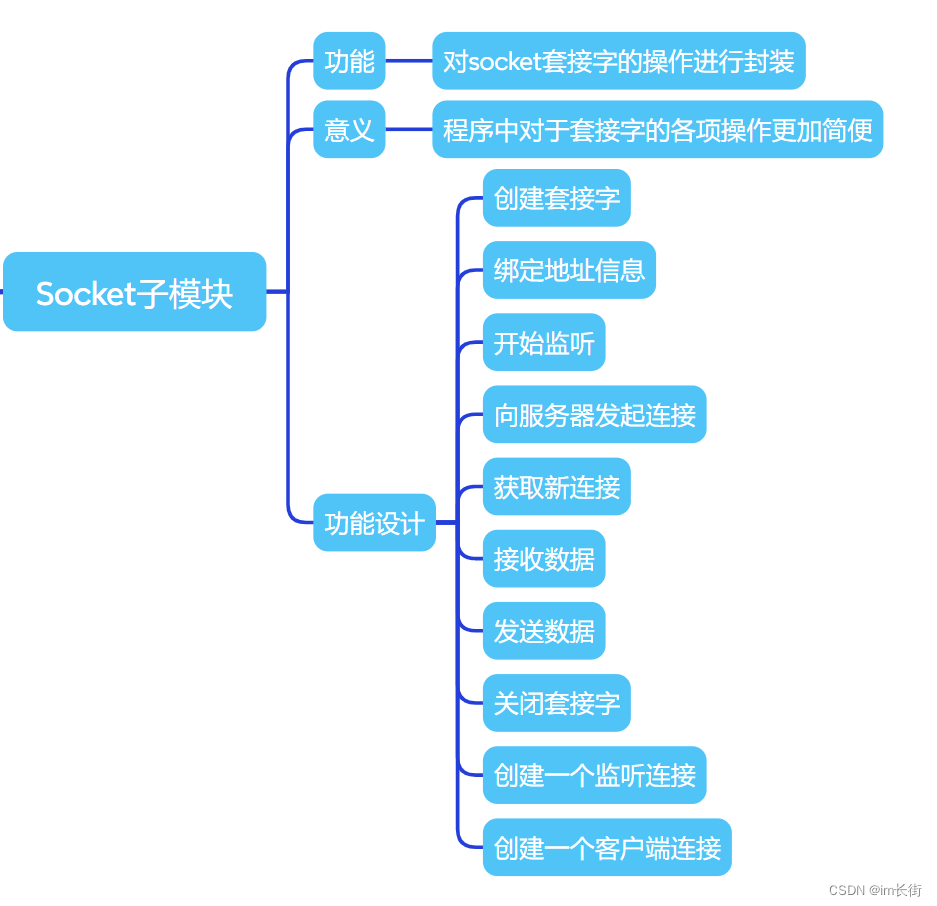

- Socket子模块

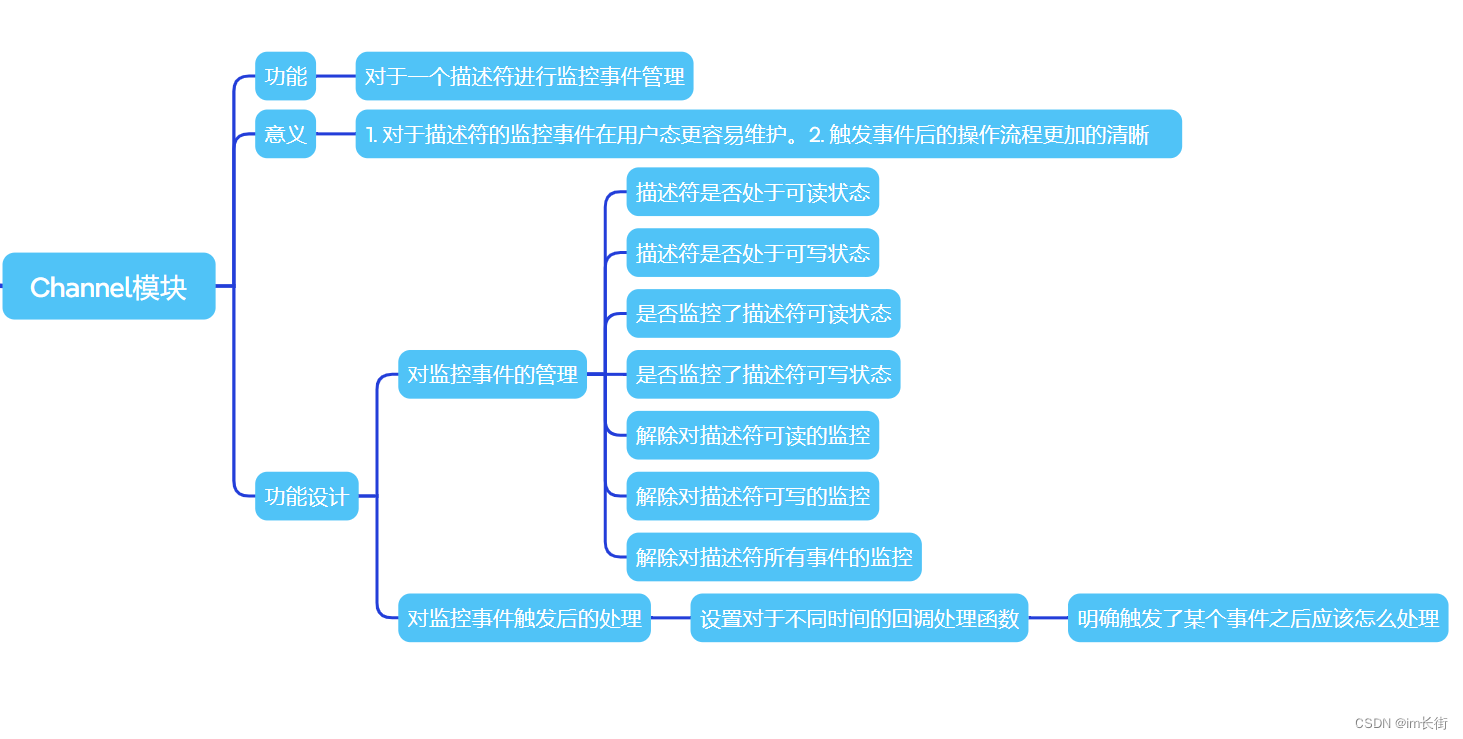

- Channel子模块

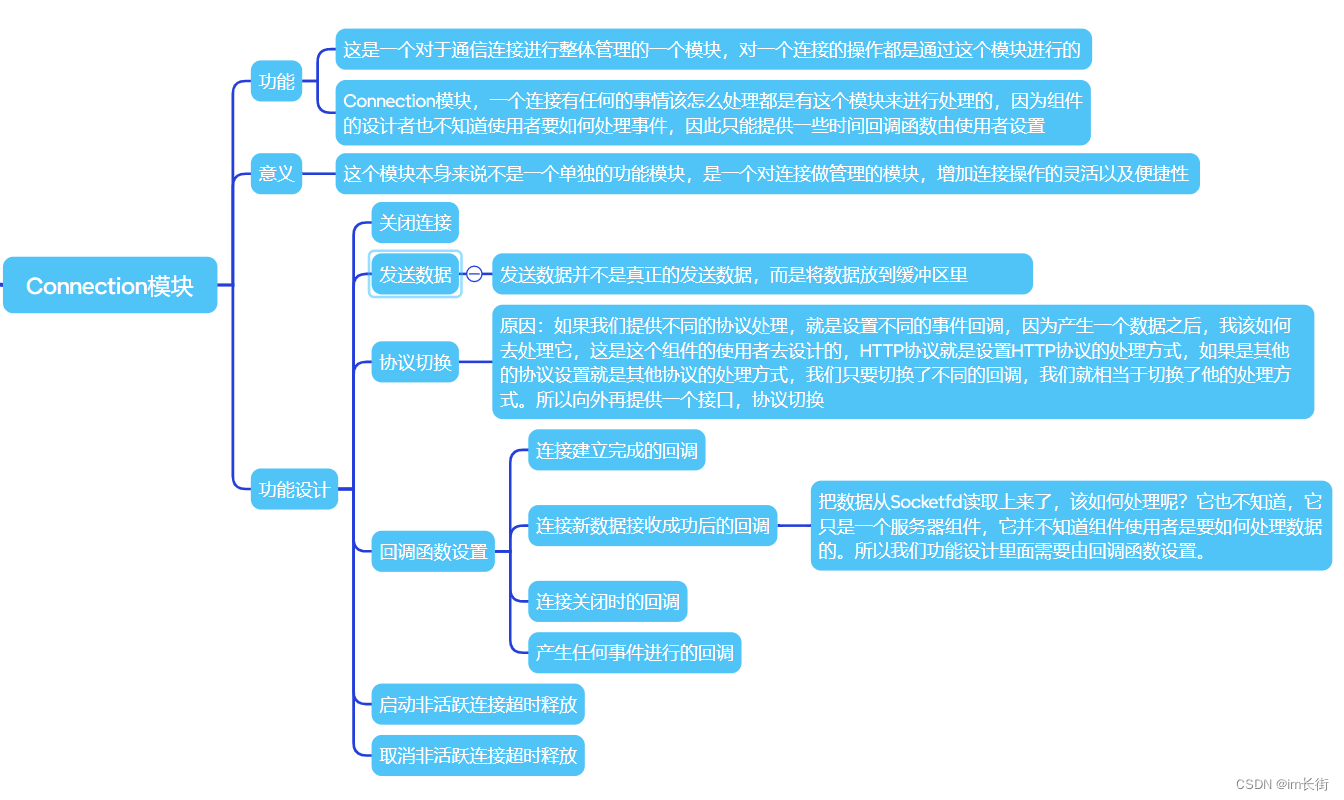

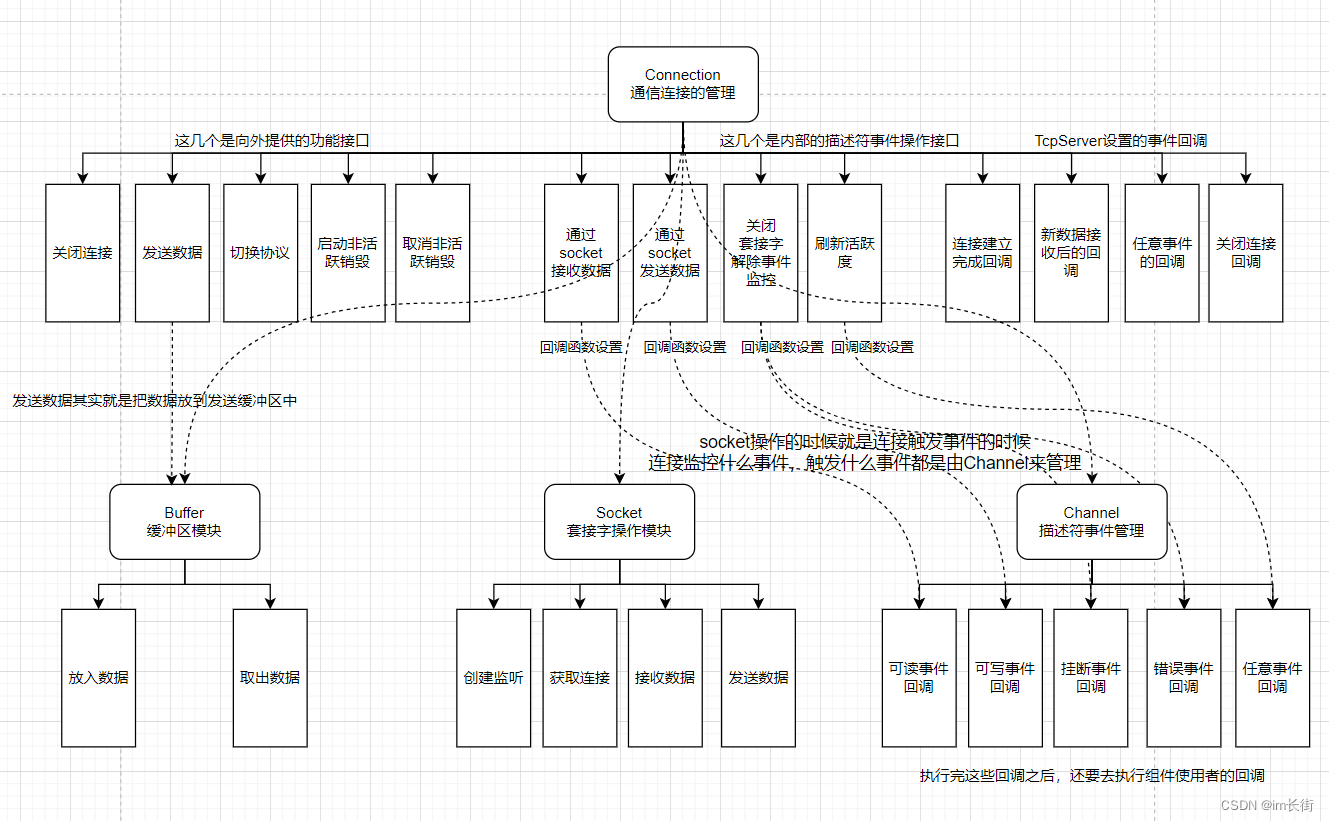

- Connection子模块

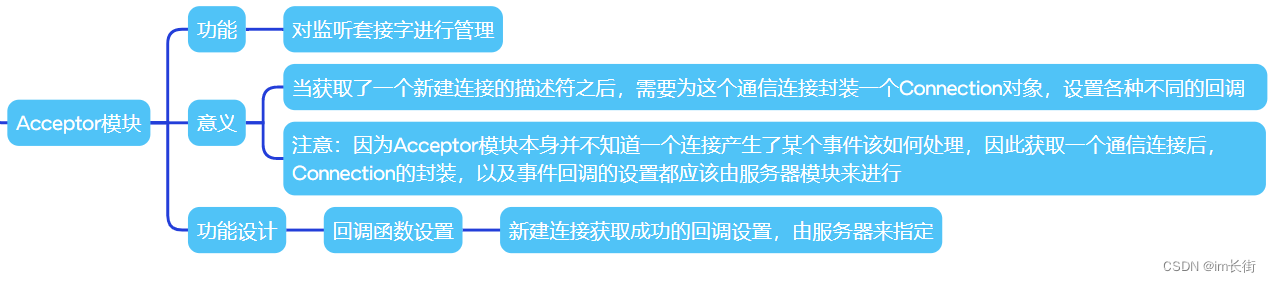

- Acceptor子模块

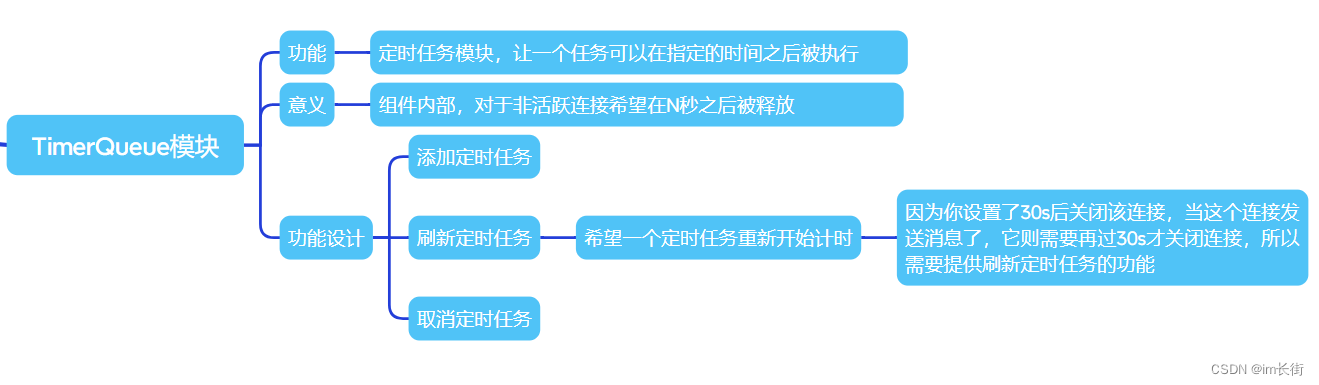

- TimerQueue子模块

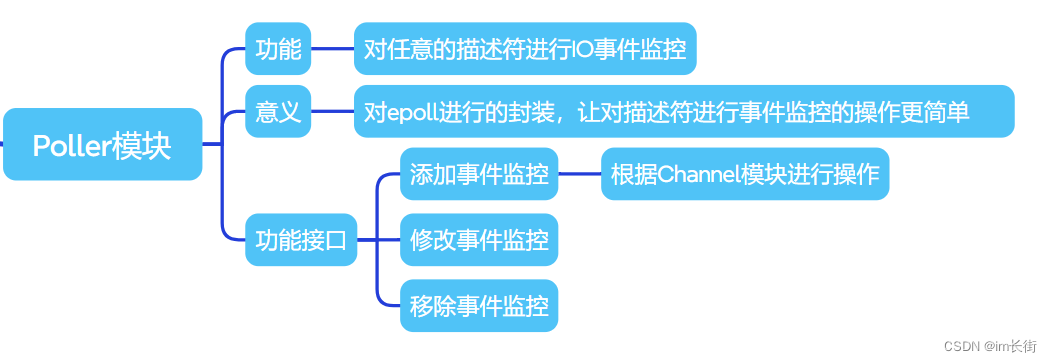

- Poller子模块

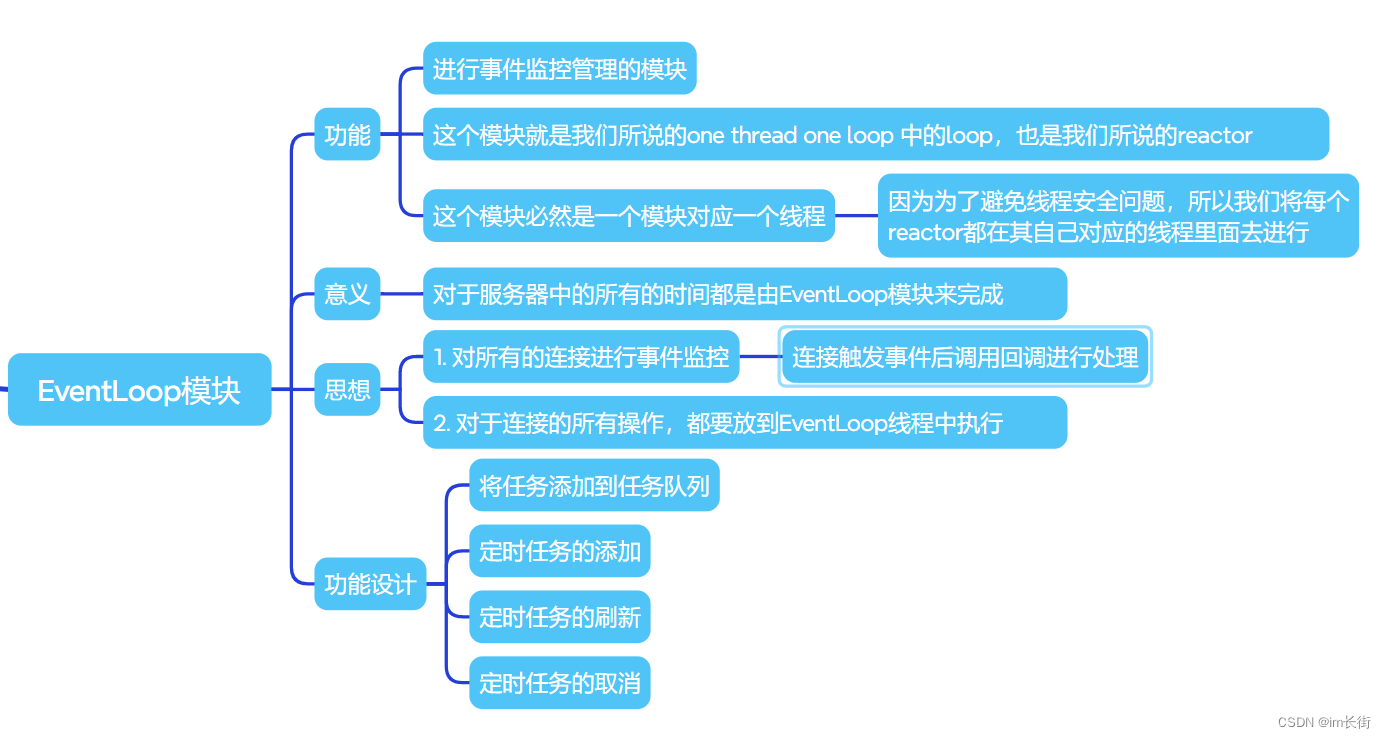

- EventLoop子模块

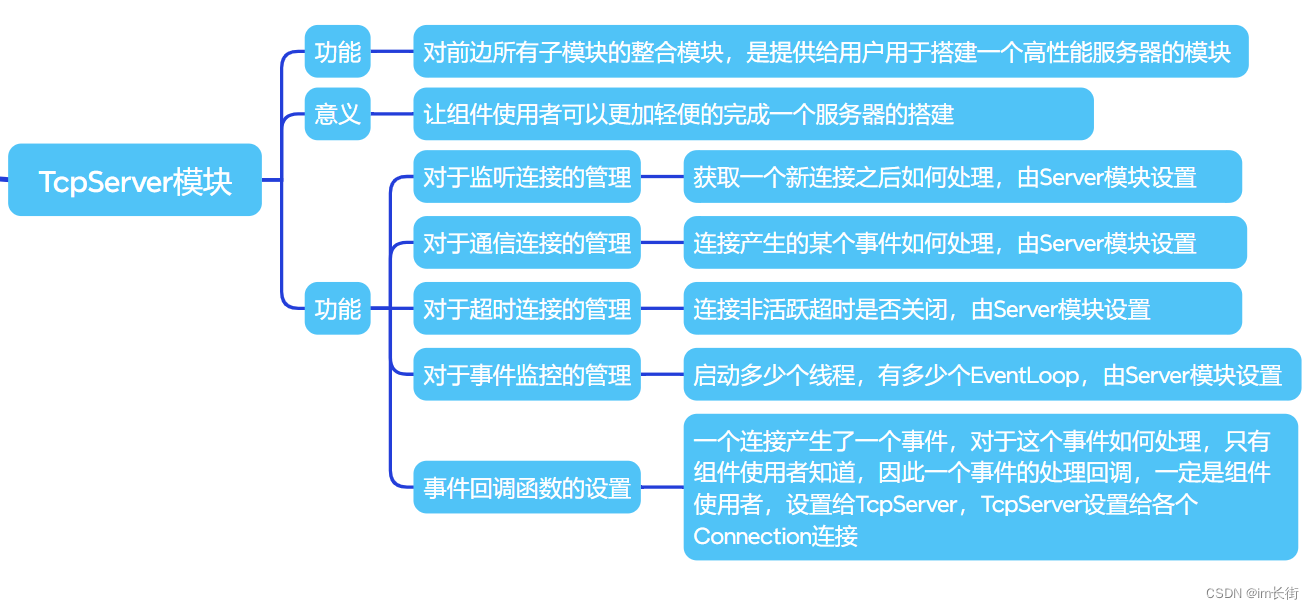

- TcpServer子模块

- 通信连接管理模块关系图

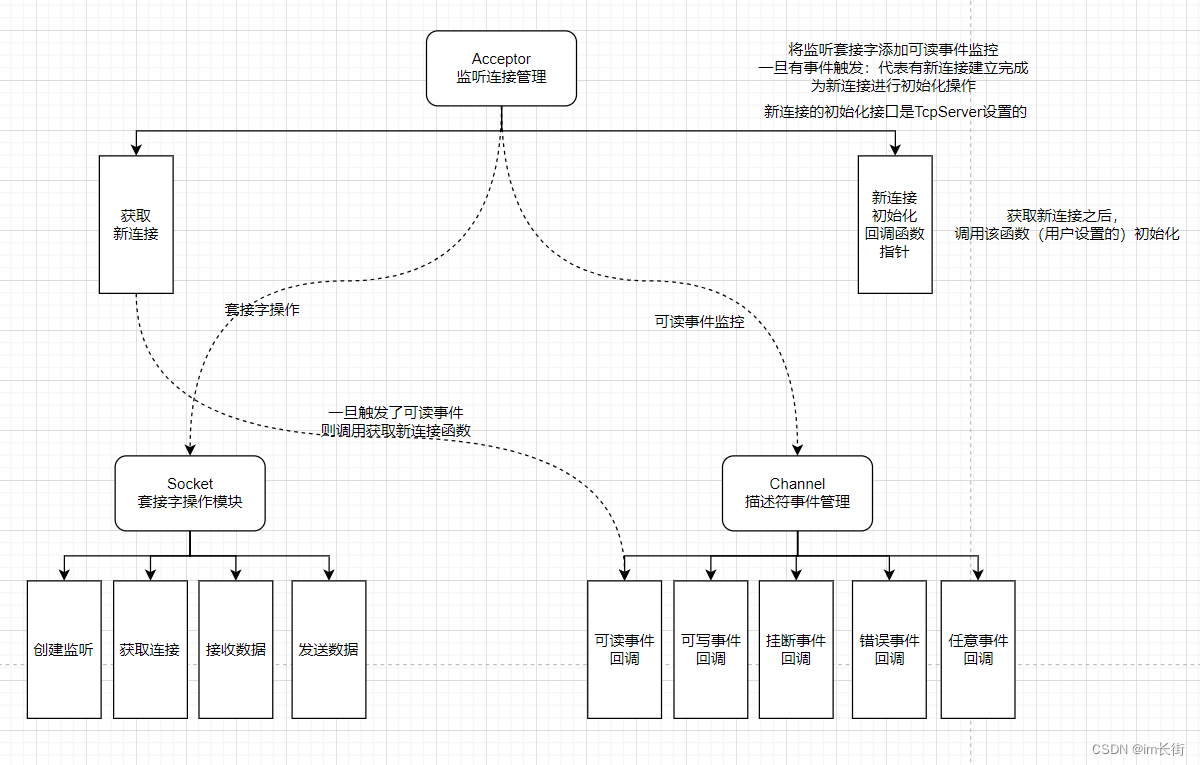

- 监听连接管理模块关系图

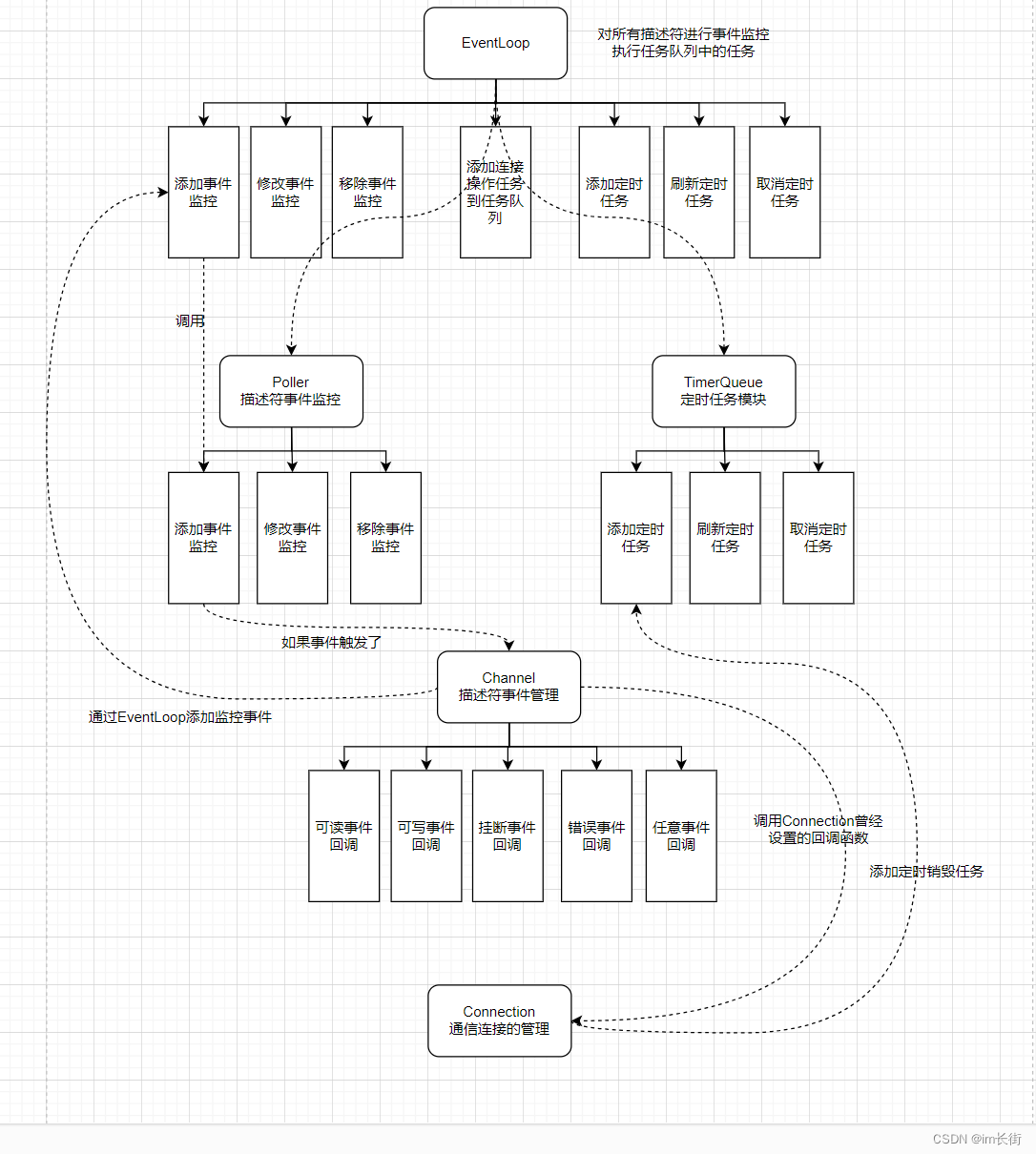

- 事件监控管理模块关系图

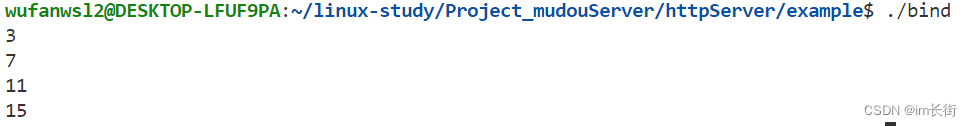

- bind函数的认识与基本使用

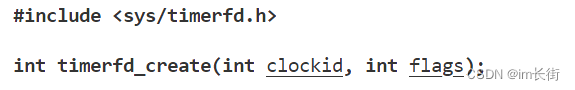

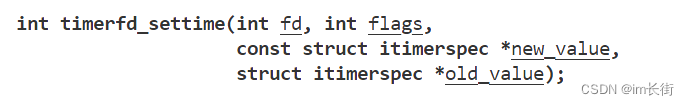

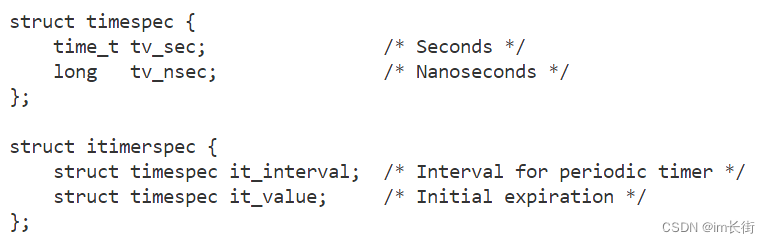

- timerfd的认识与基本使用

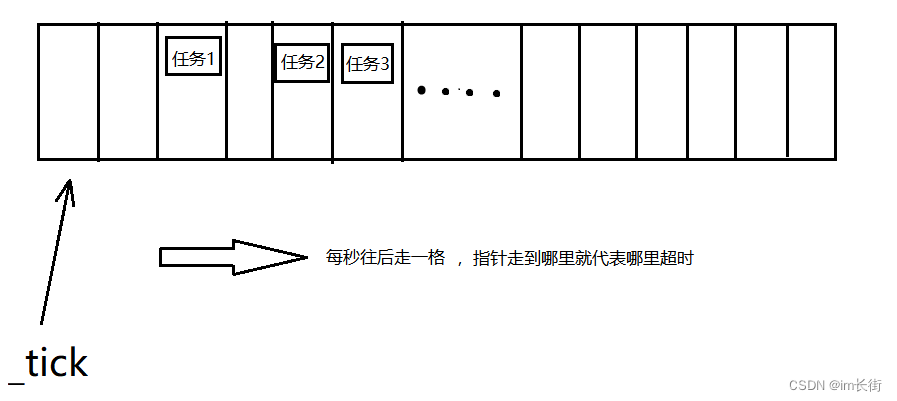

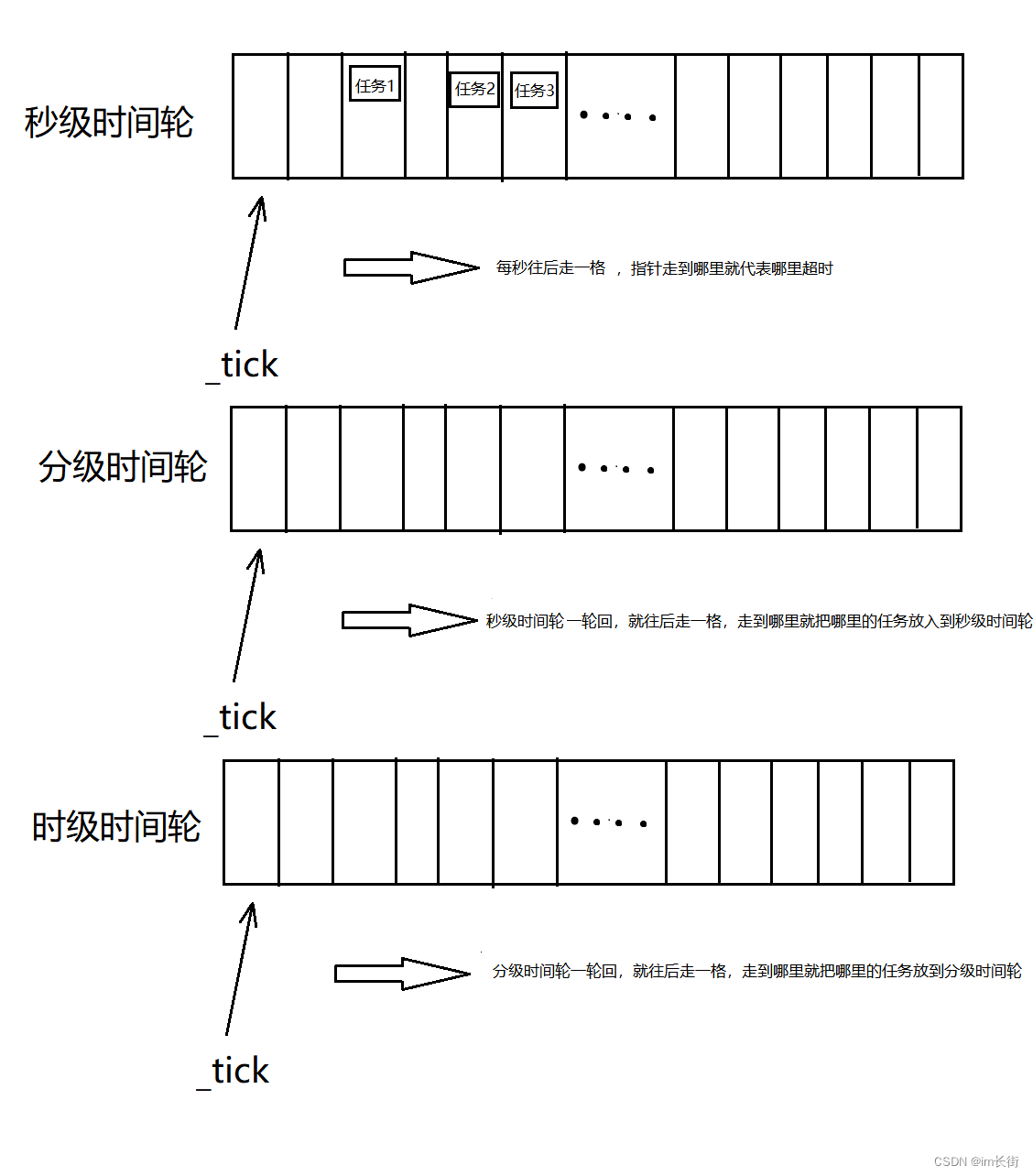

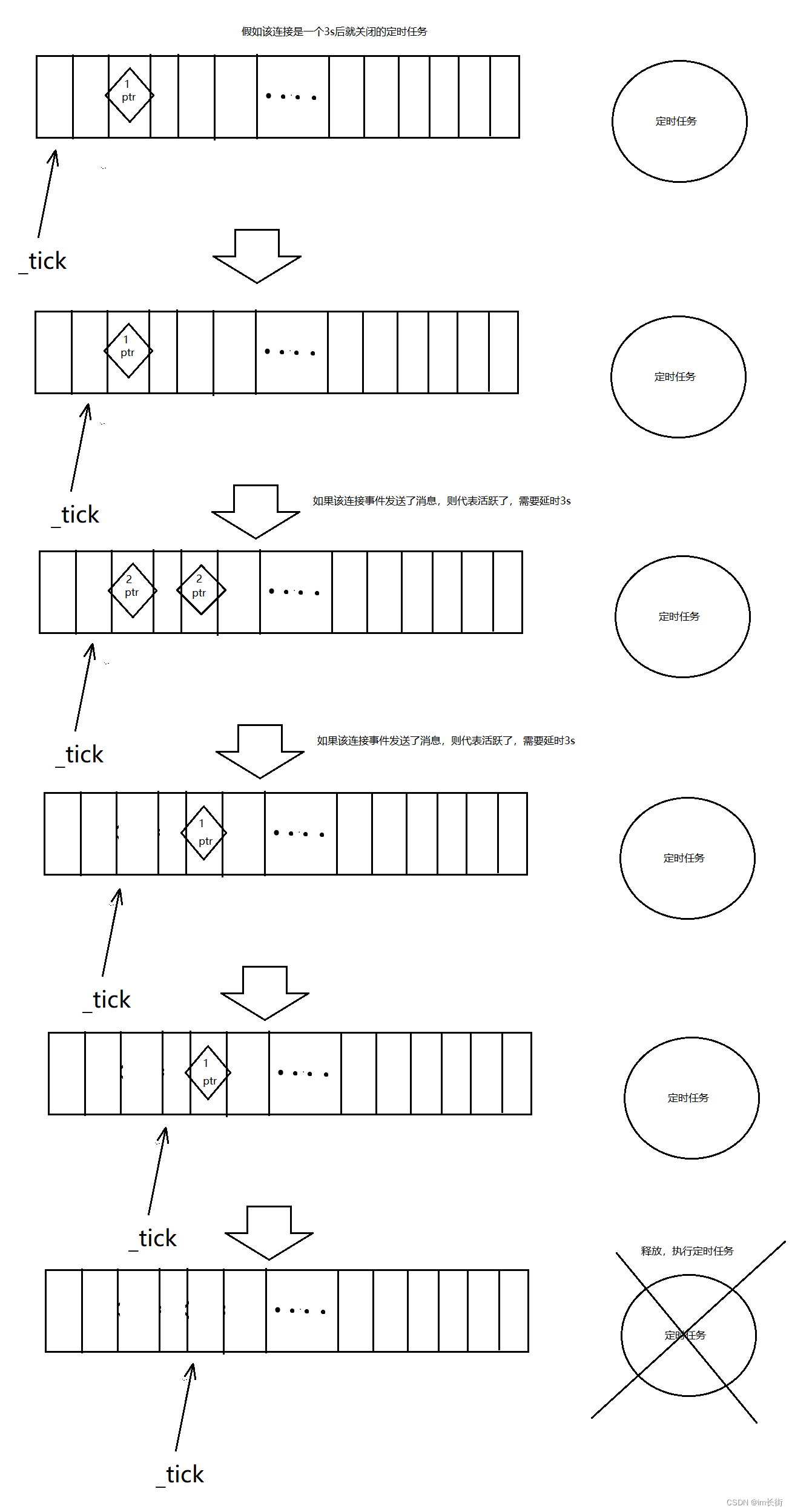

- 时间轮定时器的基本思想理解

- 时间轮定时器的代码设计及实现

- 正则表达式基本认识

- 正则表达式提取HTTP请求行

- 通用类型容器Any类设计思想

- Buffer缓冲区设计思想

- 日志打印宏的编写

- Socket套接字类设计思想

- Channel事件管理类设计思想

- Poller描述符监控类设计思想

- Poller模块与Channel模块整合与测试

- EventLoop模块中eventfd的认识

- EventLoop模块设计思想

- EventLoop与TimerWheel定时器模块整合

- EventLoop模块联调中的模块流程关系图

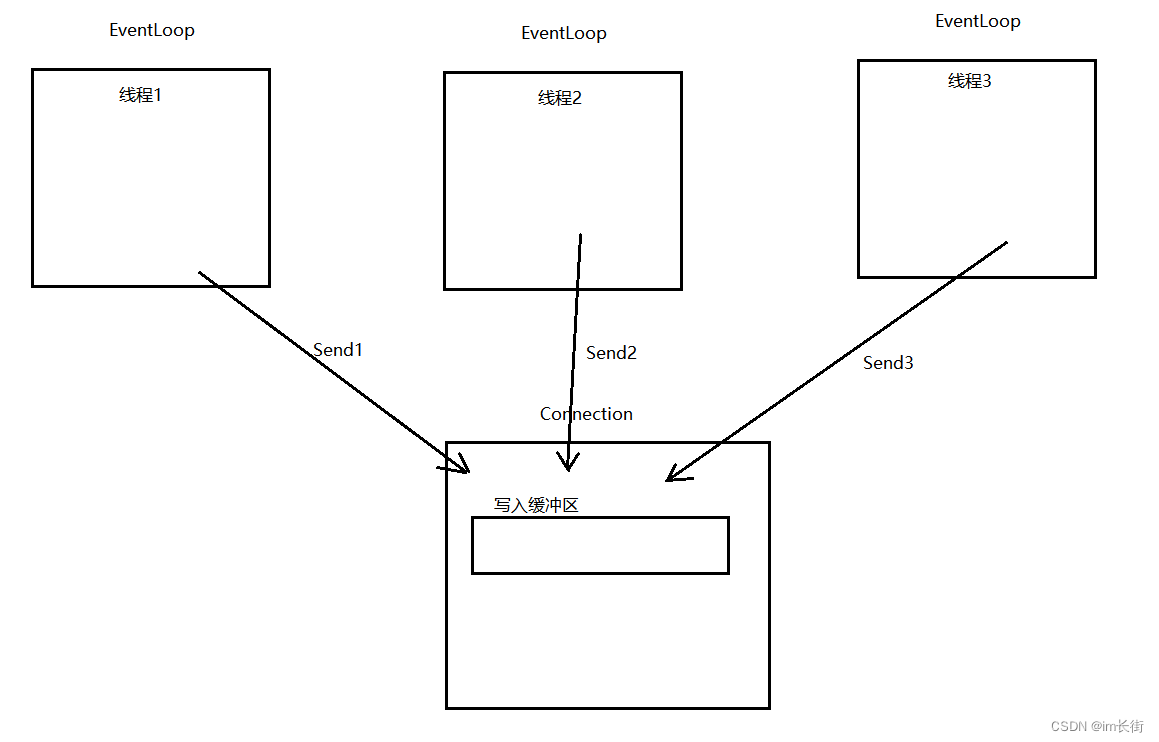

- Connection模块设计思想

- Acceptor模块设计思想

- LoopThread模块设计思想

- LoopThreadPool模块设计思想

- TcpServer模块设计思想

- 基于TcpServer实现回显服务器

- EchoServer回显服务器性能测试

- EchoServer回显服务器模块关系图

- HTTP协议模块的子模块划分

- Util工具类设计思想

- Util工具类字符串分割函数实现

- Util工具类文件数据读取函数实现

- Util工具类文件数据写入函数实现

- Util工具类UrlEncode函数实现

- Util工具类UrlDecode函数实现

- Util工具类Mime与Statu

- Util工具类文件类型判断接口实现

- Util工具类路径有效性判断接口实现

- HttpRequest模块设计思想

- HttpResponse模块设计思想

- HttpContext模块设计思想

- HttpServer模块设计思想

- 基于HttpServer搭建HTTP服务器

- HTTP服务器长连接测试

- HTTP服务器超时连接测试

- HTTP服务器错误请求测试

- HTTP服务器业务处理超时测试

- HTTP服务器同时多条请求测试

- HTTP服务器大文件传输测试

- HTTP服务器性能压力测试说明

项目源代码 https://gitee.com/wufangitee/linux-study/tree/master/Project_mudouServer/httpServer

项目初始与项目演示

上面演示了服务器在一万并发量的压力下运行。但此时为了演示效果,这并不是性能的极致。

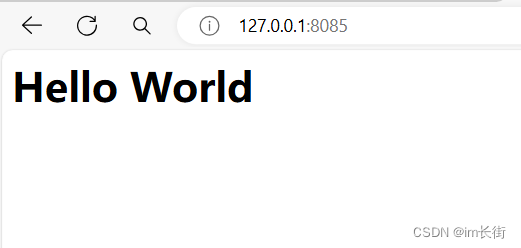

通过咱们实现的高并发服务器组件,可以简洁快速的完成一个高性能的服务器搭建。

并且,我们组件也提供的应用层的协议支持通过组件内的应用层协议支持,可以快速的完成一个高性能应用服务器的搭建(当前为了便于项目的演示,项目中提供的是HTTP协议组件的支持)。

注意:能支持不同的应用层协议只支持了HTTP协议和只能支持HTTP协议是不一样的,而我们实现的就是前者。

在这里,要明确的是咱们要实现的是一个高并发服务器组件,因此当前的项目中并不包含实际的业务内容。

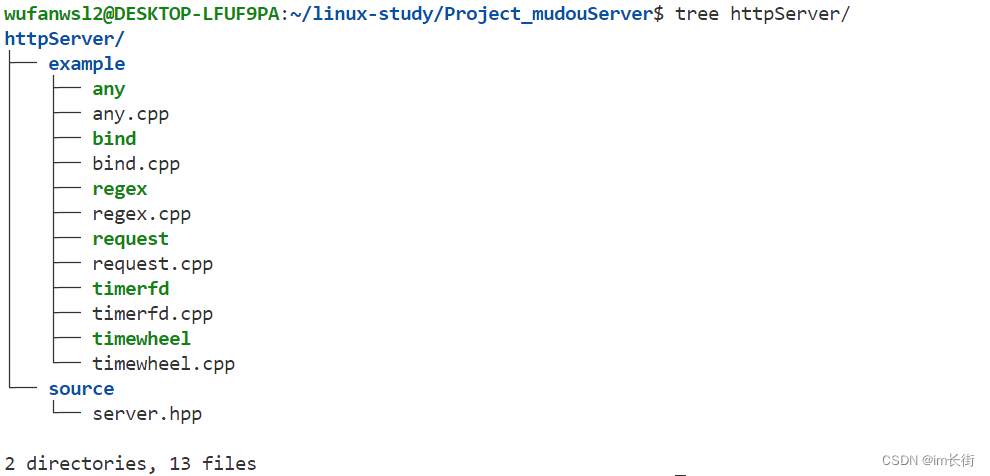

了解了我们要做什么,下面就展示一下代码的概况:

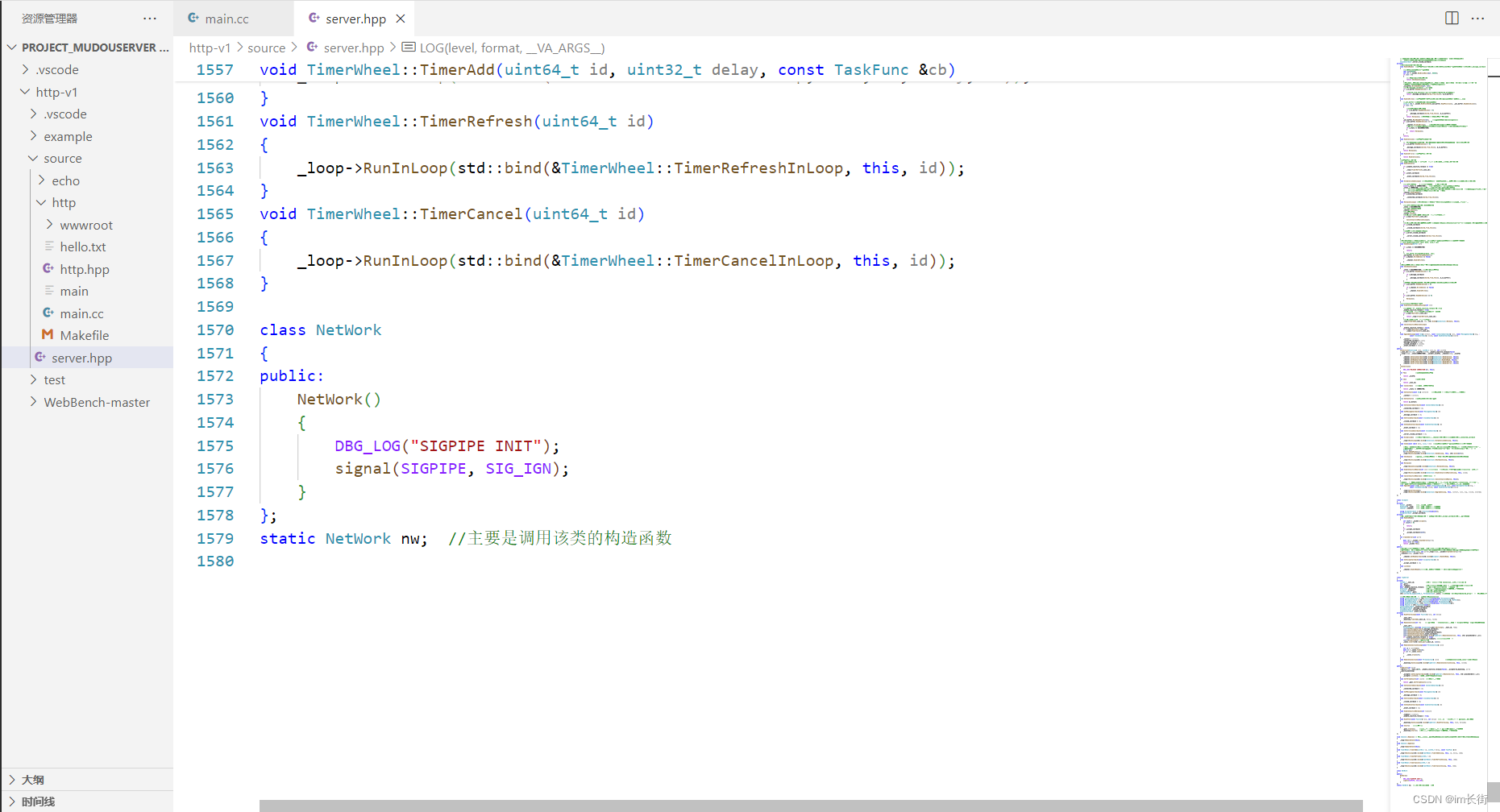

server.hpp是高性能服务器的实现,一共1500行代码左右

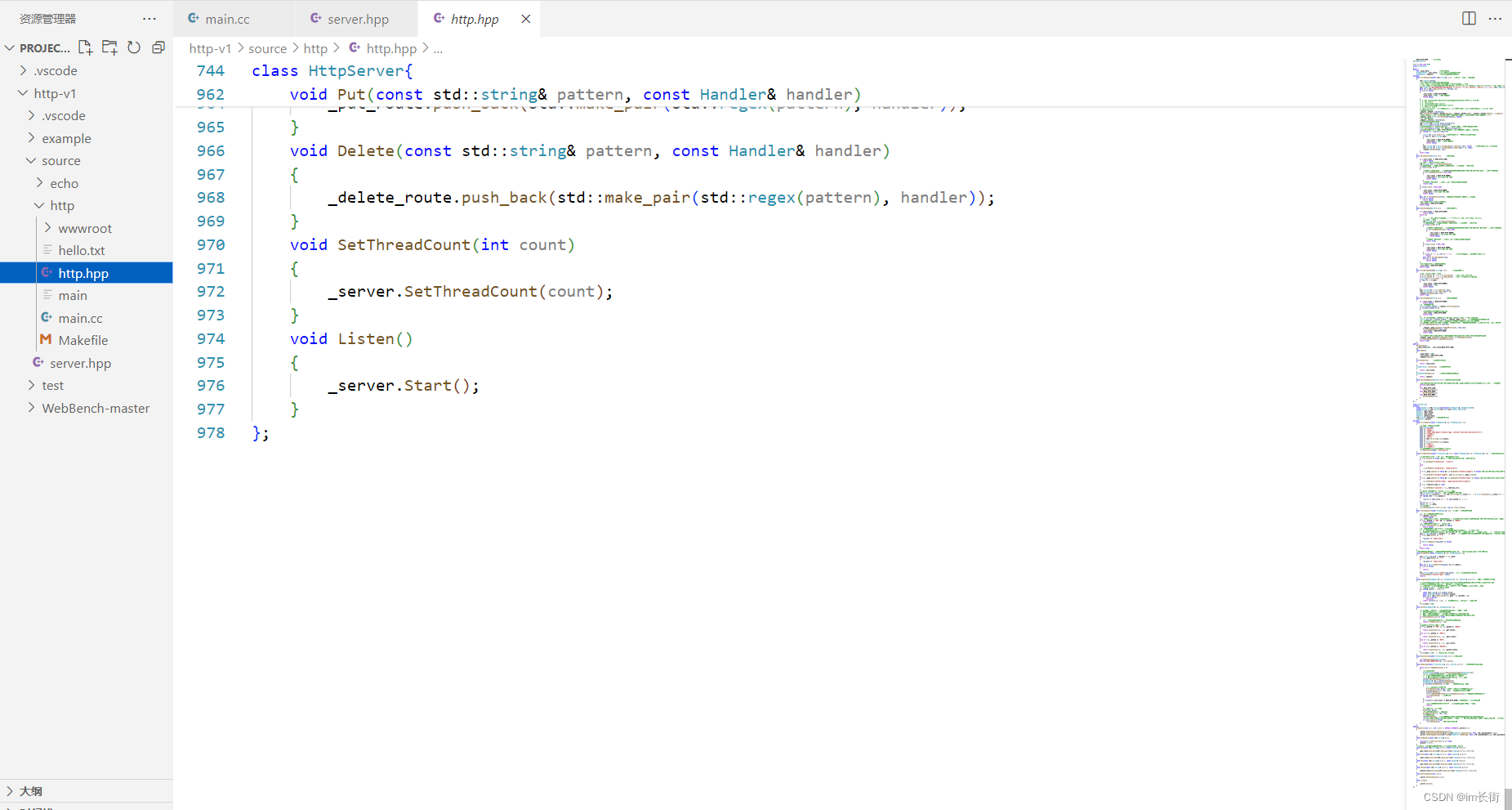

在这个服务器之上,可以提供不同协议支持,目前支持的是HTTP服务器。在http.hpp文件里,代码量是900行左右,总代码量就是2500行左右。

我们不能把所有的应用层协议都给支持了,因为应用层协议太多了,所以就实现了一个最常用的HTTP协议来支持。

再明确一下目标:

1.高并发服务器

2.在服务器基础上提供应用层协议的支持(HTTP)

HTTP服务器基础认识

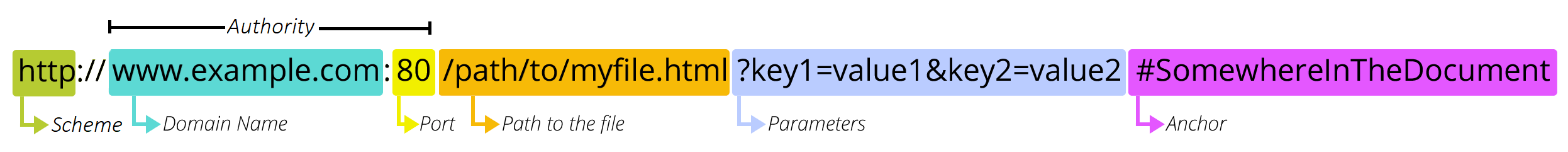

HTTP(Hyper Text Transter Protocol)超文本传输协议,是一种简单的请求-响应协议(客户端根据自己的需要向服务器发送请求,服务器针对请求提供服务,完毕后通信结束)。

HTTP协议是一个运行在TCP协议之上的应用层协议,这一点本质上是告诉我们,HTTP服务器其实就是一个TCP服务器,只不过在应用层基于HTTP协议格式进行数据的组织和解析来明确客户端的请求并完成业务处理。

仅了解这个通信模式还不够,还需要有更深的理解,理解HTTP协议的格式,如何解析HTTP协议的请求,以及如何去组织HTTP的响应。

如果看项目的同学对HTTP协议还并不是特别的了解,那么建议把HTTP协议格式这一块去回顾一下。HTTP协议在往期的文章中也给大家讲过。

这个例子是最简单的HTTP服务器代码,再讲这些简单代码是没有必要的

#include <iostream>

#include <cstring>

#include <string>

#include <unistd.h>

#include <sys/types.h>

#include <sys/socket.h>

#include <arpa/inet.h>

int main()

{

int sockfd = socket(AF_INET, SOCK_STREAM, 0);

if (sockfd < 0)

{

perror("socket failed");

return -1;

}

struct sockaddr_in server;

server.sin_addr.s_addr = INADDR_ANY;

server.sin_family = AF_INET;

server.sin_port = htons(8085);

int n = bind(sockfd, (const sockaddr*)&server, sizeof(server));

if (n < 0)

{

perror("bind failed");

return -1;

}

n = listen(sockfd, 5);

if (n < 0)

{

perror("listen failed");

return -1;

}

while (1)

{

int newsockfd = accept(sockfd, nullptr, nullptr);

if (newsockfd < 0)

{

perror("accept error");

continue;

}

char buffer[4096];

n = recv(newsockfd, buffer, 4095, 0);

if (n <= 0)

{

perror("recv failed");

continue;

}

std::string body = "<html><body><h1>Hello World</h1></body></html>";

std::string rsp = "HTTP/1.1 200 OK\r\n";

rsp += "Content-Length: " + std::to_string(body.size()) + "\r\n";

rsp += "Content-Type: text/html\r\n";

rsp += "\r\n";

rsp += body;

n = send(newsockfd, rsp.c_str(), rsp.size(), 0);

if (n < 0)

{

perror("send error");

close(newsockfd);

}

}

}

从这里面也能看出来,其实HTTP服务器的搭建就是基于一个TCP服务器的搭建。只不过上层通信的数据是用HTTP协议格式来通信数据。

实现HTTP服务器简单的,但是实现一个高性能的HTTP的服务器,却并不简单。上面是一个客户端(一个浏览器)请求我们的服务器,那如果有上万个客户端访问,那我们的服务器能抗得住那么多的客户端请求吗?所以我们就要考虑如何将我们这个服务器实现成高性能的,这才是我们需要更加去关注的一个重点

Reactor模式基础认识

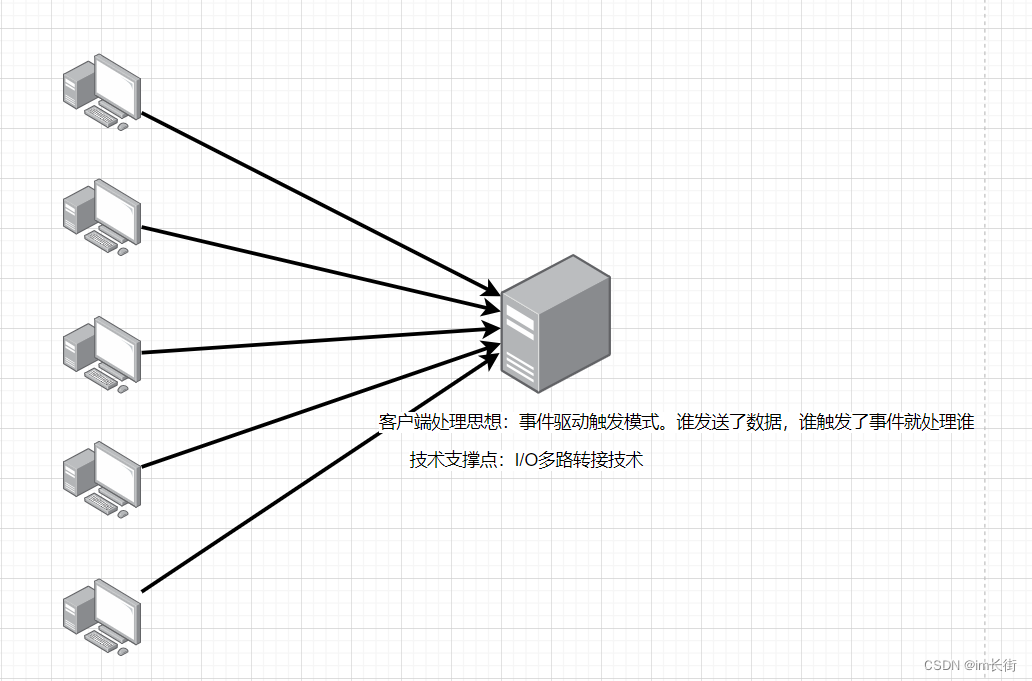

Reactor模式:也叫做事件驱动处理模式。

一个或多个客户端同时连接到我们的服务器上面,然后去请求我们的服务器,那我们的服务器如何对我们的客户端进行处理呢?处理过程就是:哪一个客户端给我发送了数据,触发了我的事件,那么我就去处理谁,你要是没有给我发送数据,没触发我的事件,我就不取处理你。这就是事件驱动处理模式,谁触发了事件服务器就处理谁,那么问题来了,服务器怎么知道谁触发了事件?

所以在Reactor模式里面就使用到了一个非常关键的技术:使用I/O多路复用(也叫I/O多路转接)。统一监听事件,收到事件后分发给处理进行或线程,这是编写高性能网络服务器的必备技术之一。

我们将Reactor模式分为了三种:

- 单Reactor单线程:单I/O多路复用 + 业务处理

- 单Reactor多线程:单I/O多路复用 + 线程池(业务处理)

- 多Reactor多线程:多I/O多路复用 + 线程池(业务处理)

单Reactor单线程模式认识

优点:因为是单线程操作,操作都是串行化,思想较为简单,编码流程也较为简单(不用考虑进行或线程间的通信,以及线程安全问题)

缺点:因为所有的时间监控以及业务处理都是在一个线程中完成的,因此很容易造成性能瓶颈。如:有一万个客户端连接上来了,有八千个触发了事件,我得一个一个处理,我在处理这个的时候,肯定处理不了下一个,下一个就得等着,就导致后面的客户端就等待了很长时间,就会导致连接超时。

适用场景:客户端数量较少,且业务处理简单快速的场景。所有的技术都是因地制宜的,不能因为缺点比较大就放弃它。

单Reactor多线程模式认识

有一个线程进行Reactor模式事件监控,客户端的请求到来之后,我们的服务器这边有一个线程专门对所有客户端进行事件监控,一有事件触发了,服务器就进行I/O处理,把你的数据读取上来,读取上来之后并不进行业务处理,因为我认为业务处理时间比较长,这样就会导致我对其它客户端处理的时候不够及时,无法充分利用CPU多核资源,所以这时候我们就加上了业务功能的线程池。

将读取上来的数据投入到业务处理的线程池里面,让线程池里面的线程进行业务处理,事件监控的线程池只需要做两件事情:事件监控以及客户端的IO操作。业务处理就分离开了,对我们CPU多核资源有充分的利用。

优点:充分利用了CPU多核资源,处理效率可以更高,降低了代码的耦合度

缺点:在单个Reactor线程中,包含了对所有客户端的事件监控,以及所有客户端的IO操作,不利于高并发场景(如:我这个Reactor线程还在给某一个客户端进行IO操作,但这时候有大量的客户端连接请求到来了,我在处理这个客户端IO的时候,就来不及处理其他客户端的连接请求)

多Reactor多线程模式认识

多Reactor多线程模式:基于但Reactor多线程的缺点考虑,如果IO的时候,有连接到来无法处理,因此将连接处理单拎出来。

因此让一个Reactor线程仅仅进行新连接的处理,让其他的Reactor线程进行IO处理,IO Reactor线程拿到数据分发给业务线程池进行业务处理。

因此多Reactor多线程模式,也叫做主从Reactor模型

主Reactor线程:进行新连接事件监控

从属Reactor线程:进行IO事件监控

业务线程池:进行业务处理

优点:充分利用CPU多核资源,并且可以进行合理分配

但是大家也要理解:执行流并不是越多越好,因为执行流多了,反而会增加CPU切换调度的成本

所以有些主从Reactor模式里,不设置业务线程,业务也再我们的从属Reactor里面来完成,也就是说从属Reactor既进行IO事件监控,IO处理,也进行业务处理,对资源的最大化利用。线程多了,看似耦合度降低了,模块清晰了,但是你要处理的会变得更加复杂,在多线程的操作中,就要涉及到锁的操作,涉及到锁就会降低效率;第二,线程多了,CPU的切换调度频繁了,又是进一步的降低效率。

那么还不如在某些情况下把业务处理放到从属Reactor里面,读取完数据之后,直接进行业务处理,处理完毕之后,然后进行响应。

目标定位

我们实现的高并发服务器用的模型就是主从Reactor模型,我们采用的思想是one thread one loop,就是把业务线程池摘掉,将业务处理也放入从属Reactor当中,只有主Reactor线程和多个从属Reactor线程。

主线程要做的事:新连接监控,新连接处理。

从属线程要做的事:IO事件监控,IO处理,业务处理

这样做的好处:把框架做了中间的简化,不让这个框架过于复杂,因为在同一台主机上,执行流并不是越多越好,执行流多了,在多对多的情况下,我们需要考虑加锁来考虑线程安全问题,平白又多出了锁的消耗。

因为我们在进行CPU资源分配的时候,只需要考虑需要去创建多少个从属Reactor线程就可以了,并且进行业务处理的时候,也不需要再去考虑更多的线程安全的操作了,对于每一个连接的所有的操作来说,都是放到同一个从属Reactor线程里面来完成的。我们也不需要考虑和其它线程的锁争抢的操作。这就是我们要实现的高并发的one thread one loop思想的模式。

总体大模块划分

实现这个项目之前,对我们的项目进行整体的模块划分,因为对模块划分之后,才能对我们项目有更透彻的理解,理解了各个模块之间的关系之后,再去实现我们服务器的时候才会更加的轻松,更加的有条理,才能明白我们写的每一句代码到底是什么。

我们要实现的是一个带有协议支持的Reactor模型高性能服务器,因此将模块总共划分为了两个大模块:

第一个模块是Server模块:实现的功能是Reactor高性能的TCP服务器。

第二个模块是协议模块:对当前的Reactor模型服务器提供应用层协议支持。

server模块的管理思想

server模块就是对所有的连接和线程进行管理,让他们各司其职,在合适的时候做合适的事。

而具体的管理也分为四个方面:

- 监听连接管理。要搭建一个服务器,我们首先得有监听套接字进行监听,获取新连接

- 通信连接管理。获取新连接之后,就相当于有了通信连接的套接字,我们需要对它有不同事件到来的处理

- 超时连接管理。我搭建了TCP服务器,管理了大量的客户端,如果有些恶意的客户端,连接到我的服务器上面了,之后并不通信,就是占着我服务器的资源,那怎么办?所以我们还要对我们的服务器有超时连接的管理。在一个连接超时后,能释放掉,归还我们的资源。

- 线程的管理:创建的线程,它内部事件循环的管理

下面我们对server模块进行更加细致的划分

Buffer子模块

Buffer模块:就是一个缓冲区模块,用于实现通信中用户态的接收缓冲区和发送缓冲区功能

Socket子模块

就是对套接字操作进行封装的模块,对套接字进行操作的时候更加的简便,这个模块我们在往期的文章中也经常出现。

Channel子模块

每一个描述符在进行事件监控的时候,都有可能会监控可读、可写、错误事件,如果我们想要对一个文件描述符进行可写监控,如果可写监控已经被设置,那我们还需要再对可写监控设置一遍吗?显然这是没有意义的,有人就要说了,重新设置就重新设置吧,反正在设置也不会有什么问题,问题在于我们我们系统调用是有消耗的,并且这样杂乱无章的管理很不好,所以我们就设计出了Channel模块。还有一点,如果这个描述符触发了可读事件,接下来按理来说应该去读取数据,放到缓冲区里面去,如果写原始代码的话,很多地方都要写这段代码,太麻烦了,我们可以给channel模块再设置一些事件回调函数,让他们在触发了某个事件的时候直接去调用某个函数就行了,这样设置代码会更加清晰,更加有条理。

Channel模块是对一个描述符需要进行IO事件管理的模块,实现对描述符可读,可写,错误…事件的管理操作,以及Poller模块对描述符进行IO事件监控就绪后,根据不同的事件,回调不同的处理函数功能。

Connection子模块

Connection模块是对Buffer模块,Socket模块,Channel模块的一个整体封装,实现了第一个通信套接字的整体的管理。

具体处理流程如下:

1.实现想Channel提供可读,可写,错误等不同事件的IO事件回调函数,然后将Channel和对应的描述符添加到Poller事件监控中。

2.当描述符在Poller模块中就绪了IO可读事件,则调用描述符对应Channel中保存的读事件处理函数,进行数据读取,全部读取到Connection管理的用户态接收缓冲区中。然后调用由组件使用者传入的新数据到来回调函数进行处理。

3.组件使用者进行数据的业务处理完毕后,通过Connection用使用者提供的数据发送接口,将数据写入Connection的发送缓冲区中。

4.启动描述符在Poll模块中的IO写事件监控,就绪后,调用Channel中保存的写事件处理函数,将发送缓冲区中的数据通过Socket进行面向系统的实际数据发送。

Acceptor子模块

Acceptor模块是对Socket模块,Channel模块的一个整体封装,实现了对一个监听套接字的整体管理

监听到新连接了,我们接下来的操作应该是获取一个新的文件描述符封装成Connection对象出来并给这个对象设置各种事件回调函数,但Acceptor也不知道监听到新连接了该怎么办,通信套接字的各种事件该怎么处理,所以在功能设计里面,需要设置一个回调函数,让Server模块来告诉它获取到新连接该怎么处理。

具体处理流程:

1.向监听套接字对应的Channel提供可读事件的回调函数,函数的功能就是如何获取新的通信连接。

2.为新连接构建一个Connection对象出来。

TimerQueue子模块

TimerQueue模块是实现固定时间定时任务的模块,可以理解就是向定时任务管理器中添加一个任务,任务将在固定的时间后被执行,同时也可以通过刷新定时任务来延迟任务的执行。

为了实现我们服务器的超时连接管理,如果一个连接半天不发消息,有些时候我们就希望把这个连接给释放掉。而我们就只需将这个固定时间执行的任务设置成销毁连接即可。

这个模块主要是对Connection对象的生命周期管理,对非活跃连接进行超时后的释放功能。

Poller子模块

Poller模块是对epoll进行封装的一个模块,主要实现epoll的IO事件添加,修改,移除,获取活跃连接功能。

EventLoop子模块

我们要实现的服务器是一个one thread one loop的服务器,这里面的loop指的是EventLoop(事件循环)

这个模块必然是我一个模块对应一个线程,在一个线程内部是运行EventLoop的启动函数。

为什么要一个模块对应一个线程?

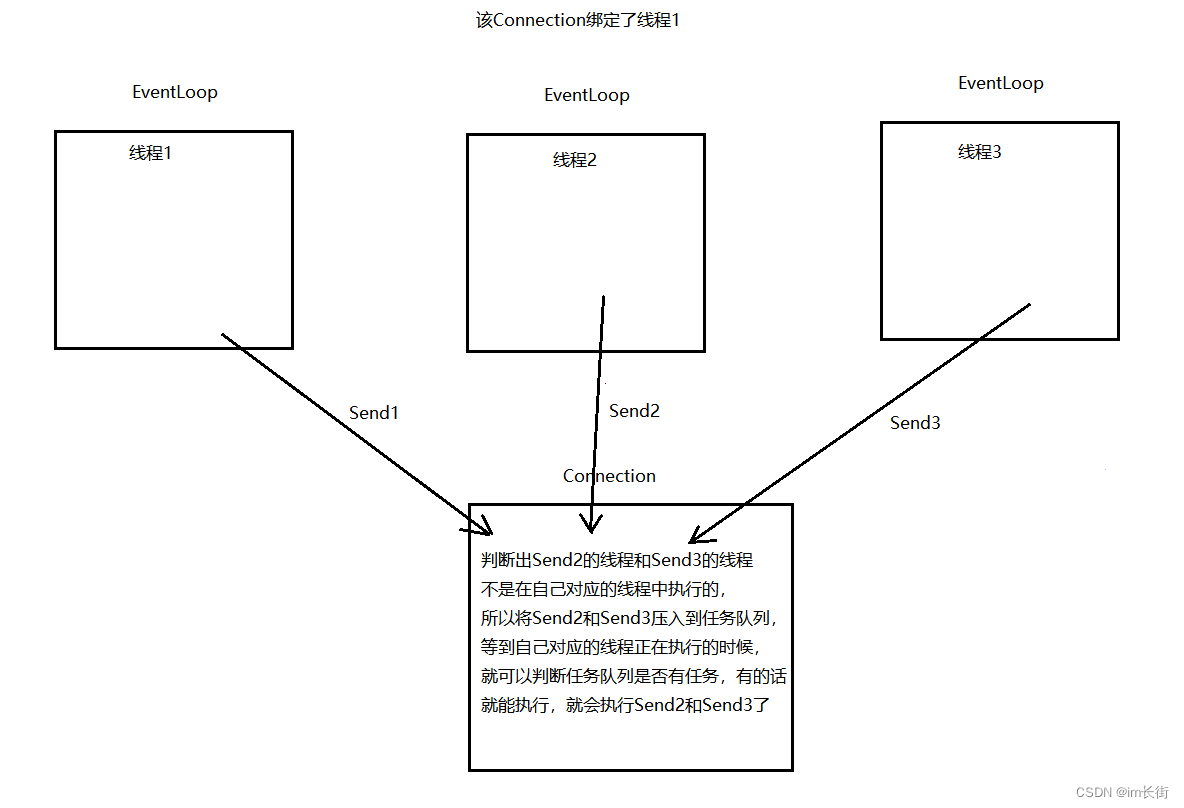

因为我们提供了外界使用者可以对通信连接进行设计操作的函数,所以不仅仅是自己线程的EventLoop会产生的事件,会对Connection处理。其他的线程也会对Connection进行处理。

而使用这个组件的用户是如何操作的,我们这个组件是不知道的,但我们知道一定在大多数情况中存在多个线程对Connection进行操作,如果Connection不在自己对应的线程去执行,则可能存在线程安全问题。

解决方案:

一个线程里面监控有很多的连接,不能立马执行你这个Connection的任务,所以线程中要有一个任务队列。

TcpServer子模块

这是一个最终的整合模块,前面的子模块要么是功能性模块(对内),而这个模块是完全提供给外界使用者(对外),用来搭建服务器的模块。

通信连接管理模块关系图

我们了解了每个模块的功能、意义和接口,下面我们来看一下Server下各个模块的关系是什么样的

Buffer接收到数据之后,就要去调用TcpServer设置的事件回调中的新数据接收后的回调(即业务处理)。任意事件触发了,不仅仅要刷新活跃度,还要执行组件使用者的任意事件回调。以及连接关闭了,挂断了,我们不单要执行自己的,还要调用用户设置的。

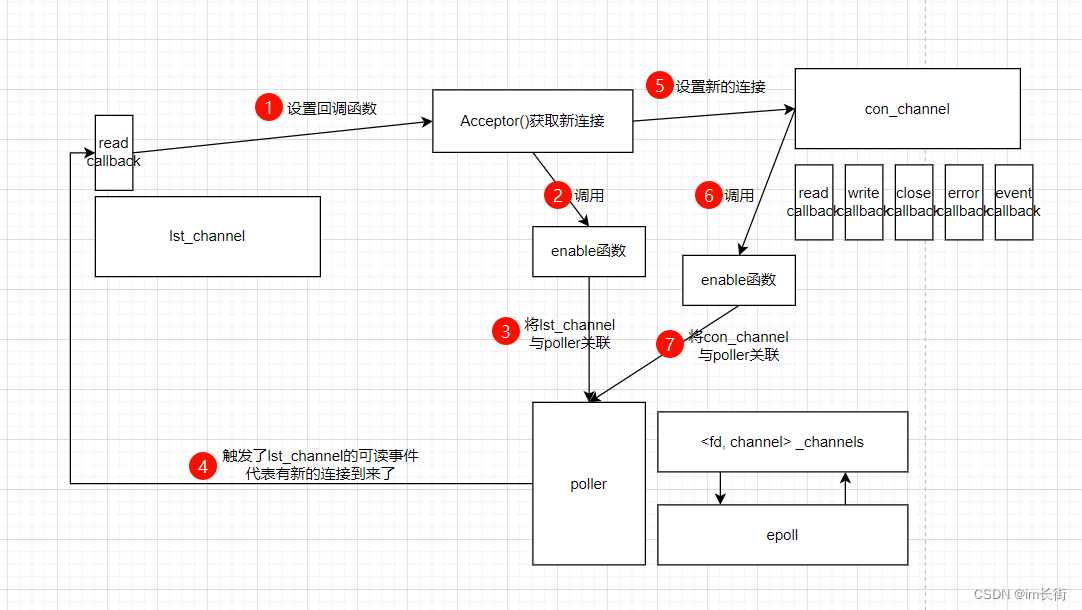

监听连接管理模块关系图

Acceptor模块:一旦触发了可读事件,获取了新连接,这时候初始化的过程就是为新连接创建一个Connection对象,并且为Connection对象设置一系列的回调函数(TcpServer的回调函数),告诉它一旦有事件到来了要该怎么处理,之后将这个Connection添加事件监控。一旦触发了事件就可以调用对应的Channel里面的回调函数。

事件监控管理模块关系图

bind函数的认识与基本使用

需要了解的一些前置知识,这样才能在我们的项目中用到的时候更加轻松一点。

bind函数,函数有几个参数,我们就需要传递几个参数,这个函数的功能,给某一个参数给一个固定值,生成一个新的函数对象。

举个例子

#include <iostream>

#include <string>

#include <functional>

int Sum(int a, int b)

{

return a + b;

}

int main()

{

auto func = std::bind(Sum, 1, 2);

std::cout << func() << std::endl;

return 0;

}

#include <iostream>

#include <string>

#include <functional>

int Sum(int a, int b)

{

return a + b;

}

int Sum100(int b)

{

return 100 + b;

}

int main()

{

auto func = std::bind(Sum, 100, std::placeholders::_1);

//此时std::bind(Sum, 100, std::placeholders::_1)就等价于Sum100

std::cout << func(1) << std::endl;

std::cout << func(2) << std::endl;

std::cout << func(3) << std::endl;

std::cout << Sum100(1) << std::endl;

std::cout << Sum100(2) << std::endl;

std::cout << Sum100(3) << std::endl;

return 0;

}

这有什么作用呢?

基于bind的作用,当我们在设计一些线程池或者任务池的时候,就可以将任务池中的任务设置为函数类型,函数的参数由添加任务者直接使用bind进行适配绑定设置,而任务池中的任务被处理,只需要取出一个个的函数进行执行即可。

#include <iostream>

#include <string>

#include <vector>

#include <functional>

int Sum(int a, int b)

{

return a + b;

}

int Sum100(int b)

{

return 100 + b;

}

int main()

{

using Task = std::function<int()>;

std::vector<Task> arry;

arry.push_back(std::bind(Sum, 1, 2));

arry.push_back(std::bind(Sum, 3, 4));

arry.push_back(std::bind(Sum, 5, 6));

arry.push_back(std::bind(Sum, 7, 8));

for (auto& f : arry)

{

std::cout << f() << std::endl;

}

return 0;

}

这样做有个好处就是,这种任务池在设计的时候,不用考虑都有哪些任务处理方式了,处理函数是如何设计的,有多少个什么样的参数,这些都不用考虑了,降低了代码之间的耦合度。

timerfd的认识与基本使用

在当前的高并发服务器中,我们不得不考虑一个问题,那就是连接的超时关闭问题。我们需要避免一个连接长时间不通信,但是也不关闭,空耗资源的情况。这时候我们就需要一个定时任务,定时对超时过期的连接进行释放

Linux给我们提供了定时器:

功能:创建一个定时器。Linux下一切皆文件,对定时器操作就是对文件进行操作。

clockid:

CLOCK_REALTIME:以系统时间作为计时基准值(如果系统时间发生了改变就会出问题)

CLOCK_MONOTONIC:以系统启动事件进行递增的一个基准值(定时器不会随着系统时间改变而改变)从系统开机到现在,经过了多长时间,作为定值,并不受你系统时间的改变而受影响。

flags:0 - 阻塞操作

返回值:文件描述符

定时器定时的原理:每隔一段时间(定时器的超时时间),系统就会给这个描述符对应的定时器写入一个8字节数据。

假如创建了一个定时器,定时器的超时时间是3s,每隔3s系统会都会给描述符写入一个1,表示从上一次读取数据到现在超时了1次,又过了30s你才来读取,则你这时候就会读取到一个10,表示从上一次读取数据到限制超时了10次。

功能:启动定时器

fd:timerfd_create函数的返回值,文件描述符 – 创建的定时器的标识符

flags:默认设置为0 - 使用相对时间(相对于现在的时间,往后延长几秒钟为一次超时)

struct itimerspec* new:设置的超时时间

old:用于接收当前定时器原有的超时时间设置(主要是用于还原以前设置的定时器,如果不关心可以设置NULL)

it_interval:第一次超时之后每次的超时间隔时间

it_value:第一次超时的时间

举例

#include <iostream>

#include <sys/timerfd.h>

#include <cstring>

#include <unistd.h>

int main()

{

int timerfd = timerfd_create(CLOCK_MONOTONIC, 0);

if (timerfd < 0)

{

perror("create timerfd failed");

return -1;

}

struct itimerspec itime;

itime.it_value.tv_sec = 1;

itime.it_value.tv_nsec = 0;

itime.it_interval.tv_sec = 1;

itime.it_interval.tv_nsec = 0;

timerfd_settime(timerfd, 0, &itime, NULL);

while (1)

{

uint64_t times;

int ret = read(timerfd, ×, sizeof(times)); //每次写入固定位8字节

if (ret < 0)

{

perror("read failed");

break;

}

printf("距离上一次超时了%ld次\n", times); //注意是%ld,不是%d

}

close(timerfd);

return 0;

}

这个接口是需要配合读事件监控来使用的。了解了Linux这个接口后,我们就可以这样设计:启动这个定时器,每隔一秒钟就去检测一下,然后将所有连接拿过来遍历一遍,看谁已经非活跃超时了,超时了,则释放掉。

时间轮定时器的基本思想理解

上述设计定时器的解决方案存在一个很大的问题,每次超时都要将所有的连接遍历一遍,如果有上万个连接,效率无疑是较为低下的。

如何提高我们的效率,我们就可以用到我们的小根堆了,这样只需要每次针对堆顶部分的连接逐个释放,直到没有超时的连接为止,这样就可以大大提高处理的效率。

上述方法可以实现定时任务,但是这里给大家介绍另一种方案:时间轮

时间轮的思想来源于钟表,如果我们定了一个3点钟的闹钟,则当时针走到3的时候,就代表时间到了。

同样的道理,如果我们定义了一个大小为60个元素的数组,并且有一个指针,指向数组起始位置,这个指针每秒钟向后走动一步,走到哪里,则代表哪里的任务该被执行了,那么如果我们想要定一个3s后的任务,则只需要将任务添加到tick+3位置,则每秒钟走一步,三秒钟后tick走到对应位置,这时候执行对应位置的任务即可。

这样就会有一个问题了,如果是以秒作为计时单位,当前的这个数组有7个元素,则最大定时时间就只有7s,如果数组有60个元素,则最大定时时间为60s。如果我想定一天的呢?那不是需要开很大的空间,如果我想定两天、一个月、一年的呢?

解决方案:

上面思想仍存在的问题:

1。同一时刻的定时任务只能添加一个,因为元素只有一块空间,需要考虑如何在同一时刻支持支持多个定时任务。解决方案:将时间轮的一维数组设计为二维数组。

2。假设当前的定时任务是一个连接的非活跃销毁任务,这个任务什么时候添加到时间轮中比较合适?

我们并不知道一个连接什么时候是非活跃的,只知道连接什么时候活跃,当一个连接有事件了就是活跃的。我们可以判断如果一个连接30s都没有事件通信,则是一个非活跃连接,这时候就该销毁了。但是一个连接在建立的时候添加了一个30s后的销毁任务,如果这个连接在30s内事件通信了一次,则不是一个非活跃连接,所以我们需要在一个连接有IO事件产生的时候,能延时定时任务的执行。

如何实现这样一个功能呢?

解决方案:类的析构函数 + 智能指针shared_ptr,通过这两个技术可以实现定时任务的延时。

1。使用一个类,对定时任务进行封装,就是一个定时任务对象,当对象被销毁的时候,就会自动去执行定时任务(将定时任务的执行,放到析构函数中)

2。shared_ptr用于对new的对象进行空间管理,当shared_ptr对一个任务对象进行管理的时候,内部有一个计数器,计数器为0的时候,则释放所管理的对象。

基于这个思想,我们可以使用shared_ptr来管理定时器任务对象。

时间轮定时器的代码设计及实现

#include <unistd.h>

#include <cstdint>

#include <functional>

#include <vector>

#include <unordered_map>

#include <memory>

#include <iostream>

using TaskFunc = std::function<void()>;

using ReleaseFunc = std::function<void()>;

class TimerTask

{

private:

uint64_t _id; //定时器任务对象ID 定时任务必须得找得着,一个程序里定时任务可能有很多

uint32_t _timeout; //定时任务的超时时间

TaskFunc _task_cb; //定时器要执行的任务

//用于删除TimerWheel中保存的定时器任务对象信息,定时任务释放的时候也要清理TimerWheel中保存的定时器对象信息

//为什么将这个_release设置到TimerTask里面呢,不在TimerWheel层管理?

//因为这个TimerWheel不知道是否某个定时任务真的释放了,而TimerTask是最清楚的,自己真的释放了就会调用析构函数

ReleaseFunc _release;

bool _canceled; //false - 代表没有被取消,true - 代表取消了

public:

TimerTask(uint64_t id, uint32_t timeout, const TaskFunc& cb)

:_id(id), _timeout(timeout), _task_cb(cb), _canceled(false)

{}

~TimerTask()

{

if (_canceled == false) //如果定时任务没有被取消

_task_cb();

_release();

}

void SetRelease(const ReleaseFunc& cb)

{

_release = cb;

}

uint32_t DelayTime()

{

return _timeout;

}

void Cancel()

{

_canceled = true;

}

};

class TimerWheel

{

private:

using WeakTask = std::weak_ptr<TimerTask>;

using PtrTask = std::shared_ptr<TimerTask>;

std::vector<std::vector<PtrTask>> _wheel;

int _tick; //当前的秒针,走到哪里释放哪里,就相当于执行哪里的任务

int _capacity; //表盘最大数量 -- 也是最大能设置的延时时间

//为什么不用普通指针,要用weak_ptr,因为刷新定时任务的时候,需要通过该weak_ptr找到曾经shared_ptr,而普通指针则不行

std::unordered_map<uint64_t, WeakTask> _timers; //对所有的定时任务进行管理

private:

void RemoveTimer(uint64_t id)

{

auto pos = _timers.find(id);

if (pos != _timers.end())

{

_timers.erase(pos);

}

}

public:

TimerWheel():_capacity(60), _tick(0), _wheel(_capacity)

{}

//时间轮提供了一个功能:释放定时任务的功能

//至于释放的任务是什么,这个组件也不知道,需要上层对内 设置回调函数

void TimerAdd(uint64_t id, uint32_t delay, const TaskFunc& cb) //添加定时任务

{

//1.构建定时任务

PtrTask pt(new TimerTask(id, delay, cb));

pt->SetRelease(std::bind(&TimerWheel::RemoveTimer, this, id));

//2.将定时任务加入到_wheel中

int i = (_tick + delay) % _capacity;

_wheel[i].push_back(pt);

//3.加入到时间轮的_timers里面

// std::unordered_map<uint64_t, WeakTask>::iterator pos = _timers.find(id);

auto pos = _timers.find(id);

if (pos == _timers.end())

{

_timers.insert({id, pt});

}

}

void TimerRefresh(uint64_t id) //刷新/延迟定时任务

{

//通过id找到对应的定时任务

auto pos = _timers.find(id);

if (pos == _timers.end())

{

//如果没找到定时任务,则没办法更新

return;

}

//获取到对应定时任务的shared_ptr,并构建一个新的智能指针,对应的计数加1

PtrTask pt = pos->second.lock();

//将对应的pt加入到_wheel中

int delay = pt->DelayTime();

int i = (_tick + delay) % _capacity;

_wheel[i].push_back(pt);

}

//这个函数会每秒钟执行一次,相当于秒针向后走了一步

void RunTimerTask()

{

_tick = (_tick + 1) % _capacity;

_wheel[_tick].clear(); //情况指定位置的数组,就会把数组中保存的所有管理定时器对象的shared_ptr释放掉

}

void TimerCancel(uint64_t id)

{

auto pos = _timers.find(id);

if (pos == _timers.end())

{

//没找到定时任务,没法刷新,没法延时

return;

}

PtrTask pt = pos->second.lock();

pt->Cancel();

}

};

//该Test类用于测试,能清楚的观察到过程

struct Test

{

Test()

{

std::cout << "Test()" << std::endl;

}

~Test()

{

std::cout << "~Test()" << std::endl;

}

};

//要交给时间轮的定时任务

void DelTest(Test* t)

{

delete t;

}

int main()

{

TimerWheel tw;

Test* t = new Test();

tw.TimerAdd(888, 5, std::bind(DelTest, t));

for (int i = 0; i < 8; ++i)

{

sleep(1);

tw.RunTimerTask(); //硬编码模拟时间轮走动

std::cout << "走了:" << i + 1 << "秒" << std::endl;

}

while (1)

{

sleep(1);

std::cout << "----------------------" << std::endl;

tw.RunTimerTask();

}

return 0;

}

预期结果:过5秒钟定时任务就结束

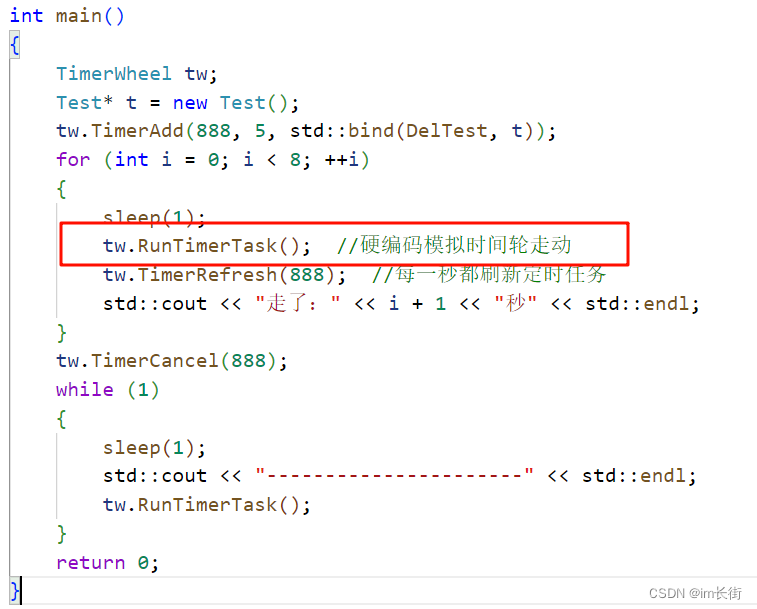

测试TimerRefresh功能,更新main函数

int main()

{

TimerWheel tw;

Test* t = new Test();

tw.TimerAdd(888, 5, std::bind(DelTest, t));

for (int i = 0; i < 8; ++i)

{

sleep(1);

tw.RunTimerTask(); //硬编码模拟时间轮走动

tw.TimerRefresh(888); //每一秒都刷新定时任务

std::cout << "走了:" << i + 1 << "秒" << std::endl;

}

while (1)

{

sleep(1);

std::cout << "----------------------" << std::endl;

tw.RunTimerTask();

}

return 0;

}

预期结果:过13秒钟定时任务才结束

测试TimerCancel功能,更新main函数

int main()

{

TimerWheel tw;

Test* t = new Test();

tw.TimerAdd(888, 5, std::bind(DelTest, t));

for (int i = 0; i < 8; ++i)

{

sleep(1);

tw.RunTimerTask(); //硬编码模拟时间轮走动

tw.TimerRefresh(888); //每一秒都刷新定时任务

std::cout << "走了:" << i + 1 << "秒" << std::endl;

}

tw.TimerCancel(888);

while (1)

{

sleep(1);

std::cout << "----------------------" << std::endl;

tw.RunTimerTask();

}

return 0;

}

预期结果:定时任务不会被执行

正则表达式基本认识

正则表达式(regular expression)描述了一种字符串的匹配模式,可以用来检测一个串是否含有某种特定格式的子串、将匹配的子串替换或者从某个串中提取符合某个条件的子串等。

HTTP协议的数据就有特定的组织格式,以前我们都是用原始字符串的格式,一个一个来解析,我们现在只需要编辑出一种符合HTTP协议规则的正则表达式,通过正则表达式来进行匹配,以及提取出HTTP请求的各项数据,可以让我们更加简单灵活(但是效率没有提高)

bool std::regex_match (const std::string& src, std::smatch& matches, std::regex& e)

src:原始字符串

matches:正则表达式可以从原始字符串中匹配并提取符合某种规则的数据,提取的数据就放在matches中,是一个类似于数组的容器。

e:正则表达式的匹配规则

返回值:用于确定匹配是否成功

举例:

#include <iostream>

#include <string>

#include <regex>

int main()

{

std::string str = "/numbers/1234"; //现在我们想提取出里面的数字字符串

std::regex e("/numbers/(\\d+)"); //括号表示提取数字

/* \d在正则表达式里表示数字

+表示匹配前面子表达式一次或多次

转的时候:第一步:字符串转义。第二步:正则表达式转义

\d在字符串里表示对d字符进行转义 \\在字符串里表示\,所以在字符串里\\d才表示正则表达式的\d

*/

std::smatch matches;

bool ret = std::regex_match(str, matches, e);

if (ret == false)

{

return -1; //字符串整体匹配失败就返回false

}

for (auto& s : matches)

{

//因为我们在匹配的时候,首先是一个整体的规则匹配,看整体的是否匹配成功,首先匹配到的肯定是原始字符串,

//所以首先存储了原始字符串,然后再去存储我们想要提取出来的字符串。所以首先打印的是原始字符串

std::cout << s << std::endl;

}

return 0;

}

编译器版本过低,可能产生各种各样的错误,如果莫名奇妙的出错了,就是需要更新编译器了。

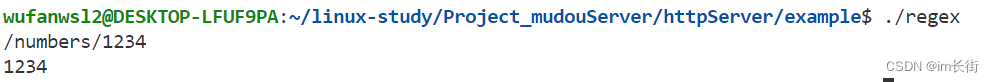

运行结果:

正则表达式不用刻意去记忆,用的时候去网上搜索即可,用到哪些,查哪些,学哪些,忘记了就再查。

正则表达式提取HTTP请求行

#include <iostream>

#include <string>

#include <regex>

int main()

{

std::string str = "GET /helloworld/login?user=xiaoming&passwd=123123 HTTP/1.1";

std::smatch matches;

std::regex e("(GET|HEAD|PUT|POST|DELETE) (/.*) HTTP/(1.[01])");

/*

(POST|GET):|表示匹配任一字符串并提取出来,使用|要加()

.点:表示匹配除\n和\r之外的任何单个字符

*:表示匹配前面子表达式任意次,可0次

[01]:表示匹配0或1的任一字符

*/

bool ret = regex_match(str, matches, e);

if (ret == false)

{

std::cerr << "匹配失败" << std::endl;

return -1;

}

for (auto match : matches)

{

std::cout << match << std::endl;

}

return 0;

}

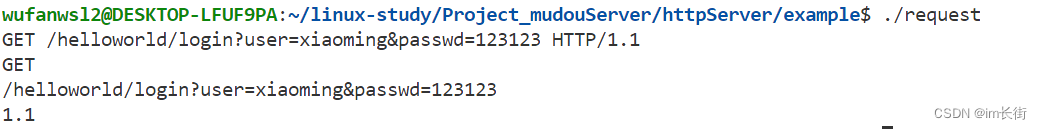

运行结果:

继续对请求路径和查询字符串进行正则匹配

因为请求行中可能没有查询字符串,所以我们写正则表达式的时候,需要将这一点考虑进去

#include <iostream>

#include <string>

#include <regex>

int main()

{

std::string str = "GET /helloworld/login?user=xiaoming&passwd=123123 HTTP/1.1";

std::smatch matches;

// std::regex e("(GET|HEAD|PUT|POST|DELETE) (/.*) HTTP/(1.[01])");

/*

(POST|GET):|表示匹配任一字符串并提取出来,使用|要加()

.点:表示匹配除\n和\r之外的任何单个字符

*:表示匹配前面子表达式任意次,可0次

[01]:表示匹配0或1的任一字符

*/

std::regex e("(GET|HEAD|PUT|POST|DELETE) (/[^?]*(?://?(.*))?) HTTP/(1.[01])");

/*

[^?]:表示匹配非问号的单个字符

(?:……):表示匹配某个字符串,但是不提取,字符串内有()则表示提取

?:表示匹配前面的子表达式1次或0次

因为?在正则表达式里面有特殊含义,所以需要转义为/?,但/?在字符串里有特殊含义,所以需要将/先转义,//会被转义为/,所以最后写为//?表示匹配一个?字符

*/

bool ret = regex_match(str, matches, e);

if (ret == false)

{

std::cerr << "匹配失败" << std::endl;

return -1;

}

for (auto match : matches)

{

std::cout << match << " size: " << match.str().size() << std::endl;

}

return 0;

}

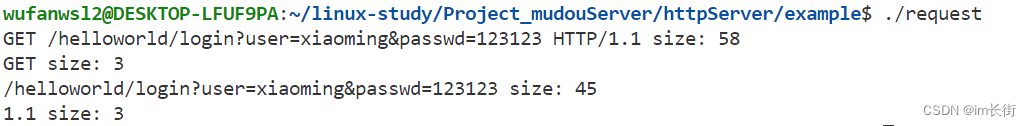

运行结果:

当没有查询字符串运行结果

#include <iostream>

#include <string>

#include <regex>

int main()

{

// std::string str = "GET /helloworld/login?user=xiaoming&passwd=123123 HTTP/1.1";

std::string str = "GET /helloworld/login HTTP/1.1";

std::smatch matches;

// std::regex e("(GET|HEAD|PUT|POST|DELETE) (/.*) HTTP/(1.[01])");

/*

(POST|GET):|表示匹配任一字符串并提取出来,使用|要加()

.点:表示匹配除\n和\r之外的任何单个字符

*:表示匹配前面子表达式任意次,可0次

[01]:表示匹配0或1的任一字符

*/

std::regex e("(GET|HEAD|PUT|POST|DELETE) (/[^?]*(?://?(.*))?) HTTP/(1.[01])");

/*

[^?]:表示匹配非问号的单个字符

(?:……):表示匹配某个字符串,但是不提取,字符串内有()则表示提取

?:表示匹配前面的子表达式1次或0次

因为?在正则表达式里面有特殊含义,所以需要转义为/?,但/?在字符串里有特殊含义,所以需要将/先转义,//会被转义为/,所以最后写为//?表示匹配一个?字符

*/

bool ret = regex_match(str, matches, e);

if (ret == false)

{

std::cerr << "匹配失败" << std::endl;

return -1;

}

for (auto match : matches)

{

std::cout << match << " size: " << match.str().size() << std::endl;

}

return 0;

}

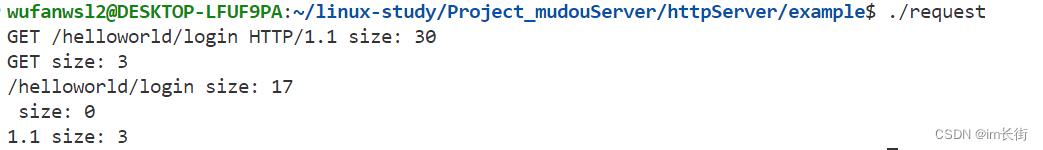

运行结果:

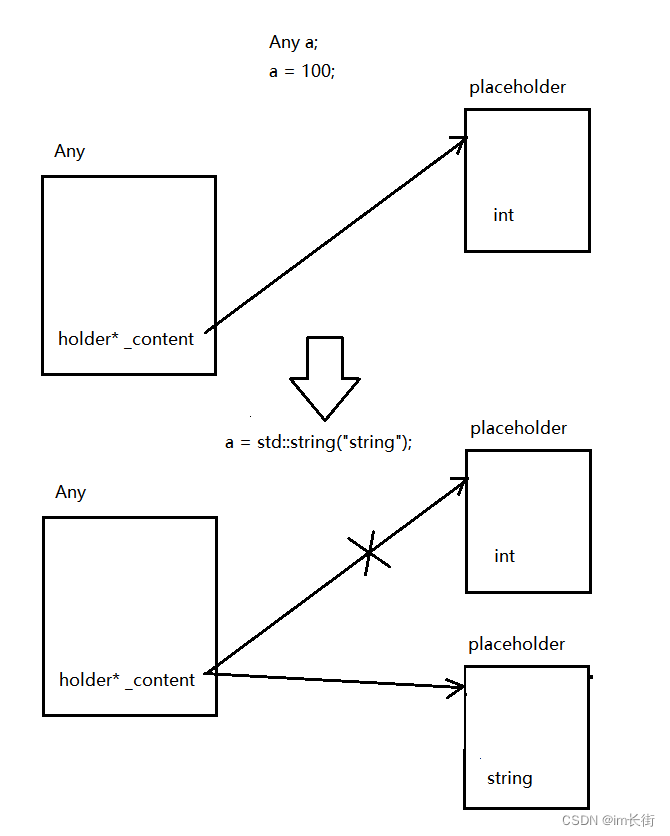

通用类型容器Any类设计思想

每一个Connection对连接进行管理,最终都不可避免需要涉及到应用层协议的处理,因此在Connection中需要设置协议处理的上下文来控制处理节奏。但是应用层协议千千万,为了降低耦合度,这个协议接收解析上下文就不能有明显的协议倾向,它可以使任意协议的上下文信息,因此就需要有一个通用的类型来保存各种不同的数据结构。

我们组件可以提供各种不同的协议支持,以便于用户去搭建一些应用服务器。问题就在于我们对协议进行支持的时候,我们支持的协议是什么,我们本身也不清楚。所以我们的并发服务器就需要考虑一个点,当我们的socket有数据到来了,接收它的数据,发现缓冲区的数据不足一条完整的请求或者比一条完整的请求多(TCP面向字节流的特点)。或者发送请求的数据比内核缓冲区还大,如果我们希望把整个数据取出来再解析,那你永远也获取不到一个完整的请求。

所以就会出现一种情况,处理到一半就没有数据了,我们就需要等到下一半数据到来接着处理,所以解决方案:给服务器里面每一个连接设置一个协议请求处理的上下文,这个上下文就是专门来控制请求数据接收以及解析节奏的,对于我们的协议支持来说它的功能就是用来记录当前的请求处理到什么的阶段了,下次有数据到来了,我们应该从缓冲区里取到的数据应该哪里开始接着继续处理。

怎么去保存接收与解析的上下文呢?既然我们要支持HTTP协议,那我们是不是得定义一个HTTP协议这样的结构,这样就能够对接收到的数据进行解析并填充进去,并记录解析的状态,如果我们的服务器只支持HTTP服务器,这么做是没有问题的,但是我们的服务器不单单要支持我们的HTTP协议,它还要支持各种不同的协议,所以在连接里面所设计的上下文就不能是一个固定结构的上下文,这时候我们就得有一个容器能够去接收各种不同的数据。

在C语言中,通用类型可以使用void*来管理,在C++中,boost库和C++17给我们提供了一个通用类型any来灵活使用,我们用C++17特性中的any,而这个any通用类型类实现起来并不复杂,我们自己来设计一个any类。

是一个容器,容器中可以保存各种不同类型的数据

#include <iostream>

#include <string>

template<class T>

class Any

{

private:

T _content;

};

int main()

{

Any a;

a = 100;

a = std::string("string");

return 0;

}

这样设计是不行的,并不能满足我们的事例。

解决方法:Any类保存的是父类对象,根据传的参数new出一个子类赋值给父类,子类是可变的模版类。

Any类中,保存的是holder类的指针,当Any容器需要保存一个数据的时候,只需要通过placeholder子类实例化一个特定类型的子类对象出来,让子类对象保存数据。

#include <iostream>

#include <string>

#include <typeinfo>

#include <utility>

class Any

{

public:

class holder

{

public:

virtual ~holder()

{}

virtual const std::type_info& type() = 0; //获取当前子类的数据类型 -- 返回类型是const type_info&

virtual holder* clone() = 0; //针对当前的对象自身,克隆出一个新的子类对象

};

template<class T>

class placeholder : public holder

{

public:

placeholder(const T& val = T()):_val(val)

{}

virtual const std::type_info& type()

{

return typeid(T);

}

virtual holder* clone()

{

return new placeholder(_val);

}

T _val;

};

Any():_content(NULL)

{}

template <class T>

Any(const T& content):_content(new placeholder<T>(content))

{}

~Any()

{

delete _content;

}

Any& swap(Any& other)

{

std::swap(_content, other._content);

return *this;

}

template<class T>

Any& operator=(const T& val)

{

Any(val).swap(*this); //这样写的好处:Any(val)为临时对象,交换完生命周期就到了,就会调用自己的析构函数

return *this;

}

Any& operator=(const Any& other)

{

Any(other).swap(*this);

return *this;

}

template<class T>

T* get() //返回子类对象保存数据的指针

{

if (typeid(T) != _content->type()) //如果你要的类型和我保存的类型不匹配

return NULL;

return &(((placeholder<T>*)_content)->_val);

}

public:

holder* _content;

};

class Test

{

public:

Test()

{

std::cout << "Test()" << std::endl;

}

Test(const Test& t)

{

std::cout << "Test()" << std::endl;

}

~Test()

{

std::cout << "~Test()" << std::endl;

}

};

int main()

{

Any a;

{

Test t;

a = t;

}

a = 10;

int *pa = a.get<int>();

std::cout << *pa << std::endl;

a = std::string("nihao");

std::string *ps = a.get<std::string>();

std::cout << *ps << std::endl;

return 0;

}

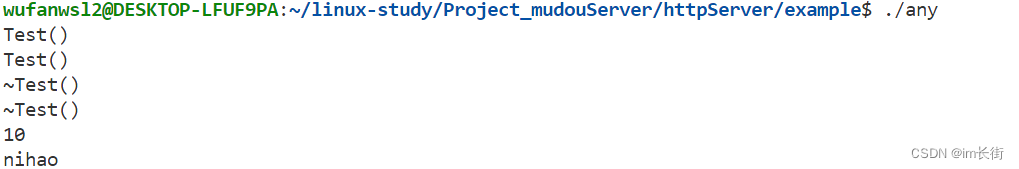

运行结果:

有人就想,既然有现成的为什么不用现成的?当然你也可以用,我们把any的思想介绍给大家,并且也不难实现。

查C++17文档,可对照文档的示例进行理解

#include <iostream>

#include <string>

#include <typeinfo>

#include <utility>

#include <any>

int main()

{

//官方any的使用方法,主要还是要查文档

std::any a;

a = 10;

int* pi = std::any_cast<int>(&a);

std::cout << *pi << std::endl;

a = std::string("hello");

std::string* ps = std::any_cast<std::string>(&a);

std::cout << *ps << std::endl;

return 0;

}

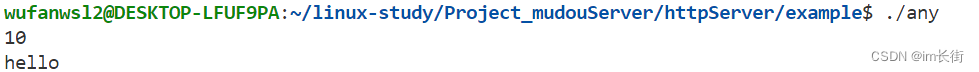

运行结果:

Buffer缓冲区设计思想

我们要开始写我们项目的代码了,所以我们创建一个新的源代码目录source。

我们写源码考虑的是,我们将高性能服务器开发完了,我们给别人提供的时候怎么提供呢?我们可以给别人提供编译完成的库,然后把头文件给它。也可以是全部写到头文件里面去,别人用的时候直接包含头文件就可以了,这样就可以简单一点。而我们的方式就是这第二种方式,这也是一种比较典型的用法,单头文件的方式。

Buffer模块:

提供的功能:存储数据,取出数据

实现思想:

1。实现缓冲区得有一块内存空间,采用vector< char>的数据结构。为什么使用vector< char>而不使用string呢?string更多的表示是字符串的操作,字符串的操作有一个缺陷就是遇到了’\0’就会停止,因为网络传输,什么样的数据都有可能传输,就有可能存在这种数据(像图片、视频这种二进制文件)。

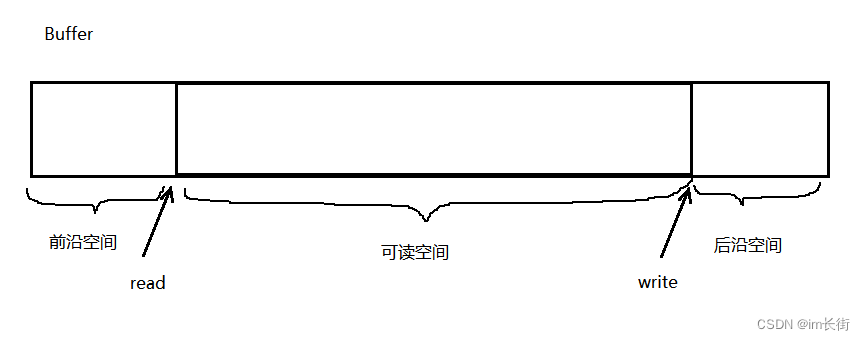

2。要素:a.默认的空间大小b.当前的读取数据位置c.当前的写入数据位置3。操作:

1)写入数据:当前写入位置指向哪里,就从哪里开始写入,如果后沿空间剩余空间不够了,考虑前沿+后沿空闲的空间是否足够a.足够:将数据移动到起始位置。b.不够:扩容,从当前写位置开始扩容足够大小。数据一旦写入成功,当前写位置就要向后偏移。

我们不可能说每次要存储数据的时候,就要把Buffer中的数据全部挪到起始位置上去,那这样效率就太低了。只有在后沿空间不够,前沿空间+后沿空间足够的时候,才将所有的数据挪到前面去。前沿空间+后沿空间不足够的时候,不挪动,直接扩容再存储。这样就可以保证挪动数据不那么频繁。

2)读取数据:当前的读取位置指向哪里,就从哪里开始读取,前提是有数据可读。可读数据大小:当前写入位置减去当前读取位置。

#include <iostream>

#include <vector>

#include <cstdint>

#include <cassert>

#include <string>

#include <cstring>

#include <memory>

#define BUFFER_DEFAULT_SIZE 1024

class Buffer

{

private:

std::vector<char> _buffer;

uint64_t _read_idx; //相对读偏移量

uint64_t _write_idx; //相对写偏移量

public:

Buffer()

:_read_idx(0), _write_idx(0), _buffer(1024)

{}

//获取起始地址

char* Begin() const

{

return (char*)&_buffer[0];

}

//获取当前写入起始地址

char* WritePosition() const

{

return Begin() + _write_idx;

}

//获取当前读取起始地址

char* ReadPosition() const

{

return Begin() + _read_idx;

}

//获取缓冲区末尾空闲空间大小 -- 写偏移之后的空闲空间

uint64_t TailIdleSize() const

{

return _buffer.size() - _write_idx;

}

//获取缓冲区起始空闲空间大小 -- 读偏移之前的空闲空间

uint64_t HeadIdleSize() const

{

return _read_idx;

}

//获取可读数据大小

uint64_t ReadAbleSize() const

{

return _write_idx - _read_idx;

}

//将读偏移向后移动,必须小于可读数据大小

void MoveReadOffset(uint64_t len)

{

assert(len <= ReadAbleSize());

_read_idx += len;

}

//将写偏移向后移动,向后移动的大小必须小于前沿和后沿的空闲空间的大小

void MoveWriteOffset(uint64_t len)

{

assert(len <= HeadIdleSize() + TailIdleSize());

_write_idx += len;

}

//确保可写空间足够(整体空闲空间够了就移动数据,否则就扩容)

void EnsureWriteSpace(uint64_t len)

{

if (TailIdleSize() > len) //如果末尾空闲空间大小足够,直接返回

return;

//末尾空间不够,则判断加上起始空闲位置的空闲空间大小是否足够

if (len <= TailIdleSize() + HeadIdleSize())

{

uint64_t rsz = ReadAbleSize(); //把当前数据大小先保存起来

//copy:第一个参数,要拷贝的起始地址。第二个参数,要拷贝的末尾地址。第三个参数:拷贝到某个地址上面

std::copy(ReadPosition(), ReadPosition() + rsz, Begin());

_read_idx = 0; //将读偏移归0

_write_idx = rsz; //将写偏移置为可读数据大小

}

else //总体空间不够,扩容

{

_buffer.resize(_write_idx + len);

}

}

//写入数据

void Write(const void* data, uint64_t len)

{

//1。保证有足够空间 2。拷贝数据进去

if (len == 0) //防御性编程,不要嫌弃多次判断

return;

EnsureWriteSpace(len);

std::copy((char*)data, (char*)data + len, WritePosition());

}

void WriteAndPush(const void* data, uint64_t len)

{

Write(data, len);

MoveWriteOffset(len);

}

void WriteString(const std::string& data)

{

Write((const void*)data.c_str(), data.size());

}

void WriteStringAndPush(const std::string& data)

{

WriteString(data);

MoveWriteOffset(data.size());

}

void WriteBuffer(Buffer& data)

{

Write((const void*)data.ReadPosition(), data.ReadAbleSize());

}

void WriteBufferAndPush(Buffer& data)

{

WriteBuffer(data);

MoveWriteOffset(data.ReadAbleSize());

}

//读取数据

void Read(void* buf, uint64_t len)

{

//要求读取的数据大小必须小于可读数据的大小

assert(len <= ReadAbleSize());

std::copy(ReadPosition(), ReadPosition() + len, (char*)buf);

}

void ReadAndPop(void* buf, uint64_t len)

{

Read(buf, len);

MoveReadOffset(len);

}

std::string ReadAsString(uint64_t len)

{

assert(len <= ReadAbleSize());

std::string str;

str.resize(len);

Read(&str[0], len);

return str;

}

std::string ReadAsStringAndPop(uint64_t len)

{

std::string str = ReadAsString(len);

MoveReadOffset(len);

return str;

}

char* FindCRLF() //查找回车字符的地址

{

//查找某一个字节/字符

char* res = (char*)memchr(ReadPosition(), '\n', ReadAbleSize());

return res;

}

//获取一行数据

std::string GetLine()

{

const char* pos = FindCRLF();

if (pos == NULL)

return "";

return ReadAsString(pos - ReadPosition() + 1); //包括将'\n'也读取进去 -- 方便后面对HTTP协议的操作

}

std::string GetLineAndPop()

{

std::string str = GetLine();

MoveReadOffset(str.size());

return str;

}

//清空缓冲区

void Clear()

{

//只需要将偏移量归0即可

_read_idx = 0;

_write_idx = 0;

}

};

测试1:

#include "../source/server.hpp"

int main()

{

Buffer buf;

std::string str = "hello!!";

buf.WriteStringAndPush(str);

std::string tmp;

tmp = buf.ReadAsStringAndPop(buf.ReadAbleSize());

std::cout << tmp << std::endl;

std::cout << buf.ReadAbleSize() << std::endl;

return 0;

}

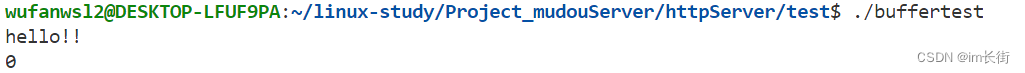

运行结果:

测试2:

#include "../source/server.hpp"

int main()

{

Buffer buf;

std::string str = "hello!!";

buf.WriteStringAndPush(str);

Buffer buf1;

buf1.WriteBufferAndPush(buf);

std::string tmp;

tmp = buf1.ReadAsStringAndPop(buf1.ReadAbleSize());

std::cout << tmp << std::endl;

std::cout << buf.ReadAbleSize() << std::endl;

std::cout << buf1.ReadAbleSize() << std::endl;

return 0;

}

运行结果:

测试3:

#include "../source/server.hpp"

int main()

{

Buffer buf;

for (int i = 0; i < 300; ++i)

{

std::string str = "hello!!" + std::to_string(i) + '\n';

buf.WriteStringAndPush(str);

}

while (buf.ReadAbleSize() > 0)

{

std::string line = buf.GetLineAndPop();

std::cout << line;

}

return 0;

}

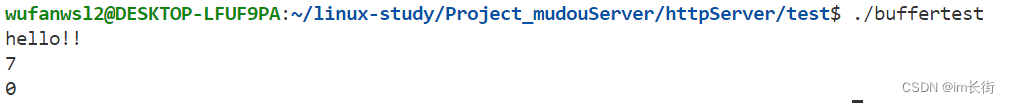

运行结果:

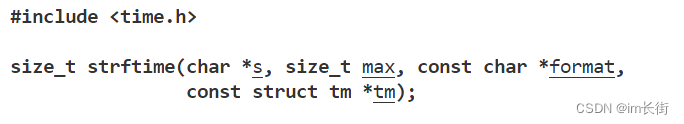

日志打印宏的编写

程序一旦出问题了,最简单的排查流程就是在代码里面做打印观察,当然gdb调试也可以,打印有一个专业叫法叫做日志,程序运行的过程中,程序出错了,日志打印的信息能快速的定位是哪一行出的问题。如果是cout打印的话,当我们调试完不需要这些打印了,我们还需要逐个的把他们找到并删除掉,很麻烦。我可以通过日志设置一个打印等级。

打印等级分为普通信息打印,调试信息打印,错误信息打印。打印等级为普通信息,则所有的信息都打印,打印等级设置为调试等级就代表打印调试信息和错误信息。调试完后,我们不需要删除代码,只需要把等级设置为错误信息等级(普通信息和调试信息都不再打印,只打印错误信息)

我们这个日志不实现的那么复杂,只做一个宏,在我们项目中够用即可。

#include <stdio.h>

#include <iostream>

#include <string>

#define LOG(msg) fprintf(stdout, "[%s:%d] %s\n", __FILE__, __LINE__, msg);

int main()

{

for (int i = 0; i < 8; ++i)

{

LOG("hello world");

}

return 0;

}

这样写,只能打印字符串,数据只有一个,参数只有一个,这样也不合适。我希望你能想printf一样的打印

#include <stdio.h>

#include <iostream>

#include <string>

#define LOG(format, ...) fprintf(stdout, "[%s:%d] " format "\n", __FILE__, __LINE__, __VA_ARGS__);

int main()

{

for (int i = 0; i < 8; ++i)

{

LOG("hello world, %d", i + 1);

}

return 0;

}

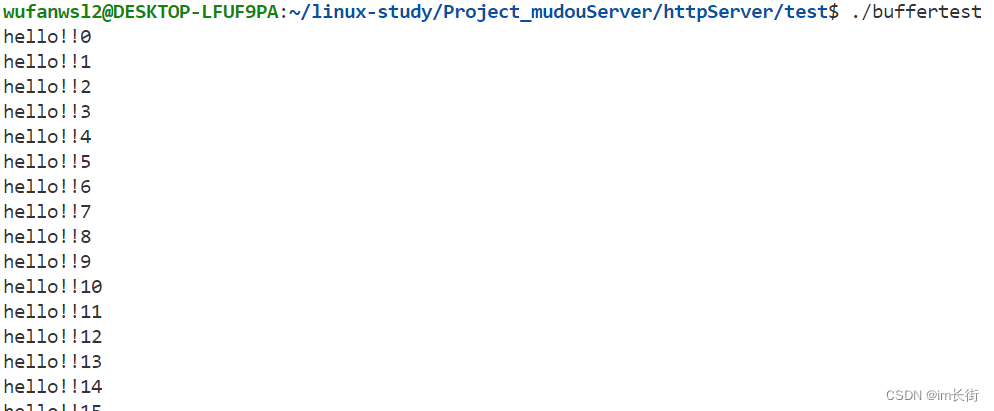

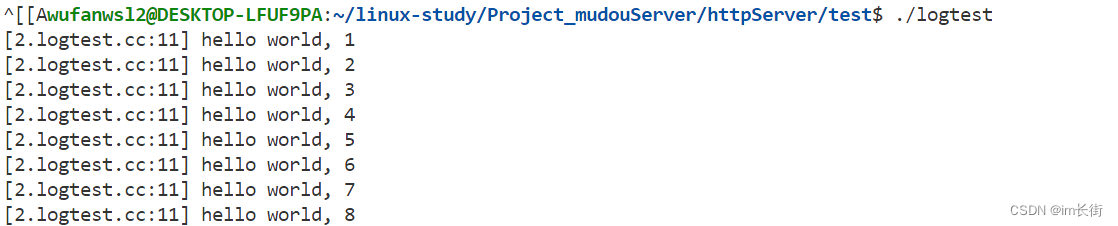

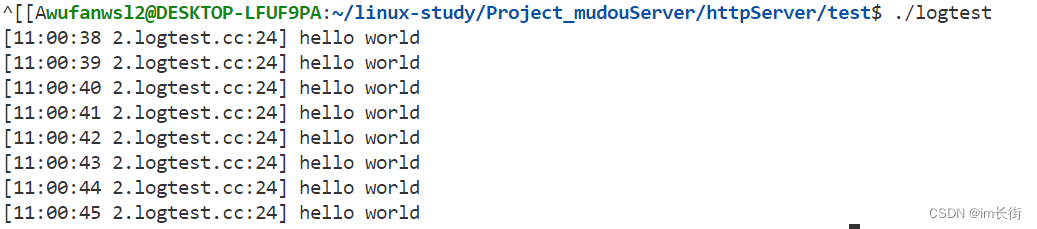

运行结果:

如果这样传就会报错,因为这种方式代表后面没有不定参,只有一个参数。所以C语言提供了一种方案:

#include <stdio.h>

#include <iostream>

#include <string>

#define LOG(format, ...) fprintf(stdout, "[%s:%d] " format "\n", __FILE__, __LINE__, ##__VA_ARGS__);

int main()

{

for (int i = 0; i < 8; ++i)

{

LOG("hello world");

}

return 0;

}

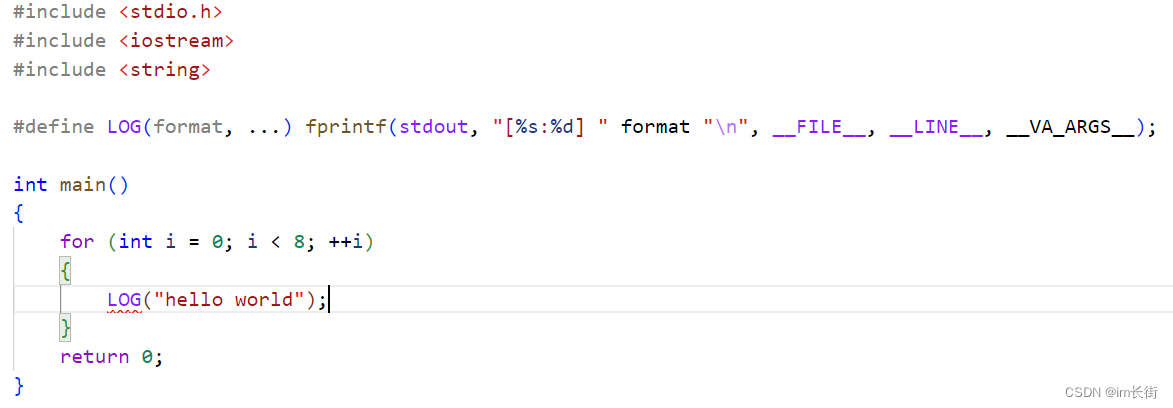

运行结果:

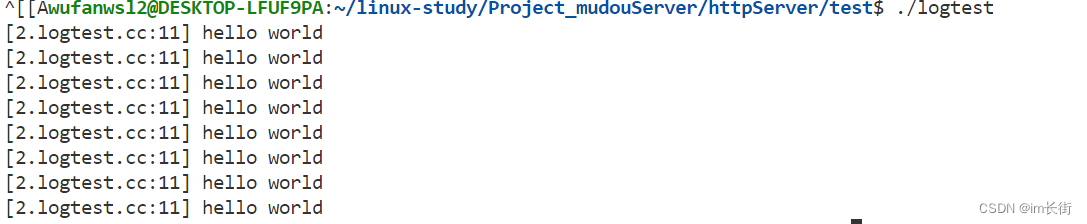

除此之外,我们还要做的更完善一点,带上一个时间,有些时候还希望看到这个日志是什么时候打印的。我们后面项目需要做一些超时的测试,都会用到这个时间。

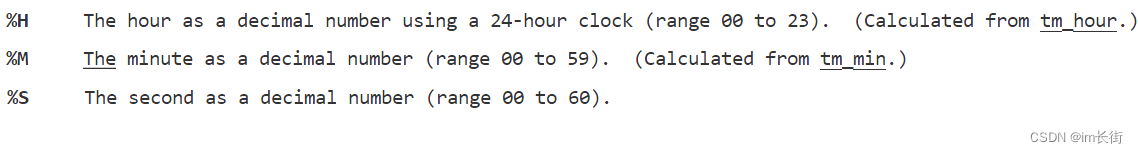

将struct tm以固定的格式写到字符串s里面

#include <stdio.h>

#include <iostream>

#include <string>

#include <ctime>

#include <unistd.h>

//技巧:加上do while循环能应用于代码的各种情况

//宏里面不能有换行,所以加上\转义换行,代表后面没有换行

#define LOG(format, ...) \

do \

{ \

time_t t = time(NULL); \

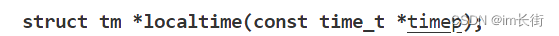

struct tm* lltime = localtime(&t); \

char time[32]; \

strftime(time, 31, "%H:%M:%S", lltime); \

fprintf(stdout, "[%s %s:%d] " format "\n", time, __FILE__, __LINE__, ##__VA_ARGS__); \

} while (0)

int main()

{

for (int i = 0; i < 8; ++i)

{

sleep(1);

LOG("hello world");

}

return 0;

}

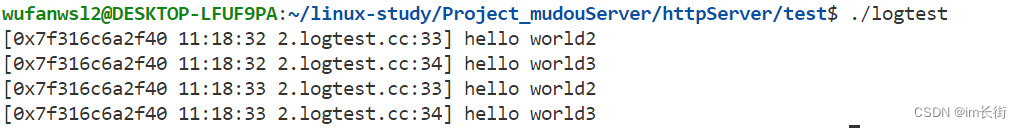

设置日志等级

#include <stdio.h>

#include <iostream>

#include <string>

#include <ctime>

#include <unistd.h>

//技巧:加上do while循环能应用于代码的各种情况

//宏里面不能有换行,所以加上\转义换行,代表后面没有换行

#define INF 0

#define DBG 1

#define ERR 2

#define LOG_LEVEL DBG

#define LOG(level, format, ...) \

do \

{ \

if (LOG_LEVEL > level) \

break; \

time_t t = time(NULL); \

struct tm* lltime = localtime(&t); \

char time[32]; \

strftime(time, 31, "%H:%M:%S", lltime); \

fprintf(stdout, "[%p %s %s:%d] " format "\n",(void*)pthread_self(), time, __FILE__, __LINE__, ##__VA_ARGS__); \

} while (0)

#define INF_LOG(format, ...) LOG(INF, format, ##__VA_ARGS__)// 使用不定参的...只能声明定义的时候用,使用的时候用__VA_ARGS__

#define DBG_LOG(format, ...) LOG(DBG, format, ##__VA_ARGS__)

#define ERR_LOG(format, ...) LOG(ERR, format, ##__VA_ARGS__)

int main()

{

for (int i = 0; i < 2; ++i)

{

sleep(1);

INF_LOG("hello world1");

DBG_LOG("hello world2");

ERR_LOG("hello world3");

}

return 0;

}

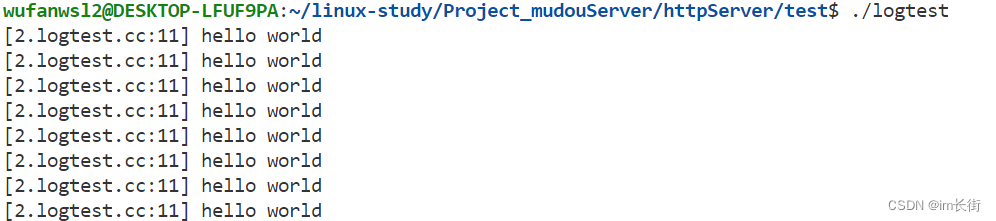

运行结果:

Socket套接字类设计思想

为了对socket的基本接口更加方便的使用,对其进行一个封装,封装成一个类出来,通过这个类的接口能更简便的完成套接字的各种操作

#define MAX_LISTEN 1024

class Socket

{

private:

int _sockfd;

public:

Socket()

:_sockfd(-1)

{}

Socket(int fd)

:_sockfd(fd)

{}

~Socket()

{

Close();

}

int Fd()

{

return _sockfd;

}

//创建套接字

bool Create()

{

int ret = socket(AF_INET, SOCK_STREAM, 0);

if (ret < 0)

{

ERR_LOG("CREATE SOCKET FAILED:%s", strerror(errno));

return false;

}

_sockfd = ret;

return true;

}

//绑定地址信息

bool Bind(const std::string& ip, uint16_t port)

{

struct sockaddr_in addr;

addr.sin_addr.s_addr = inet_addr(ip.c_str());

addr.sin_family = AF_INET;

addr.sin_port = htons(port);

int ret = bind(_sockfd, (const sockaddr*)&addr, sizeof(addr));

if (ret < 0)

{

ERR_LOG("BIND SOCKET FAILED:%s", strerror(errno));

return false;

}

return true;

}

//开始监听

bool Listen(int backlog = MAX_LISTEN)

{

int ret = listen(_sockfd, backlog);

if (ret < 0)

{

ERR_LOG("LISTEN SOCKET FAILED:%s", strerror(errno));

return false;

}

return true;

}

//向服务器发起连接

bool Connect(const std::string& ip, uint16_t port)

{

struct sockaddr_in addr;

addr.sin_addr.s_addr = inet_addr(ip.c_str());

addr.sin_port = htons(port);

addr.sin_family = AF_INET;

int ret = connect(_sockfd, (const sockaddr*)&addr, sizeof(addr));

if (ret < 0)

{

ERR_LOG("CONNECT SERVER FAILED:%s", strerror(errno));

return false;

}

return true;

}

//获取新连接

int Accept()

{

int newfd = accept(_sockfd, NULL, NULL);

if (newfd < 0)

{

ERR_LOG("ACCEPT SOCKET FAILED:%s", strerror(errno));

return -1;

}

return newfd;

}

//接收数据

ssize_t Recv(void* Buffer, size_t len, int flag = 0)

{

int n = recv(_sockfd, Buffer, len, flag);

if (n == 0)

{

//等于0的时候表示连接断开

DBG_LOG("CONNECTION CLOSED");

return -1;

}

if (n < 0)//小于0的时候表示读出错了

{

if (errno == EAGAIN || errno == EINTR)

{

//EAGAIN 表示当前socket的接收缓冲区中没有数据,在非阻塞情况下才会出现这种错误

//EINTR 表示当前socket的阻塞等待被信号打断了

return 0; //表示这次没有接收到数据

}

ERR_LOG("SOCKET RECV FAILED");

return -1;

}

return n;

}

//非阻塞读取

ssize_t NonBlockRecv(void* buffer, size_t len)

{

return Recv(buffer, len, MSG_DONTWAIT);

}

//发送数据 -- 外部可以根据实际发送的数据长度来决定下一步的处理

ssize_t Send(const void* buf, size_t len, int flag = 0)

{

int n = send(_sockfd, buf, len, flag);

if (n < 0)

{

if (errno == EAGAIN || errno == EINTR)

{

return 0;

}

ERR_LOG("SOCKET SEND FAILED");

return -1;

}

return n;

}

//非阻塞发送数据

ssize_t NonBlockSend(void* buf, size_t len)

{

return send(_sockfd, buf, len, MSG_DONTWAIT);

}

//关闭套接字

void Close()

{

if (_sockfd != -1)

close(_sockfd);

_sockfd = -1;

}

//创建一个服务器连接

bool CreateServer(uint16_t port, const std::string& ip = "0.0.0.0", bool block_flag = false)

{

//创建套接字

if (Create() == false)

return false;

if (block_flag == true)

NonBlock();

//设置端口复用

ReuseAddress();

//绑定地址

if (Bind(ip, port) == false)

return false;

//开始监听

if (Listen() == false)

return false;

return true;

}

//创建一个客户端连接

bool CreateClient(uint16_t port, const std::string ip)

{

//创建套接字

if (Create() == false)

return false;

//连接服务器

if (Connect(ip, port) == false)

return false;

return true;

}

/*

一个连接绑定了地址和端口之后一旦主动关闭连接的一方最终会进入time_wait状态,这时候套接字

并不会立即被释放,因此IP地址和端口依然被占用,导致我们无法立即去使用它,在服务器使用的时候,

崩溃了,退出了,会无法立即重启,所以我们要开启地址重用。

*/

//设置套接字选项 -- 开启端口复用

void ReuseAddress()

{

int opt = 1;

setsockopt(_sockfd, SOL_SOCKET, SO_REUSEPORT | SO_REUSEADDR, &opt, sizeof(opt));

}

/*

我们在使用套接字去接收数据的时候,一次性可能取不完数据,就需要循环去接收缓冲区里的数据,什么时候取完呢?

就是取到没有数据为止,但是套接字默认是阻塞的,没有数据的时候再去取就会被阻塞住,程序就

无法继续往下走了,所以我们需要将套接字设置为非阻塞

*/

//设置套接字阻塞属性 -- 设置为非阻塞

void NonBlock()

{

int flag = fcntl(_sockfd, F_GETFL, 0);

fcntl(_sockfd, F_SETFL, flag | O_NONBLOCK);

}

};

测试:

#include "../source/server.hpp"

int main()

{

Socket lst_sock;

lst_sock.CreateServer(8085);

while (1)

{

int newfd = lst_sock.Accept();

if (newfd < 0)

{

continue;

}

DBG_LOG("ACCEPT NEW SOCKET SUCCESS");

Socket cli_sock(newfd);

char buf[4096] = {0};

int n = cli_sock.Recv(buf, 4095);

if (n < 0)

{

//说明读取出错

cli_sock.Close();

continue;

}

cli_sock.Send(buf, n);

DBG_LOG("CLOSE CLIENT");

cli_sock.Close();

}

lst_sock.Close();

return 0;

}

#include "../source/server.hpp"

int main()

{

Socket cli_socket;

cli_socket.CreateClient(8085, "127.0.0.1");

std::string str = "hello world!!!";

cli_socket.Send(str.c_str(), str.size());

char buf[4096] = {0};

cli_socket.Recv(buf, 4095);

DBG_LOG("%s", buf);

return 0;

}

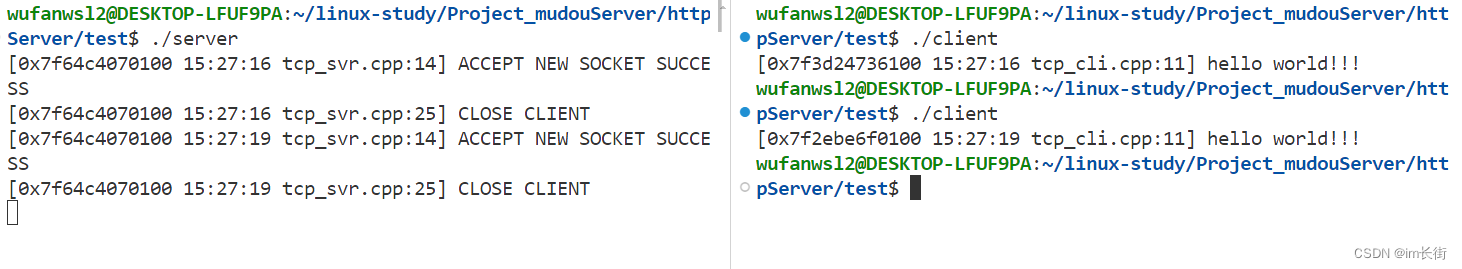

运行结果:

Channel事件管理类设计思想

Channel模块是对一个文件描述符进行监控事件管理的模块。

意义:1。用户对描述符的监控操作变得更加简单2。使用的时候流程更加清晰

之前我们画了一个流程图,可以看出Channel模块只是Connection的一个子模块,只是连接管理里面的事件管理模块,事件触发了之后要对连接进行什么样的操作呢?会调用Connection给他设置过的回调函数。这就是他们之间的关系。

EPOLL的事件,前面的事件都在之前的文章中有讲解。

什么是EPOLLHUP?EPOLLHUP一般与EPOLLERR同时触发,一般在一个连接的文件描述符完全被关闭,但你仍然去操作了这个文件描述符的时候会触发。主要处理全关闭状态。

什么是EPOLLRDHUP?你在读取的时候,对端连接断开触发的epoll事件会包含EPOLLIN | EPOLLRDHUP。主要是处理半关闭状态。

什么是EPOLLPR?recv的第三个参数,可设置为优先带外数据。在之前文章中也有讲解。

| 事件 | 说明 |

|---|---|

| EPOLLIN | 可读 |

| EPOLLOUT | 可写 |

| EPOLLEDHUP | 连接断开 |

| EPOLLPRI | 优先数据 |

| EPOLLERR | 错误 |

| EPOLLHUP | 挂断 |

class Channel

{

private:

uint32_t _events; //当前需要监控的事件

uint32_t _revents; //当前连接触发的事件

using EventCallback = std::function<void()>;

/*

只有我们的连接才知道,一旦事件触发了该去怎么处理,所以需要设置回调函数。

当启动读事件监控,就需要将channel挂到EventLoop上面进行事件监控,

当可读事件触发,就会调用channel里设置的回调函数。

*/

EventCallback _read_callback; //可读事件被触发的回调函数

EventCallback _write_callback; //可写事件被触发的回调函数

EventCallback _error_callback; //错误事件被触发的回调函数

EventCallback _close_callback; //连接断开事件被触发的回调函数

EventCallback _event_callback; //任意事件被触发的回调函数

int _fd;

public:

Channel(int fd)

:_fd(fd), _events(0), _revents(0)

{}

int Fd()

{

return _fd;

}

void SetREvents(uint32_t events)

{

_revents = events;

}

void SetReadCallback(const EventCallback& cb)

{

_read_callback = cb;

}

void SetWriteCallback(const EventCallback& cb)

{

_write_callback = cb;

}

void SetErrorCallback(const EventCallback& cb)

{

_error_callback = cb;

}

void SetCloseCallback(const EventCallback& cb)

{

_close_callback = cb;

}

void SetEventCallback(const EventCallback& cb)

{

_event_callback = cb;

}

//当前是否监控了可读

bool ReadAble()

{

return (_events & EPOLLIN);

}

//当前是否监控了可写

bool WriteAble()

{

return (_events & EPOLLOUT);

}

//启动读事件监控

void EnableRead()

{

_events |= EPOLLIN;

//后边会添加到EventLoop的事件监控中,暂时不写,因为EventLoop模块还没有写

}

//启动可写事件监控

void EnableWrite()

{

_events |= EPOLLOUT;

//后边会添加到EventLoop的事件监控中,暂时不写,因为EventLoop模块还没有写

}

//关闭读事件监控

void DisableRead()

{

_events &= ~EPOLLIN;

//后边会修改在EventLoop的事件监控中,暂时不写,因为EventLoop模块还没有写

}

//关闭写事件监控

void DisableWrite()

{

_events &= ~EPOLLOUT;

//后边会修改在EventLoop的事件监控中,暂时不写,因为EventLoop模块还没有写

}

//关闭所有事件监控

void DisableAll()

{

_events &= 0;

}

/*

关闭事件监控,只是不去关心这个事件了,但还是在EventLoop中。

移除事件监控,才是真正的将它从EventLoop中移除

*/

//移除监控

void Remove()

{

//后边会调用EventLoop接口来移除监控,暂时不写,因为EventLoop模块还没有写

}

/*

EventLoop不用 你触发了什么事件我就去调用对应的回调函数,EventLoop不用管。

EventLoop只管你触发了事件,我就调用你的HandleEvent,你自己来决定什么样的事件该如何处理

这是最能体现Channel模块作用的功能之一

*/

void HandleEvent()

{

if ((_revents & EPOLLIN) || (_revents & EPOLLRDHUP) || (_revents & EPOLLPRI))

{

if (_read_callback)

_read_callback();

}

if (_revents & EPOLLOUT)

{

if (_write_callback)

_write_callback();

}

if (_revents & EPOLLERR)

{

if (_error_callback)

_error_callback();

}

if (_revents & EPOLLHUP)

{

if (_close_callback)

_close_callback();

}

if (_event_callback)

_event_callback();

}

};

Poller描述符监控类设计思想

Channel最终是要被添加到EventLoop的事件监控中的,如何添加呢?EventLoop会通过我们的poller所提供的接口添加到Poller,被其所管理,所以Poller不仅仅管理的是描述符,还有对应的channel。

Poller模块:描述符IO事件监控的模块。

功能:

1。添加/修改描述符的事件监控(不存在则添加,存在则修改)

2。移除描述符的事件监控

逻辑流程:

1。Poller对描述符进行监控,通过Channel才能知道描述符需要监控什么事件

2。当描述符就绪了,Poller通过描述符在hash表中找到对应的Channel(得到了Channel才能知道什么事件如何处理)并返回就绪描述符对应的Channel。(外界才能通过这个Channel才能知道你就绪了什么事件,如何去处理它)

#define MAX_EPOLLEVENTS 1024

class Poller

{

private:

int _epfd;

struct epoll_event _evs[MAX_EPOLLEVENTS];

std::unordered_map<int, Channel*> _channels; //这个和epoll里面的所有文件描述符是强绑定的

private:

//对epoll的直接操作

void Update(Channel* channel, int op)

{

int fd = channel->Fd();

struct epoll_event ev;

ev.data.fd = fd;

ev.events = channel->Events();

int ret = epoll_ctl(_epfd, op, fd, &ev);

if (ret < 0)

{

ERR_LOG("EPOLLCTL FAILED");

}

return;

}

//判断一个Channel是否已经添加了事件监控

bool HasChannel(Channel* channel)

{

auto pos = _channels.find(channel->Fd());

if (pos == _channels.end())

{

return false;

}

return true;

}

public:

Poller()

{

_epfd = epoll_create(MAX_EPOLLEVENTS);

if (_epfd < 0)

{

ERR_LOG("EPOLL CREATE TAILED!");

abort(); //退出程序

}

}

//添加或修改监控事件

void UpdateEvent(Channel* channel)

{

bool ret = HasChannel(channel);

if (ret == false)

{

_channels.insert(std::make_pair(channel->Fd(), channel));

return Update(channel, EPOLL_CTL_ADD);

}

return Update(channel, EPOLL_CTL_MOD);

}

//移除监控

void RemoveEvent(Channel* channel)

{

bool ret = HasChannel(channel);

if (ret == false)

{

return;

}

_channels.erase(channel->Fd());

return Update(channel, EPOLL_CTL_DEL);

}

//开始监控,返回活跃连接

void Poll(std::vector<Channel*>* active)

{

int n = epoll_wait(_epfd, _evs, MAX_EPOLLEVENTS, -1);

if (n < 0)

{

if (errno == EINTR) //如果被信号打断了

{

return;

}

ERR_LOG("EPOLL WAIT FAILED:%s", strerror(errno));

abort();

}

for (int i = 0; i < n; ++i)

{

auto it = _channels.find(_evs[i].data.fd);

assert(it != _channels.end());

it->second->SetREvents(_evs[i].events);

active->push_back(it->second);

}

}

};

Poller模块与Channel模块整合与测试

虽然Channel模块是和EventLoop模块进行整合,但是我们可以先用Poller模块进行一个基本测试。实际操作的时候不是Poller,是依赖EventLoop,Poller只是EventLoop的子模块而已

更新Poller模块和Channel模块

class Poller;

class Channel

{

private:

Poller* _poller;

uint32_t _events; //当前需要监控的事件

uint32_t _revents; //当前连接触发的事件

using EventCallback = std::function<void()>;

/*

只有我们的连接才知道,一旦事件触发了该去怎么处理,所以需要设置回调函数。

当启动读事件监控,就需要将channel挂到EventLoop上面进行事件监控,

当可读事件触发,就会调用channel里设置的回调函数。

*/

EventCallback _read_callback; //可读事件被触发的回调函数

EventCallback _write_callback; //可写事件被触发的回调函数

EventCallback _error_callback; //错误事件被触发的回调函数

EventCallback _close_callback; //连接断开事件被触发的回调函数

EventCallback _event_callback; //任意事件被触发的回调函数

int _fd;

public:

Channel(Poller* poller, int fd)

:_poller(poller), _fd(fd), _events(0), _revents(0)

{}

int Fd()

{

return _fd;

}

uint32_t Events()

{

return _events;

}

void SetREvents(uint32_t events)

{

_revents = events;

}

void SetReadCallback(const EventCallback& cb)

{

_read_callback = cb;

}

void SetWriteCallback(const EventCallback& cb)

{

_write_callback = cb;

}

void SetErrorCallback(const EventCallback& cb)

{

_error_callback = cb;

}

void SetCloseCallback(const EventCallback& cb)

{

_close_callback = cb;

}

void SetEventCallback(const EventCallback& cb)

{

_event_callback = cb;

}

//当前是否监控了可读

bool ReadAble()

{

return (_events & EPOLLIN);

}

//当前是否监控了可写

bool WriteAble()

{

return (_events & EPOLLOUT);

}

//启动读事件监控

void EnableRead()

{

_events |= EPOLLIN;

Update();//因为EventLoop还没有实现,为了测试Channel和Poller,先暂时直接用Poller里的接口进行操作

}

//启动可写事件监控

void EnableWrite()

{

_events |= EPOLLOUT;

Update();//因为EventLoop还没有实现,为了测试Channel和Poller,先暂时直接用Poller里的接口进行操作

}

//关闭读事件监控

void DisableRead()

{

_events &= ~EPOLLIN;

Update();//因为EventLoop还没有实现,为了测试Channel和Poller,先暂时直接用Poller里的接口进行操作

}

//关闭写事件监控

void DisableWrite()

{

_events &= ~EPOLLOUT;

Update();//因为EventLoop还没有实现,为了测试Channel和Poller,先暂时直接用Poller里的接口进行操作

}

//关闭所有事件监控

void DisableAll()

{

_events &= 0;

}

/*

关闭事件监控,只是不去关心这个事件了,但还是在EventLoop中。

移除事件监控,才是真正的将它从EventLoop中移除

*/

//移除监控

void Remove();//因为里面用到了Poller的成员,所以需要在Poller代码的下面去实现该函数

void Update();

/*

EventLoop不用 你触发了什么事件我就去调用对应的回调函数,EventLoop不用管。

EventLoop只管你触发了事件,我就调用你的HandleEvent,你自己来决定什么样的事件该如何处理

这是最能体现Channel模块作用的功能之一

*/

void HandleEvent()

{

if ((_revents & EPOLLIN) || (_revents & EPOLLRDHUP) || (_revents & EPOLLPRI))

{

if (_read_callback)

_read_callback();

}

if (_revents & EPOLLOUT)

{

if (_write_callback)

_write_callback();

}

if (_revents & EPOLLERR)

{

if (_error_callback)

_error_callback();

}

if (_revents & EPOLLHUP)

{

if (_close_callback)

_close_callback();

}

if (_event_callback)

_event_callback();

}

};

#define MAX_EPOLLEVENTS 1024

class Poller

{

private:

int _epfd;

struct epoll_event _evs[MAX_EPOLLEVENTS];

std::unordered_map<int, Channel*> _channels; //这个和epoll里面的所有文件描述符是强绑定的

private:

//对epoll的直接操作

void Update(Channel* channel, int op)

{

int fd = channel->Fd();

struct epoll_event ev;

ev.data.fd = fd;

ev.events = channel->Events();

int ret = epoll_ctl(_epfd, op, fd, &ev);

if (ret < 0)

{

ERR_LOG("EPOLLCTL FAILED");

}

return;

}

//判断一个Channel是否已经添加了事件监控

bool HasChannel(Channel* channel)

{

auto pos = _channels.find(channel->Fd());

if (pos == _channels.end())

{

return false;

}

return true;

}

public:

Poller()

{

_epfd = epoll_create(MAX_EPOLLEVENTS);

if (_epfd < 0)

{

ERR_LOG("EPOLL CREATE TAILED!");

abort(); //退出程序

}

}

//添加或修改监控事件

void UpdateEvent(Channel* channel)

{

bool ret = HasChannel(channel);

if (ret == false)

{

_channels.insert(std::make_pair(channel->Fd(), channel));

return Update(channel, EPOLL_CTL_ADD);

}

return Update(channel, EPOLL_CTL_MOD);

}

//移除监控

void RemoveEvent(Channel* channel)

{

bool ret = HasChannel(channel);

if (ret == false)

{

return;

}

_channels.erase(channel->Fd());

return Update(channel, EPOLL_CTL_DEL);

}

//开始监控,返回活跃连接

void Poll(std::vector<Channel*>* active)

{

int n = epoll_wait(_epfd, _evs, MAX_EPOLLEVENTS, -1);

if (n < 0)

{

if (errno == EINTR) //如果被信号打断了

{

return;

}

ERR_LOG("EPOLL WAIT FAILED:%s", strerror(errno));

abort();

}

for (int i = 0; i < n; ++i)

{

auto it = _channels.find(_evs[i].data.fd);

assert(it != _channels.end());

it->second->SetREvents(_evs[i].events);

active->push_back(it->second);

}

}

};

void Channel::Remove()//因为EventLoop还没有实现,为了测试Channel和Poller,先暂时直接用Poller里的接口进行操作

{

return _poller->RemoveEvent(this);

}

void Channel::Update()//因为EventLoop还没有实现,为了测试Channel和Poller,先暂时直接用Poller里的接口进行操作

{

return _poller->UpdateEvent(this);

}

测试:

#include "../source/server.hpp"

void HandleClose(Channel* channel)

{

std::cout << "close: " << channel->Fd() << std::endl;

channel->Remove(); //移除监控

delete channel; //这里直接进行delete是不合理的,因为接下来其他地方可能还要使用这个channel

}

void HandleRead(Channel* channel)

{

int fd = channel->Fd();

char buf[1024] = {0};

int ret = recv(fd, buf, 1023, 0);

if (ret <= 0) //如果对端关闭,或者读取出错

{

return HandleClose(channel); //关闭释放

}

std::cout << buf << std::endl;

channel->EnableWrite(); //启动可写事件

}

void HandleWrite(Channel* channel)

{

int fd = channel->Fd();

const char* data = "天气真不错!!";

int ret = send(fd, data, strlen(data), 0);

if (ret < 0)

{

return HandleClose(channel); //关闭释放

}

channel->DisableWrite(); //关闭写监控

}

void HandleError(Channel* channel)

{

return HandleClose(channel); //关闭释放

}

void HandleEvent(Channel* channel)

{

std::cout << "有了一个事件!!" << std::endl;

}

void Acceptor(Poller* poller, Channel* lst_channel)

{

int fd = lst_channel->Fd();

int newfd = accept(fd, NULL, NULL);

if (newfd < 0) return;

Channel* channel = new Channel(poller, newfd);

//对新连接的channel进行设置,设置的是事件到来了该如何处理

channel->SetReadCallback(std::bind(HandleRead, channel)); //为通信套接字设置可读事件的回调函数

channel->SetWriteCallback(std::bind(HandleWrite, channel)); //可写事件的回调函数

channel->SetCloseCallback(std::bind(HandleClose, channel)); //关闭事件的回调函数

channel->SetErrorCallback(std::bind(HandleError, channel)); //错误事件的回调函数

channel->SetEventCallback(std::bind(HandleEvent, channel)); //任意事件的回调函数

channel->EnableRead(); //启动可读事件

}

int main()

{

Poller poller;

Socket lst_sock;

lst_sock.CreateServer(8085);

//为监听套接字,创建一个Channel进行事件的管理,以及事件的处理

Channel channel(&poller, lst_sock.Fd());

channel.SetReadCallback(std::bind(Acceptor, &poller, &channel));

channel.EnableRead(); //启动可读事件监控

while (1)

{

std::vector<Channel*> actives;

poller.Poll(&actives);

for (auto& a : actives)

{

a->HandleEvent();

}

}

lst_sock.Close();

return 0;

}

#include "../source/server.hpp"

int main()

{

Socket cli_socket;

cli_socket.CreateClient(8085, "127.0.0.1");

while (1)

{

std::string str = "hello world!!!";

cli_socket.Send(str.c_str(), str.size());

char buf[4096] = {0};

cli_socket.Recv(buf, 4095);

DBG_LOG("%s", buf);

sleep(1);

}

return 0;

}

运行结果:

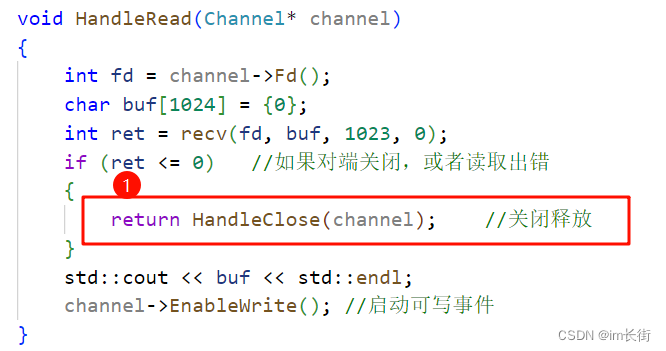

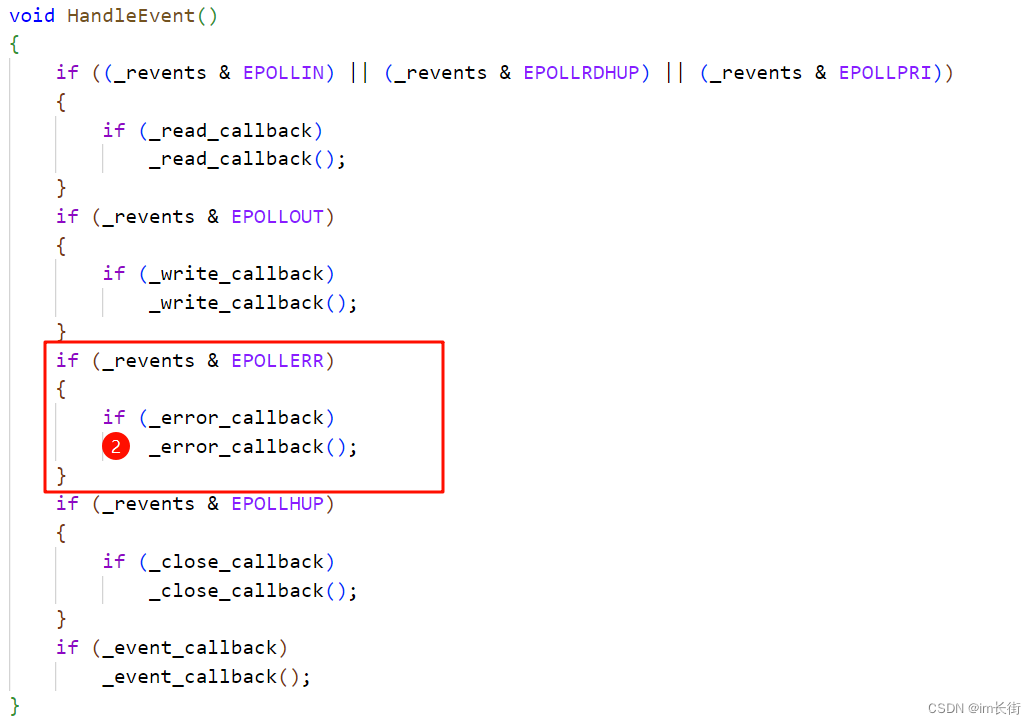

问题一:为什么打印了两次“有了一个事件!!”,因为读事件触发了一次,写事件又触发了一次。

问题二:为什么客户端关闭连接之后,服务器直接崩溃了?

因为服务器在读取的时候,客户端退出了,会触发EPOLLIN事件和EPOLLRDHUP和EPOLLERR事件。

在处理读事件的时候,如果对端关闭,这里会调用一次HandleClose

处理错误事件的时候,又调用了一次HandleClose

所以相当于是double close,在某些平台这可能导致程序崩溃,但是在这里还有一个真正崩溃的原因:close后调用又调用了_event_callback函数,对已经close的文件描述符进行了操作。

close直接关闭了文件描述符,这是不合理的,因为可能文件描述符还有其他事件要处理。

后面会解决这个问题,解决方法:用智能指针对其管理,释放连接的时候是对其智能指针进行释放,如果其他地方还会使用,则让它使用,用完了自然会释放,也不会造成崩溃。

画一幅图来理解这个思想:

最后poller监控的哪个事件触发了,就会调用channel对应的回调函数

EventLoop模块中eventfd的认识

功能:创建一个文件描述符用于事件通知。

参数:

initval:计数初值

flags:EFD_CLOEXEC - 禁止进程复制。EFD_NONBLOCK - 启动非阻塞属性

返回值:返回一个文件描述符用于操作。

eventfd也是通过read/write/close进行操作的。read/write进行IO的时候数据只能是一个8字节数据。

我们不是也可以用信号来达到事件通知的效果吗?信号是针对进程进行事件通知的,而具体的信号被进程中的哪一个线程收到并处理是不一定的。

eventfd本质就是在内核里面管理一个计数器,创建eventfd就是在内核里创建一个计数器(结果)。每当向eventfd中写入一个数值就表示事件一次通知。用read进行数据读取,读取到的数据就是通知的次数。

用处:在EventLoop模块中实现线程间的事件通知功能。

示例

#include <iostream>

#include <sys/eventfd.h>

#include <stdint.h>

#include <cstring>

#include <unistd.h>

int main()

{

int efd = eventfd(0, EFD_CLOEXEC | EFD_NONBLOCK);

if (efd < 0)

{

perror("eventfd failed");

return -1;

}

uint64_t val = 1;

write(efd, &val, sizeof(val));

write(efd, &val, sizeof(val));

write(efd, &val, sizeof(val));

uint64_t res1 = 0;

read(efd, &res1, sizeof(res1));

std::cout << res1 << std::endl;

uint64_t res2 = 0;

read(efd, &res2, sizeof(res2));

std::cout << res2 << std::endl;

close(efd);

return 0;

}

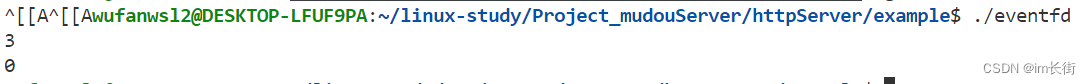

运行结果:

每加一次就代表我给你了一次事件通知,如果efd有事件了,你就去读,你就知道我给你通知了几次事件。

EventLoop模块设计思想

EventLoop:进行事件监控,以及事件处理的模块。

关键点:这个模块与线程是一一对应的。

监控了一个连接,这个连接就绪了,要进行事件处理。但是如果这个连接的描述符在多个线程中被操作处理,就会存在线程安全问题。因此我们需要将一个连接的事件监控、连接事件处理以及其他操作都放在同一个线程中进行。为什么不给连接操作都加一把锁?如果有一万个连接就需要创建一万把锁,这种方法是很不划算的。

如何保证一个连接的所有操作都在EventLoop对应的线程中?

解决方案:给EventLoop模块中添加一个任务队列,对连接的所有操作都进行封装,将对连接的操作并不直接执行,而是当做任务添加到任务队列中。

EventLoop处理流程:

1。在线程中对描述符进行事件监控

2。有描述符就绪则对描述符直接进行事件处理(此时保证了处理回调函数中的操作都在自己对应的线程中)

3。所有的就绪事件处理完了,这时候再去将任务队列中的所有任务一一执行。

这样能够保证对于连接的所有操作,都是在一个线程中进行的,不涉及线程安全问题,但多线程可能对任务队列同时进行操作,所以任务队列需要加上一把锁。

注意:因为一个线程有可能阻塞在IO事件的监控,一直没有事件就绪,导致执行流流程阻塞,这时候任务队列中的任务得不到执行,因此得有一个事件通知的eventfd,能够唤醒事件监控的阻塞。

更新Channel模块,实现EventLoop模块

class EventLoop;

class Channel

{

private:

EventLoop* _loop;

uint32_t _events; //当前需要监控的事件

uint32_t _revents; //当前连接触发的事件

using EventCallback = std::function<void()>;

/*

只有我们的连接才知道,一旦事件触发了该去怎么处理,所以需要设置回调函数。

当启动读事件监控,就需要将channel挂到EventLoop上面进行事件监控,

当可读事件触发,就会调用channel里设置的回调函数。

*/

EventCallback _read_callback; //可读事件被触发的回调函数

EventCallback _write_callback; //可写事件被触发的回调函数

EventCallback _error_callback; //错误事件被触发的回调函数

EventCallback _close_callback; //连接断开事件被触发的回调函数

EventCallback _event_callback; //任意事件被触发的回调函数

int _fd;

public:

Channel(EventLoop* loop, int fd)

:_loop(loop), _fd(fd), _events(0), _revents(0)

{}

int Fd()

{

return _fd;

}

uint32_t Events()

{

return _events;

}

void SetREvents(uint32_t events)

{

_revents = events;

}

void SetReadCallback(const EventCallback& cb)

{

_read_callback = cb;

}

void SetWriteCallback(const EventCallback& cb)

{

_write_callback = cb;

}

void SetErrorCallback(const EventCallback& cb)

{

_error_callback = cb;

}

void SetCloseCallback(const EventCallback& cb)

{

_close_callback = cb;

}

void SetEventCallback(const EventCallback& cb)

{

_event_callback = cb;

}

//当前是否监控了可读

bool ReadAble()

{

return (_events & EPOLLIN);

}

//当前是否监控了可写

bool WriteAble()

{

return (_events & EPOLLOUT);

}

//启动读事件监控

void EnableRead()

{

_events |= EPOLLIN;

Update();

}

//启动可写事件监控

void EnableWrite()

{

_events |= EPOLLOUT;

Update();

}

//关闭读事件监控

void DisableRead()

{

_events &= ~EPOLLIN;

Update();

}

//关闭写事件监控

void DisableWrite()

{

_events &= ~EPOLLOUT;

Update();

}

//关闭所有事件监控

void DisableAll()

{

_events &= 0;

}

/*

关闭事件监控,只是不去关心这个事件了,但还是在EventLoop中。

移除事件监控,才是真正的将它从EventLoop中移除

*/

//移除监控

void Remove();

void Update();

/*

EventLoop不用 你触发了什么事件我就去调用对应的回调函数,EventLoop不用管。

EventLoop只管你触发了事件,我就调用你的HandleEvent,你自己来决定什么样的事件该如何处理

这是最能体现Channel模块作用的功能之一

*/

void HandleEvent()

{

if ((_revents & EPOLLIN) || (_revents & EPOLLRDHUP) || (_revents & EPOLLPRI))

{

if (_event_callback)

_event_callback();

if (_read_callback)

_read_callback();

}

//有可能会释放连接的操作事件,一次只处理一个

if (_revents & EPOLLOUT)

{

if (_event_callback)

_event_callback();

if (_write_callback)

_write_callback();

}

else if (_revents & EPOLLERR)

{

if (_event_callback)

_event_callback();

if (_error_callback)

_error_callback();

}

else if (_revents & EPOLLHUP)

{

if (_event_callback)

_event_callback();

if (_close_callback)

_close_callback();

}

}

};

class EventLoop

{

private:

std::thread::id _thread_id; //线程ID

int _event_fd; //唤醒阻塞的IO事件监控

std::unique_ptr<Channel> _event_channel; //为了能更好的管理_event_fd,为其创建一个channel

Poller _poller; //进行所有的描述符的事件监控

using Functor = std::function<void()>;

std::vector<Functor> _tasks; //任务池

std::mutex _mutex; //保证多线程对任务池进行操作的线程安全

public:

//执行任务池中的所有任务

void RunAllTask()

{

std::vector<Functor> functor;

{

std::unique_lock<std::mutex> lock(_mutex);

functor.swap(_tasks);

}

for (auto f : functor)

{

f();

}

}

static int CreateEventFd()

{

int efd = eventfd(0, EFD_CLOEXEC | EFD_NONBLOCK);

if (efd < 0)

{

perror("eventfd failed");

abort();

}

return efd;

}

void ReadEvent()

{

uint64_t res = 0;

int ret = read(_event_fd, &res, sizeof(res));

if (ret < 0)

{

//EINTR -- 被信号打断 EAGAIN -- 暂时无数据可读(非阻塞时才会触发)

if (errno == EINTR || errno == EAGAIN)

{

return;

}

ERR_LOG("READ EVENTED FAILED");

abort();

}

}

void WeakUpEventFd()

{

uint64_t val = 1;

int ret = write(_event_fd, &val, sizeof(val));

if (ret < 0)

{

if (errno == EINTR)

{

return;

}

ERR_LOG("WRITE EVENTFD FAILED");

abort();

}

}

public:

EventLoop()

:_thread_id(std::this_thread::get_id()) //获取的是当前实例化该EventLoop线程的id,进行线程绑定

,_event_fd(CreateEventFd())

,_event_channel(new Channel(this, _event_fd))

{

//给eventfd添加可读事件回调,读取eventfd事件通知次数

_event_channel->SetReadCallback(std::bind(&EventLoop::ReadEvent, this));

//启动eventfd的读事件监控

_event_channel->EnableRead();

}

//判断将要执行的任务是否处于当前线程中,如果是则执行,不是则压入队列

void RunInLoop(const Functor& cb)

{

if (IsInLoop())

{

return cb();

}

return QueueInLoop(cb);

}

//将操作压入任务池

void QueueInLoop(const Functor& cb)

{

{

std::unique_lock<std::mutex> lock(_mutex);

_tasks.push_back(cb);

}

//其他线程把任务投入到你的EventLoop的任务池里面了,需要执行任务池里的这个任务

//所以需要唤醒这个线程(因为这个线程可能在等待事件就绪的阻塞状态)

WeakUpEventFd();

}

//用于判断当前线程是否是EventLoop对应的线程

bool IsInLoop()

{

return _thread_id == std::this_thread::get_id();

}

//添加/修改描述符的事件监控

void UpdateEvent(Channel* channel)

{

_poller.UpdateEvent(channel);

}

//移除描述符的监控

void RemoveEvent(Channel* channel)

{

_poller.RemoveEvent(channel);

}

void Start()

{

while (1)

{

//事件监控

std::vector<Channel*> actives;

_poller.Poll(&actives);

//就绪事件处理

for (auto& channel : actives)

{

channel->HandleEvent();

}

//执行任务池中的任务

RunAllTask();

}

}

};

void Channel::Remove()

{

return _loop->RemoveEvent(this);

}

void Channel::Update()

{

return _loop->UpdateEvent(this);

}

测试:

#include "../source/server.hpp"

void HandleClose(Channel* channel)

{

std::cout << "close: " << channel->Fd() << std::endl;

channel->Remove(); //移除监控

delete channel;

}

void HandleRead(Channel* channel)

{

int fd = channel->Fd();

char buf[1024] = {0};

int ret = recv(fd, buf, 1023, 0);

if (ret <= 0) //如果对端关闭,或者读取出错

{

HandleClose(channel); //关闭释放

return;

}

std::cout << buf << std::endl;

channel->EnableWrite(); //启动可写事件

}

void HandleWrite(Channel* channel)

{

int fd = channel->Fd();

const char* data = "天气真不错!!";

int ret = send(fd, data, strlen(data), 0);

if (ret < 0)

{

return HandleClose(channel); //关闭释放

}

channel->DisableWrite(); //关闭写监控

}

void HandleError(Channel* channel)

{

return HandleClose(channel); //关闭释放

}

void HandleEvent(Channel* channel)

{

std::cout << "有了一个事件!!" << std::endl;

}

void Acceptor(EventLoop* loop, Channel* lst_channel)

{

int fd = lst_channel->Fd();

int newfd = accept(fd, NULL, NULL);

if (newfd < 0) return;

Channel* channel = new Channel(loop, newfd);

//对新连接的channel进行设置,设置的是事件到来了该如何处理

channel->SetReadCallback(std::bind(HandleRead, channel)); //为通信套接字设置可读事件的回调函数

channel->SetWriteCallback(std::bind(HandleWrite, channel)); //可写事件的回调函数

channel->SetCloseCallback(std::bind(HandleClose, channel)); //关闭事件的回调函数

channel->SetErrorCallback(std::bind(HandleError, channel)); //错误事件的回调函数

channel->SetEventCallback(std::bind(HandleEvent, channel)); //任意事件的回调函数

channel->EnableRead(); //启动可读事件

}

int main()

{

EventLoop loop;

Socket lst_sock;

lst_sock.CreateServer(8085);

//为监听套接字,创建一个Channel进行事件的管理,以及事件的处理

Channel channel(&loop, lst_sock.Fd());

channel.SetReadCallback(std::bind(Acceptor, &loop, &channel));

channel.EnableRead(); //启动可读事件监控

while (1)

{

std::vector<Channel*> actives;

loop.Start();

}

lst_sock.Close();

return 0;

}

#include "../source/server.hpp"

int main()

{

Socket cli_socket;

cli_socket.CreateClient(8085, "127.0.0.1");

while (1)

{

std::string str = "hello world!!!";

cli_socket.Send(str.c_str(), str.size());

char buf[4096] = {0};

cli_socket.Recv(buf, 4095);

DBG_LOG("%s", buf);

sleep(1);

}

return 0;

}

运行结果:

我们将EventLoop模块进行了整合测试。客户端退出导致服务器崩溃之后再来解决。

EventLoop与TimerWheel定时器模块整合

在之前时间轮的测试代码中,我们是硬编码每秒钟定时执行一次RunTimerTask函数

我们要怎么做到每秒钟定时自动执行一次呢?我们可以通过timerfd,每秒钟触发一次可读事件,则TimerWheel可以实现每秒钟执行一次RunTimerTask。所以我们需要将我们的timerfd和timewheel整合到一起,来实现一个完整的定时器。

注意点:定时器对外的接口也要考虑线程安全问题,定时器信息的操作有可能在多线程中进行(如主线程想添加给所有的连接添加一个定时任务),如果不想加锁,那就把对应的所有操作都放到一个线程中进行。

实现TimerWheel模块和更新EventLoop模块

using TaskFunc = std::function<void()>;

using ReleaseFunc = std::function<void()>;

class TimerTask

{

private:

uint64_t _id; //定时器任务对象ID 定时任务必须得找得着,一个程序里定时任务可能有很多

uint32_t _timeout; //定时任务的超时时间

TaskFunc _task_cb; //定时器要执行的任务

//用于删除TimerWheel中保存的定时器任务对象信息,定时任务释放的时候也要清理TimerWheel中保存的定时器对象信息

//为什么将这个_release设置到TimerTask里面呢,不在TimerWheel层管理?

//因为这个TimerWheel不知道是否某个定时任务真的释放了,而TimerTask是最清楚的,自己真的释放了就会调用析构函数

ReleaseFunc _release;

bool _canceled; //false - 代表没有被取消,true - 代表取消了

public:

TimerTask(uint64_t id, uint32_t timeout, const TaskFunc& cb)

:_id(id), _timeout(timeout), _task_cb(cb), _canceled(false)

{}

~TimerTask()

{

if (_canceled == false) //如果定时任务没有被取消

_task_cb();

_release();

}

void SetRelease(const ReleaseFunc& cb)

{

_release = cb;

}

uint32_t DelayTime()

{

return _timeout;

}

void Cancel()

{

_canceled = true;

}

};

class TimerWheel

{

private:

using WeakTask = std::weak_ptr<TimerTask>;

using PtrTask = std::shared_ptr<TimerTask>;

int _tick; //当前的秒针,走到哪里释放哪里,就相当于执行哪里的任务

int _capacity; //表盘最大数量 -- 也是最大能设置的延时时间

std::vector<std::vector<PtrTask>> _wheel;

std::unordered_map<uint64_t, WeakTask> _timers; //对所有的定时任务进行管理

EventLoop* _loop; //timerwheel所关联的EventLoop

int _timerfd; //定时器描述符

std::unique_ptr<Channel> _timer_channel;

public:

void RemoveTimer(uint64_t id)

{

auto pos = _timers.find(id);

if (pos != _timers.end())

{

_timers.erase(pos);

}

}

static int CreateTimerFd()

{

int timerfd = timerfd_create(CLOCK_MONOTONIC, 0);

if (timerfd < 0)

{

ERR_LOG("TIMERFD CREATE FAILED");

abort();

}

struct itimerspec itime;

itime.it_value.tv_sec = 1;

itime.it_value.tv_nsec = 0;

itime.it_interval.tv_sec = 1;

itime.it_interval.tv_nsec = 0;

timerfd_settime(timerfd, 0, &itime, NULL);

return timerfd;

}

void ReadTimefd()

{

uint64_t times;

int ret = read(_timerfd, ×, 8);

if (ret < 0)

{

ERR_LOG("READ TIMEFD FAILED");

abort();

}

}

void RunTimerTask()

{

_tick = (_tick + 1) % _capacity;

_wheel[_tick].clear(); //情况指定位置的数组,就会把数组中保存的所有管理定时器对象的shared_ptr释放掉

}

//这个函数每秒钟会被执行一次,相当于秒针向后走了一步

void OnTime()

{

ReadTimefd();

RunTimerTask();

}

void TimerAddInLoop(uint64_t id, uint32_t delay, const TaskFunc& cb)

{

//1.构建定时任务

PtrTask pt(new TimerTask(id, delay, cb));

pt->SetRelease(std::bind(&TimerWheel::RemoveTimer, this, id));

//2.将定时任务加入到_wheel中

int i = (_tick + delay) % _capacity;

_wheel[i].push_back(pt);

//3.加入到时间轮的_timers里面

// std::unordered_map<uint64_t, WeakTask>::iterator pos = _timers.find(id);

auto pos = _timers.find(id);

if (pos == _timers.end())

{

_timers.insert({id, pt});

}

}

void TimerRefreshInLoop(uint64_t id) //刷新/延迟定时任务

{

//通过id找到对应的定时任务

auto pos = _timers.find(id);

if (pos == _timers.end())

{

//如果没找到定时任务,则没办法更新

return;

}

//获取到对应定时任务的shared_ptr,并构建一个新的智能指针,对应的计数加1

PtrTask pt = pos->second.lock();

//将对应的pt加入到_wheel中

int delay = pt->DelayTime();

int i = (_tick + delay) % _capacity;

_wheel[i].push_back(pt);

}

void TimerCancelInLoop(uint64_t id)

{

auto pos = _timers.find(id);

if (pos == _timers.end())

{

//没找到定时任务,没法刷新,没法延时

return;

}

PtrTask pt = pos->second.lock();

if (pt) //如果自己已经销毁,则可能为空

pt->Cancel();

}

public:

TimerWheel(EventLoop* loop)

:_capacity(60)

, _tick(0)

, _wheel(_capacity)

, _loop(loop)

, _timerfd(CreateTimerFd())

, _timer_channel(new Channel(loop, _timerfd))

{

_timer_channel->SetReadCallback(std::bind(&TimerWheel::OnTime, this));

_timer_channel->EnableRead();

}

//定时器中有个_timers成员,定时器信息的操作有可能在多线程中进行(如主线程想添加给所有的连接添加一个定时任务),因此需要考虑线程安全问题

//如果不想加锁,那就把对应定期的所有操作,都放到一个线程中进行

void TimerAdd(uint64_t id, uint32_t delay, const TaskFunc& cb); //因为用到了EventLoop的_loop成员,所以要在EventLoop代码后面去实现

void TimerRefresh(uint64_t id);

void TimerCancel(uint64_t id);

//这个接口存在线程安全问题--这个接口不能被外界使用者调用,只能在模块内,在对应的EventLoop线程内执行

bool HasTimer(uint64_t id)

{

auto it = _timers.find(id);

if (it == _timers.end())

{

return false;

}

return true;

}

};

class EventLoop

{

private:

std::thread::id _thread_id; //线程ID

int _event_fd; //唤醒阻塞的IO事件监控

std::unique_ptr<Channel> _event_channel; //为了能更好的管理_event_fd,为其创建一个channel

Poller _poller; //进行所有的描述符的事件监控

using Functor = std::function<void()>;

std::vector<Functor> _tasks; //任务池

std::mutex _mutex; //保证多线程对任务池进行操作的线程安全

TimerWheel _timer_wheel;

public:

//执行任务池中的所有任务

void RunAllTask()

{

std::vector<Functor> functor;

{

std::unique_lock<std::mutex> lock(_mutex);

functor.swap(_tasks);

}

for (auto f : functor)

{

f();

}

}

static int CreateEventFd()

{

int efd = eventfd(0, EFD_CLOEXEC | EFD_NONBLOCK);

if (efd < 0)

{

perror("eventfd failed");

abort();

}

return efd;

}

void ReadEvent()

{

uint64_t res = 0;

int ret = read(_event_fd, &res, sizeof(res));

if (ret < 0)

{

//EINTR -- 被信号打断 EAGAIN -- 暂时无数据可读(非阻塞时才会触发)

if (errno == EINTR || errno == EAGAIN)

{

return;

}

ERR_LOG("READ EVENTED FAILED");

abort();

}

}

void WeakUpEventFd()

{

uint64_t val = 1;

int ret = write(_event_fd, &val, sizeof(val));

if (ret < 0)

{

if (errno == EINTR)

{

return;

}

ERR_LOG("WRITE EVENTFD FAILED");

abort();

}

}

public:

EventLoop()

:_thread_id(std::this_thread::get_id()) //获取的是当前实例化该EventLoop线程的id,进行线程绑定

,_event_fd(CreateEventFd())

,_event_channel(new Channel(this, _event_fd))

,_timer_wheel(this)

{

//给eventfd添加可读事件回调,读取eventfd事件通知次数

_event_channel->SetReadCallback(std::bind(&EventLoop::ReadEvent, this));

//启动eventfd的读事件监控

_event_channel->EnableRead();

}

//判断将要执行的任务是否处于当前线程中,如果是则执行,不是则压入队列

void RunInLoop(const Functor& cb)

{

if (IsInLoop())

{

return cb();

}

return QueueInLoop(cb);

}

//将操作压入任务池

void QueueInLoop(const Functor& cb)

{

{

std::unique_lock<std::mutex> lock(_mutex);

_tasks.push_back(cb);

}

//其他线程把任务投入到你的EventLoop的任务池里面了,需要执行任务池里的这个任务

//所以需要唤醒这个线程(因为这个线程可能在等待事件就绪的阻塞状态)

WeakUpEventFd();

}

//用于判断当前线程是否是EventLoop对应的线程

bool IsInLoop()

{

return _thread_id == std::this_thread::get_id();

}

//添加/修改描述符的事件监控

void UpdateEvent(Channel* channel)

{

_poller.UpdateEvent(channel);

}

//移除描述符的监控

void RemoveEvent(Channel* channel)

{

_poller.RemoveEvent(channel);

}

void TimerAdd(uint64_t id, uint32_t delay, const TaskFunc& cb)

{

return _timer_wheel.TimerAdd(id, delay, cb);

}

void TimerRefresh(uint64_t id)

{

return _timer_wheel.TimerRefresh(id);

}

void TiemrCancel(uint64_t id)

{

return _timer_wheel.TimerCancel(id);

}

bool HasTimer(uint64_t id)

{

return _timer_wheel.HasTimer(id);

}

void Start()

{

while (1)

{

//事件监控

std::vector<Channel*> actives;

_poller.Poll(&actives);

//就绪事件处理

for (auto& channel : actives)

{

channel->HandleEvent();

}

//执行任务池中的任务

RunAllTask();

}

}

};

void TimerWheel::TimerAdd(uint64_t id, uint32_t delay, const TaskFunc& cb)

{

_loop->RunInLoop(std::bind(&TimerWheel::TimerAddInLoop, this, id, delay, cb));

}

void TimerWheel::TimerRefresh(uint64_t id)

{

_loop->RunInLoop(std::bind(&TimerWheel::TimerRefreshInLoop, this, id));

}

void TimerWheel::TimerCancel(uint64_t id)

{

_loop->RunInLoop(std::bind(&TimerWheel::TimerCancelInLoop, this, id));

}

测试:

#include "../source/server.hpp"