本次打卡基于gpt2的文本摘要

数据加载及预处理

from mindnlp.utils import http_get

# download dataset

url = 'https://download.mindspore.cn/toolkits/mindnlp/dataset/text_generation/nlpcc2017/train_with_summ.txt'

path = http_get(url, './')

from mindspore.dataset import TextFileDataset

# load dataset

dataset = TextFileDataset(str(path), shuffle=False)

dataset.get_dataset_size()

# split into training and testing dataset

train_dataset, test_dataset = dataset.split([0.9, 0.1], randomize=False)

import json

import numpy as np

# preprocess dataset

def process_dataset(dataset, tokenizer, batch_size=6, max_seq_len=1024, shuffle=False):

def read_map(text):

data = json.loads(text.tobytes())

return np.array(data['article']), np.array(data['summarization'])

def merge_and_pad(article, summary):

# tokenization

# pad to max_seq_length, only truncate the article

tokenized = tokenizer(text=article, text_pair=summary,

padding='max_length', truncation='only_first', max_length=max_seq_len)

return tokenized['input_ids'], tokenized['input_ids']

dataset = dataset.map(read_map, 'text', ['article', 'summary'])

# change column names to input_ids and labels for the following training

dataset = dataset.map(merge_and_pad, ['article', 'summary'], ['input_ids', 'labels'])

dataset = dataset.batch(batch_size)

if shuffle:

dataset = dataset.shuffle(batch_size)

return dataset

from mindnlp.transformers import BertTokenizer

# We use BertTokenizer for tokenizing chinese context.

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

len(tokenizer)

模型构建¶

from mindspore import ops

from mindnlp.transformers import GPT2LMHeadModel

class GPT2ForSummarization(GPT2LMHeadModel):

def construct(

self,

input_ids = None,

attention_mask = None,

labels = None,

):

outputs = super().construct(input_ids=input_ids, attention_mask=attention_mask)

shift_logits = outputs.logits[..., :-1, :]

shift_labels = labels[..., 1:]

# Flatten the tokens

loss = ops.cross_entropy(shift_logits.view(-1, shift_logits.shape[-1]), shift_labels.view(-1), ignore_index=tokenizer.pad_token_id)

return loss

from mindspore import ops

from mindspore.nn.learning_rate_schedule import LearningRateSchedule

class LinearWithWarmUp(LearningRateSchedule):

"""

Warmup-decay learning rate.

"""

def __init__(self, learning_rate, num_warmup_steps, num_training_steps):

super().__init__()

self.learning_rate = learning_rate

self.num_warmup_steps = num_warmup_steps

self.num_training_steps = num_training_steps

def construct(self, global_step):

if global_step < self.num_warmup_steps:

return global_step / float(max(1, self.num_warmup_steps)) * self.learning_rate

return ops.maximum(

0.0, (self.num_training_steps - global_step) / (max(1, self.num_training_steps - self.num_warmup_steps))

) * self.learning_rate

num_epochs = 1

warmup_steps = 2000

learning_rate = 1.5e-4

num_training_steps = num_epochs * train_dataset.get_dataset_size()

from mindspore import nn

from mindnlp.transformers import GPT2Config, GPT2LMHeadModel

config = GPT2Config(vocab_size=len(tokenizer))

model = GPT2ForSummarization(config)

lr_scheduler = LinearWithWarmUp(learning_rate=learning_rate, num_warmup_steps=warmup_steps, num_training_steps=num_training_steps)

optimizer = nn.AdamWeightDecay(model.trainable_params(), learning_rate=lr_scheduler)

# 记录模型参数数量

print('number of model parameters: {}'.format(model.num_parameters()))

from mindnlp._legacy.engine import Trainer

from mindnlp._legacy.engine.callbacks import CheckpointCallback

ckpoint_cb = CheckpointCallback(save_path='checkpoint', ckpt_name='gpt2_summarization',

epochs=1, keep_checkpoint_max=2)

trainer = Trainer(network=model, train_dataset=train_dataset,

epochs=1, optimizer=optimizer, callbacks=ckpoint_cb)

trainer.set_amp(level='O1') # 开启混合精度

trainer.run(tgt_columns="labels")

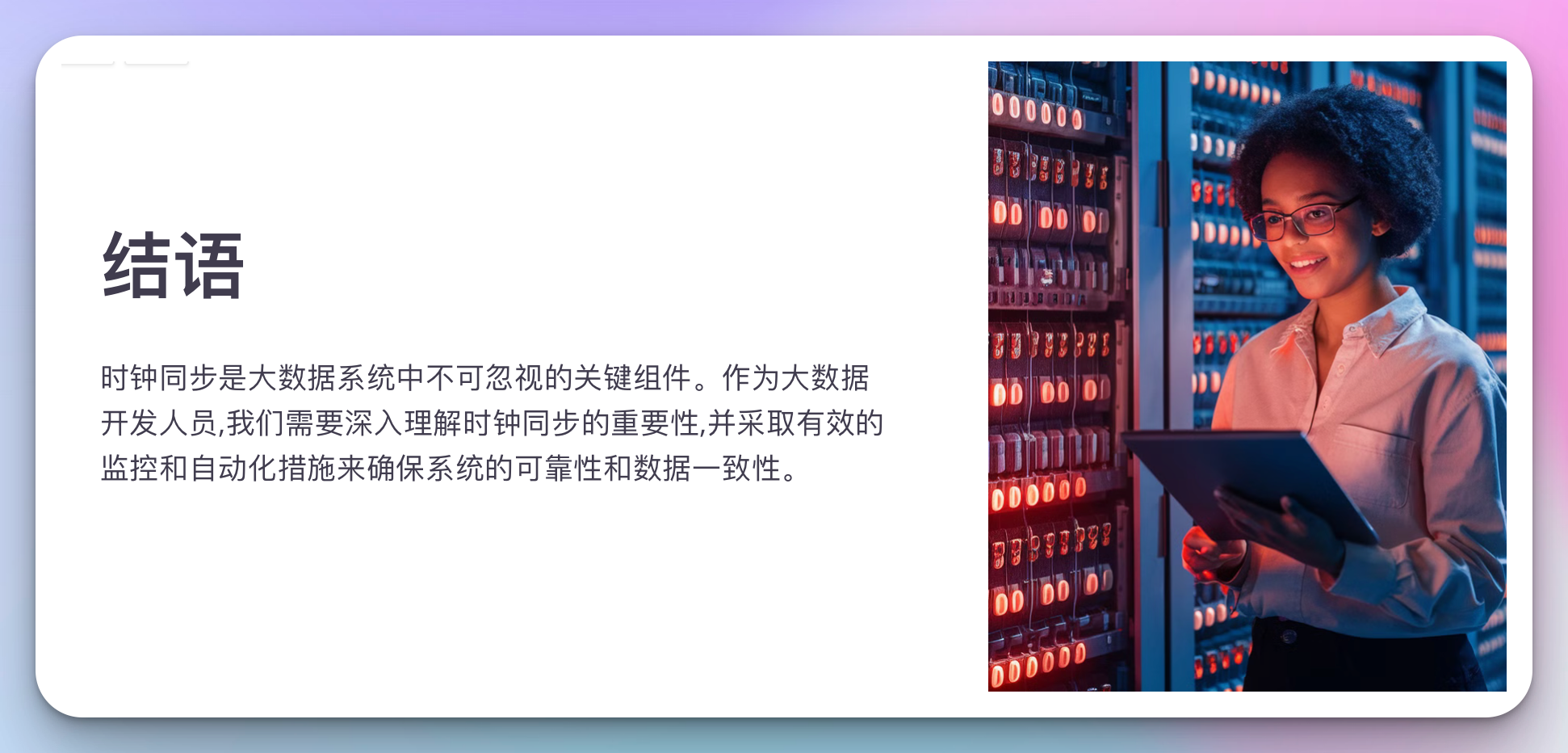

结论

gpt2相较bert等模型,在文本识别、文本摘要、命名体识别中有着优秀的表现,但其模型规模相对较大,训练时间较长,打卡中展示的没有完成训练,这里需要更好的gpu来辅助训练。